Zuckerberg, este novo produto que não será lançado, está explorando novamente a forma definitiva de óculos de IA

Desde que Zuckerberg renomeou o FaceBook para Meta, a empresa competiu completamente com os óculos.

Há um pouco de conhecimento que é quente e frio. O nome Meta é retirado das primeiras quatro letras de “metaverso”. Quando o nome foi alterado em 2021, o próprio Zuckerberg disse com muita confiança:

O Metaverso afetará um bilhão de pessoas na próxima década, e o Metaverso afetará todos os produtos que desenvolvermos.

▲ Foto de: Google

Quatro anos se passaram e o Metaverso se tornou um recurso frequente em romances de ficção científica, animações criativas e obras de cinema e televisão, mas está cada vez mais longe do mundo real. As poucas coisas que atraem a atenção das pessoas são aquelas coisas irritantes que ocasionalmente chegam às manchetes em pesquisas de tendências e usam o disfarce do Metaverso e dos ativos virtuais para fraudar.

Em termos de popularização e disseminação do metaverso, o Meta não mudou muito como há quatro anos, mas eles fizeram muitas coisas novas interessantes em dispositivos VR/AR montados na cabeça, a entrada para o metaverso.

Meta Quest, posicionada como um novo console de jogos, abriu um novo mundo de jogos interativos VR. Em 2024, a série Meta Quest ocupará 73% do mercado, muito à frente.

Ray-Ban Meta tornou-se um acessório moderno na era da IA. Após duas gerações de esforços de produto, suas remessas ultrapassaram oficialmente 2 milhões de unidades em fevereiro deste ano. Ele integra óculos tradicionais, logotipos de marcas, fones de ouvido Bluetooth, assistentes de voz e câmeras Vlog.

Superficialmente, a Meta lançou vários produtos de sucesso no mercado de consumo privado, eles também estão trabalhando silenciosamente no caminho toB, e esses óculos inteligentes para empresas e instituições profissionais começaram ainda antes de mudarem de nome.

O acordo de cinco anos chegou e Meta entregou os papéis

Em 2020, a Meta lançou seus primeiros óculos inteligentes experimentais, Meta Aria Gen 1. Comparado com os óculos tradicionais, o Aria Gen 1 é ligeiramente inchado, especialmente as duas hastes espessas, que são muito visíveis.

▲ Foto de: Google

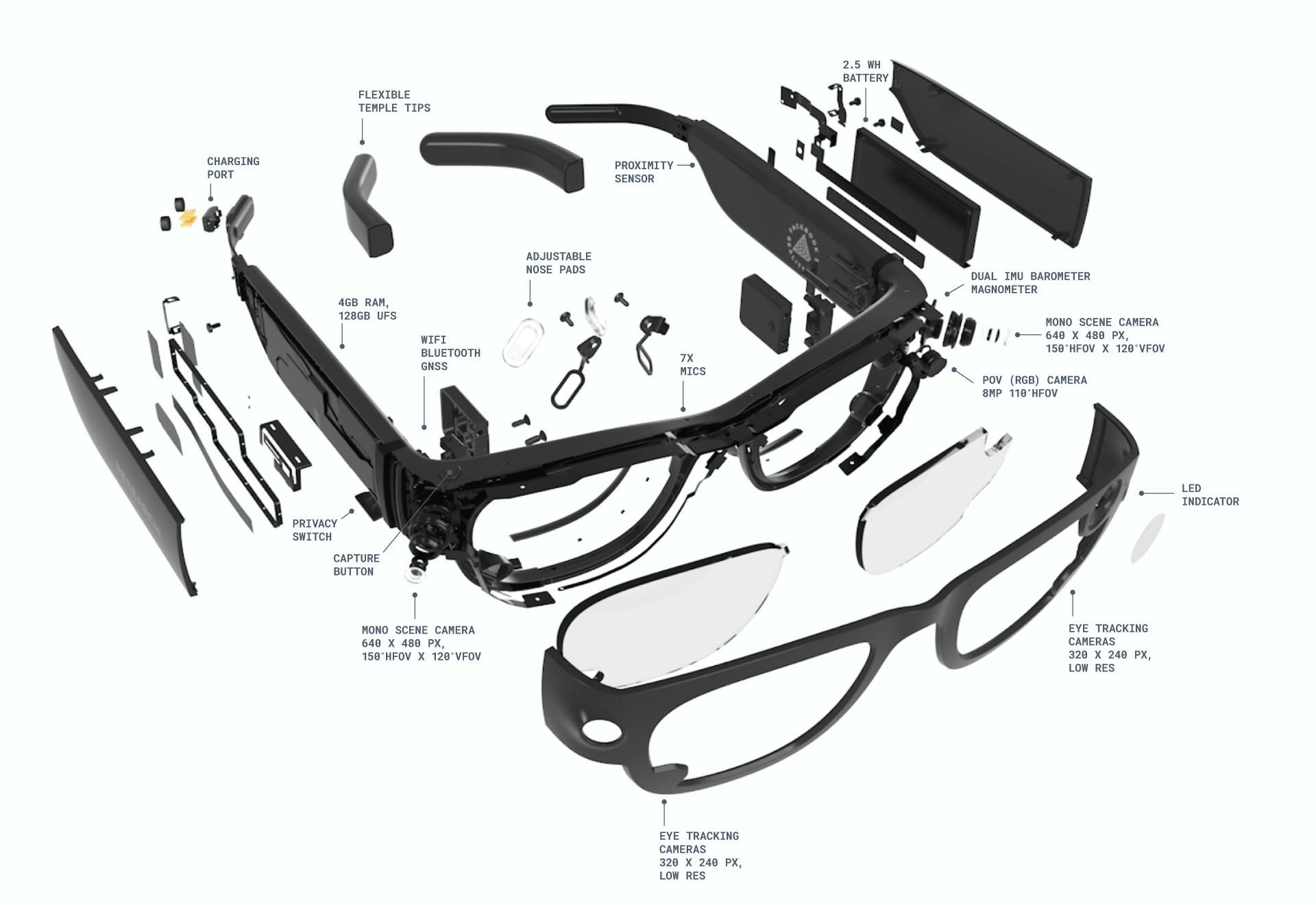

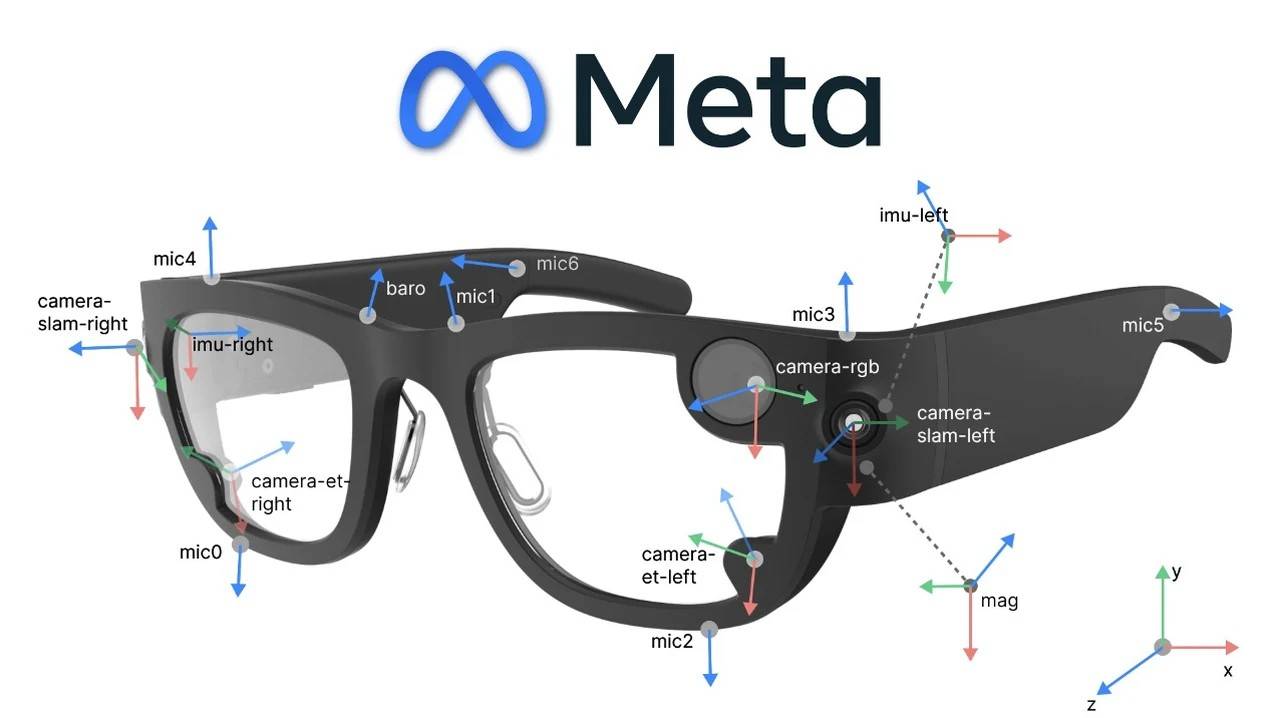

A enorme aparência não é apenas uma decoração, mas contém um grande número de pacotes de sensores, como câmeras RGB, câmeras de rastreamento de posicionamento, unidades de medição inercial (IMU), barômetros, magnetômetros, etc.

Teoricamente, o Aria Gen 1 foi especialmente projetado para pesquisas em sistemas de percepção de máquinas, inteligência artificial e robótica. Ao integrar sensores multimodais, ajuda os pesquisadores a superar os principais problemas técnicos dos óculos AR, como percepção ambiental, posicionamento espacial, etc.

Quando se trata de experiência real, Aria Gen 1 tem uma missão muito distante e emocionante:

Imagine um dia em que poderemos aproveitar todos os benefícios de estar conectados sem ter que abaixar a cabeça e olhar para nossos dispositivos. Imagine ligar para um amigo e conversar com um avatar realista do outro lado da mesa.

Imagine um assistente digital inteligente o suficiente para detectar perigos nas estradas, fornecer estatísticas durante reuniões de negócios ou até mesmo ajudá-lo a ouvir melhor em ambientes barulhentos.

Este é um mundo onde os próprios dispositivos desaparecem completamente nos altos e baixos da vida diária.

Como protótipo deste experimento e produto de primeira geração, o Aria Gen 1 não causou muito impacto. Após cinco anos de desenvolvimento, a Meta lançou oficialmente o Aria Gen 2 esta semana. Em comparação com a primeira geração, houve uma atualização abrangente.

A mudança mais óbvia está no sistema de sensores. A máquina de primeira geração usa os componentes de detecção ambiental mais básicos, apenas câmeras e sensores inerciais. Nesta base, Aria Gen 2 adiciona muitos novos acessórios, incluindo câmeras RGB, câmeras 6DOF SLAM, câmeras de rastreamento ocular, microfones espaciais, IMUs, barômetros, magnetômetros e GNSS.

Em particular, a nova geração de produtos possui dois sensores inovadores incorporados nas plaquetas: um sensor PPG para medir a frequência cardíaca e um microfone de contato para distinguir a voz do usuário da voz dos espectadores.

Se a primeira geração for comparada a “ver o mundo apenas com óculos”, em comparação, pode-se dizer que o Aria Gen 2 tem todos os sentidos abertos. Ele pode perceber, observar e coletar informações externas de mais dimensões. Pode obter dados cada vez mais precisos ao mesmo tempo, e a eficiência de operação e aprendizado da máquina será maior.

Além disso, houve uma mudança qualitativa na forma de processamento de dados. O Aria Gen 1 depende de dispositivos externos para cálculos. Embora não execute cálculos locais, pode reduzir o peso e a pressão do dispositivo até certo ponto, mas é seguido por uma resposta lenta.

Aria Gen 2 usa o chip desenvolvido pela própria Meta, que pode processar dados no lado do dispositivo. A velocidade de resposta é muito rápida, não é restringida pela rede e a experiência interativa também foi bastante melhorada.

De modo geral, equipamentos com chips de desenvolvimento próprio possuem recursos de computação final, mas também aumentam o peso do equipamento. Mas a Meta fala por si com os dados, e eles têm estado muito ocupados nos últimos cinco anos: Aria Gen 1 pesa 98g e Aria Gen 2 pesa 75 gramas. Aumente a dosagem sem agravamento e a experiência de longo prazo não aumentará o peso.

Aria Gen 2 também é conhecida por seus métodos interativos baseados na interação de voz de primeira geração, a máquina de segunda geração adicionou "rastreamento ocular + gesto + operação de contato". A interação por voz é muito direta e o caminho de recuperação será bastante reduzido, mas não é adequado para todos os cenários da vida, como estações de metrô em horários de pico e escritórios ultrassilenciosos.

É lógico que à medida que mais sensores e funções interativas aumentam, a vida útil da bateria será afetada. O chip desenvolvido pela própria empresa afeta a vida útil da bateria do Aria Gen 2, mas de uma forma positiva. As autoridades afirmam que pode durar de 6 a 8 horas de uso. Com base no tempo de uso atual dos fones de ouvido sem fio, o Aria Gen 2 pode basicamente ter funções inteligentes disponíveis para todos os climas.

Uma vez estabelecida a base de hardware, haverá mais possibilidades para experiências de uso subsequentes. A atualização do Aria Gen 2 reflete as duas direções estratégicas da Meta para a implementação da tecnologia AR:

A primeira é a integração furtiva: reduzindo a presença do dispositivo através de um design leve e ocultação do sensor (por exemplo, quando a luz indicadora da câmera está desligada, a aparência é semelhante a óculos comuns; a segunda é através de um ecossistema aberto que fornece interfaces API subjacentes e capacidades de expansão modular para incentivar os acadêmicos a desenvolver kits de ferramentas personalizados e acelerar a transformação tecnológica);

Portanto, os cenários de aplicação do Aria Gen 2 também mudaram da navegação interna anterior e da pesquisa básica de AR para campos mais dimensionais. Assistência médica, indústria, planejamento urbano, etc., podem se tornar o solo para o crescimento do Aria Gen 2.

Neste ponto, vamos resumir o progresso e o significado do Aria Gen 2:

- Atualizações de hardware de percepção para alcançar fusão de dados biológicos e compreensão aprofundada do meio ambiente;

- Equipado com um chip autodesenvolvido para melhorar o desempenho em tempo real e suportar cenários externos sem rede;

- Enriquecer métodos de interação, reduzir a interferência acústica e adaptar-se a ambientes experimentais complexos;

- A duração da bateria cobre o dia todo, prolongando o tempo de uso contínuo e melhorando o conforto de uso;

- Expanda os cenários de aplicação e promova a integração e padronização tecnológica interdisciplinar.

O “lado negro” de Zuckerberg

Se você leu a interpretação e introdução do Meta Aria, ainda está um pouco confuso sobre sua aplicação no mercado consumidor. Isso é normal, porque o Meta afirmou claramente que este produto “não será vendido aos consumidores”. Para esclarecer o propósito da sua criação, temos que recuar há mais de dez anos.

Em 2014, Zuckerberg experimentou os mais recentes equipamentos de VR e vários cenários de jogos no Laboratório Virtual de Interação Humana de Stanford (VHIL). Ele caminhou em uma ponte de prancha única, sobrevoou a cidade e derrubou algumas árvores com óculos de VR.

Cody Woputz, então gerente do laboratório VHIL, revelou certa vez que ao vivenciar a cena da queda de uma grande altitude, ele (Zuckerberg) ficou tão assustado que colocou a mão no peito.

Essa experiência deixou uma impressão profunda em Zuckerberg. Por um lado, porque o VR ainda estava em estágio inicial de pesquisa, o sistema de posicionamento era instável, fazendo com que a experiência fosse interrompida várias vezes, e o equipamento teve que ser parado e recalibrado. Além disso, o VR naquela época não era uma máquina multifuncional.

▲ Foto de: Google

Por outro lado, Zuckerberg também viu as enormes possibilidades desta tecnologia revolucionária no futuro. Foi esta experiência que o tornou determinado a adquirir a Oculus por 2 mil milhões de dólares. Zuckerberg explicou as razões da aquisição no anúncio:

Mobile é a plataforma atual e a aquisição da Oculus está se preparando para a plataforma de amanhã.

Depois disso, Zuckerberg levou o Facebook para começar a explorar a tecnologia e equipamentos AR/VR/MR. Com o acúmulo de metas e tecnologia de hardware, em 2020, a Meta lançou oficialmente o projeto Aria, cujo objetivo é “acelerar AR e IA a partir de uma perspectiva humana”.

▲ Foto de: Google

É um pouco misterioso ver as coisas desta forma. Uma explicação um pouco popular é que os óculos são usados como uma ponte, permitindo que o dispositivo observe e compreenda o mundo de uma perspectiva humana e aprenda a relação interativa entre as pessoas e o meio ambiente.

Os óculos do Projeto Aria podem ajudar os pesquisadores a coletar informações da perspectiva do usuário por meio de tecnologia inovadora, especialmente os novos sensores do Aria Gen 2, que podem capturar o áudio e o vídeo do ambiente ao redor do usuário, bem como o movimento dos olhos e informações de localização.

Partir da primeira perspectiva do usuário torna mais fácil para os pesquisadores descobrir como a AR pode desempenhar um papel real no mundo real e na vida diária, em vez de apenas permanecer em funções sofisticadas, mas pouco práticas.

Além disso, é muito importante para a IA multimodal coletar informações do mundo real a partir de uma perspectiva humana. Este método de treinamento pode simular métodos cognitivos multimodais humanos.

Percebemos o mundo através de múltiplos sentidos, como visão, audição, tato, etc., e a IA multimodal pode estar mais próxima do modelo cognitivo natural dos humanos, integrando texto, imagem, áudio, vídeo e outros dados. Além disso, a capacidade de integração de informações intermodais não pode ser alcançada pela IA monomodal.

A coleta e o treinamento multimodais também podem melhorar a precisão da tomada de decisões da IA em cenários complexos. Se o mundo não for compreendido por meio de informações multidimensionais, haverá inevitavelmente diferenças entre "mostras de compradores" e "mostras de vendedores". O mundo digital só tem 0s e 1s, mas no mundo real, além do preto e branco, também existem áreas cinzentas que são difíceis de entender.

▲ Foto de: Google

A interação em si é, na verdade, multimodal. Além da linguagem, ao conversar com amigos, as expressões, os gestos, o tom e até as roupas afetarão nossa compreensão. Portanto, a IA multimodal pode alcançar uma experiência interativa mais natural ao processar texto, imagens e áudio simultaneamente.

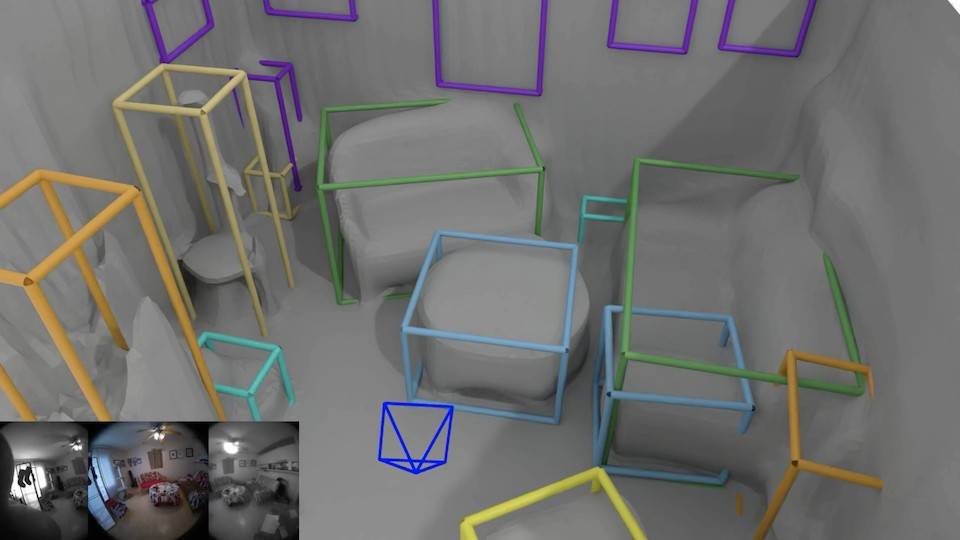

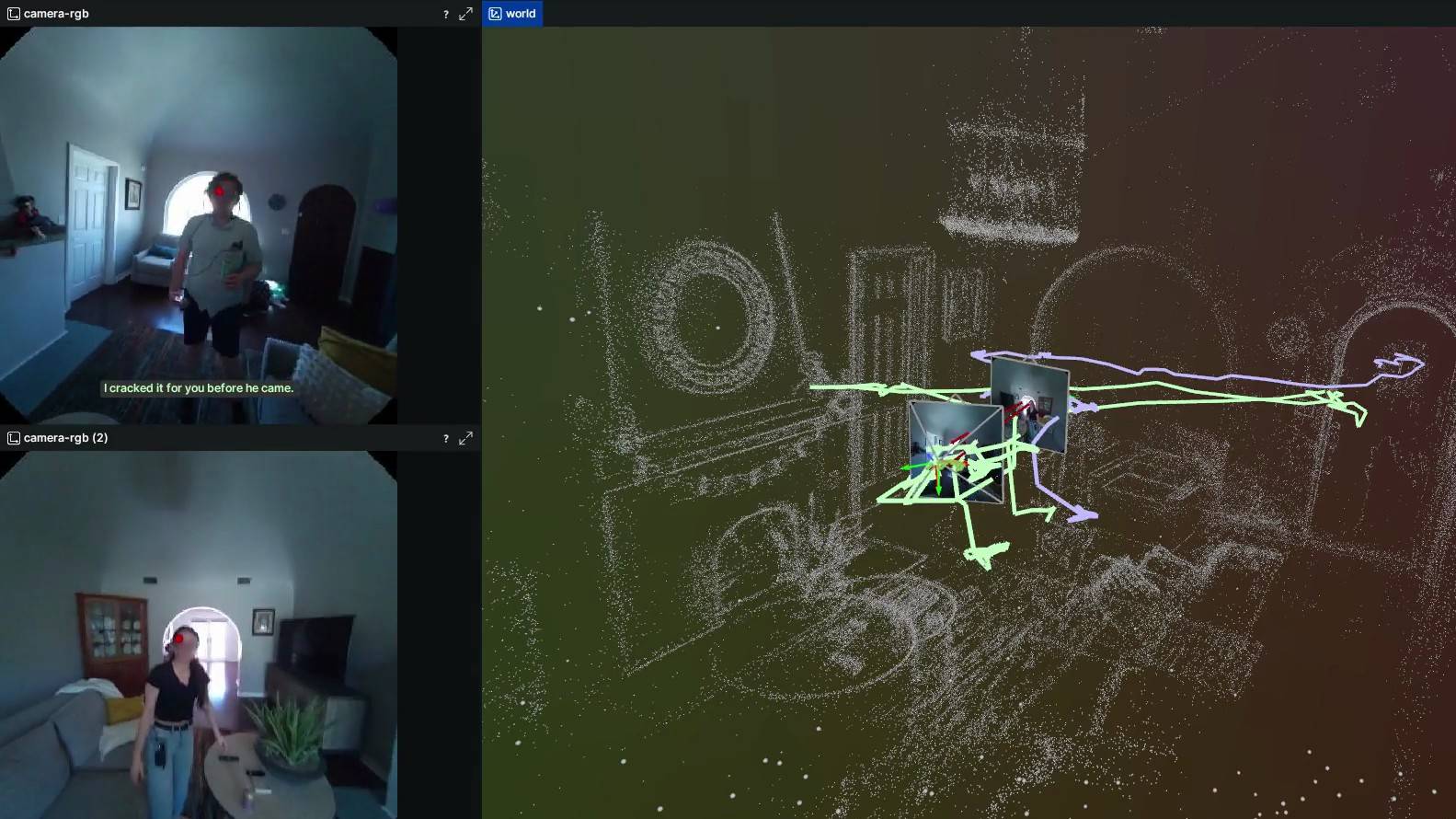

Meta também deu alguns detalhes de sua pesquisa no Projeto Aria No Projeto Aria, a maneira dos óculos inteligentes entenderem o mundo é muito simples e rudimentar: a digitalização. A tecnologia, chamada SceneScript, é um método de representar e inferir a geometria da cena usando modelos de linguagem estruturados autorregressivos e aprendizado ponta a ponta.

▲ Foto de: Meta

Simplificando, todas as cenas e objetos vistos na perspectiva de primeira pessoa podem ser transformados em números e nomes específicos pelos óculos. Quanto tempo tem a mesa? Os buracos transparentes e regulares na parede são chamados de “janelas”.

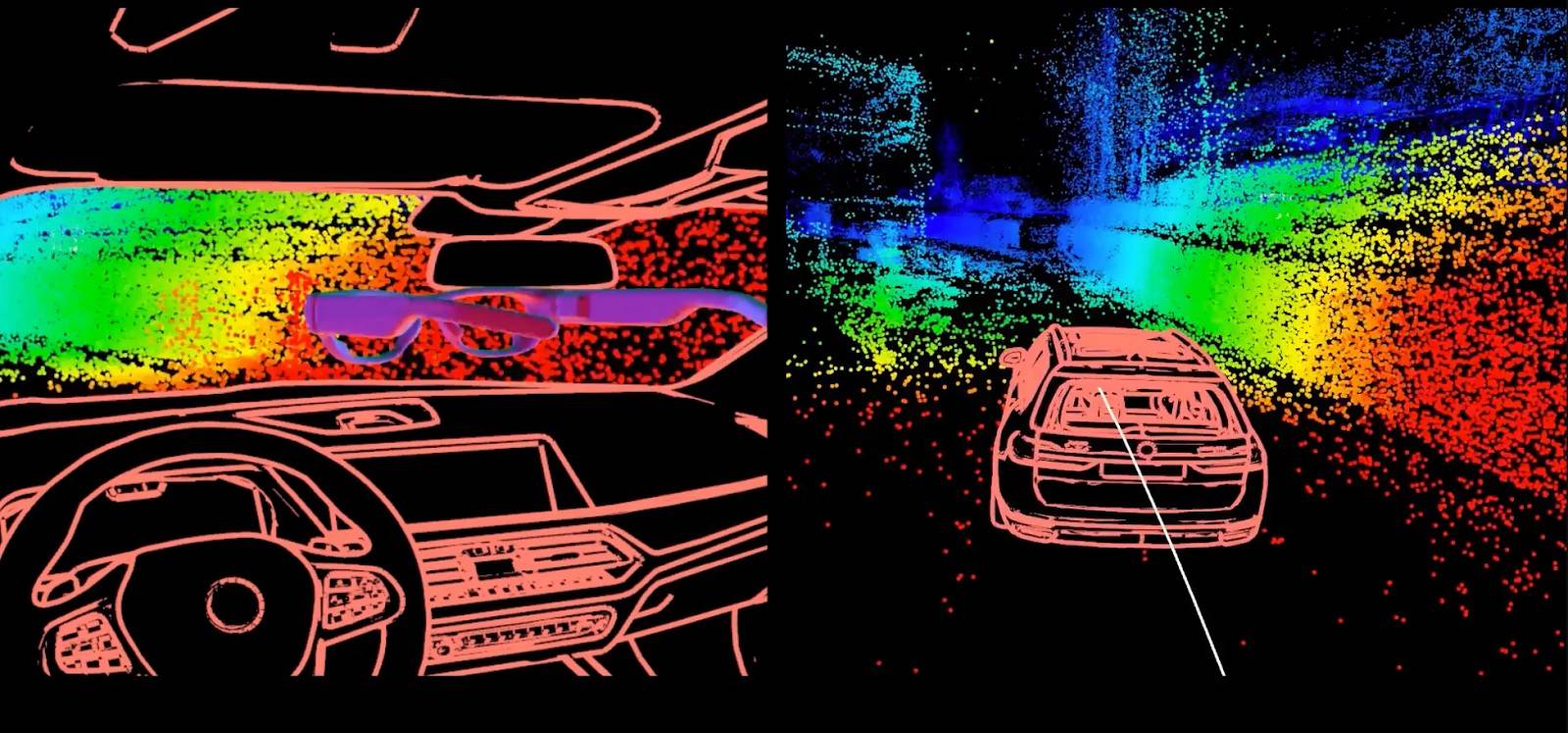

Para permitir que o modelo embutido nos óculos não apenas veja o mundo, mas também compreenda melhor o mundo, Meta usa a tecnologia de imagem tridimensional EMF3D desenvolvida por ele mesmo para "marcar claramente" todos os objetos no mundo real com diferentes segmentos de linha coloridos, unificando os pesos e medidas de coisas de diferentes materiais, formas e tamanhos.

▲ Foto de: Meta

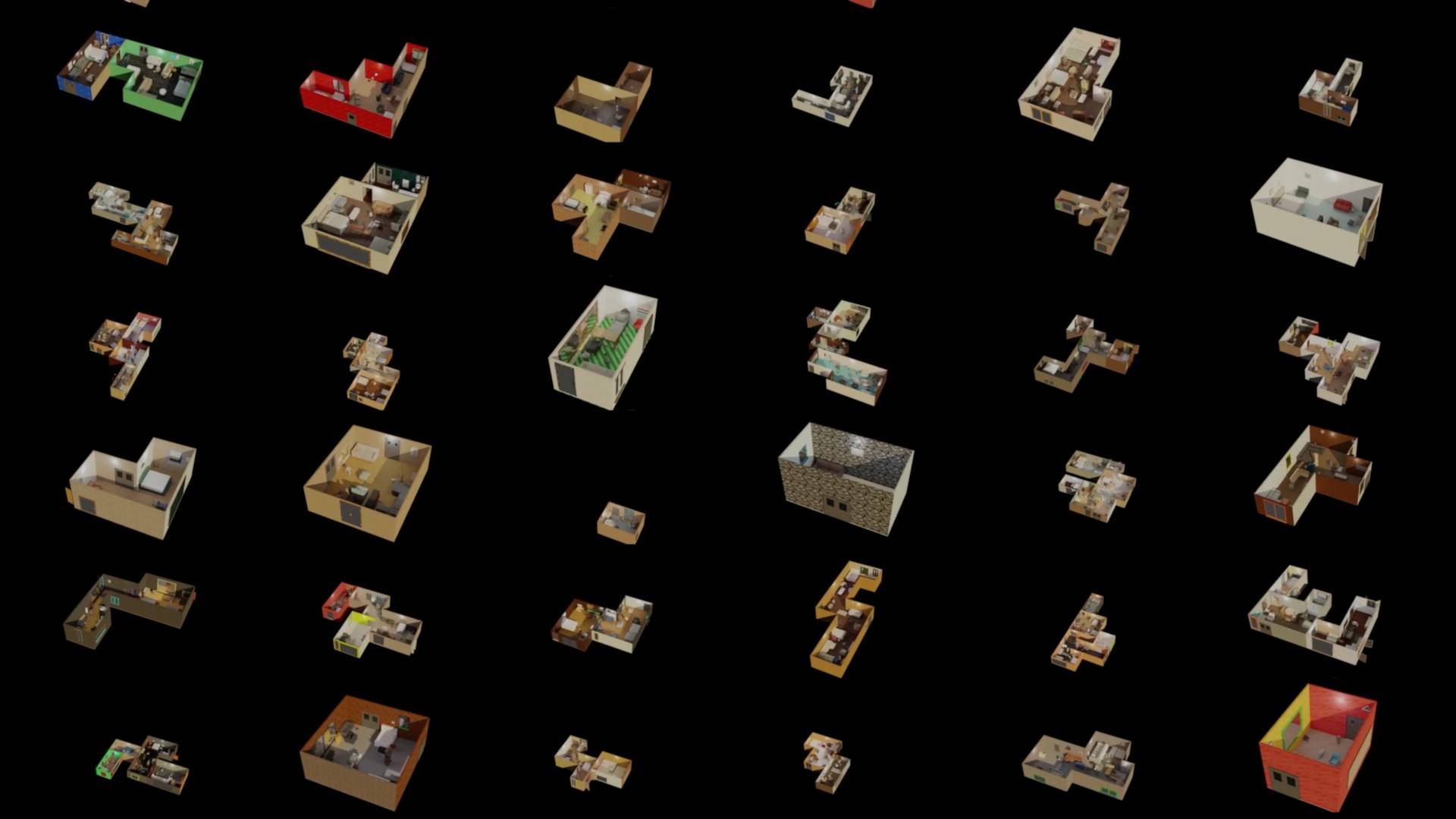

Quando os óculos conseguem ler e registrar o ambiente, torna-se mais possível recriar um mundo virtual. A tecnologia de síntese de ambiente no projeto reproduz um conjunto de dados de cenas internas totalmente simuladas em grande escala, gerado por um programa por meio de uma grande quantidade de coleta de dados. Ela também estabelece um novo padrão para "gêmeos digitais" e acelera a pesquisa em desafios como detecção de objetos 3D, reconstrução de cenas e aprendizagem da simulação para a realidade.

▲ Foto de: Meta

Esse método de aprendizagem de "sistema de desenvolvimento" tem seus prós e contras. O bom é que, uma vez que o aprendizado é muito sólido, a dificuldade é que se você quiser ser sólido, terá que passar por uma grande quantidade de dados. Portanto, são necessários muitos voluntários para participar do Projeto Aria e usar óculos Meta por muito tempo.

Em vez de encontrar pessoas, o mais crítico é como fazer com que as pessoas os utilizem com confiança, porque a recolha de dados e a protecção da privacidade são dois inimigos difíceis de conciliar. A solução proposta pela Meta é um novo modelo de IA “autodesfocado” que protege a privacidade detectando e desfocando PII em imagens e codifica diretamente informações confidenciais, como rostos e placas de veículos.

▲ Foto de: Meta

O aprendizado massivo também pode permitir que o modelo entenda melhor as intenções do usuário. Por exemplo, ao examinar e resumir as cenas da vida diária do usuário, ele pode determinar o que o usuário tem mais probabilidade de fazer em que momento. Seja descer para fazer exercícios, ir para a sala jogar ou ir para a cozinha cozinhar. Ser capaz de prever o comportamento das pessoas pode fornecer funções mais convenientes com antecedência.

Isso é semelhante à função do assistente inteligente do nosso celular, que abre uma janela em um horário específico para nos lembrar das condições do trânsito em casa e do clima de amanhã.

▲ Foto de: Meta

Nos cinco anos desde a fundação do Projeto Aria, eles produziram resultados como o conjunto de dados Ego-Exo4D coletados usando os óculos Aria de primeira geração, que se tornou uma ferramenta fundamental na visão computacional moderna e no campo em constante evolução da robótica.

Algumas empresas também começaram a estudar, como o Aria deve ser utilizado em seu fluxo de trabalho? A BMW, por exemplo, está descobrindo como integrar sistemas de realidade aumentada e realidade virtual em carros inteligentes.

▲ Foto de: Meta

Pesquisadores do Instituto de Tecnologia da Geórgia também demonstraram recentemente como Aria pode ajudar a eliminar o estresse do trabalho doméstico quando se trata de sua casa.

▲ Foto de: Meta

Há muito tempo, concluímos num artigo de experiência sobre assistentes inteligentes móveis: Do ponto de vista actual, o maior significado da combinação de inteligência artificial e vários dispositivos electrónicos deveria ser ajudar os idosos e as pessoas com deficiência a integrarem-se melhor na nova era e na nova vida. Aria também fez alguns progressos no desenvolvimento de tecnologia sem barreiras:

A Carnegie Mellon University está usando a primeira geração de óculos Aria em um projeto para desenvolver tecnologia para ajudar pessoas cegas e com baixa visão a navegar em ambientes fechados.

▲ Foto de: Meta

A função de voz AI do Aria de segunda geração também foi integrada pela Envision em seu próprio Ally AI e áudio espacial para aprimorar a navegação interna e a experiência sem barreiras.

▲ Foto de: Visualizar

Se eu tivesse que usar uma frase para descrever a relação entre o Projeto Aria, Meta e seus produtos, acho que seria como as raízes, o tronco e os galhos de uma árvore. O Projeto Aria está na parte inferior. Geralmente é invisível e intangível, mas as conquistas técnicas acumuladas ao longo dos anos acabarão por ser potencializadas na empresa e em vários produtos de várias maneiras.

No final de setembro do ano passado, Zuckerberg tirou do cofre um óculos inteligente Meta Orion na coletiva de imprensa que parecia comum, mas na verdade foi um projeto ultrassecreto por dez anos. A julgar pela tela de demonstração na conferência de imprensa, ele pode alcançar funções interativas altamente semelhantes às do Vision Pro. Mais importante ainda, o Orion é um par de verdadeiros óculos AR holográficos.

Parece um pouco mais grosso do que os óculos comuns, mas depois de usá-lo, você pode ver o mundo real através das lentes e da imagem projetada.

Embora a clareza não seja tão boa quanto a das TVs e projeções tradicionais, é mais do que suficiente para ver imagens e texto. O surpreendente é que não encontramos nenhum grande prisma nos olhos. O efeito de realidade que está tão próximo da realidade e aparece do nada é na verdade projetar a imagem na lente de carboneto de silício através do projetor LED ao redor da lente.

As 7 câmeras e sensores ao redor do quadro permitem que Meta Orion perceba verdadeiramente a capacidade de transformar realidade virtual em realidade e integrá-la à realidade. Ele pode pairar com precisão imagens holográficas no ar e também identificar itens à sua frente. Por exemplo, pode personalizar uma receita para você com base nos ingredientes da mesa.

▲ Foto de: Meta

Não é exagero dizer que o Orion é tão bom quanto o Vision Pro em termos de experiência interativa, porque ele realmente suporta o rastreamento das mãos e dos olhos, e as mãos são as alças. A pulseira neural correspondente também pode transformar a mão em um mouse. Ele pode identificar os sinais nervosos do corpo, detectando mudanças na corrente muscular e, assim, distinguir diferentes movimentos dos dedos:

- Aperte com o polegar e o indicador para selecionar

- O polegar e o dedo médio acessam o menu em conjunto

- Feche o punho e deslize o polegar para rolar a tela

Na coletiva de imprensa, também vimos a própria desmontagem do Meta Orion. A estrutura interna altamente complexa e extremamente precisa, e o corpo final montado pesava apenas 98g.

Não é difícil descobrir que a relação entre Meta Aria Gen 2 e Meta Orion é semelhante no espelho. No entanto, Zuckerberg disse em entrevista na época que devido ao alto custo (cada unidade custa cerca de 10.000 dólares americanos, aproximadamente 70.000 yuans), a empresa teve que interromper o plano de produção em massa e produziu apenas 1.000 unidades para pesquisa e desenvolvimento interno.

No entanto, a Meta também planeja integrar gradualmente a tecnologia da Aria em óculos AR de consumo, incluindo Orion, após 2026. O objetivo é realizar a transformação dos óculos AR por meio da interação da interface neural e da exibição holográfica, inaugurando assim o "momento iPhone" dos óculos inteligentes.

# Bem-vindo a seguir a conta pública oficial do WeChat do aifaner: aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.