Uma foto que quase destruiu um pai

Enquanto conversava no trabalho, Mark foi subitamente abordado pela polícia.

Mark era suspeito de ser um agressor sexual visando crianças porque seu telefone continha uma foto dos órgãos sexuais de uma criança. E a polícia descobriu que esta foto realmente veio do filho de Mark…

Uma imagem pervertida de um pedófilo provavelmente está começando a se formar em sua mente.

Não se apresse para ficar com raiva, as coisas rapidamente mudaram. Descobriu-se que esta foto foi tirada depois que o filho de Mark adoeceu, para informar o médico sobre a condição, e Mark nunca divulgou essa foto publicamente.

Então, como a polícia sabia que era o sistema de IA do Google que detectou as fotos no telefone Android de Mark, o identificou como suspeito de crime, denunciou à polícia e desativou sua conta do Google.

Nos Estados Unidos, a popularidade do balde da família do Google é aproximadamente equivalente ao WeChat, o que significa que a operação do Google mata Mark diretamente do online para o offline.

O que é ainda mais assustador é que, como Mark, há muito mais de uma pessoa que foi detectada pela plataforma como anomalia e relatada pelo caminho.

Fotos da consulta online da criança levam-no a ser identificado como criminoso

O filho de Mark desenvolveu inflamação na virilha enquanto aprendia a andar. Devido à grave epidemia, a maioria das pessoas estava em quarentena em casa naquele momento. Mark só podia optar pela consulta online e fornecer fotos da virilha da criança, tentando ajudar o médico a fazer um melhor diagnóstico. O médico também prescreveu a doença com base no descrito condição e as fotos mostradas prescrição.

Mas há um problema com essas fotos: as fotos no telefone Android são sincronizadas automaticamente com a nuvem, e o sistema do Google reconhece essas fotos como CSAM (Child Sexual Abuse Material).

Depois de ser identificado, o uso da internet de Mark foi reduzido pela metade porque ele foi bloqueado. Gmail, a caixa de correio da conta que os usuários usam para fazer login em outras plataformas; Google Fi, a operadora virtual móvel do usuário, que pode ser usada para fazer chamadas e navegar na Internet; Google Fotos, que não pode mais ser acessado, contém fotos de seus membros da família… Selado. Como o Google acha que você é suspeito de crimes sexuais infantis, bloqueou sua conta e chamou a polícia "por você" – depois que a plataforma foi banida, uma denúncia foi enviada ao Centro Nacional para Crianças Desaparecidas e Exploradas (NCMEC), que acionou a polícia investigação.

Dez meses depois, o pai foi notificado pelo Departamento de Polícia de São Francisco, que conduziu uma investigação completa sobre ele com base em uma reportagem fotográfica fornecida pelo Google.

A fim de investigar melhor potenciais criminosos sexuais de crianças, a polícia também emitiu um mandado de busca ao Google para todas as informações da conta de Mark, vídeos, fotos, dados de localização, relatórios de pesquisa na Internet e muito mais. Para Mark, isso é realmente um desastre, e se a investigação policial fosse mais fanática, temo que nem mesmo o trabalho seja feito.

Felizmente, após cuidadosa investigação, a polícia confirmou que o pai não cometeu nenhum crime sexual contra crianças.

O pai é inocente, mas o Google é rígido. Mesmo fornecer um relatório de inocência comprovado pela polícia não permitiu que ele apelasse com sucesso ao Google para recuperar sua conta. As informações da foto que ele deixou em sua conta foram completamente bloqueadas e não podem mais ser vistas. Tudo o que posso ver são os lembretes do Google —

Sua conta foi desativada por conter conteúdo nocivo que viola seriamente as políticas do Google e pode ser ilegal.

É inútil solicitar o desbloqueio, você só pode alterar seu endereço de e-mail, alterar seu número de telefone e começar do zero no mundo digital. O New York Times informou sobre dois usuários comuns que tiraram fotos de órgãos sexuais de crianças para consultas online de seus filhos e foram condenados a contas ilegais.Até hoje, eles não conseguiram recuperar suas contas.

Eles nem são excepcionais. Em 2021, o Google relatou 621.583 casos ao CyberTipLine do NCMEC (Projeto de Denúncia de Abuso Sexual Infantil). O NCMEC notificou a polícia local de 4.260 vítimas em potencial, pedindo à polícia para ajudar na investigação e resgatar as crianças se forem mais prejudicadas.

Parece uma boa história de tecnologia para parar e prevenir o crime a tempo, mas quando essa lista inclui menores que estão apenas pedindo consulta como os filhos de Mark, é uma história triste de “pegue mil e pegue um por engano”.

De todas as áreas de investigação técnica, a única exceção são os crimes sexuais infantis

É que, embora haja um erro, o Google obviamente não pretende alterá-lo. Não apenas não desbloqueia contas de usuários inocentes certificadas pela polícia, mas também não pretende interromper esse mecanismo de censura falho.

A porta-voz do Google, Christa Muldoon, disse: "Seguimos a lei dos EUA para definir o que é um CSAM e usamos uma combinação de tecnologia de correspondência de hash e inteligência artificial para identificá-lo e removê-lo de nossa plataforma. Nossa equipe de especialistas em segurança infantil o revisará. O conteúdo é sinalizado para precisão e os pediatras são consultados para garantir que possamos identificar situações em que os usuários podem procurar aconselhamento médico.”

O problema é que a equipe de revisão do Google não tem formação médica e não necessariamente consulta um pediatra especializado ao revisar todos os casos. Portanto, pode-se dizer que o erro de julgamento é inevitável neste processo, a única coisa que pode reduzir a influência de tal erro é o julgamento das instituições profissionais e a revisão secundária dos órgãos de aplicação da lei.

Mas para aqueles que foram mal julgados, isso é realmente um desastre. Por causa desse erro de julgamento, sua conta importante foi bloqueada; por causa desse erro de avaliação, você foi investigado pela polícia; por causa desses erros de julgamento, as pessoas ao seu redor também podem usar óculos escuros quando o virem.

Jon Callas, diretor de programas de tecnologia da Electronic Frontier Foundation EFF, disse à mídia que a abordagem do Google era intrusiva. "É o pesadelo que todos tememos – eles vão escanear nossos álbuns de família e nós vamos ter problemas."

Mas isso não é apenas um problema para o Google, já que quase todos os gigantes da tecnologia têm sido incomumente agressivos quando se trata de conteúdo CSAM. Assim como o Facebook e o Google, a Amazon possui um mecanismo de inteligência artificial + revisão humana. Descobriu-se que usuários suspeitos excluem ou desativam URLs, imagens e funções de bate-papo conforme apropriado e proíbem contas severamente. Em 2021, a Amazon também enviou 33.848 relatórios de CSAM ao NCMEC . Quanto à privacidade, parece ser ignorada nesta história de crime de combate à tecnologia.

Entre as histórias em defesa da privacidade do usuário, a recusa da Apple em "ajudar o desbloqueio" é a mais impressionante.

Naquela época, houve um grave atentado terrorista a tiros em uma instituição de assistência social nos Estados Unidos, e o assassino foi morto enquanto fugia. Durante a investigação, a polícia descobriu que o assassino se comunicava com o grupo extremista "Estado Islâmico" no Oriente Médio por meio de comunicação criptografada no celular, mas como o celular tinha uma senha, o tribunal só pôde pedir à fabricante do iPhone Apple que ajudar o governo a desbloqueá-lo. Mas a Apple anunciou publicamente sua recusa em cumprir a ordem, citando a proteção da privacidade do usuário: "Se o governo usar o All Writs Act para facilitar o desbloqueio do iPhone, ele terá a capacidade de invadir o dispositivo de qualquer pessoa e obter seus dados, e o governo vai. Essa invasão de privacidade pode ser estendida.”

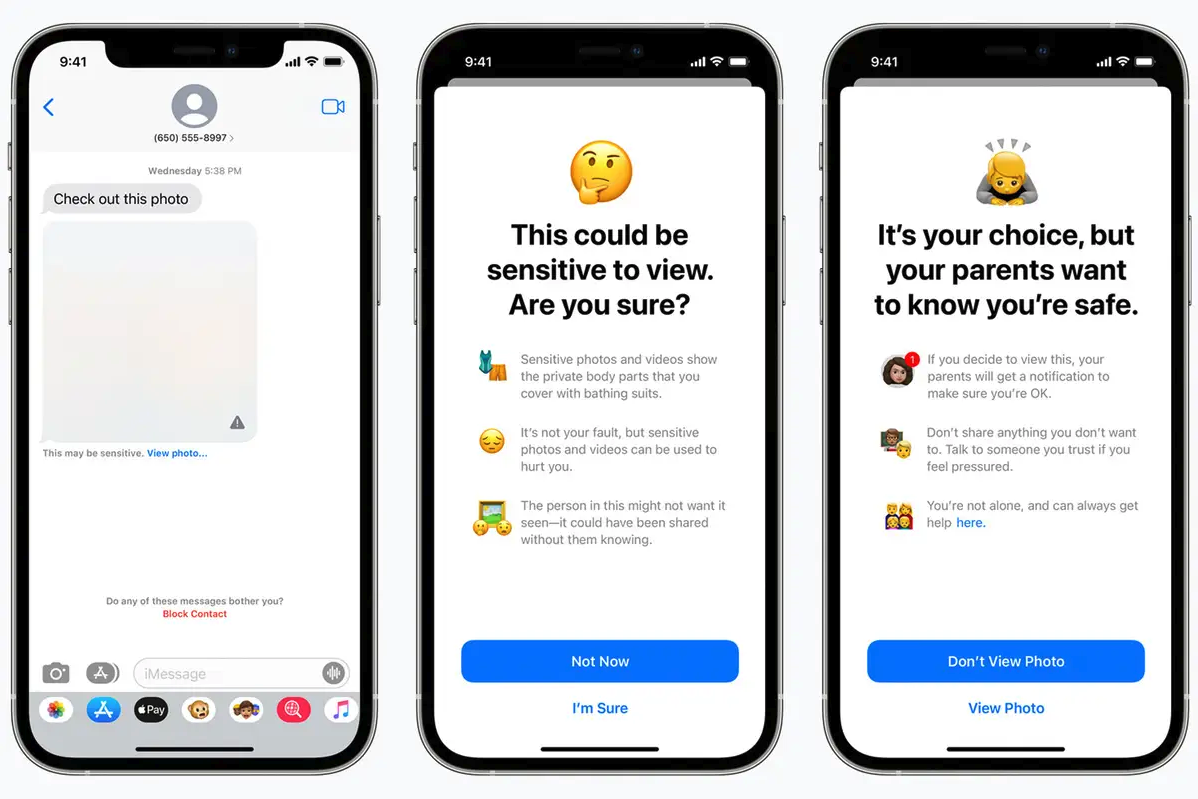

Mas mesmo a Apple, que se recusou justamente a desbloquear os iPhones dos usuários, não se abalou no campo dos crimes sexuais infantis. Assim como o Google, a Apple pensou em usar uma nova ferramenta para escanear as fotos do iCloud de um usuário, que corresponderia ao banco de dados de imagens existente do NCMEC e, se imagens semelhantes suficientes fossem encontradas, seriam entregues a um operador para revisão, o que então notifique o NCMEC.

A Apple também planejava na época introduzir um novo recurso iMessage projetado para "alertar crianças e seus pais quando [crianças] receberem ou enviarem fotos sexualmente explícitas". Crianças menores de 13 anos que receberem ou enviarem imagens avisarão os pais, e todos os usuários infantis também receberão um aviso quando estiverem prestes a receber ou enviar imagens suspeitas de pornografia.

Essa tendência de mudança foi interrompida logo depois, porque a oposição era muito barulhenta. A EFF acredita que a nova mudança pode "abrir uma porta dos fundos para sua vida privada… menos, não melhor, privacidade para todos os usuários do iCloud Photos". , Digitalize qualquer coisa amanhã."

A Apple acabou arquivando a seção de digitalização de imagens, mas manteve a capacidade opcional de incluir contas de crianças no plano de Compartilhamento Familiar. Os pais podem ativar seletivamente a função de análise de fotos para imagens nuas para seus filhos. Se uma imagem nua for detectada, ela ficará desfocada.

Até a Apple quer adicionar o reconhecimento CSAM aos seus próprios produtos, em grande parte porque é uma linha vermelha – seja para usuários comuns, agências de aplicação da lei ou plataformas, eles têm tolerância extremamente baixa para esse assunto.

Isso também significa que, quando você realmente precisa da cooperação técnica de empresas de tecnologia, optar por cooperar primeiro com casos de crimes sexuais infantis ganhará mais apoio público.

Uma atualização da Lei de Segurança Online do Reino Unido pretende exigir que os provedores de serviços de usuário para usuário se esforcem para denunciar qualquer conteúdo compartilhado de exploração e abuso sexual infantil à Agência Nacional de Crimes. A emenda legislativa deixa claro que as empresas devem desenvolver software que possa inspecionar informações, incluindo chamadas criptografadas de ponta a ponta, para detectar proativamente material de agressores sexuais infantis e denunciá-lo às autoridades – ou enfrentar sanções.

É só que a história do Google nos diz que, mesmo que essa função funcione sem problemas, existe o risco de "matar por engano", e cada lesão equivocada causará danos a usuários inocentes. A tecnologia pode não ser capaz de resolver todos os problemas. A inteligência artificial e os algoritmos com os quais estamos familiarizados ainda são muito "simples" diante de problemas sociais difíceis, e é difícil confiar em uma única tecnologia para detectar crimes potenciais ou existentes .

A intervenção da tecnologia pode até trazer novos problemas ao ambiente originalmente difícil, mas não é necessariamente um bom resultado se a intenção original for boa. Afinal, às vezes o caminho para o inferno é pavimentado com boas intenções.

A imagem do título vem de "Internet Purgatory: Expose Room N"

#Bem-vindo a prestar atenção à conta oficial do WeChat de Aifaner: Aifaner (WeChat: ifanr), mais conteúdo interessante será trazido para você o mais rápido possível.