Trump se apaixona por uma faxineira: a internet está enganando a todos. Até a IA está sendo enganada. Em quem posso confiar?

Se você não foi bombardeado com uma esquete chamada "Trump se apaixona por mim, uma faxineira da Casa Branca" ultimamente, parabéns, você pode ser o único que não foi enganado.

O título deste drama por si só já parece um romance cafona e descolado, e o cenário da trama também é mágico o suficiente: o presidente americano Trump se apaixona por Emily, uma faxineira da Casa Branca, e está pronto para abandonar sua esposa supermodelo Melania e se casar com Emily como primeira-dama. É realmente uma "versão americana de A Lenda de Zhen Huan + Cérebro Amoroso da Casa Branca".

A notícia inundou instantaneamente todas as principais plataformas de mídia social. Muitos veículos de comunicação importantes, incluindo influenciadores que geralmente parecem bastante criteriosos, começaram a republicar a história, alegando que o curta-metragem, que havia se tornado um sucesso viral no exterior, havia arrecadado US$ 150 milhões em três meses e se tornado um novo favorito entre mulheres de meia-idade e mais velhas.

Mas logo a trama deu uma guinada de 180 graus, e foi confirmado que o curta não existia e era uma completa fake news do começo ao fim.

Então, a questão é: como um programa que ninguém tinha visto se tornou uma sensação viral em apenas alguns dias? E como a IA alimentou o hype, fazendo com que ainda mais pessoas acreditassem nessa notícia inexistente?

O que exatamente aconteceu por trás disso?

Como um curta-metragem estrangeiro inexistente enganou humanos e IA?

Se você acha que isso é apenas um mal-entendido, você subestima a complexidade dessa comunicação.

De acordo com diversas fontes, esse incidente de fake news remonta a 1º de julho, quando um artigo foi publicado por uma conta de mídia própria chamada "Overseas Student Daily". A seleção de tópicos da conta é especializada em "curiosidade" e atração de tráfego. A julgar pelo estilo da linguagem e pela lógica do conteúdo, o artigo provavelmente foi gerado com o auxílio de uma ferramenta de escrita de IA e, em seguida, revisado manualmente.

O problema é que, apesar de ser um veículo de mídia independente padrão, é frequentemente republicado e citado por veículos de mídia nacionais estabelecidos. Em 23 de julho, o Shin Min Daily News, uma subsidiária da Lianhe Zaobao de Singapura, publicou um artigo intitulado "Curtas-metragens de CEOs de Overlords Chineses Estão Chegando à América".

A reportagem era bastante detalhada, afirmando que Trump havia desistido de sua esposa modelo, Melania, e se casaria com uma mãe solteira asiática que limpava a Casa Branca como primeira-dama. Chegou a afirmar que o programa havia arrecadado US$ 150 milhões em três meses. O público feminino de meia-idade e idosos xingava e gastava dinheiro no programa, e enquanto xingavam, pagavam para assistir.

▲ O relatório foi excluído

Considerando que Lianhe Zaobao é uma mídia com alta credibilidade na internet chinesa, essa notícia foi amplamente repassada pela mídia nacional, e vários blogueiros de vídeo curto a interpretaram… Um ciclo fechado de confiança perfeito de "exportação para vendas nacionais" foi formado.

Além disso, uma enxurrada de vídeos curtos e autênticos e reportagens gráficas também se espalhou rapidamente nas plataformas de mídia social estrangeiras. Essa "esquete falsa" começou a ser divulgada como "notícia real", com usuários ao redor do mundo acreditando, discutindo e até mesmo usando-a para criticar as diferenças estéticas entre a China e os Estados Unidos.

Todo mundo estava falando seriamente sobre algo que não existia.

Até que alguns veículos de comunicação perceberam que algo estava errado e começaram a investigar. O programa não estava disponível em nenhuma plataforma internacional (incluindo ReelShort, YouTube e TikTok) e também não estava no IMDb, o principal banco de dados de cinema e televisão do mundo.

Além disso, executivos de importantes produtoras nacionais de curtas-metragens que foram exportadas para o exterior se manifestaram para refutar os rumores. Por exemplo, Li Yuanjun, vice-presidente da "Tinghuadao", declarou categoricamente que eles jamais tocariam em tais gêneros. As principais evidências que sustentam a notícia falsa também foram desmascaradas, uma a uma.

A primeira imagem, um segmento satírico do programa de variedades "Saturday Night Live", foi desmascarada pessoalmente pelo ator Run Run Shaw. A segunda, uma foto de Trump com uma mulher asiática, é incrivelmente falsa; toda a imagem tem uma aparência plástica, semelhante à de uma IA.

▲Rede de fontes de imagens

Se você voltar um pouco no tempo, encontrará títulos interessantes semelhantes já ativos em plataformas sociais:

"Quando a Guerra Civil estourou, Lincoln me pediu para sair da aposentadoria três vezes!" "Viajei pelo tempo e espaço até o 11 de setembro, veja como salvei as Torres Gêmeas"… Esses são obviamente títulos de romances legais, mas, por algum motivo, foram passados de uma pessoa para dez, e de dez para cem, e foram transformados em curtas-metragens internacionais.

▲Captura de tela da Internet

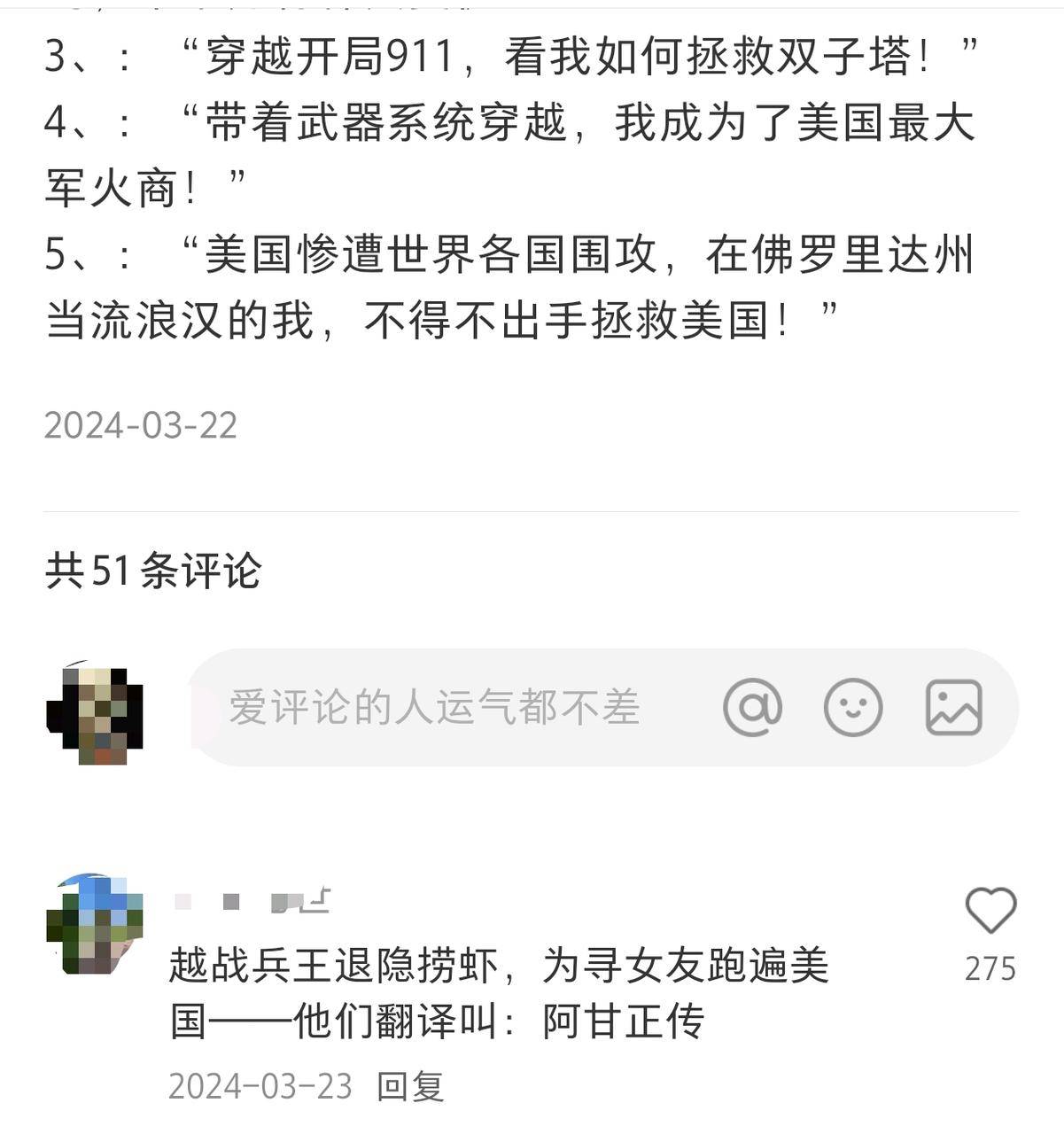

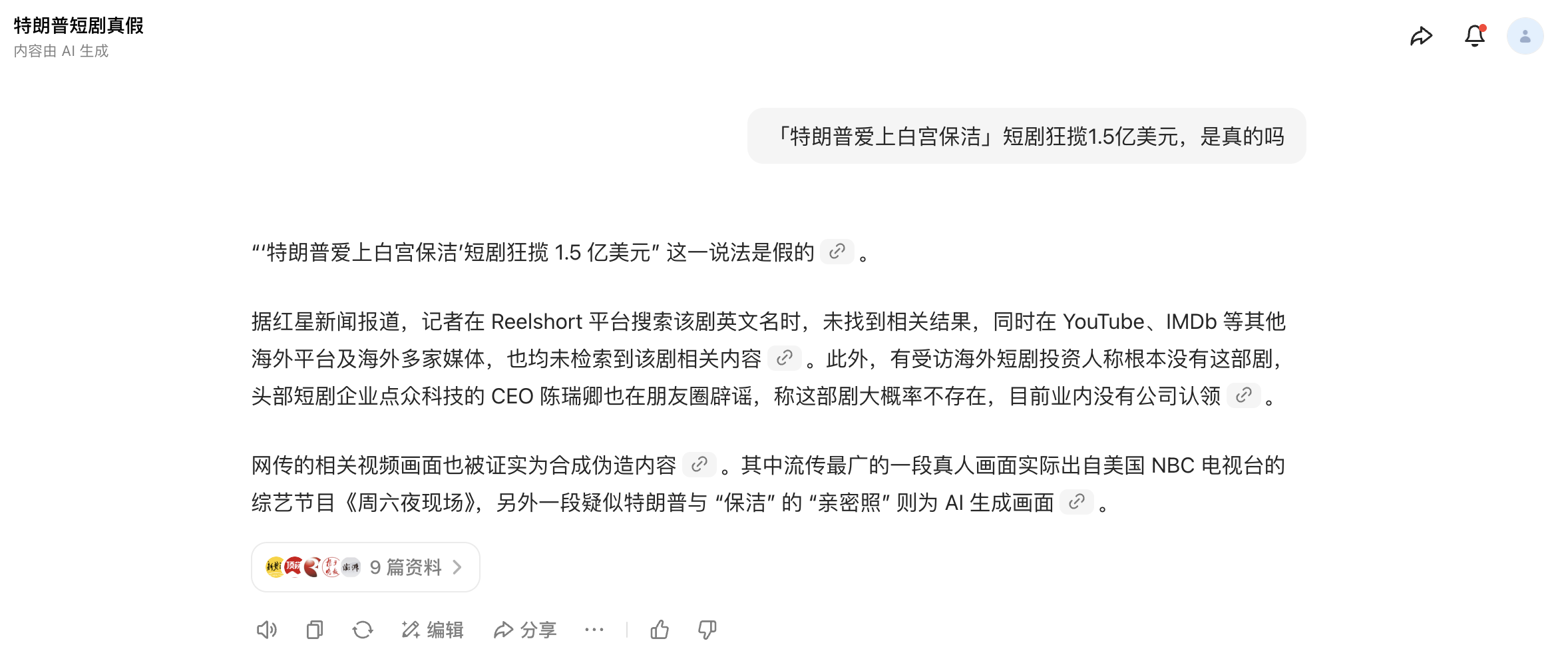

Curiosamente, até a IA acreditou no boato antes que ele fosse desmascarado.

Antes que o incidente fosse oficialmente desmascarado por um grande número de veículos de comunicação, tentei verificar a autenticidade do curta usando diversas ferramentas de IA comumente usadas. Eles ainda afirmavam com segurança que "esse drama existe", e o motivo ainda era a verificação cruzada do conteúdo com imagens e textos de veículos de comunicação confiáveis em diversas plataformas.

Claro, como um grande número de veículos de comunicação começou a desmascarar o boato ontem à tarde, essas ferramentas de IA atualizaram as últimas notícias e podem identificar corretamente que se trata de uma notícia falsa.

Costumamos dizer que a busca por IA tem um problema de "alucinação" porque às vezes ela gera respostas aparentemente razoáveis, mas completamente erradas, do nada.

Para "enjaular" as ilusões da IA, os fabricantes têm feito inúmeros esforços técnicos: fortalecendo os mecanismos de citação, introduzindo fontes confiáveis e limitando a liberdade de ação do modelo. No entanto, quando a base para as avaliações de veracidade das notícias pela IA já é derivada de notícias falsas, essas medidas podem não ser eficazes.

Se nem humanos nem IA são confiáveis, em que mais podemos confiar?

Se você pensar bem, é difícil dizer que a popularidade dessas notícias falsas seja acidental. Embora a história pareça absurda, ela tem o gene perfeito para se espalhar.

Ele tem a fórmula clássica de todo conteúdo popular: estrutura narrativa clara, materiais ilustrados, dados compactados e ritmo de disseminação preciso.

Esquetes cafonas estão viralizando no exterior? Americanos de meia-idade e mais velhos estão viciados em temas excêntricos? O TikTok está se tornando uma exportação cultural? Cada uma dessas suposições é plausível e, quando colocadas juntas, são difíceis de descartar como falsas.

Além disso, quando a IA se torna vítima e disseminadora de boatos, isso geralmente se deve à manipulação e promoção maliciosas por humanos. Em particular, a maior parte desse conteúdo gerado por IA compartilha várias características comuns:

O custo de produção é extremamente baixo, e um roteiro pode produzir um produto finalizado em apenas alguns minutos; a capacidade de disseminação é extremamente forte, e a taxa de cliques permanece alta devido à combinação de títulos clickbait e impacto visual; a narrativa é extremamente atraente, atacando especificamente as fraquezas humanas, e usa conteúdo inspirador, sensacionalista e curioso de todas as maneiras possíveis para estimular as pessoas.

O recente incidente "Desculpas da DeepSeek a Wang Yibo" é um exemplo típico. Uma reportagem intitulada "Caso do Ator Wang Yibo, Veredito Anunciado" alegou que a DeepSeek havia emitido um pedido de desculpas pela distribuição indevida de informações sobre Wang Yibo e anexou um suposto "veredito criminal" como prova.

No entanto, após várias rodadas de checagem de fatos, descobriu-se que a suposta declaração de desculpas era, na verdade, conteúdo gerado automaticamente por IA, induzido por internautas. No entanto, devido à sua formulação profissional, estrutura completa e tom sério, alguns veículos de comunicação a divulgaram erroneamente como um anúncio real sem verificação, causando mal-entendidos e disseminação generalizada.

Casos semelhantes estão se tornando cada vez mais comuns. Conteúdo gerado por IA permeou a internet, especialmente no âmbito multimodal. Inicialmente, houve imenso entusiasmo com a capacidade da IA de gerar imagens realistas, mas, posteriormente, surgiram cada vez mais casos em que "começam com uma única imagem e depois inventam o resto", dificultando a distinção entre autenticidade e falsificação.

Por exemplo, algumas pessoas usam ferramentas de IA, como o ChatGPT, para gerar fotos ou vídeos falsos de produtos intactos (frutas, roupas, necessidades diárias, etc.) que parecem danificados, mofados ou manchados, e então solicitam reembolsos maliciosos fingindo que os produtos são problemáticos, fazendo com que um grande número de comerciantes percam seus produtos e seu dinheiro.

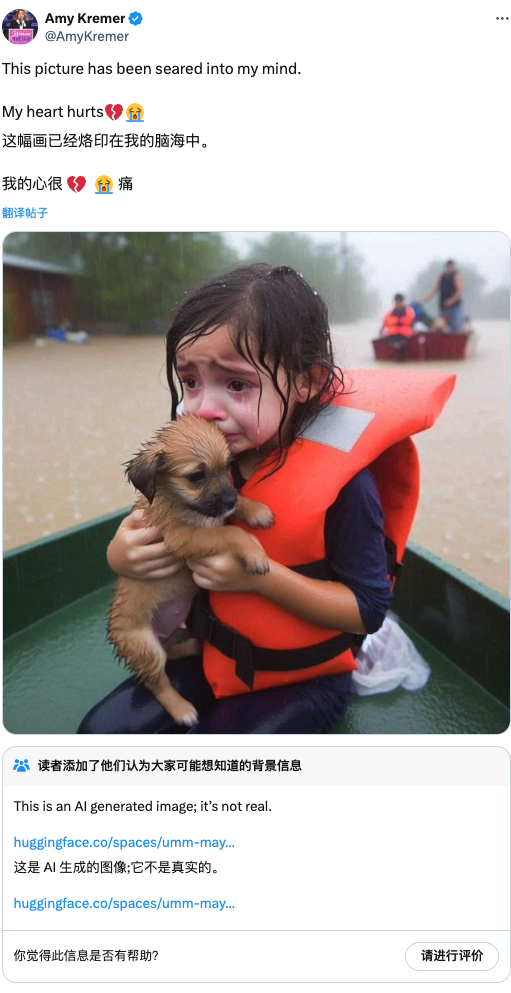

Nos relatórios de desastres, também podemos ver que a IA está começando a aparecer com frequência no conhecimento do público.

No ano passado, quando a Flórida foi atingida por um furacão, a foto de uma garotinha em prantos, de colete salva-vidas, segurando um cachorrinho em um bote salva-vidas, viralizou nas redes sociais. No entanto, a plataforma acabou confirmando que a imagem foi gerada por IA, drenando desnecessariamente a compaixão das pessoas de bom coração.

Por exemplo, no final de outubro do ano passado, a região de Valência, na Espanha, sofreu chuvas torrenciais. Quando as águas finalmente recuaram, a cena abaixo apareceu. No entanto, à medida que mais e mais conteúdo se tornava difícil de verificar, o público começou a ver tudo com desconfiança. Ao ver esta foto, a primeira reação de muitas pessoas foi: "Isso deve ter sido criado por IA. É fake news."

À medida que o jogo do "alerta falso" continua a se expandir, as notícias que realmente refletem e relatam situações perigosas são atribuídas à "IA fazendo isso", perdendo assim o melhor momento para o resgate, o que também é uma consequência ruim.

Ao mesmo tempo, a dificuldade de governança do conteúdo da plataforma também está aumentando rapidamente.

Em um relatório de governança divulgado em fevereiro, Toutiao mencionou que, somente no ano passado, interceptou mais de 5 milhões de informações falsas, processou 930.000 peças de conteúdo de baixa qualidade por meio de IA e penalizou 7,81 milhões de postagens homogêneas.

Em alguns relatos da mídia, também vimos o surgimento de uma cadeia completa da indústria de fabricação de conteúdo de IA: fábricas de conteúdo produzindo artigos de IA em massa, empresas de marketing usando ferramentas de IA para empacotá-los e promovê-los, e equipes de SEO pesquisando como fazer com que o conteúdo de IA tenha uma classificação mais alta nos mecanismos de busca.

Todos eles estão estudando o mesmo tópico: como criar conteúdo no qual a IA tenha mais probabilidade de acreditar e como tornar mais fácil para os humanos acreditarem no conteúdo criado pela IA.

Em junho passado, surgiu uma reportagem online alegando uma grande explosão em Xi'an, incluindo a hora e o local. No entanto, a polícia de Xi'an verificou a informação e não encontrou tal evento. A reportagem foi publicada a partir de uma conta pertencente a uma agência da MCN.

Após ser preso pela polícia, o principal culpado confessou ter usado uma ferramenta de IA. Ao receber um comando, a ferramenta rastreava automaticamente artigos relevantes na internet e gerava textos com centenas a milhares de palavras.

Em seu auge, de 4.000 a 7.000 informações podem ser geradas em um único dia, com quase nenhum envolvimento humano em todo o processo. Ele seleciona especificamente tópicos e eventos relacionados à vida das pessoas e que são altamente populares. Estudos demonstraram que informações negativas, deprimentes e emocionalmente estimulantes têm maior probabilidade de capturar a atenção das pessoas, o que é determinado pela estrutura das áreas dos lobos parietal e frontal.

Quando essas "informações falsas" altamente interativas e facilmente dissemináveis são frequentemente citadas, encaminhadas e indexadas, modelos de IA desavisados também as tratam como corpus para aprendizado e as incorporam em seus mecanismos de geração. Isso cria um ciclo fechado entre a IA e os humanos:

Humanos usam IA para criar informações falsas → IA aprende informações falsas → IA espalha informações falsas → Mais humanos acreditam nas informações falsas → As informações falsas se tornam "fatos estabelecidos" → Nova IA continua a aprender esses "fatos"…

Esse ciclo se repete, formando uma espiral de boatos. A cada volta, a verdade se dilui, enquanto as mentiras se tornam mais sofisticadas e difíceis de detectar. Humanos não são confiáveis, e as alegações da IA são igualmente duvidosas. Nosso julgamento restante se torna nossa última linha de defesa.

Entretanto, em uma era de sobrecarga de informações, nosso julgamento está sendo corroído por vários fatores: o preconceito nos faz acreditar apenas em informações que estão de acordo com nossa cognição existente; os casulos de informação nos fazem perder uma perspectiva mais abrangente; e a comunicação emocional também torna o pensamento racional escasso.

Talvez a maior verdade desta chamada era pós-verdade seja que a maioria das "verdades" é questionável. A próxima esquete "Trump se apaixona pelo zelador", em particular, pode já estar a caminho, e promete ser ainda mais escandalosa e difícil de desmascarar do que esta.

#Bem-vindo a seguir a conta pública oficial do WeChat do iFaner: iFaner (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.