ToF vs. LiDAR: Qual é a diferença?

Ultimamente, tem havido tanto burburinho em torno do LiDAR nos novos dispositivos da Apple que é fácil esquecer que a Realidade Aumentada móvel pode funcionar de qualquer outra maneira. Mas pode e faz, especialmente com as ferramentas ToF atingindo novos patamares nos telefones Samsung.

Seja você um desenvolvedor, procurando um novo dispositivo no mercado ou apenas curioso, vale a pena despender algum tempo para desempacotar essas siglas e aprender os meandros do sensor de profundidade em telefones celulares.

O que é ToF?

ToF é a abreviatura de Time of Flight.

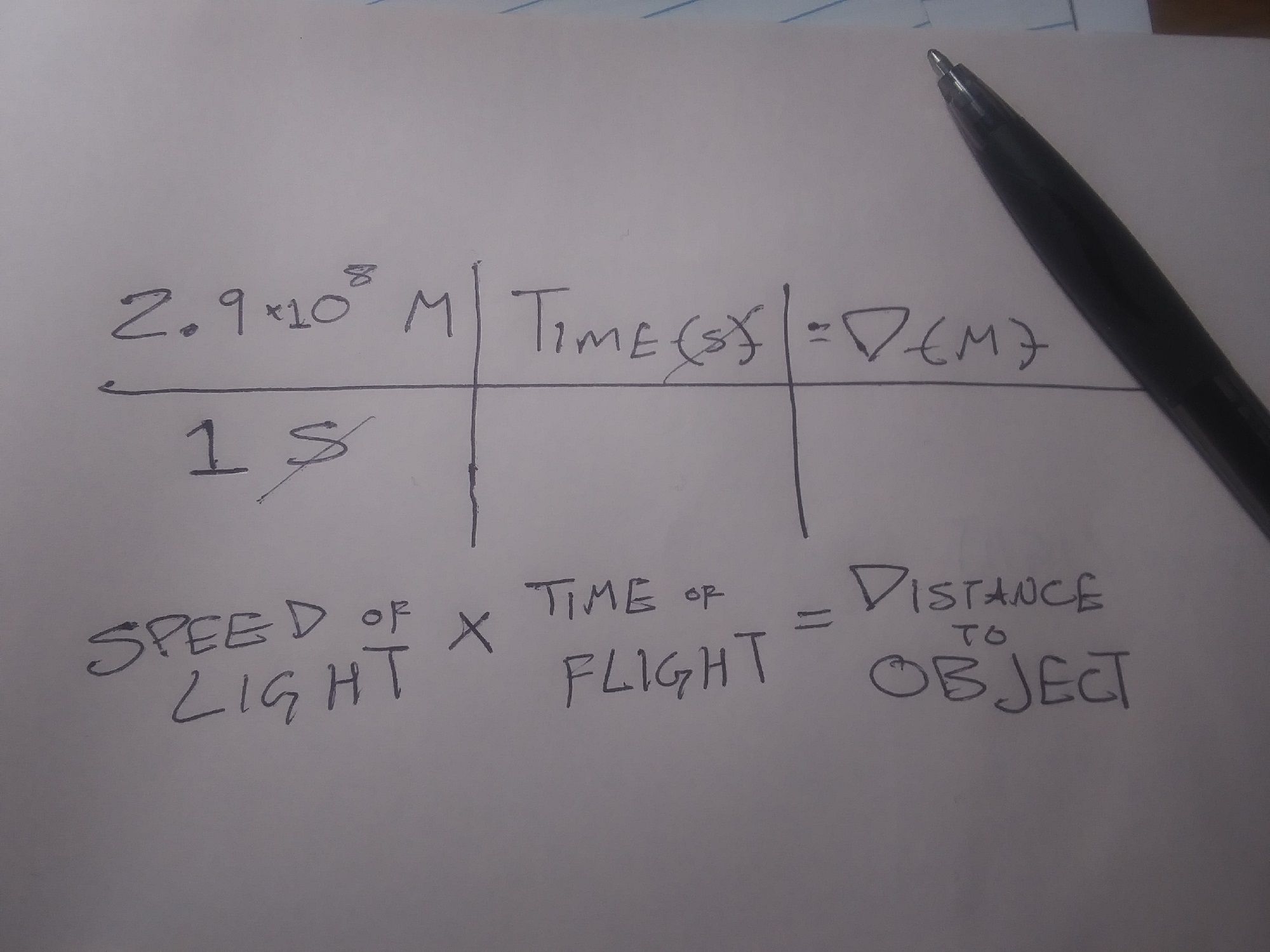

Tecnicamente, ToF se refere ao uso da velocidade da luz (ou mesmo do som) para determinar a distância. Ele mede o tempo que leva para a luz (ou som) deixar o dispositivo, ricochetear em um objeto ou plano e retornar ao dispositivo, tudo dividido por dois revela a distância do dispositivo ao objeto ou plano.

Então, a relação é que todo LiDAR é um tipo de Time of Fight, mas nem todo Time of Flight é LiDAR. Para manter as coisas simples, quando falamos sobre "ToF", queremos dizer medição de distância óptica, sem incluir LiDAR.

Então, se o LiDAR e o não-LiDAR ToF óptico usam luz para determinação de distância e mapeamento 3D, como eles são diferentes?

O que é LiDAR?

LiDAR é a abreviação de Light Detection and Ranging . Essa tecnologia usa um laser, ou uma grade de lasers, como fonte de luz na equação detalhada acima.

Uma única leitura de LiDAR pode ser usada para medir coisas como a largura de uma sala, mas várias leituras de LiDAR podem ser usadas para criar "nuvens de pontos". Eles podem ser usados para criar modelos tridimensionais de objetos ou mapas topográficos de áreas inteiras.

Embora o LiDAR possa ser novo para dispositivos móveis, a tecnologia em si já existe há um bom tempo. Em ambientes não móveis, o LiDAR é usado para fazer tudo, desde mapear ambientes subaquáticos até descobrir sítios arqueológicos.

Quais são as diferenças entre o LiDAR e o ToF?

A diferença funcional entre o LiDAR e outras formas de ToF é que o LiDAR usa lasers pulsados para construir uma nuvem de pontos, que é então usada para construir um mapa ou imagem 3D. Os aplicativos ToF criam "mapas de profundidade" com base na detecção de luz, geralmente por meio de uma câmera RGB padrão.

A vantagem do ToF sobre o LiDAR é que o ToF requer equipamentos menos especializados, de modo que pode ser usado com dispositivos menores e mais baratos. O benefício do LiDAR vem da facilidade com que um computador pode ler uma nuvem de pontos em comparação com um mapa de profundidade.

A API de profundidade que o Google criou para dispositivos Android funciona melhor em dispositivos habilitados para ToF e funciona criando mapas de profundidade e reconhecendo "pontos de recursos". Esses pontos característicos, muitas vezes barreiras entre diferentes intensidades de luz, são então usados para identificar diferentes planos no ambiente. Isso basicamente cria uma nuvem de pontos de baixa resolução.

Como o ToF e o LiDAR funcionam com o Mobile AR

Mapas de profundidade e nuvens de pontos são legais e, para algumas pessoas e aplicativos, são suficientes. No entanto, para a maioria dos aplicativos de AR, esses dados devem ser contextualizados. Tanto o ToF quanto o LiDAR fazem isso trabalhando em conjunto com outros sensores no dispositivo móvel. Especificamente, essas plataformas precisam entender a orientação e o movimento do seu telefone.

Compreender a localização do dispositivo dentro de um ambiente mapeado é chamado de Localização e Mapeamento Simultâneo ou "SLaM". SLaM é usado para outros aplicativos, como veículos autônomos , mas é mais necessário para aplicativos AR baseados em dispositivos móveis para colocar objetos digitais no ambiente físico.

Isso é particularmente verdadeiro para experiências que permanecem no lugar quando o usuário não está interagindo com elas e para colocar objetos digitais que parecem estar atrás de pessoas e objetos físicos.

Outro fator importante na colocação de objetos digitais em aplicativos baseados em LiDAR e ToF envolve "âncoras". Âncoras são pontos digitais no mundo físico aos quais os objetos digitais são "fixados".

Em aplicativos de escala mundial como o Pokémon Go, isso é feito por meio de um processo separado denominado "geotagging". No entanto, em aplicativos AR baseados em dispositivos móveis, o objeto digital é ancorado em pontos em uma nuvem de pontos LiDAR ou em um dos pontos de recursos em um mapa de profundidade.

O LiDAR é melhor do que o ToF?

A rigor, o LiDAR é mais rápido e preciso do que o tempo de voo. No entanto, isso se torna mais significativo com aplicativos mais avançados tecnologicamente.

Por exemplo, o ToF e a API de profundidade do Google têm dificuldade em entender planos grandes e de textura baixa, como paredes brancas. Isso pode tornar difícil para os aplicativos que usam esse método posicionar objetos digitais com precisão em algumas superfícies do mundo físico. Os aplicativos que usam LiDAR são menos propensos a ter esse problema.

No entanto, os aplicativos que envolvem ambientes maiores ou mais variados texturalmente provavelmente não terão esse problema. Além disso, a maioria dos aplicativos de AR para consumidores baseados em dispositivos móveis envolvem o uso de um filtro de AR no rosto ou corpo do usuário – um aplicativo que dificilmente apresentará problemas devido a grandes superfícies não texturizadas.

Por que a Apple e o Google usam sensores de profundidade diferentes?

Ao lançar seus dispositivos compatíveis com LiDAR, a Apple disse que incluiu os sensores, bem como outros hardwares com o objetivo de "abrir mais fluxos de trabalho profissionais e oferecer suporte a aplicativos profissionais de foto e vídeo". O lançamento também chamou seu iPad Pro compatível com LiDAR "o melhor dispositivo do mundo para realidade aumentada" e elogiou os aplicativos de medição da Apple.

O Google não deu explicações tão diretas sobre por que sua API Depth e a nova linha de dispositivos de suporte não usam LiDAR. Além de contornar o LiDAR, mantendo os dispositivos Android mais leves e mais acessíveis, há também uma grande vantagem de acessibilidade.

Como o Android funciona em dispositivos móveis feitos por várias empresas, o uso do LiDAR favoreceria os modelos compatíveis com o LiDAR em detrimento de todos os outros. Além disso, como requer apenas uma câmera padrão, a API Depth é compatível com versões anteriores de mais dispositivos.

Na verdade, a API Depth do Google é independente de dispositivos, o que significa que os desenvolvedores que usam a plataforma de criação de experiência AR do Google podem desenvolver experiências que funcionam em dispositivos Apple também.

Você já explorou a detecção de profundidade?

Este artigo se concentrou principalmente em LiDAR e ToF em experiências de RA baseadas em dispositivos móveis. Isso ocorre principalmente porque essas experiências mais complexas exigem mais explicações. É também porque essas experiências são as mais divertidas e promissoras.

No entanto, abordagens de detecção de profundidade como essas são a base de muitas experiências e ferramentas mais simples e práticas que você pode usar todos os dias sem se preocupar muito. Esperançosamente, a leitura de ToF e LiDAR proporcionará a você um pouco mais de apreciação por esses aplicativos.