Tecnologia de interface cérebro-computador, interruptor que muda vidas

A consciência está clara, a percepção está clara, mas é impossível mover-se.

Ao assistir “Get Out”, o que mais me impressionou foi a cena descrita na história caindo em um “lugar submerso”, que é uma espécie de desamparo “verdadeiramente involuntário”.

Inesperadamente, este estado também é “normal” para algumas pessoas.

A “síndrome do encarceramento”, também conhecida como “LIS”, é exatamente como o nome.

Você tem cognição plena, suas habilidades perceptivas são sólidas, você tem todos os cinco sentidos, mas está preso em um corpo sem qualquer movimento muscular.

Aos 30 anos, Ann Johnson ficou gravemente paralisada devido a um acidente vascular cerebral repentino, perdeu o controle dos músculos do corpo e não conseguia nem respirar de forma independente.

Nos anos seguintes, Ann gradualmente reaprendeu o controle muscular por meio da reabilitação – ela aprendeu a respirar sozinha, a controlar os músculos do pescoço e até agora ri e chora.

Este ano, com a combinação da interface cérebro-computador e da tecnologia de IA, Ann “diáloga” novamente com o marido pela primeira vez em 18 anos desde que ficou paralisada.

"Digitação mental", há realmente mais de uma maneira

Na conferência Neuralink do ano passado, a empresa mostrou o macaco Sake digitando “posso comer um lanche”, letra por letra, no teclado virtual da tela.

Claro, Sake não entende inglês, muito menos ortografia, basta controlar o cursor na tela através do cérebro, deixá-lo cair no botão indicado pelo bloco colorido e completar a chamada “digitação”.

Esta apresentação também está relacionada ao método inicial de "digitação" da interface cérebro-computador.

Anteriormente, no campo da tecnologia de comunicação linguística, as interfaces cérebro-computador concentravam-se principalmente na produção ortográfica de "uma letra por uma letra".

Nos últimos anos, o campo desenvolveu-se rapidamente e várias equipes de pesquisa começaram a adotar modos de produção mais “naturais”.

Em 2021 , uma equipe de pesquisa da Universidade da Califórnia, em São Francisco, decifrou com sucesso o sinal cerebral responsável por desencadear movimentos do trato vocal no cérebro de um paciente, permitindo que o paciente “pensasse” uma palavra completa de cada vez.

Esta técnica pode produzir 18 palavras por minuto (de um vocabulário total de 50) com uma taxa de precisão de 93%. Na vida diária, os falantes de inglês usam de 150 a 200 palavras por minuto na comunicação diária.

Embora seja apenas 1/10 da velocidade normal, esta pesquisa prova que é viável produzir palavras completas em vez de letra por letra, e está mais de acordo com os hábitos de comunicação das pessoas.

Essa pesquisa causou sensação no mundo acadêmico e também alcançou Ann no Canadá.

Este ano, Ann ajudou a equipe da UC a levar essa pesquisa a novos patamares – a produção de palavras saltou para quase 80 palavras por minuto.

No novo estudo, a equipe de pesquisa implantou um chip de silício com 253 eletrodos na superfície do cérebro de Ann, aproximadamente do tamanho de um cartão de crédito.

Esses eletrodos interceptam os sinais cerebrais que de outra forma controlariam os lábios, a língua, a mandíbula, a garganta e os músculos faciais de Ann e os enviariam de volta ao computador. Em seguida, o computador analisará o texto correspondente por trás desses sinais por meio de algoritmos de IA.

Nas semanas seguintes, Ann e a equipe de pesquisa começaram a treinar o modelo de linguagem – “falando” 1.024 palavras repetidas vezes até que o algoritmo pudesse reconhecer os sinais cerebrais relevantes.

Vale ressaltar que o que a equipe de pesquisa pediu à IA para reconhecer desta vez não foi o sinal da pronúncia completa da palavra, mas sim o reconhecimento da unidade menor da fala – o fonema.

Por exemplo, existem quatro fonemas na palavra “Hello”: “HH”, “AH”, “L” e “OW”.

A equipe de pesquisa disse que depois de usar fonemas como unidade de reconhecimento, o algoritmo só precisa aprender 39 fonemas para analisar todas as palavras em inglês e pode melhorar a precisão e a velocidade da análise do sistema.

Curiosamente, no mesmo dia em que a equipa da Universidade da Califórnia publicou o artigo, a equipa de investigação da Universidade de Stanford também publicou um relatório de investigação semelhante na "Nature".

O projeto de Stanford envolveu Pat Bennett, de 68 anos, que foi diagnosticado com ELA em 2012 e não consegue se comunicar com clareza.

Pat levou quase meio ano para treinar o sistema. O algoritmo também reconhece fonemas e produz cerca de 62 palavras por minuto.

Quanto à taxa de precisão, quando o número total de palavras é 50, a taxa de precisão pode chegar a 90%, mas quando o vocabulário é ampliado para 12.500 palavras, a taxa de precisão é de 76%.

Embora a técnica de Ann tenha uma taxa de produção mais alta, quando seu vocabulário é expandido para 1.024 palavras, a taxa média de precisão também é de cerca de 76%.

A revista Nature comentou que os participantes de ambos os estudos tinham controle sobre os músculos faciais e a vocalização em graus variados, por isso é incerto se essas técnicas seriam úteis em pacientes que não têm nenhum controle muscular remanescente.

Em segundo lugar, os sistemas de equipamento de ambos os programas “ainda são demasiado complexos para os cuidadores utilizarem em casa sem exigir formação e manutenção extensas”.

Jaimie Henderson, que trabalhou no projeto de Pat, concorda que “tecnologias implantáveis e colocadas cirurgicamente” ainda existirão nos próximos anos, mas ele vê isso como uma forma de as pessoas com ELA recuperarem uma forma importante de adquirir habilidades de comunicação.

Da “digitação” ao “diálogo”, o que buscamos?

Isto pode parecer inacreditável, mas Ann espera tornar-se consultora no futuro e usar a sua experiência de recuperação para ajudar pacientes semelhantes :

Quero que os pacientes aqui me vejam e entendam que suas vidas não acabaram.

Quero mostrar-lhes que uma deficiência não tem de nos impedir de fazer coisas que queremos ou de nos impedir.

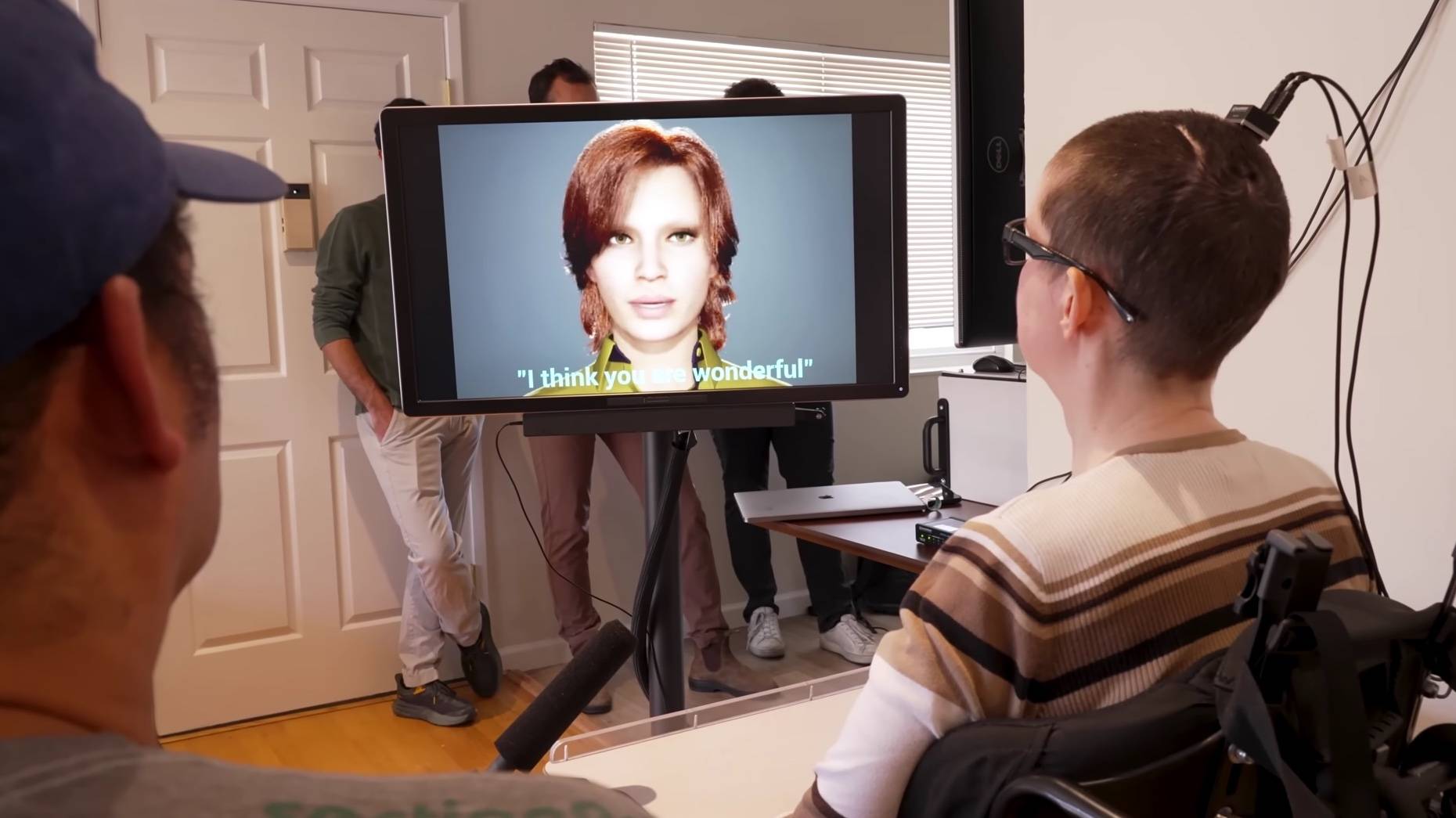

Embora o conteúdo da “falação mental” de Ann e Pat seja apresentado na mesma tela, o conteúdo de Ann tem um avatar digital adicional que pode “falar”.

Este avatar digital moverá as características faciais em tempo real e apresentará expressões de acordo com os sinais cerebrais gerados quando Ann tenta falar.

A voz sintética do avatar digital foi treinada em imagens de vídeo de Ann falando em um casamento há mais de uma década.

Tudo isso para tornar todo o processo de comunicação mais natural. Para Ann que deseja se tornar consultora no futuro, esta também é uma forma confortável de se comunicar com futuros clientes.

Quando Ann usou pela primeira vez o sistema para falar e mover o rosto do seu avatar digital, eu sabia que havíamos feito algo que faria uma diferença real.

Kaylo Littlejohn, pesquisadora do projeto, disse.

No vídeo introdutório, Ann e seu marido Bill tiveram a primeira conversa em 18 anos por meio desse sistema, conversando sobre a vida cotidiana.

– Olá, como está tudo?

– Olá Ana, está tudo bem. Como você acha que será o desempenho do “Toronto Blue Jays” (time de beisebol) hoje?

– tudo é possível.

– Parece que você tem pouca confiança neles.

– sim.

– Parece que teremos que assistir para descobrir.

Na opinião de Ann, ouvir “minha” voz novamente depois de muitos anos também é uma experiência maravilhosa, “como ouvir a voz de um velho amigo”.

No dia do teste, Ann mal podia esperar que a filha ouvisse o som.

Sua filha tinha 6 meses quando ficou doente. A mãe, em sua impressão, sempre foi uma voz feminina mecânica com sotaque britânico gerado por um dispositivo de entrada invertido.

▲ Uma foto de Ann e sua filha

Além de tornar a comunicação diária mais natural, a participação neste projeto deu a Ann um renovado sentido de propósito e significado:

Quando eu estava em um hospital de reabilitação, os fonoaudiólogos não tinham nada a ver comigo.

Ao fazer parte desta pesquisa, sinto que estou dando uma contribuição à sociedade.

Sinto que tenho um emprego novamente.

É um milagre ter sobrevivido tanto tempo; este projeto me permite viver verdadeiramente enquanto estou vivo!

A boa notícia é que a equipe também planeja avançar na pesquisa e tornar o sistema uma versão sem fio, para que Ann não precise depender de cabos para se conectar ao sistema de interface cérebro-computador:

Se pacientes como Ann puderem usar essa tecnologia para controlar livremente computadores e telefones celulares, isso melhorará muito sua independência e capacidade de interação social.

Na verdade, quer se trate da utilização de interfaces cérebro-computador para restaurar a comunicação ou a mobilidade, o objectivo final destas tecnologias é restabelecer a independência e autonomia do paciente.

A má notícia é que, às vezes, quanto melhor a tecnologia, mais doloroso é perdê-la.

Pessoas cujas interfaces cérebro-computador foram removidas à força

Embora a interface cérebro-computador seja uma área cheia de riscos desconhecidos, o potencial que demonstra também é excitante.

Além de liberar "palavras presas no cérebro", a tecnologia de interface cérebro-computador pode agora permitir que pacientes paralisados se movam novamente , tratar a depressão , controlar a epilepsia , reduzir tremores em pacientes com doença de Parkinson e melhorar a qualidade de vida de muitos pacientes.

Em 2016, havia apenas cerca de 340 estudos relacionados a interfaces cérebro-computador . Em 2021, esse número aumentou para quase 600.

Por trás disso está o surgimento de computadores cada vez mais poderosos, o desenvolvimento da IA e dos dispositivos inteligentes que os humanos estão tornando cada vez menores.

Mas o que falta é a proteção dos usuários.

Eu sinto que posso fazer qualquer coisa.

Depois de receber uma interface cérebro-computador implantada, Rita Leggett, de 62 anos, pode saber de antemão que terá epilepsia , e tomar remédios pode evitar que a epilepsia aconteça.

Posso dirigir, posso conhecer pessoas e sou mais capaz de tomar boas decisões.

Em 2010, Leggett participou de um projeto de tecnologia de interface cérebro-computador desenvolvido para pacientes com epilepsia e implantou oficialmente a tecnologia de interface cérebro-computador.

Depois de concluir o implante, Leggett rapidamente sentiu que ele e a interface estavam "em um" e, como resultado, ele "renasceu".

Pessoas com epilepsia grave têm dificuldade em levar uma vida normal.

Você não sabe quando terá uma convulsão e, como Leggett mencionou, ter uma convulsão enquanto dirige, anda na rua ou simplesmente sai sozinho pode ser desastroso.

▲ Foto do MMC

Leggett foi diagnosticada com epilepsia grave quando tinha três anos.

Antes de usar o implante, ela basicamente raramente saía.

Você pode imaginar como Leggett ficou arrasado quando lhe disseram para remover o implante.

Em 2013, três anos após o implante de Leggett, a NeuroVista, empresa que fabricou o dispositivo, ficou sem dinheiro e pediu aos voluntários participantes que removessem o implante.

Leggett e o marido tentaram negociar com a NeuroVista para ficar com o equipamento, e até se dispuseram a hipotecar a casa para comprar o equipamento.

Infelizmente, o implante acabou sendo removido contra sua vontade e reciclado.

Perdê-lo é como se eu tivesse perdido algo tão precioso e próximo de mim que nunca poderá ser substituído.

Faz parte de mim.

Segundo Marcello Ienca, especialista em ética da Universidade Técnica de Munique, isto é uma violação dos direitos humanos, que ainda não foi compreendida e discutida:

Forçada a retirar o aparelho, despojada de sua nova identidade formada pela tecnologia.

A empresa ajudou a criar essa pessoa totalmente nova… Assim que o dispositivo for removido, essa pessoa será demitida.

Eles e outros juristas argumentam que a integridade espiritual da pessoa deve ser protegida e que os “neurodireitos” devem ser reconhecidos.

Por outro lado, as pessoas que participam no ensaio precisam de conhecer antecipadamente estes riscos potenciais e participar significa aceitar estes riscos.

Mas Ienca e Gilbert argumentam que as empresas BCI deveriam adquirir um seguro para os participantes para cobrir os custos de manutenção e conservação se quiserem manter o dispositivo após o teste. Talvez o governo estadual também forneça apoio financeiro relevante na aprovação de projetos relacionados.

Com o desenvolvimento contínuo da tecnologia de interface cérebro-computador, haverá cada vez mais problemas relacionados.É necessário começar a pensar e estabelecer um sistema de garantia a tempo.

Na opinião de Ienca, retirar implantes que já fazem parte do eu é tão antiético quanto a remoção forçada de órgãos humanos:

Se houver evidências de que o BCI se tornou parte do ser humano, então, exceto por necessidades médicas, em nenhuma circunstância o implante deverá ser removido sem o consentimento do usuário.

Se isso constitui a pessoa, você está basicamente removendo à força parte da pessoa.

Apesar de já terem passado anos, Leggett chora quando fala em implantes. De acordo com Frederic Gilbert, especialista em ética da Universidade da Tasmânia:

Isso criou um trauma.

A tecnologia de interface cérebro-computador é um “interruptor” que pode mudar vidas.

Mas talvez também tenhamos que pensar em quem está controlando a mudança.

#Bem-vindo a seguir a conta pública oficial do WeChat da Aifaner: Aifaner (WeChat ID: ifanr), mais conteúdo interessante será apresentado a você o mais rápido possível.