Por que a Apple desistiu de seu recurso de digitalização de fotos?

Em agosto de 2021, a Apple revelou seus planos de escanear iPhones em busca de imagens de abuso sexual infantil. A medida atraiu aplausos de grupos de proteção à criança, mas levantou preocupações entre especialistas em privacidade e segurança de que o recurso poderia ser mal utilizado.

A Apple planejou inicialmente incluir a tecnologia de digitalização de Material de Abuso Sexual Infantil (CSAM) no iOS 15; em vez disso, atrasou indefinidamente a implementação do recurso para solicitar feedback antes de seu lançamento completo.

Então, por que o recurso de detecção de CSAM se tornou um assunto de debate acalorado, e o que fez a Apple adiar seu lançamento?

O que o recurso de digitalização de fotos da Apple faz?

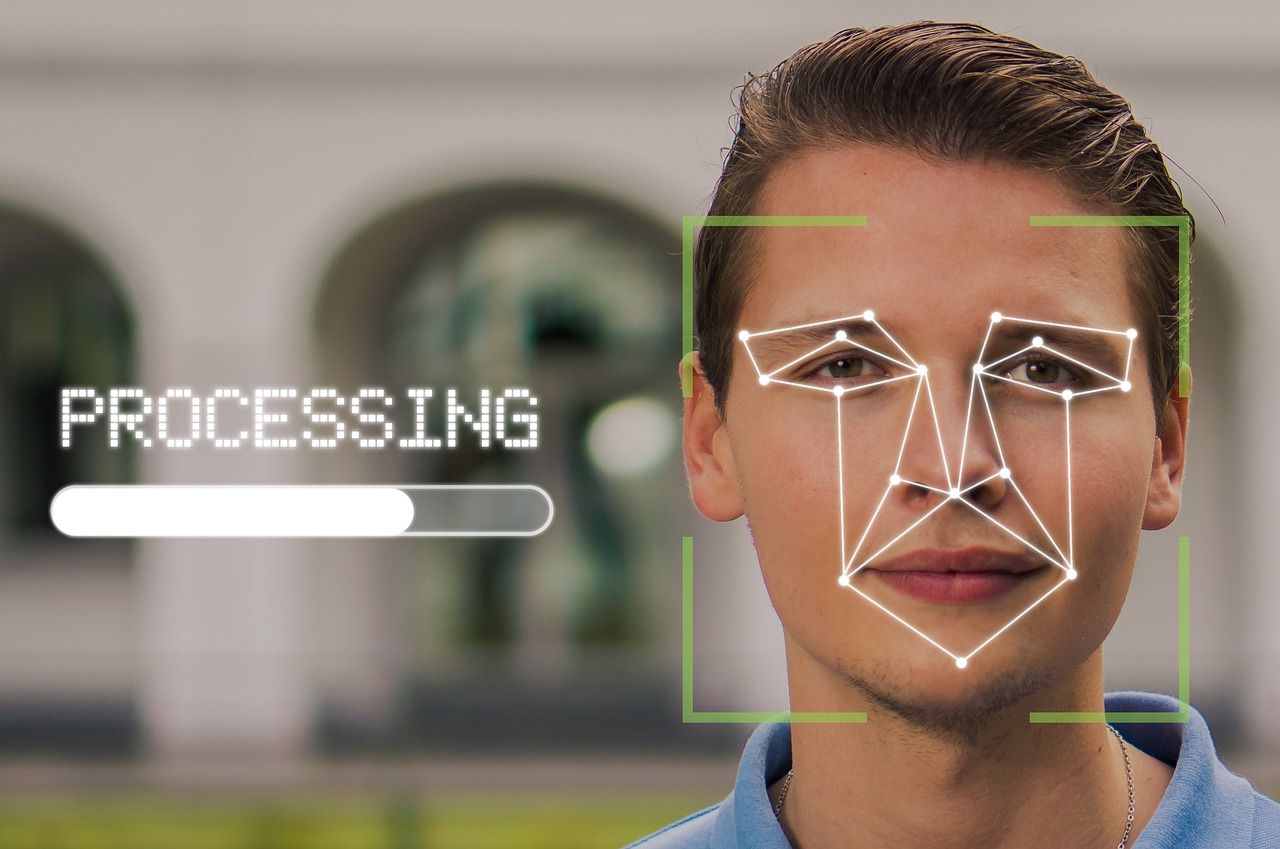

A Apple anunciou a implementação do recurso de digitalização de fotos na esperança de combater o abuso sexual infantil. Todas as fotos nos dispositivos dos usuários da Apple serão verificadas em busca de conteúdo pedofílico usando o algoritmo "NueralHash" criado pela Apple.

Além disso, quaisquer dispositivos Apple usados por crianças teriam um recurso de segurança que desfocará automaticamente as fotos de adultos se recebidas por uma criança, e o usuário será avisado duas vezes se tentar abri-los.

Além de minimizar a exposição a conteúdo adulto, se os pais registrarem os dispositivos de seus filhos para segurança adicional, os pais serão notificados caso a criança receba conteúdo explícito de alguém online.

Quanto aos adultos que usam o Siri para procurar qualquer coisa que sexualize as crianças, o Siri não fará essa busca e sugerirá outras alternativas.

Os dados de qualquer dispositivo contendo 10 ou mais fotos consideradas suspeitas pelos algoritmos serão descriptografados e submetidos à revisão humana.

Se essas fotos ou qualquer outra no dispositivo corresponderem a qualquer coisa do banco de dados fornecido pelo Centro Nacional para Crianças Desaparecidas e Exploradas , isso será relatado às autoridades e a conta do usuário será suspensa.

Principais preocupações em relação ao recurso de digitalização de fotos

O recurso de detecção de CSAM teria entrado no ar com o lançamento do iOS 15 em setembro de 2021, mas diante do clamor generalizado, a Apple decidiu levar mais tempo para coletar feedback e fazer melhorias neste recurso. Aqui está a declaração completa da Apple sobre o atraso:

"No mês passado, anunciamos planos para recursos destinados a ajudar a proteger as crianças de predadores que usam ferramentas de comunicação para recrutá-los e explorá-los, e limitar a disseminação de material de abuso sexual infantil.

Com base no feedback de clientes, grupos de defesa, pesquisadores e outros, decidimos reservar um tempo adicional nos próximos meses para coletar informações e fazer melhorias antes de lançar esses recursos de segurança infantil extremamente importantes ".

Quase metade das preocupações relacionadas ao recurso de digitalização de fotos da Apple giram em torno da privacidade; o restante dos argumentos inclui a provável imprecisão dos algoritmos e o uso indevido potencial do sistema ou de suas lacunas.

Vamos dividi-lo em quatro partes.

Potencial Uso Indevido

Saber que qualquer material que combine com pornografia infantil ou imagens conhecidas de abuso sexual infantil colocará um dispositivo na lista de "suspeitos" pode colocar os cibercriminosos em ação.

Eles podem bombardear intencionalmente uma pessoa com conteúdo impróprio através do iMessage, WhatsApp ou qualquer outro meio e suspender a conta dessa pessoa.

A Apple garantiu que os usuários podem entrar com um recurso caso suas contas tenham sido suspensas devido a um mal-entendido.

Abuso interno

Embora projetado para uma causa benevolente, esse recurso pode se transformar em um desastre total para certas pessoas se seus dispositivos forem registrados no sistema, com ou sem seu conhecimento, por parentes interessados em monitorar sua comunicação.

Mesmo que isso não aconteça, a Apple criou um backdoor para tornar os dados dos usuários acessíveis no final do dia. Agora é uma questão de motivação e determinação para as pessoas acessarem as informações pessoais de outras pessoas.

Isso não apenas facilita uma grande violação de privacidade, mas também abre caminho para que parentes, tutores, amigos, amantes, cuidadores e exes abusivos, tóxicos ou controladores invadam ainda mais o espaço pessoal de alguém ou restrinjam sua liberdade.

Por um lado, visa combater o abuso sexual infantil; por outro, pode ser usado para perpetuar ainda mais outros tipos de abuso.

Vigilância Governamental

A Apple sempre se autodenominou uma marca que se preocupa mais com a privacidade do que seus concorrentes. Mas agora, ele pode estar entrando em uma ladeira escorregadia de ter que atender às demandas intermináveis de transparência nos dados do usuário por parte dos governos .

O sistema que criou para detectar conteúdo pedofílico pode ser usado para detectar qualquer tipo de conteúdo em telefones. Isso significa que os governos com uma mentalidade de culto podem monitorar os usuários em um nível mais pessoal se eles colocarem as mãos nisso.

Opressivo ou não, o envolvimento do governo em sua vida diária e pessoal pode ser enervante e é uma invasão de sua privacidade. A ideia de que você só precisa se preocupar com essas invasões se tiver feito algo errado é um raciocínio errôneo e não consegue ver a já mencionada ladeira escorregadia.

Alarmes falsos

Uma das maiores preocupações do uso de algoritmos para combinar imagens com o banco de dados são os alarmes falsos. Algoritmos de hash podem identificar erroneamente duas fotos como correspondências, mesmo quando não são iguais. Esses erros, chamados de "colisões", são especialmente alarmantes no contexto de conteúdo de abuso sexual infantil.

Os pesquisadores encontraram várias colisões no "NeuralHash" depois que a Apple anunciou que usaria o algoritmo para digitalizar imagens. A Apple respondeu a perguntas sobre alarmes falsos apontando que o resultado será analisado por um ser humano no final, então as pessoas não precisam se preocupar com isso.

A pausa do CSAM da Apple é permanente?

Existem muitos prós e contras no recurso proposto pela Apple. Cada um deles é genuíno e tem peso. Ainda não está claro quais mudanças específicas a Apple poderia introduzir no recurso de varredura CSAM para satisfazer seus críticos.

Isso poderia limitar a digitalização para álbuns compartilhados do iCloud em vez de envolver os dispositivos dos usuários. É muito improvável que a Apple abandone totalmente esses planos, já que a empresa normalmente não está inclinada a desistir de seus planos.

No entanto, está claro pela reação generalizada e pela demora da Apple em seus planos, que as empresas devem incorporar a comunidade de pesquisa desde o início, especialmente para uma tecnologia não testada.