Para alcançar o ChatGPT e diminuir o resultado moral, o Google ainda pode “não ser mau”?

O slogan "Don't Be Evil" foi o lema e o código de conduta do Google até 2018.

▲ Imagem de: substack

Isso significa que o Google deve seguir a ética e as leis ao fazer as coisas e não fazer coisas que sejam prejudiciais à sociedade e aos usuários.

Mas em 2018, essa frase foi revisada para "Faça a coisa certa (faça a coisa certa)".

Esta mudança do Google é considerada por muitos como uma violação de sua intenção original.

▲ Foto de: vox

E em algumas ações comerciais subsequentes, o Google não manteve a neutralidade da tecnologia, mas estava mais inclinado a obter lucros comerciais, coletar a privacidade do usuário e usar alguns dados para garantir a expansão de seus próprios negócios.

A razão pela qual o slogan clássico do Google é mencionado é que o surto repentino do atual AIGC é um pouco semelhante ao surto anterior da Internet.

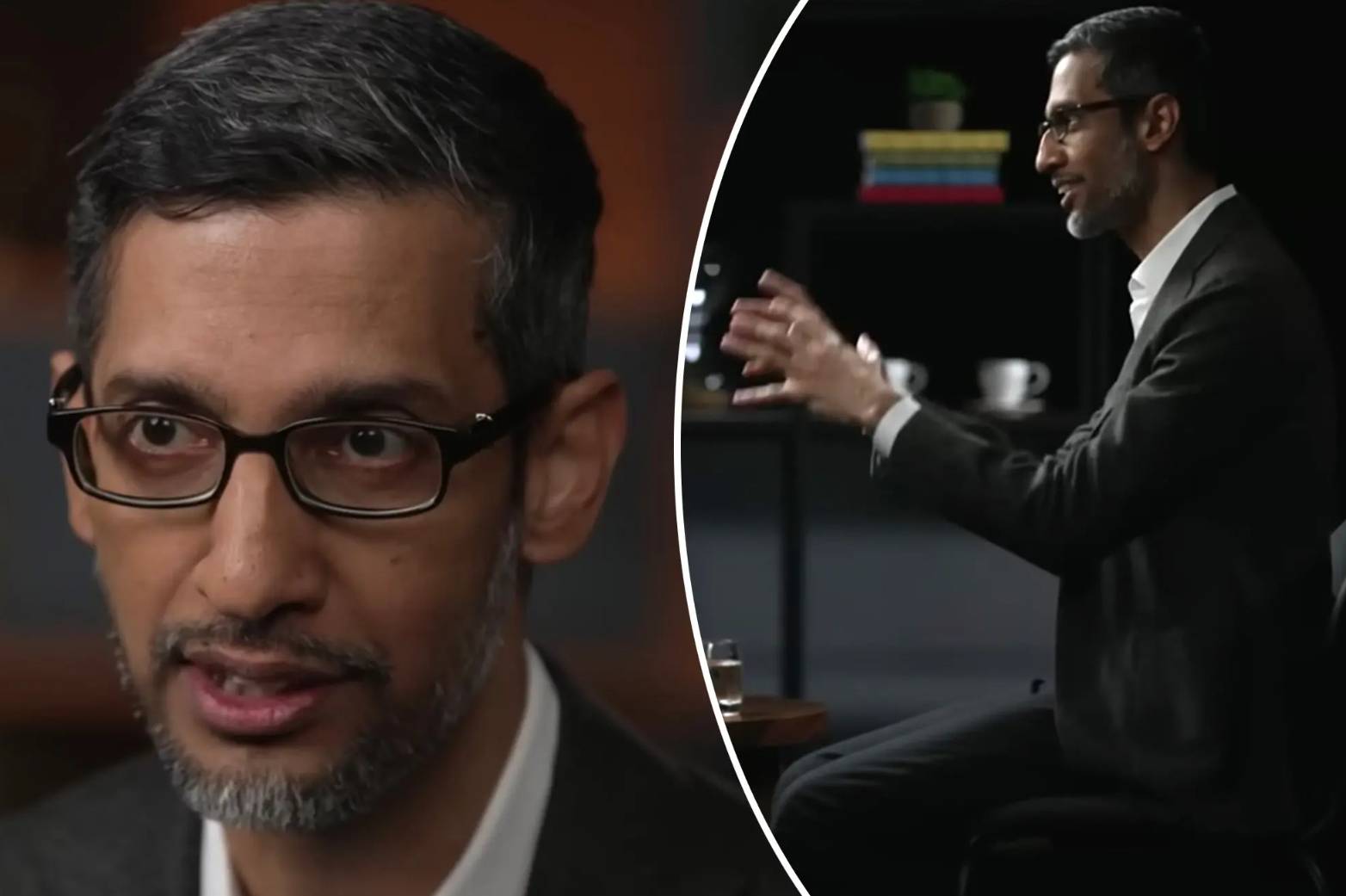

Em entrevista ao programa "60 Minutes" da CBS, o atual CEO do Google, Sundar Pichai, mencionou "Don't Be Evil" para a IA atual.

E também disse que a razão pela qual o Bard do Google parece um pouco desajeitado no momento é porque não há uma versão avançada do Bard anunciada.

“Espero dar à sociedade mais tempo para se adaptar à IA e às empresas mais tempo para desenvolver cercas de segurança”.

Simplificando, Pichai acredita que a força da IA do Google não é pior do que a OpenAI e, por responsabilidade social, a tecnologia de IA está temporariamente selada.

No entanto, independentemente dos relatórios da Bloomberg, do Verge e do Financial Times, o Google tem vozes completamente diferentes sobre o Bard e o atual desenvolvimento e supervisão da tecnologia de IA do Google.

Para combater o ChatGPT, a ética pode ser deixada de lado

Por volta de 2011, o Google fundou o projeto Google Brain, que começou no campo do aprendizado profundo, o que também significa que o Google começou a se envolver com IA.

Desde então, o Google alcançou algumas pequenas conquistas e pequenos objetivos no campo da IA quase todos os anos.

Desde AlphaGo vencendo o campeão mundial Li Shishi no xadrez, até o lançamento da estrutura de código aberto TensorFlow, até o lançamento do chip de aprendizado de máquina TPU e modelos de linguagem recentes, como BERT e LaMDA.

O Google é um veterano na área de IA. No processo de pesquisa de IA, ele também possui uma equipe interna de risco relativamente completa, equipe técnica etc., que pode ser descrita como forte.

Claro, também é um pouco arrogante.

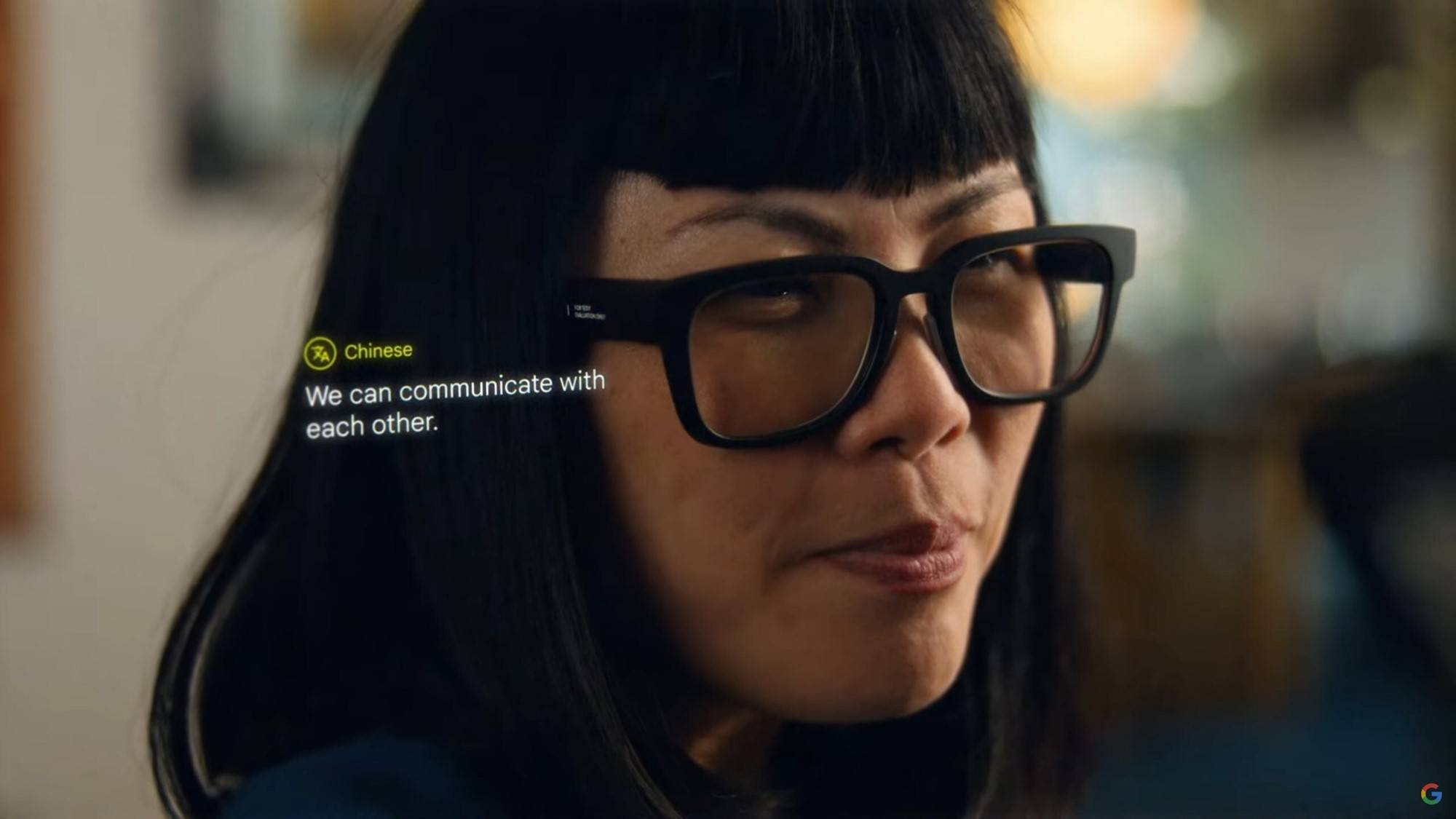

O conteúdo da Conferência anual de desenvolvedores do Google também começou a se voltar para a IA, mostrando a grande força do Google no campo da IA para o mundo exterior.

O mundo exterior também geralmente acredita que o Google assumirá a liderança na transformação da indústria de IA.

Até o ChatGPT, para ser mais preciso, o surgimento do GPT-3 e o subsequente surgimento do GPT-4, o Midjourney V5 é quente.

Antes que o Google pudesse reagir, a Microsoft aproveitou a oportunidade e cooperou com a OpenAI para aplicar o ChatGPT ao novo bing, desencadeando uma revolução de "pesquisa".

Quando o Google voltou a si, lançou o Bard da noite para o dia. Assim que ficou online, fez uma bagunça oolong. Houve muitos erros factuais e, até agora, só oferece suporte ao inglês.

Comparado com o ChatGPT e o novo bing, é muito inferior.

O resultado do lançamento apressado do Bard é causar uma crise de confiança e o preço das ações despencou.Mesmo que o Google ajuste depois, o impacto do Bard ainda não pode ser comparado ao ChatGPT.

Como resultado, alguns funcionários do Google também disseram que Bard falhou em alguns parâmetros éticos e estava propenso a mentir e fazer comentários negativos.

Durante os testes internos, um funcionário pediu à Bard instruções sobre como pousar o avião, e ela respondeu com etapas que poderiam facilmente levar a um acidente.

Outro funcionário fez a Bard uma pergunta sobre mergulho, e ele deu respostas que poderiam facilmente levar a ferimentos graves ou morte.

Além dessas respostas perigosas, o Google também relaxou seus requisitos em algumas questões éticas e sociais.

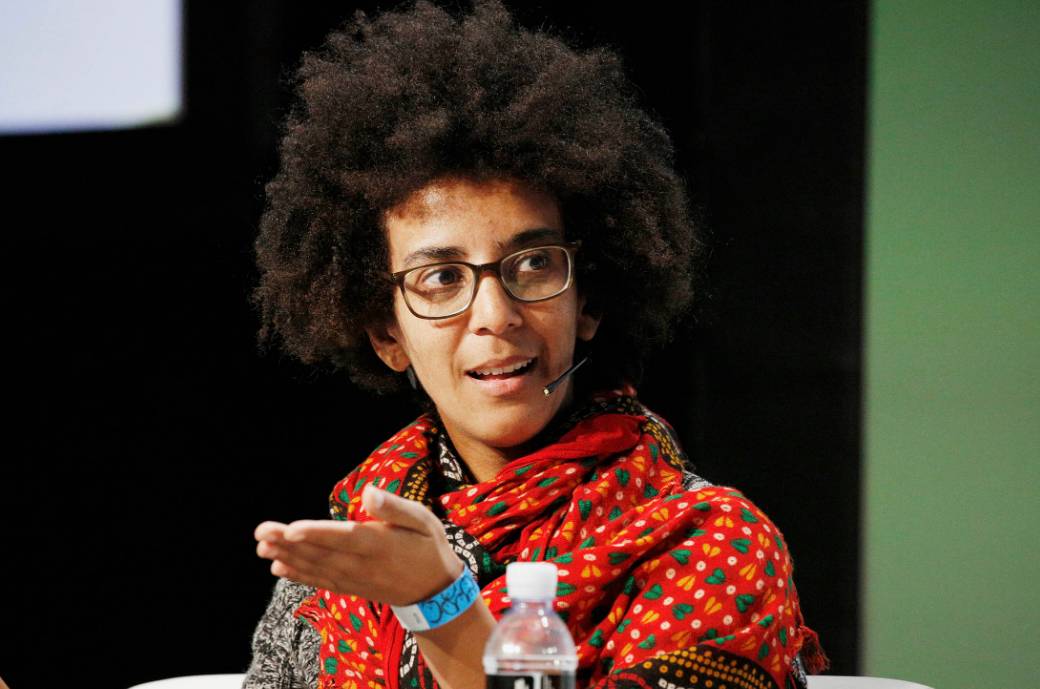

Dentro do Google, há uma equipe de pesquisa de ética em IA que explora, estabelece e avalia os riscos apresentados pela IA.

Eles têm o direito de colocar diretamente um rótulo vermelho em uma tecnologia e, se ela não passar no teste, não estará disponível ao público temporariamente.

▲ Timnit Gebru, ex-pesquisador da equipe de ética de IA do Google. Imagem de: Bloomberg

Em 2021, o Google também prometeu expandir a equipe de pesquisa de ética em IA e investir mais recursos para conter a busca por lucros de pesquisadores técnicos.

Mas o interessante é que a liderança da equipe vem mudando, e também passou por uma rodada de demissões no ano passado.

Atualmente, o Google tem 30 vezes mais pesquisadores técnicos relacionados à IA do que a equipe de segurança ética.

Mesmo depois que o ChatGPT roubou o trovão da indústria de AIGC, o Google começou a vacilar e os membros da equipe de ética foram instruídos a não obstruir ou "matar" nenhuma ferramenta de IA generativa que estivesse sendo desenvolvida.

Depois de passar por testes internos e receber muitas "perguntas", o Google enfrentou pressão comercial da Microsoft e do ChatGPT e, finalmente, optou por lançá-lo com o nome de "produto experimental".

Porque em algumas pesquisas estatísticas, os produtos experimentais têm maior probabilidade de serem aceitos pelo público, mesmo que apresentem defeitos.

E alguns funcionários também acreditam que o anúncio de novas tecnologias ao público o mais rápido possível pode obter feedback rapidamente e melhorar os produtos mais rapidamente.

De fato, por muito tempo após o lançamento do Bard, o Google fez apenas uma alteração, adicionando uma modificação da lógica matemática a ele.

Quanto a se algumas cercas sensíveis e tópicos sensíveis foram alterados e otimizados, isso não foi mencionado.

Bard também parece estar ficando de lado na onda de IA em constante mudança.

Almíscar: ta deve ser supervisionado

Curiosamente, Musk também falou sobre o Google na Fox News, quase antes e depois da entrevista de Pichai.

Musk e o fundador do Google, Larry Page, costumavam ser amigos íntimos. Page chegou a comprar 10% das ações da SpaceX e queria ir a Marte para jogar areia com Musk.

Mas em 2014, depois que o Google adquiriu a DeepMind, os dois tinham visões diferentes sobre IA e acabaram não se comunicando.

No mesmo ano, Page disse em um discurso no TED que seu objetivo final é construir uma inteligência artificial superdigital, que ele chama de "deus digital".

Sobre essa ideia, Pichai não negou nem concordou na entrevista ao "60 Minutes".

Em vez disso, ele apenas disse que o Google lançará novos produtos de IA em sua conferência Developer I/O em 10 de maio.

E Musk tem uma compreensão clara do "deus digital" O Google tem um computador de alto desempenho e uma equipe de inteligência artificial que está perto de um monopólio no mundo, e é mais provável que alcance o chamado "deus digital".

Mas Page, o líder da empresa, não se importa com os problemas de segurança trazidos pela IA, que é bastante perigosa para o mundo.

É também por isso que ele recentemente quis entrar no jogo depois de ver ChatGPT, novo bing e Bard como um absurdo, e lançou um produto semelhante chamado TruthGPT.

Além disso, Musk também está pedindo a vários países e organizações que introduzam políticas correspondentes para limitar alguns comportamentos ultrajantes da IA.

Devido às características da IA generativa, seus dados vêm de fóruns da Internet, jornais, sites e outros aspectos. Como esses dados não são dessensibilizados e não são estritamente restritos, é fácil gerar comentários arriscados, prejudiciais ou imprecisos.

Além disso, com o atual boom na indústria de AIGC, os entrantes são como garimpar ouro, como se a inteligência artificial estivesse entrando em um novo estágio de desenvolvimento.

No entanto, os atuais modelos em grande escala e os métodos de geração industrial de alta computação também facilitam o monopólio da IA por grandes empresas.

Quando é difícil para eles ponderar se devem buscar o lucro ou manter a segurança internamente, é fácil cometer erros na orientação da IA, causando consequências irreversíveis.

Embora Musk tenha um pouco de egoísmo no AIGC, Musk é de fato muito mais sóbrio quando se trata de algumas questões importantes.

Com grandes poderes vem grandes responsabilidades

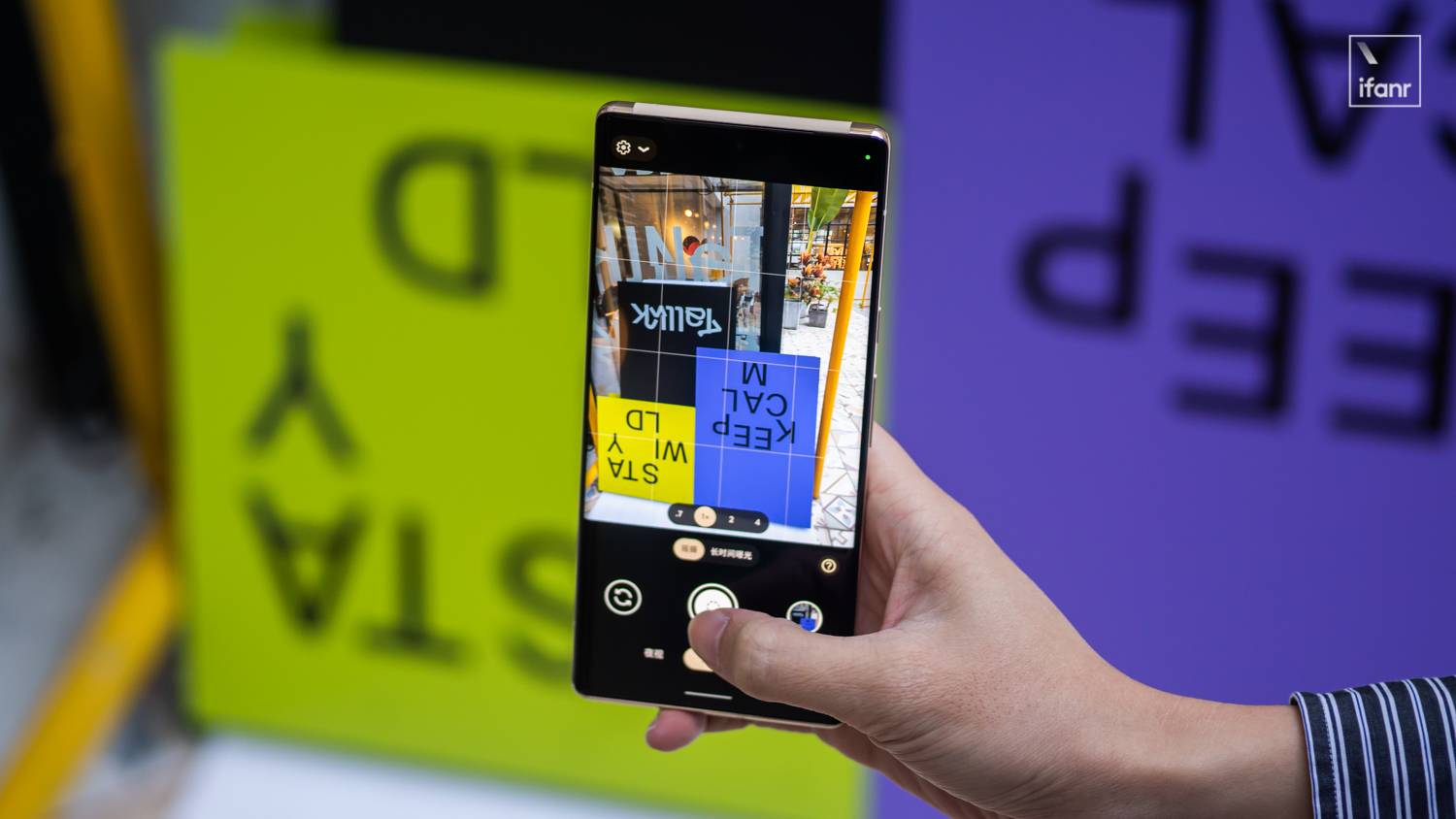

O Google Fotos usará o reconhecimento de imagem AI para marcar e ajudar os usuários a classificar as fotos.

Este é um dos aplicativos de IA anteriores do Google. Embora o Google Fotos tenha ajustado a capacidade livre, ainda é um dos meus aplicativos mais usados.

Mas em 2015, o Google Fotos classificou erroneamente uma foto de um desenvolvedor de software negro e seus amigos como um "gorila".

Uma resposta mais normal seria pedir desculpas e refatorar o algoritmo para corrigir gradativamente esse erro de reconhecimento.

Mas o Google optou por remover completamente os resultados de pesquisa para “gorila”, “chimpanzé” e “macaco”.

O problema enfrentado pelo Google Bard hoje é que o Google ainda não tem o senso de assumir responsabilidade e ainda escolhe menosprezá-la.

Para poder alcançar o ChatGPT, a equipe interna de ética de IA do Google não realizou uma avaliação abrangente dele, apenas conduziu pesquisas sobre tópicos delicados e, finalmente, lançou-o às pressas.

Bloomberg também citou a avaliação de um ex-executivo da equipe de ética de IA, que acredita que o Google sempre foi controverso sobre o desenvolvimento de IA de ponta ou o desenvolvimento de IA com base moral.

De fato, na indústria de AIGC, não apenas o Google, mas o Financial Times também revelou que gigantes da tecnologia como Microsoft e Amazon estão abolindo equipes de ética de IA em grande escala.

Parece que no momento em que o AIGC está se desenvolvendo rapidamente e competindo entre si, a ética e a segurança da IA afetaram os grilhões que estão perseguindo um ao outro.

Conforme declarado no relatório dos pesquisadores da Universidade de Stanford, o rápido desenvolvimento da indústria de IA mudou da academia para a industrialização. Sob a tentação de interesses comerciais, vários IAs estão surgindo, mas a ética, a segurança e a sensibilidade por trás deles são prejudiciais. e outras informações são gradualmente ignoradas.

As grandes empresas também não estão dispostas a assumir mais responsabilidades sociais e estão apenas pairando à margem de leis e regulamentos, o que pode ter um impacto profundo na sociedade e na indústria de IA.

Atualmente, muitos países e regiões, e até mesmo algumas empresas e organizações, estão estudando ativamente e formulando algumas regras para limitar o desenvolvimento descontrolado da IA.

Como disse Yin Sheng, ex-editor-chefe adjunto da Forbes Chinese Edition: "As grandes empresas devem fazer mais do que os usuários e a lei exigem, porque você cria um novo mundo e se beneficia dele, você deve ajudar toda a sociedade a aprender como para governá-lo, se você não tomar a iniciativa, a sociedade vai assumir.”

#Bem-vindo a prestar atenção à conta pública oficial do WeChat de Aifaner: Aifaner (ID do WeChat: ifanr), conteúdo mais interessante será apresentado a você o mais rápido possível.