OpenAI muda o mundo em 26 minutos! A versão gratuita do GPT-4 está aqui, a interação por vídeo e voz avança rapidamente para um filme de ficção científica

Esta manhã, uma conferência de imprensa de 26 minutos mudará mais uma vez a indústria de IA e nossas vidas futuras, e também tornará infelizes inúmeras startups de IA.

Na verdade, isso não é uma manchete, porque esta é uma conferência de imprensa da OpenAI.

Agora mesmo, a OpenAI lançou oficialmente o GPT-4o, onde o "o" significa "omni" (que significa abrangente e onipotente). Este modelo possui recursos de texto, imagens, vídeo e voz. versão inacabada.

Além do mais, este modelo de nível GPT-4 estará disponível gratuitamente para todos os usuários e será lançado no ChatGPT Plus nas próximas semanas.

Vamos primeiro resumir os destaques desta conferência. Leia abaixo para uma análise mais funcional.

Pontos-chave da conferência de imprensa

- Novo modelo GPT-4o: abre qualquer entrada de texto, áudio e imagem e pode gerar um ao outro diretamente, sem conversão intermediária

- O GPT-4o reduziu significativamente a latência de voz e pode responder à entrada de áudio em 232 milissegundos, com uma média de 320 milissegundos, o que é semelhante aos tempos de resposta humana em conversas.

- GPT-4 é gratuito e aberto a todos os usuários

- API GPT-4o, 2 vezes mais rápida que GPT4-turbo e 50% mais barata

- Demonstração impressionante do assistente de voz em tempo real: a conversa é mais parecida com a de um humano, pode traduzir em tempo real, reconhecer expressões e reconhecer a tela através da câmera, escrever código e analisar gráficos

- Nova IU do ChatGPT, mais concisa

- Um novo aplicativo de desktop ChatGPT para macOS, com versão para Windows chegando ainda este ano

Essas características foram descritas por Altman como "uma sensação mágica" já na fase de aquecimento. Como os modelos de IA em todo o mundo estão “alcançando o GPT-4”, a OpenAI precisa retirar algumas coisas reais de seu arsenal.

O GPT-4o gratuito e disponível está aqui, mas esse não é o seu maior destaque

Na verdade, um dia antes da conferência de imprensa, descobrimos que a OpenAI havia mudado discretamente a descrição do GPT-4 de “o modelo mais avançado” para “avançado”.

Isto é para dar as boas-vindas à chegada do GPT-4o. O poder do GPT-4o é que ele pode aceitar qualquer combinação de texto, áudio e imagens como entrada e gerar diretamente a saída de mídia acima.

Isso significa que a interação humano-computador estará mais próxima da comunicação natural entre as pessoas.

O GPT-4o pode responder à entrada de áudio em 232 milissegundos, com uma média de 320 milissegundos, o que é próximo ao tempo de reação de uma conversa humana. Anteriormente usando o modo de voz para se comunicar com ChatGPT, a latência média era de 2,8 segundos (GPT-3,5) e 5,4 segundos (GPT-4).

Ele corresponde ao desempenho do GPT-4 Turbo em inglês e texto de código, com melhorias significativas em texto em idiomas diferentes do inglês, ao mesmo tempo que é mais rápido e 50% mais barato na API.

Comparado com os modelos existentes, o GPT-4o tem um desempenho particularmente bom na compreensão visual e de áudio.

- Você pode interromper a qualquer momento durante uma conversa

- Pode gerar uma variedade de tons com base na cena, com humores e emoções semelhantes aos humanos

- Faça uma videochamada diretamente com IA e deixe-a responder a várias perguntas online

A julgar pelos parâmetros de teste, as principais capacidades do GPT-4o estão basicamente no mesmo nível do GPT-4 Turbo, o OpenAI mais forte atualmente.

[foto]

[foto]

[foto]

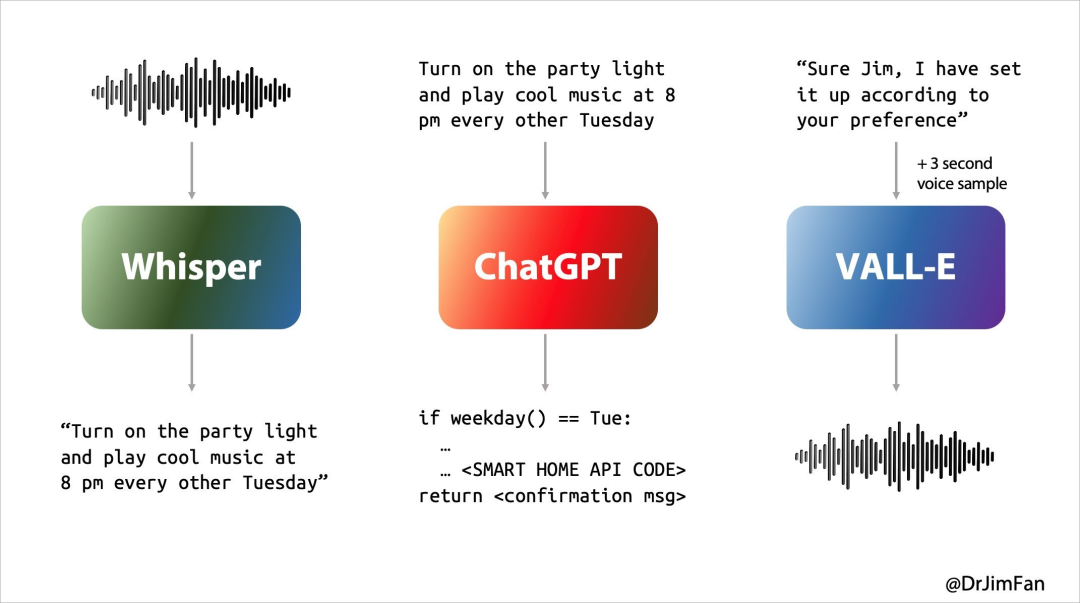

No passado, nossa experiência com Siri ou outros assistentes de voz não era ideal. Essencialmente, a conversa com o assistente de voz passava por três etapas:

- Reconhecimento de fala ou “ASR”: áudio -> texto, semelhante ao Whisper;

- LLM planeja o que dizer a seguir: Texto 1 -> Texto 2;

- Síntese para fala ou “TTS”: Texto 2 -> Áudio, pense em ElevenLabs ou VALL-E.

No entanto, nossas conversas naturais diárias são basicamente assim

- Pense no que dizer a seguir enquanto ouve e fala;

- Insira “sim, hum, hum” no momento apropriado;

- Antecipe quando a outra parte terminará de falar e assumirá imediatamente;

- Decida interromper a conversa do outro com naturalidade e sem causar ressentimentos;

- Pense no que dizer a seguir enquanto ouve e fala;

- Insira “sim, hum, hum” no momento apropriado;

- Manuseie e interrompa normalmente.

Os assistentes de linguagem de IA anteriores não conseguiam lidar bem com esses problemas e havia um grande atraso em cada uma das três etapas da conversa, resultando em uma experiência ruim. Ao mesmo tempo, muitas informações são perdidas no processo, como a incapacidade de observar diretamente a entonação, vários alto-falantes ou ruído de fundo, e a incapacidade de rir, cantar ou expressar emoções.

Quando o áudio pode gerar diretamente áudio, imagens, texto e vídeos, toda a experiência será muito rápida.

GPT-4o é um modelo totalmente novo treinado pela OpenAI para essa finalidade. A conversão direta de texto, vídeo e áudio requer que todas as entradas e saídas sejam processadas pela mesma rede neural.

O que é ainda mais surpreendente é que os usuários gratuitos do ChatGPT podem usar o GPT-4o para experimentar as seguintes funções:

- Experimente inteligência de nível GPT-4

- Obtenha respostas de modelos e redes

- Analise dados e crie gráficos

- Vamos falar sobre as fotos que você tirou

- Carregue um arquivo para obter ajuda com resumo, redação ou análise

- Usando GPTs e armazenamento GPT

- Crie experiências mais úteis com o Memory

E quando você assiste às seguintes demonstrações do GPT-4o, seus sentimentos podem ficar mais complicados.

Versão ChatGPT "Jarvis", todo mundo tem

ChatGPT não só pode falar, ouvir, mas também assistir. Isso não é novidade, mas o "envio de nova versão" do ChatGPT ainda me surpreendeu.

parceiro de dormir

Tomando como exemplo uma cena de vida específica, deixe o ChatGPT contar uma história para dormir sobre robôs e amor. Ele pode contar uma história emocionante e dramática para dormir sem pensar muito.

Pode até contar histórias em forma de canto, o que pode servir de companheiro de sono para os usuários.

Mestre de perguntas

Ou, na coletiva de imprensa, demonstre como ajudar a resolver a equação linear 3X+1=4. Ele pode guiá-lo passo a passo e dar a resposta correta.

Claro, o que foi dito acima ainda é uma "brincadeira de criança", e as dificuldades de codificação no local são o verdadeiro teste. No entanto, pode ser facilmente resolvido com três golpes, cinco golpes e dois golpes.

Com a “visão” do ChatGPT ele consegue visualizar tudo na tela do computador, como interagir com a base de código e visualizar os gráficos gerados pelo código. Então a nossa privacidade não será vista claramente no futuro?

tradução em tempo real

O público presente também fez algumas perguntas complicadas ao ChatGPT.

Traduzindo do inglês para o italiano e do italiano para o inglês, não importa o quanto você use este assistente de voz de IA, ele pode fazer isso com facilidade. Parece que não há necessidade de gastar muito dinheiro para comprar um tradutor. futuro, talvez o ChatGPT seja melhor que o seu tradutor em tempo real.

Este conteúdo não pode ser exibido fora dos documentos Feishu no momento.

▲ Tradução em tempo real (caso do site oficial)

Perceber a emoção da linguagem é apenas o primeiro passo. O ChatGPT também pode interpretar emoções faciais humanas.

Na coletiva de imprensa, ChatGPT confundiu diretamente o rosto capturado pela câmera com uma mesa. Justamente quando todos pensaram que ele iria rolar, foi porque a câmera frontal que foi ligada primeiro estava apontada para a mesa. .

Porém, no final, ele descreveu com precisão as emoções no rosto da selfie e identificou com precisão o sorriso “brilhante” no rosto.

Curiosamente, no final da conferência de imprensa, o porta-voz não esqueceu o “forte apoio” de Cue por parte da Nvidia e do seu fundador, Lao Huang.

A ideia de uma interface de linguagem conversacional era incrivelmente profética.

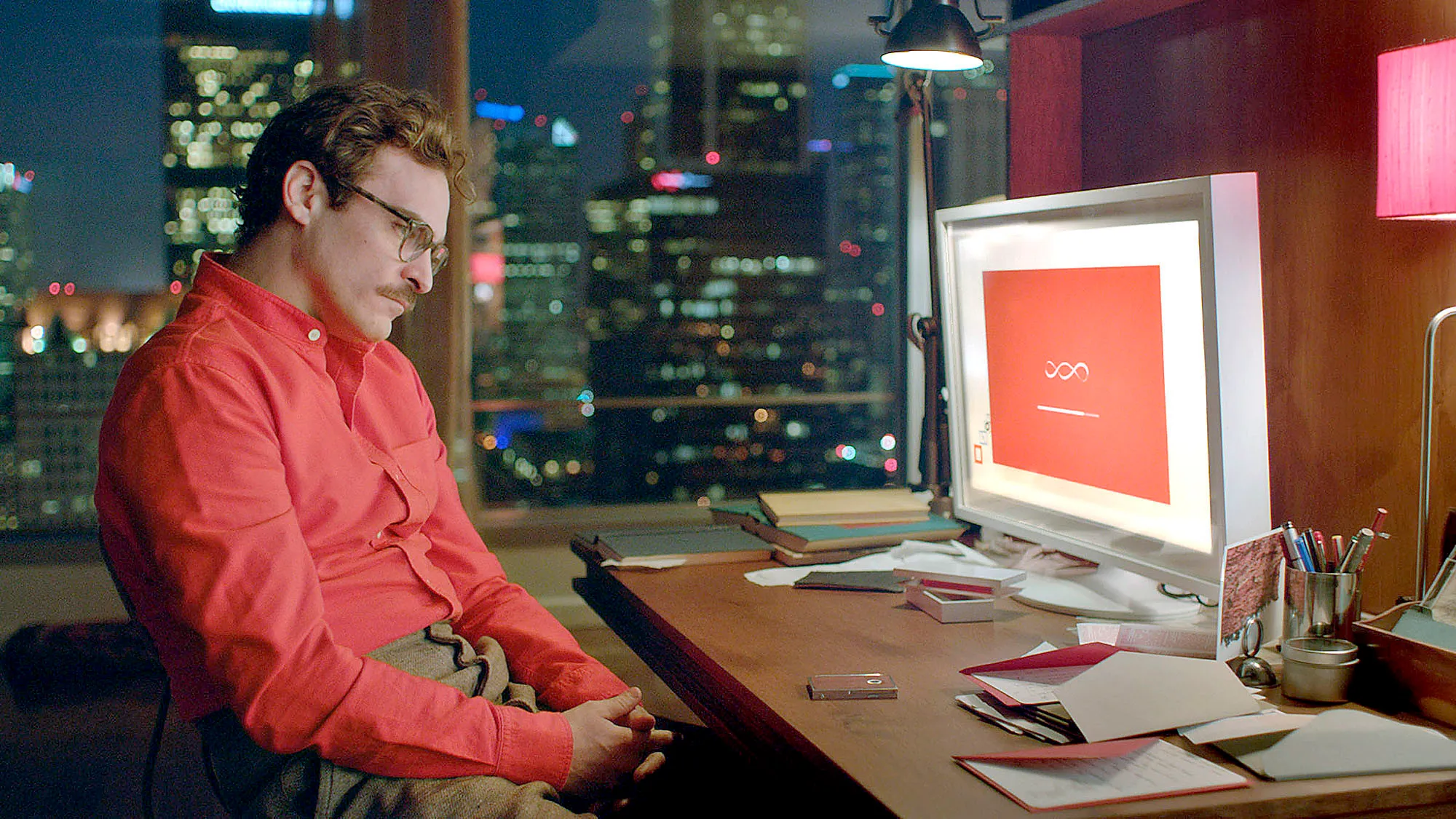

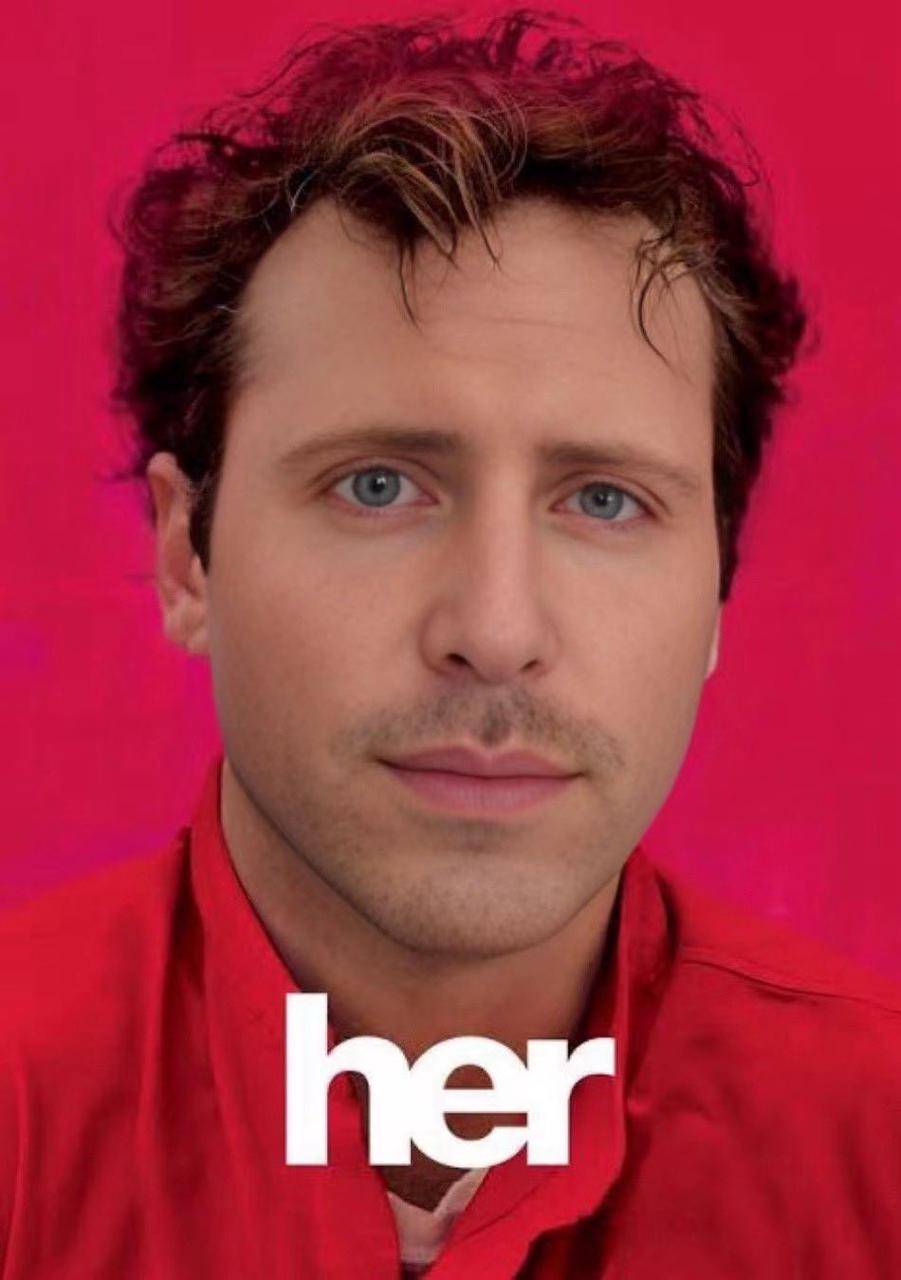

Altman expressou em entrevistas anteriores que espera eventualmente desenvolver um assistente de IA semelhante ao do filme de IA "Her", e o assistente de voz lançado pela OpenAI hoje está de fato se tornando realidade.

Brad Lightcap, diretor de operações da OpenAI, previu há pouco tempo que no futuro falaremos com chatbots de IA da mesma forma que falamos com humanos, tratando-os como parte de uma equipe.

Agora parece que isto não só preparou o caminho para a conferência de hoje, mas também constituiu uma nota de rodapé vívida para as nossas vidas nos próximos dez anos.

A Apple tem lutado com assistentes de voz de IA há treze anos e não conseguiu sair do labirinto, mas a OpenAI encontrou a saída da noite para o dia. É previsível que num futuro próximo, o “Jarvis” do Homem de Ferro não seja mais uma fantasia.

"Ela está vindo

Embora Sam Altman não tenha aparecido na conferência, ele publicou um blog após a conferência e postou uma palavra no X: ela.

Esta é obviamente uma alusão ao clássico filme de ficção científica “Her” de mesmo nome. Esta foi a primeira imagem que me veio à mente quando assisti à apresentação desta conferência.

Samantha no filme “Her” não é apenas um produto, ela até entende os humanos melhor do que os humanos e é mais parecida com os próprios humanos. Você pode realmente esquecer gradualmente que ela é uma IA ao se comunicar com ela.

Isto significa que o modelo de interação humano-computador pode inaugurar uma atualização verdadeiramente revolucionária após a interface gráfica, como disse Sam Altman em seu blog:

Os novos modos de voz (e vídeo) são a melhor interface de computador que já usei. Parece uma IA de um filme e ainda estou um pouco surpreso por ser real. Alcançar tempos de resposta e expressividade de nível humano acaba sendo uma grande mudança.

O ChatGPT anterior nos permitiu ver o início da interface de usuário natural: simplicidade acima de tudo: a complexidade é inimiga da interface de usuário natural. Cada interação deve ser autoexplicativa, não necessitando de manual de instruções.

Mas o GPT-4o lançado hoje é completamente diferente. Quase não tem atraso na resposta, é inteligente, interessante e prático. Nossa interação com computadores nunca experimentou uma interação tão natural e suave.

Ainda existem enormes possibilidades escondidas aqui. Quando funções mais personalizadas e colaboração com diferentes dispositivos terminais são suportadas, isso significa que podemos usar telefones celulares, computadores, óculos inteligentes e outros terminais de computação para fazer muitas coisas que não eram possíveis antes.

O hardware de IA não tentará mais acumular. O que é mais emocionante agora é que se a Apple anunciar oficialmente sua cooperação com a OpenAI na WWDC no próximo mês, a experiência do iPhone poderá ser melhorada mais do que qualquer conferência dos últimos anos.

O cientista sênior de código da NVIDIA, Jim Fan, acredita que a cooperação entre o iOS 18, conhecida como a maior atualização da história, e o OpenAI pode ter três níveis:

- Abandonando o Siri, a OpenAI refinou um pequeno GPT-4o para iOS que roda exclusivamente no dispositivo, com a opção de pagar para atualizar para usar serviços em nuvem.

- A funcionalidade nativa alimenta fluxos de câmera ou tela no modelo. Suporte em nível de chip para codecs neurais de áudio e vídeo.

- Integre-se à API de operação em nível de sistema iOS e à API de casa inteligente. Ninguém usa os atalhos da Siri, mas é hora de um renascimento. Isso poderia se tornar um produto de agente de IA com um bilhão de usuários desde o início. É como um volante de dados em tamanho real, semelhante ao Tesla, para smartphones.

Falando nisso, tenho que sentir pena do Google, que fará uma coletiva de imprensa amanhã.

Autor: Li Chaofan e Mo Chongyu

# Bem-vindo a seguir a conta pública oficial do WeChat do aifaner: aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.