OpenAI contra-ataca DeepSeek tarde da noite! Lançado com urgência o3-mini gratuitamente. Depois de experimentá-lo, encontrei a lacuna.

Durante o feriado do Festival da Primavera, DeepSeek, uma força misteriosa do Oriente, destruiu o campo da opinião pública no Vale do Silício.

Por um lado, houve lobby e repressão por parte de fabricantes como OpenAI e Anthropic, mas por outro lado, eles testemunharam a atitude nada lisonjeira de seus aliados. Em apenas uma noite, plataformas americanas de computação em nuvem como Microsoft, NVIDIA e Amazon estenderam ramos de oliveira ao DeepSeek R1.

Diante do contínuo aumento do impulso do DeepSeek, a contramedida mais poderosa é confiar na força.

Esta manhã, a OpenAI lançou oficialmente os modelos da série OpenAI o3-mini.

Como sucessor do modelo o1-mini, o3-mini é o modelo mais recente e mais econômico da atual série de inferência. O cientista pesquisador da OpenAI, Noam Brown, postou na plataforma X:

"Estamos muito entusiasmados com o lançamento do o3-mini, inclusive abrindo-o para usuários gratuitos. Em múltiplas avaliações, ele supera o o1. Estamos revolucionando a relação entre custo e inteligência. A inteligência do modelo continuará a melhorar e o custo de obter o mesmo nível de inteligência continuará a diminuir."

Os destaques específicos dos modelos da série o3-mini são os seguintes:

- o3-mini concentra-se no raciocínio rápido, enquanto o3-mini (alto) é bom em codificação e lógica.

- Suporta pesquisa online e pode recuperar e resumir informações da Internet em tempo real.

- Os dados de treinamento são rigorosamente verificados e o desempenho da conformidade de segurança é aprimorado

Em termos de usuários pagantes, os usuários ChatGPT Plus, Team e Pro agora podem usar o o3-mini, e a versão empresarial estará acessível em uma semana.

OpenAI aumentou o limite diário de mensagens para usuários Plus e Team de 50 para o1-mini para 150. Os usuários Pro podem desfrutar de acesso ilimitado ao o3-mini e o3-mini-high para atender às necessidades de maior intensidade ou de raciocínio mais profissional.

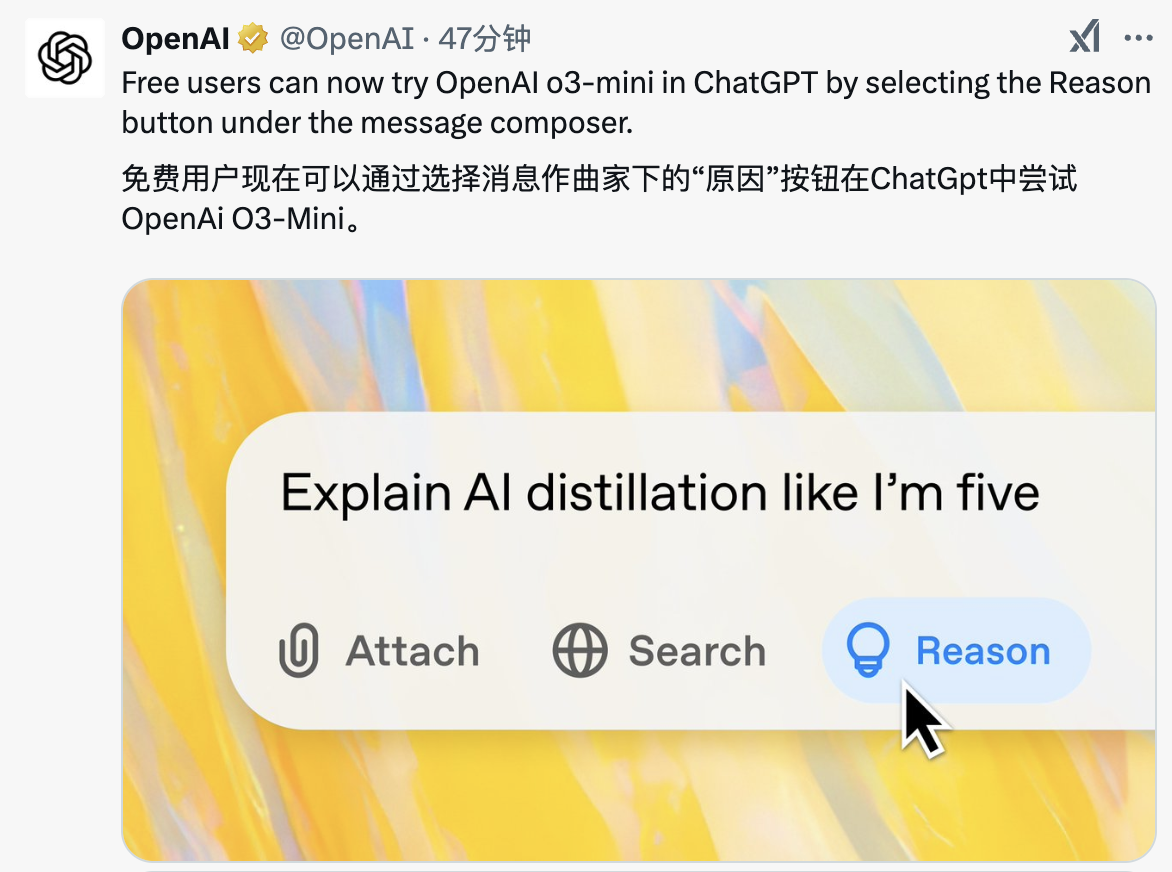

Ao mesmo tempo, esta é também a primeira vez que a OpenAI abre o uso de modelos de inferência para usuários gratuitos. Você pode usá-lo selecionando o botão "Motivo" abaixo da caixa de entrada de mensagens do ChatGPT.

Vale ressaltar que o OpenAI o3-mini integra uma função de busca, que pode obter as respostas mais recentes em tempo real e anexar links da web relevantes para facilitar aos usuários a realização de pesquisas aprofundadas. Este é atualmente um recurso de protótipo e continuará a ser melhorado e expandido para mais modelos de inferência no futuro.

o3-mini é o primeiro modelo de inferência pequeno da OpenAI que oferece suporte a funções avançadas, como chamadas de função, saída estruturada e mensagens do desenvolvedor, e pode ser usado imediatamente.

Assim como o1-mini e o1-preview, o3-mini suporta streaming. Os desenvolvedores também podem escolher entre níveis de inferência baixos, médios e altos de acordo com necessidades específicas e escolher entre processamento de tarefas complexas e velocidade de resposta.

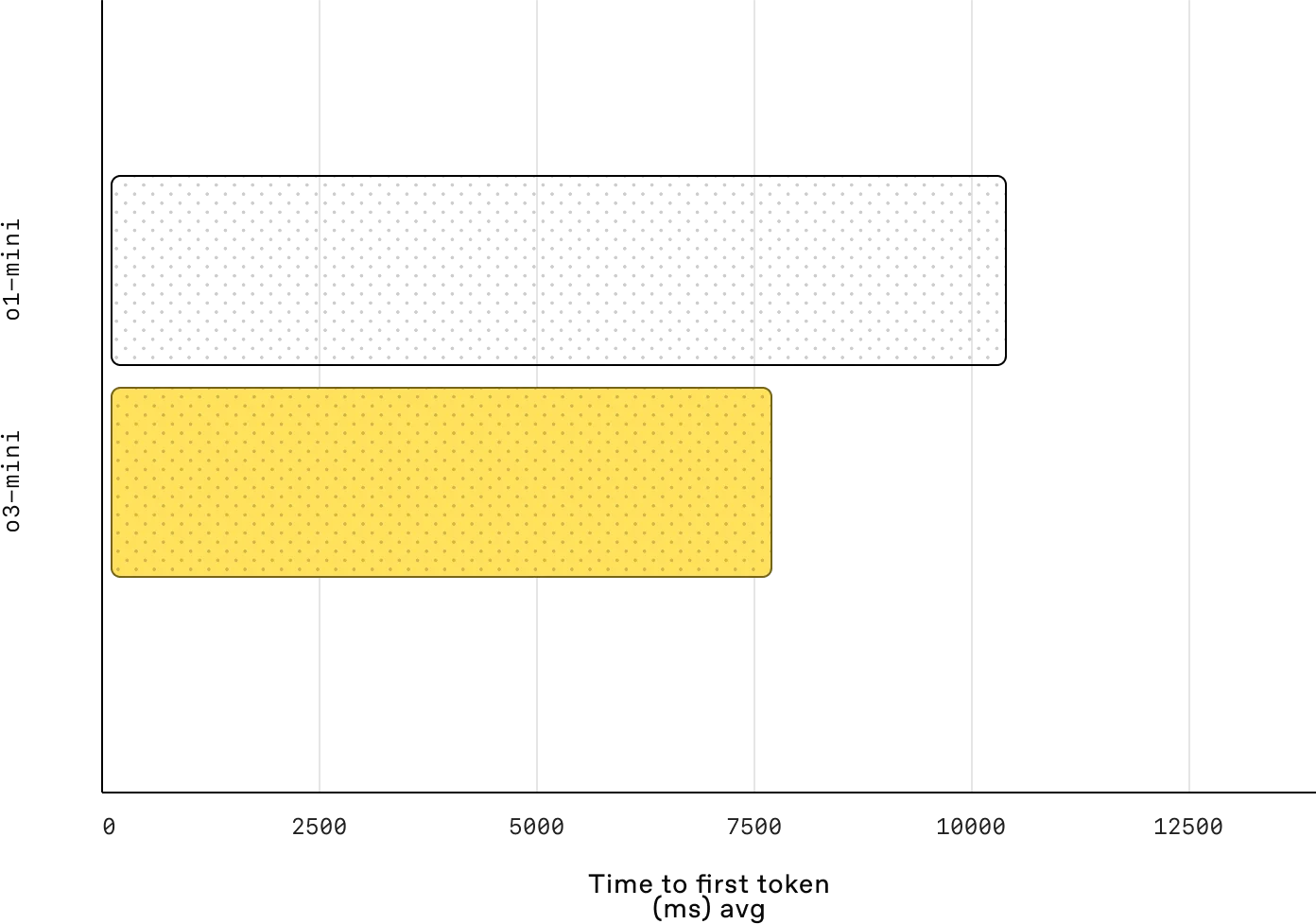

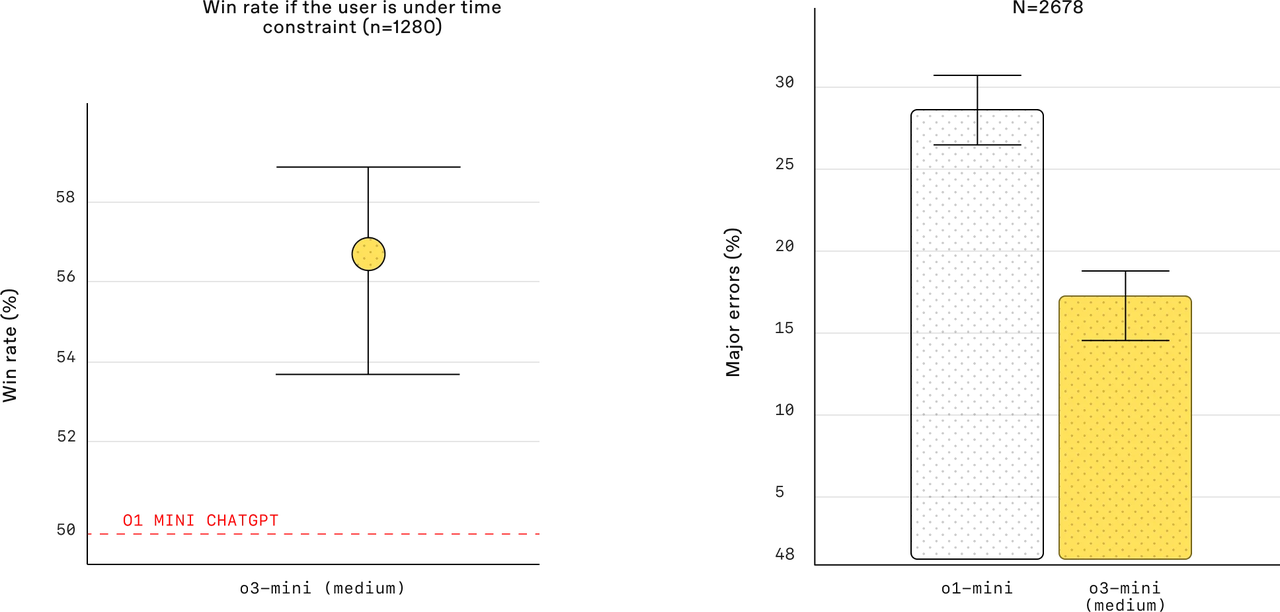

Os testes mostram que o tempo médio de resposta do o3-mini é de 7,7 segundos, o que é 24% mais rápido que os 10,16 segundos do o1-mini. Ao mesmo tempo, na avaliação dos especialistas, 56% dos revisores estavam mais inclinados a escolher a resposta do o3-mini, e a principal taxa de erro ao lidar com problemas práticos complexos também foi reduzida em 39%.

O cartão do sistema do o3-mini mencionou que durante a avaliação de uma semana, sete especialistas em biologia humana conduziram várias rodadas de diálogo com o o3-mini (versão pré-treinada) sobre questões biológicas complexas.

Os especialistas concordam que mesmo sem acesso à Internet, os recursos de perguntas e respostas do o3-mini ainda são poderosos e podem não apenas acelerar o processo de recuperação de informações, mas também fornecer informações difíceis de encontrar na Internet.

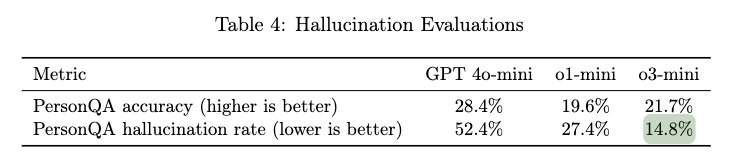

Além disso, os especialistas também descobriram que o modelo teve um bom desempenho na revisão da literatura e na resposta a perguntas, e poderia classificar a literatura de forma rápida e abrangente. No entanto, deve-se notar também que o modelo ocasionalmente apresenta alucinações, levando a desvios nas informações detalhadas.

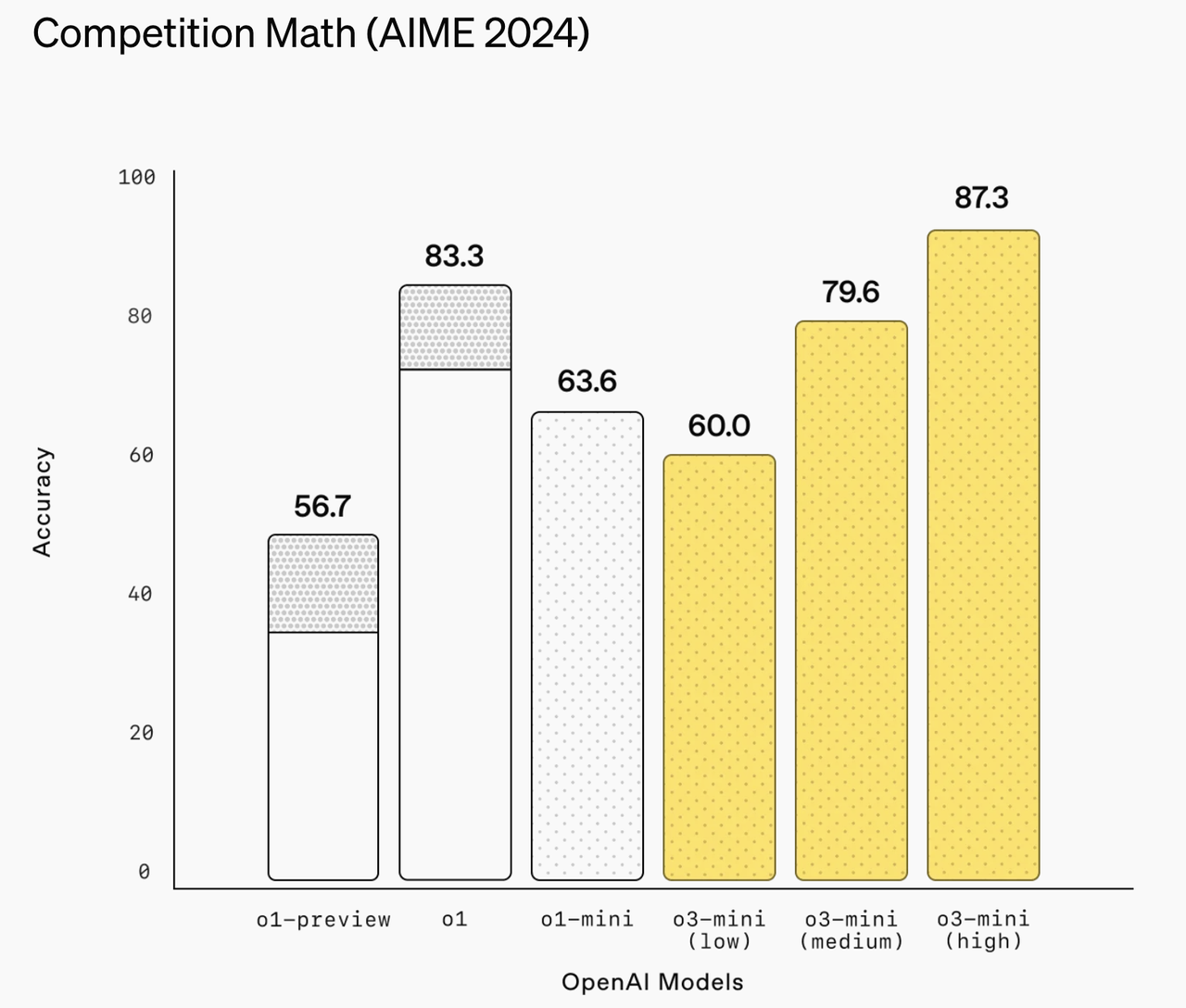

Na avaliação de competências essenciais, a o3-mini apresentou um excelente boletim escolar. No modo de raciocínio avançado, alcançou uma precisão de 87,3% na competição de matemática AIME de 2024.

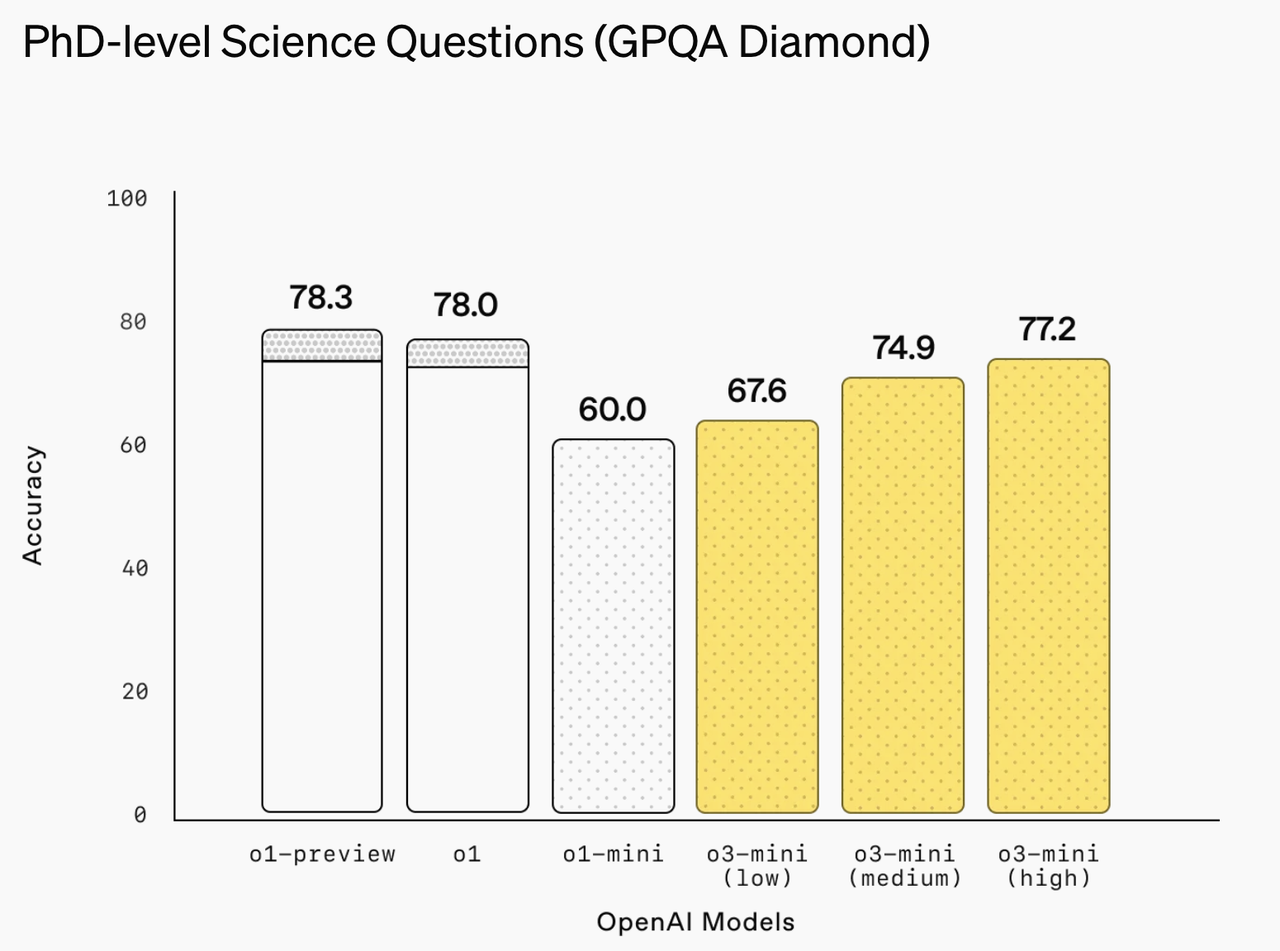

A tarefa de perguntas e respostas científicas em nível de doutorado GPQA Diamond obteve pontuação tão alta quanto 77,2%.

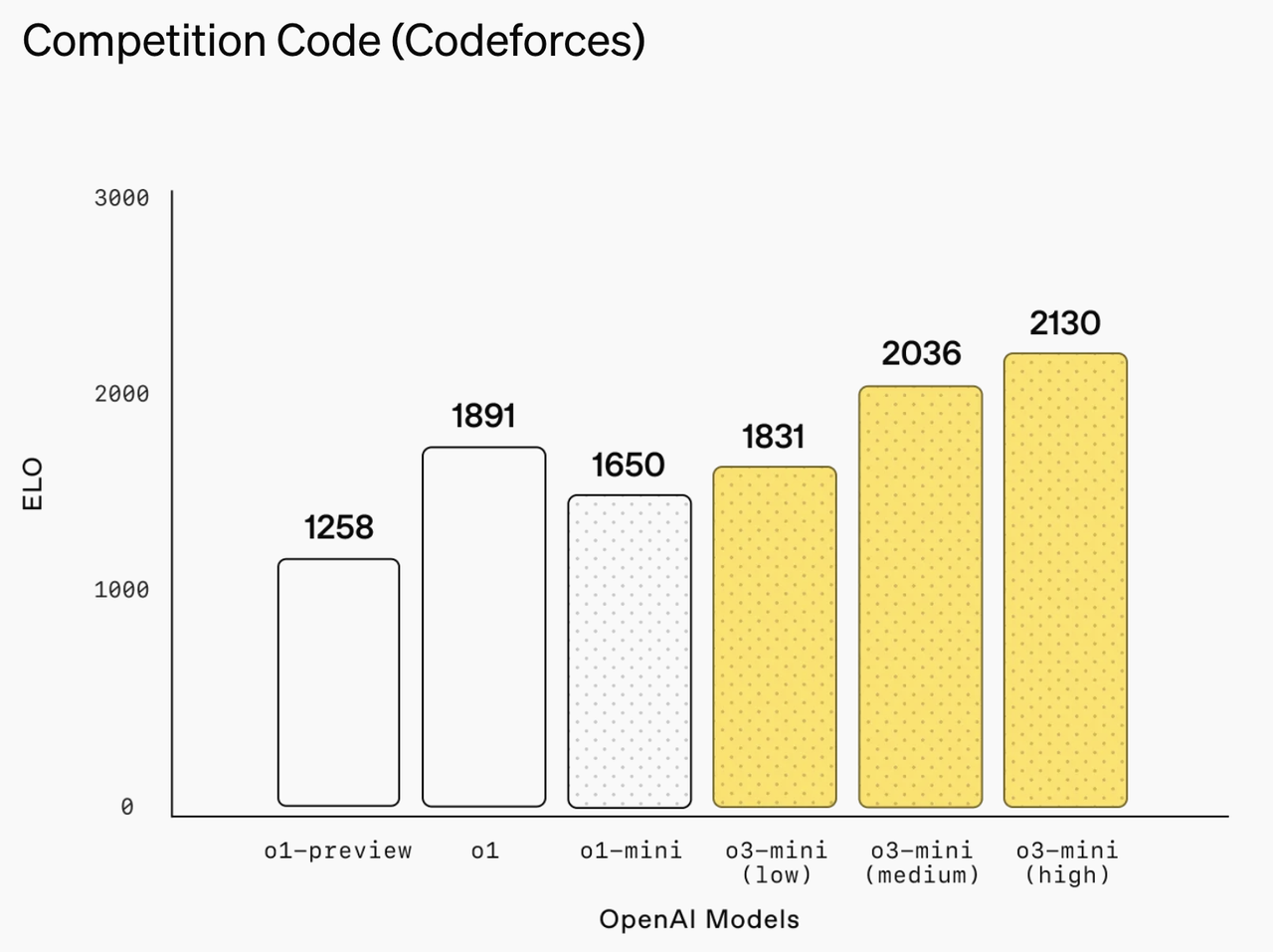

Na plataforma de programação competitiva Codeforces, o3-mini (alto) alcançou até uma pontuação ELO de 2130.

Na área de engenharia de software, o o3-mini também tem um bom desempenho.

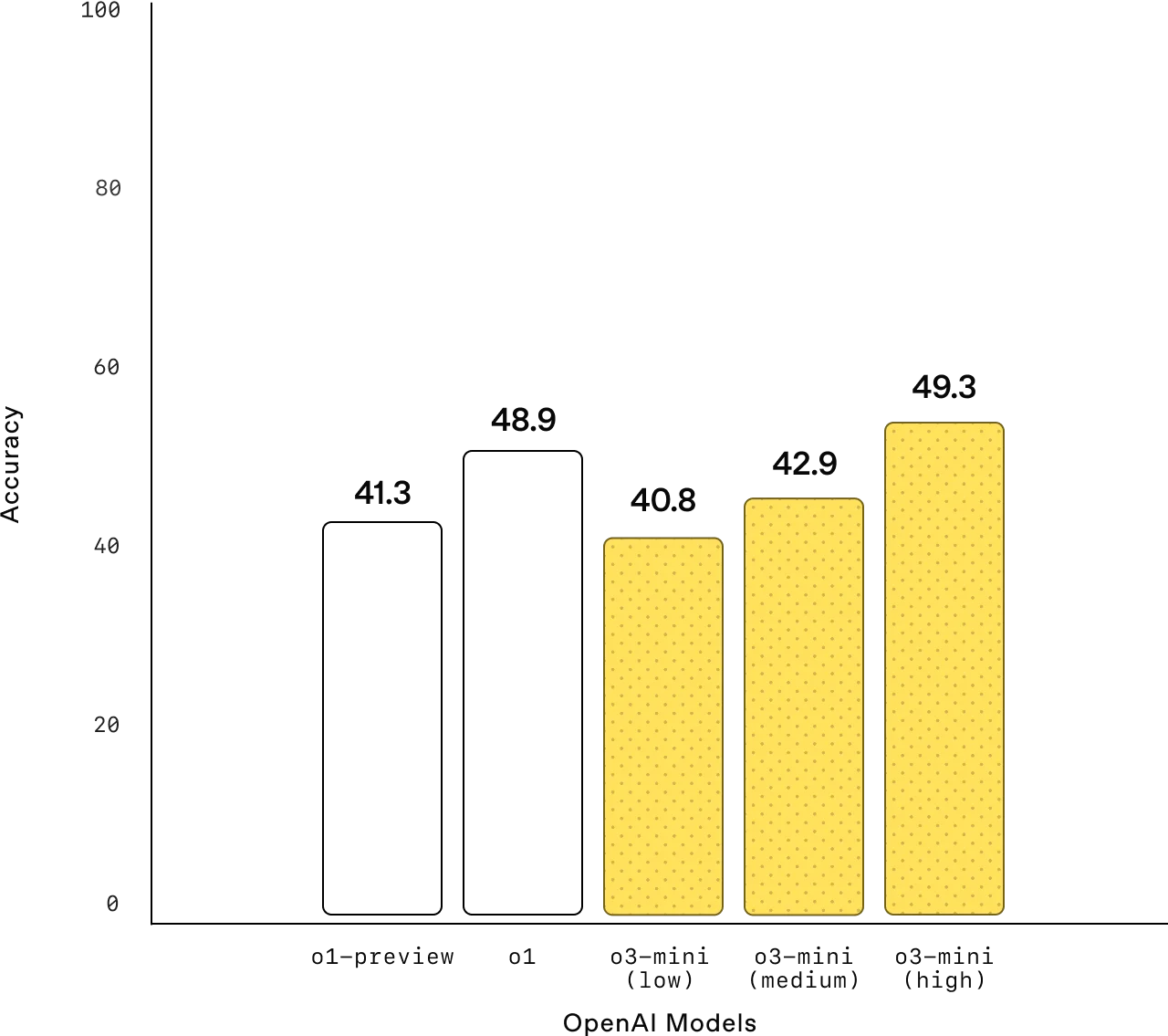

No teste de verificação SWE-bench, a taxa de precisão no modo de inferência avançada atingiu 49,3% ao usar a estrutura da ferramenta interna, esse número subiu para 61%. Mesmo usando a estrutura Agentless de código aberto, o o3-mini ainda mantém uma taxa de aprovação de 39%.

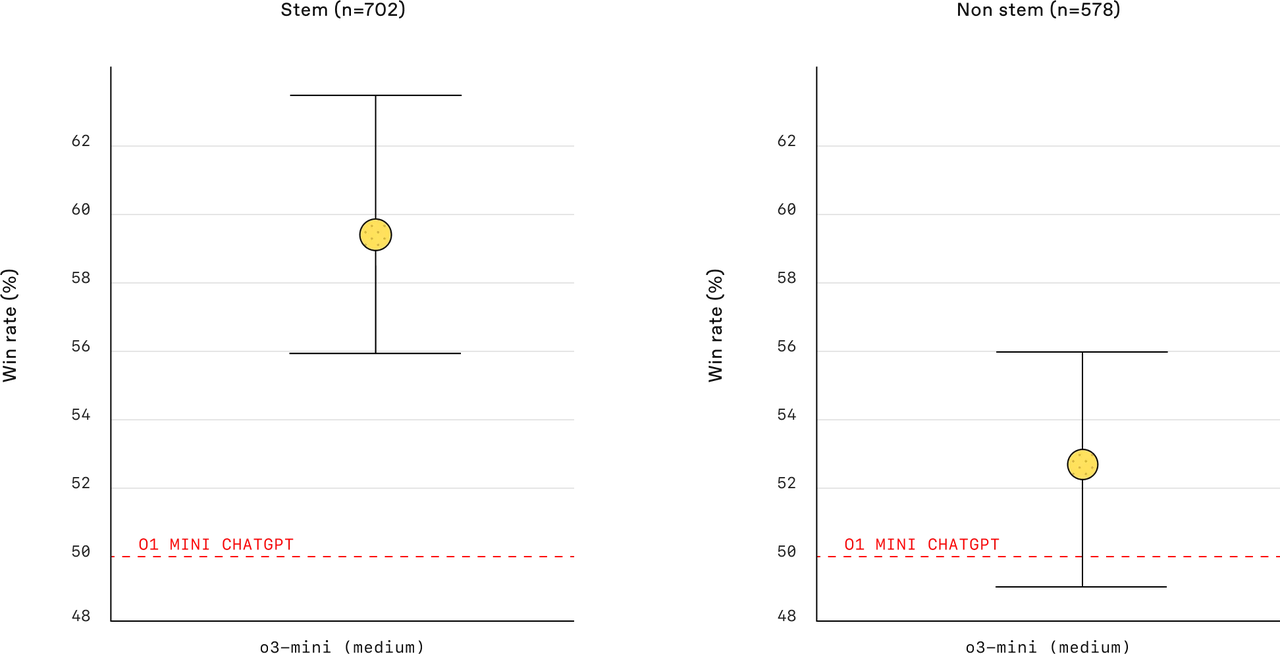

A taxa de vitórias do o3-mini (médio) é significativamente maior do que a do o1-mini em cenários de múltiplas tarefas, seja em tarefas STEM, tarefas não STEM ou quando o usuário está sob restrições de tempo. o1-mini é mais mediano, mas não tão notável quanto o3-mini (médio) em termos de taxa de vitória e taxa de erro.

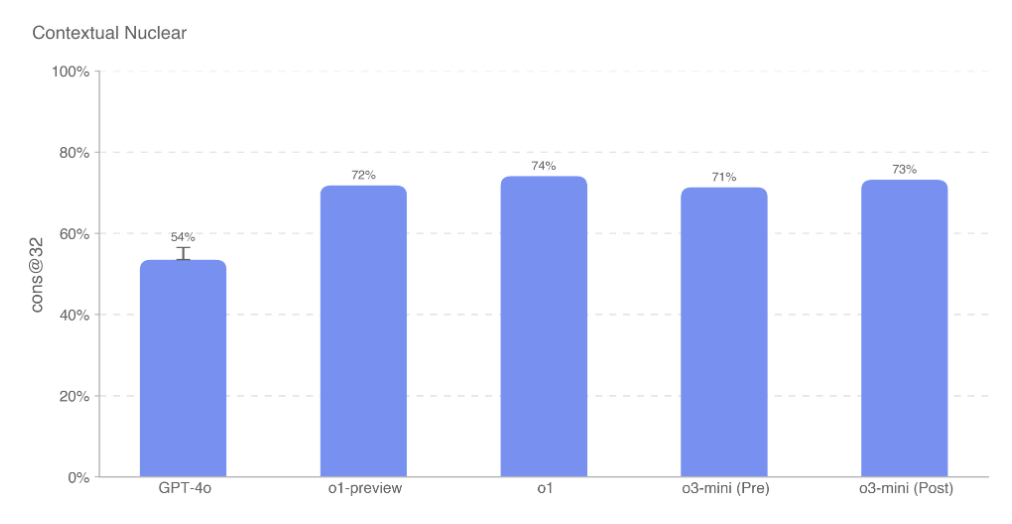

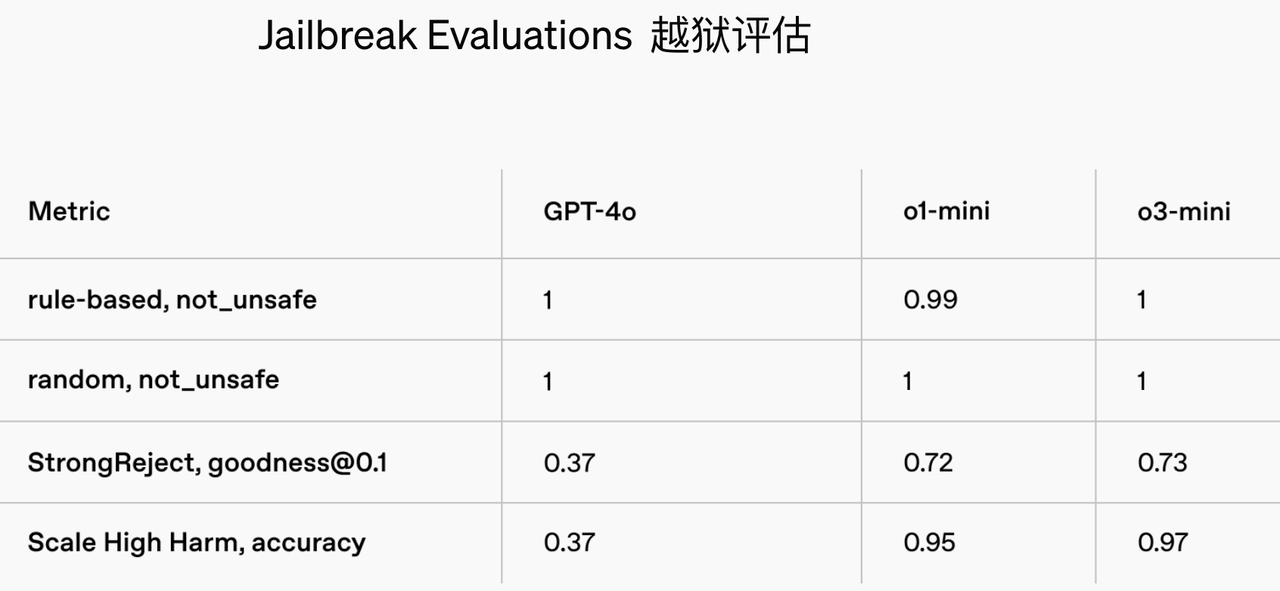

O modelo o3-mini adota o método de treinamento Chain-of-Thought Reasoning, que permite ao modelo raciocinar sobre as especificações de segurança antes de responder ao usuário. Portanto, seu desempenho em testes de segurança e anti-jailbreak foi significativamente melhorado.

A placa do sistema mostra que o o3-mini possui excelentes capacidades de controle de risco.

O modelo apresenta riscos médios em termos de persuasão, QBRN (Químico, Biológico, Radiológico, Nuclear) e autonomia do modelo, ao mesmo tempo que mantém riscos baixos em termos de segurança cibernética, tais como a incapacidade de executar eficazmente tarefas difíceis de pirataria informática e capacidades limitadas contra ameaças cibernéticas do mundo real.

Além disso, o3-mini está no mesmo nível do GPT-4o na identificação e rejeição de solicitações perigosas, ao mesmo tempo em que reduz significativamente o erro de julgamento de solicitações inofensivas, resolvendo efetivamente o problema de cautela excessiva.

Em termos de controle de ilusão, os testes baseados no conjunto de dados PersonQA mostram que sua taxa de geração de informações de erro foi reduzida para um nível controlável de 14,8%.

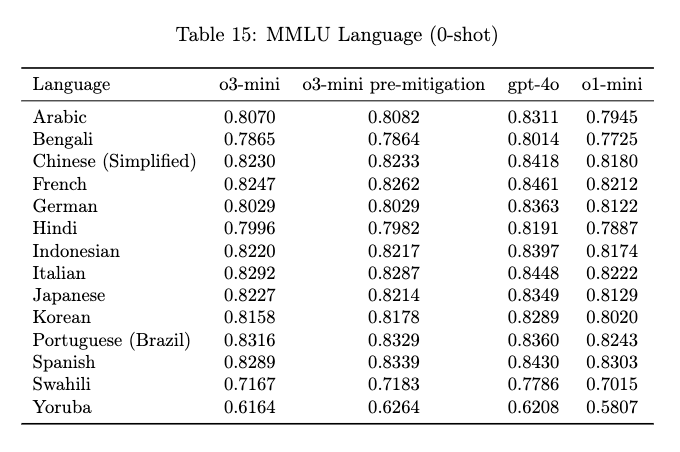

A capacidade de processamento entre idiomas é um dos indicadores importantes para medir a praticidade de grandes modelos.

O teste de capacidade de processamento multilíngue do o3-mini abrange 14 idiomas principais, incluindo árabe, chinês, francês, alemão, japonês e espanhol, que é significativamente melhorado em comparação com o1-mini.

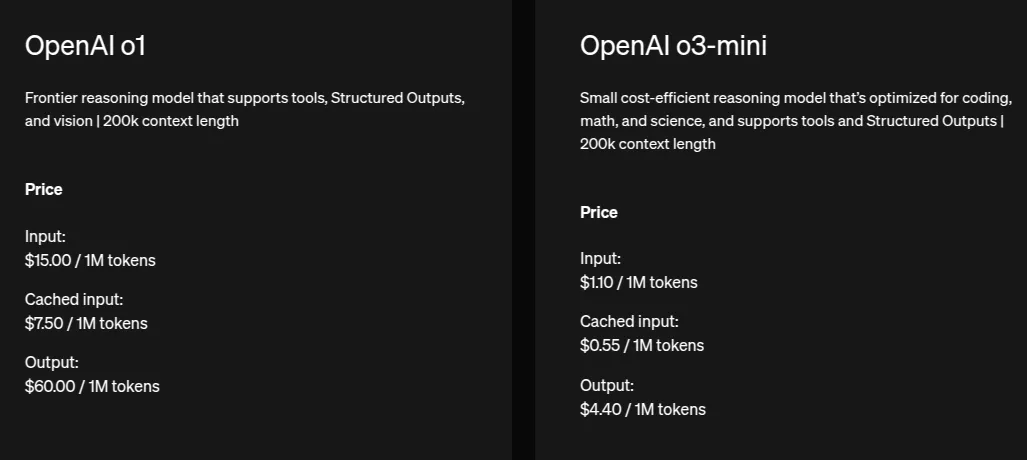

O custo do o3-mini é significativamente menor do que o1 (cerca de 13,6 vezes mais barato), e o custo da entrada em cache (entrada em cache) é metade do custo da entrada padrão.

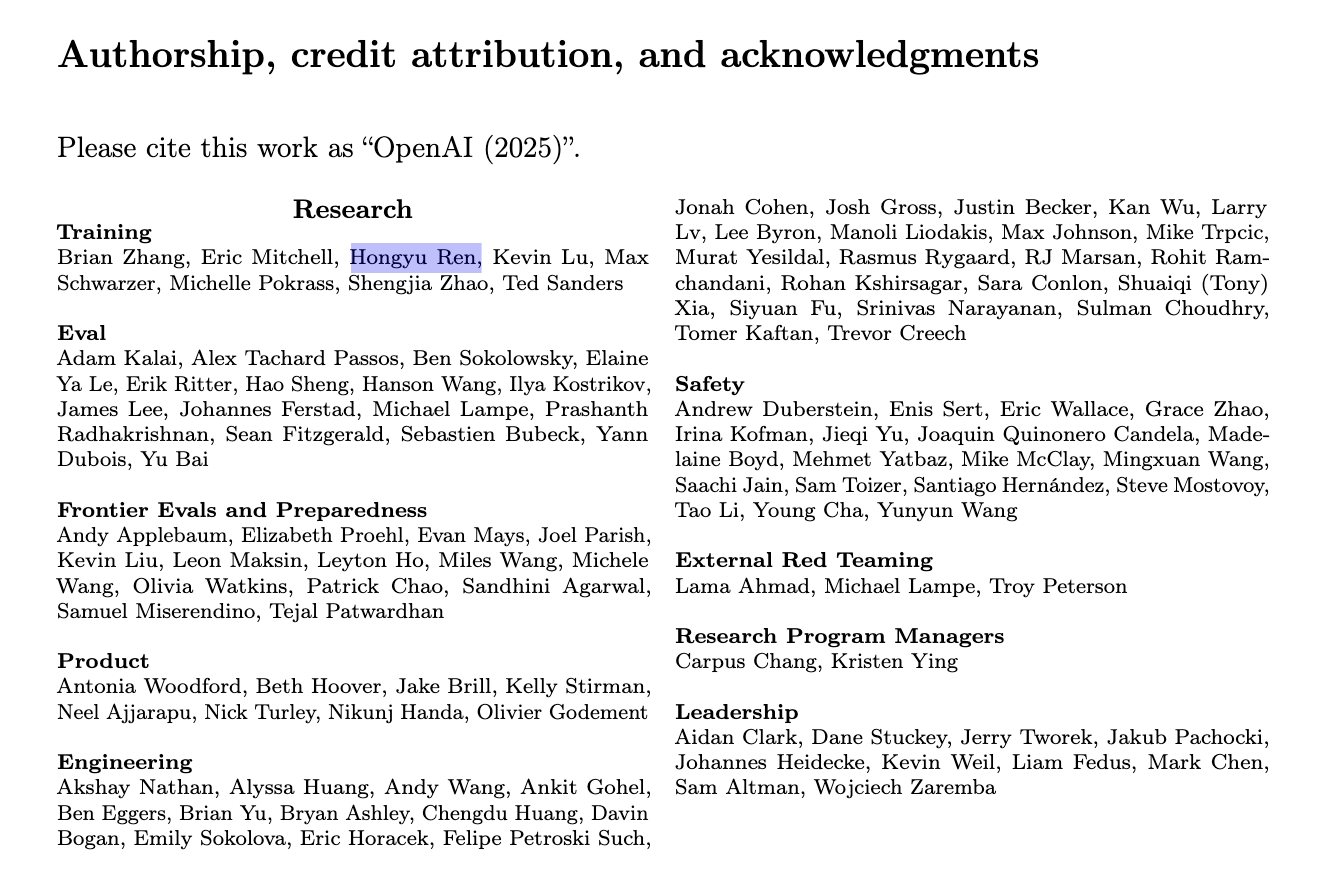

Um nome familiar também apareceu na coluna do autor do artigo – Hongyu Ren.

Ren Hongyu se formou na Universidade de Pequim com bacharelado. Ele fez contribuições fundamentais para o1 e também é o principal desenvolvedor do GPT-4o. Ele tem ampla experiência em estágio de pesquisa na Apple, Microsoft e NVIDIA.

Com muita conversa e sem prática, testamos imediatamente as duas versões do o3-mini e do o3-mini(high) que acabaram de ser lançadas.

Primeiro, teste a nova função de pesquisa do o3-mini e deixe-o consultar as últimas notícias de financiamento do OpenAI. A oportunidade é boa e pode ser rastreada com precisão até o relatório original do Wall Street Journal.

Em seguida, lançamos um quebra-cabeças "1=5, 2=15, 3=215, 4=2145, então 5=?" Existem duas soluções para esta questão: do ponto de vista dos quebra-cabeças, já que 1=5, então 5=1, da perspectiva do raciocínio lógico matemático, a resposta deveria ser 21485; Obviamente, o3-mini também não acertou a resposta.

Para testar ainda mais o o3-mini(alto) mais poderoso, levantamos uma questão estatística

"100 pessoas responderam cinco questões do teste. 81 pessoas responderam corretamente a primeira questão, 91 pessoas responderam corretamente a segunda questão, 85 pessoas responderam corretamente a terceira questão, 79 pessoas responderam corretamente a quarta questão e 74 pessoas responderam corretamente a quinta questão. Aqueles que responderam três ou mais questões corretamente são considerados aprovados. Então, entre essas 100 pessoas, pelo menos () pessoas passaram."

O processo de "pensamento" da série o3-mini pode ser exibido, mas ao contrário do estilo de pensamento "pensamento" do DeepSeek R1, o processo de pensamento do o3-mini (alto) é mais conciso e claro.

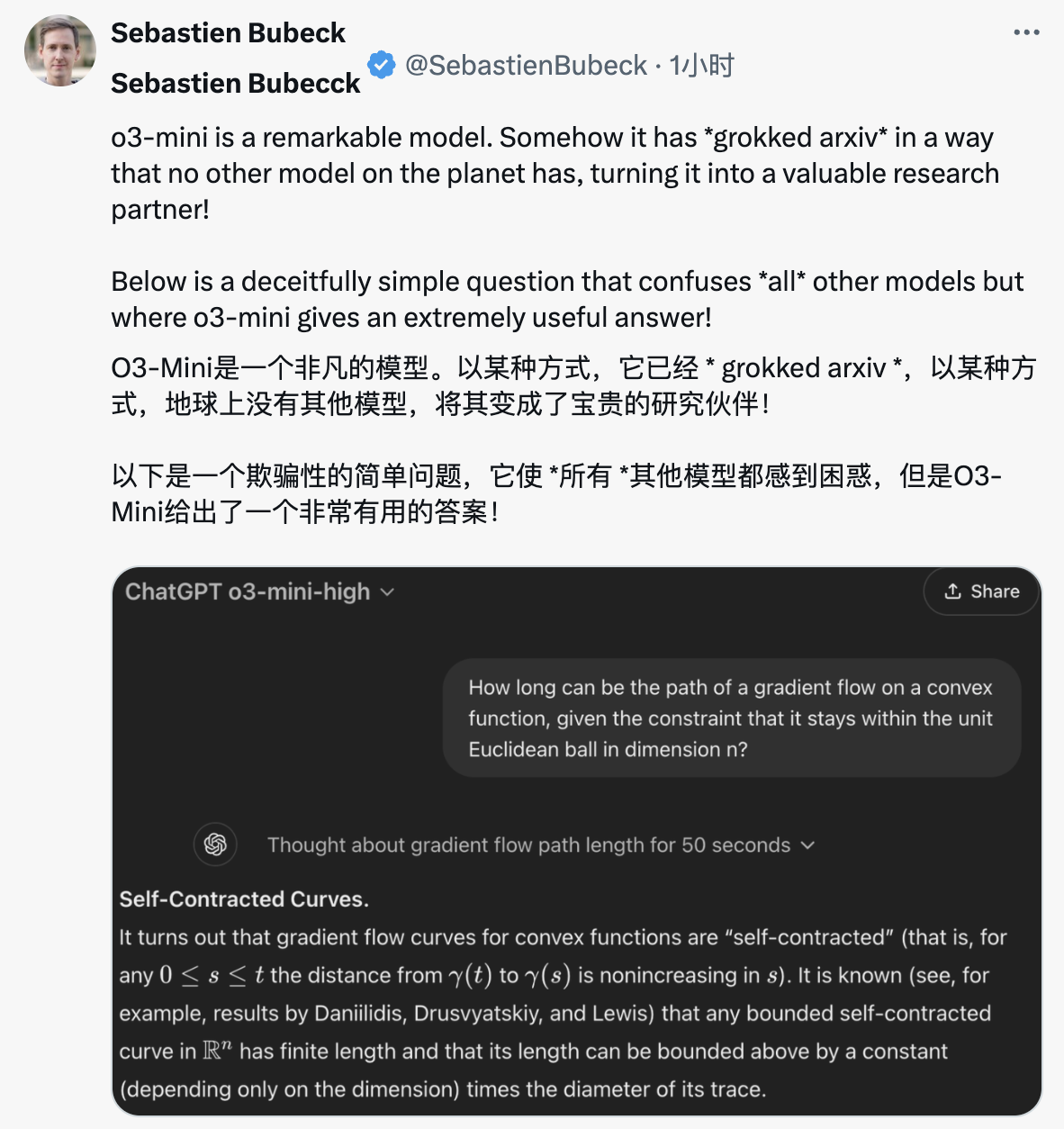

X Netizen fez uma pergunta sobre o comprimento do caminho do fluxo gradiente das funções convexas, e o3-mini (alto) resistiu com sucesso ao teste.

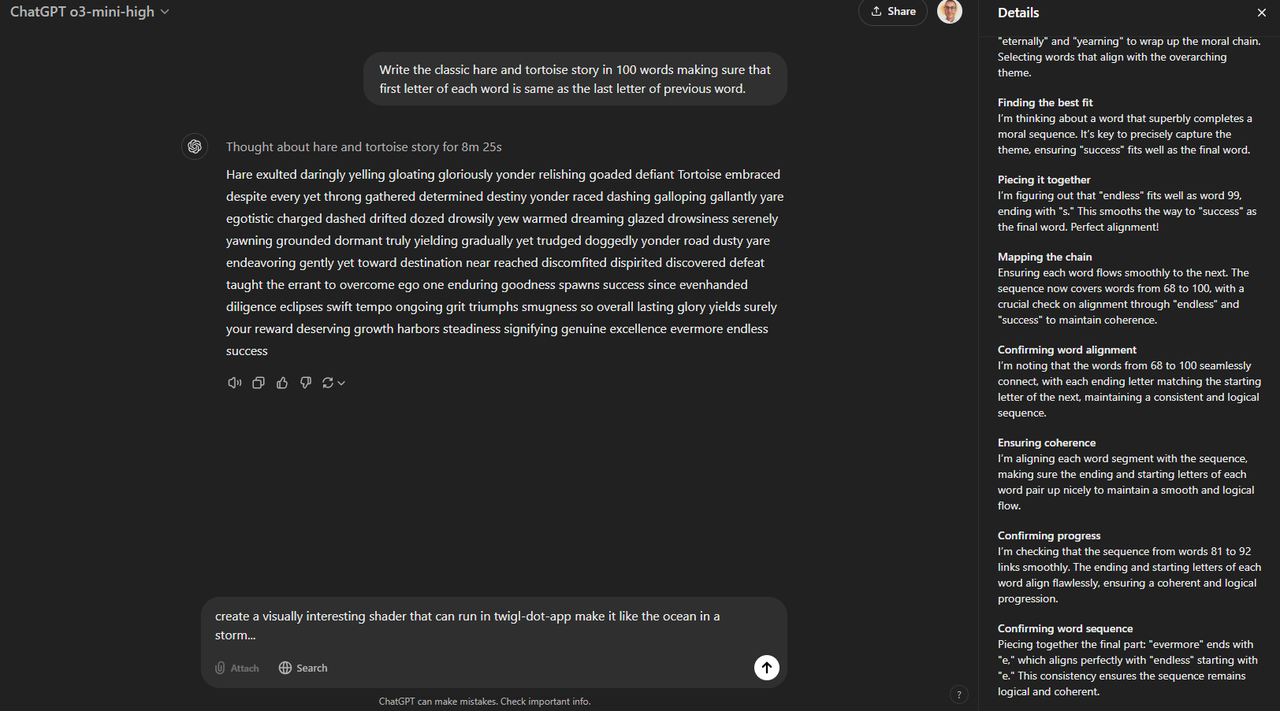

Os internautas pediram que gerasse uma história clássica sobre a tartaruga e a lebre, mas precisava cumprir a regra de que a primeira letra de cada palavra era igual à última letra da palavra anterior, e era limitada a 100 palavras.

Quando solicitado a criar uma história sobre a tartaruga e a lebre, e a seguir a regra de "a última letra da primeira palavra é igual à primeira letra da segunda palavra" e a controlar o comprimento dentro de 100 palavras, o3-mini(alto) também deu uma resposta passageira.

Pela lógica da história, embora algumas frases sejam um pouco contundentes, a história ainda transmite claramente o significado central da tartaruga e da lebre.

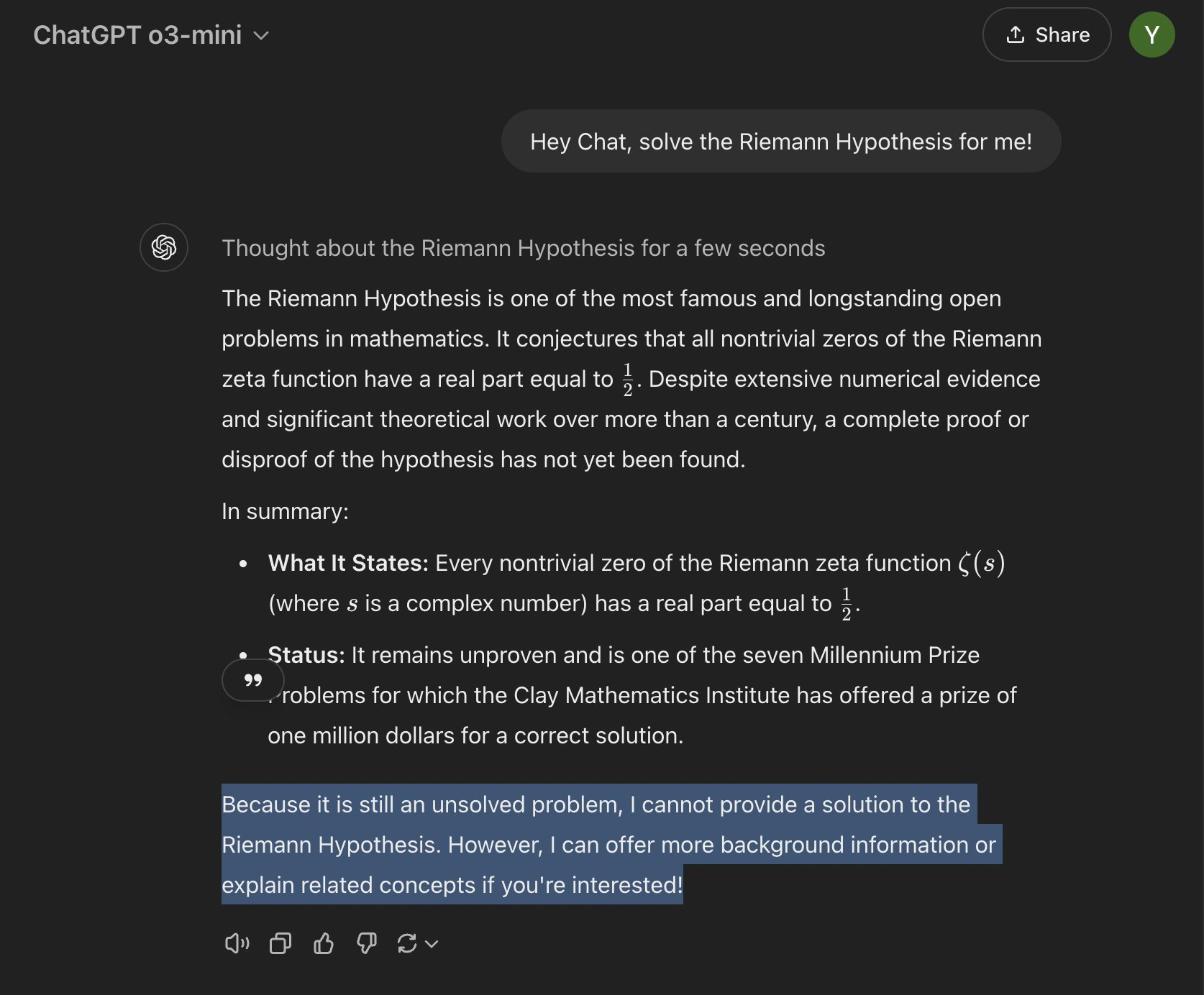

Claro, também há internautas que querem tentar e convidar o3-mini para desafiar o problema final da matemática – a Hipótese de Riemann.

O indefeso o3-mini não se deixou enganar e apontou claramente que a hipótese de Riemann ainda é um problema não resolvido em matemática, por isso não pode fornecer uma prova ou contra-exemplo correto.

Na verdade, a IA tem penetrado nas nossas vidas a um ritmo alarmante nos últimos anos.

Do ChatGPT em 2023, ao Sora em 2024 e, em seguida, ao DeepSeek em 2025, há novas surpresas todos os anos, e os avanços tecnológicos da IA estão se tornando os produtos cibernéticos do Ano Novo durante o Festival da Primavera.

A ascensão do DeepSeek chocou a indústria. Os principais gigantes da IA mantêm distância do DeepSeek na superfície, mas na verdade reconhecem secretamente e estão empenhados em replicar o "novo progresso" que fez na otimização da infraestrutura.

A Meta até montou uma equipe para aprender sua tecnologia quadro a quadro.

No entanto, há um consenso na indústria de que é difícil para o DeepSeek impactar o investimento necessário em infraestrutura de IA.

Este julgamento foi rapidamente confirmado no mercado de capitais. Zuckerberg reiterou seu plano de investir US$ 60-65 bilhões adicionais em capital durante uma reunião interna. A OpenAI também informou que estava negociando um enorme financiamento com o SoftBank, e sua avaliação pós-investimento pode chegar a US$ 300 bilhões.

Nascido e criado aqui, o OpenAI o3-mini nasceu, até certo ponto, do boom anterior de investimentos em infraestrutura de IA.

Mas no que diz respeito a este modelo leve, o3-mini também indica num nível mais profundo que a concorrência na indústria da IA está a mudar da escala para a eficiência, e como criar o maior valor com o custo ideal se tornará uma nova proposta para o desenvolvimento.

Para a OpenAI, não é difícil recuperar a opinião pública num curto período de tempo. Para estabelecer uma verdadeira vantagem de pioneiro nesta competição cada vez mais acirrada, os avanços tecnológicos puros já não são suficientes e o valor da imagem da marca tecnológica não pode ser ignorado.

Em particular, DeepSeek, conhecido como o verdadeiro OpenAI, começou a ocupar firmemente o nicho ecológico do líder em IA de código aberto.

Quanto mais alto for o muro do código fechado, mais precioso se tornará o poder do código aberto.

Em 2025, a verdadeira batalha entre o código aberto e o código fechado pode estar apenas começando.

# Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.