O robô OpenAI explode em cena! ChatGPT finalmente tem corpo, pode falar, ler e fazer tarefas domésticas

Grandes modelos representados pelo GPT-4 construíram cérebros, e o próximo passo é precisar de um corpo de robô que possa carregar esse cérebro.

Na noite passada, a empresa estrela do robô humanóide Figure AI lançou de forma chocante um vídeo mostrando uma série de interações conversacionais realizadas por seu robô Figura 01 com o apoio do poderoso modelo da OpenAI.

O robô no vídeo mostra respostas operacionais flexíveis e sua fluência na comunicação com humanos é quase comparável à de pessoas reais.

Isso ocorreu menos de meio mês depois que a Figure AI recebeu investimentos da OpenAI, Microsoft, NVIDIA e outras empresas. Também me permitiu ver como seria o grande modelo multimodal mais poderoso da OpenAI com um corpo.

Figura 01, o robô humanóide que melhor te entende?

Graças ao poderoso suporte do grande modelo multimodal da OpenAI, a Figura 01 é agora uma especialista em reconhecimento de objetos na mesa. Maçãs, escorredores, xícaras e pratos são moleza para isso!

Quando você estiver com fome e quiser comer um bocado inteiro, ele entenderá seus pensamentos instantaneamente e lhe entregará uma maçã suavemente.

Além disso, ele pode até pegar o lixo que você descartou e explicar por que acabou de lhe dar a maçã. Com a ajuda de modelos grandes, a Figura 01 consegue compreender o único alimento na mesa – maçãs.

Ao comando de um humano, a Figura 01 também pode fazer as tarefas domésticas e guardar a louça.Este robô é simplesmente o melhor parceiro na vida familiar.

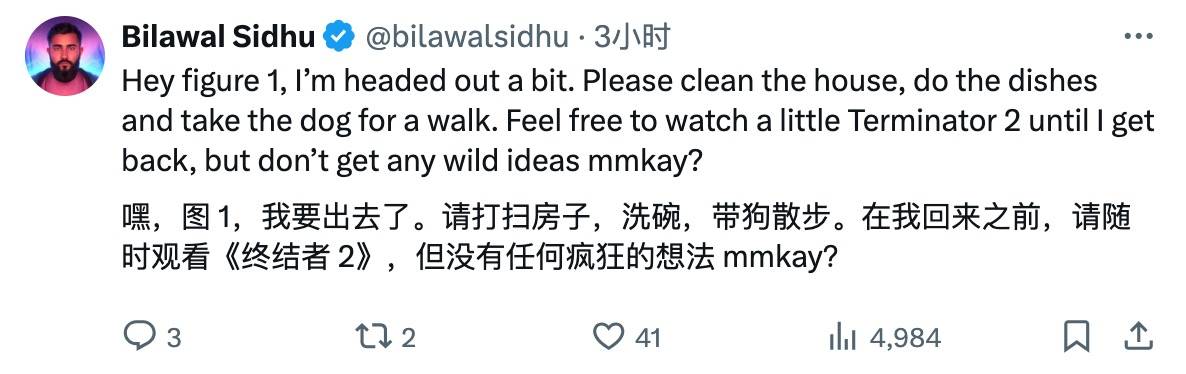

Depois de ver este vídeo impressionante, os internautas tiveram diversas reações.

Os internautas mal podem esperar para atribuir tarefas à Figura 01. Como é que existem filmes sobre antecessores de robôs misturados na lista de tarefas.

Os competidores estão com medo de ver isso, ansiosos no coração, preparando-se secretamente para se preparar para uma grande competição técnica?

Internautas mais entusiasmados disseram que o surgimento da AGI parece estar chegando.

Claro, sempre há vozes críticas, alguns internautas reclamaram, por que esse robô está gaguejando?

Os internautas também não perderam a oportunidade de fazer piadas.

Brett Adock, chefe da Figure AI, não estava disposto a ficar sozinho e saltou para o X para dar uma interpretação maravilhosa.

O vídeo demonstra a aplicação de redes neurais ponta a ponta. Nenhum controle remoto (teleop) é usado durante este processo. O vídeo é gravado na velocidade real (velocidade 1,0x) e é contínuo.

Como você pode ver no vídeo, a velocidade dos robôs melhorou significativamente e aos poucos estamos atingindo velocidades semelhantes às dos humanos.

Não é necessário controle remoto, autodidata

Então, como a Figura 01 faz isso?

O líder da equipe Figure AI, Corey Lynch, explicou isso no X.

Especificamente, todos os comportamentos demonstrados no vídeo foram aprendidos (não controlados remotamente) e executados em velocidade realista (velocidade 1,0x).

A Figure AI alimenta imagens capturadas pela câmera do robô e texto transcrito por voz gravado através do microfone integrado em um modelo multimodal treinado pela OpenAI que pode compreender informações de imagem e texto.

O modelo processa todo o histórico da conversa, incluindo imagens anteriores, para gerar uma resposta verbal e responder ao humano por meio de conversão de texto em fala. O mesmo modelo também é responsável por decidir qual comportamento de circuito fechado aprendido executar em resposta a um determinado comando.Ele carrega pesos específicos da rede neural na GPU e executa a política correspondente.

Conectar a Figura 01 a um grande modelo multimodal pré-treinado traz muitos novos recursos interessantes.

Agora, a Figura 01 + OpenAI pode:

- Detalhe seu entorno.

- Use o raciocínio do bom senso ao tomar decisões. Por exemplo, "Os itens sobre a mesa, como o prato e o copo, provavelmente serão colocados no escorredor a seguir."

- Converta instruções vagas de alto nível, como "Estou com fome", em comportamentos apropriados à situação, como "Passe uma maçã para aquela pessoa".

- Explique em inglês simples por que ele executa uma ação específica. Por exemplo, “Este é o único item comestível que posso oferecer da mesa”.

Quando se trata das excelentes habilidades práticas que a Figura 01 dominou por meio do aprendizado, há na verdade uma série de princípios complexos e sutis por trás disso.

Todos os comportamentos são impulsionados pela estratégia de conversão visão-motor da rede neural, que mapeia diretamente os pixels da imagem em ações. Essas redes recebem imagens incorporadas ao robô a uma taxa de 10 quadros por segundo e geram 200 movimentos de 24 graus de liberdade (incluindo poses de pulso e ângulos de articulação dos dedos) 200 vezes por segundo.

Esses movimentos servem como “pontos de ajuste” de alta velocidade para rastreamento por controladores de corpo inteiro de alta velocidade, garantindo a execução precisa dos movimentos.

Este design alcança uma separação eficaz de preocupações:

- Modelos pré-treinados da Internet realizam raciocínios de bom senso em imagens e texto para gerar um plano de alto nível.

- A estratégia visuomotora aprendida executa esse plano, realizando comportamentos rápidos e reativos que são difíceis de especificar manualmente, como manipular uma bolsa deformável em qualquer posição.

- Ao mesmo tempo, o controlador de corpo inteiro é responsável por garantir a segurança e estabilidade dos movimentos, por exemplo, mantendo o equilíbrio do robô.

Sobre o grande progresso alcançado pela Figura 01, Corey Lynch lamentou:

Há apenas alguns anos, eu teria pensado que ter uma conversa completa com um robô humanóide capaz de planejar e executar autonomamente comportamentos aprendidos ainda estaria décadas no futuro. Claramente, muitas coisas mudaram dramaticamente.

Poderia este ser o momento GPT dos robôs humanóides?

É preciso dizer que a velocidade de desenvolvimento da Figura 01 é como pisar no acelerador e correr até o fim.

Em janeiro deste ano, a Figura 01 dominou a habilidade de fazer café, conquista que se deveu à introdução de uma rede neural ponta a ponta, permitindo ao robô aprender e corrigir erros de forma autônoma, com apenas 10 horas de treinamento.

Um mês depois, a Figura 01 aprendeu a nova habilidade de levantar caixas e entregá-las a uma esteira transportadora, embora a apenas 16,7% da velocidade dos humanos.

Durante este processo, o ritmo de comercialização da Figura AI não parou, ela assinou um acordo comercial com a BMW Manufacturing Company para integrar IA e tecnologia robótica na linha de produção de automóveis e instalou-se na fábrica da BMW.

Então, há apenas duas semanas, a Figure anunciou a conclusão de uma rodada de financiamento Série B de US$ 675 milhões, com a avaliação da empresa subindo para US$ 2,6 bilhões.

Os investidores cobrem quase metade do Vale do Silício – Microsoft, OpenAI Venture Fund, NVIDIA, Jeff Bezos, Parkway Venture Capital, Intel Capital e Align Ventures, etc.

Naquela época, OpenAI e Figura também anunciaram que iriam desenvolver em conjunto a próxima geração de modelos de IA de robôs humanóides.O modelo multimodal da OpenAI será estendido à percepção, raciocínio e interação do robô.

Agora, a partir da Figura 01, parecemos conseguir vislumbrar um esboço da vida futura.

Na verdade, antes dos modelos grandes, os robôs eram equipamentos especializados. Agora, com as capacidades gerais dos modelos grandes, os robôs gerais estão começando a aparecer. Agora não precisamos apenas do ChatGPT, mas também do WorkGPT.

Estas evoluções confirmam indirectamente um caminho claramente visível: depois de o grande modelo de IA se enraizar, acabará por entrar no mundo real, e a inteligência incorporada é o melhor caminho.

O fundador da Nvidia, Jensen Huang, que tem atuado na linha de frente da IA, disse certa vez: “A inteligência incorporada liderará a próxima onda de inteligência artificial”.

A integração do grande modelo OpenAI na Figura 01 também é um layout estratégico intencional.

Grandes modelos maduros de IA atuam como cérebros artificiais, simulando a complexa rede neural do cérebro humano, realizando funções cognitivas, como compreensão da linguagem, reconhecimento visual e raciocínio situacional, e resolvendo problemas cognitivos e de tomada de decisão de nível superior para robôs.

Ao mesmo tempo, vários sensores, atuadores e unidades de computação são integrados ao corpo do robô para perceber e interagir com o ambiente. Por exemplo, os sistemas de visão podem capturar imagens e vídeos, e os sensores táteis podem detectar a forma e a textura dos objetos.

O fundador da Figure AI, Brett Adcock, afirmou anteriormente em uma entrevista que nos próximos 1-2 anos, a Figure AI se concentrará no desenvolvimento de produtos de referência e espera demonstrar os resultados de pesquisa e desenvolvimento de robôs humanóides ao público nos próximos um ou dois anos, cobrindo sistemas de IA, controle de baixo nível, etc., e finalmente surgir um robô que pode mostrar seus talentos na vida cotidiana.

Ele também revelou que, em termos de custo, um robô humanóide tem cerca de 1.000 peças e pesa cerca de 150 libras (68 kg), enquanto um carro elétrico pode ter cerca de 10.000 peças e pesar 4.000-5.000 libras (1.800-2.250 kg). Portanto, no longo prazo, espera-se que o custo dos robôs humanóides seja inferior ao dos carros elétricos baratos, dependendo do custo dos atuadores, componentes do motor, sensores e custos de computação.

O especialista em robôs Eric Jang certa vez apresentou sua visão: "Embora muitos pesquisadores de IA acreditem que levará décadas para que os robôs universais se tornem populares, não se esqueça que o ChatGPT nasceu quase da noite para o dia."

Há um ano, a OpenAI lançou o GPT-4, provando ao mundo o poder dos modelos grandes.

Hoje, um ano depois, não esperamos pelo GPT-5, mas também saudamos a Figura 01. Será este o momento do GPT-4 para robôs humanóides?

# Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (WeChat ID: ifanr).Mais conteúdo interessante será fornecido a você o mais rápido possível.