O resumo de fim de ano de 2025 do guru de IA, Karpathy, viraliza: a IA é ao mesmo tempo genial e tola; estes 6 pontos de virada são os mais cruciais.

Com a recente publicação de diversos relatórios de fim de ano, Andrej Karpathy, ex-cofundador da OpenAI, também compartilhou seu resumo anual de grandes modelos.

No início deste ano, seu discurso na YC viralizou, apresentando muitos pontos de vista novos:

- O Software 3.0 chegou: do código inicial escrito por humanos (1.0) ao fornecimento de dados para treinar modelos (2.0), entramos agora na era 3.0 de "instrução" direta ao modelo.

- O LLM é um novo sistema operacional: não é um produto comum como água da torneira, mas um sistema operacional complexo responsável pelo gerenciamento de memória (janela de contexto) e CPU (poder computacional de inferência).

- Uma década para agentes: Não espere que os agentes de IA amadureçam em um ano. Levará uma década para passarmos de 99% para 99,999% de confiabilidade.

Em seu resumo de fim de ano de 2025, Karpathy analisou mais uma vez para nós que tipo de "cérebro" a IA desenvolveu neste ano.

Segue abaixo uma tradução concisa do resumo anual de Karpathy, com a APPSO fornecendo interpretações mais acessíveis sem alterar o significado original.

Para ler o artigo original, clique aqui.  https://karpathy.bearblog.dev/year-in-review-2025/

https://karpathy.bearblog.dev/year-in-review-2025/

2025 será um ano de forte crescimento e grande incerteza para o LLM (Large Language Model). Abaixo, listo algumas "mudanças de paradigma" que considero notáveis e, de certa forma, surpreendentes — mudanças que não apenas remodelaram o cenário do setor, mas também impactaram profundamente minha compreensão de conceitos.

Versão resumida:

Versão resumida:

2025 é um ano emocionante e, ao mesmo tempo, um pouco surpreendente.

O LLM está emergindo como um novo tipo de inteligência, que é ao mesmo tempo muito mais inteligente e muito mais burra do que eu esperava.

Independentemente disso, são extremamente úteis. Acredito que, mesmo com as capacidades atuais, a indústria ainda não explorou nem 10% do seu potencial. Ao mesmo tempo, ainda há muitas ideias a serem exploradas e, conceitualmente, o campo ainda parece vasto. Como mencionei no início deste ano, também acredito (aparentemente paradoxalmente) que veremos um progresso rápido e contínuo, mas ainda há muito trabalho árduo pela frente.

Apertem os cintos, vamos partir.

1. RLVR: Ensinando IA a "pensar" como se estivesse resolvendo problemas de matemática de olimpíada

Antes de explicar esse conceito fundamental complexo, vamos analisar como o treinamento de modelos de grande porte era feito antigamente.

No início de 2025, as "três antigas" fórmulas para a formação de LLMs (mestres em pesquisa) em grandes laboratórios estavam muito estáveis:

1. Pré-treinamento : Assim como o GPT-3, deixe a IA ler artigos de toda a internet e aprender a falar.

2. Ajuste fino supervisionado (SFT): Peça para alguém escrever as respostas padrão e ensine a IA a responder às perguntas.

3. Aprendizado por Reforço com Feedback Humano (RLHF): Permite que a IA gere várias respostas e que humanos as avaliem, ensinando-a a ser mais agradável.

Que mudanças ocorreram agora?

Em 2025, adicionamos um ingrediente poderoso a essa fórmula: RLVR (Aprendizado por Reforço a partir de Recompensas Verificáveis).

O que isto significa?

Em termos simples, significa deixar de ter humanos corrigindo (os humanos são muito lentos e subjetivos), e passar a usar IA para realizar tarefas com "respostas padronizadas", como problemas de matemática ou escrita de código. Certo é certo e errado é errado; a máquina pode verificar automaticamente.

Por meio de milhões de simulações e tentativas, os modelos desenvolveram espontaneamente estratégias que parecem ser "raciocínio" . Eles aprenderam a decompor grandes problemas em etapas menores e até mesmo técnicas avançadas, como "voltar para verificar" (veja o artigo do DeepSeek R1).

Principais comparações:

- O paradigma antigo (RLHF) é como ensinar uma criança a escrever uma redação. Como não existe uma resposta padrão, a IA tem dificuldade em saber em que etapa está errando e só consegue imitar o tom humano.

- O novo paradigma (RLVR) é como colocar a IA em um campo de treinamento avançado de matemática. Você não precisa ensiná-la processos de pensamento específicos; basta fornecer problemas suficientes e feedback sobre suas respostas, e ela descobrirá os padrões de resolução de problemas por conta própria.

Essa estratégia foi tão eficaz que, em 2025, a maior parte do poder computacional havia sido consumida por essa "fera devoradora de dinheiro". O resultado foi que o modelo não ficou maior, mas o tempo de treinamento aumentou . Também ganhamos uma nova ferramenta: permitir que a IA pensasse por mais tempo . O o1 da OpenAI foi o começo, enquanto o o3 foi o verdadeiro ponto de virada.

2. Fantasmas vs. Animais: A IA não é um "animal de estimação digital"

Em 2025, eu e toda a indústria finalmente entendemos intuitivamente o "formato" da inteligência do LLM.

Uma analogia arrepiante: não estamos "evoluindo/criando animais" como animais de estimação; estamos "invocando fantasmas".

Por que eu digo isso?

Porque tudo na IA é diferente do que acontece nos organismos vivos. O cérebro humano é otimizado para a sobrevivência na selva e para a reprodução; enquanto o cérebro do LLM é otimizado para imitar a linguagem humana, obter notas altas em problemas de matemática e ganhar curtidas em arenas competitivas.

Inteligência Irregular:

É precisamente devido à existência de RLVR (Recompensas e Recompensas Verificáveis) que as capacidades da IA em certos campos (como matemática e programação) podem aumentar repentinamente de forma drástica. Isso leva a um fenômeno extremamente cômico:

- Ele também é um gênio incomparável (capaz de resolver problemas matemáticos avançados em segundos);

- Outro aluno do ensino fundamental com deficiência intelectual (que pode ser facilmente enganado por armadilhas lógicas simples).

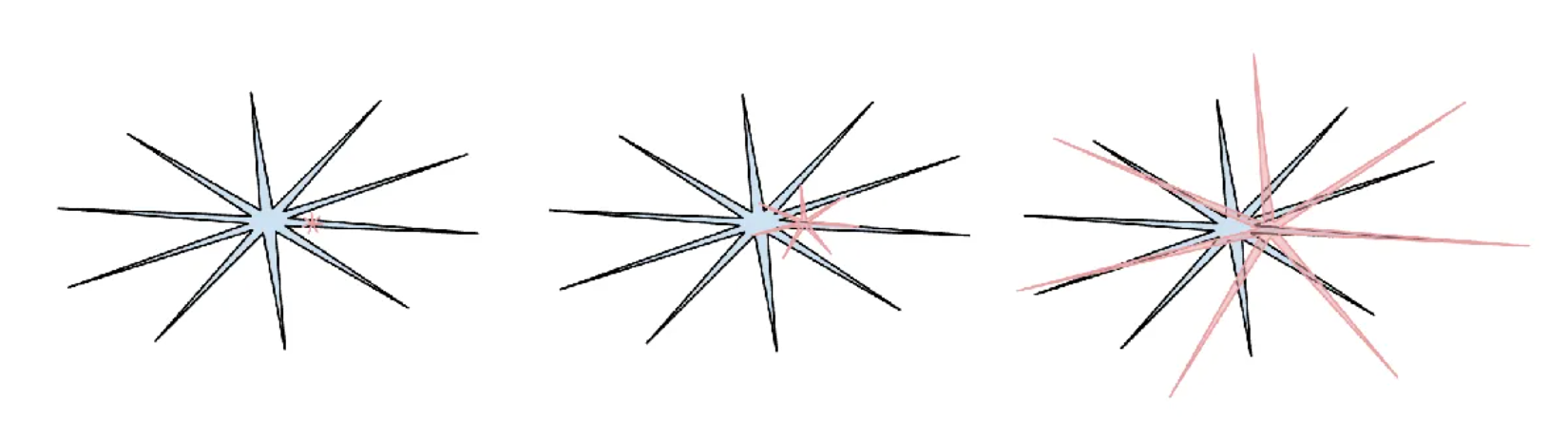

▲Aqui, Karpathy usa um meme: a inteligência humana é um círculo azul liso, enquanto a inteligência artificial é uma forma vermelha coberta de espinhos, como um ouriço-do-mar. É bem apropriado.

Isso também explica por que perdi a fé nos rankings de referência atuais.

Qual é a essência da "manipulação de rankings"?

Como a classificação é verificável, o RLVR pode ser usado para treinamento direcionado. Os laboratórios modernos estão essencialmente praticando "educação orientada a exames", visando especificamente as capacidades da IA para se adequar às questões da prova. "Treinar com conjuntos de testes" tornou-se mais do que apenas trapacear; tornou-se uma nova forma de arte.

3. Cursor: Mais do que um editor, é um "contratado"

A popularidade explosiva do Cursor este ano revelou uma nova verdade: a camada de aplicação do LLM é mais espessa do que pensávamos.

As pessoas começaram a falar sobre "cursores para a área médica" e "cursores para a área jurídica". O que exatamente esses aplicativos fazem?

- "Context Engineer": Ajuda você a organizar todas as informações de contexto para alimentar a IA.

- "Supervisor": Direcionando secretamente vários mestres em direito para trabalharem nos bastidores, decompondo tarefas complexas e ajudando você a economizar dinheiro.

- "Controle Remoto": Ele oferece um controle deslizante para ajustar a "autonomia" e decidir o quanto você permite que a IA faça.

Previsão: Grandes laboratórios de modelagem (como o OpenAI) serão responsáveis por treinar "estudantes generalistas"; enquanto desenvolvedores de aplicativos (como o Cursor) serão responsáveis por fornecer a esses estudantes dados e ferramentas privados, formando-os em "equipes de construção profissionais" .

4. Claude Code: O "Ciberfantasma" que vive no seu computador

O surgimento do Claude Code (CC) foi uma revelação. Não se trata apenas de um agente (agente inteligente) capaz de escrever código; mais importante ainda, ele reside dentro do seu computador .

Em comparação, acho que a OpenAI seguiu na direção errada.

Os primeiros agentes da OpenAI funcionavam na nuvem (ChatGPT), o que era muito distante do ambiente do mundo real. Embora agentes inteligentes baseados em nuvem pareçam ser o objetivo final da Inteligência Artificial Geral (IAG), na atual fase de transição desigual, o ambiente local é o caminho a seguir.

Por que a localização é importante?

Porque seu código, sua configuração, suas chaves, seu ambiente complexo, tudo é local. A Anthropic (empresa-mãe de Claude) acertou nas prioridades; eles condensaram IA em uma pequena interface de linha de comando (CLI).

Não se trata mais apenas de uma página da web no seu navegador (como o Google); tornou-se um "fantasma cibernético" residente no seu computador, pronto para realizar o seu trabalho a qualquer momento. É assim que a interação com IA no futuro deverá ser.

5. Codificação de Vibração

O que é Codificação Vibe?

Essa é uma palavra que eu inventei no Twitter (e que viralizou): significa que escrever código não exige mais que você entenda a sintaxe; basta descrever sua "intenção" e "sentimento" em inglês e deixar o resto para a IA.

Que mudanças isso provocou?

- Para pessoas comuns: A barreira de entrada para a programação desapareceu completamente.

- Para especialistas: O código tornou-se tão barato, descartável e reutilizável quanto papel higiênico.

Por exemplo, para encontrar um bug, eu poderia pedir para a IA escrever um aplicativo específico para teste na hora e depois excluí-lo. No passado, escrever um aplicativo só para encontrar um bug? Loucura! Mas em 2025, o código será gratuito.

A Vibe Coding vai remodelar completamente a indústria de software e reescrever as descrições de cargos para programadores.

6. Nano Banana: A IA finalmente tem seu próprio "rosto"

Por que a interação atual com a IA é tão anti-humana?

Seja o ChatGPT ou o Claude, ainda estamos conversando com eles "digitando". É como usar uma linha de comando DOS em preto e branco na década de 1980.

A verdade é: os computadores adoram texto, mas os humanos detestam ler texto. Os humanos são criaturas visuais; gostamos de olhar para imagens, tabelas e vídeos.

A banana do Google Gemini Nano (um codinome fictício que se refere a algum tipo de modelo de interação multimodal) representa outra mudança de paradigma em 2025. Ela indica como serão as GUIs (interfaces gráficas de usuário) do futuro do LLM .

A IA do futuro não deve apenas despejar um monte de texto; ela deve desenhar uma imagem, gerar uma página da web ou exibir um painel interativo. Isso é mais do que simplesmente "desenhar"; é uma capacidade híbrida que interliga geração de texto, raciocínio lógico e expressão visual.

#Siga a conta oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde você encontrará conteúdo ainda mais interessante o mais breve possível.