O que você precisa saber sobre as proteções de segurança infantil da Apple

A Apple anunciou recentemente novas proteções de segurança infantil que estão chegando neste outono com o lançamento do iOS 15, iPadOS 15 e macOS Monterey.

Veremos mais de perto esses recursos expandidos de segurança infantil e a tecnologia por trás deles abaixo.

Digitalização de material de abuso sexual infantil

A mudança mais notável é que a Apple vai começar a usar uma nova tecnologia para detectar imagens que retratam imagens de abuso infantil armazenadas no iCloud Photos.

Essas imagens são conhecidas como Material de Abuso Sexual Infantil, ou CSAM, e a Apple relatará ocorrências delas ao Centro Nacional para Crianças Desaparecidas e Exploradas. O NCMEC é um centro de relatórios para CSAM e trabalha com agências de aplicação da lei.

A digitalização do CSAM da Apple será limitada aos Estados Unidos no lançamento.

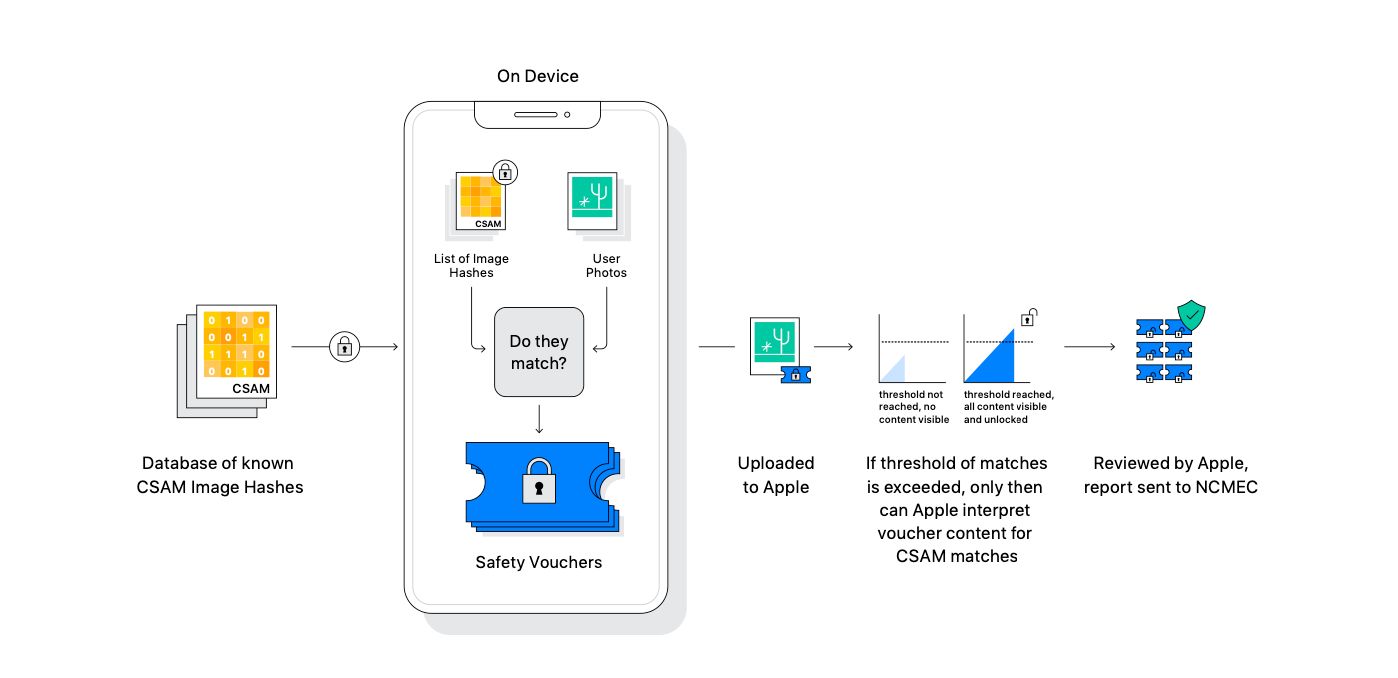

A Apple afirma que o sistema usa criptografia e foi projetado com a privacidade em mente. As imagens são verificadas no dispositivo antes de serem carregadas no iCloud Photos.

De acordo com a Apple, não há necessidade de os funcionários da Apple verem suas fotos reais. Em vez disso, o NCMEC fornece à Apple hashes de imagem de imagens CSAM. Um hash pega uma imagem e retorna uma sequência longa e exclusiva de letras e números.

A Apple pega esses hashes e transforma os dados em um conjunto ilegível de hashes armazenados com segurança em um dispositivo.

Antes de a imagem ser sincronizada com o iCloud Photos, ela é verificada nas imagens CSAM. Com uma tecnologia criptográfica especial – interseção de conjuntos privados – o sistema determina se há uma correspondência sem revelar um resultado.

Se houver uma correspondência, um dispositivo cria um voucher de segurança criptográfico que codifica a correspondência junto com mais dados criptografados sobre a imagem. Esse voucher é carregado no iCloud Photos com a imagem.

A menos que uma conta do iCloud Photos ultrapasse um limite específico de conteúdo CSAM, o sistema garante que os vouchers de segurança não possam ser lidos pela Apple. Isso graças a uma tecnologia criptográfica chamada compartilhamento secreto.

De acordo com a Apple, o limite desconhecido fornece uma grande quantidade de precisão e garante menos de uma chance em um trilhão de sinalizar incorretamente uma conta.

Quando o limite é excedido, a tecnologia permitirá que a Apple interprete os vouchers e as imagens CSAM correspondentes. A Apple revisará manualmente cada relatório para confirmar uma correspondência. Se confirmado, a Apple desativará a conta de um usuário e enviará um relatório ao NCMEC.

Haverá um processo de apelação para restabelecimento se um usuário achar que sua conta foi sinalizada por engano pela tecnologia.

Se você tiver preocupações com a privacidade do novo sistema, a Apple confirmou que nenhuma foto será digitalizada usando a tecnologia de criptografia se você desativar o Fotos do iCloud. Você pode fazer isso acessando Configurações> [Seu nome]> iCloud> Fotos .

Existem algumas desvantagens ao desligar o Fotos do iCloud. Todas as fotos e vídeos serão armazenados no seu dispositivo. Isso pode causar problemas se você tiver muitas imagens e vídeos e um iPhone antigo com armazenamento limitado.

Além disso, fotos e vídeos capturados no dispositivo não estarão acessíveis em outros dispositivos Apple usando a conta iCloud.

A Apple explica mais sobre a tecnologia que está sendo usada na detecção de CSAM em um documento PDF . Você também pode ler um FAQ da Apple com informações adicionais sobre o sistema.

No FAQ, a Apple observa que o sistema de detecção de CSAM não pode ser usado para detectar nada além de CSAM. A empresa afirma ainda que nos Estados Unidos, e em muitos outros países, a posse de imagens do CSAM é crime e que a Apple é obrigada a informar as autoridades.

A empresa também diz que recusará qualquer demanda do governo para adicionar uma imagem não CSAM à lista de hash. Também explica por que imagens não CSAM não podem ser adicionadas ao sistema por terceiros.

Por causa da análise humana e do fato de que os hashes usados são de imagens CSAM conhecidas e existentes, a Apple diz que o sistema foi projetado para ser preciso e evitar problemas com outras imagens ou usuários inocentes sendo relatados ao NCMEC.

Protocolo Adicional de Segurança de Comunicação em Mensagens

Outro novo recurso será a adição de protocolos de segurança no app Mensagens. Oferece ferramentas que alertam as crianças e seus pais ao enviar ou receber mensagens com fotos sexualmente explícitas.

Ao receber uma dessas mensagens, a foto ficará desfocada e a criança também será avisada. Eles podem ver recursos úteis e são informados de que não há problema se não visualizarem a imagem.

O recurso será apenas para contas configuradas como famílias no iCloud. Os pais ou responsáveis precisarão ativar o recurso de segurança de comunicação. Eles também podem optar por ser notificados quando uma criança de 12 anos ou menos enviar ou receber uma imagem sexualmente explícita.

Para crianças de 13 a 17 anos, os pais não são notificados. Mas a criança será avisada e questionada se deseja ver ou compartilhar uma imagem sexualmente explícita.

O Mensagens usa aprendizado de máquina no dispositivo para determinar se um anexo ou imagem é sexualmente explícito. A Apple não receberá nenhum acesso às mensagens ou ao conteúdo da imagem.

O recurso funcionará para mensagens SMS e iMessage regulares e não está vinculado ao recurso de varredura CSAM que detalhamos acima.

Orientação de segurança expandida no Siri e no Search

Por fim, a Apple expandirá a orientação para os recursos Siri e Search para ajudar crianças e pais a se manterem seguros online e receber ajuda em situações inseguras. A Apple apontou um exemplo em que os usuários que perguntam ao Siri como eles podem denunciar CSAM ou exploração infantil receberão recursos sobre como fazer uma denúncia às autoridades.

As atualizações chegarão ao Siri e ao Search para quando alguém realizar consultas de pesquisa relacionadas ao CSAM. Uma intervenção explicará aos usuários que o interesse no tópico é prejudicial e problemático. Eles também mostrarão recursos e parceiros para auxiliar na obtenção de ajuda com o problema.

Mais mudanças estão chegando com o software mais recente da Apple

Desenvolvidos em conjunto com especialistas em segurança, os três novos recursos da Apple são projetados para ajudar a manter as crianças seguras online. Mesmo que os recursos possam causar preocupação em alguns círculos focados na privacidade, a Apple tem se manifestado sobre a tecnologia e como ela irá equilibrar as preocupações com a privacidade com a proteção da criança.