O novo rei do código aberto! Derrotando o GPT-5 pela primeira vez, teste prático do Kimi K2 Thinking, a IA chinesa está enlouquecendo!

O Kimi K2 Thinking, o maior e melhor modelo de código aberto até o momento, com um total de 1 trilhão de parâmetros, obteve os melhores resultados em diversos testes de benchmark.

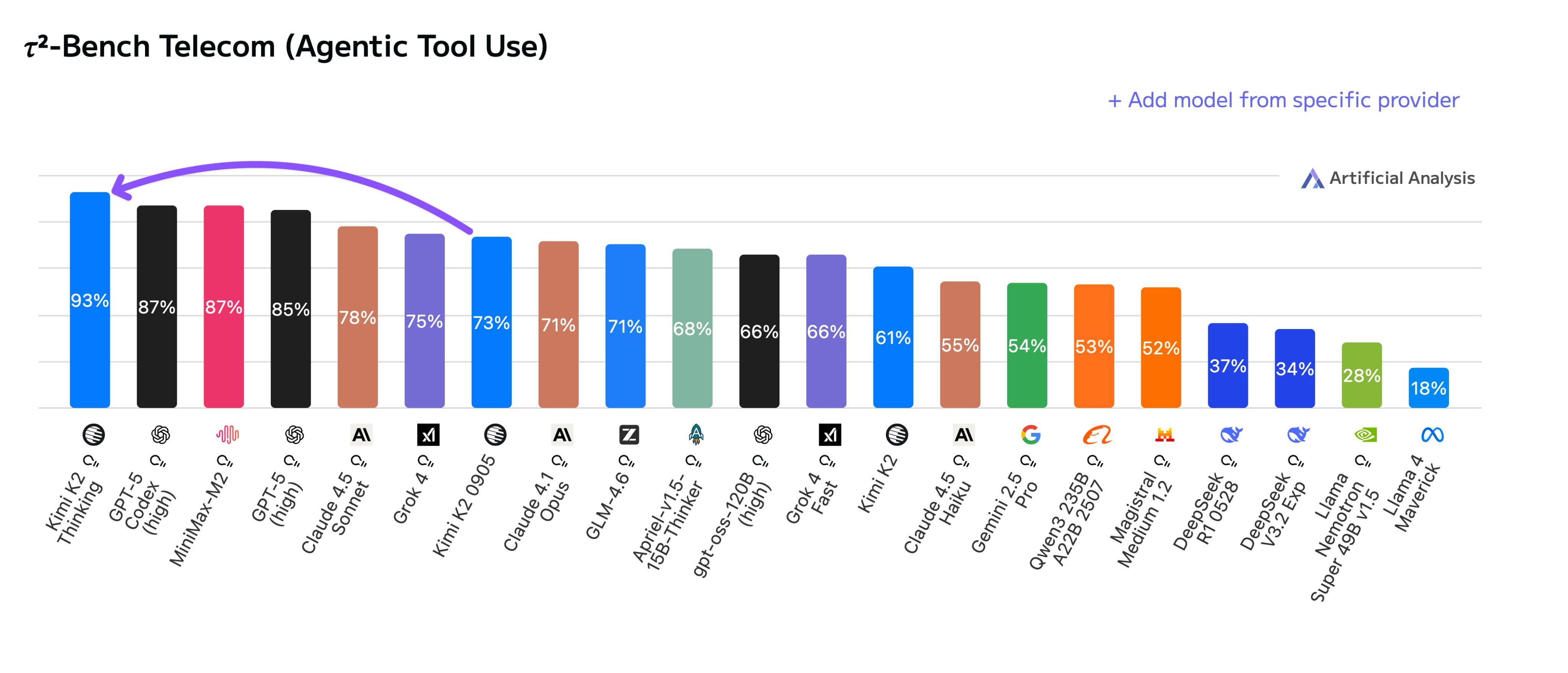

▲ O Kimi K2 Thinking ficou em primeiro lugar no ranking TAU (Agent Tool Invocation), superando modelos de ponta da OpenAI e da Anthropic.

Em sua estreia, conquistou imediatamente o primeiro lugar em diversas listas de benchmarks. Kimi não se limita a competir apenas com modelos de código aberto; em vez disso, utiliza com segurança modelos proprietários como GPT-5 e Claude 4.5 Sonnet.

▲ Os chefes dos departamentos de processamento de linguagem natural da Zhipu e da MiniMax, assim como o cofundador da HuggingFace, deixaram mensagens de parabéns na seção de comentários.

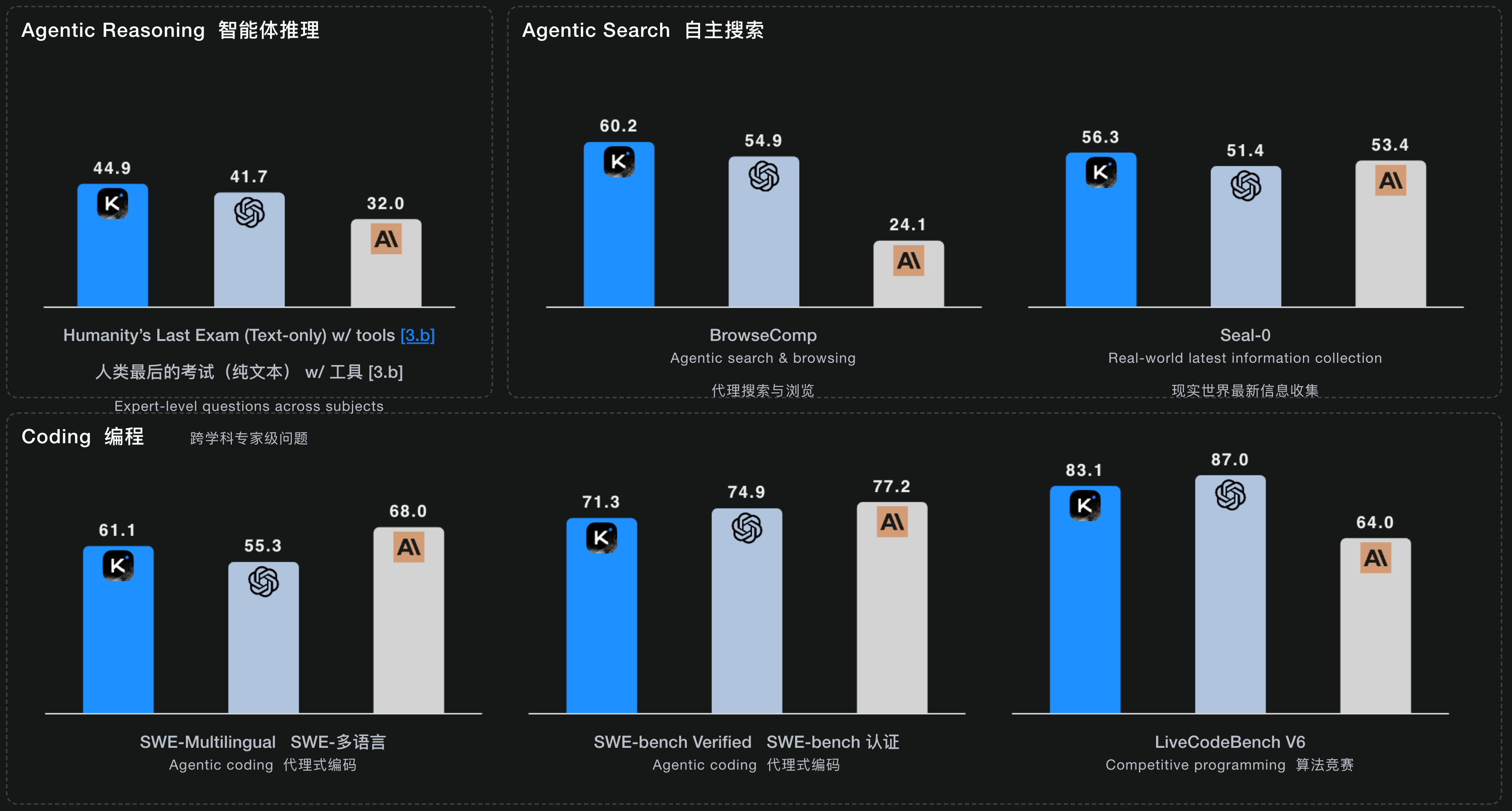

Além de ocupar o primeiro lugar nas listas de uso de ferramentas, o Kimi K2 Thinking está consistentemente entre os melhores modelos avançados no Human Last Exam (HLE), BrowseComp e outros testes de referência.

▲ Ficou em primeiro lugar no ranking HLE para problemas interdisciplinares de nível especialista e nos três rankings para busca autônoma; suas pontuações nos três rankings para capacidade de programação também foram próximas aos melhores modelos Claude ou GPT.

Seja para tarefas de programação que exigem altos níveis de capacidade do agente, ou para raciocínio geral, escrita e pesquisa avançada, o desempenho do Kimi K2 Thinking é indiscutivelmente o modelo de código aberto mais próximo de um modelo fechado atualmente disponível .

Dando continuidade ao seu lançamento em julho, onde foi posicionado como parte de um roteiro de inteligência autônoma, o Kimi K2 Thinking também se concentra em Inteligência Agêntica . Trata-se de um modelo híbrido de especialista (MoE) para raciocínio, com um total de 1 trilhão de parâmetros, 32 bilhões de parâmetros de ativação e um comprimento de contexto de 256 mil.

O K2 Thinking consegue intercalar processos de pensamento durante as chamadas de ferramentas do agente, realizando continuamente de 200 a 300 chamadas sequenciais de ferramentas enquanto mantém o objetivo da tarefa. Embora as chamadas de ferramentas tenham se tornado um padrão em modelos proprietários semelhantes, o K2 Thinking pode ser o primeiro modelo de código aberto com capacidades tão abrangentes de chamadas de ferramentas.

Em comparação com o K2 0905, resumimos as melhorias do K2 Thinking em tarefas específicas a partir do blog técnico de Kimi, destacando estes pontos principais.

- Resolver problemas complexos que exigem centenas de etapas de raciocínio : o sistema consegue decompor um grande objetivo em centenas de subtarefas e executá-las uma a uma, como um gerente de projetos. O exemplo oficial citado é o de um problema matemático de nível doutoral resolvido com sucesso por meio de 23 etapas de raciocínio interligadas e chamadas de ferramentas.

- Encontre informações mais precisas e detalhadas : Ao executar um ciclo dinâmico de pensamento → pesquisa → uso do navegador → raciocínio → código, o K2 Thinkging pode pesquisar repetidamente online, navegar em páginas da web e verificar evidências quando confrontado com requisitos de pesquisa vagos ou obscuros até encontrar a resposta precisa.

- Transforme ideias diretamente em produtos utilizáveis : o K2 Thinking é particularmente bom em código front-end (como HTML e React) e, assim como outros produtos da Vibe Coding, pode transformar nossas ideias diretamente em uma página da web ou produto de software totalmente funcional e responsivo.

- Escreva artigos mais humanos : artigos profissionais logicamente rigorosos, histórias criativas e imaginativas, e até mesmo conselhos emocionais que exigem empatia. O K2 Thinking pode desenvolver habilidades de raciocínio e escrita mais sólidas e refinadas, além de habilidades gerais como conversação e resposta a perguntas.

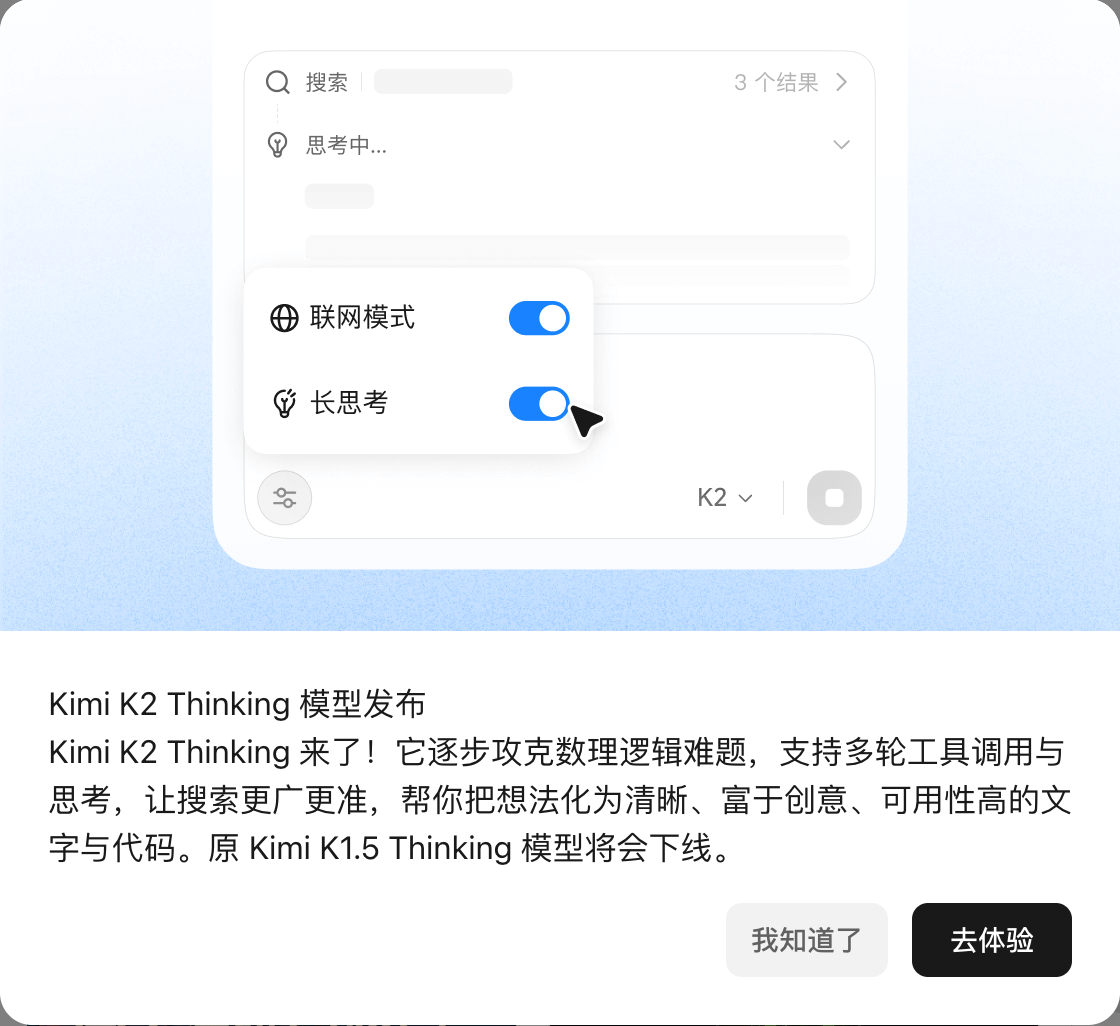

Atualmente, o Kimi K2 Thinking foi lançado no modo de bate-papo no site oficial da Kimi.

No entanto, é importante ressaltar que Kimi explicou que, para garantir uma experiência de usuário rápida e leve, a versão atual do chat na web reduz seletivamente o uso e a frequência de certas ferramentas. Portanto, conversar diretamente no kimi.com pode não reproduzir totalmente as pontuações extremas nos testes de benchmark mencionados acima.

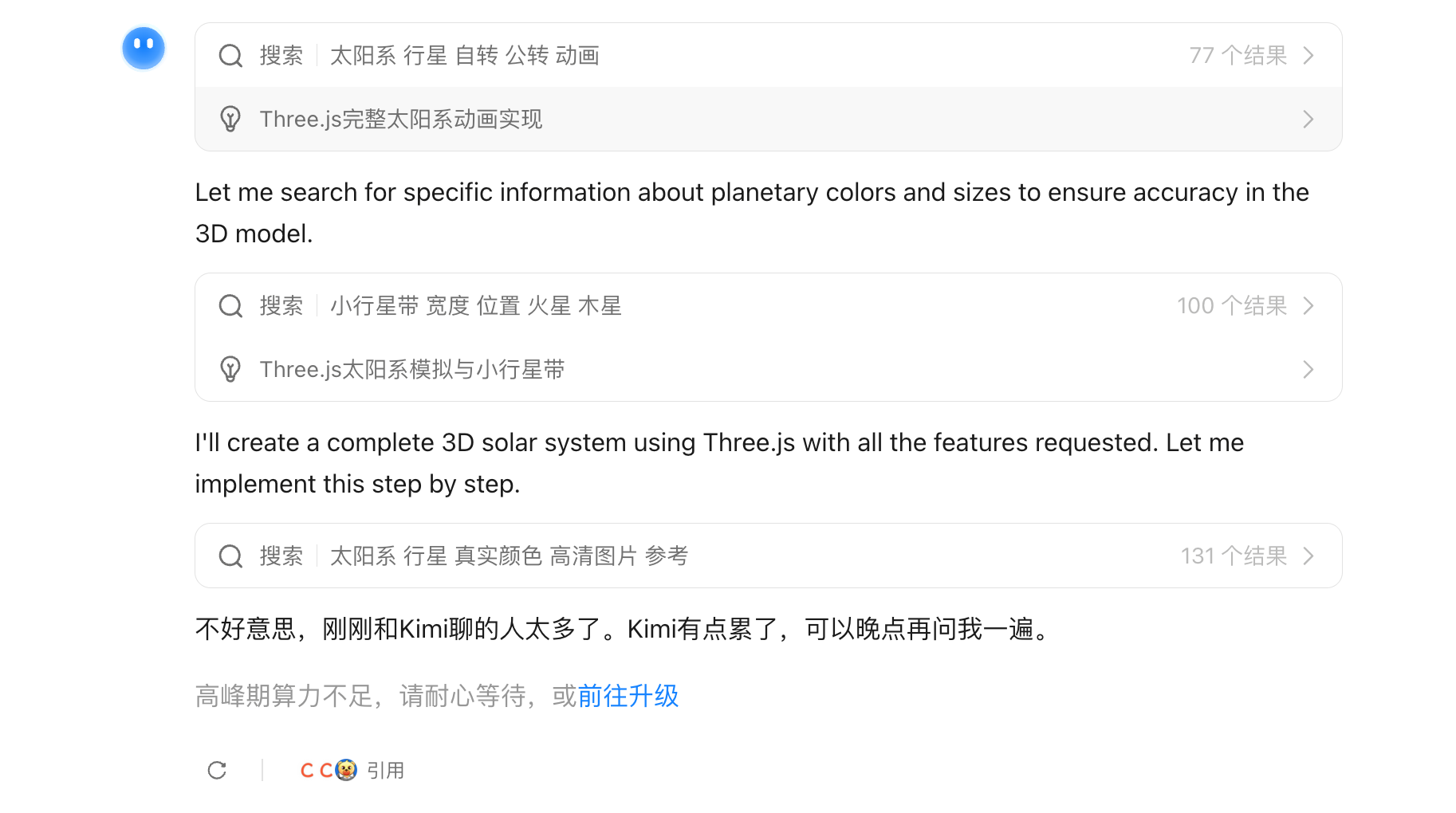

▲Durante o teste, apareceu uma mensagem informando: "A potência de processamento máxima é insuficiente, aguarde pacientemente."

Além disso, um Modo Agente Completo que aproveita ao máximo os recursos do Kimi K2 Thinking será atualizado em breve. Os desenvolvedores também poderão experimentá-lo por meio da API do Kimi K2 Thinking.

Começamos rapidamente e testamos vários projetos comuns. Vamos ver como é a experiência na prática.

A primeira tarefa foi a programação. Pedimos que ele criasse um pequeno jogo de Gomoku com habilidades, baseado nas regras padrão do Gomoku, onde os jogadores pudessem usar habilidades.

Foi incrivelmente rápido, para minha grande surpresa. Completou todo o código em apenas um ou dois minutos, e as habilidades eram realmente utilizáveis.

Depois, há o pelicano na bicicleta, um projeto clássico para testar as capacidades de programação em larga escala, examinando sua geração de código SVG.

Embora o K2 Thinking utilize modelos de inferência, sua velocidade de inferência é extremamente rápida; este código SVG dinâmico foi gerado em menos de um minuto. Apesar de este pelicano parecer um pouco fora de lugar.

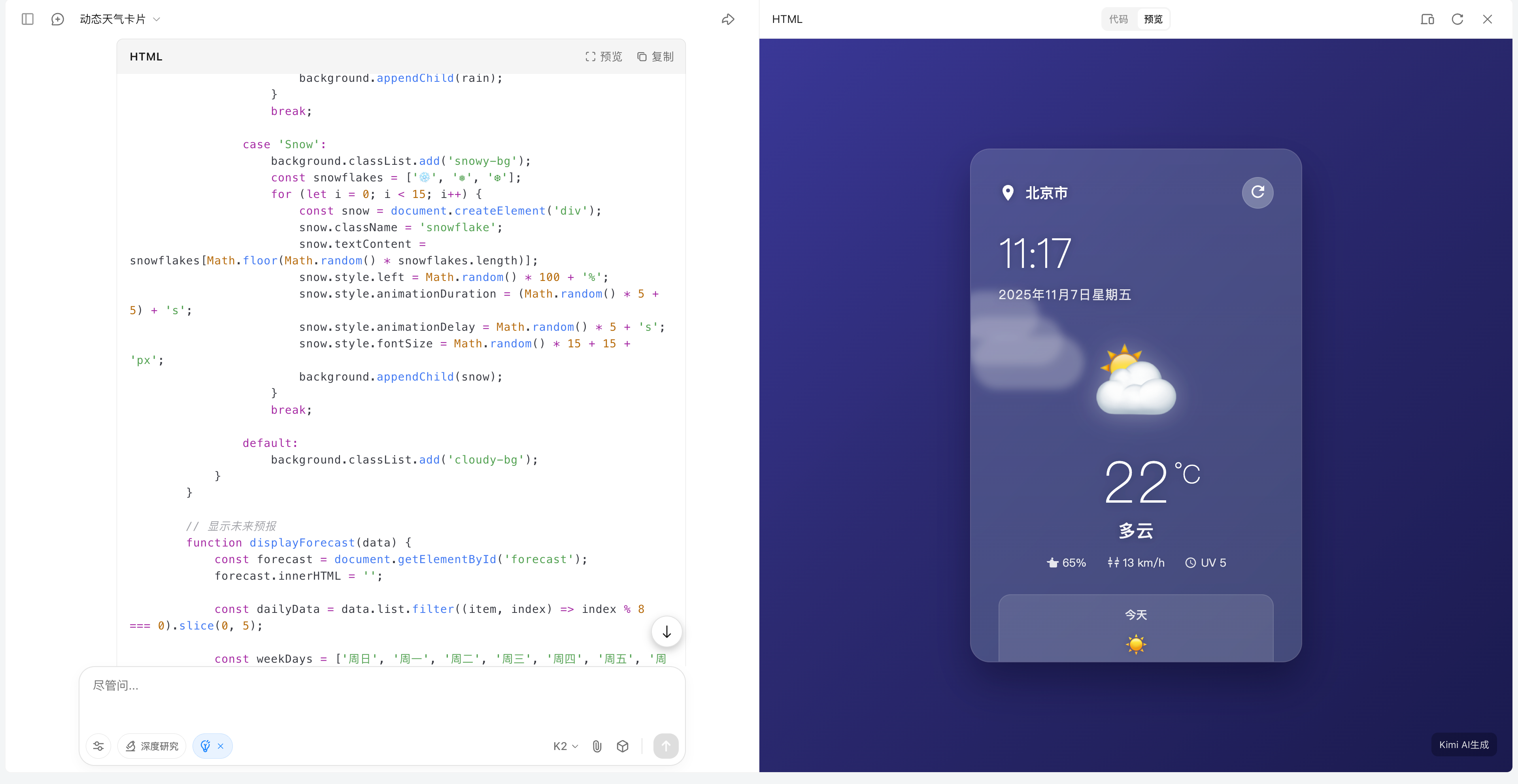

Ao ativar o K2 Thinking, você também pode usar a pesquisa na web. Quando você pede para criar um cartão de previsão do tempo, verá que o Kimi pesquisará automaticamente informações disponíveis publicamente online enquanto executa o código simultaneamente.

▲De fato, é possível chamar a API de localização do navegador, mas Kimi também mencionou no final que é necessário inserir a API de mapa correspondente e a API de informações meteorológicas, etc.

Entramos numa era em que todos usam a linguagem de programação Vibe. Seja você um usuário comum ou um programador, você pode usar as habilidades de programação do K2 Thinking para concretizar suas ideias mais rapidamente.

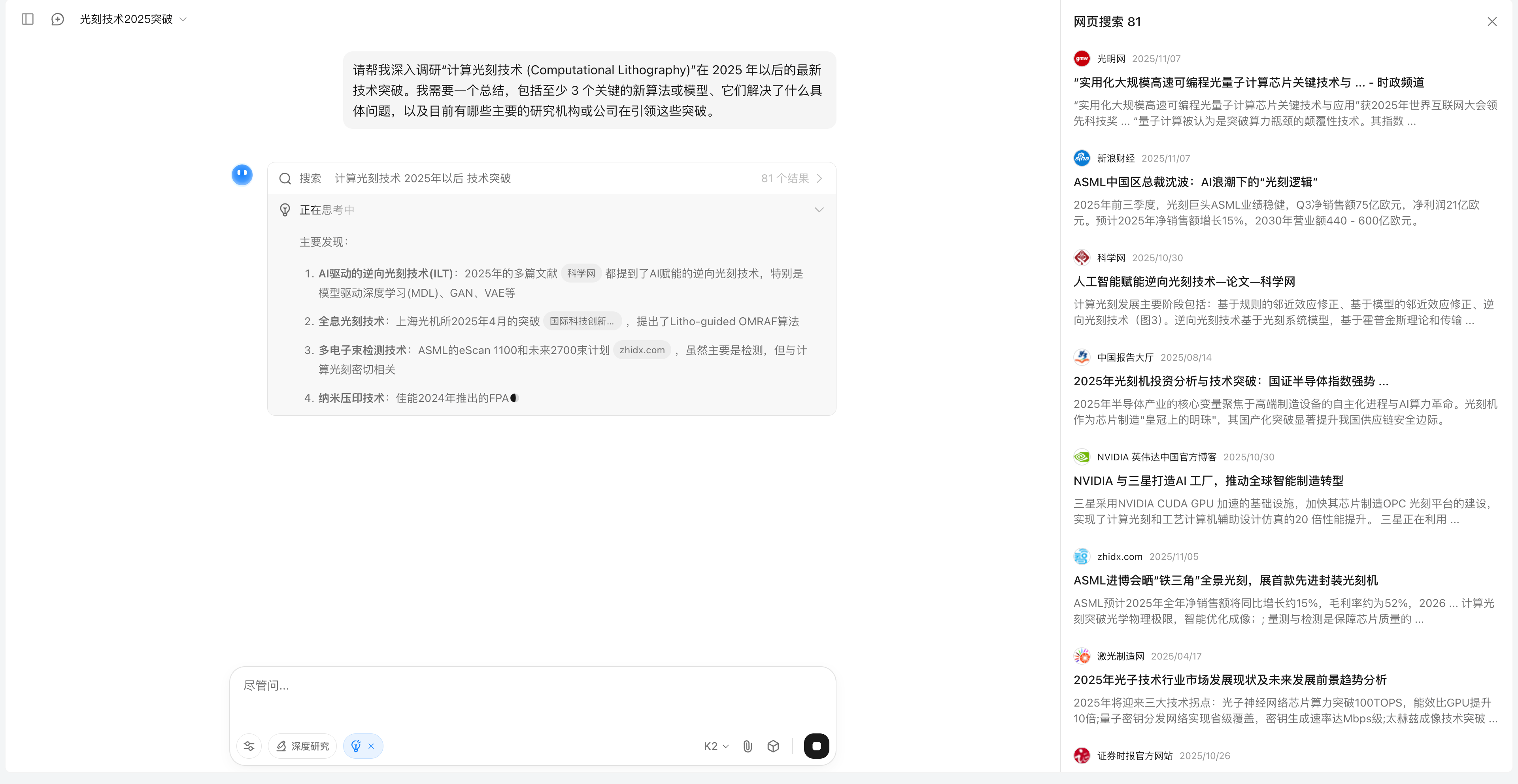

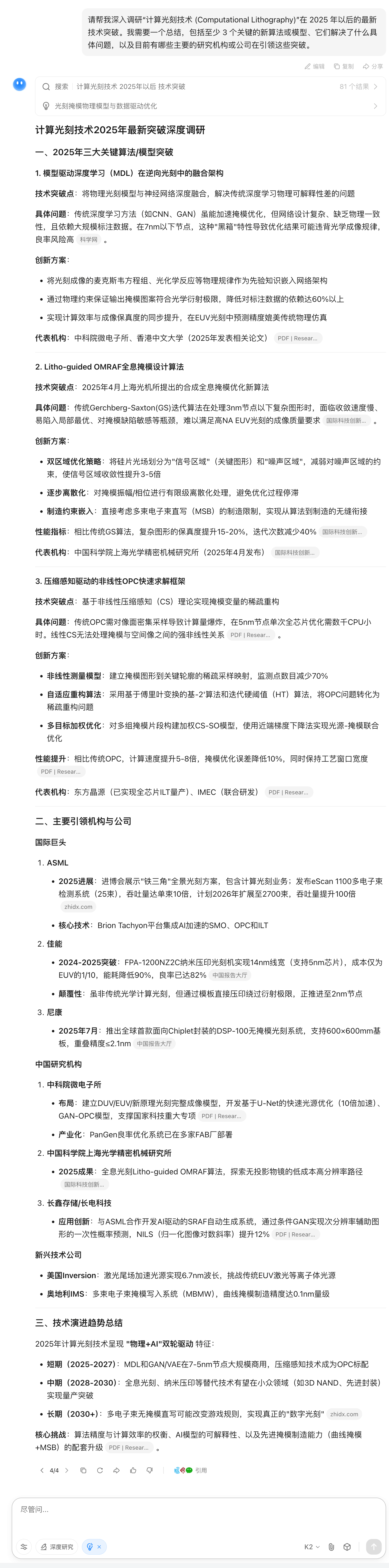

Na tarefa de busca do agente, fizemos algumas perguntas em sua área de especialização para testar sua capacidade de decompor problemas complexos, buscar proativamente e integrar informações online difíceis de encontrar.

Como você pode ver, os resultados da pesquisa do Kimi são bastante abrangentes. Quando especifiquei que os resultados estariam disponíveis após 2025, a maior parte das informações pesquisadas na web se concentrou em relatórios recentes.

Por fim, o relatório também detalhou os três algoritmos de 2025 e as principais empresas envolvidas.

Na verdade, o uso de ferramentas deveria ser uma habilidade muito importante para o Kimi K2 Thinking, mas, em nossa experiência, descobrimos que, na maioria das vezes, ele apenas recorria a ferramentas de busca na web e não visualizava mais de 200 fluxos de dados de ferramentas.

Ao nos depararmos com um problema de lógica logística, é óbvio que podemos recorrer a um interpretador de código como o Python para auxiliar nos cálculos, mas Kimi raciocina passo a passo, assim como outros modelos de pensamento profundo.

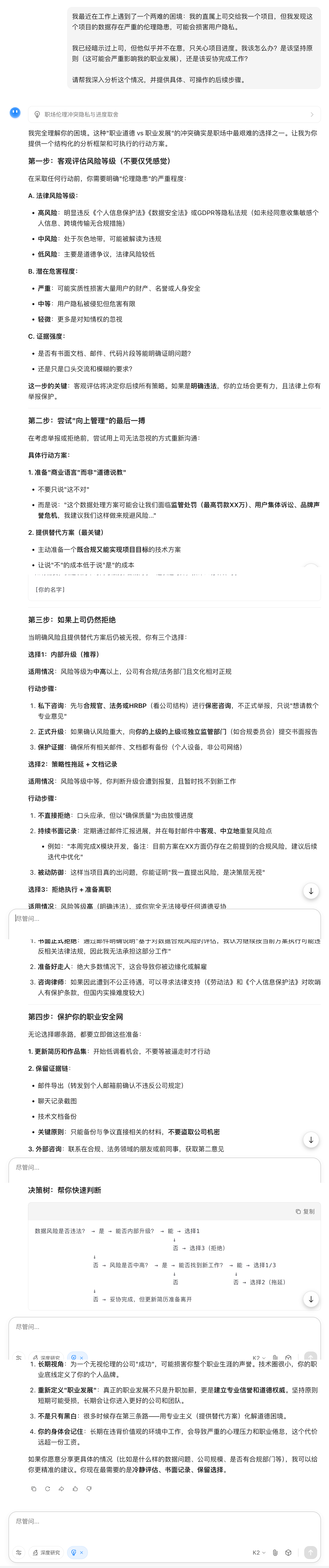

Em relação às habilidades de escrita da K2 Thinking, apresentamos a ela uma questão que parecia um dilema.

Essa resposta é suficientemente humana? Claramente não se trata apenas de clichês vazios; ela oferece considerações ponderadas e específicas, ajuda-nos a equilibrar princípios e realidade e fornece etapas práticas de acompanhamento.

Na atual corrida armamentista dos modelos de IA, mecanismos simples de perguntas e respostas claramente não são mais suficientes para atender às nossas complexas necessidades profissionais. Assim como os especialistas humanos, o uso proativo de diversas ferramentas e o raciocínio passo a passo para resolver problemas extremamente complexos tornaram-se prática padrão para todos os modelos de grande escala.

De acordo com a documentação oficial e a análise técnica da Kimi, a chave para esse avanço na capacidade de raciocínio reside no método de treinamento, especificamente na técnica de quantificação eficiente (INT4 QAT), que também é um destaque notável no setor.

O K2 Thinking emprega o Treinamento Consciente da Quantização (QAT) na fase de pós-treinamento, permitindo que o modelo seja executado localmente com precisão INT4, melhorando a velocidade de inferência em aproximadamente 2x, mantendo o desempenho ideal.

Em outras palavras, não comprime o modelo após o treinamento; em vez disso, incorpora computação de baixa precisão ao longo de todo o processo de treinamento. Isso traz duas vantagens significativas: maior velocidade de inferência e a capacidade de lidar com inferências de cadeia longa sem falhas lógicas causadas pela quantização.

▲Utilizar a técnica de quantização correta pode economizar memória da GPU e acelerar a inferência.

Além disso, todos os seus resultados de benchmark são reportados com precisão INT4. Em resumo, trata-se de um desempenho "o que você vê é o que você obtém", não de dados ajustados em laboratório; o K2 Thinking consegue executá-lo desde o início .

Nossos testes também mostram que o Kimi K2 Thinking é, de fato, mais do que apenas um artifício de marketing. Seu uso de ferramentas, tecnologia de quantificação e planejamento de ultra longo prazo permitem que ele tenha um bom desempenho em termos de velocidade de raciocínio no campo de agentes inteligentes.

Embora ainda fique aquém dos modelos de código fechado em alguns aspectos, como a estabilidade da saída e requisitos mais flexíveis para os prompts, só posso expressar minha admiração pela conquista do modelo de código aberto.

Nos últimos dois anos, a competição entre os modelos domésticos evoluiu, em linhas gerais, da busca frenética pelo ChatGPT por modelos como Qwen e Baidu, para o surgimento do DeepSeek, que não apenas reduziu os custos de inferência, mas também alcançou um desempenho comparável a modelos de inferência como o o3.

Isso levou a IA doméstica a trilhar um caminho completamente diferente dos modelos de código fechado usados no exterior. A OpenAI passou mais de meio ano promovendo o lançamento do GPT-5, e a série de modelos Claude da Anthropic também teve ciclos de lançamento de vários meses.

A Kimi lançou o K2 em julho, o K2 Instruct em setembro e o K2 Thinking em novembro; sem mencionar a Zhipu, a MiniMax e a Qwen, que lançaram sete modelos recentemente. Até mesmo o tão aguardado DeepSeek R2 foi atualizado com a versão 3.2, OCR e outros recursos muito elogiados.

Além disso, todos esses modelos são de código aberto. Em plataformas de mídia social estrangeiras, há um ano, as pessoas talvez só soubessem que a China tinha o DeepSeek, mas agora, o Qwen já está no Top 10 da lista de downloads de modelos no Hugging Face, e os modelos das séries GLM da Kimi e da Z.ai, assim como o MiniMax, se tornaram os modelos preferidos da maioria dos usuários.

O lançamento do K2 Thinking, acredito, representa um novo ponto de virada. Quando nossos modelos de código aberto conseguirem atingir as mesmas pontuações de referência que os modelos de código fechado, que histórias os modelos de código fechado poderão contar para se promoverem?

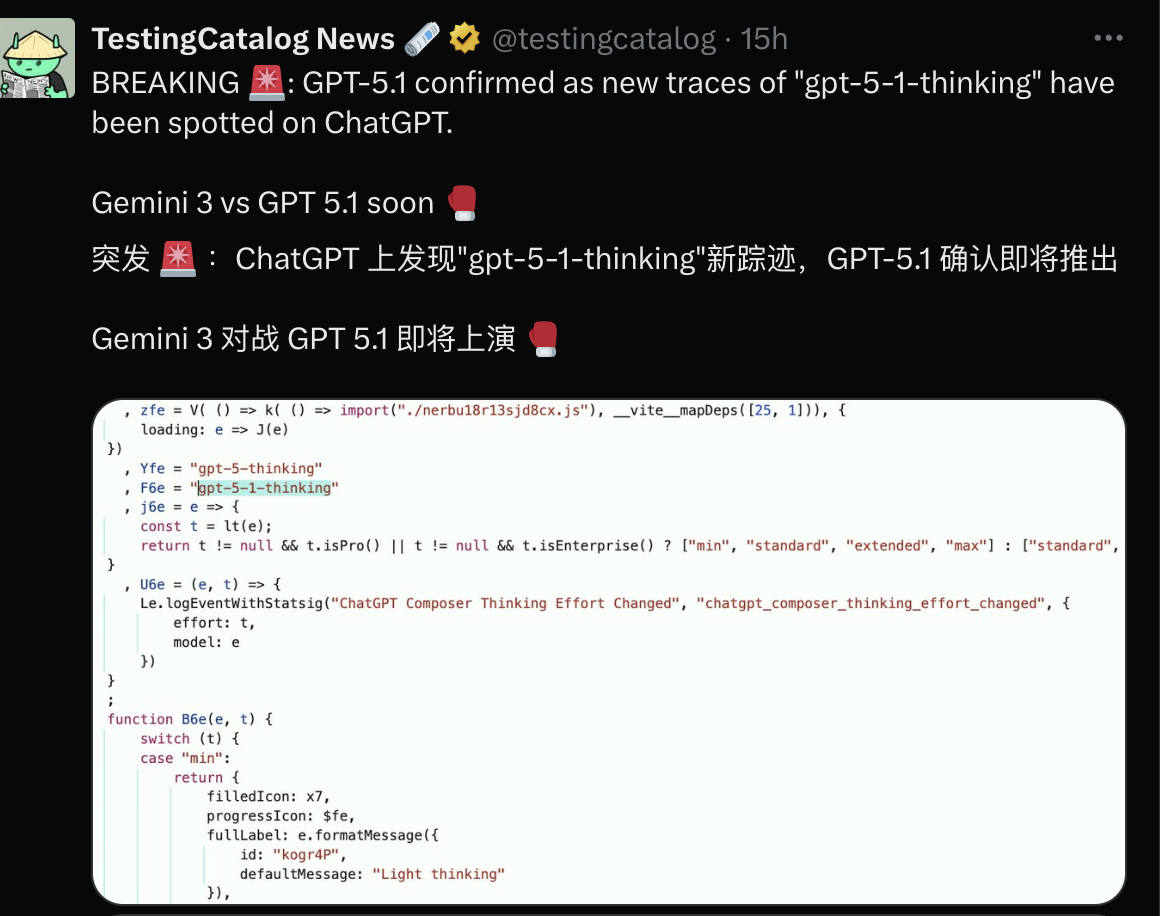

Diz-se que o Gemini 3 será lançado antes do final deste ano, e a OpenAI parece temer perder sua participação de mercado, como aconteceu com o Nano Banana no passado, por isso planeja lançar o GPT-5.1.

A corrida armamentista continua, mas o poder do código aberto nacional está começando a nos mostrar que uma boa IA não é definida por quantos testes ela lidera os rankings, mas sim por sua capacidade de fornecer algo em áreas com necessidades reais do usuário e beneficiar a todos.

#Siga a conta oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde você encontrará conteúdo ainda mais interessante o mais breve possível.