O momento do iPhone da Nvidia AI chegou

Na conferência GTC em março, o CEO da Nvidia, Huang Renxun, lançou a frase de ouro "Chegou a hora do iPhone da IA"

Agora, após um lapso de 5 meses, é mais correto dizer que talvez a frase de ouro de Huang Renxun possa ser reescrita como “chegou a hora do iPhone da Nvidia AI”.

Hoje, a Nvidia anunciou seu relatório financeiro para o segundo trimestre do ano fiscal de 2024. A receita da Nvidia no segundo trimestre foi de US$ 13,51 bilhões, um aumento anual de 101% e um aumento trimestral de 88%.

Vale ressaltar que esta também é a primeira vez que a Nvidia supera a Intel em receita trimestral, criando um momento histórico.

Depois que o relatório financeiro foi anunciado, o preço das ações da Nvidia disparou 9,6% nas negociações após o expediente, e o preço das ações atingiu um novo máximo, atingindo mais de US$ 500, tornando-se o "menino mais bonito" do mercado de ações dos EUA.

No relatório financeiro, Huang Renxun disse: "Uma nova era da computação começou e as empresas em todo o mundo estão se transformando da computação de uso geral para a computação acelerada e IA generativa".

Na verdade, a explosão da IA generativa deu às pessoas um vislumbre da próxima saída. Inúmeros gigantes da tecnologia estão lutando para entrar no caminho da IA generativa, tentando abrir esta porta tecnológica cheia de oportunidades.

Mas as ideias são muito subjetivas, a realidade é muito objetiva. O poder de computação, os modelos e os dados sempre foram os três principais elementos do desenvolvimento da IA. O poder de computação representado pelos chips de IA não é apenas a pedra angular da inteligência artificial, mas também a chave para abrir a porta para esta tecnologia.

E agora, a chave para o futuro está nas mãos da Nvidia.

Há cinquenta e oito anos, Gordon Moore, um dos fundadores da Intel, propôs a famosa Lei de Moore com base nos dados coletados de 1959 a 1965 sobre o número de transistores em circuitos integrados.

O número de transistores que podem ser acomodados em um circuito integrado dobra aproximadamente a cada dois anos.

Surgiram então novas extrapolações e o intervalo de dois anos foi reduzido para 18 meses.

Sob o efeito da Lei de Moore, o desempenho de processamento da CPU e GPU atingiu um crescimento exponencial.Depois de 2000, a CPU passou de núcleo único para núcleo múltiplo, e o número de núcleos aumentou bastante.

O treinamento e o raciocínio do aprendizado profundo de IA dependem fortemente de cálculos matriciais e cálculos de ponto flutuante, o que impõe requisitos extremamente altos ao poder de computação.As GPUs são capazes de computação paralela em grande escala, ultrapassando em muito as CPUs em computação matricial e vetorial, e tornaram-se a "plataforma de computação de alto desempenho". querida".

Além disso, as vantagens da largura de banda de memória de alta velocidade, do pool de poder de computação escalonável, da estrutura de aprendizado profundo especialmente otimizada e do suporte à implantação em nuvem também estabeleceram firmemente a posição central do poder de computação da GPU na era da IA.

Fundada em abril de 1993, a Nvidia começou com GPUs e gradualmente se tornou líder no campo da computação de alto desempenho por meio de inovação e desenvolvimento contínuos.

De acordo com o relatório de estatísticas do mercado de GPU divulgado pela Jon Peddie Research, a Nvidia ocupa o primeiro lugar com uma participação de mercado de 84%, seguida pela AMD com 12% e pela Intel com 4%.

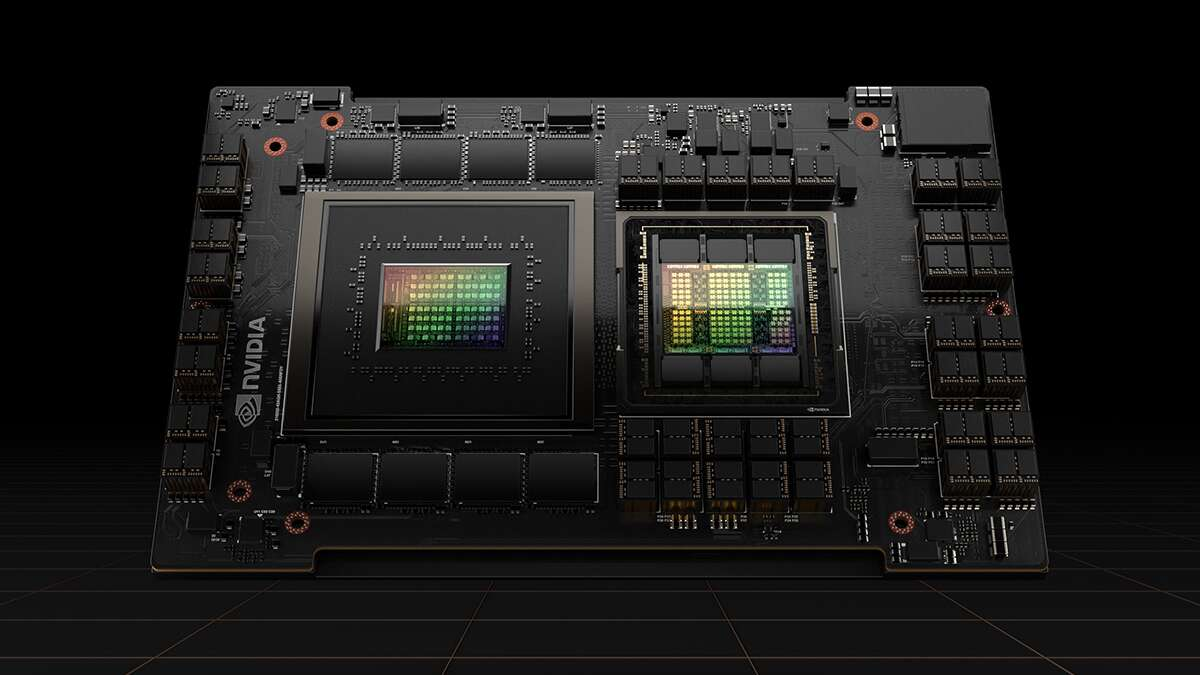

Tanto A100 quanto H100 são GPUs de data center de alto nível da Nvidia especialmente projetadas para computação de IA. Em termos de treinamento e raciocínio de redes neurais de grande escala, seu desempenho excede em muito o de outros concorrentes. Os dois chips ás nas mãos da Nvidia.

Desde o início deste ano, a Nvidia tem se concentrado em “quanto mais você compra, mais você economiza” e lançou várias GPUs atualizadas iterativamente com muita habilidade e “intimidade”.

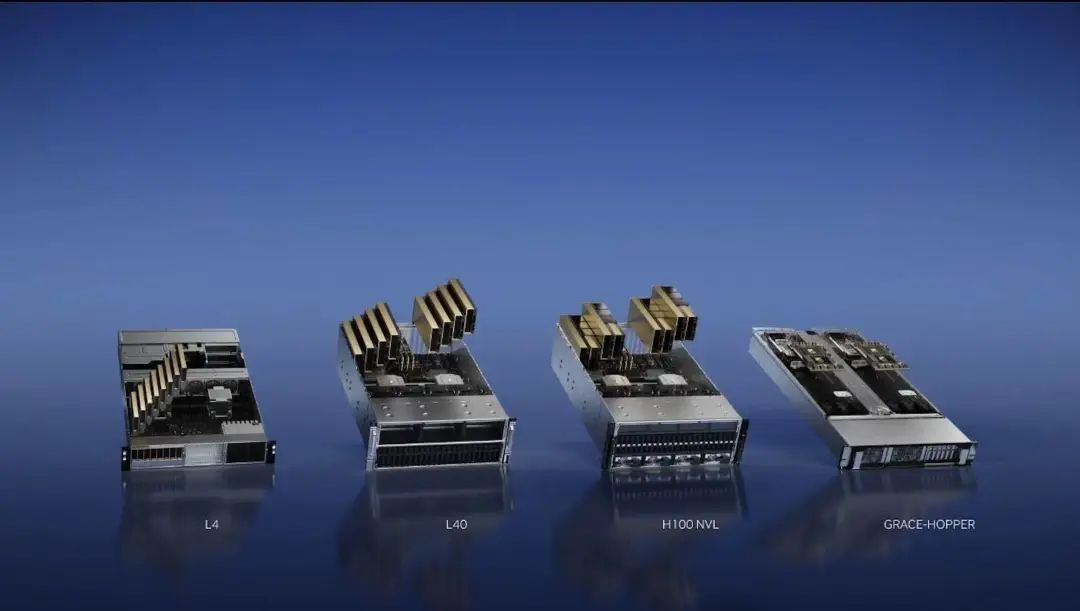

Em março, a Nvidia lançou quatro chips de inferência de IA, GPU H100 NVL, GPU L4 Tensor Core, GPU L40 e NVIDIA Grace Hopper.

Dois meses depois, no Taipei Computer Show em maio, Huang Renxun lançou o supercomputador DGX GH200 composto por 256 superchips NVIDIA GH200 Grace Hopper.

Apenas duas semanas atrás, Huang Renxun lançou uma nova versão do GH200 Grace Hopper equipada com memória HBM3e, que também é o primeiro chip GPU do mundo equipado com memória HBM3e.

A memória HBM3e é um novo tipo de tecnologia de memória de alta largura de banda. Em termos de velocidade de computação, o HBM3e pode ser 50% mais rápido que a velocidade de computação do HBM3, proporcionando uma taxa de transmissão máxima de 5 TB/s.

O treinamento e o raciocínio são duas etapas muito importantes dos grandes modelos de IA, e é exatamente nisso que o GH200 é bom. Na opinião de Huang Renxun, o cenário de aplicação típico do GH200 no futuro é o modelo de linguagem grande, e a "computação acelerada" e a "computação de IA" substituirão gradualmente a "computação geral" das GPUs x86 tradicionais.

Numerosos casos no passado provaram que, uma vez construído um excelente ecossistema num fosso, os estrangeiros ganharão vantagem na competição.

O forte ecossistema da Nvidia naturalmente exige a certificação do selo dos concorrentes.Naveen Rao, um cientista de redes neurais, já atuou como vice-presidente e gerente geral da divisão de plataforma de inteligência artificial da Intel.

Ele descobriu que a maior vantagem da Nvidia não é apenas o chip em si, mas a Nvidia possui uma grande comunidade e centro de distribuição com um grande número de excelentes programadores de inteligência artificial.

No relatório financeiro do segundo trimestre, Huang Renxun também disse: "As GPUs Nvidia conectadas através de nossa rede Mellanox e tecnologia de switch e executando nossa pilha de software CUDA AI constituem a infraestrutura de computação para IA generativa."

CUDA é uma plataforma de computação paralela e modelo de programação baseada em GPUs produzidas pela Nvidia, cujo objetivo é facilitar a participação de mais técnicos no desenvolvimento.

Os desenvolvedores podem chamar APIs CUDA por meio de linguagens de alto nível, como C/C++ e Fortan, para realizar programação paralela e realizar computação de alto desempenho. O estabelecimento desse ecossistema faz com que muitos desenvolvedores confiem no CUDA.

Anteriormente, Huang Renxun revelou ao mundo exterior que CUDA tem mais de 4 milhões de desenvolvedores e mais de 3.000 aplicativos em todo o mundo, e os downloads cumulativos de CUDA atingiram 40 milhões de vezes. Existem 40.000 grandes empresas no mundo que usam produtos NVIDIA para computação acelerada. 15.000 startups são construídas na plataforma NVIDIA.

O grande número reflete a vantagem significativa de ser pioneira da Nvidia.Se outros oponentes quiserem lançar um novo hardware, eles também precisam considerar a possibilidade de alcançar esse ecossistema de inovação em inteligência artificial já formado.

As duas extremidades da transação, uma extremidade está conectada ao vendedor e a outra extremidade está conectada ao comprador.

Em abril, o "padrão duplo" Musk assinou conjuntamente uma proibição de treinamento de IA, enquanto secretamente varria 10.000 GPUs para desenvolver modelos grandes, e até fez reclamações públicas sobre X: "Parece que todo mundo e todo cachorro está Compre uma GPU ".

No mês passado, o presidente da Oracle disse publicamente que a Oracle gastaria bilhões de dólares comprando GPUs da Nvidia para expandir os serviços de computação em nuvem para uma nova onda de empresas de inteligência artificial.

Quem consegue o poder da computação ganha o mundo.Na pista de IA generativa onde vocês perseguem uns aos outros, há também a ansiedade de buscar "chips" no país.

Na teleconferência de resultados, a CFO da Nvidia, Colette Kress, disse: “Esperamos que o crescimento sequencial seja impulsionado principalmente pelos data centers, com as vendas para clientes chineses representando aproximadamente 20% a 25% da receita do último trimestre da Nvidia”.

Anteriormente, de acordo com o relatório britânico "Financial Times", os gigantes chineses da Internet estão lutando para adquirir os chips de IA de alto desempenho da Nvidia, com pedidos no valor de até US$ 5 bilhões neste ano e no próximo.

Entre eles, Baidu, Tencent, Alibaba e ByteDance colocaram ordens de pagamento à Nvidia no valor total de US$ 1 bilhão este ano, comprando um total de 100.000 A800s, equivalente a um preço de US$ 10.000 por chip A800, e entregando os 400.000 chips restantes. no próximo ano, cem milhões de dólares americanos.

Deve-se notar que o A800 é essencialmente uma “versão castrada” do A100. Devido ao impacto da política de agosto do ano passado, a Nvidia só pode lançar uma versão alternativa irrestrita para o mercado continental chinês.

Muitas pessoas na indústria acreditam que a GPU se tornou uma mercadoria reconhecidamente escassa no mercado, e a situação dos chips difíceis de encontrar ainda será difícil de aliviar nos próximos um ou dois anos.

Portanto, sob a busca contínua de GPUs em falta, as GPUs da Nvidia até se tornaram uma moeda forte para algumas startups de IA.

Como uma startup de computação em nuvem, não foi fácil para a CoreWeave obter um empréstimo inicial. Mas "não olhe para o rosto do monge para ver o rosto do Buda", graças ao status de investidor da Nvidia, CoreWeave pode até usar a GPU H100 como garantia e obteve facilmente um empréstimo de 2,3 bilhões de dólares americanos.

Do ponto de vista do credor, este não será naturalmente um negócio deficitário.

Por um lado, este empréstimo permitirá que a CoreWeave expanda rapidamente sua escala e força computacional e melhore sua capacidade de reembolsar o empréstimo. Por outro lado, a Nvidia lançará mais GPUs iterativas no próximo ano. Com o empréstimo, a CoreWeave também pode aproveitar o oportunidade de adquirir a GPU GH200 que estará disponível no próximo ano.

Como mencionado anteriormente, uma vez que os principais fabricantes não conseguem obter GPUs no mercado, a situação das start-ups de IA que não são fortes é obviamente ainda mais preocupante.

Desde então, algumas startups inteligentes de IA só podem optar por encontrar outro caminho, manterem-se unidas para se aquecerem e investirem nos braços da Nvidia.

Em junho deste ano, a startup de inteligência artificial Inflection AI anunciou oficialmente que havia concluído uma nova rodada de financiamento de US$ 1,3 bilhão. Vale destacar que a NVIDIA apareceu pela primeira vez na nova lista de investimentos.

A Inflection AI disse que construirá o maior cluster de IA do mundo com os parceiros CoreWeave e NVIDIA.

A aliança aparentemente feliz é mais como uma escolha indefesa. O CEO da Inflection AI, Mustafa Suleyman, disse em uma entrevista ao New York Times: "A empresa não é obrigada a usar os produtos da Nvidia, mas os concorrentes não forneceram alternativas viáveis."

Na verdade, a Inflection AI está fazendo de tudo para construir um supercomputador avançado que consiste em quase 700 CPUs Intel Xeon em um servidor rack de quatro nós equipado com 22.000 GPUs H100.

Um número tão grande de GPUs é invejável para outros, mas é difícil não lembrar as pessoas da estratégia de fornecimento prioritário de GPU da Nvidia de “não permitir que a gordura e a água fluam para estranhos”.

Claro, com a brisa da primavera da IA generativa, o fornecimento global de GPU está escasso e o preço está subindo. A Nvidia também está ganhando muito dinheiro nesta onda de IA.

No final do ano passado, fontes revelaram a Raymond James, da empresa de banco de investimento, que o custo da GPU H100 era de US$ 3.320 (atualmente cerca de 24.181 yuans), enquanto a Nvidia optou por vendê-la a um preço de US$ 25.000 a US$ 30.000 (atualmente cerca de 182.000 yuans). para 219.000 yuans) Venda essas GPUs.

Embora esta afirmação possa não levar em conta outros custos, como transporte e logística, mas apenas a partir da relação custo de produção / preço de venda, a GPU NVIDIA H100 é simplesmente uma “super vaca leiteira”.

Além disso, de acordo com a mídia estrangeira Tomshardware, a Nvidia planeja vender mais de 550.000 GPUs H100 este ano. Se for verdade, isso significa que a receita da Nvidia apenas com a GPU H100 já é astronômica.

A IA generativa trouxe mais surpresas para a Nvidia do que isso.

Este ano é o “Trinta Ano” da Nvidia. No último dia de maio, a Nvidia se tornou a primeira empresa de chips do mundo com um valor de mercado de mais de US$ 1 trilhão. Esta também é a nona empresa de tecnologia na história a entrar no valor de mercado de um trilhão de dólares. clube.

Para o terceiro trimestre fiscal do ano fiscal de 2024, a Nvidia também apresentou uma perspectiva ambiciosa, com receitas esperadas de atingir US$ 16 bilhões, mais ou menos 2%.

Este valor é quase três vezes o nível de um ano atrás e 3,7 mil milhões de dólares superior à estimativa média dos analistas de 12,3 mil milhões de dólares.

No momento desta publicação, o valor de mercado da Nvidia atingiu 1,16 trilhão de dólares americanos, mais do que o dobro do valor de mercado da TSMC, com uma relação preço-lucro de 244,86 vezes, e a dinâmica de crescimento continua otimista.

Em junho deste ano, Jen-Hsun Huang, que usava um vestido de formatura, foi convidado a participar do discurso de formatura da Universidade Nacional de Taiwan e usou sua experiência de vida passada para enviar uma mensagem aos formandos!

Seja o que for, corra atrás com todas as forças, corra! Não ande devagar.

Seja correndo em busca de comida ou não sendo tratado como comida pelos outros.

Muitas vezes você não sabe em que situação está, então continue correndo, não importa o que aconteça.

A oportunidade da história é passageira, e a pista da GPU está destinada a ser uma pista em que o vencedor leva tudo.

Huang Renxun, que tem corrido descontroladamente, aproveitou a oportunidade da IA e fez com que a Nvidia, que nasceu em uma rede de restaurantes de beira de estrada, entrasse com sucesso no clube de um trilhão de dólares, tornando-se a maior vencedora desta onda de IA, e continuará a liderar esta era.

#Bem-vindo a seguir a conta pública oficial do WeChat da Aifaner: Aifaner (WeChat ID: ifanr), mais conteúdo interessante será apresentado a você o mais rápido possível.