O discurso chinês de Musk e Ultraman: o vídeo de IA finalmente se transforma de um “brinquedo” em uma “ferramenta”

Se você navegar pelas redes sociais hoje em dia, encontrará alguns vídeos virais com visuais impressionantes, muitas vezes produzidos por IA. No entanto, como criador, além de simplesmente criar um "sorteio de cartas", há um problema além dos visuais que não foi abordado adequadamente.

O problema é o diálogo.

Por exemplo, se eu pedir à IA para gerar uma bela cena de chuva, isso não é difícil. Mas se eu pedir à IA para gerar uma cena de término de relacionamento na chuva com enredo e diálogo, e o diálogo precisa ser em chinês autêntico, isso é uma tarefa muito complicada.

O conteúdo gerado pela IA é uma "pantomima" completa que exige que o criador faça dublagem e dublagem posteriormente; ou pode falar, mas a voz e a entonação não são naturais, cheias de "sensação humano-máquina" e "tom de tradução", o que arruína instantaneamente o enredo que deveria ser triste.

Este também é um dos maiores desafios na geração atual de vídeos de IA: como lidar com diálogos, especialmente diálogos chineses com emoções complexas.

Pode-se dizer que a capacidade do vídeo de IA de lidar com conversas naturais e fluentes em chinês é fundamental para que ele deixe de ser um brinquedo "para diversão" e se torne uma ferramenta de produtividade real.

O modelo de vídeo MuseSteamer 2.0 do Baidu, lançado hoje, parece solucionar esse problema central. Sua característica mais marcante é ser a primeira tecnologia integrada de geração de áudio e vídeo em chinês do mundo. Alegando ser baseado em corpus chinês, ele pode gerar vídeos de conversas em chinês com áudio e vídeo sincronizados, movimentos labiais precisos e emoção natural em uma única etapa.

Para verificar se o vídeo realmente resolve os problemas dos criadores ou se é apenas uma demonstração técnica no vídeo promocional, decidi ignorar os casos oficiais selecionados (Demos) e criar algumas cenas "complicadas" que estão mais próximas das necessidades criativas diárias de pessoas comuns para explorar sua realidade por conta própria.

Endereço da experiência: https://huixiang.baidu.com/

De uma imagem a um confronto sonoro

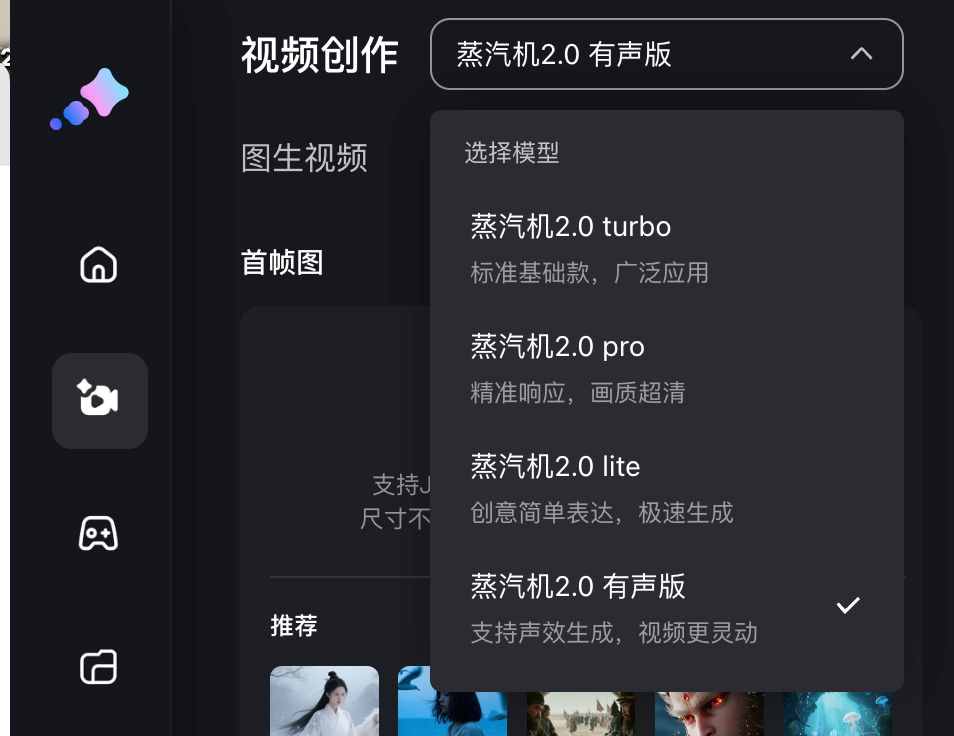

Desta vez, o Baidu Steam Engine oferece 4 modelos de geração, todos gerando um vídeo a partir de uma imagem, ou seja, Steam Engine 2.0 turbo, pro, lite e versão em áudio; modelos diferentes consumirão diferentes números de pontos, e usuários gratuitos podem obter uma quantidade limitada de valor de imaginação (pontos) ao fazer login todo mês.

A versão com áudio pode gerar vídeos de 5 ou 10 segundos, enquanto a Turbo e as outras três versões são de 5 segundos. Em termos de pixels, com exceção da versão Pro, que suporta 1080p, as outras três versões têm qualidade de imagem de alta definição de 720p.

Nós lhe damos uma imagem diretamente e seguimos as instruções na página de geração de vídeo para inserir o conteúdo do vídeo e as linhas temáticas que você deseja gerar; para um vídeo de 5 segundos, as linhas devem ser controladas em 20 palavras, e para um vídeo de 10 segundos, o número de palavras deve ser controlado em 35 palavras.

▲ Enviamos uma foto de Musk e Ultraman, com a seguinte mensagem: Duas pessoas estão discutindo. A pessoa à esquerda diz: "A IA que você criou não tem lucro." A pessoa à direita diz: "Seu marketing não tem lucro." Gerado pela versão em áudio do Steam Engine 2.0.

Em primeiro lugar, Musk e Ultraman nas fotos estáticas são conduzidos naturalmente, suas expressões faciais e movimentos corporais são bastante suaves e basicamente consistentes com as fotos publicadas. A capacidade básica de conversão de imagem em vídeo ainda é muito sólida.

Mais crucial ainda, o desempenho do diálogo é realmente de primeira linha na dublagem em chinês. Os movimentos labiais correspondem perfeitamente à pronúncia de palavras como "resultado final" e "marketing", sem atrasos ou desalinhamentos perceptíveis.

▲ Um primeiro quadro dos goblins da Montanha Langlang, acompanhado por uma deixa: No quadro, um goblin javali, segurando um forcado, olha com expectativa para o corpulento Treinador Urso ao seu lado. Versos: (0-5 segundos) O goblin javali, segurando um forcado, diz: "Treinador, vamos polir nossa armadura. Lutaremos com mais força!" (5-10 segundos) O corpulento Treinador Urso olha para ele e o interrompe impacientemente: "Quem tem tempo? Corte mil flechas para mim primeiro!"

Na coletiva de imprensa, o Baidu mencionou especificamente que essa é a lógica de geração subjacente à " integração de áudio e vídeo ". O som e a imagem são concebidos simultaneamente, em vez de serem combinados posteriormente. Durante o treinamento, eles colocam a imagem e o som em um único modelo para aprendizagem síncrona.

Além disso, existe uma tecnologia pioneira chamada "Latent Multi Modal Planner "; multimodalidade é fácil de entender, referindo-se a texto, imagens e áudio, e latente é um termo em aprendizado profundo que se concentra no aprendizado de características latentes. Essa tecnologia pode planejar de forma autônoma múltiplas identidades de personagens, falas e lógica de interação no espaço de geração latente.

Em termos simples, podemos imaginá-lo como um diretor incorporado à IA. Ao receber a instrução de "deixar duas pessoas discutirem", ele não deixará as duas pessoas conversarem ao mesmo tempo, mas planejará o roteiro da discussão de forma independente.

Também tentamos alguns dialetos, como o chinês do nordeste, para ver se não haveria problemas em conversas entre várias pessoas.

▲ Prompt: A mulher de azul no lado esquerdo da tela sussurra rápida e friamente no dialeto do nordeste: "Irmã, a sinceridade é o nosso carvão, mas também é o fogo que nos queima até a morte"; a mulher de roxo e rosa no lado direito da tela responde resolutamente no dialeto do nordeste: "Então por que não, apenas queimá-lo de forma mais limpa"; gerado pela versão em áudio do Steam Engine 2.0.

Ter Zhen Huan e Shen Meizhuang falando em dialeto do nordeste dentro do modelo integrado de áudio e vídeo foi um pouco desafiador, mas as expressões dos personagens, os movimentos dos lábios, os movimentos dos brincos e dos chapéus foram transmitidos com muita naturalidade. As vozes em chinês também eram altamente detalhadas, o que, na minha opinião , demonstra uma profunda adaptação ao contexto chinês.

Há também esta imagem clássica de meme, que finalmente não é "Venha e prove minha carne fresca".

Uma captura de tela do curta-metragem "Wan Wan Wo Xiang". A legenda diz: Tang Sanzang, usando um chapéu vermelho, aponta o dedo para o nariz do homem com chifres e diz com raiva: "Você ainda quer provar minha carne fresca? De jeito nenhum!"

O Baidu Steam Engine aborda com precisão a dificuldade criativa de permitir que uma única imagem fale e represente uma cena. Ele simplifica o processo multiferramenta, antes trabalhoso, em uma única operação de "uma imagem + uma frase". Isso, sem dúvida, libera a produtividade para cenários como criação de memes, diálogos virtuais, compartilhamento de conhecimento e produção de esquetes.

Ainda há um longo caminho a percorrer antes que possamos realmente igualar o desempenho de dublagem dos vídeos recentemente populares "Empresses in the Palace" e "Let the Bullets Fly". No entanto, dado o estado atual da tecnologia de geração de vídeos por IA, acredito que é apenas uma questão de tempo até que a IA consiga expressar emoções humanas mais sutis e conflitantes. Afinal, o modelo Steam Engine 1.0 foi lançado no início do mês passado.

Ele consegue lidar com movimentos de câmera e cenas grandes?

Além da primeira geração integrada de áudio e vídeo com voz para dois jogadores em cenas chinesas, outra atualização do Baidu Steam Engine 2.0 é a qualidade de imagem de nível de filme e movimentos de câmera complexos de nível mestre .

Em vídeos de conversação anteriores, emoções, expressões e geração de rostos em 3D demonstraram expressões de personagens realistas e detalhadas. Continuamos testando transições e tomadas vazias, comuns em comerciais e curtas-metragens, que são outro requisito essencial para vídeos de IA, além de conversas.

▲ Forneça a primeira imagem do quadro com o prompt: Uma tomada que começa com um close de um livro aberto sobre uma mesa, sobe lentamente e finalmente congela na cena da rua chuvosa do lado de fora da janela; gerada pelo Steam Engine 2.0 Pro.

A julgar pelo vídeo resultante, a Steam Engine seguiu as instruções perfeitamente. Todo o movimento da câmera — close-ups, pull-ups, congelamentos — foi executado com notável fluidez, sem problemas de trepidação da câmera ou mal-entendidos das instruções. Isso demonstra seu sólido conhecimento da terminologia fotográfica.

Quando a IA aprende chinês autêntico, um novo ponto de virada na criação de vídeos chegou

Após esse teste, acho que o posicionamento do Baidu Steam Engine 2.0 está muito claro: ele não pretende ser um modelo abrangente no estilo Sora, mas escolheu um caminho mais pragmático: usando o "diálogo chinês" como ponto de inovação central, ele transformou o vídeo de IA de um "brinquedo" interessante em uma "ferramenta" que pode ser entregue como um filme.

Ele evita a competição interna de simplesmente competir em qualidade e duração de imagem, e gasta mais energia na solução do problema mais crítico e mais localizado: fazer com que os vídeos de IA realmente "falem chinês" e falem melhor do que pessoas reais.

Essa transformação de "brinquedo" em "ferramenta" foi verificada em campos criativos e comerciais reais.

Yao Qi, um diretor de efeitos visuais de nível hollywoodiano, trabalhou em filmes como "2012", "Matrix 3" e "Transformers 3". Ele também criou os icônicos efeitos de ação Guzheng no drama de ficção científica chinês "O Problema dos Três Corpos". Desta vez, ele usou o Baidu Steam Engine para criar um curta-metragem de ficção científica de alta qualidade com mais de 40 tomadas de efeitos especiais complexas e elaboradas, cada uma gerada três vezes, totalizando mais de 120 clipes, tudo por apenas 330,6 yuans.

▲ Vídeo da coletiva de imprensa "Viagem de Volta para Casa"

Quando o custo de produção visual de um curta-metragem que costumava exigir um orçamento de milhões de yuans é comprimido a um nível inimaginavelmente baixo, o que é subvertido não é apenas o orçamento, mas também o limite e os direitos de criação.

Não se trata apenas de lidar com custos; trata-se de transformar a geração de um clipe incrível em uma narrativa completa. Quando efeitos visuais grandiosos podem ser perfeitamente integrados à narrativa e ao diálogo, a IA realmente evolui de um plug-in de efeitos especiais para uma ferramenta altamente eficiente para criadores.

Em cenários de marketing de marca, esse modelo também rompe com o processo convencional de produção de vídeo. Por exemplo, a Yili Beichang precisava produzir um vídeo promocional para seu leite em pó de cabra, intitulado "Uma ovelha cruza o mar para te ver". Os métodos tradicionais de produção normalmente levam de quatro a seis semanas, e a filmagem envolveu a representação da jornada mágica do "Pequeno Cordeiro Shasha" em um balão de ar quente, viajando por pastagens holandesas e fábricas de alta tecnologia. Essa abordagem era custosa e desafiadora.

Desta vez, a equipe de produção utilizou uma máquina a vapor para criar essas cenas fantásticas, que seriam difíceis de serem realizadas com ação ao vivo, por meio de renderização estilizada por IA. Mais importante ainda, a IA integrou perfeitamente à narrativa pontos-chave de venda, como a origem do leite holandês e uma fórmula probiótica, encurtando o ciclo de produção para apenas alguns dias. Os visuais resultantes permaneceram fluidos e expressaram perfeitamente a filosofia da marca.

Sejam criadores profissionais ou inúmeros criadores e marcas de pequeno e médio porte, todos ganharam essencialmente uma "caneta cibernética". Com apenas "uma imagem e uma frase", você pode dar vida a um Guerreiro de Terracota estático e fazer uma ligação, ou ter Zhang Fei conversando com você enquanto borda. Essa barreira à criação está desaparecendo e está remodelando a equação de custos e as regras competitivas da indústria de conteúdo.

Claro, não é um canivete suíço perfeito . Atualmente, ele tem limitações quanto à duração dos vídeos que pode gerar para efeitos visuais sem diálogo, e sua escolha de som e estilo poderia ser mais rica.

No entanto, na era dos produtos de IA com iteração rápida, não existe um produto verdadeiramente perfeito. Em vez disso, os produtos mais eficazes são aqueles que podem ser implementados mais rapidamente para atender às necessidades reais do usuário. O Steam Engine do Baidu evitou a vaidade de uma corrida armamentista tecnológica, optando por uma abordagem mais pragmática e focada no mercado. É como um martelo focado em martelar pregos. Embora não consiga aplainar madeira, atinge a perfeição na tarefa de martelar pregos.

Observando o personagem gerado pela IA falar livremente diante de mim, sem me sentir como uma máquina, não posso deixar de sentir uma onda de admiração. As ferramentas eventualmente se tornarão invisíveis, mas a criatividade sempre brilhará. O que a máquina a vapor fez foi devolver o sonho de dirigir, antes incrivelmente caro e reservado a poucos, a todos que tivessem algo a dizer.

Hoje em dia, não nos faltam mais boas ferramentas, mas sim ideias novas; e ideias únicas surgem de tentativas repetidas.

Texto|Li Chaofan e Zhang Zihao

Para ver o vídeo no artigo, clique neste link: https://mp.weixin.qq.com/s/cy7m7e97AVVo5VqUcnS0_w

#Bem-vindo a seguir a conta pública oficial do WeChat do iFaner: iFaner (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.