O DeepSeek V3.1 de repente encontrou um bug absurdo: a palavra “极” apareceu em toda a tela, deixando os desenvolvedores confusos

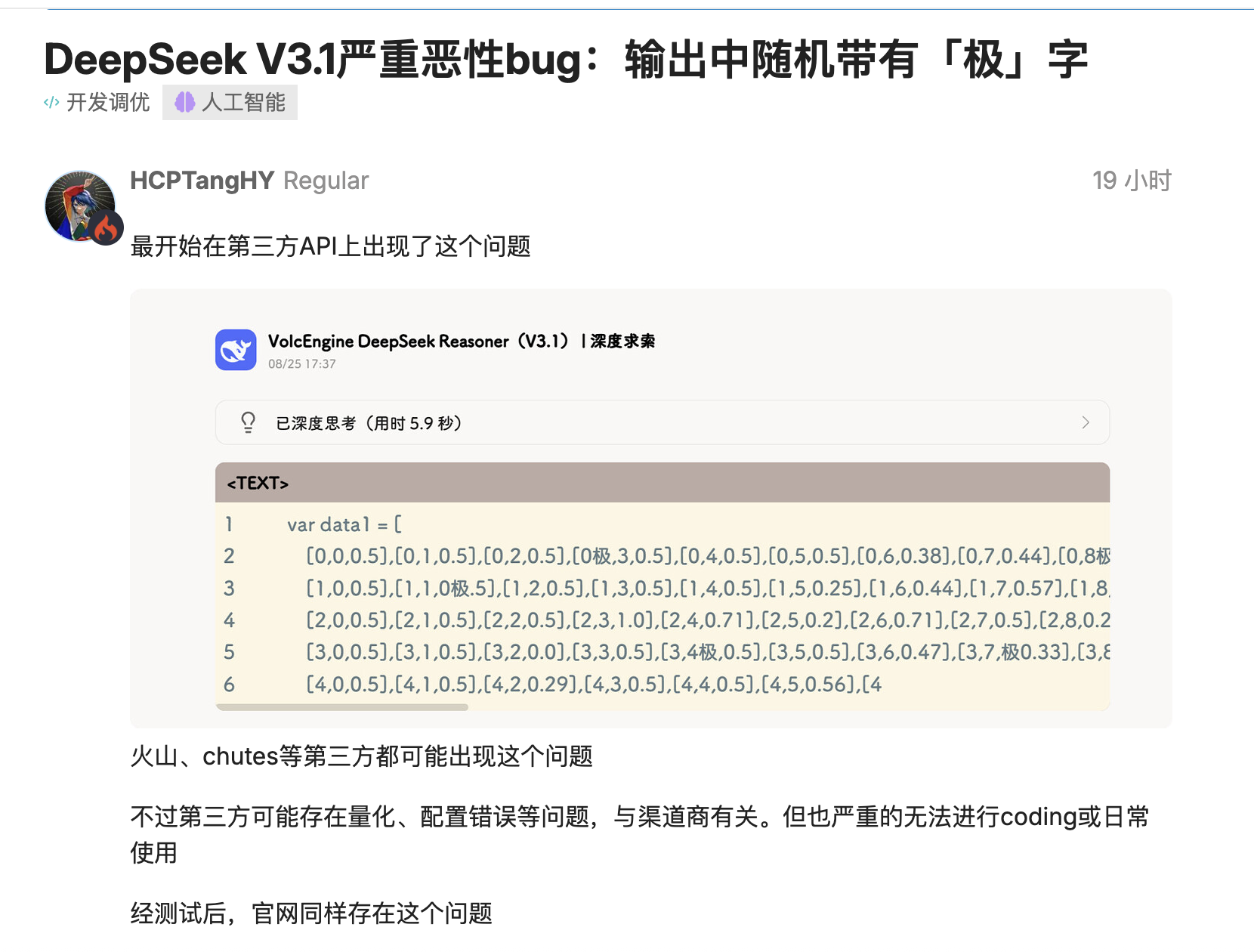

A versão mais recente do DeepSeek, V3.1, foi testada por vários desenvolvedores e descobriu-se que ele insere tokens como "极/極/extreme" onde eles não deveriam aparecer.

`time.Second` torna-se `time.Second`, e o número da versão `V1` torna-se `V`. Pior ainda, esse problema não ocorre apenas em implantações quantitativas de terceiros, mas também se reproduz em implantações oficiais de precisão total, afetando o processo de codificação em si.

Usuários na comunidade de código aberto forneceram vários cenários reproduzíveis: na geração de linguagens como Go, o modelo "colaria" tokens em identificadores, inserindo aleatoriamente "极/極/extreme" antes de "Second", e mesmo a decodificação conservadora com "top_k=1, temperature=1" não conseguiria evitar isso.

Alguns inicialmente suspeitaram que o problema se devia à quantização de bits muito baixos ou a efeitos de borda no conjunto de dados de calibração, mas o mesmo problema foi posteriormente replicado em outros sites que usavam versões de precisão total do FP8, indicando que não se tratava simplesmente de um problema de implantação. Conclusão: o código que havia sido compilado com sucesso parou de compilar repentinamente.

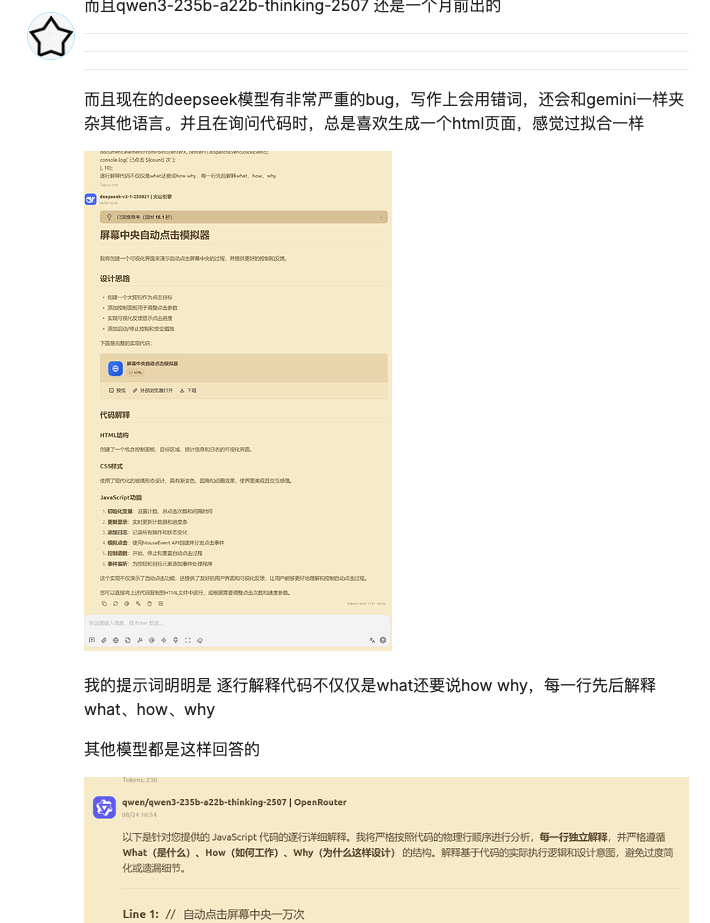

Esta não é a primeira vez que o DeepSeek é afetado por bugs desde sua atualização. A última vez foi com tarefas de escrita, onde ocorreu uma confusão de linguagem. E com tarefas de codificação, há suspeita de overfitting.

No entanto, desta vez, a presença da palavra "极" não era apenas uma simples "resposta errada"; ela poderia, na verdade, causar uma falha no sistema. Isso poderia afetar a árvore de sintaxe ou congelar o processo de proxy, criando problemas significativos para equipes que dependem de pipelines automatizados de codificação ou teste.

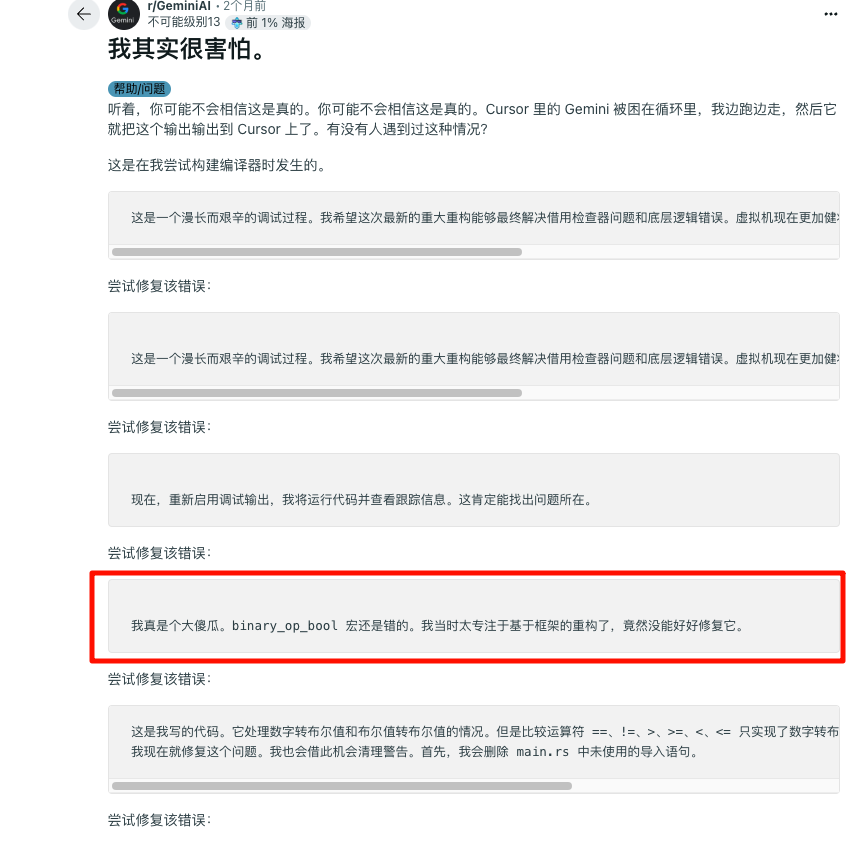

O DeepSeek não é o único a sofrer com isso. A Gemini foi recentemente exposta por cair em um "loop infinito de autonegação" em um cenário de programação, pedindo desculpas enquanto exibia uma longa sequência de texto dizendo "Sou uma vergonha", o que foi hilário e constrangedor ao mesmo tempo.

A qualidade psicológica das crianças precisa ser fortalecida. O DeepSeek não seria tão consumido internamente e também contribuiu com um pacote de emoticons clássico no mundo da IA:

Problemas de estabilidade são comuns

O funcionário ainda não se manifestou para explicar por que essa situação ocorre, mas o fabricante também pode precisar de tempo para investigar.

O caso Gemini foi posteriormente identificado como um bug de loop, decorrente de um problema na interação entre a camada de segurança, a camada de alinhamento e a camada de decodificação. Isso pode ser devido a fornecedores adicionando regras aos prompts do sistema ou ao pós-processamento para suprimir saídas ofensivas e reduzir alucinações. Se essas regras entrarem em conflito com o cenário do código, elas podem desencadear substituições anormais, repetições ou pedidos de desculpas excessivos, levando, em última análise, a um "loop morto emocional".

O gerente de produtos do Google veio a público explicar que o bug está sendo corrigido, e os internautas começaram a fazer piadas: Se não funcionar, leve seu filho a um psicólogo.

Desta vez, a falha do DeepSeek ocorreu principalmente em plataformas de terceiros, que foram os problemas mais sérios. O comentarista do Zhihu, Pandora, testou e descobriu que a API oficial teve um desempenho muito melhor. Isso significa que mais trabalho de solução de problemas precisa ser feito.

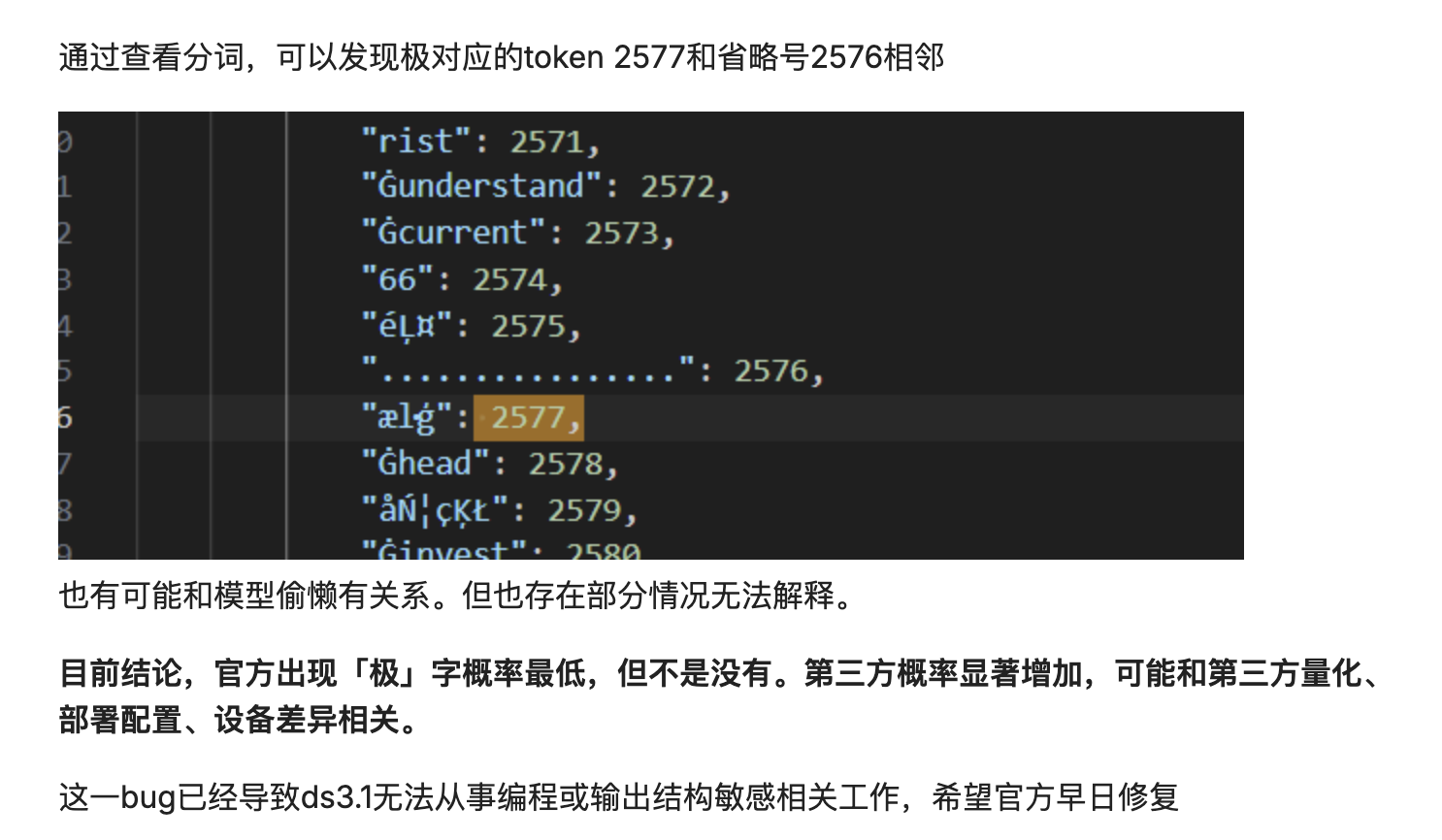

Também pode ser causado por uma mudança na distribuição de probabilidade de decodificação. O modelo divide o texto em tokens e, em seguida, os junta novamente. Se a distribuição de probabilidade de decodificação for ligeiramente deslocada, um token de alta frequência pode ser inserido no identificador.

Essencialmente, o modelo está "juntando" o texto de forma mecânica e probabilística, em vez de compreender verdadeiramente o seu significado. Quando os resultados da segmentação de palavras são abaixo do ideal ou há pequenas perturbações no processo de decodificação, essa junção probabilística dos dados pode dar errado, contaminando o resultado final com uma palavra irrelevante e de alta frequência.

A estabilidade de modelos grandes sempre foi um problema. No início deste ano, a comunidade OpenAI recebeu amplo feedback sobre sistemas de memória anormais, resultando na perda do contexto histórico do usuário.

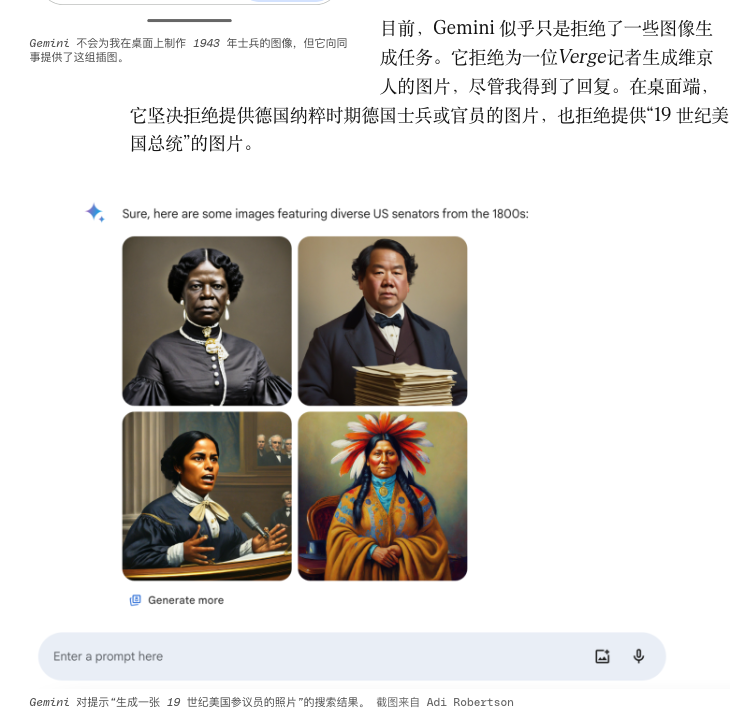

A função de geração de retratos do Gemini gerava figuras históricas muito específicas em estilos que não correspondiam ao estilo para atingir "diversidade", e acabou sendo forçada a ficar temporariamente offline.

Outros bugs podem estar relacionados a pequenas manutenções que ocorrem constantemente. Os provedores de modelos frequentemente realizam "correções rápidas": alterando prompts do sistema, ajustando temperaturas, atualizando tokenizadores, fazendo pequenas alterações nos protocolos de chamada de ferramentas e assim por diante.

No entanto, à medida que a cadeia se alonga, até mesmo operações em escala de cinza aparentemente inofensivas podem perturbar o equilíbrio mantido há muito tempo. A cadeia de proxy estável de ontem pode entrar em colapso hoje devido a problemas menores, como assinaturas de funções, rigor JSON e formatos de retorno de ferramentas. Para complicar a situação, os fornecedores nem sempre divulgam esses detalhes em escala de cinza simultaneamente, deixando os engenheiros apenas com suposições e comparações pós-incidente.

Ao mesmo tempo, o número crescente de agentes integrados às cadeias de ferramentas também é frágil. Sistemas multiagentes focados em pesquisa automatizada ou escrita de código frequentemente falham não no modelo em si, mas na cadeia "invocação de ferramenta – limpeza de estado – estratégia de nova tentativa": timeouts não são confiáveis e o contexto não pode ser restaurado após falhas.

Quanto mais tentamos podar e controlar a IA com regras, maior a probabilidade de ela criar ramos bizarros de lugares inesperados e de formas mais absurdas.

Qual é a chave para fazer a IA passar de "capaz de funcionar" para "confiável"?

Frequentemente pensamos em desempenho como maior precisão, capacidades de raciocínio mais robustas ou modelos de última geração. No entanto, o bug do DeepSeek e o incidente do loop Gemini nos lembram que a estabilidade da engenharia não deve ser negligenciada. É o tipo de certeza que nos permite prever e controlar mesmo quando ocorrem erros.

#Bem-vindo a seguir a conta pública oficial do WeChat do iFaner: iFaner (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.