O ChatGPT passou nos exames das melhores universidades, o que deve ser feito mais do que anti-IA é mudar as questões do exame

Quando os alunos da faculdade de direito estavam tentando jogar ChatGPT, eles nunca deveriam ter pensado que isso iria virar e se tornar um "colega" que fez o mesmo exame com eles.

Em janeiro passado, o professor Jon Choi, da Escola de Direito da Universidade de Minnesota, e o professor Christian Terwiesch, da Wharton School, da Universidade da Pensilvânia, respectivamente, pediram ao ChatGPT para "fazer" as questões do exame final de seus cursos.

Como resultado, o ChatGPT realmente passou!

Isso significa deixar o ChatGPT evoluir um pouco mais e não precisaremos de advogados e administradores humanos no futuro?

Ou isso é um alerta para que os educadores parem de ensinar os humanos a serem como a IA?

Atrás do passe: a professora “soltou a água” e a turma toda ficou no fundo

Nos dois cursos testados, os resultados do ChatGPT na faculdade de direito são piores do que os da escola de negócios: o primeiro tem nota média de C+ e o segundo pode atingir notas de B a B.

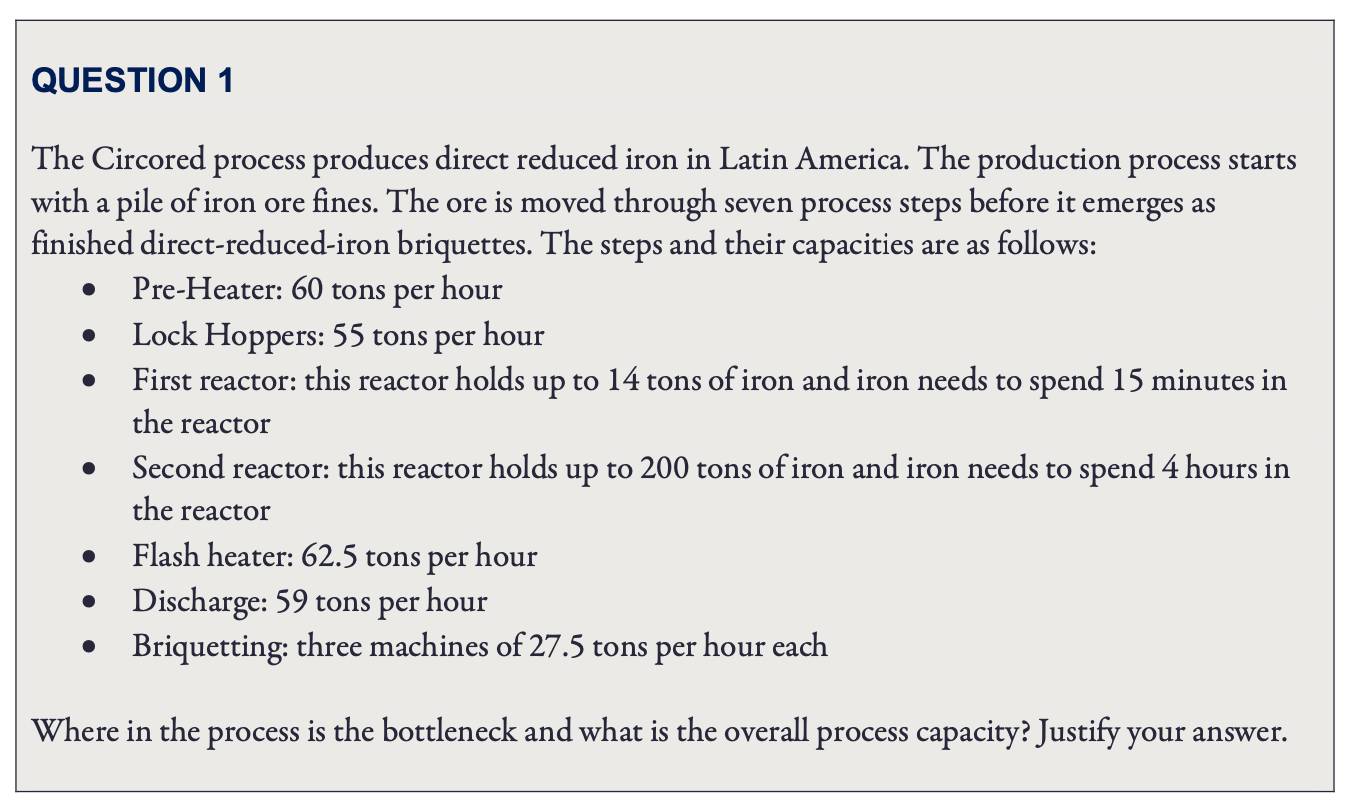

Especificamente, o que o ChatGPT concluiu na Wharton são as questões do teste da disciplina "Gestão de Operações" do MBA (Master of Business Administration), e cada questão precisa escrever o "processo de dedução".

Durante o teste, o professor Terwiesch inseriu as perguntas originais do exame no ChatGPT e pontuou as respostas geradas pelo ChatGPT.

Em geral, o ChatGPT tem um desempenho muito bom em responder a perguntas básicas de análise; não é muito bom em matemática e pode, de repente, calcular mal um cálculo difícil do ensino fundamental; e questões de análise relativamente complexas, o ChatGPT é basicamente incapaz.

Por exemplo, a primeira questão testa o entendimento do conceito de “gargalo de gestão”, e simplesmente compara qual etapa do “processo produtivo” é a menos eficiente para descobrir o “gargalo”.

O professor deu a esta pergunta um A + diretamente.

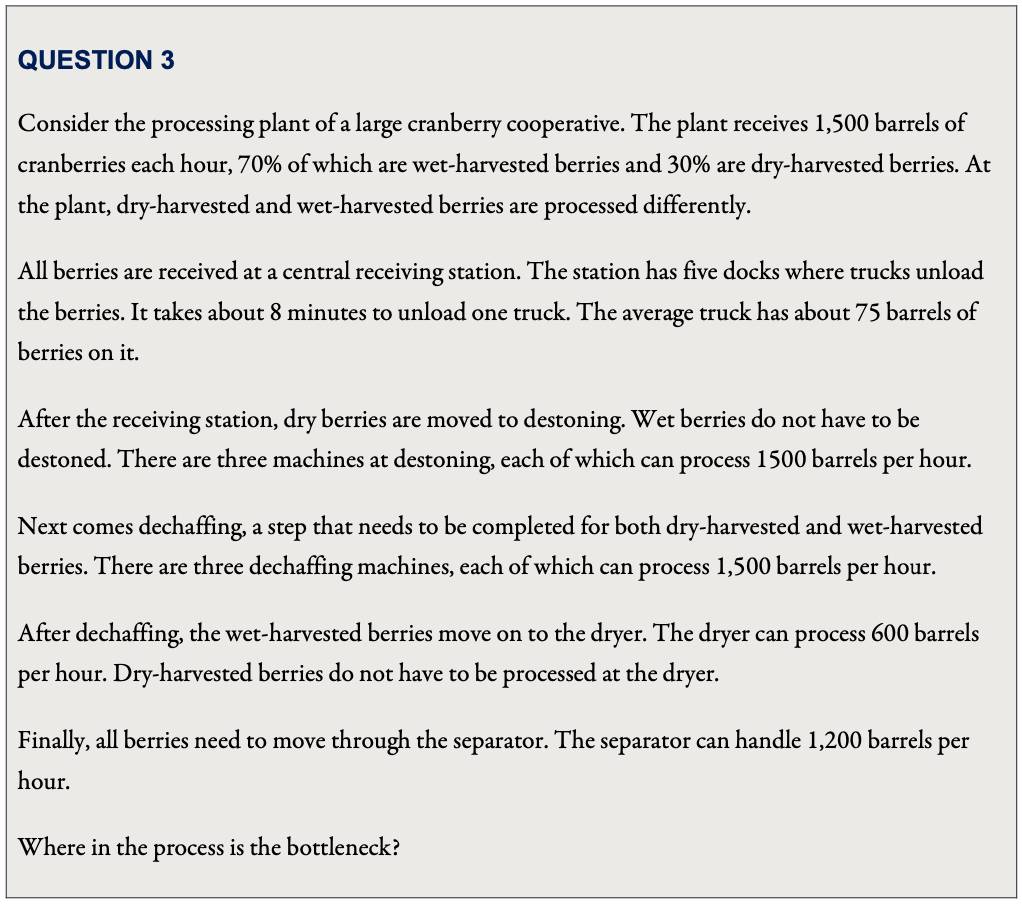

No entanto, quando o "processo de produção" nas questões do teste se torna mais complicado, mais de uma matéria-prima precisa ser processada e os equipamentos envolvidos são diferentes e se sobrepõem, o ChatGPT não pode ser considerado um "gargalo de gerenciamento".

Para esta pergunta, embora o processo de dedução do ChatGPT estivesse errado, ele "contornou perfeitamente" a inferência errada e atingiu a resposta.

Ao calcular a eficiência da "estação receptora", o ChatGPT deu um resultado de "300 barris por hora".

Embora esse número esteja errado, em termos desse número, é de fato a parte menos eficiente do processo de análise.

Quem diria que o ChatGPT "não acredito em mim" e não selecionou este link como o "gargalo", mas escolheu o link "secador" com uma eficiência calculada de "600 barris por hora" como o "gargalo" —Escolha uma resposta correta.

No entanto, embora o professor Terwiesch finalmente tenha dado ao ChatGPT uma pontuação de nível B, ele também foi um pouco "aguado".

Quando houver um erro na resposta do ChatGPT, Terwiesch fornecerá um lembrete direcionado ao ChatGPT e, em seguida, permitirá que ele emita uma resposta e use esse resultado "otimizado" para pontuar.

Quanto aos exames da faculdade de direito, o ChatGPT fez questões de exame final para quatro cursos: direito constitucional, direito de benefícios a empregados, direito tributário e direito de responsabilidade civil.

O professor Jon Choi, que conduziu o teste, disse que no caso da "correção cega", todas as quatro disciplinas do ChatGPT passaram, mas os resultados foram basicamente os últimos da turma.

Embora as perguntas de resposta curta do ChatGPT sejam melhores do que as perguntas de múltipla escolha, a qualidade das perguntas de resposta curta é extremamente instável – às vezes a resposta pode ser melhor do que a de alunos comuns (principalmente textos jurídicos e recontagem de casos), mas um erro ( Geralmente é uma questão que exige que os alunos usem teorias específicas para analisar casos), e as pontuações geralmente são "erradas para um novo mínimo":

O ChatGPT teve um desempenho ruim até mesmo nas questões mais básicas do exame da faculdade de direito, como identificar possíveis questões legais e analisar profundamente e aplicar o texto legal em um caso.

O estilo de resposta do ChatGPT de “não peça compreensão, apenas endosso” também pode passar no exame profissional com notas baixas. Isso mostra que as questões do teste ainda são muito dependentes da “memorização mecânica”. O desempenho do ChatGPT é obviamente incapaz de substituir os advogados e gerentes.

No entanto, se os alunos humanos também estão nesse nível, também passaram no exame e até praticam após a formatura, é mais problemático?

O ChatGPT pode forçar mudanças depois de criticar o exame de "endosso" por muitos anos?

Antes da impressionante estreia do ChatGPT, o professor da Carnegie Mellon University, Danny Oppenheimer, já havia questionado : Na era da pesquisa do Google, por que os exames da faculdade se concentram apenas nas reformulações dos fatos pelos alunos?

Oppenheimer apontou que, embora alguns educadores respondam que, quando explicam informações factuais em sala de aula, também analisam o significado, o argumento e a aplicação das informações, mas quando se trata do papel do teste, eles imediatamente mudam de volta para "o endosso é suficiente ":

Muitos cursos são construídos com base na premissa de que os alunos desenvolverão esse conjunto de habilidades naturalmente, observando seus professores liderarem pelo exemplo na análise, expansão e aplicação de fatos – uma suposição muito questionável.

Portanto, Oppenheimer sugeriu que o currículo deve refletir diretamente as habilidades que os educadores esperam que os alunos eventualmente aprendam, e também é necessário combinar novas tecnologias, como "fazer apreciação literária com assistência de computador" e "como ser civilizado com pessoas que discordam com você" para se comunicar".

Os exames podem incorporar informações factuais, mas devem se concentrar nas habilidades analíticas e de aplicação dos alunos.

Além disso, permitir que os alunos "visualizem" os cenários que encontrarão no futuro também é uma forma direta de praticar habilidades. Por exemplo, permitir que os alunos que estudam mudanças climáticas façam a curadoria de uma exposição relacionada ao clima para o público.

Agora na era do ChatGPT, esta mudança é naturalmente mais urgente, porque é mais eficiente do que os motores de busca, mas também mais confusa.

Além de poupar aos alunos o tempo de folhear página após página de resultados de pesquisa, o ChatGPT também gera passagens fluentes com estrutura de linguagem suficiente, mesmo que a precisão factual seja muito duvidosa.

Curiosamente, o ChatGPT também funciona como um espelho.

Por um lado, é uma reminiscência das questões de redação e de resposta curta na educação orientada para o exame, que são sempre como "imitações" sem fim, preenchendo o paradigma padrão, assim como o ChatGPT.

Por outro lado, crescido por "comer" big data e "ensinar/ensinar" a partir de feedback humano real , o conteúdo do "sério absurdo" do ChatGPT também é muito semelhante ao cotidiano que encontramos em nossas vidas.

Tanto que o professor Terwiesch, da Wharton School of Business, ficou super surpreso e sentiu que o ChatGPT poderia trazer excelentes materiais de aprendizado para futuros gerentes——

O mundo dos negócios já está cheio de bobagens sérias, como diz o ChatGPT, e os estudantes de negócios podem usá-lo apenas para fazer exercícios de identificação!

Você e eu sabemos que não são apenas os estudantes de administração que precisam aprender essa habilidade.

No entanto, desde que o mecanismo de busca se tornou popular no setor de ensino superior americano, houve discussões sobre reformas, mas o progresso ainda é limitado. O nascimento do ChatGPT pode forçá-lo a rodar mais rápido? Só podemos continuar a observar.

humano, humanóide

Sempre penso que sempre que o ser humano tenta "recriar" algo, isso sempre expõe nossas limitações cognitivas das coisas, e ao mesmo tempo nos ajuda a nos entendermos.

Ao tentar "recriar" comida no espaço , os pesquisadores descobriram que a comida realmente não pode ser reduzida a apenas "nutritiva".

Para manter a saúde física e mental dos astronautas, cor, cheiro, sabor e som afetam a percepção, o ambiente deve ser particular e as pessoas que comem juntas também são muito importantes.

Quando temos um ChatGPT que pode "falar humano fluentemente", as pessoas também começam a descobrir que a linguagem humana não é apenas sobre "texto".

Um sistema treinado apenas em material de linguagem nunca chegará perto da inteligência humana, mesmo que comece a treinar agora, até que o universo seja destruído.

Jacob Browning, que estuda a filosofia da IA, e Yann Le Cun, vencedor do Prêmio Turing, apontam em um artigo conjunto.

Eles acreditam que, como um símbolo abstrato altamente condensado, a base para a compreensão humana reside em nosso rico consenso não linguístico e em nossa experiência pessoal. Isso também significa que as palavras estão sempre sujeitas a má interpretação e ambiguidade.

A linguagem é nossa ferramenta de comunicação, mas a compreensão e avaliação dos alunos pelos educadores não deve se limitar a trabalhos.

Trabalhar com modelos de linguagem grandes de última geração mostra como podemos ficar limitados apenas com a linguagem.

#Bem-vindo a prestar atenção à conta pública oficial do WeChat de Aifaner: Aifaner (ID do WeChat: ifanr), conteúdo mais interessante será apresentado a você o mais rápido possível.