A câmera do meu iPhone 14 Pro estragou e é tudo culpa da Apple

Todos os anos, a Apple divulga o iPhone como tendo um sistema de câmera incrível – e, sim, o hardware é certamente impressionante. O iPhone 14 Pro possui os últimos avanços que a Apple oferece em termos de atualizações de câmera, incluindo um grande salto para uma câmera principal de 48MP com tecnologia pixel-binning (quatro su-pixels para formar um pixel maior), uma lente telefoto com 3x óptica zoom, modo noturno mais rápido e muito mais. Novamente, na frente do hardware, a câmera do iPhone 14 Pro parece impressionante. E isso é!

Mas de que adianta um ótimo hardware de câmera quando o software continua a arruinar as imagens que você tira? Desde a linha do iPhone 13 , parece que todas as imagens tiradas de um iPhone, a menos que sejam tiradas no formato ProRaw, parecem ruins em comparação com as tiradas em iPhones mais antigos e nos melhores telefones Android concorrentes. Isso porque a Apple aumentou bastante a fotografia computacional e o pós-processamento cada vez que você tira uma foto. Está arruinando minhas imagens, e a Apple precisa tomar uma pílula fria e diminuir um pouco.

Esses recursos 'inteligentes' não são tão inteligentes quanto afirmam

Para tirar fotos, precisamos de sensores que ajudem a capturar luz e detalhes para criar essas imagens. No entanto, como os smartphones são muito mais compactos do que uma DSLR completa, os sensores são bastante limitados no que podem fazer. É por isso que a Apple, assim como outros fabricantes de smartphones, pode contar com software para melhorar a qualidade de imagem das fotos que você captura em um telefone.

A Apple introduziu o Smart HDR no iPhone em 2018, e esse recurso de software está agora em sua quarta iteração com a linha do iPhone 14 . Com o Smart HDR 4, o dispositivo tira várias fotos com diferentes configurações e combina os “melhores” elementos de cada imagem em uma única foto. Há muita fotografia computacional acontecendo com esse processo e, embora a intenção seja fazer com que as imagens pareçam boas, na verdade acontece o oposto.

Você deve ter notado isso quando tira uma foto no seu iPhone 14 (ou iPhone 13) e imediatamente toca na miniatura no canto para ver as imagens que acabou de tirar. A imagem ficará parecida com o que você capturou por um rápido segundo, mas então parece excessivamente nítida – com cores parecendo mais artificiais, talvez desbotadas em certas áreas e excessivamente saturadas em outras. Mesmo o tom de pele pode parecer um pouco diferente do que você vê na vida real. Embora eu tenha adorado o modo noturno quando estreou na série iPhone 11 , em comparação com a concorrência agora, o modo noturno faz com que as fotos pareçam muito “brilhantes” devido ao superprocessamento, e muitas fotos noturnas nem parecem ter sido tiradas em noite.

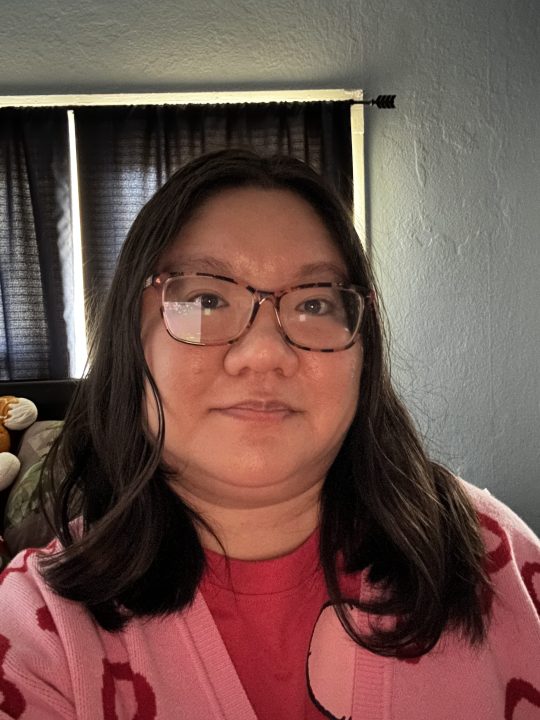

E você já tentou tirar uma selfie em condições de pouca luz? Claro, o iPhone também tem modo noturno para a câmera frontal, mas não achei que ajudasse muito. As selfies com pouca luz parecem horríveis, não importa o que você faça, porque o iOS adiciona muitos artefatos digitais à imagem para tentar “salvá-la”. Mas ao invés de salvar a foto, ela acaba parecendo uma aquarela ruim e bagunçada. Na verdade, tento não tirar selfies no meu iPhone 14 Pro quando estou em um ambiente escuro porque quase sempre acabam ficando ruins.

Não tenho certeza de quando as fotos tiradas com um iPhone começaram a ficar assim, mas definitivamente sinto que se tornou mais proeminente a partir da série iPhone 13. Posso estar errado, mas não me lembro particularmente das imagens do meu iPhone 12 Pro parecendo tão exageradas e, especialmente, das fotos do meu iPhone 11 Pro. O iPhone costumava tirar fotos que pareciam realistas e naturais, mas todo esse HDR inteligente e o pós-processamento de fotografia computacional ficaram fora de controle, tornando as imagens piores do que deveriam.

Apple, vamos desligar essas coisas

Alguns anos atrás, era possível não usar o Smart HDR. Essa era uma configuração opcional e que você poderia ativar ou desativar conforme achar melhor. Essa configuração estava disponível apenas nos modelos iPhone XS, iPhone XR, iPhone 11 series, iPhone SE 2 e iPhone 12. Desde o iPhone 13 e posteriores, a opção de ativar o Smart HDR foi removida.

Tirar essa opção foi uma jogada míope e espero que a Apple a traga de volta em algum momento. Apesar de meu iPhone 14 Pro ser meu dispositivo pessoal e principal, especialmente para fotografia, às vezes preciso editar uma imagem antes de considerá-la adequada para compartilhar com outras pessoas. Entendo o que a Apple está tentando fazer com o Smart HDR, mas a imagem resultante geralmente parece muito artificial em comparação com o que você vê na realidade.

Por exemplo, quando tiro fotos ao ar livre em condições de sol, a foto pode ter um céu azul excessivamente saturado, fazendo com que pareça falso. Também acho que, às vezes, a mudança de cor faz meu tom de pele parecer um pouco diferente — algo que o YouTuber Marques Brownlee (MKBHD) inclusive fala em um vídeo recente .

A concorrência do Android faz melhor

Mais uma vez, a Apple colocou um ótimo hardware de câmera na linha do iPhone 14 Pro, mas está manchado pelo superprocessamento do software. Como peguei alguns dispositivos Android diferentes em meu tempo aqui na Digital Trends, passei a gostar de como alguns telefones Android concorrentes lidam com a fotografia no iPhone.

Por exemplo, o Google Pixel 7 tira ótimas fotos com a câmera principal sem nenhum esforço extra. Basta apontar e disparar, e os resultados são precisos para o que seus olhos veem – se não melhores. O Google ainda usa muito de seu próprio processamento de imagem, mas não faz com que as fotos pareçam artificiais como a Apple faz. O único problema com ele, pelo que percebi, são as selfies. Não consegue obter o tom de pele com precisão, mas, caso contrário, a câmera principal é ótima. As cores são equilibradas, não desbotadas, e o software não se esforça muito para torná-las “boas”, porque elas já são. E com ferramentas divertidas como Magic Eraser , prefiro usar meu Google Pixel 7 para editar fotos.

Também testei o Samsung Galaxy S21 mais antigo para algumas dessas comparações de fotos e, embora não ache que ele lide com o tom e a cor da pele tão bem, parece funcionar bem para selfies com pouca luz, o que me surpreende. Ele também lidou muito bem com as imagens no modo noturno, fazendo com que pareçam naturais e realistas, em vez de estouradas com as cores apagadas como o iPhone 14 Pro.

Portanto, embora a Apple possa dizer que tem o “melhor” hardware de câmera, o iOS e o excesso de confiança na fotografia computacional estão arruinando a aparência das imagens. Claro, algumas pessoas podem gostar dessa estética, mas eu pessoalmente não suporto o quão antinatural muitas das minhas fotos acabam parecendo. A Apple precisa diminuir o tom do Smart HDR ou, pelo menos, trazer de volta a opção de desligá-lo, se quisermos. Porque, neste momento, as coisas não parecem boas.