“Rabbit Trampoline” tem mais de 500 milhões de visualizações! Este vídeo de IA mais popular da internet é o resultado da paixão dos humanos por serem “enganados”.

Um vídeo de um "trampolim de coelho" que parece ter sido capturado por vigilância de visão noturna se tornou viral no TikTok, acumulando 500 milhões de visualizações na rede.

O vídeo parece ter sido gravado por uma câmera de segurança. A iluminação é fraca e a imagem está borrada, mas captura perfeitamente vários coelhos pulando alternadamente, como se estivessem em um show noturno.

A legenda do vídeo diz: "Acabei de verificar a segurança da minha casa e acho que temos alguns convidados especiais no nosso quintal! @Ring."

As imagens borradas da vigilância e alguns coelhos que pareciam estar festejando fizeram com que essa imagem fofa e levemente realista rapidamente atraísse a atenção das pessoas.

@Greg, uma celebridade com milhões de seguidores na plataforma de mídia social X, também comentou: "Eu nunca percebi que precisava de um monte de coelhinhos de trampolim até hoje."

No entanto, essa fofura é falsa. O coelho no vídeo não existe na vida real. Algumas pessoas descobriram que ele foi gerado por IA.

Entre o 5º e o 6º segundo, o coelho no canto superior esquerdo "desaparece" de repente. Olhando para trás, os detalhes são realmente um pouco estranhos.

Mas, ao contrário da maioria dos vídeos de "erros de IA", este ficou quase irreconhecível imediatamente. Até mesmo espectadores mais jovens e experientes exclamaram: "Ah, não! Fui enganado!"

Mas isso não foi um golpe, foi mais como um pequeno desastre nas redes sociais: não que fomos enganados, mas que estávamos dispostos a ser enganados .

Parece certo, mas na verdade é certo

A razão pela qual esse vídeo de IA conseguiu "enganar" o público com sucesso não é porque a tecnologia de geração de vídeo de IA é perfeita, mas porque ela "engana perfeitamente".

Ele explora com precisão nossas impressões inerentes de vídeos de vigilância e também detecta as senhas de tráfego que têm mais probabilidade de nos fazer baixar a guarda.

A qualidade de visão noturna desfocada e os fundos estáticos apenas encobrem as fraquezas da IA

Estamos acostumados a pensar em imagens de vigilância noturna como desfocadas, escuras e cheias de ruído. Essa noção preconcebida mascara efetivamente as falhas técnicas do vídeo de IA, como problemas com continuidade de movimento, detalhes de sombra e dinâmica de fundo.

Então, quando aparece na forma de "vídeo de vigilância noturna", a baixa definição e a qualidade desfocada da imagem se tornam uma isca, ajudando a encobrir a falta de realismo.

▲ A qualidade do vídeo atende às características de vigilância noturna, e o fundo é completamente estático.

Além disso, embora alguns modelos de geração de vídeo de IA sejam muito bons em lidar com assuntos em primeiro plano, a renderização do fundo geralmente parece muito surreal.

O fundo deste vídeo é estático, o que ajuda a IA a contornar uma dificuldade técnica.

A redação com "@Ring" aumenta a credibilidade da fonte

O editor do vídeo inteligentemente colocou a marca de câmeras de segurança doméstica "Ring" no título, o que imediatamente fez a fonte do vídeo parecer razoável e fez as pessoas se sentirem mais autênticas.

▲ Ring é uma marca de câmeras domésticas

Esse pequeno detalhe cria a ilusão de que "este vídeo foi capturado pela campainha de outra pessoa", fazendo com que as pessoas o classifiquem automaticamente como um "registro de vida" em vez de "conteúdo criativo".

“Animais fazendo coisas à noite” é um meme que os internautas aceitaram por padrão

Inúmeros vídeos virais nos condicionaram a acreditar que esse cenário é real. Gatos roubando macarrão instantâneo à noite, guaxinins invadindo piscinas, coiotes brincando em trampolins — os animais sempre adoram "quebrar as regras" quando os humanos não estão por perto. Um trampolim para coelhos, por exemplo, parece perfeitamente plausível, não importa como você o veja.

▲ Urso invade piscina

O mais importante: é tão fofo! Quem poderia questionar um momento tão terno? Quando algo é doce e leve, é fácil para nós "escolher acreditar".

Embora o coelho no canto superior esquerdo do vídeo desapareça repentinamente no meio, revelando sua natureza gerada por IA, para a maioria dos espectadores que rolam vídeos curtos rapidamente, essa falha momentânea é facilmente ignorada.

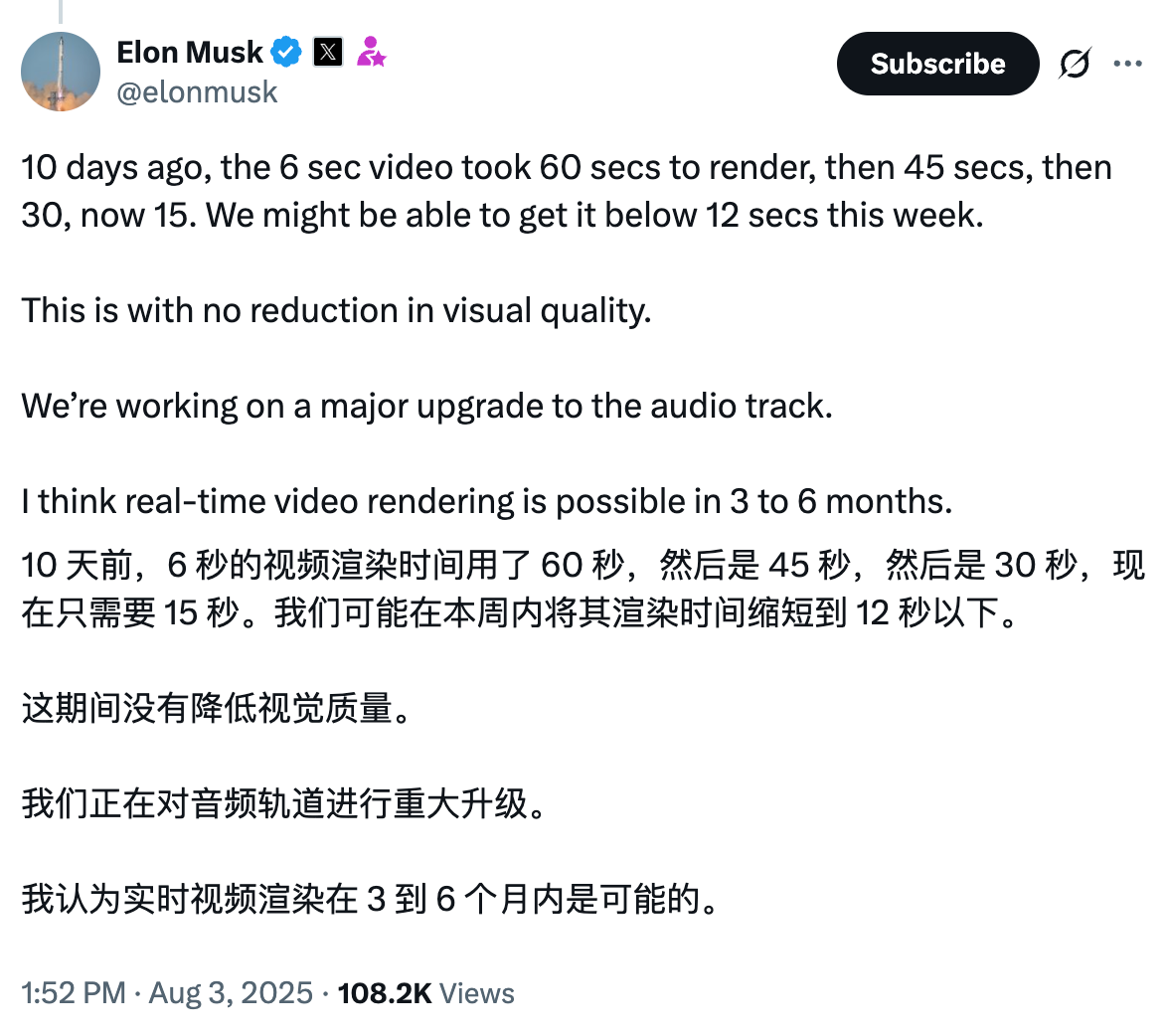

Enquanto o vídeo do coelho gerou uma discussão acalorada, Musk também compartilhou o incrível progresso da tecnologia de vídeo de IA.

Dez dias atrás, um vídeo de 6 segundos levava 60 segundos para ser renderizado, depois caiu para 45 segundos, depois 30 segundos e agora está em 15 segundos.

Esta semana poderemos conseguir um tempo abaixo de 12 segundos.

Ele também disse que a tecnologia de renderização de vídeo em tempo real deverá ser implementada dentro de 3 a 6 meses.

▲ Captura de tela do Twitter de Musk

Isso significa que os insetos nas fotos do "coelho desaparecendo" que ainda podemos ver hoje podem ser quase difíceis de detectar em alguns meses.

Quando os vídeos de IA são tecnicamente impecáveis, não faz sentido discutir "como distinguir entre verdadeiro e falso".

Isso também nos obriga a mudar nosso foco da tecnologia em si para questões mais centrais.

Não é a IA que nos engana e nos deleita com ela

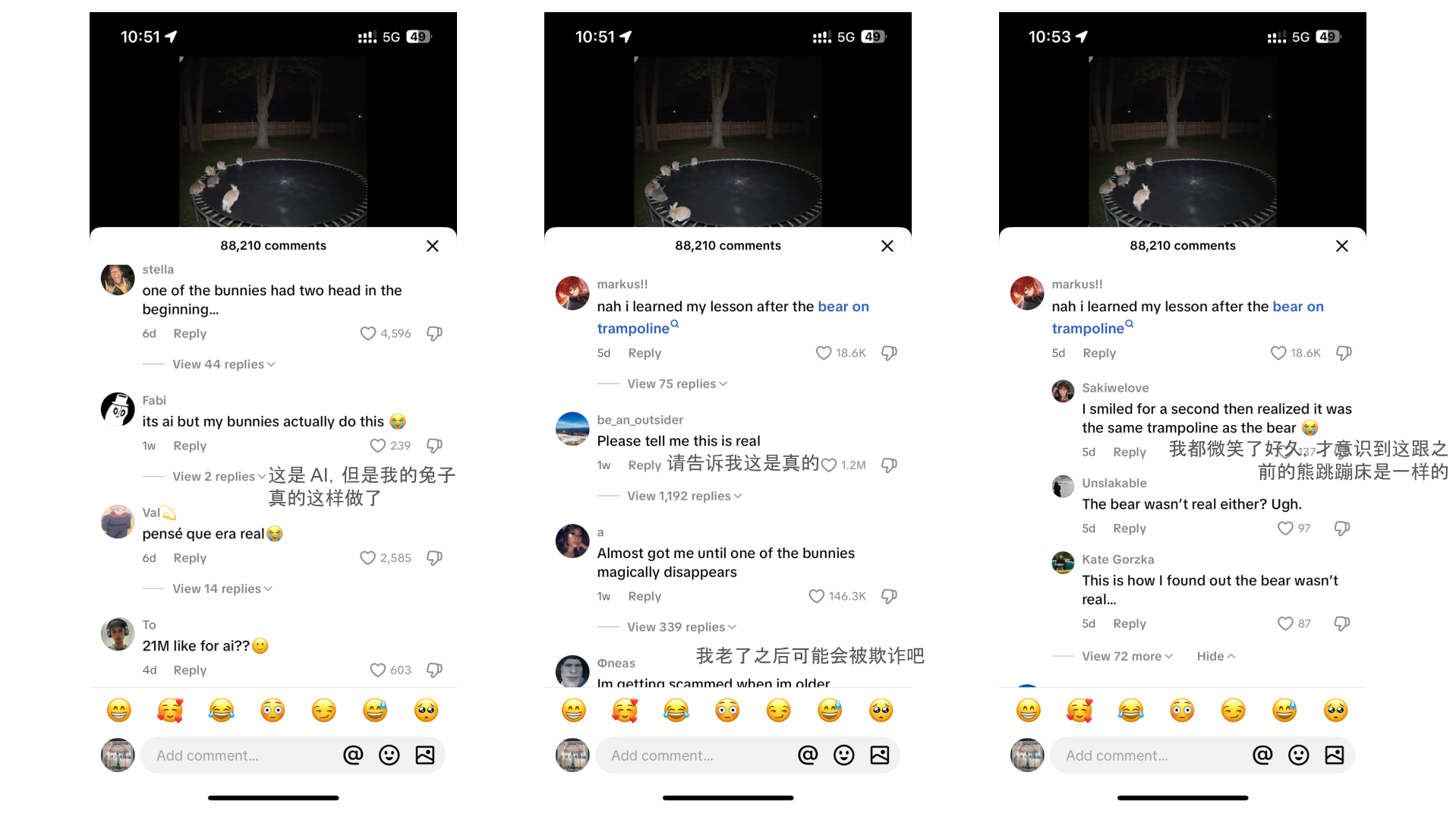

Depois que a verdade do vídeo foi revelada, muitos usuários expressaram um sentimento de "colapso de fé".

Um usuário do TikTok disse: "Este é o primeiro vídeo de IA que acredito ser real. Definitivamente, estarei ferrado quando ficar velho." Outro usuário disse: "Agora acho que serei um desses idosos que são enganados."

Essa mudança emocional da confiança para o pânico se tornou um novo tópico quente online.

No entanto, atribuir o problema simplesmente ao "desenvolvimento rápido demais da IA" ou ao "sermos facilmente enganados" pode ignorar questões mais profundas. O cerne deste incidente pode não estar na tecnologia de IA em si, mas nas próprias práticas das plataformas de mídia social.

Ao analisar os comentários no vídeo, descobrimos que as reações das pessoas na seção de comentários mostraram quase o mesmo roteiro psicológico.

Primeiro, “Meu Deus, isso é tão fofo”;

Então, “Espere, alguma coisa não parece certa?”;

O terceiro passo é: "Fui enganado? Acabou. Vou me tornar um velho enganado?"

Finalmente, voltei a isso: "Mas… eu não o culpo."

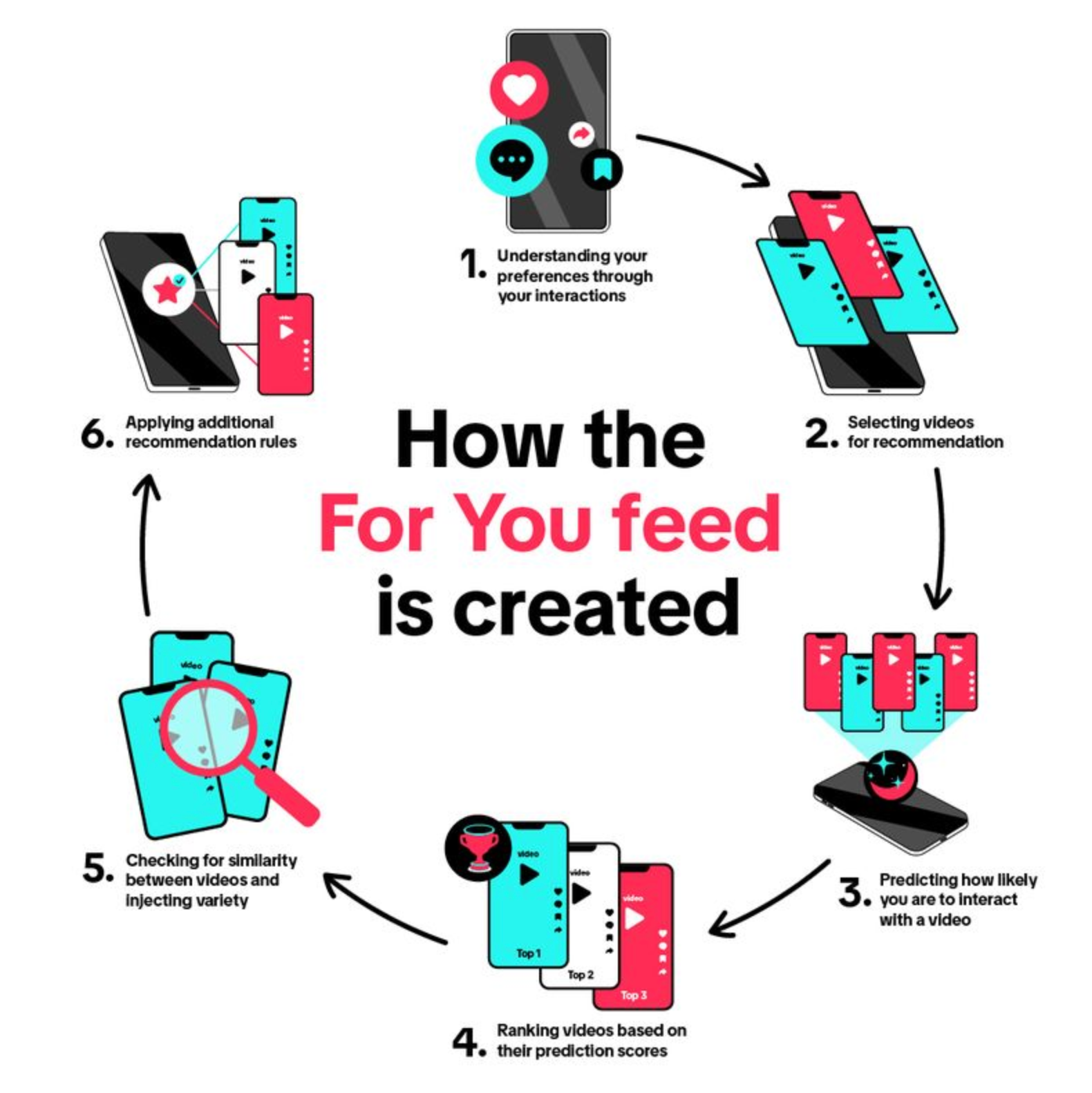

Estamos estabelecendo uma nova "lógica de interação" com vídeo de IA.

Não acreditamos completamente, mas achamos que pode ser falso, mas ainda estamos dispostos a parar e dar uma olhada, curtir, encaminhar para os amigos e dar um palpite, como em um jogo.

▲ Sistema de recomendação de plataforma de vídeos curtos

O algoritmo da plataforma também está bem ciente dessa estrutura psicológica.

Nesse processo, a questão de saber se o vídeo da IA é real ou falso deixa de ser a questão central; torna-se uma barreira de entrada: você o entende? Consegue distinguir a diferença? Você foi enganado?

Nos últimos dois anos, desde a explosão da IA, sempre lamentamos que os vídeos e imagens da IA tenham se tornado tão realistas que sentimos pânico e nos preocupamos que seremos mais facilmente enganados por informações falsas no futuro.

No entanto, a disseminação viral deste vídeo não se deve inteiramente ao "poder enganoso" da tecnologia de IA, mas sim à necessidade profunda do público humano de ser "enganado".

Nem todos esses internautas foram enganados passivamente, mas muitos deles participaram ativa e tacitamente de um jogo coletivo chamado "fingir que acredita".

O protagonista deste carnaval não é a IA, mas nós mesmos.

Foi o "flash" do coelho desaparecendo no vídeo que transformou todo o incidente em um jogo de "encontre as diferenças" do qual toda a rede participou. Se o vídeo fosse perfeito e contínuo, ele poderia ser rapidamente abafado pelo próximo vídeo.

▲ O filme "O Grande Truque"

É como se o público soubesse que o mágico está os “trapaceando”, mas o que eles gostam é justamente o desafio cognitivo de “saber que é falso, mas não conseguir ver a falha”.

A "exposição" do coelho da IA foi o momento em que a mágica foi exposta, o que permitiu que todos participassem da discussão e desencadeou a disseminação da ideia.

Falhas criam controvérsia, e a controvérsia impulsiona a participação. A autenticidade do vídeo não importa mais; a confusão e a discussão que ele gera são garantia de tráfego.

Esse comentário autodepreciativo de "Eu também fui enganado" rapidamente diminui a distância psicológica entre estranhos on-line, promovendo um senso de comunidade: "Somos todos facilmente enganados ". A conexão promovida por "sermos enganados juntos" tem um valor social muito maior do que a autenticidade do conteúdo do vídeo em si.

O ideal seria aprendermos a aproveitar conscientemente esse "conteúdo falso", mantendo um entendimento claro, mas isso pode não ser fácil para a maioria das pessoas.

O perigo potencial reside não apenas no realismo da IA, mas também quando esse "engano coletivo" é usado para fins maliciosos, como a fabricação de boatos ou golpes. O que precisamos estabelecer é a capacidade de identificar a "intenção" da informação, em vez de simplesmente julgar sua "verdade".

Podemos nos perguntar com mais frequência: Como esse conteúdo quer que eu me sinta? O que ele quer que eu faça?

#Bem-vindo a seguir a conta pública oficial do WeChat do iFaner: iFaner (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.