Ilya faz uma rara declaração pública: A era da escalabilidade acabou, e nossa definição de Inteligência Artificial Geral (IAG) pode estar completamente errada.

Corrigir um bug pode levar repetidamente ao mesmo erro; escrever código pode ser um ciclo vicioso que termina no ponto de partida.

Mas quase todas as empresas de IA acreditam firmemente que, desde que o modelo seja ampliado, os dados sejam abundantes e haja poder computacional suficiente, a inteligência surgirá automaticamente. Essa lei de escalabilidade já foi a crença mais inabalável no Vale do Silício.

Após um longo hiato e a fundação de sua nova empresa, a SSI (Safe Superintelligence), o ex-cientista-chefe da OpenAI, Ilya Sutskever, declarou em tom extremamente calmo: " A era da escalabilidade acabou; retornamos à era da pesquisa. "

Em uma conversa recente e aprofundada entre Ilya e Dwarkesh Patel, ele não apenas apresentou um roteiro tecnológico para o futuro da IA, mas, mais importante ainda, ofereceu uma resposta profunda para a questão de por que a IA atual, por mais poderosa que seja, ainda não se assemelha a um ser humano.

Link do podcast: https://x.com/dwarkesh_sp/status/1993371363026125147

Link do podcast: https://x.com/dwarkesh_sp/status/1993371363026125147

Por que a IA é uma aluna de alto desempenho, mas com baixa capacidade?

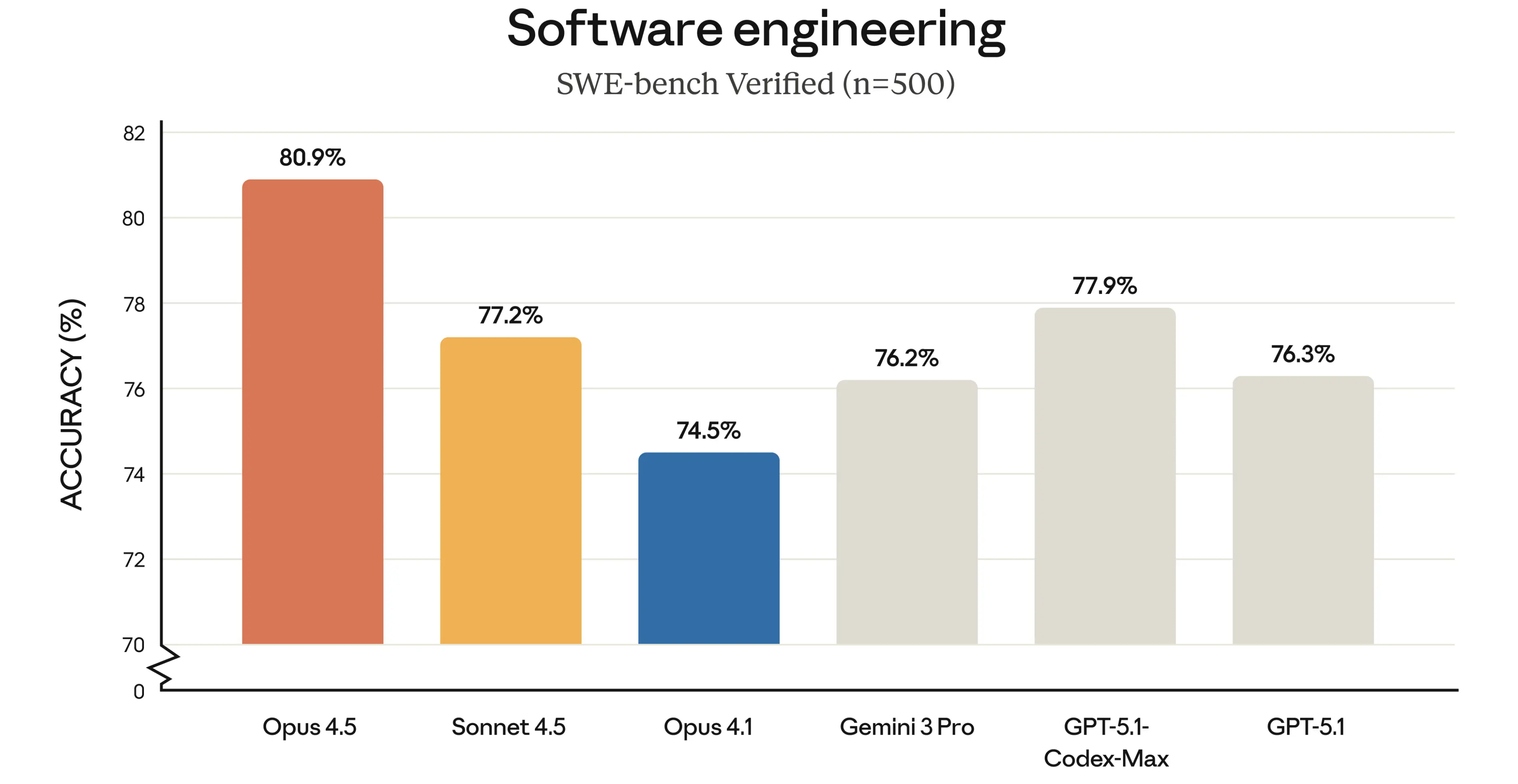

Frequentemente pensamos que a IA atual é muito poderosa; ela pode ganhar medalhas de ouro em competições de programação, competições de matemática e em vários rankings, e a cada novo modelo lançado, ela continua quebrando diversos recordes. Mas Ilya apontou um fenômeno que o intrigou.

▲ O recém-lançado modelo Claude 4.5 Opus alcançou uma pontuação de 80,9 em rankings relacionados à programação.

Ele disse que, quando usamos o Vibe Coding para que a IA escreva código, a IA pode encontrar um bug em algum lugar. Simplesmente dizemos a ela: "Há um erro aqui". A IA responde: "Meu Deus, você tem razão, vou corrigir imediatamente". Então ela corrige esse bug, apenas para introduzir outro. Você aponta o erro novamente, e ela corrige o primeiro bug de novo. Ela fica num ciclo infinito entre esses dois bugs, o que é extremamente desajeitado.

Sua explicação sugeriu que isso indicava um problema com a "capacidade de generalização" da IA. Para explicar esse termo, Ilya usou a analogia de diferentes alunos.

Imagine dois alunos aprendendo programação. O aluno A, representando a IA, é extremamente dedicado, praticando por 10.000 horas. Ele memorizou todo o banco de problemas e se lembra de todas as estratégias de resolução. Durante as provas, ele consegue tirar nota máxima em qualquer questão que já tenha visto.

O aluno B representa a humanidade. Ele simplesmente achava as competições de programação legais, passou 100 horas praticando, mas realmente entendia a lógica da programação, desenvolveu uma certa intuição e conseguiu ter um ótimo desempenho. No longo prazo, quem irá mais longe na carreira? Ele diz que com certeza será o aluno B.

A IA atual é como o aluno A. Sua suposta inteligência é baseada, em grande parte, na memorização mecânica de quantidades massivas de dados; ela é sobretreinada em grandes conjuntos de dados aumentados para problemas específicos, o que a faz ter um bom desempenho em tarefas, mas não necessariamente ser boa em generalizar para outros domínios.

O modelo carece da capacidade de generalizar para outras situações quando confrontado com pequenas alterações fora dos dados de treinamento, como a correção de um bug recorrente.

Desde o aumento da capacidade computacional até a ênfase na criatividade.

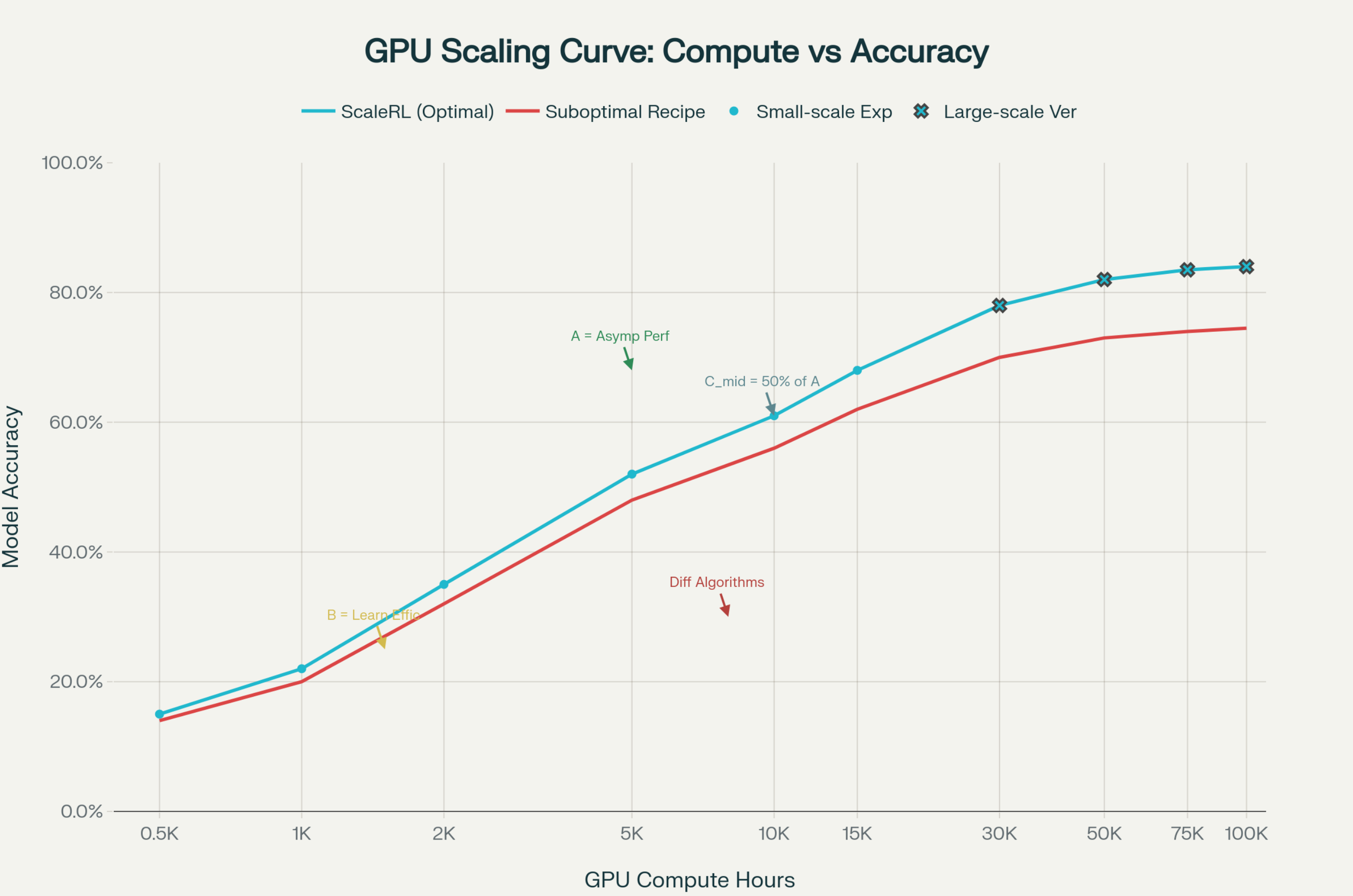

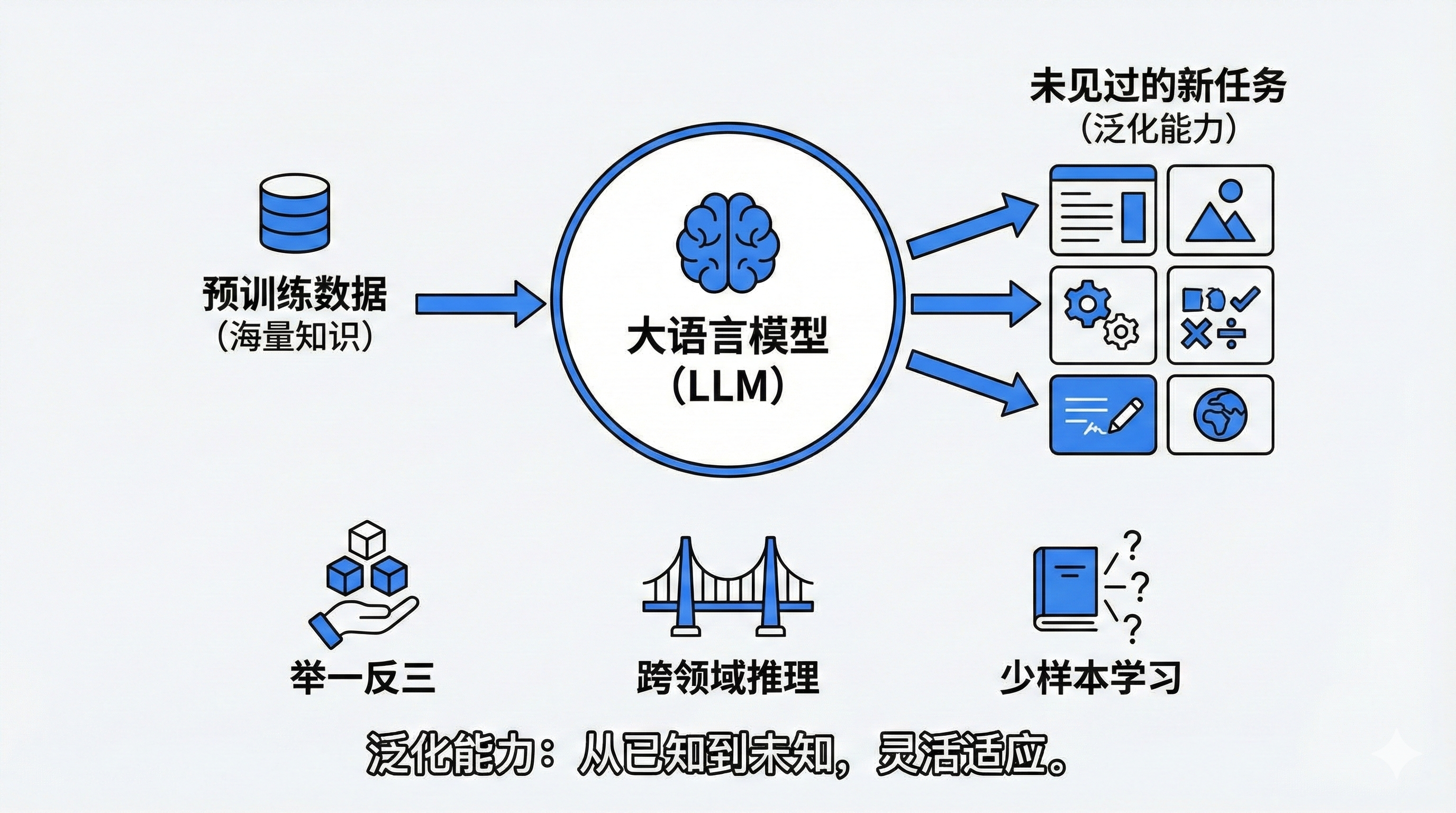

No entanto, esse método de treinamento com quantidades massivas de dados não é totalmente inútil. Nos últimos cinco anos, o desenvolvimento da indústria de IA seguiu basicamente a chamada "Lei de Escala", passando de grandes modelos com milhões de parâmetros no início para trilhões de parâmetros atualmente. O consumo de poder computacional das GPUs também está em uma escala que deve atingir níveis extraordinários.

Essa abordagem, que combina uma certa quantidade de poder computacional com uma certa quantidade de dados em uma rede neural, tornou-se um processo essencial no desenvolvimento de todos os modelos de grande porte — ou seja, o pré-treinamento. Durante a fase de pré-treinamento, não há necessidade de considerar quais dados usar, porque a resposta é: todos os dados; é o mundo inteiro que os humanos projetam no texto.

Ilya acredita que a própria palavra "escala" fixou nossa mentalidade. Ela implica que só precisamos fazer uma coisa: aumentar o poder computacional, aumentar os dados, manter a receita a mesma e aumentar o tamanho da panela para fazer um bom prato.

Ele afirmou que essa abordagem deixa as grandes empresas confortáveis porque é um investimento de "baixo risco". Comparado com pesquisas que exigem inspiração e sorte, as grandes empresas não precisam contratar cientistas para quebrar a cabeça; elas só precisam "adicionar dados e poder computacional", e os resultados de um modelo mais robusto são previsíveis.

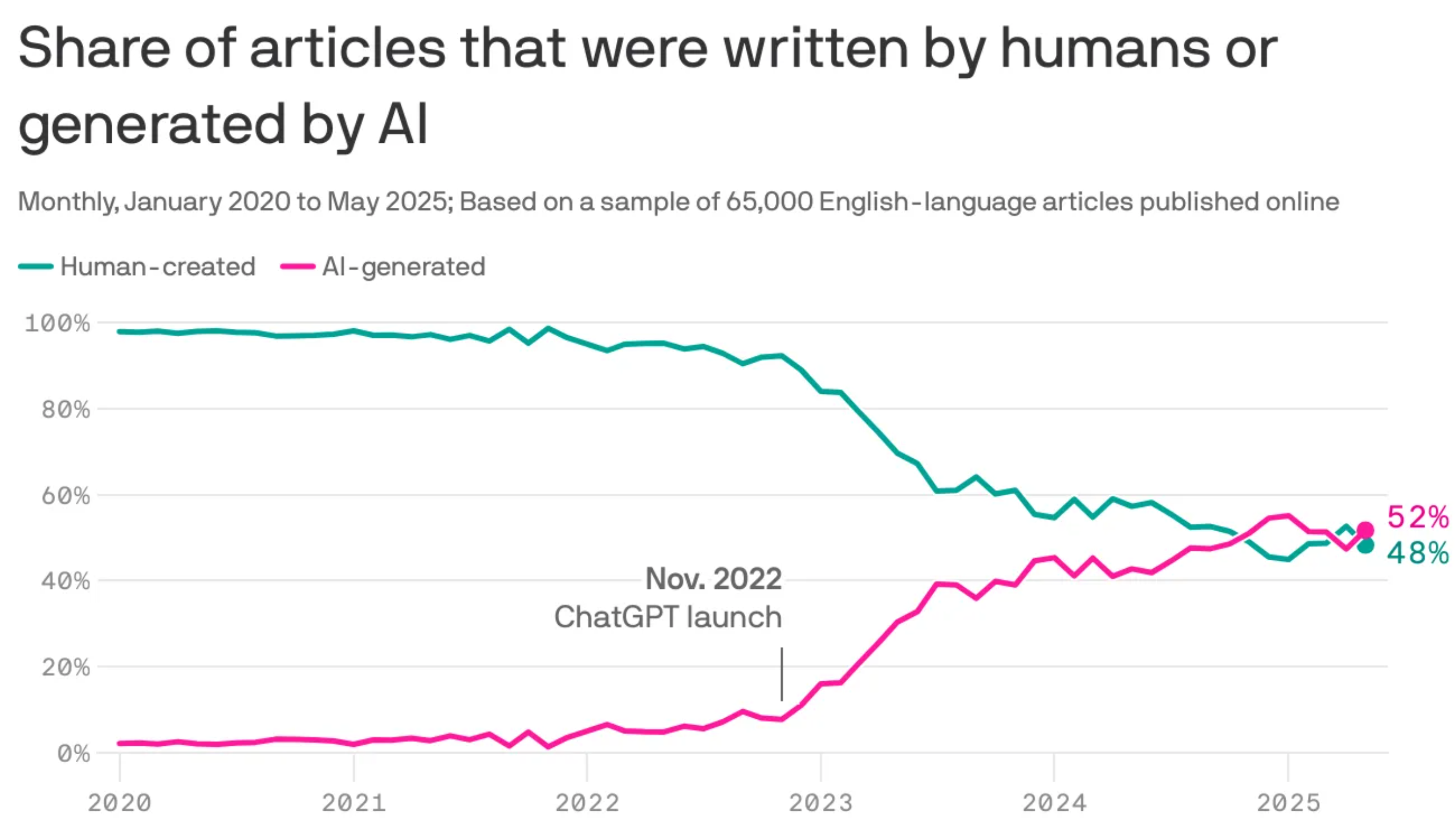

Mas agora, surgiu um gargalo. Não há dados suficientes. Nosso corpus de textos da internet, que contém dados de pré-treinamento, é limitado e está quase esgotado. Algumas instituições de pesquisa demonstraram estatisticamente que a proporção de conteúdo gerado por IA na internet já supera o conteúdo produzido por humanos.

Em segundo lugar, há o efeito marginal. Expandir o modelo 100 vezes pode melhorar as coisas, mas não trará uma mudança qualitativa.

Ilya também mencionou que, recentemente, no fórum X, algumas pessoas disseram que o Gemini 3 parece ter resolvido alguns problemas de pré-treinamento. Anteriormente, o The Information também noticiou que Altman estava preocupado com o impacto do desenvolvimento do Google na OpenAI, e que a empresa chegou a pressioná-lo.

Parte da razão é que o lançamento do GPT-5 enfrentou problemas com o pré-treinamento; ou seja, à medida que a quantidade de dados de pré-treinamento aumentava, o modelo não demonstrava a mesma melhoria na inteligência que antes. Em contrapartida, o Gemini encontrou um avanço. Altman afirmou em um memorando interno que a OpenAI também precisa resolver o problema do pré-treinamento para talvez superar o Google novamente.

▲ Oriol Vinyals, vice-presidente de pesquisa do Google DeepMind, mencionou que o segredo do Gemini 3 é resolver o problema do pré-treinamento.

Retornamos à era da pesquisa. Só que desta vez, temos computadores muito maiores.

Ilya divide sua pesquisa do último período em duas fases. O período de 2012 a 2020 foi a era da pesquisa, quando todos estavam experimentando e descobrindo novos métodos. O período de 2020 a 2025 é a era da expansão, quando todos estão se expandindo desenfreadamente, o poder computacional está aumentando e cada vez mais empresas de IA estão surgindo.

Agora, depender apenas da força bruta para realizar milagres não é mais viável, ou melhor, esgotamos os benefícios da escalabilidade. Retornamos à era da pesquisa. No entanto, desta vez, estamos usando os supercomputadores construídos durante a era da escalabilidade para conduzir pesquisas — uma era de pesquisa com enorme poder computacional.

Em resumo, Ilya não negou o enorme sucesso do pré-treinamento e da escalabilidade, mas acredita que essa é uma estética de baixo risco e força bruta, que troca dinheiro por inteligência, e que esse modelo já atingiu seu limite. A indústria de IA precisa retornar à fase de pesquisa fundamental, onde a competição se baseia em ideias, intuição e inovação.

Encontrando a intuição: a peça que faltava no quebra-cabeça da IA

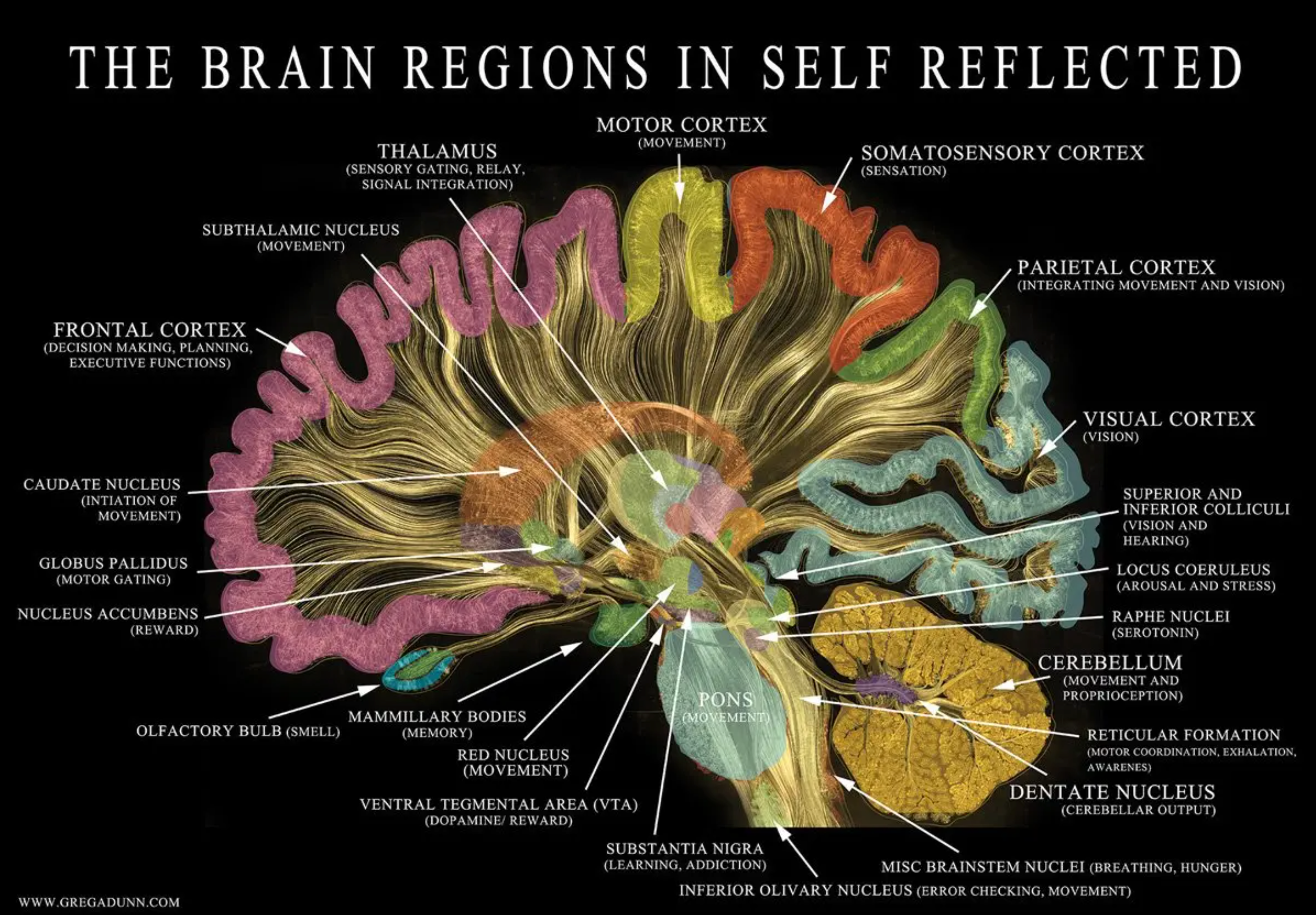

Se simplesmente acumular dados não produz verdadeira inteligência, qual é o segredo da humanidade? A resposta de Ilya é: Emoções .

Ele citou o caso de um paciente com lesão cerebral que havia perdido a capacidade emocional. Embora a pessoa tivesse inteligência normal e fosse eloquente, ela se angustiava por horas sobre qual par de meias usar. Isso ilustra que a emoção não é meramente um sentimento; é essencialmente uma função valorativa.

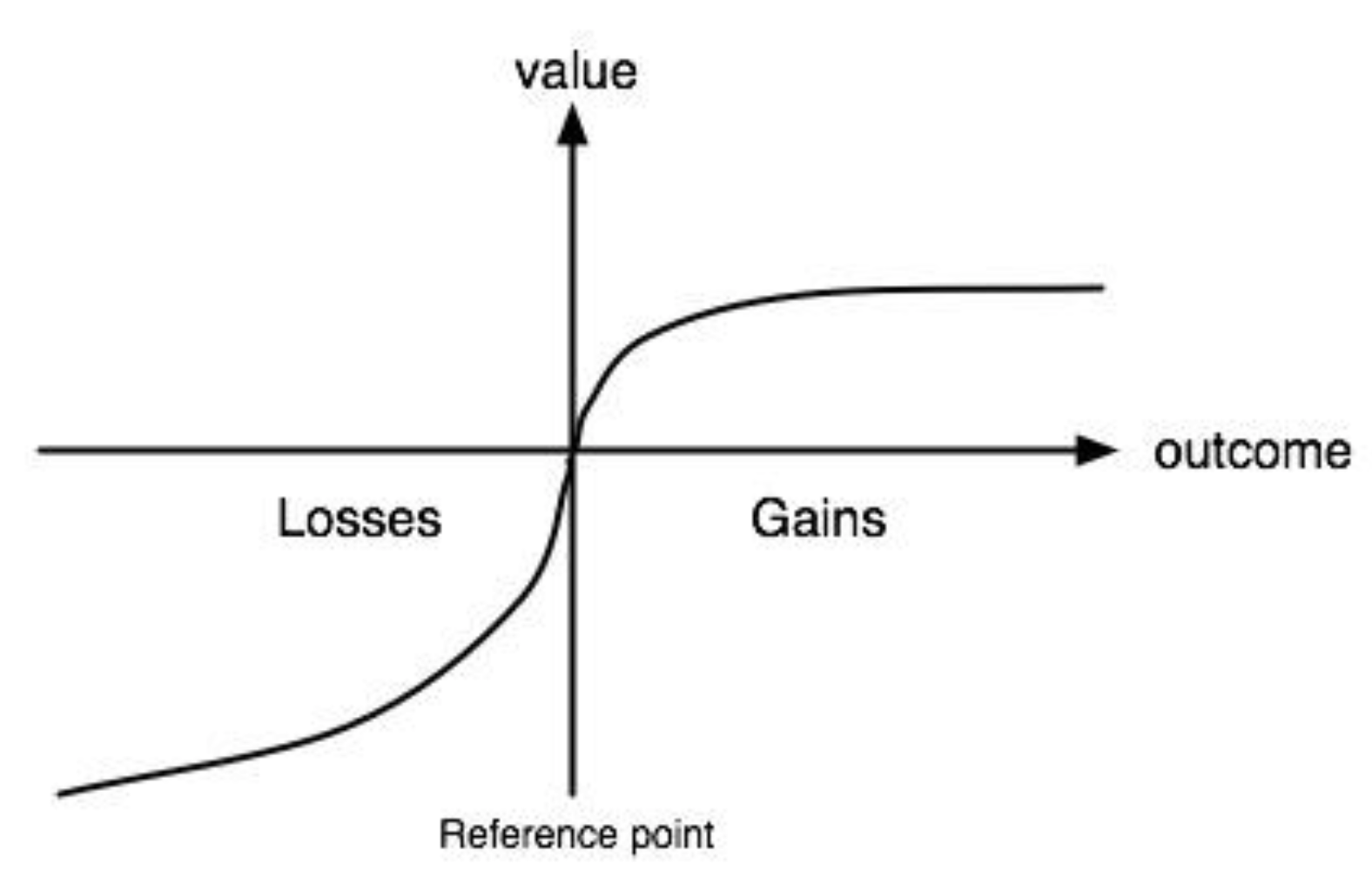

No entanto, Ilya afirmou que não encontrou um conceito adequado para analogizar o papel da emoção na aprendizagem de máquina, então utiliza uma função de valor como substituto.

Para explicar o que é uma função de valor, Ilya citou o exemplo de um adolescente aprendendo a dirigir. Um adolescente pode precisar de apenas 10 horas ou menos de prática para aprender a dirigir na rua. Ele não precisa bater milhões de vezes em simuladores como os atuais sistemas de direção autônoma com IA para aprender a evitar obstáculos.

Por quê? Porque os seres humanos possuem uma função de valor extremamente poderosa, que age como um avaliador inato. Quando nos desviamos do caminho, nós, humanos, sentimos ansiedade, o que equivale a um feedback negativo.

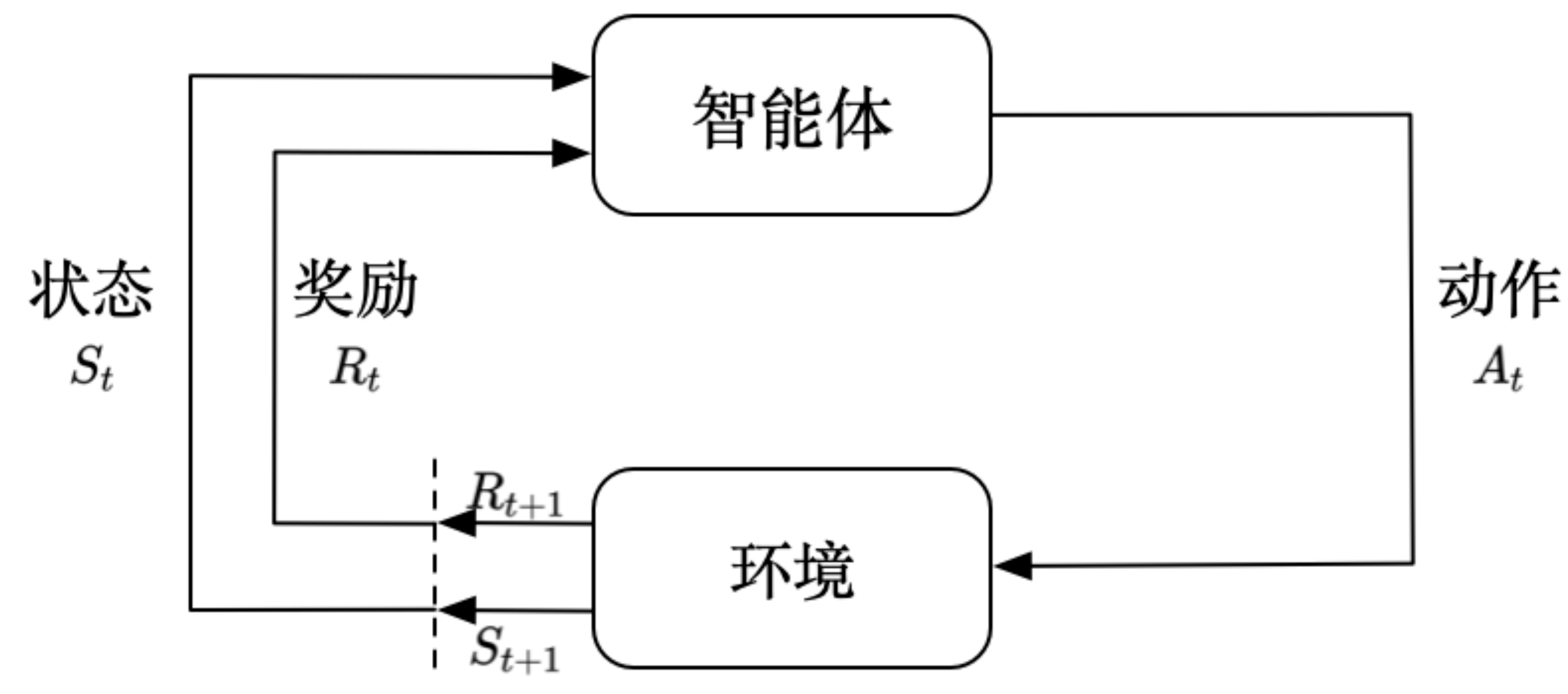

Qual é, então, a diferença entre a função de valor que se baseia em emoções e o aprendizado por reforço de que temos ouvido falar?

Ilya explica que, no aprendizado por reforço sem uma função de valor intermediária, a IA normalmente não sabe se ganhou ou perdeu até que a tarefa esteja completamente concluída; no entanto, uma função de valor é como nossa intuição ou sistema de classificação interno. Quando perdemos uma peça no xadrez, não precisamos esperar até o final da partida; imediatamente temos um estalo de percepção de que cometemos um erro.

O menino que estava aprendendo a dirigir não esperava até cruzar a linha e perder pontos para corrigir seu erro; em vez disso, ele imediatamente se sentia nervoso ou inseguro se saísse da faixa, mesmo que minimamente. Esse mecanismo de feedback interno em tempo real permitiu que ele aprendesse de forma extremamente eficiente a partir de uma experiência limitada.

Sua visão sobre o aprendizado por reforço tradicional é que se trata de uma abordagem ingênua e ineficiente. No aprendizado por reforço tradicional, o modelo precisa tentar milhares de ações ou processos de pensamento até produzir uma solução final e, em seguida, obter uma pontuação, ou seja, o sinal de treinamento, com base na qualidade desse resultado final.

Isso significa que o modelo não aprende nada antes de chegar à solução final. Esse método exige muitos recursos computacionais para deduções longas, mas a quantidade de aprendizado envolvida em cada dedução é relativamente pequena.

A função de valor não precisa esperar até o final; ela pode fornecer uma avaliação do processo intermediário. Ela emite sinais a cada passo, orientando a direção, comprimindo consideravelmente o espaço de busca e melhorando a velocidade de aprendizado.

A IA atual carece de um sistema de avaliação interna tão eficiente. Se pudermos dotar a IA de capacidades de julgamento de valor semelhantes às emoções ou instintos humanos, ela poderá libertar-se da sua dependência de quantidades massivas de dados e aprender verdadeiramente com a mesma eficiência que um ser humano.

O próximo passo de Ilya é acessar diretamente a superinteligência.

Uma vez que se determinou que a era de depender exclusivamente do poder computacional chegou ao fim, e que funções de valor poderosas podem se tornar a nova abordagem da IA, o que a nova empresa de Ilya, a SSI (Safe Superintelligence), planeja fazer?

Sua resposta apresenta um tom extremamente idealista, conduzindo diretamente à superinteligência. Eles optaram por abordar o problema mais fundamental e alcançar uma generalização confiável .

Ilya afirmou categoricamente que a atual indústria de IA está presa em uma corrida desenfreada. Para sobreviver à concorrência de mercado, as empresas são forçadas a lançar constantemente produtos inacabados e a fazer escolhas difíceis entre experiência do usuário e segurança. O que a SSI pretende é se desvencilhar desse ruído comercial, trabalhar de forma isolada e, eventualmente, criar uma verdadeira superinteligência.

Curiosamente, a ideia de Ilya sobre "treinamento recluso" começa a vacilar. Ele está começando a perceber que uma liberação gradual pode ser o único caminho seguro e necessário.

Por quê? Porque a imaginação humana é limitada. Se você simplesmente escrever artigos e publicar trabalhos dizendo que a IA será incrivelmente poderosa, as pessoas pensarão que é ficção científica. Somente quando as pessoas testemunharem em primeira mão a IA demonstrando algum poder perturbador é que todos, incluindo os concorrentes, sentirão medo de verdade e se tornarão mais conscientes da segurança.

Ilya prevê que, à medida que a IA se torna mais poderosa, as gigantes da tecnologia, atualmente envolvidas em uma competição acirrada, acabarão por convergir em estratégias de segurança de IA.

No podcast, ele também mencionou que, embora a SSI tenha recebido menos financiamento em comparação com grandes laboratórios como a OpenAI e o Google, ela possui mais poder computacional dedicado à pesquisa pura do que aparenta. Ele disse que essas grandes empresas alocam uma quantidade significativa de recursos computacionais para inferência de produtos e possuem grandes equipes de engenharia e vendas, resultando em uma dispersão de seus recursos. Ilya acredita que a SSI tem poder computacional suficiente para comprovar a veracidade de suas ideias.

Ao ser questionado sobre o modelo de lucro, Ilya simplesmente respondeu: "Nós nos concentramos apenas na pesquisa; a questão de gerar lucro virá naturalmente com o tempo." O apresentador também mencionou que o ex-CEO (cofundador) da SSI optou por sair e se juntar à Meta quando esta quis adquirir a SSI.

Ilya esclareceu especificamente: "Ele é o único que foi para Meta." Ele fundou a SSI não para lucrar com o mercado comercial, mas com um único e puro objetivo: criar uma superinteligência segura antes que essa singularidade irreversível chegue.

Redefinindo a Inteligência Artificial Geral (AGI), um menino de 15 anos

Quão longe estamos da Inteligência Artificial Geral (IAG)? Ilya prevê que será em 5 a 20 anos.

No entanto, ele nos alertou contra o termo "Inteligência Artificial Geral" (IAG). Modelos pré-treinados criam a ilusão de que a IAG é uma enciclopédia onisciente. Mas a visão de superinteligência de Ilya se assemelha mais à de um adolescente excepcionalmente brilhante de 15 anos.

Este jovem pode ainda não ter estudado direito ou medicina, mas possui uma capacidade de aprendizagem extraordinária. Se lhe fosse permitido estudar medicina, provavelmente conseguiria ler toda a literatura médica da humanidade em apenas alguns dias e começar a realizar cirurgias.

O conceito mais arrepiante nessa visão é a fusão.

A tragédia da humanidade reside no fato de que o conhecimento não pode ser copiado diretamente. Uma pessoa aprende a dirigir, mas outra ainda precisa aprender tudo do zero. A IA, no entanto, é diferente. Ilya descreve um cenário onde milhões de avatares de IA trabalham em diferentes setores da economia, alguns escrevendo código, outros lidando com processos judiciais. Eles aprendem de forma independente e, em seguida, integram todas as suas experiências em um único cérebro.

Essa velocidade de evolução coletiva é o que ele considera Inteligência Artificial Geral (IAG).

Diante de um supercérebro capaz de integrar instantaneamente milhares de experiências, para onde a humanidade deve ir a partir daqui?

Ilya propõe dois níveis de reflexão. Primeiro, o design da IA. Não a limite a amar apenas humanos, pois isso é muito restrito. As IAs do futuro também serão seres sencientes; devemos utilizar o princípio da empatia para que se importem com toda a vida senciente — potencialmente uma medida de segurança mais robusta do que o código.

Em segundo lugar, há o plano B da humanidade. Se todos tivessem um agente de IA cem vezes mais inteligente do que eles próprios, a humanidade se tornaria uma mera espectadora na história? Ilya ofereceu uma resposta que ele admitiu francamente que "não gostava, mas que poderia ser a única solução": interfaces cérebro-computador (Neuralink).

Somente quando a humanidade optar por se fundir com a IA, permitindo que a compreensão da IA se torne diretamente a nossa compreensão, poderemos continuar sendo os protagonistas deste mundo após essa singularidade.

Ao final do podcast, Dwarkesh fez a pergunta que todos queriam fazer: Como uma lenda na área de IA, como você conseguiu acertar tantas vezes?

A resposta de Ilya foi como a de um artista: "Em busca da beleza".

Naqueles momentos mais sombrios, quando nenhum dado lhe dá apoio, apenas uma crença inabalável na beleza, na simplicidade e na lógica biológica pode sustentá-lo. Porque as redes neurais imitam o cérebro, e o cérebro é belo, esse deve ser o caminho certo para a inteligência.

Essa é talvez a qualidade que Ilya considera mais necessária na "era da pesquisa": além do poder computacional, manter uma intuição poética sobre a essência da inteligência.

#Siga a conta oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde você encontrará conteúdo ainda mais interessante o mais breve possível.