Gastando US$ 10 bilhões para construir, qual é a força do chip de IA mais poderoso da história?

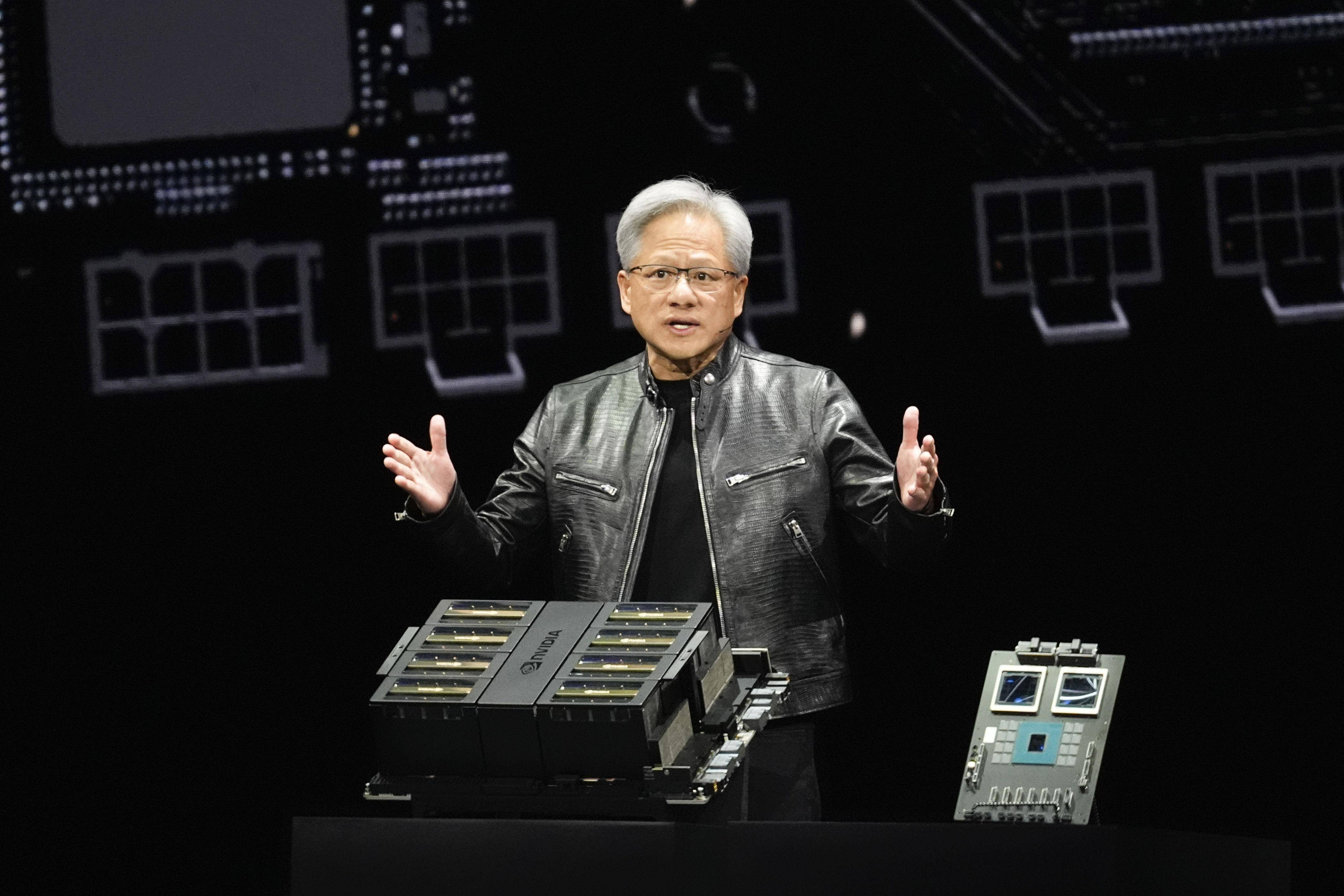

Nos últimos dois dias, revisamos mais uma vez o discurso de Huang Renxun no GTC 2024. Quando conduzimos uma análise e interpretação mais profunda do produto, descobrimos alguns destaques que havíamos perdido enquanto ficávamos acordados até tarde.

Em primeiro lugar, o estilo de discurso de Huang é bem-humorado, natural e muito comunicativo. Não é de admirar que ele consiga transformar uma conferência de lançamento de produtos tecnológicos num concerto.

A segunda é revisar a arquitetura Blackwell e a série de GPUs recém-lançadas em combinação com as gerações anteriores de produtos. Só posso dizer que seu desempenho computacional, custo e desempenho futuro estão muito além da minha imaginação.

Assim como o nome NVIDIA, as duas primeiras letras N e V de NVIDIA representam a Próxima Versão “próxima geração”.

Como o GTC nos anos anteriores, a Nvidia lançou a próxima geração de produtos conforme programado, com maior desempenho e melhor desempenho; mas é completamente diferente de antes, porque a Blackwell representa não apenas a próxima geração de produtos, mas também a próxima era.

Redescubra a GPU mais poderosa do planeta

A autoapresentação geralmente começa com seu nome, então vamos começar aqui com o chip de IA mais recente e poderoso.

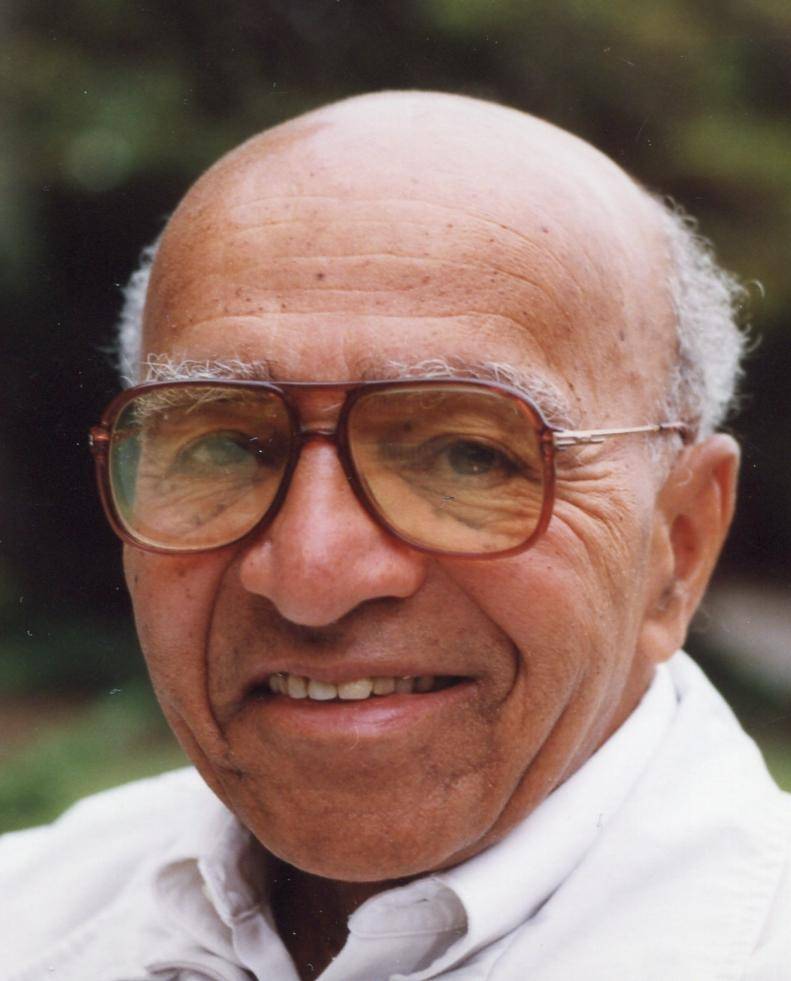

O nome completo de Blackwell é David Harold Blackwell.Ele é um estatístico americano e um dos proponentes do teorema de Rao-Blackwell. Mais importante ainda, ele foi o primeiro membro negro da Academia Nacional de Ciências e o primeiro membro negro efetivo do corpo docente da Universidade da Califórnia, Berkeley.

Daí vem o "Blackwell" lançado no GTC 2024. Não é que o próprio Blackwell tenha feito contribuições notáveis à NVIDIA, mas que no sistema de nomenclatura da NVIDIA são usados os nomes de alguns cientistas (ou matemáticos) famosos da história. tornou-se uma convenção nomear microarquiteturas GPU por seus nomes.

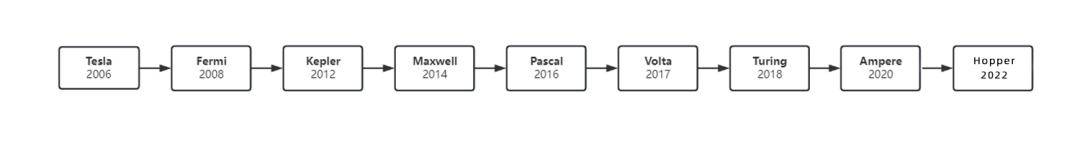

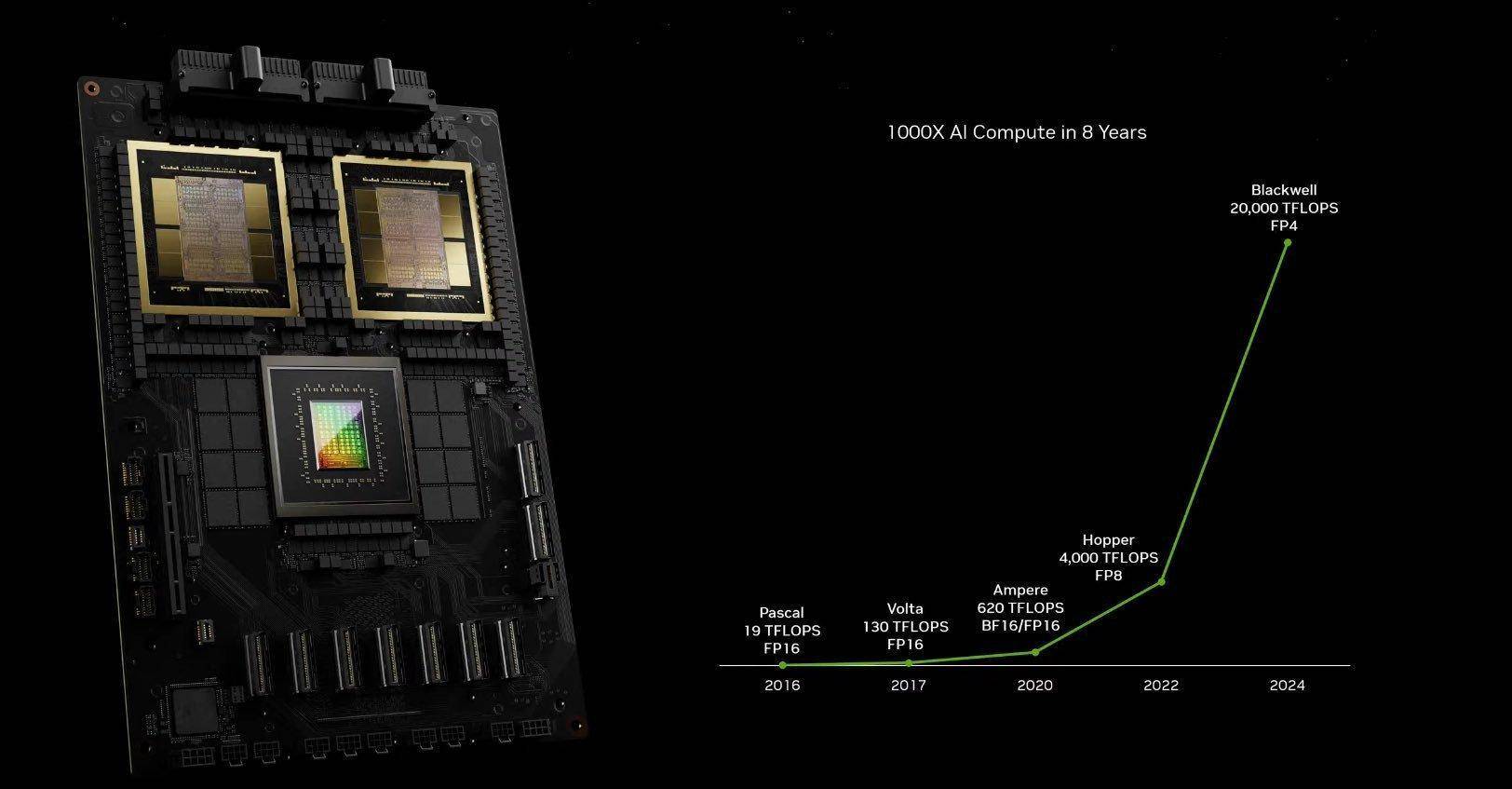

Desde 2006, a NVIDIA lançou sucessivamente as arquiteturas Tesla, Fermi, Kepler, Maxwel, Pascal, Volta, Turing e Ampere, correspondendo a Tesla, Fermi, Kepler, Maxwell, Pascal, Volta, Turing, Ampere e esses líderes acadêmicos.

Uma é que é famoso e a outra é que possui materiais. Quanto a corresponder ao produto designado individualmente, na verdade não é uma correlação tão forte.

Deve-se enfatizar aqui que os objetos nomeados acima não são chips individuais, mas referem-se a toda a arquitetura da GPU (Huang Renxun a chama de plataforma).

Arquitetura de chip refere-se ao design básico e estrutura organizacional do chip. Diferentes arquiteturas determinam o desempenho, a eficiência energética, o poder de processamento e a compatibilidade do chip, e também afetam o método de execução e a eficiência dos aplicativos.

Simplificando, você agora possui um estádio (matéria-prima para fazer chips) e planeja transformá-lo completamente. Se o terreno será usado para shows ou jogos esportivos (a finalidade do chip) determina o layout do local, contratação de pessoal, decoração e forma de anúncio (arquitetura de chip).

Portanto, a arquitetura e o design do chip estão inter-relacionados e determinam em conjunto o desempenho do chip.

Por exemplo, x86 e ARM, que são frequentemente ouvidos, são duas arquiteturas convencionais projetadas para CPUs. A primeira tem desempenho poderoso e a segunda tem excelente controle de consumo de energia. Cada uma tem seus próprios pontos fortes.

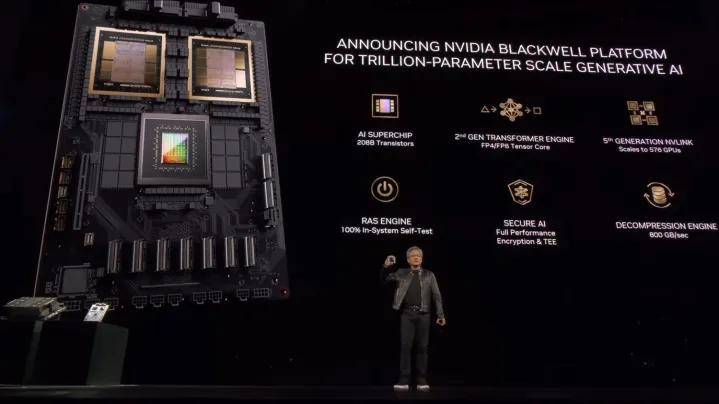

Construídos com base em múltiplas gerações de tecnologia NVIDIA, os chips B200 e B100 da arquitetura Blackwell apresentam excelente desempenho, eficiência e escala, e também abrem um novo capítulo para AIGC.

Mas por que é chamada de “bomba nuclear de IA”? Quão poderosa é a nova GPU? Comparado com o produto da geração anterior, teremos uma sensação mais intuitiva.

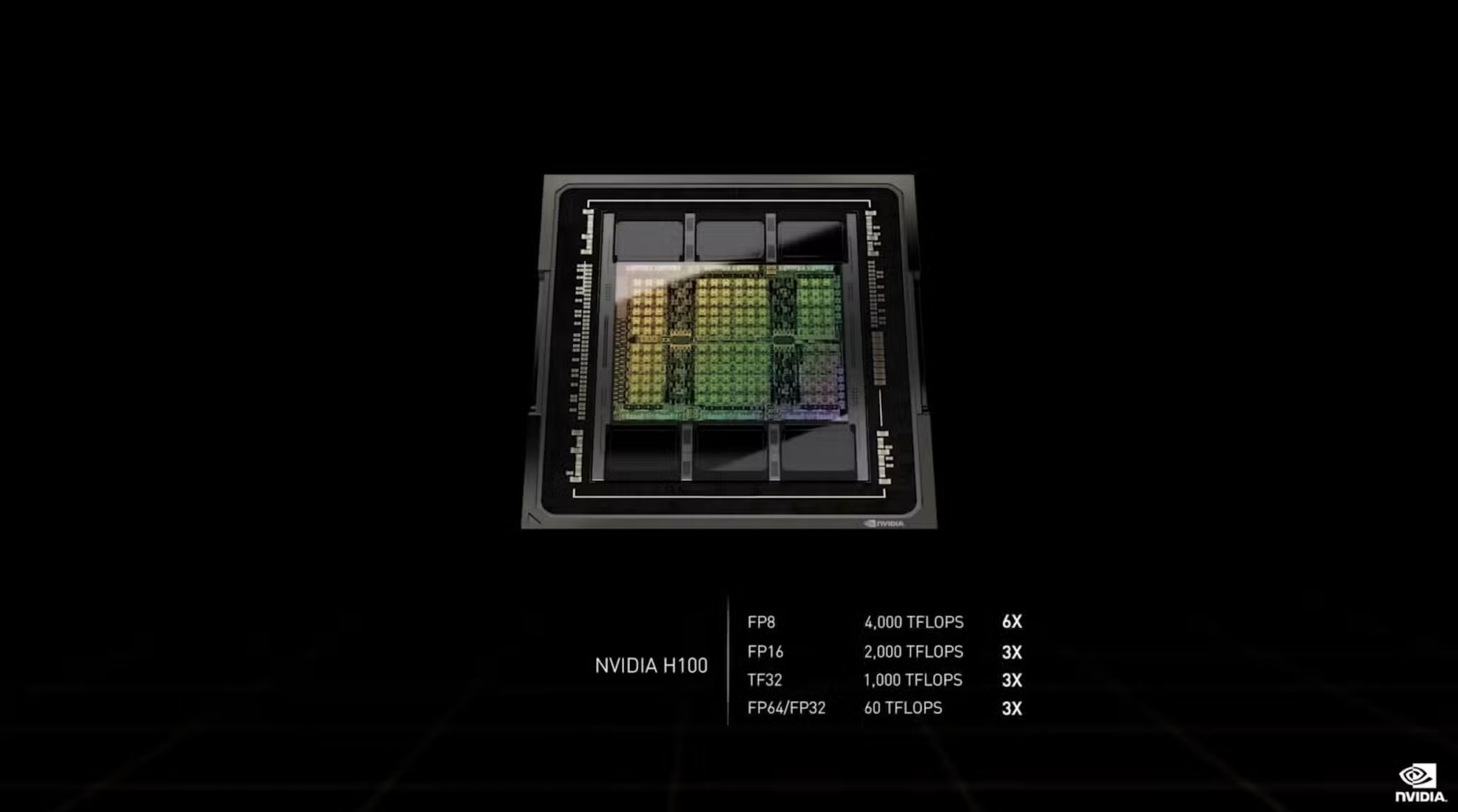

No GTC 2022, Huang Renxun lançou uma nova arquitetura Hopper e um novo chip H100:

1. É fabricado usando o processo de 4 nm da TSMC e integra 80 bilhões de transistores, o que representa 26 bilhões a mais que a geração anterior A100.

2. O desempenho FP16, TF32 e FP64 do H100 é 3 vezes maior que o do A100, que são 2.000 TFLOPS, 1.000 TFLOPS e 60 TFLOPS respectivamente. Leva apenas 1 dia para treinar um modelo grande com 395 bilhões de parâmetros. Nas palavras originais de Lao Huang, “20 as imagens podem transportar os dados do mundo”tráfego da Internet”.

3. O lançamento do H100 elevou o valor de mercado da NVIDIA para mais de US$ 2 trilhões, tornando-a a terceira maior empresa de tecnologia depois da Microsoft e da Apple.

De acordo com a análise estatística da empresa de monitoramento de mercado Omdia, a Nvidia vendeu aproximadamente 500.000 GPUs H100 e A100 no terceiro trimestre do ano passado, e o peso total dessas placas gráficas foi de quase 1.000 toneladas.

Até agora, o Hopper H100 ainda é a GPU mais poderosa à venda, por uma ampla margem.

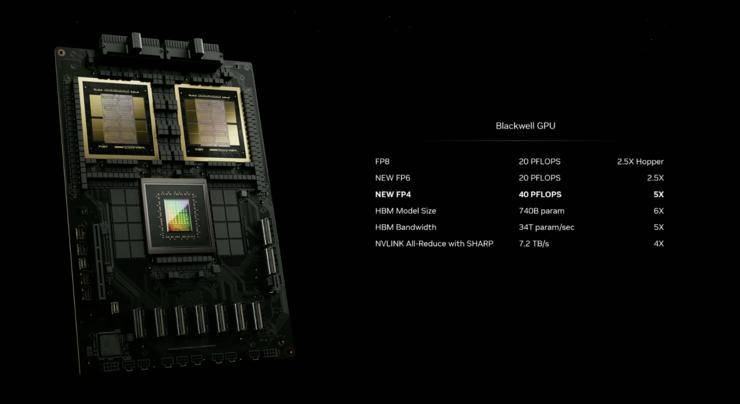

O Blackwell B200 estabeleceu mais uma vez um novo recorde de “mais forte”, com melhorias de desempenho muito além das iterações de produtos convencionais.

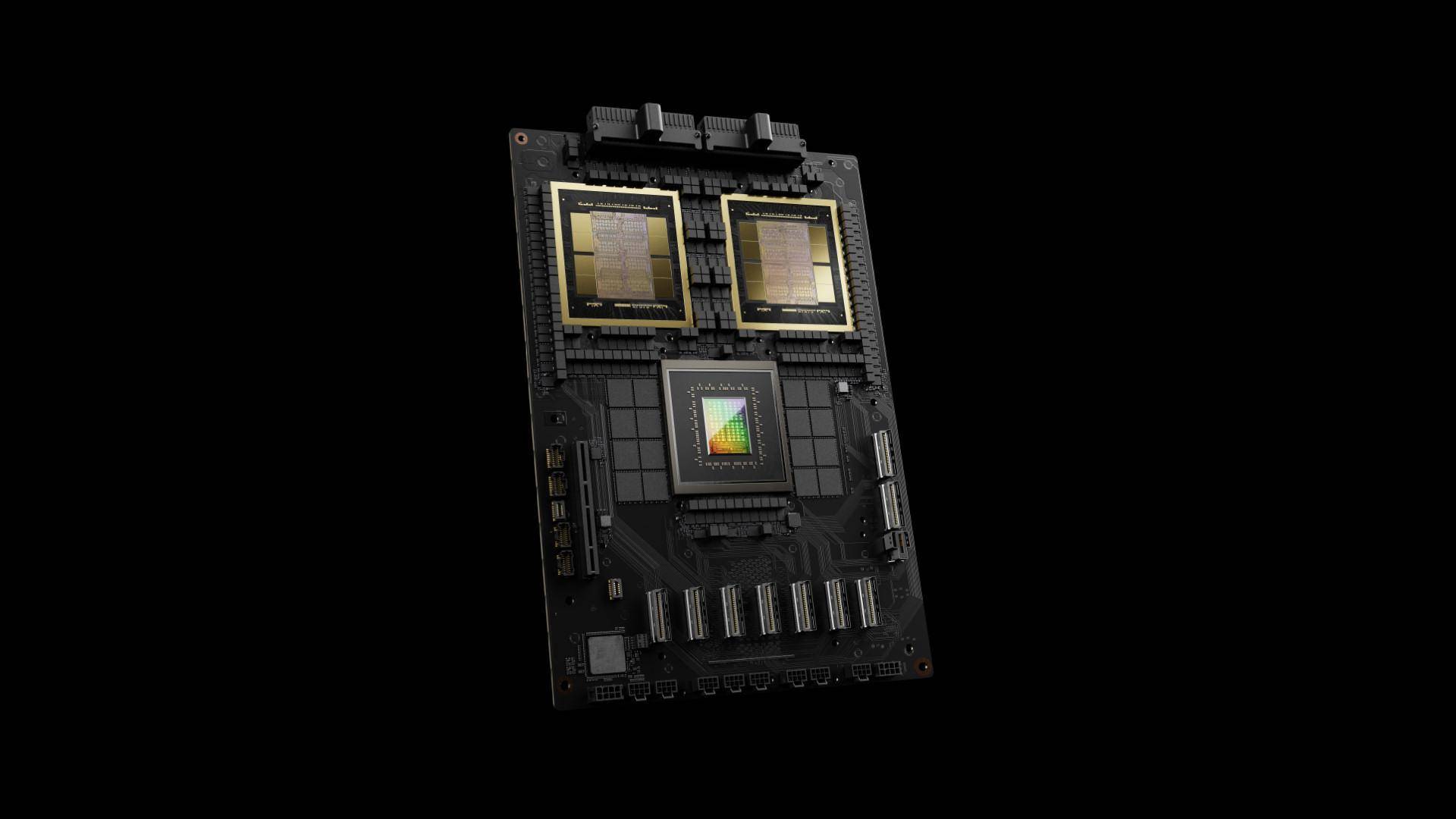

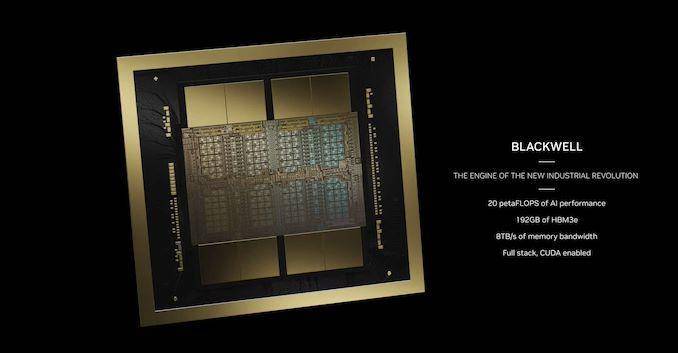

Do ponto de vista da tecnologia de processo, a GPU B200 usa o processo TSMC 4nm de segunda geração, usando wafers nus com o dobro do tamanho limite da fotolitografia, e é conectada por meio de tecnologia de interconexão entre chips de 10 TB/s para formar uma GPU unificada, com um total de 208 bilhões de transistores (um único chip equivale a 104 bilhões), em comparação com a tecnologia N4 usada para fazer o Hopper H100, o desempenho é melhorado em 6%. , o desempenho geral é melhorado em cerca de 250%.

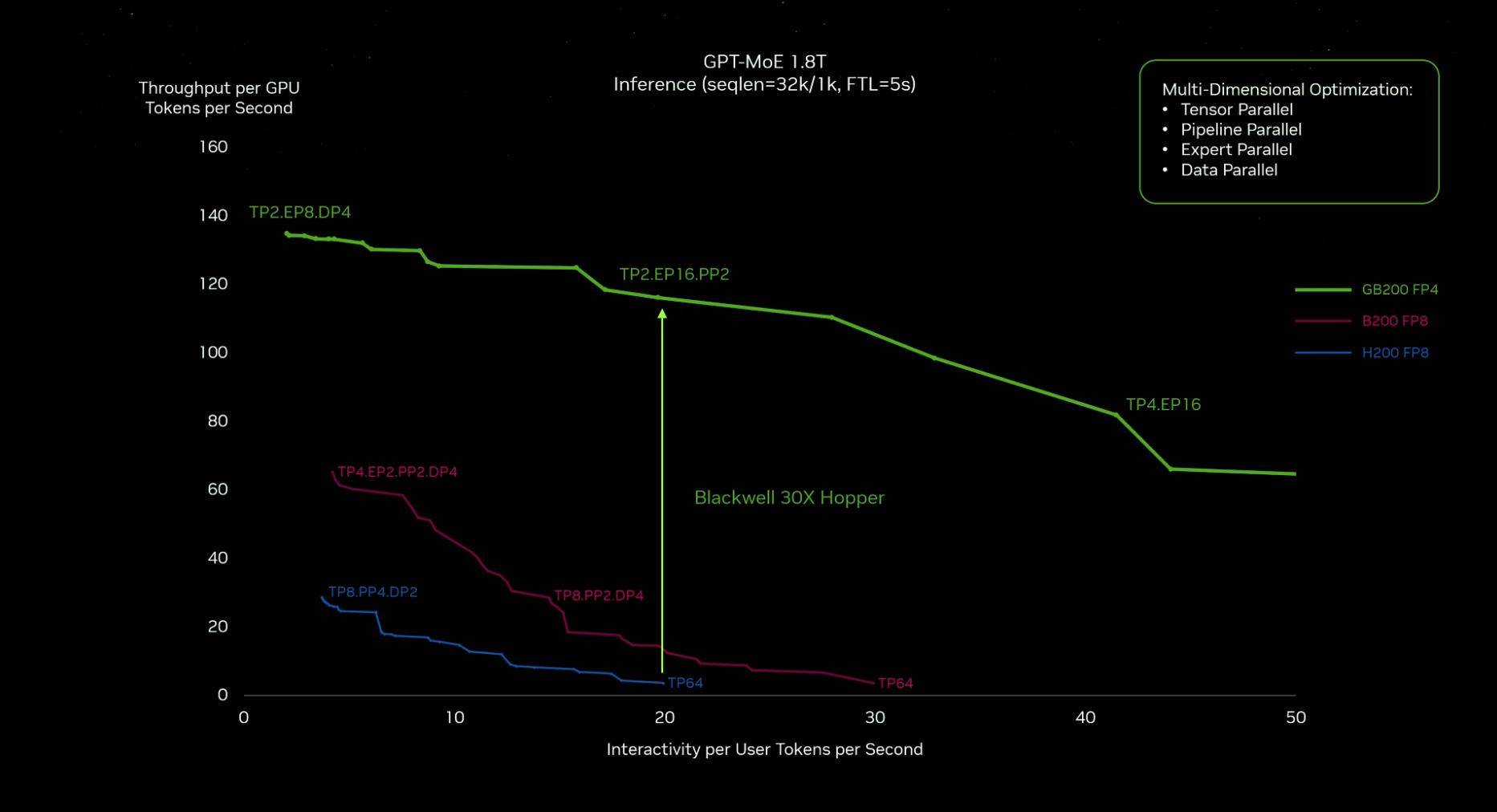

Em termos de desempenho, o motor Transformer de segunda geração permite que a Blackwell suporte o dobro das capacidades de cálculo e raciocínio do tamanho do modelo através da nova IA de ponto flutuante de 4 bits. O desempenho da IA de chip único é tão alto quanto 20 PetaFLOPS (pode executar 20× 10 ^ 15 flutua por segundo) Operação pontual), que é 4 vezes maior que a geração anterior Hopper H100, e o desempenho de inferência de IA é 30 vezes maior que a geração anterior.

Do ponto de vista do controle do consumo de energia, no passado, o treinamento de um modelo de 1,8 trilhão de parâmetros exigia 8.000 GPUs Hopper e 15 megawatts de potência. Agora, 2.000 GPUs Blackwell podem fazer isso, e o consumo de energia é de apenas 4 megawatts, reduzindo diretamente 96%.

Portanto, a afirmação de Huang Renxun de que “Blackwell se tornará o chip mais poderoso do mundo” não é apenas uma mentira, mas se tornou um fato.

Não é barato, não é simples de usar

Analistas da empresa de serviços financeiros Raymond James estimaram o custo do B200.

O custo de fabricação de cada H100 da Nvidia é de cerca de US$ 3.320, e o preço está entre US$ 25.000 e US$ 30.000. Com base na diferença de desempenho entre os dois, estima-se que o custo do B200 será 50% a 60% maior que o do H100, que custa cerca de US$ 6.000.

Em entrevista exclusiva à CNBC após a coletiva de imprensa, Huang Renxun revelou que o preço da GPU Blackwell é de cerca de US$ 30.000 a US$ 40.000, e a pesquisa e desenvolvimento de toda a nova arquitetura custou aproximadamente US$ 10 bilhões.

Tivemos que inventar alguma nova tecnologia para tornar isso (a nova arquitetura) possível.

De acordo com o ritmo anterior, a Nvidia lançará uma nova geração de chips de IA aproximadamente a cada dois anos. Em comparação com as gerações anteriores de produtos, o Blackwell mais recente melhorou significativamente o desempenho da computação e o controle do consumo de energia. De forma mais intuitiva, ele combina os dois GPU Blackwell é quase duas vezes maior que o Hooper.

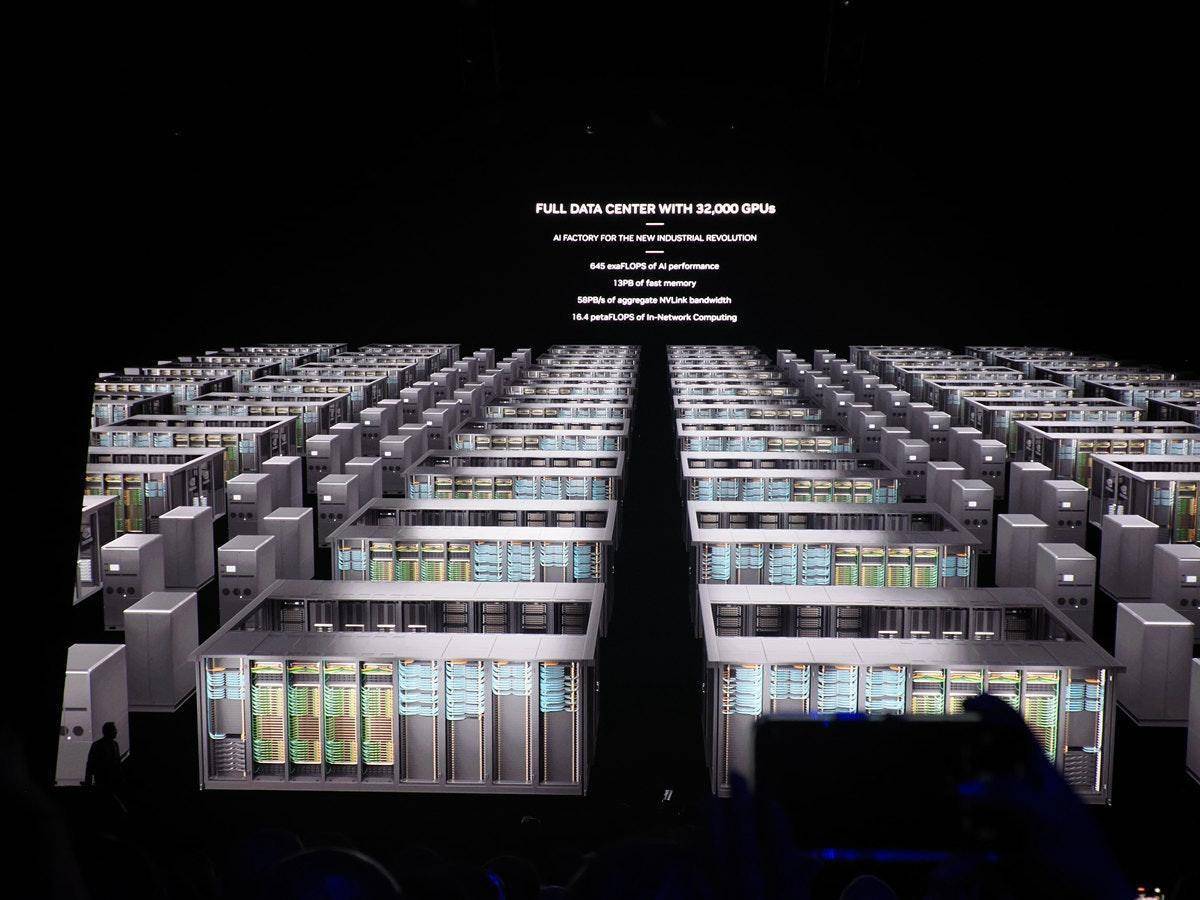

O alto custo não está apenas relacionado aos chips, mas também ao projeto de data centers e à integração em data centers de outras empresas, porque na visão de Huang Renxun, a Nvidia não fabrica chips, mas está construindo data centers.

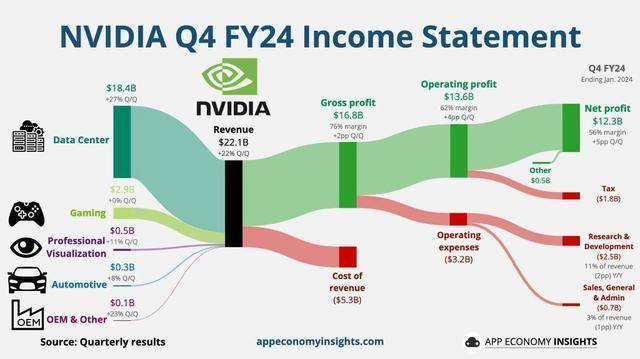

De acordo com o último relatório financeiro da Nvidia, a receita do quarto trimestre atingiu um recorde de US$ 22,1 bilhões, um aumento anual de 265%. O lucro líquido no quarto trimestre foi de US$ 12,3 bilhões, um aumento anual de 765%.

O segmento de data centers, a maior fonte de receita, atingiu um recorde de US$ 18,4 bilhões, um aumento de 27% em relação ao terceiro trimestre e um aumento de 409% em relação ao mesmo período do ano passado.

Os custos de I&D são elevados, mas os retornos positivos são mais elevados.

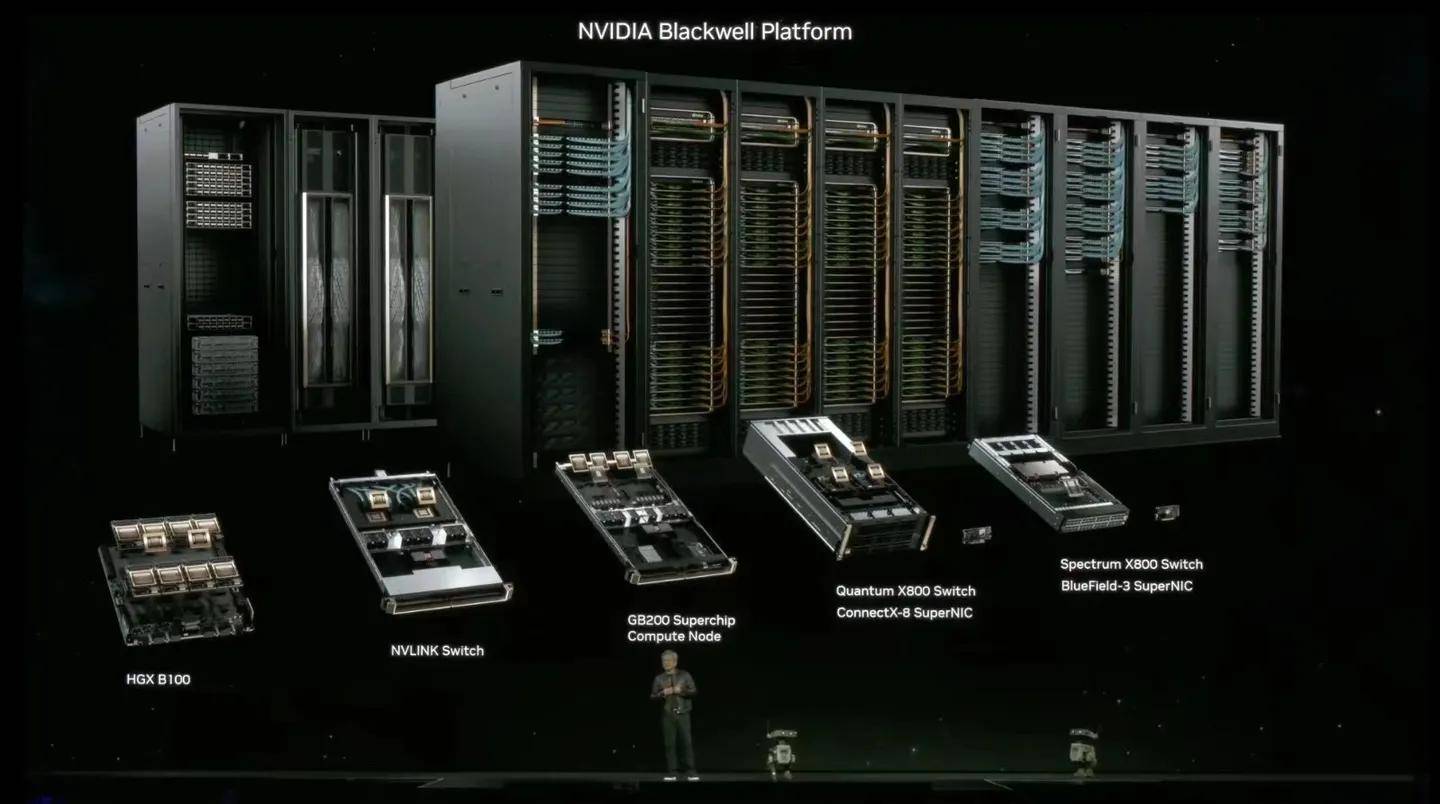

O data center que a NVIDIA está construindo atualmente inclui um sistema full-stack e todo o software. É um sistema completo. Blackwell ou GPU é apenas uma parte dele.

O data center é decomposto em vários módulos. Os usuários podem escolher livremente os serviços de software e hardware correspondentes de acordo com suas próprias necessidades. A NVIDIA ajustará a rede, o armazenamento, a plataforma de controle, a segurança e o gerenciamento de acordo com os diferentes requisitos e possui uma equipe dedicada. para fornecer suporte tecnológico.

Quer essa visão global e serviços personalizados sejam bons ou não, os dados podem dizer tudo: em 5 de março, o valor de mercado da Nvidia ultrapassou gigantes como Alphabet e Amazon, e ultrapassou a Saudi Aramco para se tornar a terceira maior empresa do mundo, perdendo apenas para Os dois grandes gigantes da tecnologia, Microsoft e Apple, têm um valor de mercado combinado de US$ 2,4 trilhões.

Atualmente, o mercado global de data centers é de aproximadamente 200 bilhões de euros (aproximadamente RMB 787,3 bilhões), e a NVIDIA faz parte dele. Huang Renxun prevê que este mercado provavelmente crescerá para US$ 1-2 trilhões no futuro.

Análise do CFO Kress da Nvidia:

A receita do data center no quarto trimestre fiscal foi impulsionada principalmente pela IA generativa e pelo treinamento relacionado. Estimamos que aproximadamente 40% da receita do data center no ano passado foi derivada da IA.

Há menos de um mês, Huang Renxun também declarou no relatório financeiro

A computação acelerada e a IA generativa atingiram um ponto de viragem, com a procura a aumentar em empresas, indústrias e países em todo o mundo.

Na verdade, a personalização não é exclusiva da NVIDIA, mas na era da IA, restam poucas empresas que podem fornecer serviços “da cabeça aos pés”, e a NVIDIA é uma delas.

Para os porcos decolarem, eles devem primeiro estar no vento

Na intersecção da realidade virtual, da computação de alto desempenho e da inteligência artificial, as GPUs estão até substituindo as CPUs como cérebros dos computadores de IA.

A principal razão pela qual a IA generativa tem despertado discussões acaloradas em vários setores é que ela começa a trabalhar e aprender como um “humano”, desde conversar, escrever textos, desenhar imagens, fazer vídeos, até analisar condições, pesquisar e resumir… tudo dos quais são emocionantes. Resultados surpreendentes requerem quantidades astronômicas de dados de amostra para apoiá-los.

Por exemplo, se você consegue se lembrar do nome "Ai Fan'er", pode ser porque as informações divulgadas diariamente pela conta pública fortaleceram sua memória ao repeti-las; também pode ser porque você nunca viu a combinação de " Ai" e "Fan'er" antes, o que é uma novidade. O sentido disso deixa uma impressão profunda em você; ou talvez o logotipo laranja deixe um símbolo visual único em sua mente.

Cada pequeno detalhe consolida a imagem de “Faner” em sua mente, mas quando as informações da mídia tecnológica nacional são misturadas, mais símbolos são necessários para aprofundar a impressão e evitar confusão.

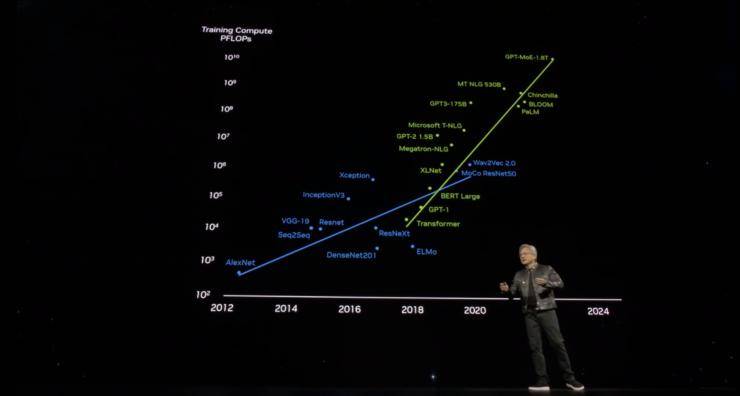

O aprendizado profundo da IA provavelmente segue essa lógica, e a GPU é a melhor escolha para processar grandes quantidades de informações.

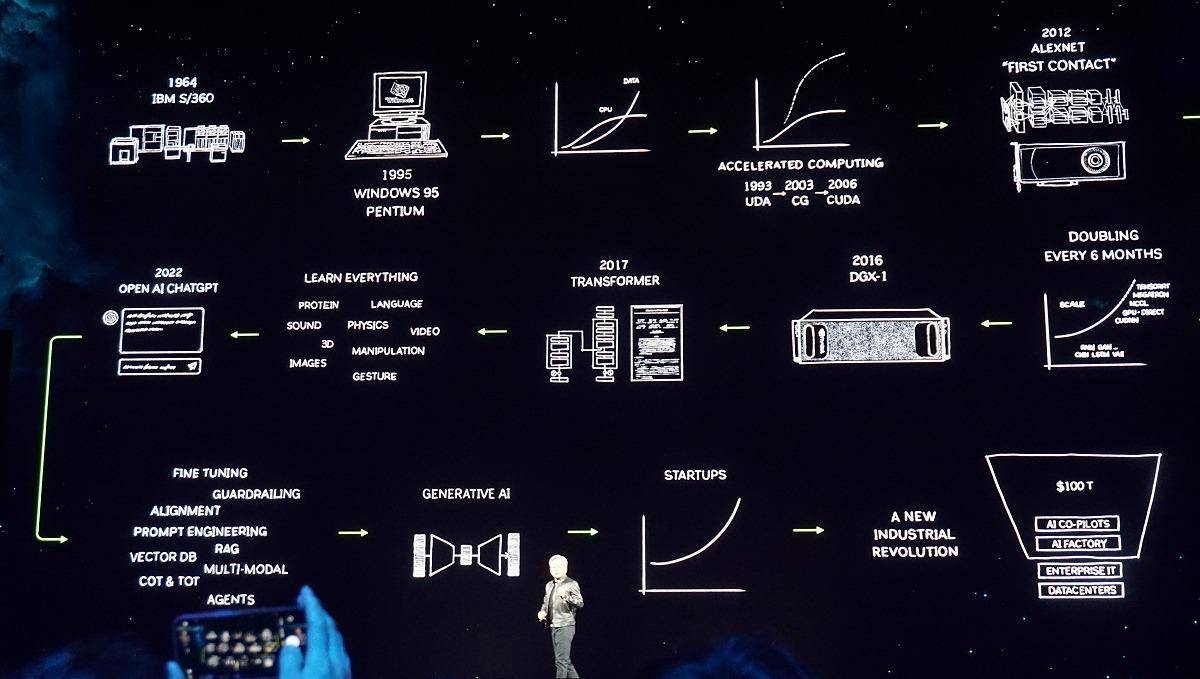

Desde que a OpenAI iniciou o AIGC, as empresas mais conhecidas começaram a colocar rapidamente seus próprios modelos grandes e pequenos nas prateleiras. Carros inteligentes, software de tradução, documentos eletrônicos, assistentes móveis e até mesmo robôs de varredura, todos possuem IA.

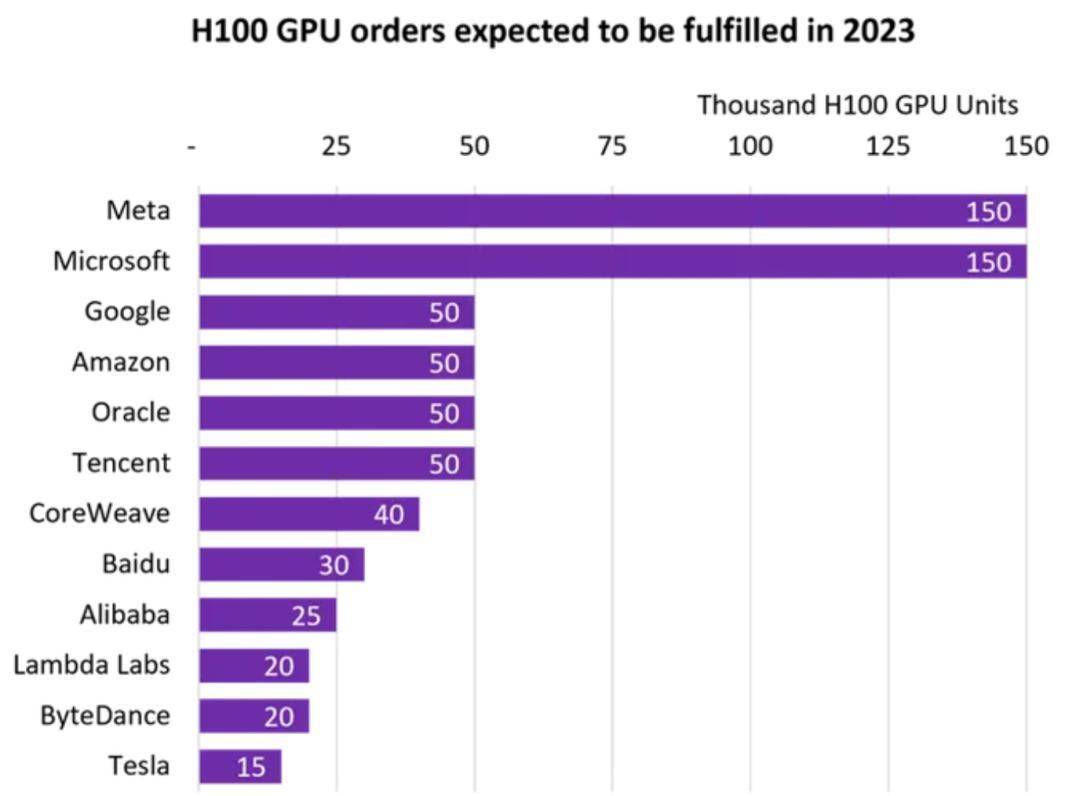

As GPUs se tornaram objeto de competição global aparentemente da noite para o dia. De acordo com estatísticas da empresa de monitoramento de mercado Omdia, Tencent, Alibaba, Baidu, ByteDance, Tesla, Meta e Microsoft compraram cada uma 150.000 unidades de GPU H100 (o chip mais poderoso do ano passado).

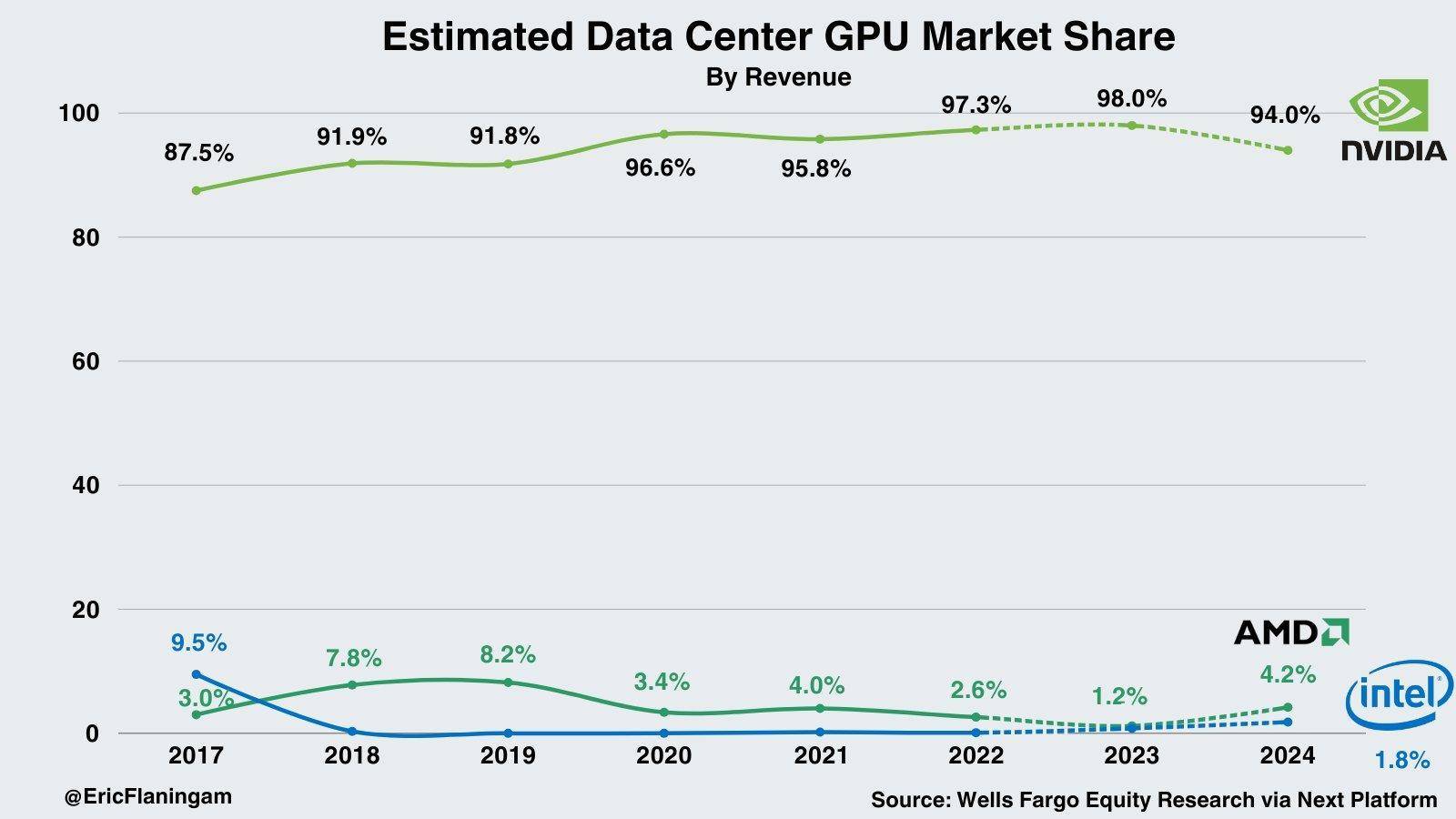

Os princípios técnicos e os antecedentes da época promoveram conjuntamente a explosão das GPUs e criaram o “império das placas gráficas” pertencente à Nvidia. De acordo com estatísticas do Wells Fargo, a Nvidia tem atualmente 98% de participação de mercado no mercado de IA de data center.

Parado na saída do vento, até um porco pode voar.

Mas quando a participação de uma empresa num setor está próxima de 100%, deve haver uma razão por trás disso que seja tão importante quanto estar na vanguarda.

Em 1999, a NVIDIA assumiu a liderança na proposta do conceito de GPU e lançou o CUDA em 2006. Este foi um importante ponto de viragem tecnológica na história do desenvolvimento da NVIDIA. Ele reduziu o limite de aplicação da GPU. Os desenvolvedores podem usar C/C++ e outros linguagens para construir na GPU. Ao escrever programas, a GPU rompeu com o único propósito de processamento de imagens e a computação de alto desempenho entrou no mundo das placas gráficas.

A vitória do AlphaGo em 2016, o aumento do Bitcoin em 2017 e o boom da mineração, nesse período apostamos no mercado de direção autônoma. Até o advento de grandes modelos de IA como o ChatGPT em 2023, a NVIDIA inaugurou um momento de colheita para as sementes que plantou há muitos anos.

A saída é importante, mas a configuração do mercado virada para o futuro, as áreas de aplicação diversificadas, o investimento maciço e a inovação, qualquer ligação que esteja fora do lugar não criará o mito actual do mercado de resultados próximos da perfeição.

No entanto, para a Nvidia, como manter a sua posição de liderança na encruzilhada dos tempos é a questão mais importante.

A Blackwell é um passo fundamental na consolidação dos resultados: antes de muitos fabricantes receberem o H100 encomendado, as linhas de montagem do B200 e do B100 já começaram.

Em seu discurso, Huang Renxun reiterou o que afirmou em relatórios financeiros anteriores de que "a computação de uso geral atingiu um gargalo".

Portanto, agora precisamos de modelos maiores, precisamos de GPUs maiores e precisamos empilhar GPUs juntas.

Não se trata de reduzir custos, mas de aumentar a escala.

Há alguma humildade nisso, mas é claro que também há uma enorme demanda no mercado.

Atualmente, o maior modelo da OpenAI já possui parâmetros de 1,8T (trilhões) e precisa lidar com bilhões de tokens (strings), mesmo com uma GPU de nível PetaFLOP (petaflops), o treinamento de um modelo tão grande requer 1.000 anos para ser concluído.

Hopper é ótimo, mas precisamos de uma GPU mais poderosa.

A primeira onda de discussão trazida pelo GTC 2024 desapareceu lentamente nos últimos dias. É previsível que a série de GPUs Blackwell, NVLink de quinta geração e motores RAS na conferência tragam mais quando chegarem ao mercado. Chocante ; é difícil prever quantas surpresas e mudanças “o ponto de inflexão que a IA generativa atingiu” trará ao mundo?

No momento em que o AIGC irrompe e às vésperas da chegada do AGI, a série de fogos de artifício de IA disparados pela Nvidia explodiu apenas pela primeira vez.

# Bem-vindo a seguir a conta pública oficial do WeChat de aifaner: aifaner (WeChat ID: ifanr).Mais conteúdo interessante será fornecido a você o mais rápido possível.