Forçada a utilizar o GPT-5.2 em uma emergência, como a Gemini 3 conseguiu reverter a situação? O arquiteto-chefe de IA do Google revela os segredos pela primeira vez.

"Essa é realmente uma grande história de superação."

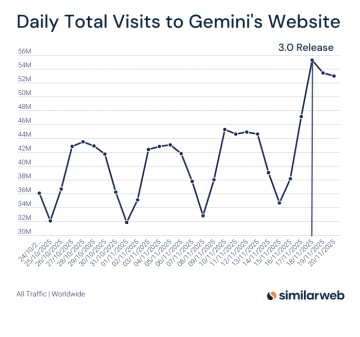

O lançamento da Gemini 3 nas primeiras horas do dia 19 de novembro quebrou a tranquilidade habitual. No dia do lançamento, a plataforma obteve mais de 54 milhões de visitas em todo o mundo, estabelecendo um novo recorde.

O retorno triunfal do Google causou ondas de choque até mesmo em seus concorrentes. De acordo com o The Information, diante da ofensiva implacável do Google, o CEO da OpenAI, Sam Altman, anunciou com urgência em um memorando interno nesta segunda-feira que a empresa havia entrado em "modo de alerta máximo", preparando-se para mobilizar todos os recursos estratégicos para aprimorar significativamente as capacidades do ChatGPT.

Segundo o The Verge, citando fontes familiarizadas com o assunto, a OpenAI planeja lançar o modelo GPT-5.2 já na próxima semana, um avanço significativo em relação ao plano original para o final de dezembro.

Isso não apenas confirma indiretamente a presença imponente do Gemini 3, mas também torna a conversa que se segue ainda mais significativa.

Recentemente, Koray Kavukcuoglu, CTO da DeepMind e novo arquiteto-chefe de IA do Google, participou do programa de entrevistas de Logan Kilpatrick, onde afirmou: "Antes éramos seguidores, mas a inovação é a única saída".

Principais destaques em resumo:

1. Koray Kavukcuoglu enfatiza que a otimização da Gemini se concentra nas seguintes áreas principais:

- As instruções seguem este princípio : garantir que o modelo compreenda e execute com precisão as necessidades específicas do usuário, em vez de gerar conteúdo arbitrariamente.

- Internacionalização : Aprimorar os recursos de suporte multilíngue para garantir uma experiência de alta qualidade para usuários em todo o mundo.

- Capacidades do agente e da ferramenta : O modelo pode não apenas usar nossas ferramentas e funções existentes de forma nativa, mas também escrever suas próprias ferramentas.

2. O Gemini 3 é um "modelo de colaboração em toda a equipe do Google". Equipes de todo o mundo, incluindo Europa e Ásia, contribuíram para ele, incluindo não apenas a equipe do DeepMind, mas também equipes de vários departamentos dentro do Google.

3. Com os avanços tecnológicos, a arquitetura e os conceitos dos modelos de texto e dos modelos de imagem estão convergindo cada vez mais. No passado, suas arquiteturas diferiam significativamente, mas agora estão se tornando mais semelhantes. Este é um resultado natural da evolução tecnológica: todos estão explorando soluções mais eficientes, seus conceitos estão gradualmente se unificando e, por fim, um caminho de desenvolvimento comum está sendo formado.

Link do vídeo:

Segue abaixo a transcrição e tradução do conteúdo completo. (A ordem foi alterada.)

A avaliação comparativa é apenas o primeiro passo; o feedback do usuário é o segundo passo.

Logan Kilpatrick : Olá a todos, sejam bem-vindos de volta às Notas de Lançamento. Sou Logan Kilpatrick, da equipe DeepMind. Hoje, tenho a honra de ter comigo Koray, CTO da DeepMind e o novo Arquiteto Chefe de IA do Google. Koray, obrigado por se juntar a nós e espero que possamos conversar mais a fundo.

Koray Kavukcuoglu : Eu também estou ansioso. Obrigado pelo convite!

Logan Kilpatrick : Claro, o Gemini 3 já foi lançado. Tínhamos a sensação de que este modelo teria um bom desempenho, e os resultados dos benchmarks foram muito impressionantes, mas o feedback real dos usuários depois de o produto estar em suas mãos…

Koray Kavukcuoglu : Este é o teste final. A avaliação comparativa é apenas o primeiro passo; também realizamos muitos testes posteriormente, incluindo a participação de testadores de confiança na experiência de pré-lançamento. Portanto, podemos afirmar que este é um excelente modelo, com capacidades excepcionais. Embora não seja perfeito, o feedback dos usuários me deixou muito satisfeito.

Parece que todos gostaram muito do modelo e estão igualmente interessados nas partes que achamos interessantes. Até agora, tudo está indo bem e progredindo sem problemas.

Logan Kilpatrick : Sim, estávamos falando sobre isso ontem mesmo, e o tópico principal era a rapidez com que o desenvolvimento da IA progrediu. Relembrando a conferência I/O do ano passado, quando lançamos o Gemini 2.5, e assistindo às demonstrações e às discussões do Serge sobre o futuro da IA, senti que o 2.5 já era o modelo mais avançado, ultrapassando obstáculos em várias dimensões. E agora, o Gemini 3.0 alcançou outro avanço. Estou curioso, pois a discussão sobre se esse progresso pode continuar está em andamento; quais são suas opiniões atuais?

Koray Kavukcuoglu : Estou muito confiante no progresso e nas pesquisas atuais. Estando na vanguarda da pesquisa, você verá que todos os campos estão repletos de entusiasmo pela inovação, desde os dados, o pré-treinamento, o ajuste fino, até cada etapa, muitas ideias novas e descobertas inovadoras estão surgindo.

Em última análise, tudo se resume à inovação e à criatividade. Quando nossa tecnologia consegue realmente impactar o mundo real e é amplamente utilizada, recebemos mais feedback, nosso alcance se expande e isso, por sua vez, gera mais inspiração.

Além disso, acredito que os problemas futuros serão mais complexos e diversos, o que trará novos desafios, mas esses desafios são benéficos e nos impulsionarão em direção à inteligência geral.

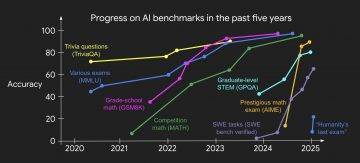

Às vezes, se você observar apenas um ou dois indicadores de desempenho, poderá ter a impressão de que o progresso diminuiu, mas isso é normal. Os indicadores de desempenho são estabelecidos quando um determinado desafio técnico se torna evidente. Conforme a tecnologia avança, eles deixam de ser sinônimo de tecnologia de ponta, e é aí que novos indicadores de desempenho precisam ser estabelecidos.

Isso é comum na área de aprendizado de máquina: a avaliação comparativa e o desenvolvimento de modelos se complementam. A avaliação comparativa orienta a iteração do modelo e, somente ao nos aproximarmos da vanguarda atual, podemos esclarecer o próximo objetivo e, então, formular uma nova avaliação comparativa.

Logan Kilpatrick : Concordo plenamente. Por exemplo, nos primeiros testes de benchmark do HLE, todos os modelos alcançaram uma precisão de apenas 1% a 2%, enquanto os modelos mais recentes da DeepMind agora conseguem atingir cerca de 40%, o que é incrível. Os testes de benchmark do ArcGIS inicialmente quase não tinham modelos capazes de lidar com eles, mas agora a precisão também ultrapassa os 40%.

No entanto, alguns benchmarks estáticos resistiram ao teste do tempo, como o GPQA Diamond. Embora agora só possamos melhorar a precisão em cerca de 1%, ele ainda é amplamente utilizado e pode estar próximo da saturação.

Koray Kavukcuoglu : Esses benchmarks realmente apresentam muitos problemas desafiadores que ainda não superamos completamente, mas ainda assim têm valor para testes. Tomemos o GPQA como exemplo; não precisamos buscar uma taxa de precisão absoluta acima de 90%, pois já estamos perto dessa meta, então o número de problemas não resolvidos está naturalmente diminuindo.

Portanto, descobrir novas fronteiras e estabelecer novos parâmetros de referência é crucial. A avaliação comparativa é uma forma de medir o progresso, mas não representa um alinhamento perfeito. Idealmente, os dois estariam perfeitamente alinhados, mas, na realidade, nunca poderão ser perfeitamente compatíveis.

Para mim, o critério mais importante para medir o progresso é: nosso modelo é amplamente utilizado no mundo real? Cientistas, estudantes, advogados e engenheiros o utilizam para resolver problemas? As pessoas o utilizam para escrever, enviar e receber e-mails, e assim por diante? O verdadeiro progresso, seja ele simples ou complexo, reside na sua capacidade de gerar continuamente maior valor para os usuários em mais áreas e cenários. O benchmarking é apenas uma ferramenta para nos ajudar a quantificar esse progresso.

Logan Kilpatrick : Tenho uma pergunta que não é exatamente controversa: o Gemini 3 teve um desempenho excepcional em inúmeros testes de benchmark, foi lançado simultaneamente em todos os produtos do Google e ecossistemas de parceiros e recebeu feedback muito positivo dos usuários. Olhando para o futuro, para o próximo grande lançamento do modelo do Google, quais aspectos você acha que precisamos aprimorar? Por exemplo, "Esperamos melhorar em X, Y e Z", ou devemos primeiro aproveitar os frutos do sucesso do Gemini 3?

Koray Kavukcuoglu : Acho que podemos ter os dois. Devemos aproveitar o momento; afinal, o dia do lançamento merece ser comemorado, e a equipe deve se orgulhar de suas conquistas. Mas, ao mesmo tempo, vemos claramente que o modelo tem deficiências em várias áreas: sua capacidade de escrita não é perfeita e sua capacidade de programação pode ser aprimorada.

Principalmente em relação à ação do agente e à codificação, ainda há muito espaço para melhorias, que também é a área mais promissora para crescimento. Precisamos identificar áreas para otimização e, em seguida, continuar aprimorando-as. Acredito que fizemos progressos consideráveis: para 90% a 95% dos usuários relacionados à codificação (sejam engenheiros de software ou indivíduos criativos que buscam desenvolver produtos), o Gemini 3 provavelmente é a melhor ferramenta disponível, mas existem, de fato, alguns cenários que exigem otimização adicional.

De "criativo" a "prático"

Logan Kilpatrick : O que você acha de "otimização gradual"? Por exemplo, da versão 2.5 para a 3.0 do Gemini, ou em outras iterações de versão, quais são nossas prioridades de otimização? Com tantos testes de benchmark disponíveis hoje, como escolhemos nossa direção de otimização, seja para toda a série Gemini ou especificamente para a versão Pro?

Koray Kavukcuoglu : Acho que existem várias áreas-chave que são cruciais. A primeira é a conformidade com as instruções . O modelo precisa entender e executar com precisão as necessidades do usuário, em vez de gerar respostas aleatórias, algo que sempre enfatizamos. A segunda é a internacionalização . Os negócios do Google abrangem o mundo todo, e queremos que usuários do mundo inteiro possam usar este modelo.

Logan Kilpatrick : De fato, conversei com Tulsi esta manhã, e ela mencionou que este modelo tem um desempenho excepcionalmente bom em alguns idiomas nos quais tínhamos dificuldades anteriormente.

Koray Kavukcuoglu : Isso é ótimo. Portanto, devemos continuar a nos concentrar nessas áreas, que podem não ser de ponta, mas são cruciais para a interação do usuário. Como eu disse antes, precisamos obter feedback dos usuários.

Em áreas mais técnicas, chamadas de função, chamadas de ferramenta, ações do agente e capacidades do código também são extremamente importantes.

As chamadas de função e de ferramenta podem aumentar consideravelmente o efeito multiplicador inteligente de um modelo: o modelo pode não apenas usar nossas ferramentas e funções existentes de forma natural, mas também escrever suas próprias ferramentas. Em essência, o próprio modelo também é uma ferramenta.

As habilidades de programação são importantes não apenas porque nossa equipe conta com muitos engenheiros, mas também porque o código é a base do mundo digital. Seja no desenvolvimento de software ou na transformação de qualquer ideia em realidade, o código é indispensável. Ele permite que os modelos sejam profundamente integrados a diversos aspectos da vida das pessoas.

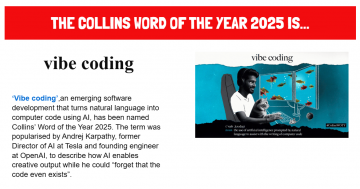

Por exemplo, sou muito otimista em relação à "programação intuitiva". Muitas pessoas são criativas, mas não conseguem dar vida às suas ideias. A programação intuitiva permite que elas passem da "criatividade" para a "prática": basta anotar suas ideias e você verá o aplicativo correspondente surgir diante de você, e na maioria das vezes ele funcionará perfeitamente.

Esse ciclo fechado, da ideia ao produto, é fantástico; dá a mais pessoas a oportunidade de se tornarem criadoras.

Logan Kilpatrick : Isso é incrível! Este é o argumento de venda perfeito para o AI Studio, e vamos editar este vídeo e publicá-lo online. Um tópico importante que você mencionou foi o lançamento simultâneo da plataforma Google Antigravity com o lançamento do Gemini 3. Do ponto de vista do modelo, qual a importância que você acha que essa arquitetura de produto tem para melhorar a qualidade do modelo? Obviamente, está intimamente relacionada ao uso de ferramentas e às capacidades de programação.

Koray Kavukcuoglu : Para mim, isso é crucial. A plataforma em si é realmente empolgante, mas, da perspectiva do modelo, é uma via de mão dupla. Primeiro, o modelo pode obter feedback dos usuários finais (engenheiros de software) por meio da integração direta com eles, o que ajuda a esclarecer a direção em que o modelo precisa ser aprimorado, e isso é vital para nós.

Assim como a Gemini e a AI Studio, a plataforma Anti-gravity é outro exemplo. Esses produtos nos permitem conectar-nos de perto com os usuários e obter feedbacks reais, o que é uma grande vantagem. Embora a plataforma Anti-gravity seja uma parceira fundamental de lançamento há pouco tempo, seu feedback tem desempenhado um papel decisivo nos preparativos para o lançamento nas últimas duas a três semanas.

O mesmo se aplica à busca por Modelos de IA, da qual recebemos uma grande quantidade de feedback. A avaliação comparativa nos ajuda a aprimorar a inteligência em áreas como ciência e matemática, mas entender casos de uso no mundo real é igualmente importante; os modelos devem ser capazes de resolver problemas do mundo real.

Gemini 3, um modelo para colaboração total da equipe do Google.

Logan Kilpatrick : Como novo Arquiteto Chefe de IA, suas responsabilidades vão além de simplesmente garantir que tenhamos modelos excelentes; você também lidera as equipes de produto para implementar esses modelos e criar experiências de usuário excepcionais em todos os produtos do Google. O lançamento simultâneo do Gemini 3 em todos os produtos do Google no dia do lançamento foi uma grande surpresa para os usuários, e esperamos que ele abranja ainda mais produtos no futuro. Da perspectiva da DeepMind, essa colaboração entre equipes adiciona complexidade extra? Afinal, há um ano e meio, as coisas provavelmente eram muito mais simples.

Koray Kavukcuoglu : Mas nosso objetivo é construir inteligência, certo? Muitas pessoas me perguntam se existe algum conflito entre ser CTO e Arquiteto Chefe de IA, mas para mim, esses dois cargos são essencialmente o mesmo.

Para construir inteligência, é preciso que isso aconteça por meio da interação entre produtos e usuários. Meu principal objetivo é garantir que todos os produtos do Google utilizem a tecnologia mais avançada. Não somos uma equipe de produto, mas sim desenvolvedores de tecnologia. Somos responsáveis por desenvolver modelos e tecnologias. Claro que também temos nossas próprias opiniões sobre os produtos, mas, acima de tudo, oferecemos suporte técnico da melhor maneira possível, colaborando com as equipes de produto para criar os melhores produtos na era da IA.

Esta é uma nova era, em que novas tecnologias estão redefinindo as expectativas dos usuários, o comportamento em relação aos produtos e a forma como as informações são entregues. Portanto, espero impulsionar esse empoderamento tecnológico dentro do Google, em colaboração com todas as equipes de produto. Isso não é apenas benéfico para os produtos e usuários, mas também crucial para nós mesmos.

Somente nos aproximando dos usuários podemos entender suas necessidades e obter feedback genuíno, que é a principal força motriz por trás da iteração do modelo. É assim que construímos Inteligência Artificial Geral (AGI): crescendo junto com os usuários por meio de nossos produtos.

Logan Kilpatrick : Concordo plenamente. Essa poderia ser a legenda do seu tweet! Também acho que estamos essencialmente construindo a Inteligência Artificial Geral (IAG) junto com nossos clientes e parceiros — não se trata de uma pesquisa isolada em um único laboratório, mas de um esforço colaborativo com o mundo todo.

Koray Kavukcuoglu : Acho que este também é um "sistema de testes confiável" — estamos enfatizando cada vez mais o pensamento de engenharia. Esse pensamento é importante porque um sistema bem projetado é mais robusto e seguro.

Ao desenvolver produtos para o mundo real, baseamo-nos fortemente no conceito de "testes confiáveis", o que se reflete na nossa ênfase em segurança e privacidade: fazemos da segurança e da privacidade princípios fundamentais desde o início, em vez de os adicionarmos posteriormente.

Seja no pré-treinamento, no ajuste fino ou na triagem de dados, todos na equipe precisam considerar a segurança. Certamente temos equipes dedicadas à segurança e privacidade que fornecem suporte técnico relevante, mas preferimos que todos na equipe Gemini estejam profundamente envolvidos, integrando segurança e privacidade em cada etapa do desenvolvimento. Essas equipes também fazem parte da equipe de ajuste fino.

Portanto, ao iterar modelos e lançar versões candidatas, não nos baseamos apenas em resultados de testes de referência, como GPQA e HLE, mas também revisamos rigorosamente as métricas de segurança e privacidade. Essa mentalidade de engenharia é crucial.

Logan Kilpatrick : Concordo plenamente. Isso também está alinhado com a cultura corporativa do Google; afinal, lançar o modelo Gemini é um empreendimento gigantesco que exige trabalho em equipe global.

Koray Kavukcuoglu : Falando em Gemini 3, acho que a característica mais notável é que se trata de um "modelo para colaboração total da equipe do Google".

Logan Kilpatrick : Podemos analisar os dados relevantes. Este é provavelmente um dos projetos com o maior número de participantes na história, assim como o programa Apollo da NASA. É um projeto global de grande envergadura.

Koray Kavukcuoglu : Isso mesmo, é global.

Logan Kilpatrick : É incrível que todas as equipes do Google tenham se envolvido.

Koray Kavukcuoglu : Equipes de todo o mundo, incluindo Europa e Ásia, contribuíram, não apenas da equipe do DeepMind, mas também de vários departamentos do Google. Foi um enorme esforço coletivo: lançá-lo simultaneamente com o AI Mode e o aplicativo Gemini não foi tarefa fácil.

Essas equipes de produto colaboraram estreitamente conosco durante a fase de desenvolvimento do modelo, e por isso conseguimos lançá-lo simultaneamente em todas as plataformas no dia do lançamento. O termo "envolvimento total do Google" refere-se não apenas às equipes diretamente envolvidas na construção do modelo, mas também a todas as equipes que desempenharam seus respectivos papéis e contribuíram discretamente.

Nano Banana, um nome espontâneo, resultado de uma mistura natural.

Logan Kilpatrick : Outro tópico que me interessa são os modelos de mídia generativa — embora sempre tenhamos tido interesse neles, não foram um foco principal no passado. No entanto, com o lançamento dos modelos Veo 3, Veo 3.1 e Nano Banana, tivemos grande sucesso na implementação em produtos.

Tenho curiosidade em saber como você vê o papel dos modelos generativos de vídeo na busca pela Inteligência Artificial Geral (IAG)? Às vezes, tenho a impressão de que os modelos de vídeo não têm relação com a IAG, mas, analisando mais a fundo, percebo que envolvem a compreensão do mundo e das leis da física, então os dois deveriam estar interligados.

Koray Kavukcuoglu : Há 10 a 15 anos, os modelos generativos estavam focados principalmente no domínio da imagem, porque naquela época conseguíamos observar melhor o processo de geração de imagens, e compreender o mundo e as leis da física também era o objetivo principal dos modelos de geração de imagens.

A exploração de modelos generativos pelo Google remonta a 10 anos, ou até mesmo antes. Quando eu era estudante de doutorado, todos estavam trabalhando em modelos generativos de imagem, como redes neurais convolucionais de pixels (Pixel CNNs). Mais tarde, percebemos que o progresso no domínio do texto seria ainda mais rápido.

No entanto, a importância dos modelos de imagem tornou-se evidente mais uma vez. A DeepMind acumulou ao longo do tempo uma sólida experiência técnica em modelos de imagem, vídeo e áudio, tornando a integração dessas tecnologias com modelos de texto uma progressão natural.

Sempre enfatizamos a multimodalidade, incluindo a multimodalidade de entrada e a multimodalidade de saída. Com os avanços tecnológicos, as arquiteturas e os conceitos dos modelos de texto e dos modelos de imagem estão convergindo cada vez mais. No passado, suas arquiteturas diferiam significativamente, mas agora estão se tornando cada vez mais semelhantes. Isso não é algo que promovemos deliberadamente, mas sim um resultado natural da evolução tecnológica: todos estão explorando soluções mais eficientes, seus conceitos estão gradualmente se unificando e, por fim, um caminho de desenvolvimento comum foi formado.

O principal valor dessa fusão reside no fato de que os modelos de texto possuem um vasto conhecimento do mundo, enquanto os modelos de imagem o compreendem a partir de outra perspectiva. A combinação dos dois permite que o modelo entenda melhor a intenção do usuário e crie resultados mais surpreendentes.

Logan Kilpatrick : Tenho outra pergunta sobre a Nano Banana: você acha que deveríamos dar nomes interessantes a todos os modelos? Isso ajudaria?

Koray Kavukcuoglu : Não necessariamente. Acho que os nomes devem surgir naturalmente, e não serem escolhidos deliberadamente. Por exemplo, não criamos o nome Gemini 3 intencionalmente.

Logan Kilpatrick : Se o Gemini 3 não se chamasse assim, que nome você daria a ele? Seria um nome engraçado?

Koray Kavukcuoglu : Não sei, não sou bom em dar nomes às coisas. Na verdade, nossos modelos Gemini têm codinomes internos, alguns dos quais são até gerados pelo próprio modelo Gemini, mas Nano Banana não; não foi gerado pelo modelo.

Existe uma história por trás desse nome, que acredito já ter sido divulgada. Acho que, contanto que o nome surja de forma natural e espontânea, está ótimo. É significativo que a equipe que está construindo o modelo possa ter uma conexão emocional com o nome.

O nome "Nano Banana" foi mantido porque usamos esse codinome durante os testes e todos gostaram; ele se espalhou espontaneamente. Acho difícil criar nomes tão naturais de forma deliberada. Se você tiver um, use-o; caso contrário, usar um nome padrão também funciona.

Logan Kilpatrick : Vamos falar sobre o Nano Banana Pro, um modelo de geração de imagens de última geração baseado no Gemini 3 Pro. Ouvi dizer que, após a conclusão do Nano Banana, a equipe descobriu que a atualização para a versão Pro melhorou significativamente o desempenho em cenários mais detalhados, como renderização de texto e compreensão do mundo real. O que você acha desse desenvolvimento?

Koray Kavukcuoglu : Isso é precisamente uma manifestação da integração de diferentes tecnologias. Sempre dissemos que cada versão do Gemini é uma família de modelos, como Pro, Flash, etc., com diferentes tamanhos de modelos que fazem concessões em termos de velocidade, precisão e custo. O mesmo se aplica aos modelos de geração de imagem, o que naturalmente leva a produtos com posicionamentos diferentes.

Baseada na arquitetura do Gemini 3.0 Pro e combinada com a experiência do modelo de primeira geração, a equipe criou um modelo de geração de imagens mais poderoso, expandindo a escala do modelo e otimizando os métodos de ajuste, o que é bastante razoável. Sua principal vantagem reside no processamento de cenários complexos: por exemplo, ao receber um grande número de documentos complexos, o modelo não só responde a perguntas relevantes, como também gera infográficos correspondentes, com excelentes resultados. Isso demonstra a fusão natural da multimodalidade de entrada e da multimodalidade de saída, o que é fantástico.

Logan Kilpatrick : Sim, é como mágica! Espero que todos já tenham visto exemplos quando este vídeo for lançado; alguns dos casos compartilhados internamente são realmente incríveis.

Koray Kavukcuoglu : Concordo plenamente! Quando você vê um modelo que consegue apresentar grandes quantidades de texto e conceitos complexos em uma imagem clara e intuitiva, você fica realmente impressionado. É uma demonstração direta das capacidades do modelo.

Logan Kilpatrick : E há muitos detalhes que merecem atenção. Tenho outra pergunta relacionada: em dezembro passado, Tulsi prometeu que lançaríamos um ponto de verificação unificado do modelo Gemini. O que você acabou de descrever significa que estamos muito perto de atingir esse objetivo?

Koray Kavukcuoglu : Historicamente, a arquitetura dos modelos generativos tem sido consistente…

Logan Kilpatrick : Então, acho que esse é o nosso objetivo: integrar de fato esses recursos em um modelo, mas certamente existem alguns obstáculos na prática. Você pode explicar isso de uma perspectiva macro?

Koray Kavukcuoglu : Como eu disse antes, tecnologia e arquitetura estão convergindo, e essa convergência é uma tendência inevitável, mas precisa ser verificada. Não podemos nos basear em suposições subjetivas; devemos seguir o método científico: formular hipóteses, realizar testes e observar os resultados. Às vezes funciona, às vezes não, mas esse é o processo do progresso tecnológico.

Estamos nos aproximando gradualmente de nosso objetivo e acredito que, em um futuro próximo, veremos um modelo mais unificado, mas isso exigirá muita inovação.

Isso é realmente bastante difícil — o espaço de saída do modelo é crucial porque está diretamente relacionado à qualidade do sinal aprendido. Atualmente, nossos sinais aprendidos vêm principalmente de código e texto, e é por isso que o modelo tem um bom desempenho nessas áreas.

A geração de imagens, no entanto, é diferente: exige altíssima qualidade, requerendo não apenas precisão em nível de pixel, mas também a coerência do conceito da imagem — ou seja, cada pixel deve estar em conformidade com a lógica da imagem como um todo. Obter simultaneamente boa geração de texto e imagem é muito difícil. Mas acredito que seja absolutamente viável; basta encontrar uma direção adequada para a inovação do modelo.

Logan Kilpatrick : Que emocionante! Espero que isso também torne nosso trabalho mais eficiente, por exemplo, com um ponto de verificação de modelo unificado.

Koray Kavukcuoglu : É difícil dizer, mas é muito provável.

Tudo se constrói com base na aprendizagem.

Logan Kilpatrick : Tenho outra pergunta sobre programação e uso de ferramentas. Analisando o desenvolvimento do Gemini: a versão 1.0 focou em computação multimodal e a versão 2.0 começou a construir a infraestrutura. Embora nosso progresso tenha sido rápido, por que não atingimos o estado da arte no uso de ferramentas de agentes desde o início no domínio multimodal? Afinal, o Gemini 1.0 sempre esteve na vanguarda da computação multimodal.

Koray Kavukcuoglu : Não acho que isso tenha sido intencional. Para ser honesto, acredito que esteja intimamente relacionado à proximidade do ambiente de desenvolvimento do modelo com o mundo real. Quanto mais próximo da realidade, melhor ele consegue compreender as reais necessidades do usuário.

O desenvolvimento do Gemini também é um processo de transição da "pesquisa pura" para o "pensamento de engenharia" e uma profunda integração com o produto. O Google tem uma base sólida em pesquisa de IA e muitos pesquisadores de destaque, mas o que torna o Gemini especial é que ele nos levou de "escrever artigos e fazer pesquisas" para "desenvolver junto com os usuários por meio de produtos".

Tenho orgulho da nossa equipe — a maioria de nós, inclusive eu, estava focada em publicar artigos e conduzir pesquisas em IA há quatro ou cinco anos. Agora, estamos na vanguarda da tecnologia, impulsionando a iteração tecnológica em conjunto por meio de produtos e usuários.

Essa transformação é notável: lançamos um novo modelo a cada seis meses e o atualizamos a cada um mês ou um mês e meio. Acredito que foi nesse processo que aprimoramos gradualmente nossa capacidade de usar ferramentas de agentes inteligentes.

Logan Kilpatrick : Outro ponto interessante: a DeepMind agora possui diversos produtos de IA líderes mundiais, como o Vibe Coding, o AI Studio, o Gemini e a plataforma Antigravity. O Google também tem muitos modelos de ponta, como o Gemini 3, o Nano Banana e o Veo. Dez ou mesmo quinze anos atrás, o mundo era completamente diferente.

Estou curioso. Olhando para trás na sua carreira, você mencionou ontem que foi o primeiro pesquisador de aprendizado profundo da DeepMind, o que me surpreendeu, assim como a outros. De 13 anos atrás (2012), quando o aprendizado profundo era visto com ceticismo, até agora, quando essa tecnologia impulsiona inúmeros produtos e é uma força motriz fundamental, quais são seus pensamentos? Tudo isso era esperado ou te surpreendeu?

Koray Kavukcuoglu : Acho que esse é o resultado ideal. Como acontece com todos que fazem doutorado, você acaba se convencendo de que o que está fazendo é importante e terá um impacto significativo — essa era a minha mentalidade na época.

Então, quando Demi e Shane entraram em contato comigo e me contaram que a DeepMind era uma equipe focada em construir inteligência, com aprendizado profundo em seu núcleo, fiquei incrivelmente empolgado. Meu amigo Carl Greger e eu (ambos viemos do laboratório de Jan na NYU) nos juntamos à DeepMind ao mesmo tempo. Naquela época, startups focadas em aprendizado profundo e IA eram muito raras, então a visão da DeepMind era realmente notável, e trabalhar lá era incrivelmente empolgante. Mais tarde, montei minha própria equipe de aprendizado profundo e a vi crescer e prosperar.

Minha postura em relação ao aprendizado profundo sempre foi: baseá-lo em princípios fundamentais e aderir a uma mentalidade "orientada para o aprendizado", que também é a filosofia central da DeepMind: tudo é construído sobre o aprendizado.

Ao relembrarmos essa jornada, desde os primórdios do DQN, AlphaGo, AlphaZero e AlphaFold até o atual Gemini, é realmente uma experiência emocionante. Sempre avançamos com expectativas positivas, mas, ao mesmo tempo, nos sentimos muito afortunados.

Temos a sorte de viver nesta era. Muitas pessoas dedicaram suas vidas à IA ou às suas paixões, na esperança de presenciar uma explosão tecnológica, e agora ela realmente aconteceu. A ascensão da IA não se deve apenas aos avanços em aprendizado de máquina e aprendizado profundo, mas também está intrinsecamente ligada ao desenvolvimento de hardware, da internet e dos dados — todos esses fatores contribuíram para o cenário atual. Portanto, tenho orgulho de ter escolhido a área de IA e me sinto privilegiado por viver nesta era. É realmente empolgante.

Logan Kilpatrick : Recentemente assisti à série de vídeos "The Thinking Game" e aprendi sobre a história por trás do AlphaFold. Não vivenciei essa época em primeira mão, então só a conheço por meio de materiais e relatos de outras pessoas. Você esteve envolvido em vários projetos importantes na DeepMind. Como você acha que seu trabalho atual difere do seu trabalho anterior? Por exemplo, você mencionou anteriormente que "dominamos os métodos para trazer modelos ao mundo". Como esse sentimento é semelhante ou diferente dos seus projetos anteriores?

Koray Kavukcuoglu : Como organizar uma equipe e cultivar uma cultura para transformar problemas científicos e tecnológicos complexos em resultados bem-sucedidos? Acredito que adquirimos muita experiência com diversos projetos, desde o DQN, AlphaGo e AlphaZero até o AlphaFold, todos com um impacto profundo. Aprendemos a organizar grandes equipes para trabalhar em torno de objetivos e missões específicos.

Lembro-me de que, nos primórdios da DeepMind, tínhamos 25 pessoas trabalhando juntas em um projeto para publicar um artigo — muitos questionavam como 25 pessoas poderiam colaborar em um único artigo, mas conseguimos. Essa colaboração em larga escala é incomum na pesquisa científica, mas a alcançamos por meio de uma organização eficaz. Essa experiência e mentalidade evoluíram ao longo do tempo e se tornaram cada vez mais importantes.

Nos últimos dois ou três anos, também incorporamos o pensamento de engenharia – temos uma direção principal de desenvolvimento para o modelo e aprendemos a explorar com base nessa direção principal.

Acho que o Deep Think é um bom exemplo: nós o usamos para participar de competições de alto nível, como a Olimpíada Internacional de Matemática (IMO) e o Concurso Internacional de Programação Universitária (ICPC). Essas competições têm problemas extremamente difíceis, e muitas pessoas gostariam de personalizar um modelo especificamente para a competição, mas optamos por usá-la como uma oportunidade para otimizar nosso modelo existente.

Acreditamos firmemente na versatilidade da tecnologia. Por meio de competições, exploramos novas ideias, integramos essas ideias a modelos existentes e, por fim, criamos modelos que podem participar de competições de alto nível, os quais disponibilizamos a todos.

Logan Kilpatrick : Isso me lembra um paralelo: antes, 25 pessoas colaboravam em um artigo, mas agora a lista de colaboradores do Gemini 3 pode ter 2.500 pessoas — muitos podem pensar: "Como 2.500 pessoas podem estar envolvidas?", mas é verdade. Essa maneira de resolver problemas por meio da colaboração em larga escala é realmente incrível.

Koray Kavukcuoglu : Isso é muito importante, e é aí que reside a força do Google. O Google possui capacidades técnicas completas, das quais podemos nos beneficiar: de data centers, chips e redes à implantação de modelos em larga escala, há especialistas em cada etapa.

Retomando o tema do pensamento de engenharia, esses aspectos são inseparáveis. Ao projetar um modelo, consideramos o hardware em que ele será executado; e ao projetar a próxima geração de hardware, antecipamos a direção futura do modelo. Essa colaboração é maravilhosa, mas coordenar tantos aspectos realmente exige o esforço conjunto de milhares de pessoas. Devemos reconhecer o valor dessa colaboração; ela é verdadeiramente notável.

Logan Kilpatrick : Isso não é tarefa fácil. Retomando a tradição da DeepMind: sempre empregamos uma abordagem científica multidisciplinar, buscando solucionar uma variedade de problemas interessantes. E agora, demonstramos claramente a eficácia dessa tecnologia em diversas áreas; precisamos simplesmente continuar a expandi-la. É claro que isso também exige inovação.

Na sua opinião, como a DeepMind equilibra a "exploração científica pura" e a "expansão da escala do Gemini" nos dias de hoje? Por exemplo, o "modelo de difusão Gemini" é uma manifestação desse processo decisório.

Koray Kavukcuoglu : Esta é a questão mais crucial: encontrar um equilíbrio entre os dois é essencial.

Muitas pessoas me perguntam agora: qual é o maior risco da Gemini? Refleti bastante sobre isso e a resposta é "falta de inovação". Acredito piamente que não encontramos uma "fórmula universal" que possamos simplesmente seguir passo a passo.

Nosso objetivo é construir inteligência geral, o que exige profunda integração com usuários e produtos. No entanto, esse objetivo em si continua sendo extremamente desafiador, e não temos soluções prontas. A inovação é a principal força motriz para alcançá-lo.

A inovação pode assumir diferentes escalas e direções: dentro do projeto Gemini, exploramos novas arquiteturas, novas ideias e novos métodos; enquanto que, no geral, o Google DeepMind também realizará explorações mais interdisciplinares, porque algumas ideias podem ser muito limitadas dentro do projeto Gemini para serem totalmente desenvolvidas.

Portanto, o Google DeepMind e o Google Research precisam explorar diversas ideias em conjunto e, em seguida, integrá-las ao Gemini, pois o Gemini não é uma arquitetura, mas um objetivo: construir inteligência geral para que todos os produtos do Google possam ser executados nesse mecanismo de IA.

Independentemente da arquitetura que viermos a adotar, continuaremos a evoluir, e a inovação será sempre a principal força motriz. Encontrar um equilíbrio, ou avançar na exploração de diferentes maneiras, é crucial.

Logan Kilpatrick : Tenho uma pergunta relacionada: na conferência I/O, conversei com o Sergey, e quando você reúne tantas pessoas para lançar modelos e impulsionar a inovação, você sente uma espécie de "calor humano" — eu entendo perfeitamente isso. Eu estava sentado ao seu lado naquele momento e também senti seu entusiasmo.

Isso é muito significativo para mim, pessoalmente, porque reflete a cultura geral da DeepMind: uma base científica sólida aliada a um ambiente de equipe amigável e inclusivo. Muitas pessoas podem não perceber a importância dessa cultura e como ela influencia o trabalho. Como líder de equipe, como você vê a manifestação dessa cultura?

Koray Kavukcuoglu : Primeiramente, obrigado pelo elogio; fico um pouco sem graça. Mas acredito sinceramente no poder do trabalho em equipe e na importância de confiar e dar oportunidades aos outros. O trabalho em equipe é crucial, e isso é algo que aprendi durante meu tempo na DeepMind.

Começamos como uma equipe pequena e mantivemos a confiança mútua ao longo de nosso crescimento. Acredito que seja crucial criar um ambiente "focado na solução de problemas técnicos e científicos complexos e de grande impacto", e é isso que estamos fazendo agora.

No cerne do Gemini está a construção da inteligência geral, um problema técnico e científico extremamente desafiador que precisamos abordar com humildade, questionando e otimizando constantemente a nós mesmos. Espero que a equipe também sinta isso; estou verdadeiramente orgulhoso da nossa equipe, de seus esforços conjuntos e apoio mútuo.

Como eu estava conversando com a equipe na sala de descanso mais cedo, "É difícil, estamos todos exaustos, mas isso é normal quando se desenvolve tecnologia de ponta. Não temos processos perfeitos, mas todos estão se dedicando ao máximo e se apoiando mutuamente." O que torna tudo isso interessante e significativo, e o que nos dá coragem para enfrentar desafios, é em grande parte "ter uma equipe excelente", onde todos trabalham juntos para concretizar o potencial da tecnologia.

Posso afirmar com certeza que a arquitetura de Modelo de Linguagem Amplo (LLM) que usamos hoje estará definitivamente obsoleta em 20 anos. Portanto, explorar continuamente novas direções é a escolha certa. O Google DeepMind, o Google Research e toda a comunidade de pesquisa acadêmica precisam trabalhar juntos para avançar na exploração em múltiplos campos.

Acredito que não devemos nos prender a "o que é certo e o que é errado". O que realmente importa é a capacidade e o desempenho da tecnologia no mundo real.

Logan Kilpatrick : Uma última pergunta: Durante meu primeiro ano no Google, pessoalmente senti uma sensação de "retorno triunfal do Google". Apesar da forte vantagem da infraestrutura do Google, na área de IA, parecia que estávamos constantemente correndo atrás do prejuízo. Por exemplo, nos estágios iniciais do AI Studio, não tínhamos usuários (depois chegamos a 30.000), nenhuma receita, e o modelo Gemini também estava em seus estágios iniciais.

Agora, com o lançamento do Gemini 3, tenho recebido muitos feedbacks de diversas partes do ecossistema, e parece que as pessoas finalmente perceberam que "a era da IA do Google chegou". Você já sentiu essa sensação de "retorno triunfal"? Acreditava que chegaríamos aonde chegamos hoje? Qual será o impacto dessa mudança de função na equipe?

Koray Kavukcuoglu : À medida que o potencial dos Modelos de Linguagem de Grande Porte (LLMs) se torna cada vez mais evidente, digo com franqueza que, embora considere o DeepMind um laboratório de IA de ponta, também percebo que nós, como pesquisadores, não investimos o suficiente em certas áreas. Esta é uma lição importante para mim: devemos ampliar nossa exploração e a inovação é crucial, em vez de nos limitarmos a uma única arquitetura.

Sempre fui honesto com a equipe: há cerca de 2,5 anos, quando começamos a levar a sério os grandes modelos de linguagem e lançamos o projeto Gemini, estávamos atrasados em muitos aspectos. Havia muitas coisas que não sabíamos e, embora tivéssemos nossas próprias vantagens, estávamos de fato em uma fase de recuperação.

Esse processo de recuperação durou bastante tempo e, agora, acredito que entramos para o grupo líder. Estou muito satisfeito com nosso ritmo de desenvolvimento, a dinâmica da equipe e o ritmo de colaboração. Mas precisamos enfrentar os desafios dessa jornada de recuperação.

No processo de alcançar o nível dos outros, devemos aprender com os pontos fortes alheios, mantendo nossa própria inovação e buscando soluções que nos sejam adequadas: sejam tecnologias, modelos, processos ou métodos de operação em equipe, todos esses aspectos são exclusivos de cada um.

Muitas pessoas dizem: "O Google é grande demais e ineficiente", mas acredito que isso pode se tornar uma vantagem. Temos a capacidade de realizar projetos únicos e em grande escala, como disponibilizar o Gemini em todos os produtos do Google simultaneamente. Estou muito feliz com a minha situação atual, e isso foi conquistado por meio de aprendizado contínuo e inovação. É realmente uma história de superação notável.

É claro que sempre haverá comparações, mas nosso objetivo permanece o mesmo: construir inteligência geral — e queremos alcançar isso da maneira correta, dedicando todos os nossos esforços e inovação a esse propósito.

Logan Kilpatrick : Acho que os próximos seis meses serão tão empolgantes quanto os últimos seis meses, e até mesmo os seis meses anteriores. Agradeço novamente por ter dedicado seu tempo para esta entrevista, foi um prazer! Espero que possamos conversar novamente antes da conferência I/O do ano que vem.

Embora pareça muito tempo, o tempo certamente passará voando. Acredito que haverá uma reunião de planejamento para a conferência I/O de 2026 na próxima semana. Parabéns novamente a você e à equipe da DeepMind, e a todos os pesquisadores de modelos, pelo lançamento bem-sucedido do Gemini 3, do Nano Banana Pro e de uma série de outros produtos!

Koray Kavukcuoglu : Muito obrigado! Esta troca de informações foi fantástica. Agradeço à equipe pelo trabalho árduo e pelo convite!

#Siga a conta oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde você encontrará conteúdo ainda mais interessante o mais breve possível.