Este gerador de imagens de IA lançou seu primeiro modelo de vídeo: sem resolução, mas os internautas disseram que a imagem era incrível e superou as expectativas com palavras rápidas

Diante de processos judiciais de direitos autorais da Disney e da Universal Pictures, a veterana "unicórnio" do design gráfico Midjourney não diminuiu o ritmo. Em vez disso, lançou seu primeiro modelo de vídeo na manhã de hoje, sob pressão.

A combinação de cores é precisa, a composição é requintada, as emoções são plenas e o estilo ainda está online.

Midjourney não oferece resolução nem lentes longas, mas sim uma atmosfera única e reconhecimento estético. Midjourney é ambicioso, visando o "modelo mundial", mas ainda não se sabe se o design funcional atualmente um pouco "bruto" conseguirá levá-lo além.

A versão de economia de fluxo é a seguinte:

- Após carregar ou gerar uma imagem, basta clicar em "Animar". Por padrão, uma única tarefa gerará 4 vídeos de 5 segundos, que podem ser estendidos para um máximo de 21 segundos.

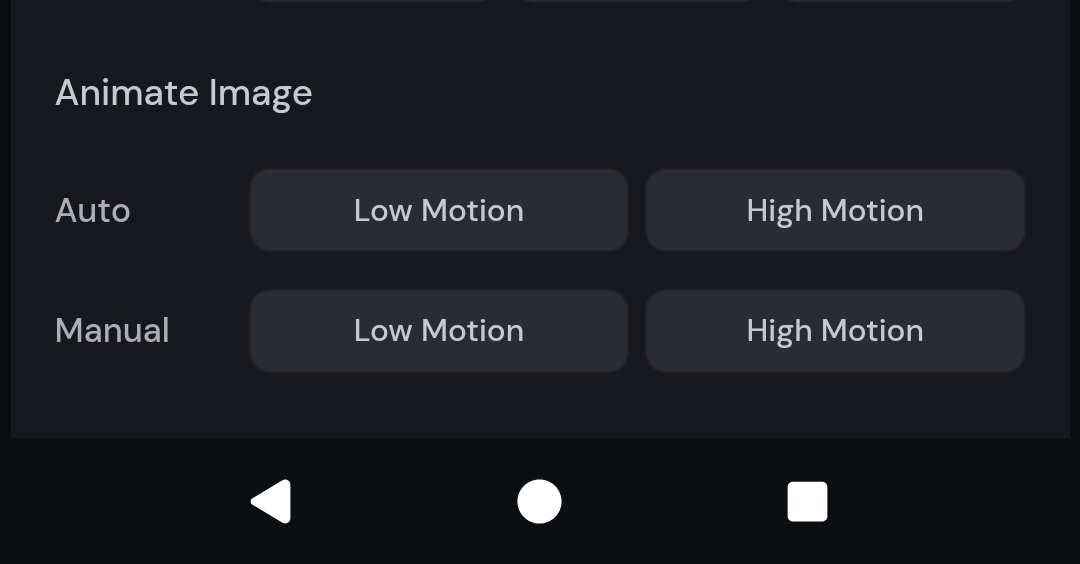

- Suporta modos manual e automático, e os usuários podem definir o efeito de geração de imagem por meio de palavras de prompt; fornece opções de baixo movimento e alto movimento, adequadas para atmosfera estática ou cenas dinâmicas fortes, respectivamente

- O vídeo está incluído nas assinaturas existentes (US$ 10/mês) e usa 8 vezes mais recursos da GPU do que tarefas gráficas

- Não suporta adição de efeitos sonoros, edição de linha do tempo, transições de clipes ou acesso à API. A resolução é de apenas 480p e a proporção da tela se adapta automaticamente à imagem. Ainda é uma versão inicial.

- O modelo de vídeo é um resultado gradual. No futuro, continuaremos a lançar modelos 3D e sistemas em tempo real e, por fim, visaremos o modelo mundial.

O modelo de vídeo Midjouney já está disponível

Você rola sua resolução, eu vou com minha hiper-realidade.

Midjourney sempre foi conhecido por seu estilo visual fantástico e surreal. A julgar pelos resultados testados por usuários atuais, seu modelo de vídeo também segue essa direção estética, com um estilo estável e alto reconhecimento.

No vídeo compartilhado pelo blogueiro @EccentrismArt, um menino cai verticalmente de uma grande altura. A modelagem do personagem é simples e dinâmica, como se ele estivesse pulando, caindo ou em queda livre em um sonho. A trajetória do movimento é suave e o centro de gravidade do personagem é relativamente natural.

Os quarteirões da cidade estão densamente povoados de luzes, e os edifícios parecem inclinar e girar no espaço, criando uma ilusão visual de distorção espacial, mas a dinâmica geral dos edifícios não apresenta nenhuma trepidação óbvia ou falhas de emenda geradas por IA;

Neste vídeo de uma cena de estação de bonde japonesa, o bonde parte da estação e o sol está prestes a se pôr. A temperatura da cor é bem controlada e a fonte de luz é natural, criando um ritmo de movimento na imobilidade e imobilidade no movimento.

▲Prompt: O trem passando pela estação. | @PAccetturo

A silhueta de uma mulher vestindo uma camisa e segurando um documento ou livro. Atrás dela, a enorme silhueta de uma cabeça humana. Você pode ver que a composição de exposição múltipla/sobreposição é muito limpa, com halo natural e sem superexposição. Não é à toa que Phi Hoang, designer de IA da Perplexity, disse que superou as expectativas.

O famoso blogueiro X @nickfloats compartilhou um vídeo de uma garota caminhando em uma plataforma de trem bem iluminada, com um trem de alta velocidade passando ao fundo. As divisões de luz e sombra eram óbvias e o efeito tridimensional era forte.

A coexistência de noite, aurora, neve, faróis de carros, desfoque de movimento e outros elementos representa um grande desafio para o modelo de geração de vídeo. No entanto, o modelo lida com sucesso com a interferência de múltiplas fontes de luz; partículas de neve, desfoque de velocidade de carros e efeitos de luz de trajetória são altamente consistentes.

▲Prompt: Subaru azul do Rally Mundial de 2022, correndo pela Finlândia nevada à noite, cena de ação dramática, desfoque de movimento dinâmico, neve voando, aurora boreal no céu, faróis iluminando a neve, alto contraste, iluminação cinematográfica | @JamianGerard

Usando trajes espaciais clássicos, um grande número de rastros de luz coloridos se estendem atrás dos astronautas, criando uma ilusão de "viagem" ou "movimento de alta velocidade" com um forte senso de ritmo visual.

▲Prompt: "Viva um pouco, tomando ácido, e eu vou voar para longe. Estou me sentindo como um astronauta no espaço. Não acho que isso vá fazer o mal que dizem. Estou me sentindo como um astronauta no espaço" | @JamianGerard

Elementos como destaques, materiais e movimento de líquidos são janelas para testar a capacidade do modelo de IA de expressar objetos estáticos. Neste vídeo, os cubos de gelo, o creme e o caramelo são dinâmicos e naturais, e o rótulo não apresenta nenhuma distorção óbvia durante a rotação do copo.

▲Sugestão: Uma bebida do Starbucks, copo alto clássico, caramelo macchiato gelado, calda de caramelo em espiral, chantilly por cima, condensação no copo, bebida vibrante e apetitosa, fotografia de alta qualidade da bebida, proporção 1:1. | @JamianGerard

A sensação de profundidade da perspectiva é clara, a distância e a proximidade são adequadamente sobrepostas, e o estilo realista também é forte.

▲Sugestão: Sentado no meio da selva com muitos animais selvagens se movendo ao redor S | @JamianGerard

Nas ruas apocalípticas de Nova York, há muitos detalhes, como carros em chamas e ruínas; de acordo com os requisitos das palavras do prompt, o vídeo gerado precisa ter uma textura de filme de 35 mm e também é um pouco granulado no geral.

▲Instrumento: Uma rua da cidade no início da manhã, com carros em chamas e destroços espalhados por toda parte. A cena evoca a Nova York dos anos 1990, capturada no estilo do fotógrafo Jeff Wall, com a textura granulada do filme 35 mm. | @JamianGerard

A bola de cristal paira e gira lentamente, o que testa a estabilidade da cena e o movimento da câmera também é bastante suave.

▲Sugestão: esfera cristalina pairando e girando lentamente sobre um campo colorido e calmo, tomada de câmera estável | @JamianGerard

Vale ressaltar que os resultados da geração de casos mostrados acima podem ter passado por diversas rodadas de "sorteio de cartas", mas, a julgar pelo efeito final, a conclusão visual já é bastante impressionante.

A ambiciosa Midjourney está construindo o segundo bloco de construção do "modelo mundial"

A partir de hoje, os usuários do Midjourney podem enviar imagens para o site oficial (Midjourney.com) ou usar diretamente as imagens geradas pela plataforma e clicar no botão "Animar" para converter imagens em vídeos.

Cada tarefa gerará 4 vídeos de 5 segundos, e os usuários podem estender qualquer segmento até 4 vezes, adicionando 4 segundos a cada vez, com uma duração total de até 21 segundos. É claro que o começo é difícil, e o responsável disse que a duração e as funções serão expandidas ainda mais no futuro.

O limite lógico operacional não é alto. Você pode criar imagens no Midjourney como de costume, mas agora há uma etapa adicional para animar a imagem. Além disso, você também pode carregar imagens externas como "quadro inicial" e, em seguida, usar palavras-chave para descrever o efeito dinâmico que deseja apresentar.

A versão V1 fornece algumas configurações personalizadas ajustáveis para permitir que os usuários tenham controle mais detalhado sobre o conteúdo da imagem.

No modo Manual, você pode inserir indicações específicas para definir automaticamente como os elementos do vídeo se movem e como a cena se desenvolve, mas se ainda não tiver uma ideia das indicações, você pode escolher uma configuração Automática que gerará automaticamente indicações de movimento para você e fará as imagens se moverem.

Em termos de estilo criativo, você também pode escolher entre duas configurações de movimento:

- Modo de baixo movimento: adequado para cenas atmosféricas, a câmera permanece praticamente parada e o objeto se move lenta ou ritmicamente. A desvantagem é que, às vezes, pode não haver movimento algum (como pessoas piscando, brisa soprando na paisagem, etc.);

- Modo de alto movimento: adequado para cenas que exigem muito movimento tanto da lente quanto do objeto. A desvantagem é que movimentos intensos podem, às vezes, causar erros ou instabilidade na imagem.

Em termos de preço, a função de vídeo está diretamente incorporada ao sistema de assinatura do Midjourney, e o preço inicial ainda é US$ 10 por mês.

De acordo com o blog oficial, o Midjourney consome cerca de 8 vezes mais tempo de GPU por vídeo do que tarefas de imagem, mas, considerando a capacidade de gerar vídeos de até 20 segundos de duração, o custo médio por segundo é quase o mesmo da geração de imagens. Comparado aos produtos concorrentes, sua relação custo-benefício é a melhor.

Também usamos o mecanismo de busca de IA para classificar brevemente as taxas de assinatura de alguns modelos de vídeo convencionais para sua referência.

Além disso, a Midjourney está testando o "Modo Relax" para assinantes Pro e superiores, que permite que a tarefa de geração seja concluída em uma velocidade menor, reduzindo assim o consumo de recursos de computação. Usuários de outros níveis ainda serão cobrados de acordo com o tempo de GPU e o nível de assinatura.

Atualmente, há muitos pontos que merecem ser reclamados sobre o modelo de vídeo Midjourney. O recurso mais comum é a falta de alguns recursos essenciais para criação profissional.

Em primeiro lugar, ao contrário do Veo 3 do Google ou do Dream Machine da Luma, o modelo de vídeo Midjourney não suporta atualmente a adição automática de música de fundo ou efeitos sonoros ambientes. Se for necessário áudio, ele ainda precisa ser adicionado manualmente usando outras ferramentas de terceiros.

Em segundo lugar, o modelo de vídeo Midjourney não suporta a edição da linha do tempo, e os videoclipes gerados são "cortes abruptos", o que torna impossível alcançar a continuidade da história e a conexão natural entre as imagens, dificultando o controle do ritmo do enredo ou o prenúncio emocional.

Além disso, o modelo de vídeo Midjourney não fornece acesso à API no momento.

Mais importante ainda, a resolução padrão dos vídeos gerados pelo Midjourney é 480p (definição padrão), e a proporção do vídeo é adaptada automaticamente com base no tamanho original da imagem. Ele também será marcado como 480p ao ser carregado em outras plataformas.

▲Observação: o Midjourney pode ajustar ligeiramente a proporção da tela, e as proporções do vídeo final podem ser ligeiramente diferentes da imagem inicial.

Funcionários da Midjourney também admitiram que a versão atual ainda está em estágio inicial de exploração, com foco em acessibilidade, facilidade de uso e escalabilidade.

O modelo de vídeo é apenas um corte. O que a Midjourney quer é um sistema de produção de conteúdo mais completo.

De acordo com o plano oficial, o objetivo final é construir um "modelo mundial", ou seja, integrar geração de imagens, controle de animação, navegação espacial tridimensional e renderização em tempo real.

Você pode pensar nisso como se, em um sistema de IA capaz de gerar imagens em tempo real, você pudesse inserir uma frase para comandar o protagonista da IA a se mover no espaço 3D, o cenário do ambiente mudaria de acordo e você poderia interagir com tudo.

Assim como os blocos de construção, para atingir esse objetivo, precisamos de um modelo de imagem (para gerar imagens estáticas) → um modelo de vídeo (para fazer as imagens se moverem) → um modelo 3D (para obter navegação espacial e movimento da lente) → um modelo em tempo real (para garantir que cada quadro possa responder de forma sincronizada).

De acordo com o plano de produto da Midjourney, esses quatro "blocos de construção" técnicos serão entregues nos próximos 12 meses e, eventualmente, integrados em um sistema unificado. O modelo de vídeo V1, como resultado gradual, é o segundo passo para esse objetivo final.

#Bem-vindo a seguir a conta pública oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.