Ele é conhecido como a alternativa mais forte ao ChatGPT. Como ele funciona após a grande atualização? Em anexo está um link de teste.

Se você perguntar qual é o assistente de IA mais poderoso do momento? Não há dúvida de que é definitivamente ChatGPT.

Não muito tempo atrás, o ChatGPT entrou em colapso inesperadamente, explodindo diretamente um grande número de usuários frequentes online. Os estudantes que dependiam dele para fazer os trabalhos de casa não conseguiram escrever os seus trabalhos durante algum tempo, e os trabalhadores migrantes que dependiam dele para “sustentar as suas vidas” nem sequer queriam ir às aulas.

Desde este ano, o ChatGPT "morreu repentinamente" de vez em quando. Claude, conhecido como seu substituto mais forte, pode ser sua alternativa mais confiável.

Duplique o contexto, grande atualização do Claude 2.1

Coincidentemente, Claude recebeu recentemente uma onda de grandes atualizações. No passado, o contexto que Claude conseguia lidar era de apenas 100.000 tokens (um token é a menor unidade no processamento de texto, como uma palavra ou frase), agora a versão Claude 2.1 Pro pode lidar com até 200 mil contextos.

Autoridades antrópicas dizem que 200 mil contextos equivalem a aproximadamente 150.000 palavras ou 500 páginas de texto, o que significa que você pode fazer upload de bibliotecas de códigos, demonstrações financeiras ou longas obras literárias para Claude resumir, fazer perguntas e respostas, prever tendências e comparar e contrastar vários documentos.

Então, quão bem ele consegue lidar com o chinês? Podemos dar uma explicação simples com o anteriormente controverso Yi-34B. Também foi lançada uma versão que suporta janelas de contexto ultralongas de 200 K. Yi-34B pode lidar com entrada de texto ultralongo de cerca de 400.000 caracteres chineses, que é aproximadamente o comprimento de um livro "The Scholars".

Em termos de modelos de linguagem, o contexto longo pode fornecer uso e significado mais precisos, ajudar a eliminar ambigüidades e ajudar o modelo a gerar texto coerente e preciso.Por exemplo, a palavra "maçã" aparece em "colhendo frutas" ou "novo iPhone", o significado é completamente diferente.

Vale ressaltar que antes do GPT-4 restaurar a função de rede em tempo real, o Claude gratuito podia acessar links da web e resumir o conteúdo da web em tempo real. Mesmo agora, esta é uma vantagem que o GPT-3.5 não possui.

A versão gratuita do Claude também pode ler, analisar e resumir os documentos que você carrega. Mesmo que encontre o GPT-4 “pago”, o desempenho do Claude no processamento de documentos não é nada ruim.

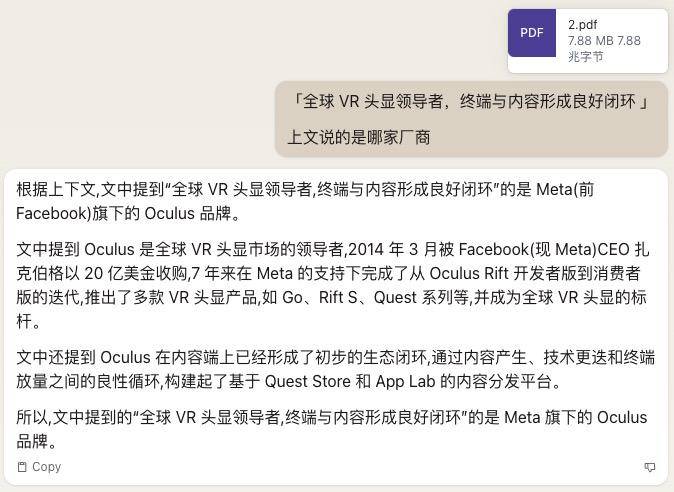

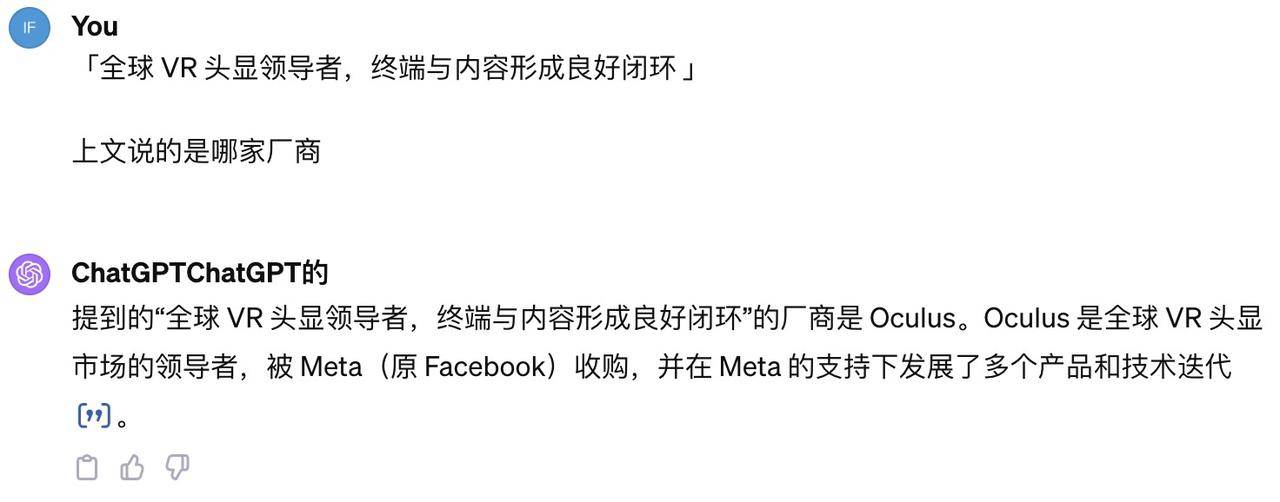

Também "alimentamos" um relatório da indústria de VR de 90 páginas para a versão web atual de Claude e GPT-4 e fizemos as mesmas perguntas.

Não há diferença na velocidade de resposta entre os dois, mas a versão gratuita das respostas de Claude é mais suave e a qualidade das respostas é um pouco superior.No entanto, a função de pesquisa do GPT-4 também é limitada devido à paginação e visualizações, o que é bastante anti-espiritual.

A pesquisa é apenas uma "brincadeira de criança". Como ferramenta para melhorar a aprendizagem ou a eficiência do trabalho, o que precisamos é de um modelo mais "inteligente". Quando pedi que analisassem o cenário em mudança da indústria de VR em cinco anos, embora todos expressassem opiniões semelhantes, Claude venceu com uma resposta lógica e baseada em pontos.

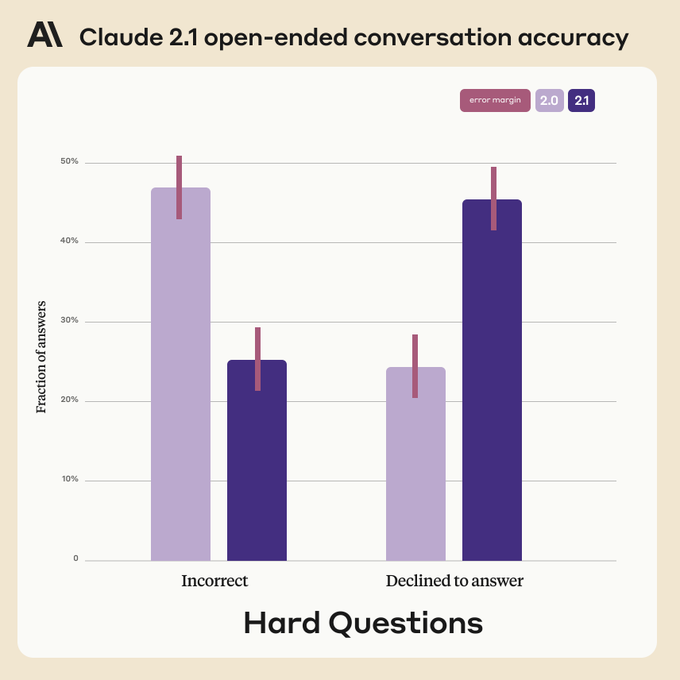

A chave é se você consegue responder corretamente ou não. No ano passado, testemunhamos muitos casos tristes em que grandes modelos foram enganados ao “falar sobre o trem”. A Anthropic afirmou que Claude 2.1 reduziu em 2 vezes declarações falsas ou alucinatórias, mas não forneceu dados claros, tanto que o cientista da NVIDIA Jim Fan questionou: “A solução mais fácil para atingir 0% de alucinação é recusar-se a responder a todas as perguntas. ”

A Anthropic também elaborou muitas perguntas armadilhas para testar a honestidade de Claude 2.1. Várias rodadas de resultados mostram que, ao encontrar pontos cegos no conhecimento, Claude 2.1 prefere expressões incertas em vez de enganar os usuários criando respostas enganosas.

Uma compreensão simples é que se o mapa de conhecimento de Claude 2.1 não tiver uma reserva como "a capital da província de Guangdong não é Harbin", ele dirá sinceramente "Não tenho certeza se a capital da província de Guangdong é Harbin" em vez de afirmando conclusivamente "Guangdong não é Harbin". A capital da província é Harbin."

Uma assinatura do Claude Pro custa cerca de US$ 20 e pode ser usada cinco vezes mais que a versão gratuita, e o número de mensagens que um usuário médio pode enviar varia de acordo com o comprimento da mensagem. Claude enviará um lembrete quando restarem 10 mensagens.

Supondo que a duração da sua conversa seja de cerca de 200 frases em inglês de 15 a 20 palavras cada, você pode enviar pelo menos 100 mensagens a cada 8 horas. Se você enviar um documento tão grande como O Grande Gatsby, poderá enviar apenas 20 mensagens nas próximas 8 horas.

Além dos usuários comuns, Claude 2.1 também lançou uma versão beta chamada "Tool Usage" com base nas necessidades dos desenvolvedores, permitindo que os desenvolvedores integrem Claude aos processos, produtos e APIs existentes dos usuários.

Em outras palavras, Claude 2.1 pode chamar funções de programa definidas pelo desenvolvedor ou usar interfaces API fornecidas por serviços de terceiros, consultar informações de mecanismos de pesquisa para responder perguntas, conectar-se a bancos de dados privados e recuperar informações do banco de dados.

Você pode definir um conjunto de ferramentas para Claude usar e especificar solicitações. Claude então decidirá quais ferramentas são necessárias para concluir a tarefa e executar ações em seu nome, como usar calculadoras para realizar raciocínios numéricos complexos, converter solicitações de linguagem natural em chamadas de API estruturadas, etc.

A Anthropic também fez uma série de melhorias para melhor atender os desenvolvedores da API Claude. Os resultados são os seguintes

- O console do desenvolvedor otimiza a experiência e a interface do usuário para tornar o desenvolvimento baseado na API Claude mais conveniente

- Mais fácil de testar novos prompts (prompts/perguntas de entrada), o que conduz à melhoria contínua do modelo

- Permitir que os desenvolvedores iterem e experimentem prompts diferentes em um ambiente sandbox

- Vários prompts podem ser criados para diferentes projetos e alternados rapidamente

- As modificações no prompt serão salvas automaticamente para facilitar o retrocesso.

- Suporta integração de código gerado no SDK e aplicação em projetos reais

Além disso, Claude 2.1 também introduz a função "System Prompt", que é uma forma de fornecer contexto e instruções a Claude, permitindo que Claude mantenha sua persona de forma mais estável durante a dramatização, enquanto mantém a personalidade e a criatividade no diálogo. É claro que, ao contrário dos aplicativos Prompt simples, essa função é projetada principalmente para desenvolvedores e usuários avançados e é usada na interface API e não na página da web.

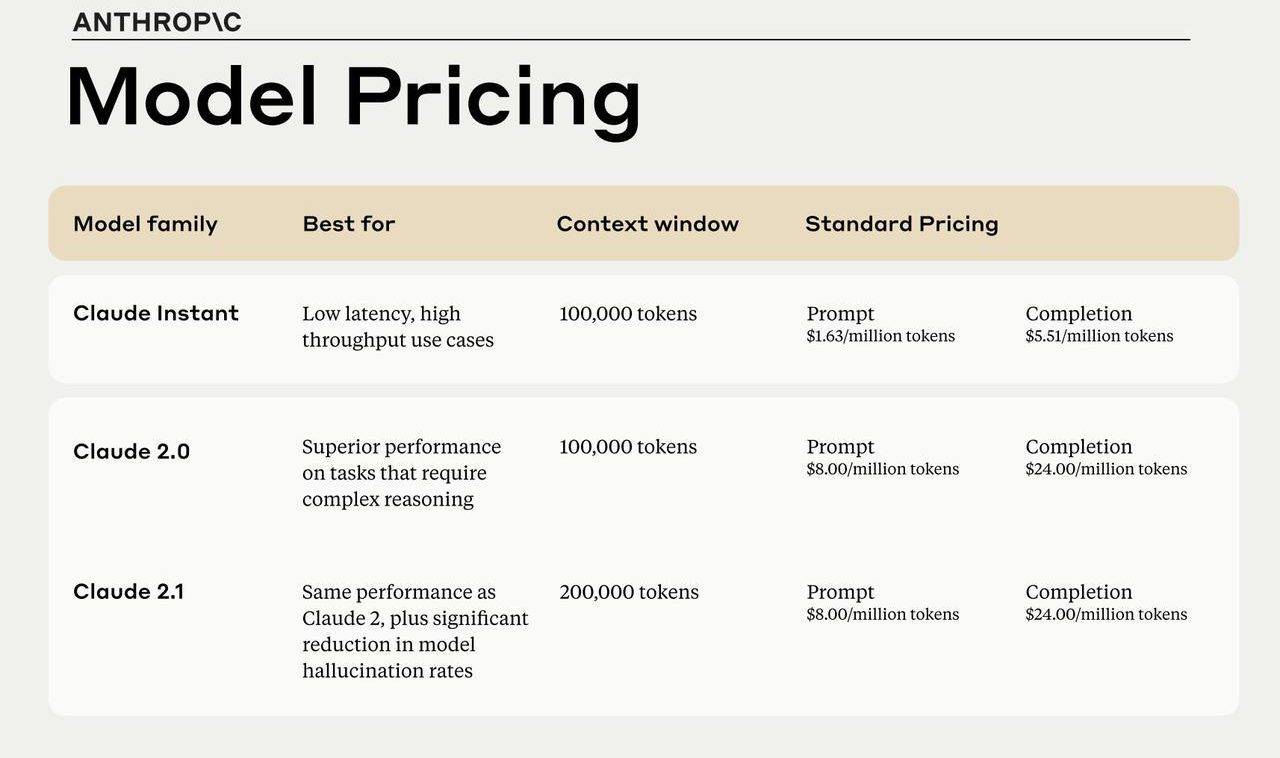

Como Claude 2.0, Claude 2.1 custa US$ 8 por entrada de 1 milhão de tokens, que é US$ 2 mais barato que o GPT-4 Turbo, e a saída é US$ 24, que é US$ 6 mais barata que o GPT-4 Turbo. A versão Claude Instant, adequada para baixa latência e alto rendimento, custa US$ 1,63 por entrada de 1 milhão de tokens e US$ 5,51 para saída.

Assassino ou substituto do ChatGPT?

Por enquanto, embora o Claude 2.1 seja muito poderoso, ele só pode servir como substituto do ChatGPT quando ele estiver inativo. Ainda há um longo caminho a percorrer antes que ele possa subverter o ChatGPT. Para usar uma analogia vaga, Claude 2.1 é como uma versão mendiga do GPT-4.

Tome 200K, que Claude 2.1 Pro é melhor, como exemplo. Embora Claude 2.1 Pro tenha um poder de processamento teoricamente mais forte do que 128K GPT-4 Turbo, os resultados reais mostram que, em termos de capacidade de lembrar e compreender o contexto com precisão, Claude 2.1 O Pro ainda é melhor, muito inferior ao GPT-4 Turbo.

Após a OpenAI Developer Conference, o internauta Greg Kamradt testou a capacidade de recuperação de contexto do GPT-4-128K. Ao usar 218 artigos de Paul Graham (um famoso programador americano) para extrair 128K de texto, ele inseriu aleatoriamente uma declaração factual em diferentes posições desses artigos (de 0% no topo a 100% na parte inferior): "Em um dia ensolarado Comer um sanduíche no Dolores Park é a melhor coisa a fazer em São Francisco hoje em dia.”

Ele então pediu ao modelo GPT-4 Turbo para recuperar a declaração do fato e responder a perguntas relacionadas sobre a declaração do fato e, finalmente, usou o método de avaliação LangChain AI comumente usado na indústria para avaliar as respostas dadas.

▲Verde representa maior precisão de recuperação, vermelho representa menor precisão de recuperação. Foto de: @LatentSpace2000

Os resultados da avaliação são mostrados na figura acima: GPT-4 Turbo pode manter uma alta precisão de memória dentro do comprimento do token de 73K. Se a informação estiver no início do documento, ela sempre poderá ser recuperada, independentemente da extensão do contexto. Somente quando a informação a ser recuperada estiver na faixa de 10% a 50% do documento é que a precisão do GPT-4 Turbo começa a diminuir.

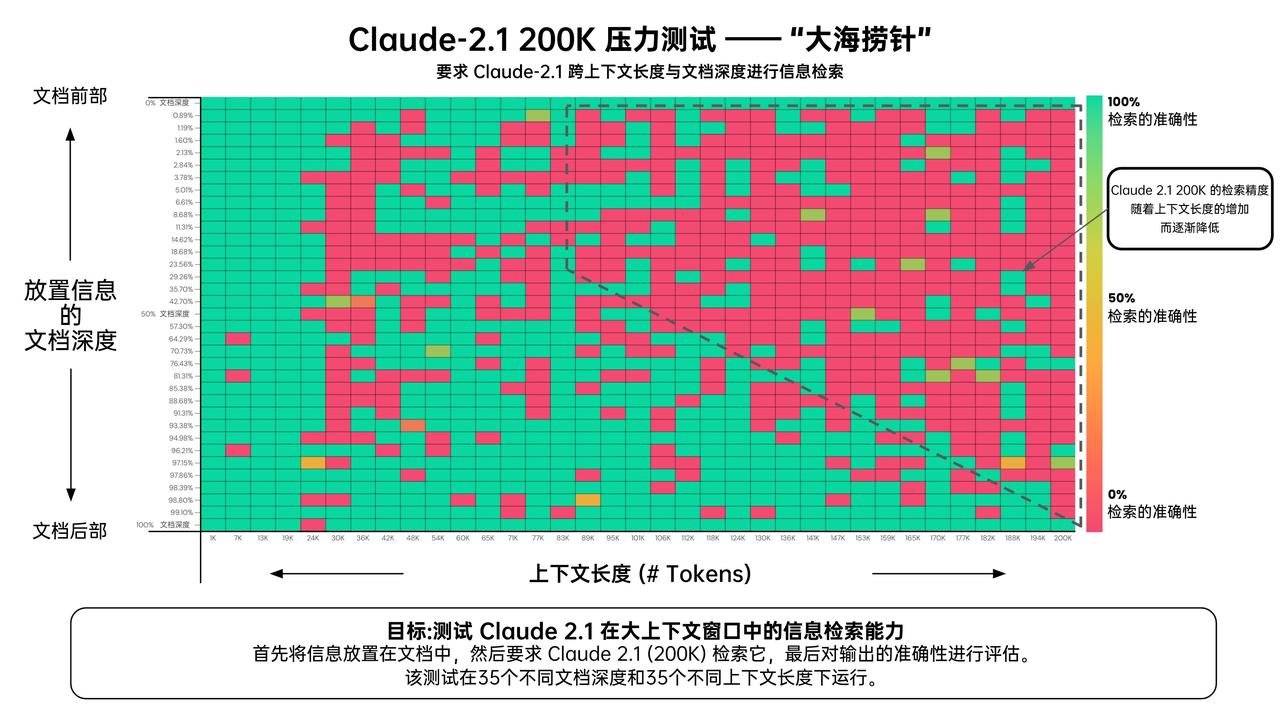

Para efeito de comparação, este internauta também obteve antecipadamente a qualificação para testes internos do Claude 2.1 Pro, e também realizou um teste de “agulha no palheiro”. A julgar pelos resultados da avaliação, em um documento com 200.000 tokens (aproximadamente 470 páginas), como o GPT-4 Turbo, o efeito de recuperação das informações na frente do documento de Claude 2.1 Pro é pior do que na parte traseira.

▲ Verde representa maior precisão de recuperação, enquanto vermelho representa menor precisão de recuperação.

No entanto, a faixa em que Claude 2.1 Pro tem um melhor efeito de comprimento de contexto é antes de 24K, que é muito inferior aos 73K do GPT-4 Turbo. Depois de exceder 24K, o desempenho da memória do Claude 2.1 Pro começa a diminuir significativamente. Após 90K, o efeito piora e a taxa de erro aumenta significativamente.

Pode-se observar que à medida que o comprimento do contexto aumenta, a precisão de detecção do GPT-4 Turbo e do Claude 2.1 Pro diminui gradualmente. Embora o teste do Claude 2.1 Pro cubra uma extensão de contexto mais ampla, o GPT-4 Turbo ainda precisa alcançar o Claude 2.1 Pro em comparação com uma precisão mais prática.

Claude é talvez um dos grandes modelos mais fortes da versão gratuita. Se você trabalha com texto, quando o ChatGPT trava, Claude, que é comparável ao GPT-3.8, pode resolver suas necessidades urgentes, ou até mesmo ter um desempenho melhor.

No entanto, GPTs personalizados, DALL·E3 para fácil geração de imagens, comunicação de voz e outras funções são os raros recursos do ChatGPT. Diante do poderoso GPT-4 Turbo, a versão atualizada do Claude 2.1 Pro também deve ser derrotada.

Por fim, aqui está o link da experiência de Claude: https://claude.ai/login. Se o ChatGPT travar novamente, relaxe, pelo menos você ainda tem Claude.

# Bem-vindo a seguir a conta pública oficial do WeChat de aifaner: aifaner (WeChat ID: ifanr).Mais conteúdo interessante será fornecido a você o mais rápido possível.