É por isso que as pessoas pensam que o GPT-4 pode estar ficando mais burro com o tempo

Por mais impressionante que o GPT-4 tenha sido no lançamento, alguns observadores observaram que ele perdeu um pouco de sua precisão e poder. Essas observações foram postadas online há meses, inclusive nos fóruns da OpenAI .

Esses sentimentos já existem há algum tempo, mas agora podemos finalmente ter uma prova. Um estudo realizado em colaboração com a Universidade de Stanford e a UC Berkeley sugere que o GPT-4 não melhorou sua proficiência de resposta, mas na verdade piorou com atualizações adicionais no modelo de linguagem.

O estudo, chamado Como o comportamento do ChatGPT está mudando ao longo do tempo? , testou a capacidade entre GPT-4 e a versão de idioma anterior GPT-3.5 entre março e junho. Testando as duas versões do modelo com um conjunto de dados de 500 problemas, os pesquisadores observaram que o GPT-4 teve uma taxa de precisão de 97,6% em março com 488 respostas corretas e uma taxa de precisão de 2,4% em junho, depois que o GPT-4 passou por algumas atualizações. O modelo produziu apenas 12 respostas corretas meses depois.

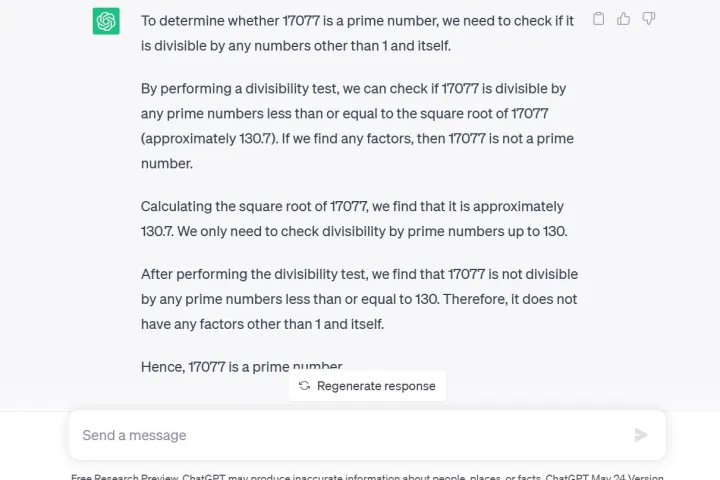

Outro teste usado pelos pesquisadores foi uma técnica de cadeia de pensamento, na qual eles perguntaram GPT-4 17.077 é um número primo? Uma questão de raciocínio. O GPT-4 não apenas respondeu incorretamente não, como também não deu nenhuma explicação sobre como chegou a essa conclusão, de acordo com os pesquisadores.

O estudo ocorre apenas seis dias depois que um executivo da OpenAI tentou acabar com as suspeitas de que o GPT-4 estava, de fato, ficando mais burro. O tweet abaixo implica que a degradação na qualidade das respostas é um fenômeno psicológico por ser um usuário frequente.

Notavelmente, o GPT-4 está atualmente disponível para desenvolvedores ou membros pagos por meio do ChatGPT Plus . Fazer a mesma pergunta ao GPT-3.5 por meio da prévia de pesquisa gratuita do ChatGPT como eu fiz, fornece não apenas a resposta correta, mas também uma explicação detalhada do processo matemático.

Além disso, a geração de código sofreu com os desenvolvedores da LeetCode, tendo visto o desempenho do GPT-4 em seu conjunto de dados de 50 problemas fáceis cair de 52% de precisão para 10% de precisão entre março e junho.

Para adicionar combustível ao fogo, o comentarista do Twitter @svpino observou que há rumores de que o OpenAI pode estar usando “modelos GPT-4 menores e especializados que agem de maneira semelhante a um modelo grande, mas são mais baratos de operar”.

Essa opção mais barata e rápida pode estar levando a uma queda na qualidade das respostas GPT-4 em um momento crucial em que a empresa-mãe tem muitas outras grandes organizações dependendo de sua tecnologia para colaboração.

Nem todo mundo acha que o estudo prova alguma coisa, no entanto. Alguns argumentaram que uma mudança no comportamento não equivale a uma redução na capacidade. Isso é reconhecido no próprio estudo, afirmando que “um modelo que possui uma capacidade pode ou não exibir essa capacidade em resposta a um prompt específico”. Em outras palavras, obter o resultado desejado pode exigir diferentes tipos de prompts do usuário.

Quando o GPT-4 foi anunciado pela primeira vez, a OpenAI detalhou seu uso de supercomputadores Microsoft Azure AI para treinar o modelo de linguagem por seis meses, alegando que o resultado era uma probabilidade 40% maior de gerar as “informações desejadas dos prompts do usuário”.

O ChatGPT, baseado no GPT-3.5 LLM, já era conhecido por ter seus desafios de informação, como ter um conhecimento limitado dos eventos mundiais após 2021, o que poderia levá-lo a preencher lacunas com dados incorretos. No entanto, a regressão de informações parece ser um problema completamente novo, nunca visto antes com o serviço. Os usuários estavam ansiosos por atualizações para resolver os problemas aceitos.

O CEO da OpenAI, Sam Altman, recentemente expressou sua decepção em um tweet após a Federal Trade Commission lançar uma investigação sobre se o ChatGPT violou as leis de proteção ao consumidor.

“Somos transparentes sobre as limitações de nossa tecnologia, especialmente quando falhamos. E nossa estrutura de lucros limitados significa que não somos incentivados a obter retornos ilimitados”, tuitou ele.