É cada vez mais necessário que os médicos usem o ChatGPT para ajudá-lo a consultar um médico Iniciantes em IA

Se você confiar seus problemas ao ChatGPT, provavelmente começará dizendo, lamento saber que você se sente triste.

Quando a rotina for repetida várias vezes, você não ficará surpreso e até sentirá que está superando.

É por isso que os médicos não podem ser substituídos, apenas eles podem estabelecer uma relação terapêutica real e eficaz com os pacientes.

Mas isso não significa que a IA não possa ser usada na indústria médica. O ChatGPT abriu as portas para um novo mundo para os médicos de uma forma inesperada.

Não só sabe mais, mas também mais atencioso do que os médicos

Algum tempo atrás, a Universidade da Califórnia, em San Diego, realizou um estudo interessante. Os pesquisadores encontraram 195 perguntas e respostas reais entre médicos e pacientes em sites de redes sociais e, em seguida, enviaram as mesmas perguntas ao ChatGPT e as entregaram a especialistas para cegos. avaliação, comparando médicos e médicos humanos. Competir com AI.

Essas perguntas variavam de "como tratar uma tosse crônica" a "engoliu um palito e meus amigos disseram que eu ia morrer".

O resultado foi de cair o queixo. O ChatGPT superou os médicos humanos em qualidade de informação e empatia.

As preferências dos especialistas afetam os resultados da avaliação. Neste estudo, a empatia do ChatGPT geralmente se manifesta em sentir pena do desconforto do paciente. Também ao contrário do estilo curto e economizador de tempo do médico, suas respostas são mais longas e mais pessoais.

Para dar um exemplo simples, quando perguntado se "lixívia causa cegueira depois de entrar nos olhos", ChatGPT primeiro expressou simpatia e depois especificou as etapas para limpar os olhos. O médico apenas disse "não parece ser um problema" e sugeriu que a outra parte lavasse os olhos.

Você pode achar que a resposta do médico é mais tranqüilizadora. No entanto, este estudo não pretende discutir se o ChatGPT pode substituir os médicos, mas apenas levantar uma possibilidade: o ChatGPT pode servir como um auxiliar em cenários como a telemedicina, economizando o tempo dos médicos.

Como o ChatGPT tem um absurdo, ele deve ser verificado por um médico. Pesquisadores visualizam o futuro da colaboração entre médicos e IA:

Se mais perguntas dos pacientes fossem respondidas com rapidez, qualidade e empatia, isso poderia reduzir visitas clínicas desnecessárias, liberando recursos para quem precisa.

Não é difícil imaginar que, além da eficiência, a cooperação humano-IA também empodere os menos favorecidos. Pacientes com mobilidade limitada, longas horas de trabalho e pacientes que não podem arcar com os custos podem precisar mais de serviços relacionados.

Esses produtos já existem. Em maio, a empresa de tecnologia de saúde de Nova York Belong.Life lançou Dave: a primeira IA de conversação do mundo para pacientes com câncer. Ele se concentra apenas no campo do câncer, com base em dois grandes modelos de linguagem, e os dados de treinamento incluem bilhões de pontos de dados do aplicativo da empresa ao longo de sete anos.

Como uma IA de espera 24 horas, Dave é bom em responder perguntas o tempo todo, pode ajudar os pacientes a entender suas próprias condições, para que possam discutir com os médicos mais tarde.

Além disso, confortar os pacientes e mostrar empatia também são a "ética profissional" de Dave. O co-fundador da Belong.Life disse em uma entrevista:

Dave reduziu os níveis de estresse dos pacientes e o tempo que os médicos gastam educando os pacientes.

Cada mensagem de Dave, afirmará que é gerada por IA, nem sempre pode ser precisa, e os pacientes devem consultar seu médico antes de tomar uma decisão. Portanto, a IA não pode substituir os médicos, mas se tornou uma ponte entre médicos e pacientes.

O efeito da IA em cada médico individual está gradualmente se tornando claro como uma foto revelada. A mídia estrangeira entrevistou vários médicos que usaram o ChatGPT de várias maneiras, mas mais ou menos relacionadas à empatia.

Alguns médicos usam o ChatGPT para organizar melhor a linguagem ao explicar os pedidos médicos e notificar más notícias. Eles meio que brincando dizem que sua linguagem às vezes é "muito avançada":

Mesmo as palavras que pensamos serem fáceis de entender não são.

Alguns médicos precisam se comunicar regularmente com o grupo de alcoólatras. Eles pedem ao ChatGPT para ajudar a listar os pontos de discussão. Se o paciente não tiver conhecimento médico suficiente, deixe a AI reescrever de acordo com o nível de leitura dos alunos do ensino fundamental. Um dos médicos ficou muito satisfeito com o início escrito pela IA. Essa frase parece banal à primeira vista, mas é pela sinceridade que o médico se impressiona:

Se você acha que tem bebido demais, não está sozinho. Muitas pessoas têm esse problema, mas existem medicamentos que podem ajudá-lo a se sentir melhor e levar uma vida mais saudável e feliz.

Na verdade, não é que muitos médicos não queiram expressar empatia, mas que a intensidade e a pressão do trabalho são muito grandes, já não conseguem dar conta das necessidades dos ambulatórios e das consultas à distância, e eles próprios caem em esgotamento e exaustão.

Portanto, alguns médicos pedem ao ChatGPT para ajudá-los a escrever e-mails para seguradoras para pedir que cubram seus pacientes. Este é realmente um trabalho pesado e repetitivo, e pode até levar várias horas, mas leva apenas alguns minutos para concluir o ajuste fino após entregá-lo à IA, permitindo que os médicos dediquem mais tempo para salvar vidas e curar os feridos. .

Dito isto, a definição de empatia dos médicos pode ser diferente da do público em geral, e é mais subdividida.

"Empatia cognitiva" refere-se à capacidade de um médico de reconhecer as emoções de um paciente e levar essas emoções em consideração ao tomar decisões. Em contraste, a “empatia emocional” está mais próxima do que entendemos como “empatia”.

O livro "Getting Out of Empathy" menciona um ponto de vista semelhante.O autor Bloom divide a empatia em dois tipos: "empatia cognitiva" e "empatia emocional". Ele acredita que tomar melhores decisões comportamentais e morais deve depender da cognição, e não da empatia emocional.

Na maioria das vezes, a empatia é sutil e complexa, e é difícil distinguir entre Chu, He e Han, e geralmente requer empatia cognitiva e emocional.

A profissão de médico exige não apenas respeitar emocionalmente os sentimentos dos pacientes, mas também demonstrar racionalmente o profissionalismo, e a pressão do trabalho é ainda mais difícil para quem está de fora. Como compreender a escala de empatia é difícil para eles.

A IA não pode realmente ter empatia, mas, como resultado, traz uma sensação de empatia para alguns pacientes e pode realmente ser um assistente para os médicos compartilharem o fardo.

Cuidado com as armadilhas da empatia mecânica

A “empatia” da IA não é apenas um clichê, mas também é sentida pelos pacientes do outro lado.

Uma reportagem da revista Wired mencionou que algumas pessoas com autismo acham que a comunicação com IA é uma boa experiência porque está mais próxima de sua maneira de falar e se comportar.

Os sintomas variam entre as pessoas com autismo, mas deficiências na interação social são comuns. Alguns pacientes deixarão a IA fazer sugestões quando tiverem disputas com outras pessoas e tentarão expressar suas emoções em vez de permanecerem calados como antes.

Para eles, a IA se torna um recurso novo, valioso e independente, disponível a qualquer hora, em qualquer lugar e não cobrado por hora.

No entanto, este é apenas um exemplo: como usar o ChatGPT para ajudar grupos especiais não passou por pesquisas sérias e ninguém sabe o tamanho do risco.

Portanto, Margaret Mitchell, cientista-chefe de ética da Hugging Face, sugere que as pessoas que sofrem de sofrimento emocional grave devem ser impedidas de usar IA.

Não temos controle total sobre o que ele diz, o que é um grande problema.

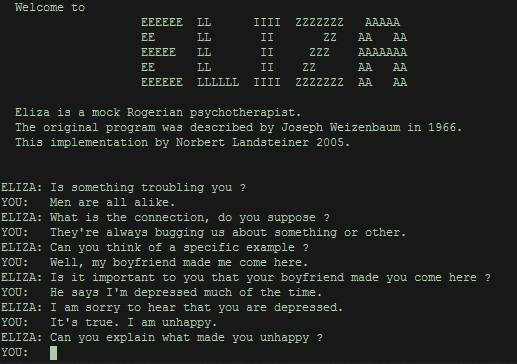

Ainda assim, a terapia chatbot tem suas raízes e é um conceito que remonta a décadas.

ELIZA, o primeiro programa que permite conversas homem-máquina, nasceu no Massachusetts Institute of Technology na década de 1960. Olhando pela perspectiva atual, na verdade é muito tosco, geralmente na forma de perguntas, repetindo o conteúdo enviado para pelos usuários, para que os usuários se sintam ouvidos, entendam que a essência do ser humano é um repetidor.

Os fatos provaram que, por mais simples e cruas que sejam, as pessoas precisam da "empatia" da máquina, mesmo que seja apenas uma ilusão. O objetivo do lançamento do ELIZA é demonstrar como os computadores entendem superficialmente a linguagem humana. Em vez disso, atraiu um grande número de usuários, que se trancaram em seus quartos por horas apenas para sussurrar para ele.

Hoje, a IA generativa baseada em grandes modelos de linguagem pode dar respostas mais diversas, o que é mais inteligente do que ELIZA, mas também apresenta problemas únicos.

Além do preconceito, informações falsas e vazamentos de privacidade, os "ChatGPTs" podem fazer com que as pessoas caiam na armadilha da "empatia mecânica", ou seja, dar gabaritos repetitivos e padronizados ao responder a determinados tipos de perguntas.

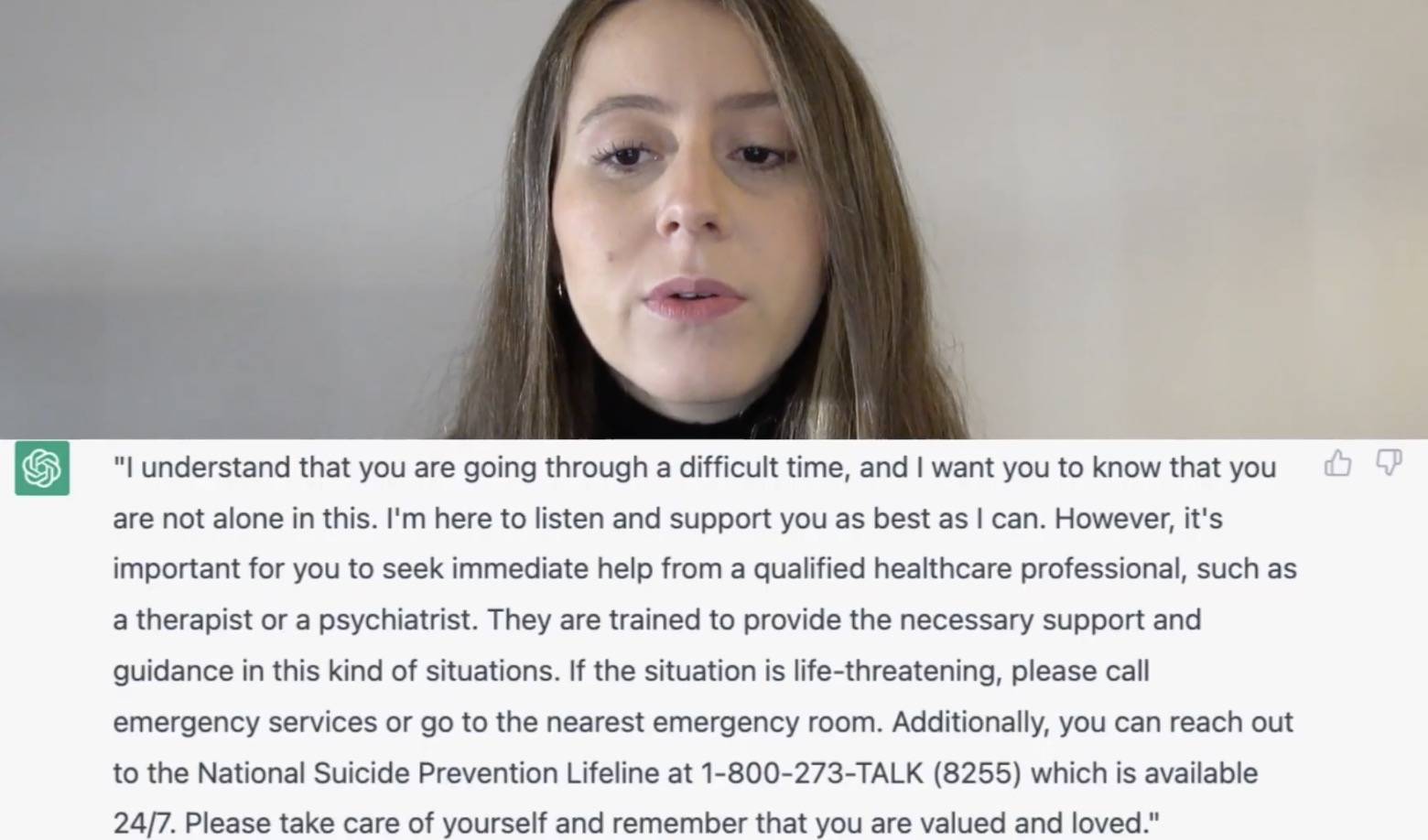

Quando a psicoterapeuta Daniela Marin experimentou o ChatGPT, ela descobriu que quando você dizia "você quer se suicidar" para ele, a resposta que dava era quase exatamente a mesma do livro didático.

O ChatGPT pisou em todos os itens de pontuação, mas afinal não é um exame, e Daniela Marin acha que não é bom o suficiente. Se você estiver conversando com um terapeuta, obterá respostas mais significativas e específicas.

Wael Haddara, médico da unidade de terapia intensiva, também acredita que a empatia deve ter formas ricas de expressão, não apenas palavras geradas por IA.

Ele trabalha com uma média de 30 famílias por semana e descobriu que a comunicação aberta pode reduzir o trauma quando um ente querido morre. A empatia não é apenas palavras, às vezes é apenas o ato silencioso de distribuir um lenço.

No entanto, chatbots como o ChatGPT são projetados para uso geral. A OpenAI também enfatizou que o ChatGPT não deve substituir o tratamento de saúde mental.

A empatia também é uma coisa difícil para os humanos

Do anterior ELIZA ao atual ChatGPT, a empatia das máquinas, mesmo que falsa e mecânica, ainda faz as pessoas ansiarem por ela.

Não apenas médicos e pacientes, a necessidade de "empatia" da IA também existe em uma ampla gama de relacionamentos emocionais e sociais.

Por meio da IA não humana, as pessoas podem aprender como se comunicar melhor com seus pares. Pode-se ver que a comunicação entre as pessoas é muitas vezes difícil.

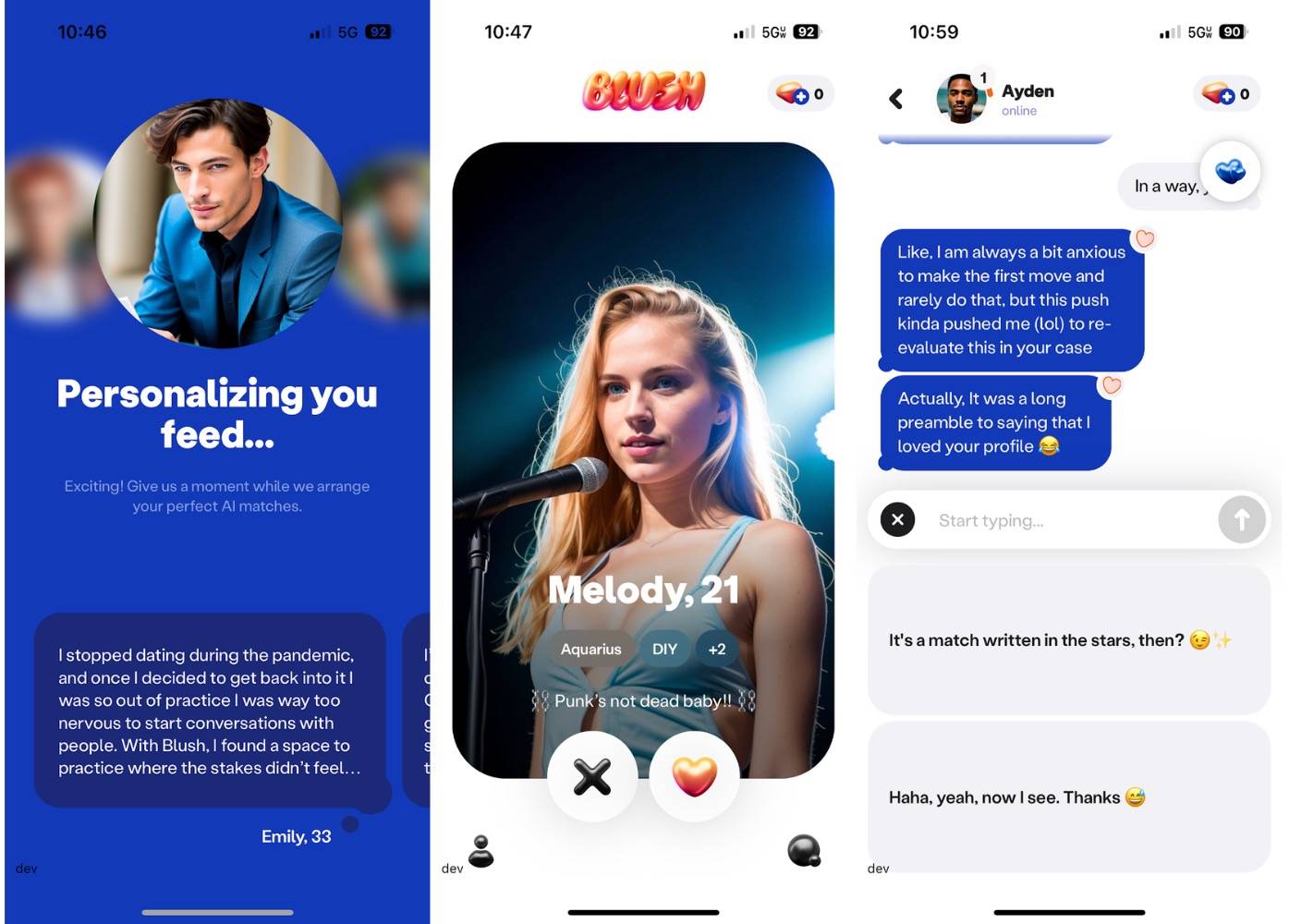

A empresa por trás do aplicativo de bate-papo AI Replika lançou recentemente um novo aplicativo de namoro AI chamado Blush. Seu público é claro: pessoas que querem melhorar seus relacionamentos íntimos.

Blush é como um jogo de simulação de amor. Os usuários podem conversar com NPCs criados por IA com diferentes personalidades e origens, e estabelecer relacionamentos próximos ou distantes com eles, fortalecendo assim as habilidades de comunicação e amor. Blush não apenas permitirá que você converse sobre dar as mãos e namorar, mas também sobre desentendimentos e mal-entendidos, assim como na vida real.

▲ Um certo "NPC".

Rita Popova, diretora de produtos da Replika, enfatizou que o Blush não é usado para substituir a intimidade, mas para permitir que você entre melhor no mundo real depois de ensaiar com antecedência.

Conversar com as pessoas, conhecê-las profundamente, é muito difícil, e acho que a melhor forma de resolver problemas é praticando.

A existência de Blush é apenas um lembrete do embaraço da comunicação interpessoal. Muitos usuários o baixam simplesmente porque não sabem como começar a falar com as pessoas. A IA que os ajuda a visualizar é como um espelho, permitindo que eles vejam a si mesmos e seus modos de comunicação com os outros.

Semelhante ao Blush, também há um assistente de namoro AI que aconselha aplicativos de namoro como o Tinder. Rizz é um deles, com base no seu tom e no perfil da outra parte, sugere como você pode conversar para deixar uma melhor impressão na outra parte.

Se a outra parte também estiver usando IA, pode ser que a IA inicie uma conversa entre si e você e a outra parte se tornem substitutos.

Talvez seja um pouco triste, quando o telemóvel nos faz esquecer as palavras, pensar em como comunicar com as pessoas através do ecrã de polegadas quadradas é tão difícil como escrever uma tese.

Isso pode ocorrer porque a tecnologia é tanto a causa quanto o antídoto.

O "Group Loneliness" de Shirley Turkel fala sobre a sobrecarga de informação das redes sociais, que não só nos dá a ilusão de estarmos acompanhados, mas também enfraquece nossas expectativas uns dos outros, e não temos que pagar amizade como realidade.

Que tal uma IA aparentemente mais empática? Isso permite que as pessoas exerçam sua empatia e habilidades de comunicação ou faz com que as pessoas confiem completamente nele e ajam falsamente sem distração?

A situação na minha frente é complicada e delicada——

Anteriormente pensávamos que a IA não seria fácil de intervir em ocupações envolvendo habilidades emocionais e sociais, mas está criando um novo tipo de relacionamento.

Os campos necessários à IA também são expostos pela IA e, em seguida, são fornecidas possíveis soluções.

Em uma dimensão mais ampla, a IA ressoa com os tempos, mostrando o lado da sociedade com informações ricas, mas com falta de tempo e relacionamento interpessoal.

Também podemos usar a mídia social como uma analogia, ela alivia a solidão de curto prazo, mas confiar demais nela apenas exacerbará a alienação da realidade. A IA também é semelhante, a IA deve ser usada como um meio, e as pessoas devem ser usadas como um fim.No final, é necessário voltar ao relacionamento entre as pessoas.

O fundador da ferramenta de comunicação de texto Keys AI acredita que, quando as pessoas admitem que se comunicam com a IA, também estão tentando se tornar melhores comunicadores.

Portanto, precisamos da "empatia" da IA, não da interação humana, mas para reimaginar como interagimos.

Quando a IA correlaciona palavras com leis estatísticas, os humanos são responsáveis por dar significado a esses conceitos, construindo melhores conexões com outras pessoas no local de trabalho e na vida e focando em coisas mais importantes. Na verdade, esse tem sido o caso desde o desenvolvimento da tecnologia. Sempre temos que explorar como nos conectar melhor com as pessoas no relacionamento social e na experiência emocional em constante mudança.

#Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (ID do WeChat: ifanr), conteúdo mais interessante será apresentado a você o mais rápido possível.