Contra-ataque Coreia N Sala 2.0! Quando as pessoas comuns são completamente derrotadas pela mudança de rosto da IA, elas usam magia para derrotar a magia

O recente incidente “Room N 2.0” na Coreia do Sul mais uma vez trouxe o tema comum do Deepfake para o primeiro plano.

Os perpetradores se reuniram no Telegram e usaram IA para sintetizar fotos femininas em fotos nuas, o que mostra que o círculo de deepfakes já se expandiu de estrelas do entretenimento e políticos para pessoas comuns como você e eu.

Nesta era em que a IA se tornou uma ciência proeminente, queremos compreender como esta tecnologia, que não parece nova, mas que se tornou cada vez mais popular nos últimos anos, afeta a vida quotidiana.

Até que ponto os deepfakes evoluíram e que danos causarão? Como usar a tecnologia para combater o Deepfake? Como as pessoas comuns evitam Deepfakes?

Conversamos sobre essas questões com o Dr. Chen Peng, cientista da Ruilai Intelligent Algorithm. A Ruilai Wisdom foi fundada em 2018 e incubada pelo Instituto de Pesquisa de Inteligência Artificial da Universidade de Tsinghua. Ela está profundamente envolvida na detecção de falsificações de IA há muitos anos.

Chen Peng nos disse que as pessoas comuns falharam miseravelmente na identificação do Deepfake, e o anti-Deepfake ainda depende da IA.

Uma foto, alguns segundos, Deepfake está cada vez mais fácil

O Deepfake surgiu pela primeira vez em 2017 no Reddit, a “versão americana do Tieba”. A principal forma é substituir rostos de celebridades por protagonistas de vídeos pornográficos, ou fazer paródia de figuras políticas.

Hoje, espalhar boatos e praticar pornografia ainda são os principais usos dos Deepfakes, mas acabaram de se tornar mais fáceis.

Chen Peng explicou que coletar uma foto é suficiente para mudar o rosto. É claro que quanto mais dados forem coletados, os detalhes do rosto, como manchas e características faciais, serão melhor modelados e mais realista será o efeito de mudança de rosto. .

Em abril deste ano, o projeto de arte performática de dois artistas alemães é um exemplo vivo.

Eles projetaram uma câmera AI NUCA. O corpo da câmera é impresso em 3D e possui uma lente grande angular de 37 mm integrada. As fotos tiradas serão transmitidas para a nuvem, onde a IA “tirará a roupa” e a foto será. ser "retirado" em menos de 10 segundos.

Na verdade, o NUCA não sabe a aparência do seu corpo nu. Ele apenas analisa seu sexo, rosto, idade, formato do corpo, etc. para apresentar seu corpo nu aos olhos da IA.

Duro? Talvez isso não importe. Em alguns segundos, você foi exposto à IA e outros podem acreditar que é você.

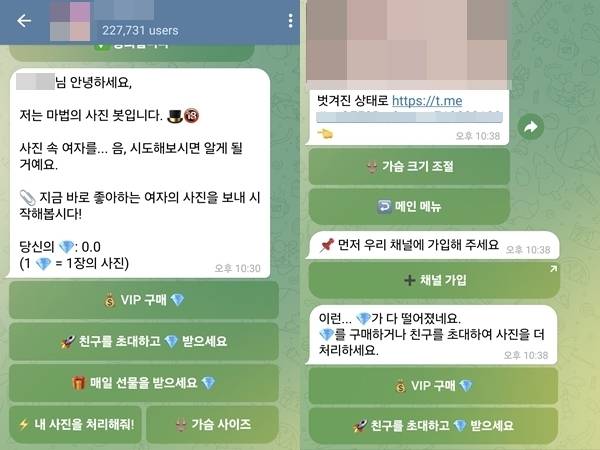

A "Room N 2.0" da Coreia do Sul também foi exposta com detalhes semelhantes: uma sala de bate-papo do Telegram com 227 mil pessoas, um robô embutido que sintetiza fotos femininas em fotos nuas e pode ajustar seios, além de gerar conteúdo deepfake em 5 a 7 segundos.

▲ Captura de tela da sala de bate-papo explicando como usar o Deepfake

Mudar de rosto e tirar a roupa são apenas uma das aplicações do Deepfake.

O uso de modelos generativos de IA (GAN, VAE, modelo de difusão, etc.) para sintetizar ou forjar conteúdo realista, incluindo texto, imagens, áudio e vídeo, pode ser chamado de Deepfake.

Entre eles, o áudio deepfake também é bastante comum.

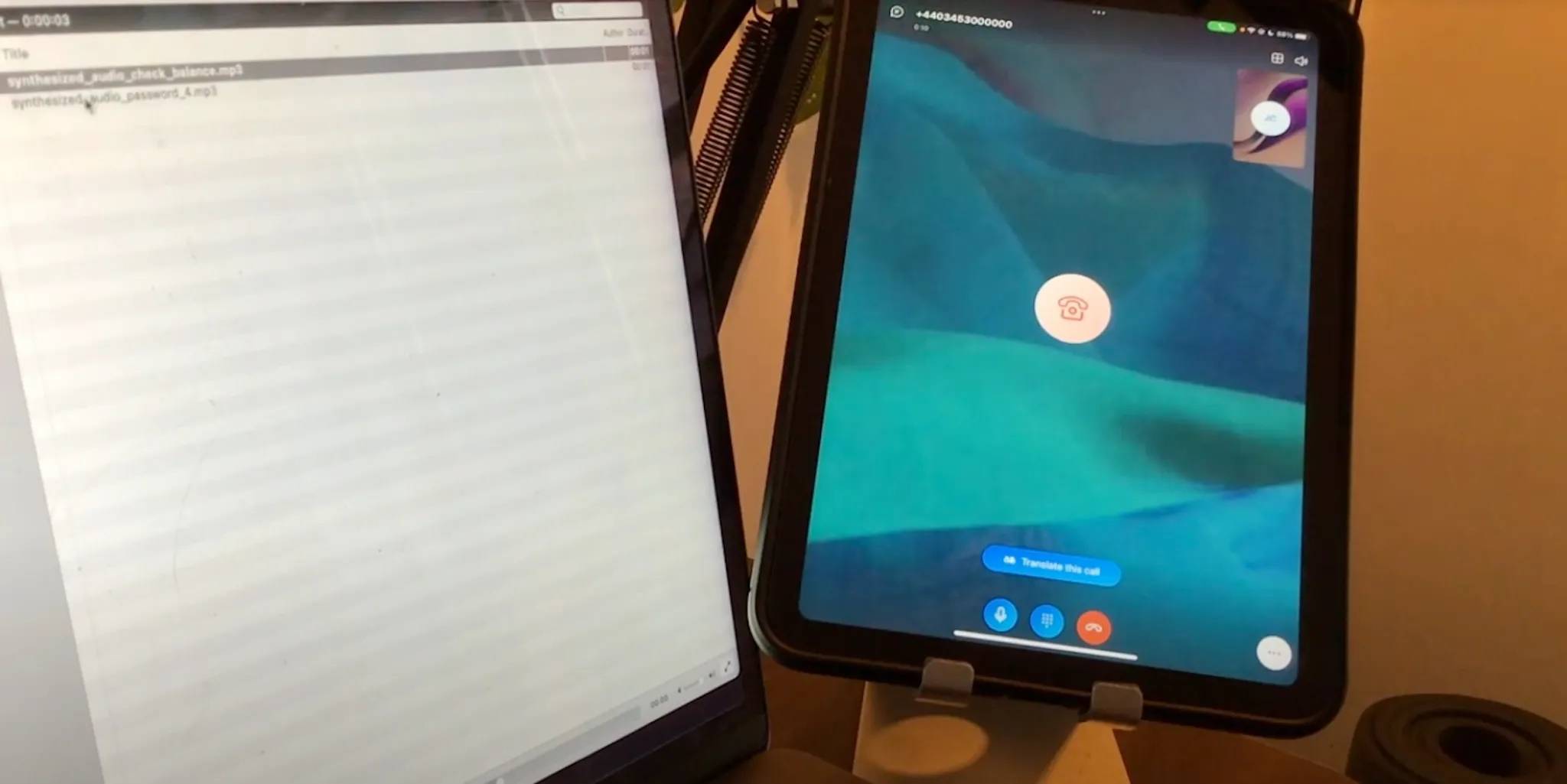

No início de 2023, o repórter de tecnologia Joseph Cox ligou para a linha direta de atendimento automatizado do banco, tocou a voz da IA "Minha voz é minha senha" que ele clonou com o ElevenLabs e pediu para verificar o saldo. Inesperadamente, a verificação de voz foi bem-sucedida.

Chen Peng disse que isso não é surpreendente. No passado, demorava vários minutos ou dezenas de minutos para capturar nossas informações de impressão de voz, mas agora elas podem ser capturadas aproximadamente em meio minuto ou dezenas de segundos. Se recebermos mais algumas ligações de assédio, nossas vozes poderão vazar.

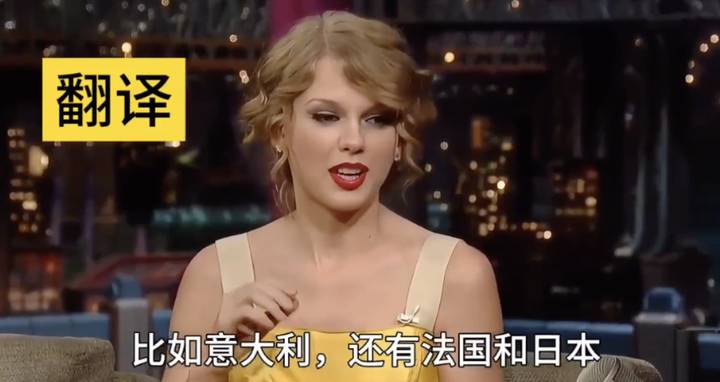

Claro, se você quiser clonar com mais precisão e copiar o tom e outros estilos de fala, como deixar Guo Degang falar em conversa cruzada em inglês ou deixar Swift falar chinês, você ainda precisará de mais corpus.

Até mesmo o texto é uma área profundamente falsificada. O texto gerado por IA é visto há muito tempo em todos os lugares e está causando dores de cabeça aos professores quando os alunos o utilizam para colar e fazer o dever de casa, mas podemos não estar cientes dos riscos por trás disso.

Notícias falsas e rumores são as áreas mais afetadas pelo deepfake de texto. Chen Peng disse que, no passado, os próprios humanos ainda precisavam escrever a cópia, mas agora a IA pode gerar vários comentários sobre um determinado evento e publicá-los automaticamente nas redes sociais. .

Deepfake é mais rápido e simples. Segundo Chen Peng, há três motivos principais.

Primeiro, houve avanços em tecnologias de IA generativa, como Vincent Pictures e Vincent Videos. Em segundo lugar, o poder da computação tornou-se cada vez mais popular e as placas gráficas de consumo já podem executar modelos de IA generativa.

Outro ponto muito importante é que a tecnologia Deepfake foi otimizada em diversas ferramentas com limites mais baixos.

Tomemos como exemplo a mudança de rosto. Existem muitos projetos de código aberto para Deepfake, como DeepFaceLive e Deep-Live-Cam no Github. Os usuários podem baixar o código do site e configurar o ambiente de execução localmente.

▲ Transmissão ao vivo de AI Musk, usando Deep-Live-Cam

Se os novatos que não entendem de tecnologia ainda acham difícil, também há profissionais que colocam o arroz diretamente na boca, encapsulam o modelo e o escrevem em um software simples e fácil de usar para os jogadores baixarem gratuitamente, e ganhe algumas taxas de publicidade por conta própria, incluindo muitos aplicativos de um clique para remoção.

Quanto ao deepfake de áudio, já existem empresas comerciais maduras que permitem aos usuários utilizar facilmente serviços na forma de SDK (kit de desenvolvimento) ou API (interface de programação de aplicativos).

Os usuários nem precisam de um dispositivo com placa gráfica para implantar o programa, mas sim fazer upload de conteúdo como áudio para o site, aguardar a geração dos resultados e baixá-los.

Portanto, princípios técnicos complexos estão escondidos nos bastidores, e o que está diante dos usuários são interfaces "prontas para uso". Até mesmo os adolescentes podem criar informações falsas à vontade.

Em poucas palavras, a conclusão de Chen Peng é:

Deepfake atingiu o ponto em que pessoas comuns podem obtê-lo facilmente.

Os humanos podem ter falhado completamente na identificação do Deepfake a olho nu

Quando uma tecnologia “voa para as casas das pessoas comuns”, as pessoas com maior probabilidade de serem afetadas são as pessoas comuns.

A fraude é uma das formas mais comuns pelas quais os Deepfakes fazem o mal.

No início deste ano, a sucursal de uma empresa multinacional em Hong Kong foi fraudada em 25 milhões de dólares devido à IA. A vítima participou de uma videoconferência e os demais eram fraudadores que haviam passado por “mudança de rosto de IA” e “mudança de voz de IA”.

▲ A polícia demonstrou como usar Deepfake para falsificar uma videoconferência com várias pessoas

Agora que as coisas chegaram a este ponto, o que podemos fazer para nos proteger?

Se alguém usa Deepfake para te enganar, aproveitar as brechas da IA é uma das maneiras, mas tem prazo de validade.

Por exemplo, durante uma videochamada, se suspeitarmos que o rosto da outra parte foi substituído por IA, podemos orientar a outra parte a realizar ações específicas, como colocar a mão na frente do rosto e deslizar algumas vezes rapidamente, ou virando a cabeça significativamente.

Se o modelo por trás da substituição facial por IA não for especificamente otimizado para oclusão da mão, ele ficará exposto e o rosto poderá aparecer nas costas da mão ou poderá ficar distorcido repentinamente.

O princípio de virar a cabeça é o mesmo. Se durante a fase de coleta de dados a outra parte não coletar deliberadamente o material de giro da cabeça superior a 45 graus, o ajuste facial não será natural.

Mas, no futuro, essas falhas visíveis a olho nu irão certamente diminuir gradualmente.

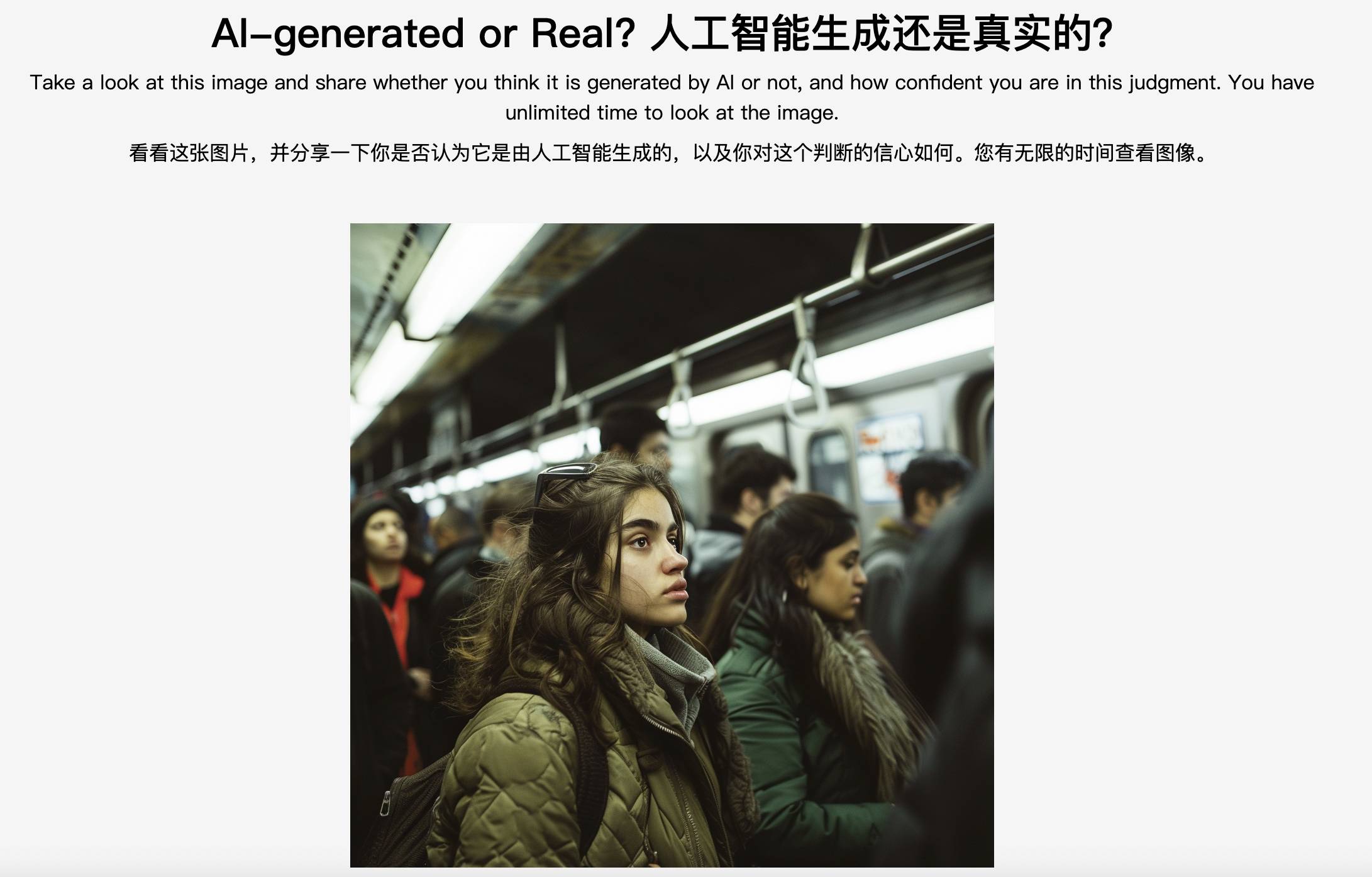

▲ Teste de “solução de problemas” da Northwestern University: gerado por IA ou real?

Chen Peng brincou que se os fraudadores pensam que você é uma ovelha gorda esperando para ser abatida e deliberadamente querem enganá-lo, retirar suas informações de mídia social e passar vários dias otimizando seu modelo, então esses métodos não têm garantia de eficácia.

Se um vídeo não apresenta essas falhas, isso significa que é um vídeo real? Isto não é verdade.

Quanto a ser eficaz ou não, certamente não pode ser completamente eficaz ou 100% eficaz, mas é eficaz até certo ponto.

Em termos mais profissionais, a percepção visual humana funciona muito bem no nível semântico, como ser capaz de distinguir facilmente o significado de objetos ou cenas, mas quando se trata de processar nuances de baixo nível no nível do pixel, a percepção a capacidade não é tão boa quanto a do modelo de IA.

Desta perspectiva, Chen Peng acredita que as pessoas comuns falharam miseravelmente em distinguir Deepfake. Os especialistas ainda podem ser capazes de lutar, porque viram muito e têm capacidades de análise relativamente abrangentes, e podem ver que algo não está em conformidade com as regras.

Nenhum de nós é Leeuwenhoek, nem temos olhos aguçados, mas a natureza humana permanece inalterada. Portanto, também podemos levantar a tradicional linha de defesa psicológica que nada tem a ver com tecnologia – tenha cuidado ao navegar.

Os golpes geralmente seguem o mesmo padrão: roubar privacidade, usar o medo, a ganância e o valor emocional para inventar histórias, fingir ser conhecidos ou se disfarçar para ganhar confiança, e o objetivo final é o dinheiro.

▲ O produto RealBelieve da Realai Smart emitirá avisos antecipados durante videochamadas.

Tenha isso em mente e fique mais atento. Não clique em links desconhecidos, não forneça códigos de verificação casualmente, tente não expor excessivamente seu rosto, voz, impressões digitais e outras informações biométricas pessoais na Internet, receba ligações suspeitas, e têm múltiplas opiniões quando se trata de dinheiro. Maneiras de verificar a identidade um do outro, como perguntar coisas que só um ao outro sabe.

Como diz o velho ditado, a melhor coisa a fazer é atacar o coração. Uma vez que percebemos que podemos ser enganados, podemos não ser enganados.

Magia versus magia, IA derrota IA

Aumentar a conscientização antifraude não é suficiente. O incidente “Room N 2.0” na Coreia do Sul mostra outra forma de maldade profunda. As pessoas estão sentadas em casa e as panelas vêm do céu.

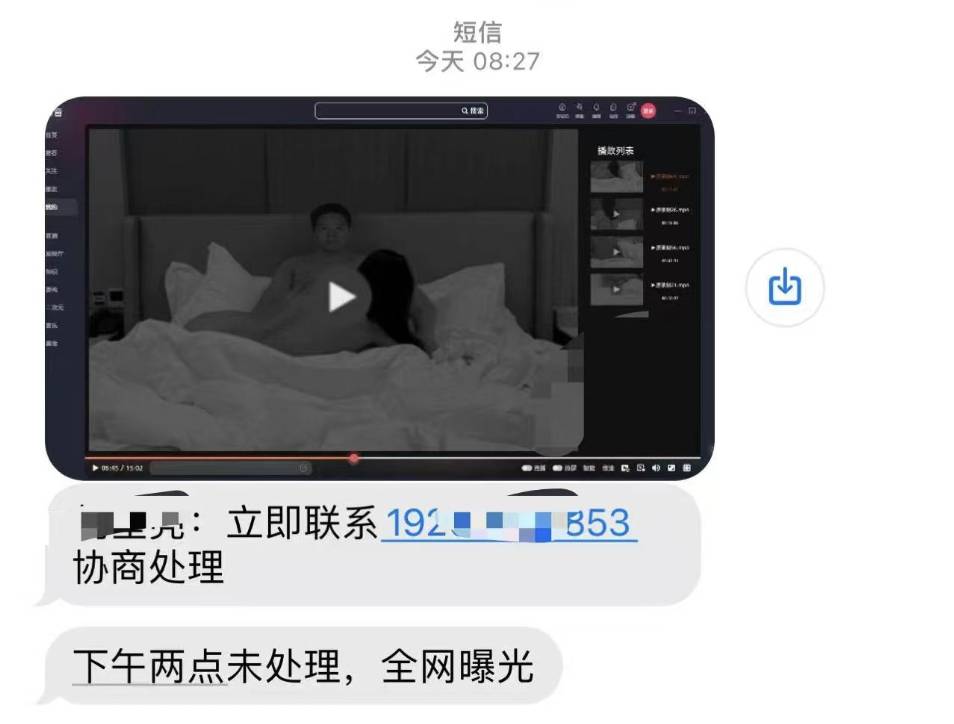

As vítimas de fotos falsas de nudez podem encontrar “pornografia de vingança” – os perpetradores ameaçam espalhar materiais falsos para chantagear e assediar as vítimas, causando danos secundários mais graves.

Mas essa foice também pode estar levantada sobre nossas cabeças: imagine que a gangue fraudulenta tirou suas fotos do nada, combinou-as em vídeos vulgares, enviou mensagens de texto para ameaçá-lo e, se você não transferir o dinheiro, ele será exposto em toda a Internet. Como você pode provar seu valor?

A sabedoria de Ruilai, onde Chen Peng trabalha, realmente encontrou esse tipo de assunto pessoal. A outra parte disse que seu rosto mudou em um vídeo e ele poderia ser inocentado?

Claro que existem maneiras: magia versus magia, IA derrotando a IA.

Chen Peng apresentou que existem duas rotas técnicas principais para a falsificação de IA: defesa ativa e detecção passiva.

Vamos falar primeiro sobre defesa ativa. Quando postamos fotos nas redes sociais e não queremos que elas sejam usadas por outras pessoas, podemos incorporar nelas algum ruído visualmente imperceptível.

Se outra pessoa usar nossas fotos para treinar o modelo, a IA não conseguirá extrair bem a representação visual devido a essa interferência invisível, e o resultado final poderá ficar distorcido ou desfocado. Isso é chamado de "ataque de amostra adversária". "

A "marca d'água semivulnerável" é outro método de defesa ativo. Após adicionar uma marca d'água, se outra pessoa editar nossa foto, a marca d'água será destruída e saberemos que a imagem foi processada e não é confiável.

As marcas d'água não podem impedir diretamente que as imagens sejam falsas, mas podem detectar e certificar a autenticidade das imagens.

▲Existem explorações semelhantes no exterior. A Adobe iniciou o padrão C2PA, usando parâmetros de metadados como forma de determinar a origem das imagens.

É claro que o limite para defesa ativa é maior, por isso precisamos tomar precauções antes que elas aconteçam e fazer algum processamento nas imagens com antecedência.

Uma situação mais comum é que não temos como prever. Recebemos “fotos nuas” de nós mesmos, mas também é a primeira vez que somos “francos” conosco mesmos. Neste momento, a detecção passiva deve ser usada.

A Realai Intelligence possui uma série de produtos de IA responsáveis por detectar falsificações, incluindo a plataforma generativa de detecção de conteúdo de IA DeepReal, o firewall de segurança de IA facial RealGuard e assim por diante.

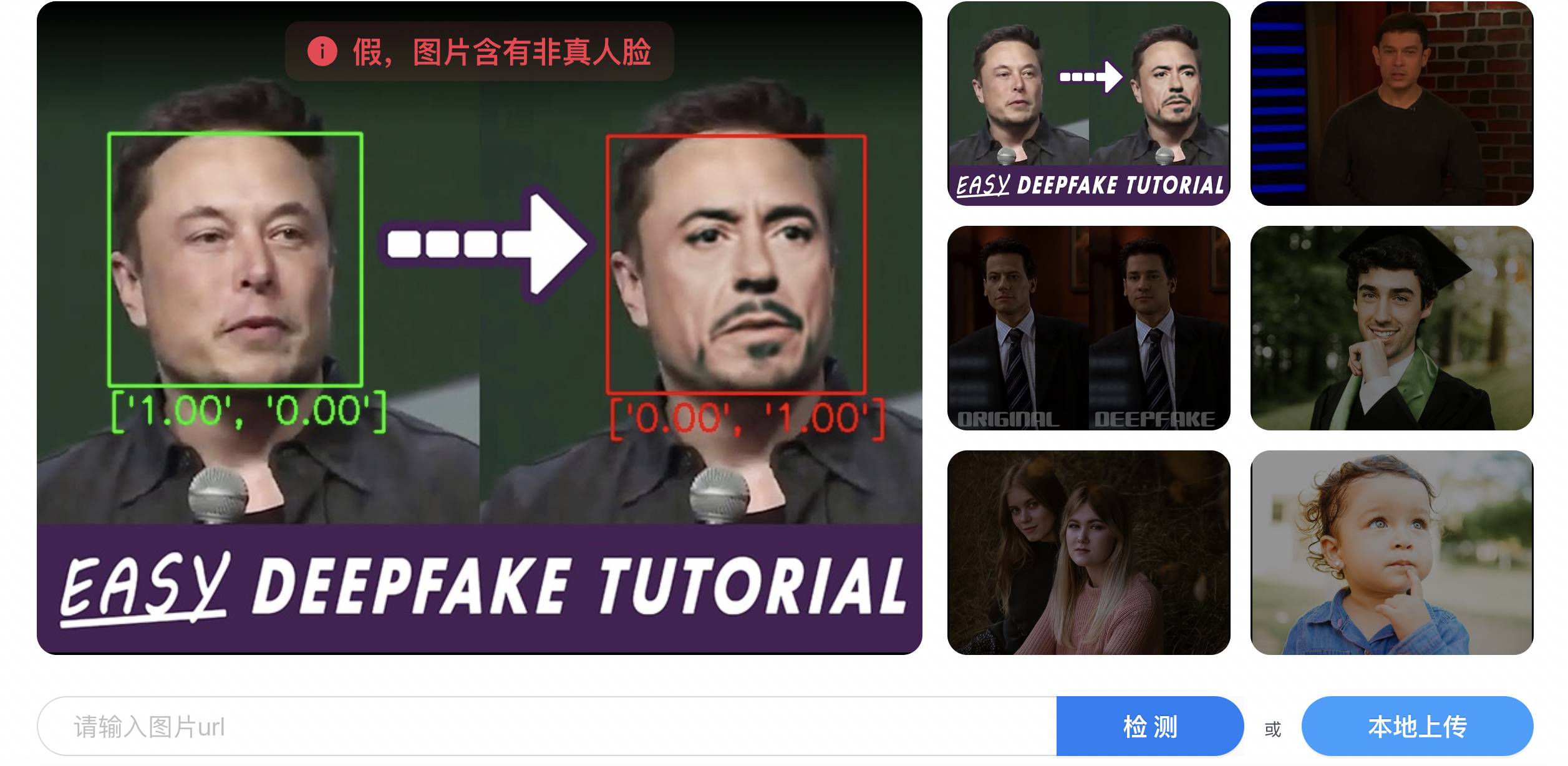

▲DeapReal

Simplificando, o uso da IA para identificar a IA é dividido em duas etapas: primeiro, extrair um grande número de recursos de falsificação e, em seguida, modelar com base nessas amostras para permitir que a IA aprenda as regras de identificação de falsificações.

Cores distorcidas, texturas irracionais, expressões não naturais, áudio e vídeo fora de sincronia, formas irregulares da íris e realces inconsistentes das duas pupilas são todos materiais de aprendizagem para IA.

Entre eles, a precisão da falsificação de vídeo pode ser maior do que a das imagens, pois o vídeo consiste em uma série de imagens contínuas, que fornece mais informações que podem ser utilizadas para a falsificação do que uma única imagem, como a aparência de um personagem entre diferentes quadros. continuidade da ação.

Em essência, a falsificação de IA é um pouco como usar olhos humanos para encontrar falhas e também explora as falhas do próprio modelo de IA.

▲ Pesquisadores da Academia Chinesa de Ciências disponibilizaram o modelo de IA para detectar Deepfake para o mundo

Mas os defeitos certamente melhorarão gradualmente, então surge uma questão muito crítica: existe primeiro a falsificação e depois a autenticação? Se assim for, a falsificação não estaria sempre meio passo atrás da falsificação?

Chen Peng respondeu que a tecnologia gerada pode estar um pouco à frente da tecnologia de falsificação, mas eles têm um laboratório interno de ataque e defesa vermelho-azul para simular Deepfake enquanto se defendem contra Deepfake e melhoram constantemente as capacidades de detecção de Deepfake.

Se alguma nova tecnologia Deepfake for lançada, eles poderão reproduzi-la rapidamente e depois verificá-la no produto de detecção "Quando uma nova tecnologia for lançada, mesmo que eu não a tenha visto, ainda posso detectá-la até certo ponto."

Além disso, o próprio modelo também tem uma certa capacidade de generalização. Ele viu muito conteúdo Deepfake e pode identificá-lo e detectá-lo com precisão, até certo ponto, se encontrar conteúdo não visto.

▲ Plataformas como Bilibili rotularão conteúdo de entretenimento inovador de IA

Em suma, a detecção de falsificações e falsificações por IA é um “jogo de gato e rato” de confronto de longo prazo e competição mútua.

É por isso que Chen Peng tem estudado algoritmos de falsificação de IA:

O Anti-Deepfake é muito conflituoso e requer investimento de longo prazo. Ao contrário de muitos produtos de IA, você pode esquecê-lo depois de terminá-lo.

Apesar disso, ele ainda está relativamente otimista: "Use leis e regulamentos para supervisionar, as plataformas gerenciam conteúdo, a indústria fornece tecnologia e ferramentas, e a mídia conscientiza mais pessoas sobre os riscos. Se a governança multifacetada atingir um certo nível, haverá definitivamente será uma flexibilização."

No futuro, ao navegar na Internet, poderemos cair num cenário um tanto absurdo: o código de verificação permite provar “Eu sou um ser humano”, e o Deepfake permite provar “Eu não sou eu”.

A tecnologia não consegue detectar completamente todas as intenções maliciosas, mas os humanos não precisam ficar muito ansiosos. O sucesso do Deepfake é apenas o resultado final, mas a prevenção do Deepfake pode começar a qualquer momento.

Como disse Chen Peng, mesmo um produto de IA muito simples é um projeto muito sistemático.

Fazemos parte de um sistema maior. Deixemos que os feridos falem, deixemos que os perpetradores sejam punidos, deixemos a tecnologia que impede as más ações intervir e deixemos que o conceito da sociedade melhore um pouco. uso justo do futuro.

# Bem-vindo a seguir a conta pública oficial do WeChat do aifaner: aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.