Construir uma “placa gráfica de bomba nuclear” não pode mais satisfazer a Nvidia

Todo mês de agosto, a Nvidia exibirá seus "músculos" na SIGGRAPH, a conferência de computação gráfica mais importante do mundo.

Cinco anos atrás, o CEO da Nvidia, Huang Renxun, lançou a Quadro RTX, a primeira placa de vídeo compatível com ray tracing, no SIGGRAPH 2018. Este é o produto mais importante da Nvidia desde o G80, empurrando as GPUs Nvidia da era GTX para a era RTX.

Naquela época, a Nvidia ainda era um fabricante de chips de computação gráfica muito puro e estava pensando em como levar a renderização 3D ao extremo. Seu valor de mercado era de cerca de 81,4 bilhões de dólares americanos e ainda não havia entrado no clube dos 100 bilhões. .

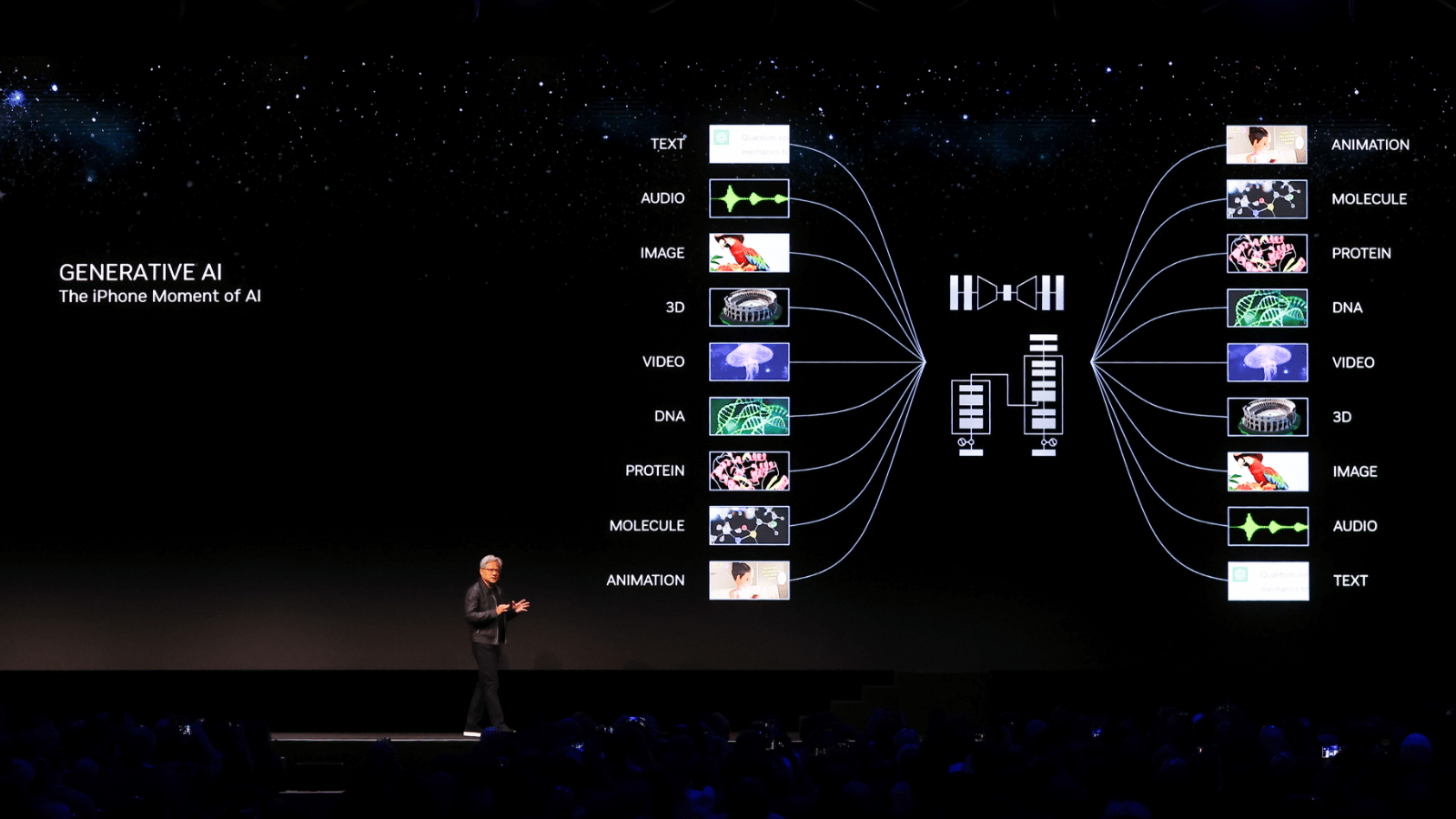

Mas em 2023, a Nvidia passou por uma mudança radical. Na conferência GTC em março, depois que Lao Huang lançou a frase de ouro "Chegou a hora do iPhone da IA", o preço das ações da Nvidia começou a subir constantemente, estabelecendo constantemente novos máximos históricos.

Nos últimos cinco anos, o preço das ações da Nvidia subiu quase 10 vezes e seu valor de mercado atual ultrapassou 1,1 trilhão, tornando-a a primeira empresa de chips do mundo com um valor de mercado superior a um trilhão de dólares americanos. mercado de ações.

As placas gráficas da Nvidia ainda são populares no mercado, mas agora não são mais os jogadores que buscam a imagem definitiva, mas gigantes da tecnologia como Microsoft e Meta que estão ansiosos para implantar e treinar modelos grandes.

No SIGGRAPH 2023 ontem à noite, foi difícil para você ouvir Lao Huang proferir palavras-chave familiares, como jogos, renderização em tempo real e 3D, e substituí-las por conceitos como IA generativa, data centers e computação acelerada.

Esta é uma nova Nvidia e uma nova era.

Nvidia mudou

Podemos interpretar que tipo de empresa é essa a partir do relatório financeiro da Nvidia.

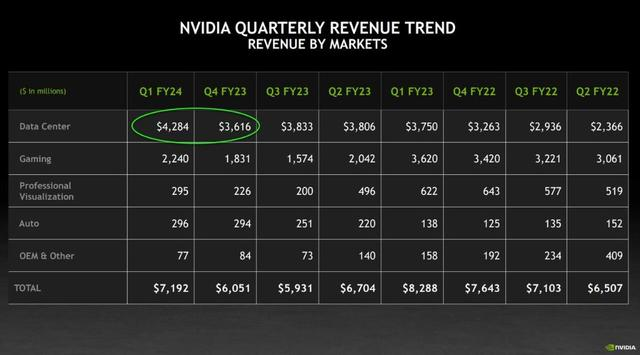

Por muito tempo, o negócio de jogos foi o principal negócio da Nvidia. Até o primeiro trimestre fiscal de 2023, sob a dupla influência da desaceleração do consumo no mercado de PCs e do aumento da computação de IA, o negócio de data center da Nvidia finalmente pegou e se tornou o número 1 da Nvidia. Isso também marca a transformação oficial da Nvidia de um fornecedor tradicional de GPU para um dos maiores fornecedores de energia de computação do mundo.

Depois disso, os datacenters da Nvidia começaram a disparar, e seu H100, A100 e outras placas gráficas de computação tornaram-se moeda forte na indústria de IA, e houve uma séria escassez ao mesmo tempo. Alguns analistas especulam que o mundo pode precisar de 432.000 H100 para atender à demanda do mercado.

O último relatório financeiro trimestral da Nvidia mostra que, graças à forte demanda das empresas, a receita de negócios de data center da Nvidia no primeiro trimestre foi de cerca de 4,2 bilhões, um aumento ano a ano de 14% e um aumento mês a mês de 18%, superando expectativas de Wall Street.

Mas se você acha que a Nvidia é apenas a sortuda que foi atingida pelo dinheiro quente da IA, então você subestima Lao Huang.

Para a Nvidia, construir uma "GPU de bomba nuclear" e investir em IA são apenas "trabalhos preparatórios" para realizar sua visão final. O que a Nvidia realmente quer fazer é construir um verdadeiro metaverso.

A "enxada" mais avançada

Se um trabalhador deseja fazer um bom trabalho, ele deve primeiro afiar suas ferramentas, e a Nvidia entende isso muito bem.

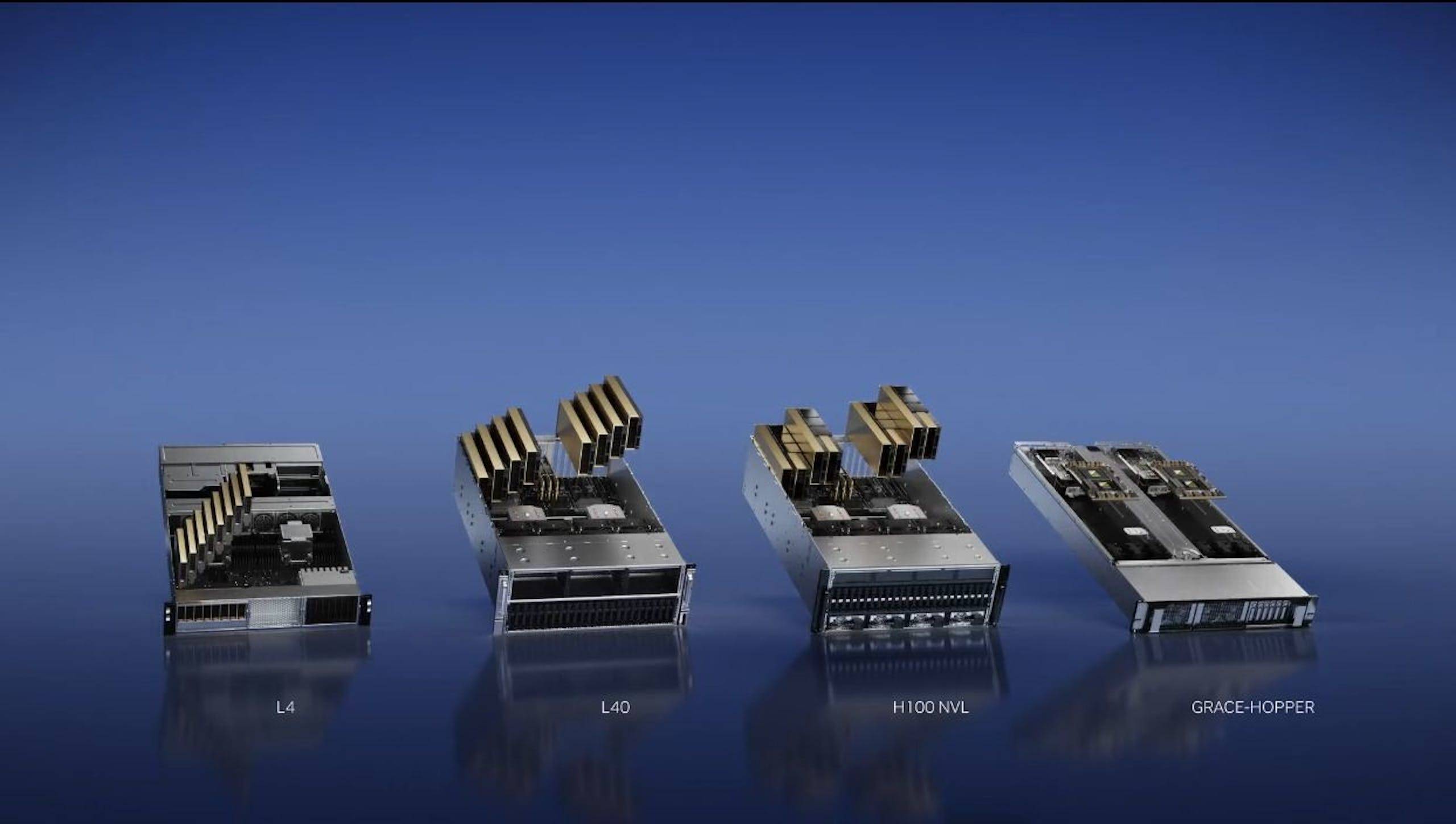

Em março deste ano, a Nvidia lançou quatro chips de inferência AI, H100 NVL GPU, L4 Tensor Core GPU, L40 GPU e NVIDIA Grace Hopper, para atender às crescentes necessidades de poder de computação das empresas.

No Taipei Computer Show em maio, Lao Huang lançou o supercomputador DGX GH200 composto por 256 superchips NVIDIA GH200 Grace Hopper.

E ontem, Lao Huang lançou uma nova versão do GH200 equipada com memória HBM3e. Mesmo a geração anterior do GH200 ainda não foi lançada oficialmente e a velocidade de atualização é assustadora.

As diferenças entre o antigo e o novo GH200 estão principalmente na memória.

O GH200 Grace Hopper é o primeiro chip GPU do mundo com memória HBM3e, um aumento de 50% na capacidade de memória de 96 GB para 144 GB por GPU.

A memória HBM3e é um novo tipo de tecnologia de memória de alta largura de banda. Em termos de velocidade de computação, a HBM3e pode ser 50% mais rápida que a velocidade de computação HBM3, fornecendo uma taxa de transmissão máxima de 5 TB/s. Isso permite que a nova versão do GH200 execute modelos AI 3,5 vezes mais rápido que os modelos atuais.

Entre eles, a memória GH200 de configuração dupla pode atingir 282 GB de memória HBM3e, o que representa um aumento de capacidade de 3,5 vezes e um aumento de largura de banda de 3 vezes em comparação com a geração anterior. Comparado com o popular H100, a memória aumentou 1,7 vezes e a largura de banda aumentou 1,5 vezes.

Assim como a geração anterior, o novo GH200 também possui escalabilidade exagerada.

Graças à tecnologia de interconexão NVLink da Nvidia, o GH200 pode ser combinado em formas de tamanhos diferentes de acordo com as necessidades das empresas, como servidores de cartão único, cartão duplo, cartões múltiplos, gabinetes e até mesmo supercomputadores.

Por fim, os GH200s podem ser combinados no supercomputador DGX GH200 SuperPod de 256 cartões, que possui 144 TB de memória rápida e pode executar 1.018 operações de ponto flutuante por segundo.

Se isso não for suficiente para você, você também pode conectar vários Nvidia DGX GH200 SuperPods com um Nvidia Quantum-2 InfiniBand Switch.

Lao Huang disse brincando: "Isso deve ser capaz de mover 'Crysis'."

A forte capacidade de expansão oferece possibilidades ilimitadas para o futuro do GH200.

Em outras palavras, se você quiser aumentar a velocidade de computação, basta adicionar mais gabinetes de servidor. Isso é muito benéfico no futuro. Huang Renxun acredita que o cenário típico de aplicação do GH200 no futuro é o modelo de linguagem grande, e a "computação acelerada" e a "computação AI" substituirão gradualmente a "computação geral" das GPUs x86 tradicionais.

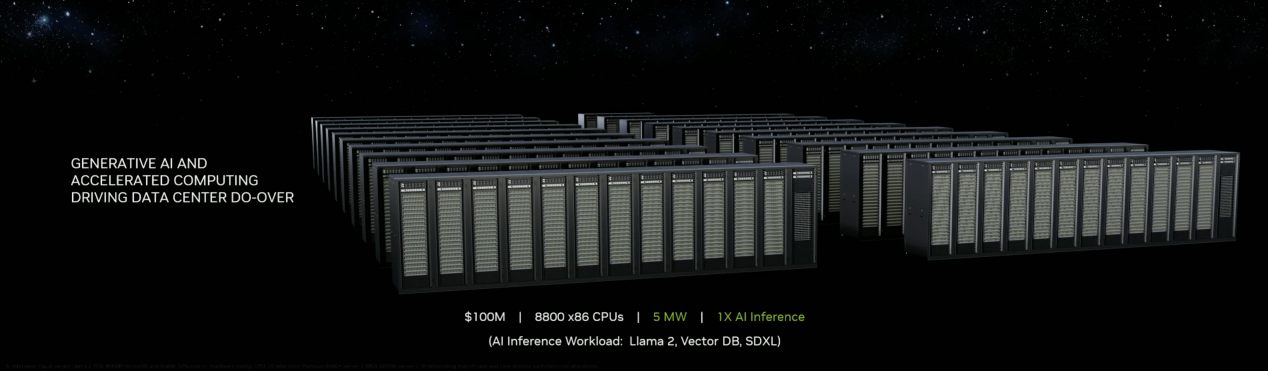

Por exemplo, no orçamento anterior de US$ 100 milhões, só era possível construir um pequeno data center, comprar 800 GPUs x86 e usar 5 megawatts de eletricidade para operar.

Mas com o mesmo orçamento, Grace Hopper, que escolhe a computação acelerada, precisa consumir apenas 3 megawatts de eletricidade, e a taxa de transferência de dados pode ser aumentada em uma ordem de grandeza. E se o cálculo for baseado na mesma carga de trabalho, o plano de cálculo de Grace Hopper precisa apenas de 8 milhões de dólares americanos.

Falando nisso, Lao Huang lançou seu famoso ditado: "Quanto mais você compra, mais você economiza."

As autoridades preveem que o novo GH200 precisará esperar até o segundo trimestre de 2024 para ser lançado. O GH200 equipado com memória HBM3 será lançado no segundo semestre deste ano, conforme planejado originalmente.

Obviamente, para desenvolvedores individuais e pequenas equipes, não é realista construir um data center no valor de centenas de milhões. Por esse motivo, a Nvidia lançou "intimamente" uma nova geração de placas gráficas para estações de trabalho que integram a tecnologia RTX avançada: NVIDIA RTX 5000 , NVIDIA RTX 4500 e NVIDIA RTX 4000.

Entre eles, como a principal GPU, a NVIDIA RTX 5000 adota o Tensor Core de 4ª geração e o RT Core de 3ª geração. 32 GB de memória de vídeo GDDR6, suporta verificação de erros ECC, adequado para estações de trabalho de ponta, data centers e jogos em nuvem.

Como uma GPU de médio a alto nível, a NVIDIA RTX 4500 é equipada com memória de vídeo GDDR6 de 24 GB e também suporta verificação ECC.

Em comparação com a geração anterior de produtos, a NVIDIA RTX 4500 dobra o desempenho do traçado de raios e dobra o desempenho do processamento de IA.

A NVIDIA RTX 4000 usa o mesmo núcleo de GPU da RTX 4500, equipada com memória de vídeo GDDR6 de 20 GB, e seu rastreamento de raios e desempenho de computação AI foram bastante aprimorados.

A nova GPU NVIDIA RTX 5000 está atualmente à venda, e as GPUs NVIDIA RTX 4500 e RTX 4000 serão enviadas no segundo semestre deste ano.

A "terra" mais fértil

Aplicando as palavras publicitárias de Nongfu Spring, podemos apresentar a mais recente estratégia de IA da Nvidia da seguinte forma:

Não produzimos IA, somos apenas carregadores de IA.

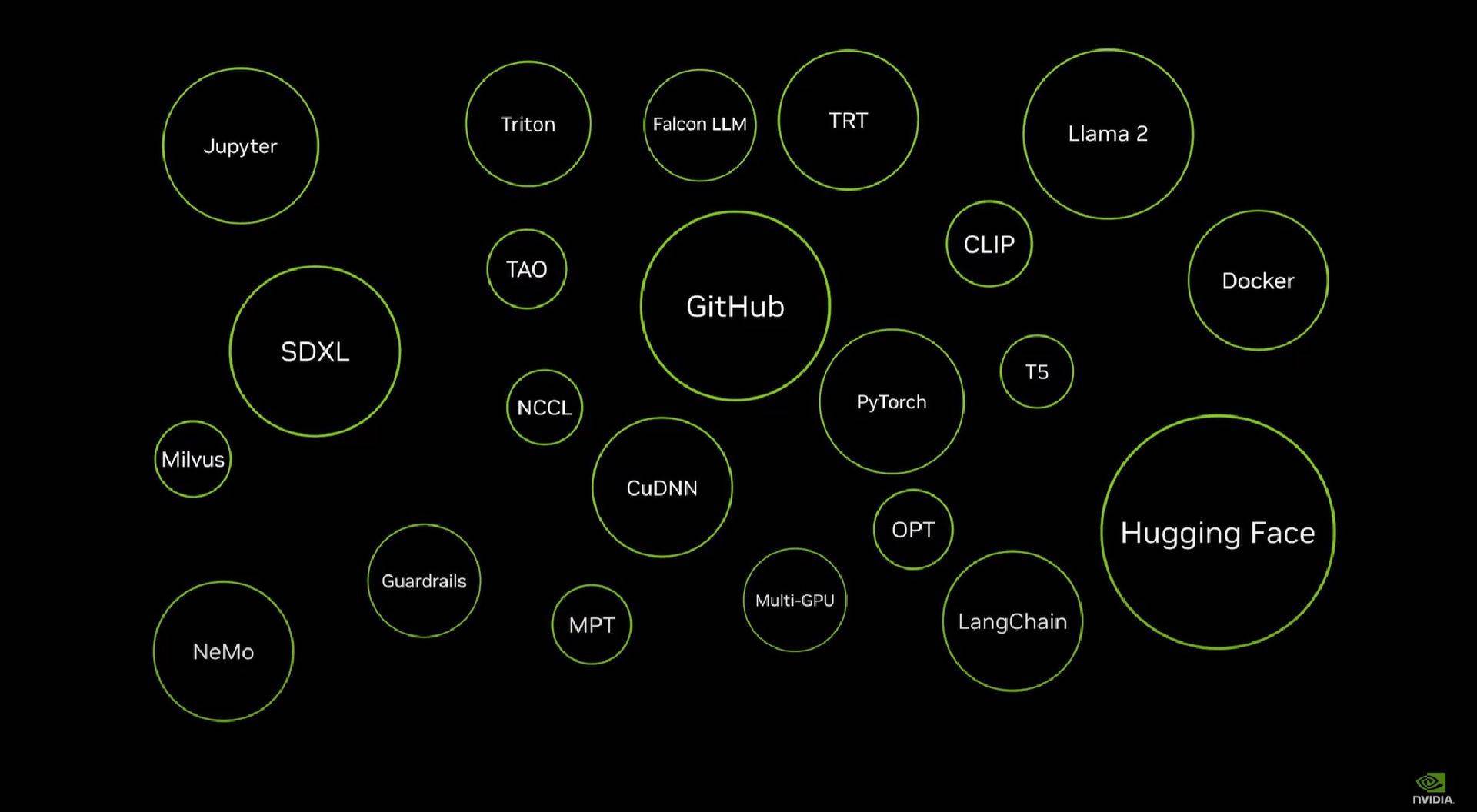

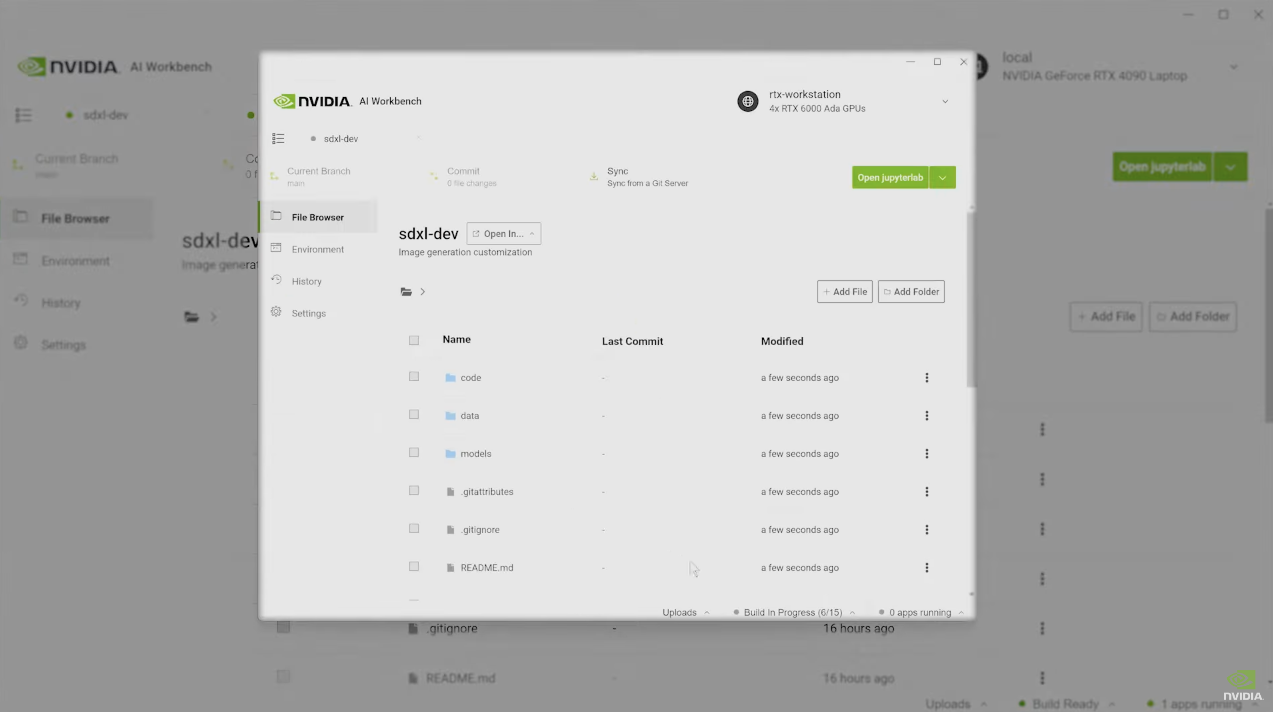

Como todos sabemos, configurar modelos de IA localmente é uma tarefa tediosa e complicada. Para ajudar os desenvolvedores a resolver esse problema, Lao Huang anunciou que a Nvidia lançará o "AI Workbench".

Simplificando, o AI Workbench pode fornecer aos desenvolvedores a estrutura, o kit de desenvolvimento de ferramentas e outros ambientes necessários para configurar modelos de IA de uma maneira completa, e eles podem começar a criar projetos diretamente.

Lao Huang deu um exemplo muito vívido na cena.

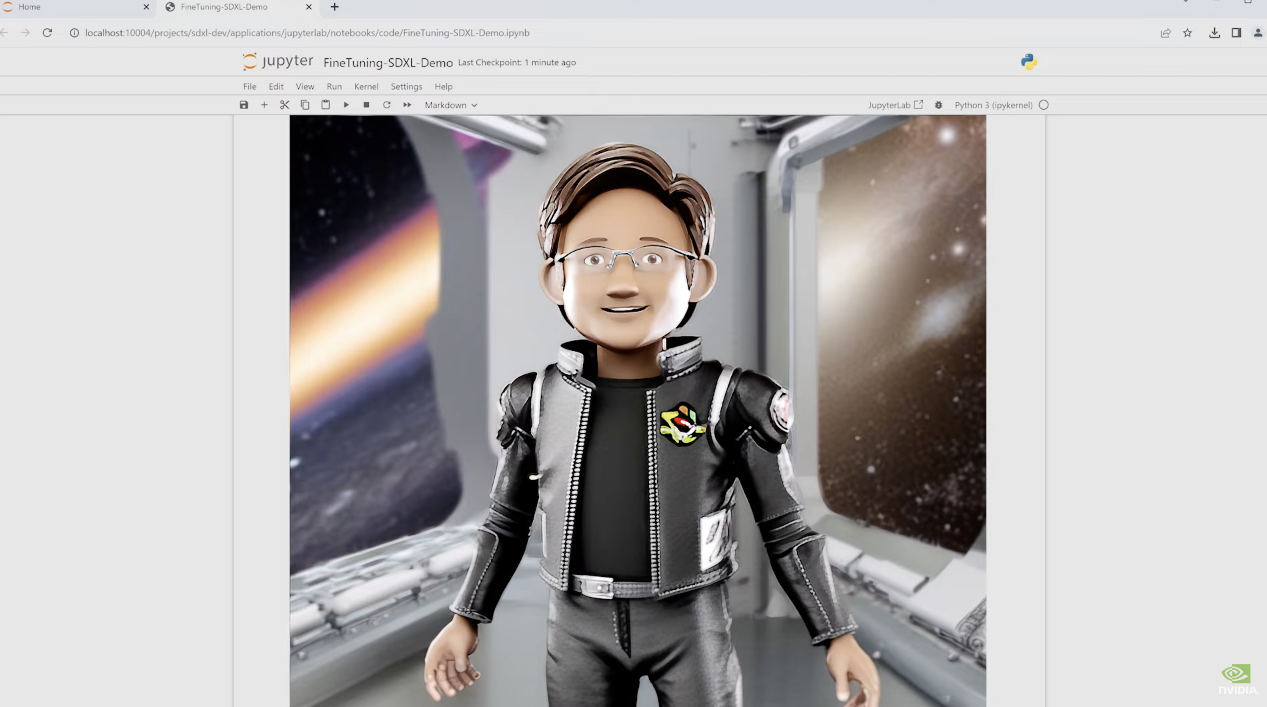

Por exemplo, a empresa precisa configurar um modelo Stable Diffusion para pintura, mas você não tem hardware e nem sabe configurar o modelo.

Não se preocupe, neste momento você só precisa abrir o AI Workbench, escolher uma estação de trabalho em nuvem com 4 GPUs RTX 6000 Ada e configurar o modelo Stable Diffusion com um clique.

Se você não estiver satisfeito com as imagens geradas, também poderá fazer o upload das imagens, reprogramar o modelo e gerá-las novamente.

Em menos de um minuto, uma imagem decente é gerada, e você não precisa se preocupar com outras questões ao longo do processo, pois o AI Workbench já preparou todo o resto.

A Nvidia anunciou que estabelecerá uma parceria estratégica com a Hugging Face, uma plataforma de IA de código aberto, e aplicará essa tecnologia ao lado corporativo.

Com apenas alguns cliques simples na plataforma Hugging Face, os desenvolvedores podem facilmente mover projetos de IA generativa de laptops para estações de trabalho e, em seguida, para data centers ou nuvens e, finalmente, usar recursos de supercomputação de IA em nuvem NVIDIA DGX para treinar modelos de IA.

Lao Huang enfatizou que, por meio da cooperação com a Hugging Face, a tecnologia de IA mais avançada da Nvidia pode fornecer suporte para todas as esferas da vida. As empresas também podem usar o poder da comunidade de código aberto para promover treinamento em IA de acordo com as necessidades de planejamento da empresa.

Maior sonho"

Depois de apresentar a atualização da plataforma de software e hardware, Lao Huang disse com um longo suspiro: "Vamos falar sobre o tópico mais importante esta noite – OpenUSD".

OpenUSD deve ser um termo desconhecido para a maioria das pessoas. OpenUSD é um framework de código aberto da Pixar (sim, a Pixar que fez a animação) em 2015. Antes disso, a Pixar usou esse framework por mais de 10 anos. Muitas animações que vimos são baseadas no framework OpenUSD.

O OpenUSD pode ser entendido como um padrão universal para criar mundos 3D para descrição, combinação, simulação e cooperação. Huang o comparou com "o significado de HTML para páginas da web 2D" e "realmente unindo o mundo inteiro".

Na semana passada, Pixar, Adobe, Apple, Autodesk, Nvidia e JDF anunciaram a formação da OpenUSD Alliance (AOUSD) para promover a padronização, desenvolvimento, evolução e crescimento do OpenUSD.

Por que esse nome pouco conhecido reúne tantas empresas gigantes em diferentes áreas? Começa com o fluxo de trabalho do trabalho 3D.

Os fluxos de trabalho 3D são muito granulares e complexos, por exemplo, designers, artistas e engenheiros são todos especializados em uma determinada parte do fluxo de trabalho 3D, como modelagem, texturização, materiais, simulação física, animação, cenografia e composição.

Como as ferramentas que eles usam (PS, AutoCAD, Blender etc.) o conteúdo.

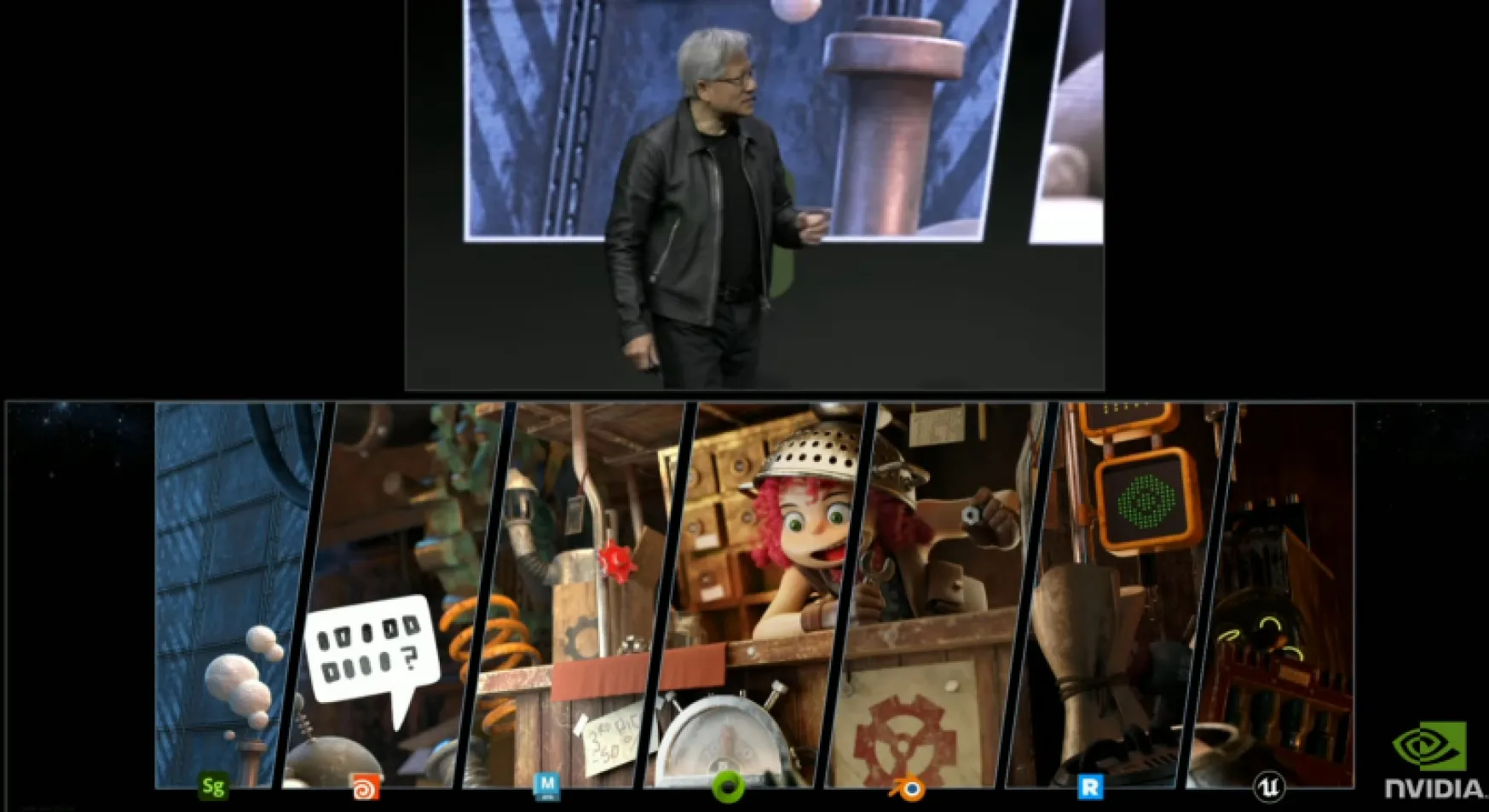

O OpenUSD é uma tecnologia criada para resolver esses problemas. Por meio do OpenUSD, ferramentas como Adobe Stager, Houdini, Maya, Blender, Renderman, Minuteman da Pixar e Unreal Engine da Epic podem trocar dados e desempenhar um papel mais poderoso.

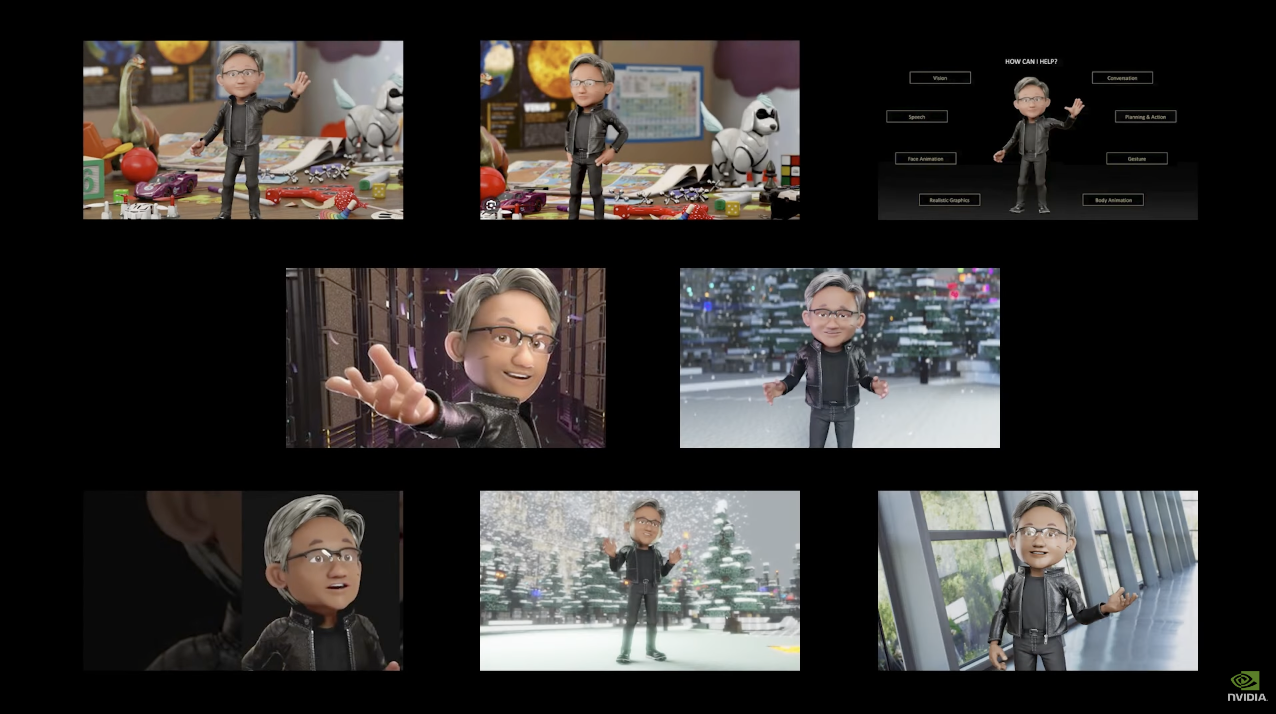

Mais tarde, Lao Huang anunciou solenemente que o Omniverse da Nvidia se tornará a primeira plataforma totalmente construída para o OpenUSD.Do banco de dados subjacente ao sistema do mecanismo, cada linha de código é projetada em torno do OpenUSD.

Além disso, a Nvidia também lançou APIs como RunUSD, ChatUSD e DeepSearch, que reduzirão ainda mais o limite para os desenvolvedores criarem aplicativos baseados em OpenUSD, permitindo que fluxos de trabalho 3D sejam combinados com IA e outras tecnologias.

Por exemplo, o anúncio produzido pela WPP, a maior empresa de publicidade do mundo, para o Denza N7 da BYD foi filmado no "Metaverse".

O WPP carregou os dados CAD de alta precisão do Denza N7 para o Omniverse para criar um carro gêmeo digital e, em seguida, os artistas do WPP podem criar no ambiente do Omniverse.

Por exemplo, você pode chamar a API ChatUSD e só precisa inserir uma descrição de uma frase para permitir que a IA gere diferentes ambientes de fundo, criando assim milhares de clipes de conteúdo personalizado para atividades de marketing global.

Metaverso e IA generativa são como um par natural. Quando os dois se encontram, seu valor será ampliado exponencialmente, e a tecnologia OpenUSD torna tudo isso possível.

Lao Huang acredita que, no futuro, mais e mais indústrias precisarão passar pela transformação digital, e o Omniverse e a inteligência artificial logo se tornarão o fluxo de trabalho mais importante para que essas empresas concluam a transformação digital.

Para construir Omniverse e inteligência artificial, é naturalmente inseparável do forte suporte de poder de computação. Esta é a verdadeira forma da Nvidia:

Com a GPU como espinha dorsal e a IA como a pele, ela forma a mão mais poderosa para promover a transformação digital industrial.

#Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (ID do WeChat: ifanr), conteúdo mais interessante será apresentado a você o mais rápido possível.