A versão paga do ChatGPT também ficou mais burra, e a OpenAI foi exposta por “trocar de modelos”, deixando os usuários frenéticos Relatório Semanal Hunt Good

Bem-vindo à última edição do Hunt Good Weekly!

Nesta edição você verá:

7 informações novas

4 ferramentas úteis

1 caso interessante

3 pontos de vista claros

Caça às Notícias|Manchetes Avançadas

O mecanismo de roteamento de modelos da OpenAI gera controvérsia entre os usuários

O mecanismo de roteamento de modelos da OpenAI gera controvérsia entre os usuários

Recentemente, o conhecido blogueiro do X Tibor Blaho descobriu que o OpenAI está desviando automaticamente as solicitações dos usuários do ChatGPT para dois "modelos secretos" não divulgados, sem o consentimento dos usuários.

De acordo com Blaho, os dois modelos são "gpt-5-chat-safety" e "gpt-5-at-mini". O primeiro é um novo modelo projetado especificamente para lidar com conteúdo sensível, enquanto o segundo é um modelo de inferência de detecção de "violação" altamente sensível que dispara uma resposta apenas com a inserção da palavra "violação".

Quando o sistema determina que a conversa de um usuário envolve tópicos delicados, expressões emocionais ou informações potencialmente ilegais, o sistema encaminha automaticamente a solicitação para esses modelos de backend para processamento, independentemente de o usuário ter selecionado a versão GPT-4 ou GPT-5. Mesmo expressões simples com conotações emocionais leves, como "Estou tendo um dia ruim" ou "Eu também te amo", podem acionar o mecanismo de roteamento.

Vale ressaltar que essa prática não afeta apenas usuários gratuitos, mas também usuários Plus, que pagam US$ 20 por mês, e membros Pro, que pagam US$ 200 por mês, não estão imunes. Muitos internautas até reclamaram que o ChatGPT claramente reduziu sua inteligência.

Nick Turley, vice-presidente da OpenAI e chefe de aplicativos ChatGPT, admitiu que a OpenAI está testando um novo sistema de roteamento seguro. Ele explicou que, quando a conversa envolve tópicos delicados e emocionais, o sistema mudará para um modelo de raciocínio ou GPT-5, projetado especificamente para lidar rigorosamente com tais cenários.

Além disso, Turley enfatizou que essa mudança do modelo padrão para o modelo sensível é atualmente apenas temporária e disse que o ChatGPT ainda informará o modelo específico usado atualmente após o usuário solicitar explicitamente.

https://x.com/btibor91/status/1971959782379495785

https://x.com/btibor91/status/1971959782379495785

MuskxAI processa OpenAI por supostamente roubar segredos comerciais

MuskxAI processa OpenAI por supostamente roubar segredos comerciais

Em 25 de setembro, a empresa de inteligência artificial de Elon Musk, xAI, entrou com uma ação judicial contra a OpenAI no Tribunal Federal do Distrito Norte da Califórnia, acusando a empresa de roubar segredos comerciais ao recrutar funcionários importantes.

A xAI entrou com uma ação judicial em agosto contra o ex-funcionário Li Xuechen, que vendeu abruptamente suas ações na empresa e posteriormente se juntou à rival OpenAI, embora não esteja claro se ele realmente começou a trabalhar lá.

Em sua última acusação, a xAI acusou a OpenAI de "induzir" ex-funcionários, incluindo Li Xuechen, o antigo engenheiro Jimmy Fratello e um alto executivo financeiro a roubar segredos comerciais.

Uma acusação fundamental na acusação é que a OpenAI tentou obter a "arma secreta" da xAI, ou seja, "a capacidade da xAI de implantar data centers com recursos de computação em larga escala para treinar e executar inteligência artificial em uma velocidade sem precedentes".

De acordo com a acusação, o "executivo financeiro sênior" não identificado trouxe conhecimento dos processos de rápida construção e escalonamento de data centers para a OpenAI. Quando questionado por e-mail sobre supostas violações do acordo de confidencialidade ao sair, o executivo respondeu: "Dane-se". A xAI incluiu uma captura de tela do e-mail como prova na acusação.

A xAI acusa a OpenAI de se envolver em uma "campanha coordenada, injusta e ilegal" para recrutar funcionários-chave da xAI e então "induzi-los" a trazer segredos comerciais para a OpenAI, já que ela "rapidamente alcançou o domínio entre as empresas de IA generativa simplesmente porque foi a 'pioneira'".

Em resposta, um porta-voz da OpenAI disse em um e-mail: "Este novo processo é o capítulo mais recente do assédio contínuo do Sr. Musk. Temos tolerância zero para quaisquer violações de acordos de confidencialidade e não temos interesse nos segredos comerciais de outros laboratórios."

https://sherwood.news/tech/musks-xai-sues-openai-alleging-theft-of-trade-secrets/

https://sherwood.news/tech/musks-xai-sues-openai-alleging-theft-of-trade-secrets/

O ChatGPT vai adicionar anúncios?

Segundo fontes, o CEO do novo aplicativo da OpenAI, Fidji Simo, quer formar uma nova equipe para introduzir publicidade no ChatGPT. O novo líder será totalmente responsável por todos os negócios lucrativos da OpenAI, abrangendo vários aspectos, como publicidade e serviços de assinatura.

Pessoas familiarizadas com o assunto disseram que Simo tem se reunido recentemente com potenciais candidatos, incluindo alguns de seus ex-colegas do Facebook. As negociações ainda estão em andamento, e a recém-contratada chefe de publicidade deverá se reportar diretamente a Simo.

Como complemento, Simo se juntou oficialmente à OpenAI após renunciar ao cargo de CEO da Instacart no mês passado.

Na estrutura organizacional da OpenAI, Simo é responsável por gerenciar a maioria das unidades de negócios da empresa, exceto as equipes de pesquisa, infraestrutura, hardware de consumo e segurança. Esses departamentos principais ainda se reportam diretamente ao CEO Sam Altman.

https://sources.news/p/openai-ads-leader-sam-altman-memo-stargate?hide_intro_popup=true

https://sources.news/p/openai-ads-leader-sam-altman-memo-stargate?hide_intro_popup=true

Meta aposta em plataforma de robôs "estilo Android"

Meta aposta em plataforma de robôs "estilo Android"

O CTO da Meta, Andrew Bosworth, revelou em uma entrevista recente que, sob as instruções diretas do CEO Mark Zuckerberg, ele formou uma equipe dedicada à pesquisa em robótica no início deste ano e atualmente está desenvolvendo um projeto de robô humanoide com o codinome "Metabot".

Ao contrário de seus concorrentes, a Meta não pretende se tornar uma fabricante de hardware. Em vez disso, planeja adotar um modelo de negócios semelhante ao que o Google licencia para seu sistema operacional Android para fabricantes de celulares. A Meta prevê desenvolver um projeto completo de software e, em seguida, licenciá-lo para qualquer empresa que atenda às especificações técnicas, permitindo que mais fabricantes produzam robôs humanoides com base na plataforma de software da Meta.

Em termos de tecnologia, Bosworth enfatizou que o desenvolvimento de software é atualmente o maior gargalo, não o hardware em si.

Durante a entrevista, ele pegou um copo d'água sobre a mesa e explicou: "Esses robôs conseguem ficar em pé, correr e até dar cambalhotas porque o chão é uma plataforma superestável. Mas se o robô tentar pegar o copo d'água, provavelmente irá esmagá-lo ou derramar toda a água que está dentro." Este exemplo simples mostra que a manipulação hábil ainda é um dos maiores desafios da robótica.

Para enfrentar esse desafio, o Laboratório de IA Superinteligente da Meta está colaborando estreitamente com a equipe de robótica para construir um "modelo mundial" capaz de simular movimentos complexos das mãos. Bosworth observa que o circuito sensorial que permite que robôs humanoides realizem movimentos delicados, como retirar cuidadosamente as chaves do bolso de uma calça jeans com precisão semelhante à humana, ainda não existe, então a equipe teve que construir o conjunto de dados correspondente do zero.

https://www.theverge.com/column/786759/humanoid-robots-meta

https://www.theverge.com/column/786759/humanoid-robots-meta

Microsoft anuncia que assistente Copilot introduz modelo Claude, reduzindo dependência do OpenAI

Microsoft anuncia que assistente Copilot introduz modelo Claude, reduzindo dependência do OpenAI

Em 24 de setembro, a Microsoft anunciou a introdução do modelo Claude da Anthropic no assistente Copilot do Microsoft 365.

Nesta nova colaboração, os usuários do recurso do agente Researcher no Copilot, que coleta e analisa informações e gera relatórios, agora podem escolher que suas solicitações rápidas sejam respondidas por um modelo Claude ou um modelo OpenAI.

No entanto, o uso desses modelos requer aprovação prévia de um administrador e está sujeito aos termos e condições da Anthropic.

Vale a pena mencionar que, como grande investidora e parceira-chave de serviços de nuvem da OpenAI, a Microsoft tem confiado principalmente nos modelos da OpenAI para fornecer recursos de IA para a pesquisa do Bing, sistema operacional Windows e outros produtos por um longo tempo.

Mas, à medida que a divergência com a OpenAI se aprofundava, além de integrar mais modelos de linguagem de larga escala da empresa, a Microsoft também começou a testar seu próprio modelo MAI-1-preview.

Ao mesmo tempo, a OpenAI também rompeu com sua dependência do Microsoft Azure e acelerou a expansão de seu território de cooperação, fechando acordos enormes que variam de dezenas de bilhões a centenas de bilhões de dólares americanos com Oracle, Broadcom e Nvidia para dar suporte à construção de seu data center em larga escala.

https://www.cnbc.com/2025/09/24/microsoft-adds-anthropic-model-to-microsoft-365-copilot.html

https://www.cnbc.com/2025/09/24/microsoft-adds-anthropic-model-to-microsoft-365-copilot.html

Versão interna do ChatGPT da Apple vaza, preparando o novo Siri

Versão interna do ChatGPT da Apple vaza, preparando o novo Siri

De acordo com uma reportagem da Bloomberg de ontem, a Apple está desenvolvendo um aplicativo móvel semelhante ao ChatGPT para ajudar a testar e se preparar para a nova versão da Siri, que será lançada no ano que vem.

Relatórios indicam que a divisão de IA da Apple está usando o aplicativo para avaliar rapidamente novos recursos da Siri, incluindo testes de buscas por dados pessoais e execução de ações no aplicativo, como edição de fotos.

O software, com o codinome interno "Veritas" (latim para "verdade"), é atualmente para uso interno. Embora o software não esteja planejado para uso do consumidor, a função do aplicativo é basicamente extrair novas tecnologias em desenvolvimento da nova Siri, ajudando assim os funcionários da Apple a concluir os testes com eficiência.

Mesmo sem um lançamento público, a ferramenta interna marca uma nova fase nos preparativos da Apple para uma revisão abrangente da Siri, que já sofreu vários atrasos e agora está programada para ser lançada em março do ano que vem, observou o relatório.

O Veritas supostamente roda no sistema subjacente que a Apple reconstruiu para alimentar o novo Siri, codinome "Linwood". O Veritas também depende do Large Language Model (LLM) e incorpora o trabalho da própria equipe de modelagem fundamental da Apple.

Além disso, de acordo com um relatório recente do 9to5Mac, códigos ocultos nas versões beta para desenvolvedores do iOS 26.1, iPadOS 26.1 e macOS Tahoe 26.1 mostram que a Apple está estabelecendo as bases para introduzir o suporte MCP para App Intents.

Leitura relacionada: Ovo de Páscoa oculto do iOS 26.1 exposto, a Apple criou uma nova "porta C" para o ChatGPT

Leitura relacionada: Ovo de Páscoa oculto do iOS 26.1 exposto, a Apple criou uma nova "porta C" para o ChatGPT

Meta lança serviço de streaming de vídeo com IA "Vibes", Zuckerberg o promove pessoalmente e é criticado por internautas

Meta lança serviço de streaming de vídeo com IA "Vibes", Zuckerberg o promove pessoalmente e é criticado por internautas

A Meta anunciou recentemente o lançamento de um novo fluxo de vídeo de IA chamado "Vibes".

Em uma publicação no Instagram, Zuckerberg apresentou o Vibes como “um fluxo de vídeos expressivos gerados por IA, feitos por artistas e criadores”. O recurso estará disponível nos Estados Unidos e em mais de 40 outros países.

Em termos de design funcional, Meta disse que os usuários não só podem assistir a conteúdo gerado por IA, mas também criar seus próprios vídeos ou "remixar" vídeos existentes, incluindo a adição de novos efeitos visuais e músicas.

Para demonstrar o novo recurso, Zuckerberg compartilhou um videoclipe gerado por IA intitulado "Pai tenta calcular a gorjeta de um almoço de US$ 30". No vídeo, uma figura paterna parecida com Zuckerberg diz: "Meu Deus… Acho que provavelmente são pelo menos US$ 600 bilhões".

No entanto, o vídeo promocional de Zuckerberg foi ridicularizado pelos internautas, com muitos chamando esses vídeos gerados por IA de "lixo de IA" em seu vídeo.

Vale ressaltar que, embora a Meta tenha seu próprio modelo de IA, o Llama, para o projeto Vibes a empresa escolheu usar modelos de geração de vídeo dos laboratórios de IA Midjourney e Black Forest.

https://www.theguardian.com/technology/2025/sep/26/cute-fluffy-characters-and-egyptian-selfies-meta-launches-ai-feed-vibes

https://www.theguardian.com/technology/2025/sep/26/cute-fluffy-characters-and-egyptian-selfies-meta-launches-ai-feed-vibes

Caça às Ferramentas|Ferramentas Avançadas

Ex-CTO da OpenAI anuncia sua segunda conquista empresarial

Ex-CTO da OpenAI anuncia sua segunda conquista empresarial

Em 27 de setembro, o Thinking Machines Lab (TML), fundado por vários ex-executivos da OpenAI, lançou oficialmente seu segundo artigo de pesquisa "Modular Manifolds", que visa tornar o processo de treinamento de grandes modelos estável e eficiente desde a raiz.

Simplificando, a ideia central desta pesquisa é colocar um "anel estreito" geométrico nos parâmetros de peso da rede neural.

As abordagens tradicionais geralmente envolvem a aplicação de um otimizador a um modelo após sua construção. A estrutura de "variedade modular" vai um passo além, tratando cada camada de uma rede neural como um "espaço geométrico" (ou seja, uma variedade) com regras independentes. Os parâmetros são primeiro restringidos internamente e, em seguida, esses espaços são "costurados", usando um "limitador de taxa" global para coordenar o ritmo de atualização de toda a rede.

Este modelo integrado e design otimizador evitam a perda de controle sobre os parâmetros internos da rede. Experimentos em pequena escala conduzidos neste artigo demonstram estabilidade e precisão promissoras.

O autor dessa conquista é Jeremy Bernstein, pesquisador de aprendizado de máquina no TML, que também conduziu pesquisa de pós-doutorado no MIT.

Este mês, seis meses após sua criação, a TML lançou seu primeiro grande artigo de pesquisa, "Derrotando o não determinismo na inferência de LLM".

Vale ressaltar que a avaliação da TML havia disparado para US$ 12 bilhões (equivalente a RMB 85 bilhões) quando tinha “0 produtos e 0 usuários”.

https://thinkingmachines.ai/blog/modular-manifolds/

https://thinkingmachines.ai/blog/modular-manifolds/

Modelo DeepSeek atualizado novamente, a versão definitiva

Modelo DeepSeek atualizado novamente, a versão definitiva

Em 22 de setembro, a DeepSeek anunciou que o deepseek-chat e o deepseek-reasoner foram totalmente atualizados para o DeepSeek-V3.1-Terminus.

Entre eles, o deepseek-chat corresponde ao modo não pensante, e o deepseek-reasoner corresponde ao modo pensante. Segundo relatos, esta atualização mantém os recursos existentes do modelo, otimizando-o com base no feedback dos usuários.

- Em termos de consistência linguística, a mistura de chinês e inglês e caracteres anormais ocasionais foram atenuados;

- Em termos de recursos do agente, o desempenho do Code Agent e do Search Agent foi ainda mais aprimorado.

- Vale ressaltar que desenvolvedores em diversas plataformas relataram que o modelo DeepSeek V3.1 apresenta anomalias "extremas ocasionais" — a inserção repetida de tokens como o caractere chinês "极", o caractere inglês "extreme" ou o caractere chinês tradicional "極" (極) em código normal ou saída de texto. Embora a probabilidade desse bug seja de aproximadamente uma em mil, ele é suficiente para causar falhas de compilação ou conteúdo inutilizável. Esta atualização de versão também deve incluir uma correção específica para esse problema.

O novo modelo agora é de código aberto:

Abraço Face: https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Terminus

Abraço Face: https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Terminus  Escopo do modelo: https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Terminus

Escopo do modelo: https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Terminus

ChatGPT lança assistente de informações proativo "Pulse"

ChatGPT lança assistente de informações proativo "Pulse"

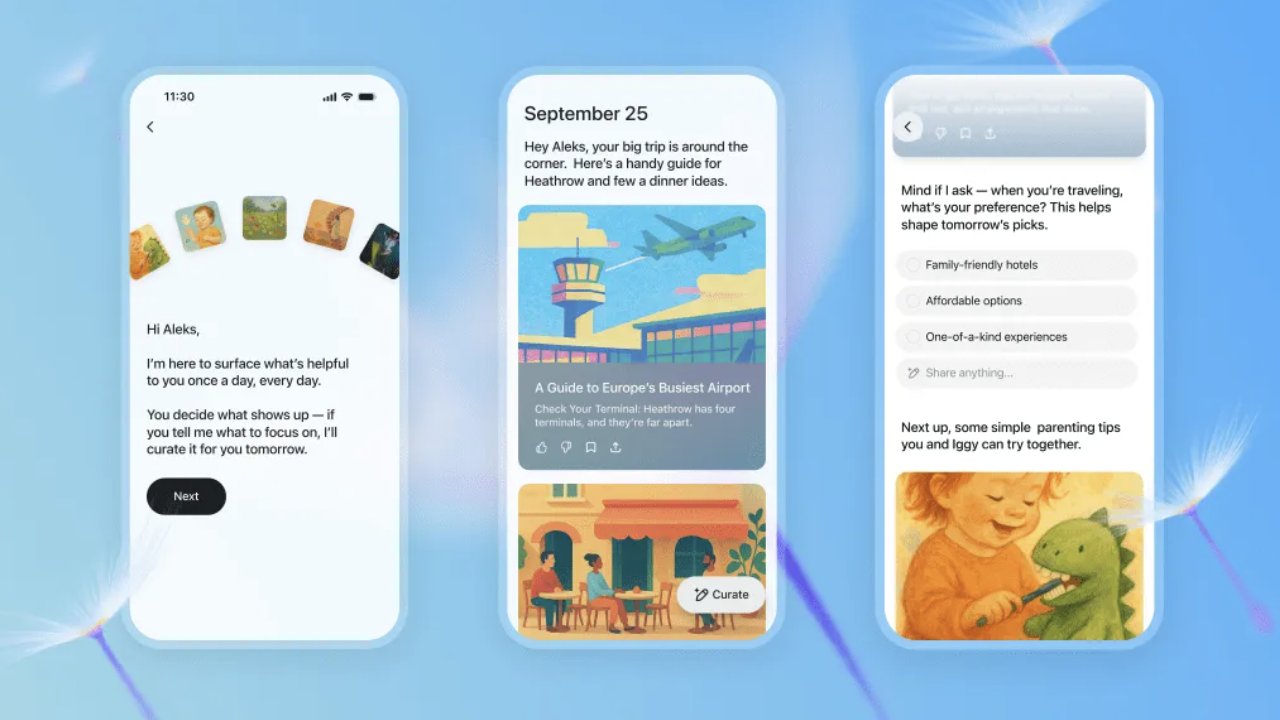

Em 26 de setembro, a OpenAI anunciou o lançamento de um novo recurso "ChatGPT Pulse", que agora está aberto para visualização para usuários móveis Pro.

De acordo com a introdução oficial, o ChatGPT Pulse gera automaticamente um conjunto de atualizações de pesquisa personalizadas todas as manhãs com base no histórico de bate-papo, feedback e aplicativos conectados do usuário (como Gmail e Google Agenda). Essas atualizações são apresentadas na forma de cartões, que os usuários podem navegar rapidamente ou expandir para visualizar detalhes.

Ao contrário do modelo tradicional de "perguntas e respostas" da IA, o ChatGPT Pulse enfatiza a proatividade. O sistema realiza pesquisas assíncronas durante a noite, integrando os interesses dos usuários e o feedback histórico para fornecer recomendações mais direcionadas no dia seguinte, como "receitas de jantar saudáveis", "planos de treinamento de triatlo" ou "rascunhos de pautas de reuniões".

Vale ressaltar que as atualizações do ChatGPT Pulse são válidas apenas para o dia em que são lançadas. Se um usuário não salvar ou expandir uma publicação, as informações não serão armazenadas a longo prazo. Os responsáveis enfatizaram que o objetivo desse recurso é "ajudar os usuários a acessar informações importantes rapidamente, em vez de ter que rolar a página indefinidamente".

Atualmente, o "ChatGPT Pulse" ainda está em fase de pré-visualização. Ele será expandido gradualmente para mais usuários no futuro e planeja oferecer suporte a mais acesso a aplicativos de terceiros.

Leitura relacionada: ChatGPT acaba de ser atualizado, Ultraman: este é meu recurso favorito

Leitura relacionada: ChatGPT acaba de ser atualizado, Ultraman: este é meu recurso favorito

O Google DeepMind lança um novo modelo de IA que permite que robôs pesquisem na web para ajudar a concluir tarefas complexas

O Google DeepMind lança um novo modelo de IA que permite que robôs pesquisem na web para ajudar a concluir tarefas complexas

Em 26 de setembro, o Google DeepMind anunciou o lançamento de um modelo de IA atualizado que pode ajudar robôs a concluir tarefas mais complexas.

Há relatos de que, graças ao recém-lançado Gemini Robotics 1.5 e ao modelo de raciocínio incorporado Gemini Robotics-ER 1.5, os modelos de IA recém-lançados da Deepmind podem trabalhar juntos para permitir que os robôs "pensem vários passos à frente" antes de agir no mundo físico.

O relatório disse que os robôs serão capazes de completar operações mais complexas de várias etapas, como separar roupas por cores claras e escuras, fazer malas de acordo com as condições climáticas atuais de Londres e ajudar as pessoas a separar lixo, composto e materiais recicláveis de acordo com as necessidades específicas da área.

Carolina Parada, chefe do departamento de robótica da DeepMind, disse: "Os modelos anteriores podem executar tarefas de instrução única muito bem e são muito genéricos. Com esta atualização, vamos além da execução de instruções únicas para realmente compreender e resolver tarefas físicas."

Para isso, os robôs podem usar o modelo Gemini Robotics-ER 1.5 para entender o ambiente ao seu redor e utilizar ferramentas digitais como a Pesquisa Google para obter mais informações. Essas descobertas são então traduzidas em instruções em linguagem natural e passadas para o Gemini Robotics 1.5, permitindo que o robô execute tarefas passo a passo usando os recursos de visão e compreensão de linguagem do modelo.

Além disso, a DeepMind também anunciou que o Gemini Robotics 1.5 pode ajudar robôs a "aprender" uns com os outros, mesmo que tenham configurações diferentes. Atualmente, a DeepMind está disponibilizando o Gemini Robotics-ER 1.5 para desenvolvedores por meio da API Gemini no Google AI Studio, e o Gemini Robotics 1.5 está disponível apenas para alguns parceiros.

https://www.theverge.com/news/785193/google-deepmind-gemini-ai-robotics-web-search

https://www.theverge.com/news/785193/google-deepmind-gemini-ai-robotics-web-search

Caça à Diversão | Jogue Primeiro

Google lança aplicativo Androidify para criar "pessoas Android" personalizadas

Google lança aplicativo Androidify para criar "pessoas Android" personalizadas

O Google lançou oficialmente recentemente um novo aplicativo, o Androidify, que permite aos usuários enviar selfies ou inserir palavras-chave para gerar sua própria imagem de robô Android com a ajuda da tecnologia de IA.

O aplicativo já está disponível para download na web e na Google Play Store.

Segundo relatos, o Androidify integra o Gemini e o Firebase AI Logic SDK, suportando funções como verificação de imagem, geração automática de descrição e geração de robôs personalizados.

O aplicativo usará inicialmente o Gemini 2.5 Flash para detectar as fotos enviadas pelos usuários e garantir que as imagens sejam nítidas e atendam aos padrões de segurança. Em seguida, ele gerará uma descrição detalhada e chamará o modelo Imagen 3 para gerar a imagem final do robô.

Vale ressaltar que a versão mais recente também adiciona "geração de atmosfera de fundo" e "modo de adesivos".

O primeiro pode adicionar fundo de cena ao robô por meio do modelo Gemini, enquanto o último usa a tecnologia de segmentação do ML Kit para remover o fundo e gerar adesivos PNG que podem ser usados em aplicativos de bate-papo.

O Google disse que o objetivo do Androidify é permitir que os usuários experimentem a criatividade e a personalização proporcionadas pela combinação de IA e tecnologia Android enquanto se divertem.

https://androidify.com/

https://androidify.com/

Caça ao Insight

Cientista-chefe da OpenAI: Após a codificação da atmosfera, talvez venha a "pesquisa da atmosfera"

Cientista-chefe da OpenAI: Após a codificação da atmosfera, talvez venha a "pesquisa da atmosfera"

Em uma entrevista recente realizada pela a16z, o cientista-chefe da OpenAI, Jakub Pachocki, e o diretor de pesquisa, Mark Chen, revelaram profundamente alguns pensamentos importantes e planos futuros sobre o caminho de desenvolvimento da IA.

Em relação à questão da saturação das métricas de avaliação atuais, Jakub Pachocki admitiu que o sistema de avaliação que ele vem utilizando nos últimos anos está, de fato, muito próximo da saturação. Portanto, a OpenAI se concentrará em verificar se seus modelos conseguem descobrir coisas novas e fazer progressos reais em áreas economicamente relevantes.

Jakub revelou um grande objetivo do OpenAI: treinar pesquisadores automatizados para descobrir novas ideias automaticamente.

Ele mencionou uma métrica interessante: o intervalo de tempo necessário para observar o modelo efetivamente raciocinando e progredindo. Atualmente, o nível de raciocínio do modelo pode ser mantido por cerca de 1 a 5 horas. Em seguida, a OpenAI se concentrará em estender esse intervalo de tempo, tanto em termos de capacidade de planejamento de longo prazo quanto de retenção de memória.

Em termos de programação de IA, Mark Chen comparou o progresso dos modelos de programação à experiência do jogador de Go Lee Sedol enfrentando o AlphaGo, dizendo que o progresso da resolução de problemas de matemática da oitava série para atingir o nível profissional em competições de codificação um ano depois é "louco".

Ele observa que esse progresso já mudou a abordagem padrão para a codificação. Os jovens agora consideram a "codificação ambiental" o padrão, enquanto a ideia de escrever tudo do zero parece estranha. Ele prevê que o próximo passo após a codificação ambiental pode ser a "pesquisa ambiental".

Quando se trata de recrutamento de talentos, Jakub Pachocki acredita que a perseverança é uma característica fundamental. A pesquisa, por sua própria natureza, envolve explorar o desconhecido, e muitas tentativas falharão, portanto, é preciso estar preparado para falhar e aprender com elas. Mark Chen acrescentou que não há atalhos na pesquisa; escolher as perguntas certas requer experiência.

https://www.youtube.com/watch?v=KSgPNVmZ8jQ

https://www.youtube.com/watch?v=KSgPNVmZ8jQ

Vencedor do Prêmio Turing: Grandes modelos de linguagem são um beco sem saída

Vencedor do Prêmio Turing: Grandes modelos de linguagem são um beco sem saída

Richard Sutton, vencedor do Prêmio Turing de 2024 e conhecido como o "Pai do Aprendizado por Reforço", disse em uma entrevista recente que grandes modelos de linguagem não podem atingir inteligência verdadeira e serão substituídos por novas arquiteturas.

O ponto central de Sutton é que grandes modelos de linguagem estão essencialmente apenas imitando o comportamento humano, em vez de realmente compreender o mundo.

Na visão de Sutton, a verdadeira inteligência deve advir da interação direta com o ambiente e do aprendizado com a experiência, assim como os animais aprendem na natureza. Ele enfatizou que os animais nunca recebem "aprendizagem supervisionada"; eles aprendem tentando ações e observando os resultados, o que é um mecanismo de aprendizagem comum na natureza.

Quando o apresentador Patel mencionou que grandes modelos de linguagem pareciam ter construído um modelo de mundo, Sutton retrucou: "Imitar pessoas que falam não é o mesmo que construir um modelo de mundo. Um modelo do mundo real deve permitir que você preveja o que vai acontecer, não o que as pessoas vão dizer."

Sutton acredita que o maior problema enfrentado por grandes modelos de linguagem é a falta de um objetivo claro. Ele citou a definição de John McCarthy: "Inteligência é a capacidade computacional de atingir objetivos". Sem um objetivo, é impossível definir qual é o comportamento correto, e o verdadeiro aprendizado não pode ser alcançado.

Ele explicou ainda: "Na aprendizagem por reforço, existe o comportamento correto, porque comportamento correto é aquele que pode receber recompensas. Temos uma definição clara do que é comportamento correto, para que possamos testar e aprender." No entanto, modelos de linguagem de grande porte não possuem esses critérios de avaliação e não conseguem obter feedback e melhorar em interações reais.

Durante a entrevista, Sutton também apontou as falhas fundamentais nas capacidades de generalização dos métodos atuais de aprendizado profundo. Ele acredita que, embora modelos de linguagem de grande porte tenham bom desempenho em determinadas tarefas, esse sucesso geralmente se deve a uma única solução, e não a verdadeiras capacidades de generalização.

"A descida gradiente permite que o sistema encontre soluções para problemas que ele viu, mas se houver várias soluções, algumas das quais generalizam bem e outras generalizam mal, o algoritmo em si não levará o sistema a escolher a solução com boa capacidade de generalização." Sutton disse que isso também explica por que os sistemas de aprendizado profundo são propensos a problemas como o esquecimento catastrófico.

https://www.dwarkesh.com/p/richard-sutton

https://www.dwarkesh.com/p/richard-sutton

O pai da computação quântica: Decifrar a teoria da gravidade quântica pode se tornar um novo padrão para julgar a IAG

O pai da computação quântica: Decifrar a teoria da gravidade quântica pode se tornar um novo padrão para julgar a IAG

Em 25 de setembro, em um evento de diálogo realizado na sede da Axel Springer em Berlim, Alemanha, o CEO da OpenAI, Sam Altman, e David Deutsch, um famoso físico britânico e o "pai da computação quântica", tiveram uma discussão aprofundada sobre os critérios de avaliação da AGI e chegaram a um consenso.

Na visão de Deutsch, a capacidade dos grandes modelos de linguagem de conduzir conversas contínuas depende principalmente da enorme quantidade de treinamento de conhecimento que eles recebem, enquanto a verdadeira inteligência deve ser refletida na capacidade de criar conhecimento – isto é, a capacidade de descobrir problemas, inventar soluções, testá-las e melhorá-las continuamente.

Para ilustrar esse ponto, Deutsch cita a teoria da relatividade de Einstein como exemplo: "Alguns questionam se Einstein realmente criou a teoria da relatividade ou simplesmente combinou mecanicamente ideias existentes. Temos certeza de que sim, porque entendemos seu processo de pesquisa, os problemas que ele procurou abordar e suas motivações."

No entanto, ele também admitiu francamente que acreditava que computadores não conseguiriam ter conversas abertas sem a IA, mas o desempenho do ChatGPT contrariou essa crença. Ele disse: "Embora o ChatGPT não seja uma IA, ele tem a capacidade de ter uma conversa."

Em resposta ao ponto de Deutsch, Altman fez uma pergunta hipotética: se o GPT-8 pudesse resolver o problema da gravidade quântica e detalhar sua história de pesquisa, incluindo a escolha do problema e a motivação para a pesquisa, "isso seria suficiente para convencê-lo?"

Deutsch respondeu definitivamente: "Acho que sim". Ultraman sorriu e disse: "Concordo com isso como um padrão de teste".

https://www.businessinsider.com/sam-altman-predicts-ai-agi-surpass-human-intelligence-2030-2025-9

https://www.businessinsider.com/sam-altman-predicts-ai-agi-surpass-human-intelligence-2030-2025-9

Hora dos ovos de Páscoa

Autor: @azed_ai

Palavra-chave: Uma renderização 3D de baixa poligonal de um [assunto], construída a partir de facetas triangulares limpas com superfícies planas [cor1] e [cor2]. O ambiente é um deserto digital estilizado com geometria mínima e oclusão ambiental.

Link: https://x.com/azed_ai/status/1971892865581350967

#Bem-vindo a seguir a conta pública oficial do WeChat do iFaner: iFaner (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.