A Nvidia construiu uma enorme GPU dupla para alimentar modelos como o ChatGPT

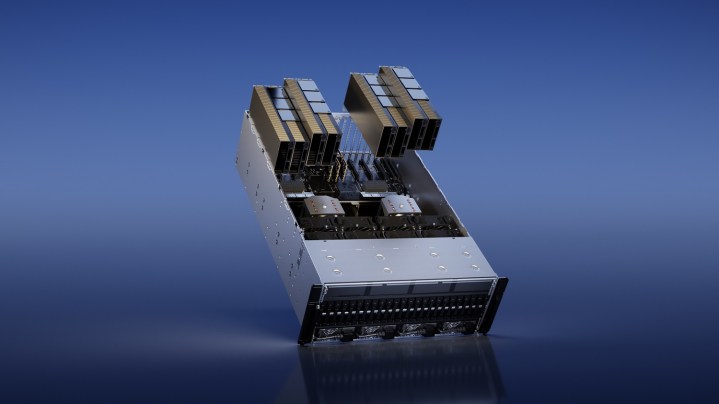

A GPU Technology Conference (GTC) semestral da Nvidia geralmente se concentra em avanços em IA, mas este ano, a Nvidia está respondendo ao aumento maciço do ChatGPT com uma lista de novas GPUs. O principal deles é o H100 NVL, que une duas das GPUs H100 da Nvidia para implantar modelos de linguagem grande (LLM) como o ChatGPT.

O H100 não é uma nova GPU. A Nvidia anunciou há um ano na GTC, ostentando sua arquitetura Hopper e prometendo acelerar a inferência de IA em uma variedade de tarefas. Diz-se que o novo modelo NVL com seus enormes 94 GB de memória funciona melhor ao implantar LLMs em escala, oferecendo inferência até 12 vezes mais rápida em comparação com o A100 da última geração.

Essas GPUs estão no centro de modelos como o ChatGPT. A Nvidia e a Microsoft revelaram recentemente que milhares de GPUs A100 foram usadas para treinar o ChatGPT , que é um projeto que está em andamento há mais de cinco anos.

O H100 NVL funciona combinando duas GPUs H100 sobre a interconexão NVLink de alta largura de banda da Nvidia. Isso já é possível com as atuais GPUs H100 — na verdade, você pode conectar até 256 H100s por meio do NVLink — mas esta unidade dedicada foi criada para implementações menores.

Este é um produto desenvolvido para empresas mais do que qualquer coisa, portanto, não espere ver o H100 NVL aparecer na prateleira do seu Micro Center local. No entanto, a Nvidia diz que os clientes corporativos podem esperar vê-lo por volta do segundo semestre do ano.

Além do H100 NVL, a Nvidia também anunciou a GPU L4, construída especificamente para alimentar vídeos gerados por IA. A Nvidia diz que é 120 vezes mais poderosa para vídeos gerados por IA do que uma CPU e oferece eficiência energética 99% melhor. Além do vídeo AI generativo, a Nvidia diz que a GPU possui recursos de decodificação e transcodificação de vídeo e pode ser aproveitada para realidade aumentada.

A Nvidia diz que o Google Cloud está entre os primeiros a integrar o L4. O Google planeja oferecer instâncias L4 aos clientes por meio de sua plataforma Vertex AI ainda hoje. A Nvidia disse que a GPU estará disponível de parceiros posteriormente, incluindo Lenovo, Dell, Asus, HP, Gigabyte e HP, entre outros.