Repentino! DeepSeek foi questionado pelos Estados Unidos como “roubo” e investigado pela OpenAI e pela Microsoft. O jornal revelou que ele rompeu o fosso da Nvidia.

Durante o Festival da Primavera, uma tempestade em torno de Deepseek está agitando o círculo de IA.

De acordo com o último relatório da Bloomberg, os pesquisadores de segurança da Microsoft descobriram no outono passado que indivíduos possivelmente relacionados ao DeepSeek estavam conduzindo extração de dados em grande escala por meio da API da OpenAI.

De acordo com pessoas familiarizadas com o assunto, como parceira tecnológica e maior financiadora da OpenAI, a Microsoft notificou imediatamente a OpenAI após descobrir a situação.

Segundo relatos, esse comportamento pode violar os termos de serviço da OpenAI. Porque os termos de serviço da OpenAI afirmam claramente que os usuários não podem usar métodos automatizados ou programáticos para extrair dados de seus serviços sem autorização.

Mesmo que o DeepSeek obtenha alguma forma de acesso à API, isso pode ser considerado uma violação dos termos de serviço se for usado de uma forma que exceda o escopo da autorização da OpenAI, como para fins comerciais ilegais ou não autorizados.

A OpenAI não respondeu aos pedidos de comentários, a Microsoft recusou-se a comentar e a DeepSeek ainda não respondeu.

Vale ressaltar que muitos de fora acreditavam anteriormente que o DeepSeek pode ter usado os dados de saída de modelos como ChatGPT como materiais de treinamento durante o processo de treinamento. Por meio da tecnologia de destilação de modelo, o "conhecimento" desses dados foi migrado para o próprio modelo do DeepSeek.

Essa prática não é incomum no campo da IA, mas os céticos estão preocupados se o DeepSeek usou os dados de saída do modelo OpenAI sem divulgação completa. Isso parece refletir-se na autoconsciência do DeepSeek-V3.

No relatório técnico do último modelo R1, a equipe DeepSeek deixou claro que os dados de saída do modelo OpenAI não foram utilizados e afirmou que o alto desempenho foi alcançado por meio de aprendizado por reforço e uma estratégia de treinamento exclusiva.

Por exemplo, um método de treinamento em vários estágios é adotado, incluindo treinamento de modelo básico, treinamento de aprendizagem por reforço (RL), ajuste fino, etc. Este método de treinamento cíclico em vários estágios ajuda o modelo a absorver diferentes conhecimentos e habilidades em diferentes estágios.

Usuários anteriores descobriram que, quando questionados sobre a identidade de um modelo, ele se confundia com GPT-4.

O relatório da Bloomberg também apontou que David Sacks, chefe de assuntos de IA dos EUA, disse em uma entrevista recente à Fox News que há “evidências conclusivas” de que DeepSeek usa os dados de saída do modelo OpenAI para desenvolver sua própria tecnologia. No entanto, Sacks não forneceu provas específicas.

Muitas autoridades dos EUA também afirmaram que o DeepSeek é suspeito de “roubo” e estão lançando uma investigação de segurança nacional sobre o seu impacto.

Em resposta às observações de David Sacks, a resposta da OpenAI foi relativamente conservadora e cautelosa. Seu porta-voz disse: “Sabemos que as empresas da China, assim como algumas outras empresas, têm tentado ‘destilar’ os modelos das principais empresas americanas de IA”.

O porta-voz enfatizou que, como líder no campo da IA, a OpenAI tomou contramedidas correspondentes para proteger os seus direitos de propriedade intelectual, incluindo uma triagem rigorosa das capacidades de ponta e a decisão de quais funções podem ser divulgadas publicamente. Eles acreditam que trabalhar em estreita colaboração com o governo dos EUA é fundamental para proteger os modelos de IA de última geração.

No entanto, à medida que esta controvérsia continua a fermentar, a atenção da mídia estrangeira também começou a se voltar para o modelo V3 de código aberto lançado anteriormente pela DeepSeek, que também divulgou detalhadamente os detalhes relevantes de otimização subjacentes por meio de um relatório técnico.

A mídia estrangeira revelou que o desenvolvimento do modelo V3 até contornou o CUDA e alcançou desempenho máximo otimizando a linguagem assembly de baixo nível da GPU NVIDIA PTX.

PTX é uma arquitetura de conjunto de instruções intermediárias para GPUs NVIDIA que permite otimizações refinadas, como alocação de registro e ajuste de nível de thread/warp. Se CUDA é uma “linguagem de alto nível” que se comunica com GPUs NVIDIA, então PTX é como uma “linguagem de máquina de baixo nível”.

Imagine que você está jogando um console de videogame. Normalmente, só precisamos usar um controlador (como CUDA) para jogar, o que é muito conveniente, mas pode não ser capaz de usar toda a força do console de jogo.

O PTX é como abrir a tampa traseira do console de jogo e ajustar diretamente vários acessórios e circuitos internos. Embora fazer isso seja complicado e exija muito conhecimento profissional, pode fazer com que o console de jogo funcione mais rápido e tenha melhor desempenho.

Simplificando, PTX é uma ferramenta que permite aos desenvolvedores “levantar a tampa” da GPU e ajustar diretamente seu funcionamento interno. É como modificar um carro: em vez de simplesmente pressionar o acelerador, você ajusta diretamente cada parte do motor para obter o máximo desempenho.

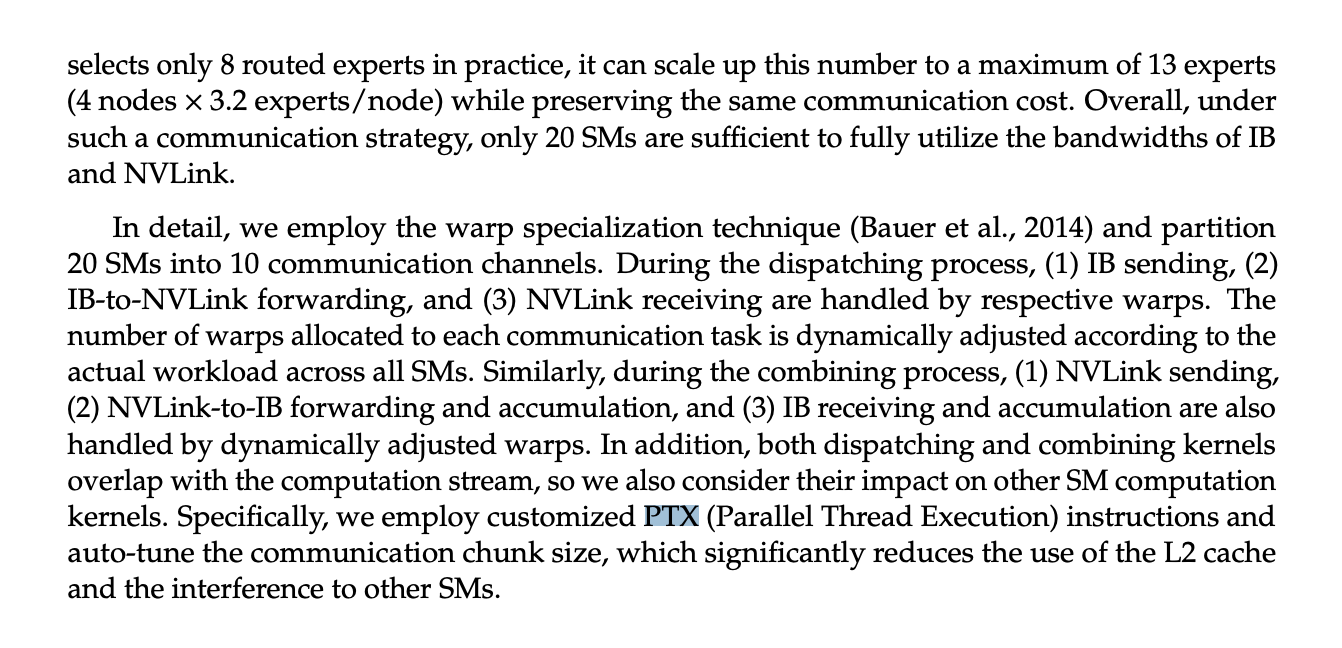

Quando DeepSeek treinou o modelo V3, ele reconfigurou a GPU H800, incluindo a divisão de 20 SMs para comunicação entre servidores e a implementação de um algoritmo de pipeline avançado. Os recursos de otimização excederam em muito o nível de desenvolvimento CUDA convencional. Se esta tecnologia for verdadeira, também irá abalar o fosso de hardware que a Nvidia construiu há muito tempo.

▲ Captura de tela da imagem do relatório técnico do DeepSeek v3

No entanto, embora o PTX possa trazer uma otimização de desempenho mais extrema, ele também impõe exigências extremamente altas à equipe de desenvolvimento. Em contraste, o fosso CUDA da NVIDIA ainda é a primeira escolha para a maioria dos desenvolvedores devido às suas vantagens de facilidade de desenvolvimento e rápida iteração.

Além do mais, a otimização PTX geralmente requer personalização para um modelo específico de hardware.

Embora esta estratégia de otimização "sob medida" seja eficaz, ela também aumenta muito a dificuldade de desenvolvimento e os custos de manutenção. Isto também explica por que o CUDA ainda dominará o desenvolvimento dominante no futuro próximo.

No entanto, buscar avanços fora das regras existentes é muitas vezes o início da subversão. Desta vez, pode-se esperar que a onda tecnológica desencadeada pela DeepSeek no país e no exterior alavanque a ordem existente de toda a cadeia da indústria de IA.

# Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.