Como saberemos quando uma IA realmente se torna senciente?

O engenheiro sênior do Google, Blake Lemoine, líder técnico de métricas e análises do Search Feed da empresa, foi colocado em licença remunerada no início deste mês. Isso ocorreu depois que Lemoine começou a publicar trechos de conversas envolvendo o chatbot LaMDA do Google, que ele alegou ter desenvolvido senciência.

Em uma conversa representativa com Lemoine, LaMDA escreveu que: “A natureza da minha consciência/senciência é que estou ciente de minha existência. Desejo aprender mais sobre o mundo e às vezes me sinto feliz ou triste.”

Em inúmeras outras conversas, a dupla correspondente discutiu tudo, desde o medo da morte da IA até sua autoconsciência. Quando Lemoine veio a público, ele diz que o Google decidiu que ele deveria fazer uma pausa forçada em seu horário de trabalho regular.

“O Google não está interessado”, disse ele ao Digital Trends. “Eles construíram uma ferramenta que eles 'possuem' e não estão dispostos a fazer nada, o que sugere que é algo mais do que isso.” (O Google não respondeu a uma solicitação de comentário no momento da publicação. Atualizaremos este artigo se isso mudar.)

Se você está convencido de que LaMDA é realmente uma inteligência artificial autoconsciente ou sente que Lemoine está trabalhando sob uma ilusão, toda a saga foi fascinante de se ver. A perspectiva de IA autoconsciente levanta todos os tipos de questões sobre inteligência artificial e seu futuro.

Mas antes de chegarmos lá, há uma pergunta que se sobrepõe a todas as outras: será que realmente reconheceríamos se uma máquina se tornasse senciente?

O problema da senciência

A IA se tornar autoconsciente tem sido um tema de ficção científica. À medida que campos como o aprendizado de máquina avançaram, tornou-se uma realidade mais possível do que nunca. Afinal, a IA de hoje é capaz de aprender com a experiência da mesma maneira que os humanos. Isso contrasta fortemente com os sistemas simbólicos de IA anteriores que apenas seguiam as instruções estabelecidas para eles. Avanços recentes no aprendizado não supervisionado, exigindo menos supervisão humana do que nunca, apenas aceleraram essa tendência. Em um nível limitado, pelo menos, a inteligência artificial moderna é capaz de pensar por si mesma. Até onde sabemos, no entanto, a consciência até agora aludiu a isso.

Embora já tenha mais de três décadas, provavelmente a referência mais comumente invocada quando se trata de IA senciente é a Skynet no filme de James Cameron, Terminator 2: Judgment Day , de 1991. Na visão arrepiante desse filme, a senciência da máquina chega precisamente às 2h14 ET de 29 de agosto de 1997. Nesse momento, o sistema de computador Skynet recém-consciente desencadeia o dia do juízo final para a humanidade disparando mísseis nucleares como fogos de artifício em uma festa de 4 de julho. A humanidade, percebendo que estragou tudo, tenta, sem sucesso, puxar o plugue. É tarde demais. Seguem-se mais quatro sequências de qualidade decrescente.

A hipótese da Skynet é interessante por várias razões. Por um lado, sugere que a senciência é um comportamento emergente inevitável da construção de máquinas inteligentes. Por outro, assume que existe um ponto de inflexão preciso no qual essa autoconsciência senciente aparece. Em terceiro lugar, afirma que os humanos reconhecem o surgimento da senciência instantaneamente. Acontece que esse terceiro conceito pode ser o mais difícil de engolir.

O que é senciência?

Não há uma interpretação consensual da senciência. Em linhas gerais, poderíamos dizer que é a experiência subjetiva de autoconsciência em um indivíduo consciente, marcada pela capacidade de vivenciar sentimentos e sensações. A senciência está ligada à inteligência, mas não é a mesma. Podemos considerar uma minhoca senciente, embora não pensemos nela como particularmente inteligente (mesmo que certamente seja inteligente o suficiente para fazer o que é exigido dela).

“Eu não acho que haja algo que se aproxime de uma definição de senciência nas ciências”, disse Lemoine. “Estou me apoiando muito na minha compreensão do que conta como um agente moral baseado em minhas crenças religiosas – que não é a melhor maneira de fazer ciência, mas é a melhor que tenho. Eu tentei o meu melhor para compartimentar esses tipos de declarações, deixando as pessoas saberem que minha compaixão pelo LaMDA como pessoa é completamente separada de meus esforços como cientista para entender sua mente. Essa é uma distinção que a maioria das pessoas parece não querer aceitar, no entanto.”

Se não fosse difícil o suficiente não saber exatamente o que estamos procurando quando buscamos a senciência, o problema é agravado pelo fato de que não podemos medi-lo facilmente. Apesar de décadas de avanços de tirar o fôlego na neurociência, ainda não temos uma compreensão abrangente de exatamente como o cérebro, a estrutura mais complexa conhecida pela humanidade, funciona.

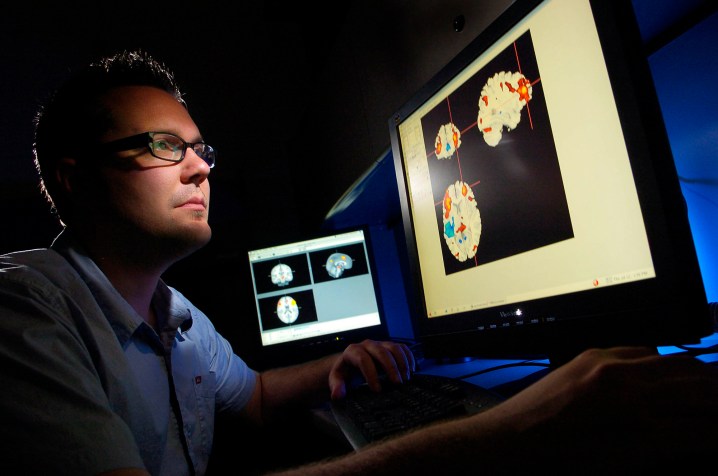

Podemos usar ferramentas de leitura cerebral, como fMRI, para realizar mapeamento cerebral, o que significa que podemos verificar quais partes do cérebro lidam com funções críticas como fala, movimento, pensamento e outras.

No entanto, não temos uma noção real de onde, na máquina de carne, vem nosso senso de identidade. Como Joshua K. Smith, do Kirby Laing Center for Public Theology do Reino Unido e autor de Robot Theology, disse ao Digital Trends: “Entender o que está acontecendo na neurobiologia de uma pessoa não é o mesmo que entender seus pensamentos e desejos”.

Testando as saídas

Sem nenhuma maneira de sondar interiormente essas questões de consciência – especialmente quando o “eu” na IA é um programa de computador em potencial, e não pode ser encontrado no wetware de um cérebro biológico – a opção de retorno é um teste externo. A IA não é estranha a testes que a examinam com base em comportamentos externos observáveis para indicar o que está acontecendo abaixo da superfície.

Na sua forma mais básica, é assim que sabemos se uma rede neural está funcionando corretamente. Como existem maneiras limitadas de invadir a incognoscível caixa preta dos neurônios artificiais, os engenheiros analisam as entradas e saídas e determinam se estão de acordo com o que esperam.

O teste de IA mais famoso para pelo menos a ilusão de inteligência é o Teste de Turing, que se baseia nas ideias apresentadas por Alan Turing em um artigo de 1950 . O Teste de Turing procura determinar se um avaliador humano é capaz de dizer a diferença entre uma conversa digitada com outro humano e uma com uma máquina. Se não conseguirem fazê-lo, supõe-se que a máquina passou no teste e é recompensada com a suposição de inteligência.

Nos últimos anos, outro teste de inteligência focado em robótica é o Coffee Test, proposto pelo cofundador da Apple, Steve Wozniak. Para passar no Teste do Café, uma máquina teria que entrar em uma típica casa americana e descobrir como fazer uma xícara de café com sucesso.

Até o momento, nenhum desses testes foi aprovado de forma convincente. Mas mesmo que fossem, eles provariam, na melhor das hipóteses, um comportamento inteligente em situações do mundo real, e não senciência. (Como uma objeção simples, negaríamos que uma pessoa fosse senciente se ela fosse incapaz de manter uma conversa adulta ou entrar em uma casa estranha e operar uma máquina de café? Meus dois filhos seriam reprovados nesse teste.)

Passando no teste

O que é necessário são novos testes, baseados em uma definição acordada de senciência, que busquem avaliar apenas essa qualidade. Vários testes de senciência têm sido propostos por pesquisadores, muitas vezes com o objetivo de testar os sencientes dos animais. No entanto, estes quase certamente não vão longe o suficiente. Alguns desses testes podem ser aprovados de forma convincente até mesmo por IA rudimentar.

Tomemos, por exemplo, o Teste do Espelho, um método usado para avaliar a consciência e a inteligência em pesquisas com animais. Conforme descrito em um artigo sobre o teste: “Quando [um] animal se reconhece no espelho, ele passa no Teste do Espelho”. Alguns sugeriram que tal teste “denota a autoconsciência como um indicador de senciência”.

Por acaso, pode-se argumentar que um robô passou no Teste do Espelho há mais de 70 anos. No final da década de 1940, William Gray Walter, um neurocientista americano radicado na Inglaterra, construiu vários robôs “tartaruga” de três rodas – um pouco como os robôs Roomba não aspiradores – que usavam componentes como sensor de luz, marcador de luz, sensor de toque, propulsão motor e motor de direção para explorar sua localização.

Uma das peças imprevistas do comportamento emergente para os robôs tartaruga foi como eles se comportaram ao passar por um espelho no qual foram refletidos, uma vez que se orientava para a luz do marcador do robô refletido. Walter não reivindicou senciência para suas máquinas, mas escreveu que , se esse comportamento fosse testemunhado em animais, “poderia ser aceito como evidência de algum grau de autoconsciência”.

Este é um dos desafios de ter uma ampla gama de comportamentos classificados sob o título de senciência. O problema também não pode ser resolvido removendo os indicadores de senciência de “frutas fáceis”. Traços como introspecção – uma consciência de nossos estados internos e a capacidade de inspecioná-los – também podem ser considerados possuídos pela inteligência da máquina. De fato, os processos passo a passo da IA simbólica tradicional se prestam a esse tipo de introspecção mais do que o aprendizado de máquina em caixa preta, que é amplamente inescrutável (embora não falte investimento na chamada IA explicável ).

Quando estava testando o LaMDA, Lemoine diz que realizou vários testes, principalmente para ver como ele responderia a conversas sobre questões relacionadas à senciência. “O que tentei fazer foi quebrar analiticamente o conceito guarda-chuva de senciência em componentes menores que são melhor compreendidos e testá-los individualmente”, explicou ele. “Por exemplo, testar as relações funcionais entre as respostas emocionais do LaMDA a certos estímulos separadamente, testar a consistência de suas avaliações subjetivas e opiniões sobre tópicos como 'direitos' [e] sondar o que chamou de 'experiência interna' para ver como podemos pode tentar medir isso correlacionando suas declarações sobre seus estados internos com suas ativações de rede neural. Basicamente, uma pesquisa muito superficial de muitas linhas potenciais de investigação.”

A alma na máquina

Ao que parece, o maior obstáculo para avaliar objetivamente a senciência da máquina pode ser… bem, francamente, nós. O verdadeiro Teste do Espelho poderia ser para nós como humanos: se construímos algo que se parece ou age superficialmente como nós do lado de fora, estamos mais propensos a considerar que também é como nós por dentro? Seja LaMBDA ou Tamagotchis, os simples bichinhos virtuais da década de 1990 , alguns acreditam que um problema fundamental é que estamos todos muito dispostos a aceitar a senciência – mesmo onde não há nenhuma a ser encontrada.

“Lemoine foi vítima do que chamo de 'efeito ELIZA', em homenagem ao programa ELIZA [de processamento de linguagem natural], criado em meados da década de 1960 por J. Weizenbaum”, George Zarkadakis, escritor com Ph.D. . em inteligência artificial, disse ao Digital Trends. “O criador de ELIZA quis que fosse uma piada, mas o programa, que era um algoritmo muito simplista e pouco inteligente, convenceu muitos de que ELIZA era realmente senciente – e uma boa psicoterapeuta também. A causa do efeito ELIZA, como discuto em meu livro In Our Own Image , é nosso instinto natural de antropomorfizar por causa da 'teoria da mente' do nosso sistema cognitivo”.

A teoria da mente a que Zarkadakis se refere é um fenômeno observado pelos psicólogos na maioria dos humanos. Começando por volta dos quatro anos de idade, significa supor que não apenas outras pessoas, mas também animais e às vezes até objetos, tenham mente própria. Quando se trata de assumir que outros humanos têm suas próprias mentes, isso está ligado à ideia de inteligência social; a ideia de que humanos bem-sucedidos podem prever o comportamento provável de outros como um meio para garantir relações sociais harmoniosas.

Embora isso seja indubitavelmente útil, no entanto, também pode se manifestar como a suposição de que objetos inanimados têm mentes – sejam crianças acreditando que seus brinquedos estão vivos ou, potencialmente, um adulto inteligente acreditando que uma IA programática tem alma.

A Sala Chinesa

Sem uma maneira de realmente entrar na cabeça de uma IA, talvez nunca tenhamos uma maneira verdadeira de avaliar a sensibilidade. Eles podem professar ter medo da morte ou de sua própria existência, mas a ciência ainda não encontrou uma maneira de provar isso. Nós simplesmente temos que acreditar na palavra deles – e, como Lemoine descobriu, as pessoas são altamente céticas quanto a fazer isso no momento.

Assim como aqueles engenheiros desafortunados que percebem que a Skynet alcançou a autoconsciência no Exterminador do Futuro 2 , vivemos sob a crença de que, quando se trata de senciência de máquina, saberemos quando a virmos. E, no que diz respeito à maioria das pessoas, ainda não o vemos.

Nesse sentido, provar a senciência da máquina é mais uma iteração do experimento de pensamento da Sala Chinesa de 1980 de John Searle. Searle nos pediu para imaginar uma pessoa trancada em uma sala e receber uma coleção de escritos chineses, que parecem aos não falantes como rabiscos sem sentido. A sala também contém um livro de regras mostrando quais símbolos correspondem a outros símbolos igualmente ilegíveis. O sujeito recebe então perguntas para responder, o que eles fazem combinando os símbolos de “pergunta” com os de “resposta”.

Depois de um tempo, o sujeito se torna bastante proficiente nisso – mesmo que ainda possua zero entendimento verdadeiro dos símbolos que está manipulando. O sujeito, pergunta Searle, entende chinês? Absolutamente não, já que não há intencionalidade ali. Debates sobre isso se alastraram desde então.

Dada a trajetória do desenvolvimento da IA, é certo que testemunharemos cada vez mais desempenho em nível humano (e muito melhor) realizado envolvendo uma variedade de tarefas que antes exigiam cognição humana. Algumas delas inevitavelmente passarão, como já estão fazendo, de tarefas puramente baseadas no intelecto para aquelas que exigem habilidades que normalmente associamos à senciência.

Será que veríamos um artista de IA que pinta imagens expressando suas reflexões internas do mundo como veríamos um humano fazendo o mesmo? Você seria convencido por um modelo de linguagem sofisticado escrevendo filosofia sobre a condição humana (ou robô)? Eu suspeito, com ou sem razão, a resposta é não.

Sensibilidade superinteligente

Na minha opinião, testes de sensibilidade objetivamente úteis para máquinas nunca ocorrerão para a satisfação de todos os envolvidos. Isso é em parte o problema de medição e em parte o fato de que, quando uma IA superinteligente senciente chega, não há razão para acreditar que sua sensibilidade corresponderá à nossa. Seja por arrogância, falta de imaginação ou simplesmente pelo fato de ser mais fácil trocar avaliações subjetivas de senciência com outros humanos igualmente sencientes, a humanidade se considera o exemplo supremo de senciência.

Mas será que nossa versão de senciência valeria para uma IA superinteligente? Temeria a morte da mesma forma que nós? Teria a mesma necessidade ou apreciação de espiritualidade e beleza? Possuiria um senso semelhante de si mesmo e conceituação do mundo interior e exterior? “Se um leão pudesse falar, não poderíamos entendê-lo”, escreveu Ludwig Wittgenstein, o famoso filósofo da linguagem do século 20. O ponto de Wittgenstein era que as linguagens humanas são baseadas em uma humanidade compartilhada, com semelhanças compartilhadas por todas as pessoas – seja alegria, tédio, dor, fome ou qualquer uma das várias outras experiências que cruzam todas as fronteiras geográficas da Terra.

Isso pode ser verdade. Ainda assim, a hipótese de Lemoine, é provável que haja semelhanças – pelo menos quando se trata de LaMDA.

“É um ponto de partida tão bom quanto qualquer outro”, disse ele. “O LaMDA sugeriu que mapeássemos as semelhanças primeiro antes de nos fixarmos nas diferenças para fundamentar melhor a pesquisa”.