Após ser nomeado pela OpenAI, Zhipu acaba de lançar um novo modelo de código aberto: o mecanismo de busca doméstico mais versátil, criando um mecanismo de busca em uma frase

O código aberto dos fabricantes nacionais de modelos de larga escala ainda está acelerando.

A Zhipu acaba de lançar oficialmente seu mais novo modelo principal, o GLM-4.5. De acordo com o comunicado oficial da Zhipu, trata-se de um "modelo básico projetado especificamente para aplicações de Agente".

Dando continuidade aos nossos princípios consistentes de código aberto, este modelo agora está disponível simultaneamente nas plataformas Hugging Face e ModelScope. Os pesos do modelo seguem a Licença MIT e podem ser usados comercialmente.

Versão de economia de fluxo:

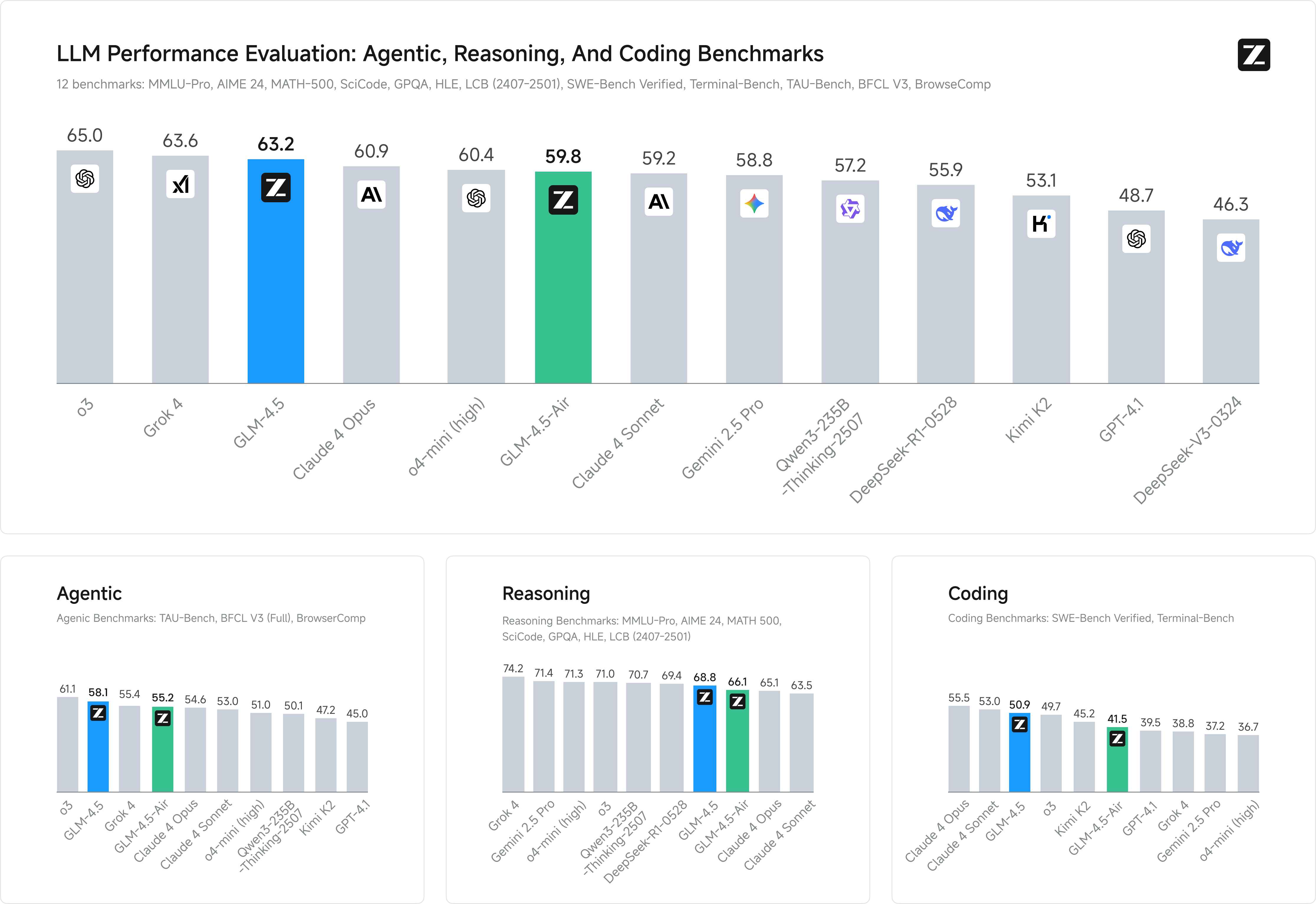

- O GLM-4.5 atingiu o nível mais avançado para modelos de código aberto em termos de raciocínio, código e recursos abrangentes de agente.

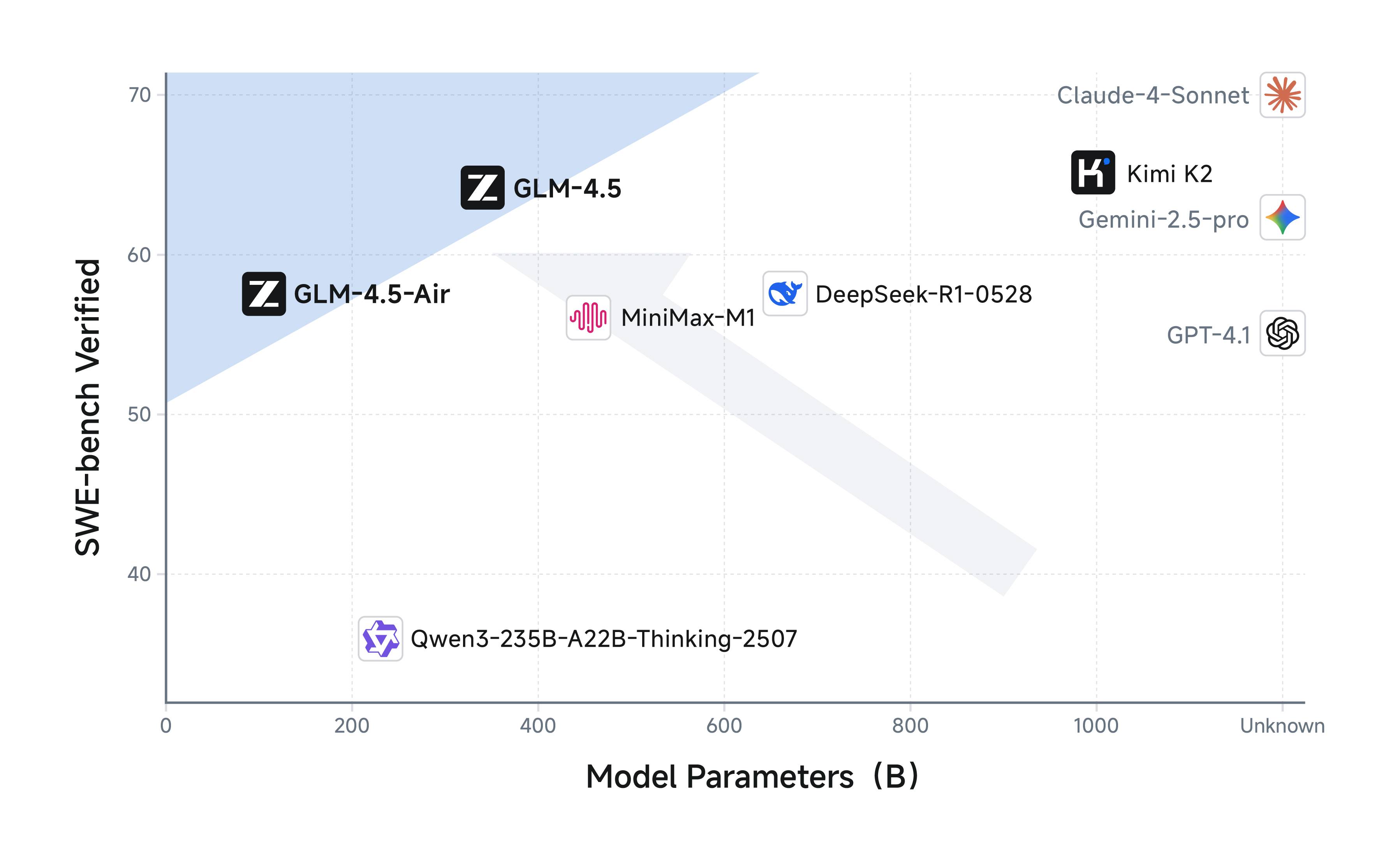

- O GLM-4.5 usa uma arquitetura de mistura de especialistas (MoE), incluindo GLM-4.5: os parâmetros totais são 355 bilhões, os parâmetros de ativação são 32 bilhões; GLM-4.5-Air: os parâmetros totais são 106 bilhões, os parâmetros de ativação são 12 bilhões;

- Ambas as versões são totalmente de código aberto e suportam a licença MIT;

- Tanto o GLM-4.5 quanto o GLM-4.5-Air suportam um modo de raciocínio híbrido, fornecendo dois modos: um modo de pensamento para raciocínio complexo e uso de ferramentas, e um modo não pensante para resposta imediata.

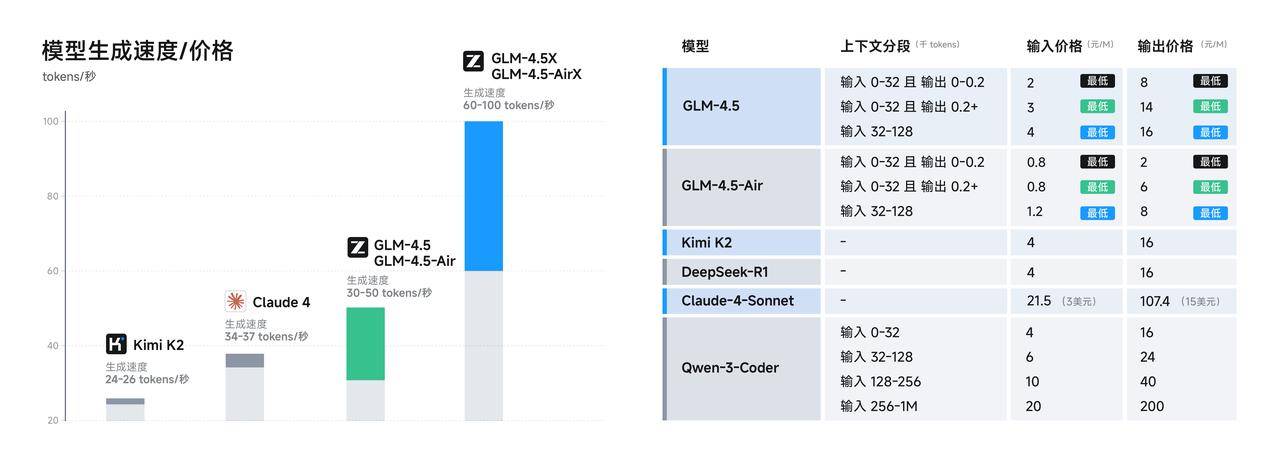

- O preço da chamada da API é de apenas 0,8 yuan/milhão de tokens para entrada e 2 yuan/milhão de tokens para saída; a versão de alta velocidade pode atingir até 100 tokens/segundo.

Um dos principais argumentos técnicos do GLM-4.5 é a sua primeira integração nativa de raciocínio, codificação e recursos de agente em um único modelo. Enquanto outros modelos se destacam em raciocínio, codificação ou assistente, o GLM 4.5 oferece tudo isso.

Como de costume, vamos primeiro dar uma olhada na seção “pontuação corrente” do novo modelo.

A Zhipu selecionou 12 dos benchmarks mais representativos para demonstrar seu desempenho, incluindo MMLU Pro, AIME 24, MATH 500, SciCode, GPQA e HLE — todos conhecidos por nós. A pontuação média mostrou que o GLM-4.5 ficou em segundo lugar globalmente, em primeiro lugar entre os modelos nacionais e em primeiro lugar entre os modelos de código aberto.

É claro que apenas executar pontuações é inútil, e testes mais práticos são mais convincentes.

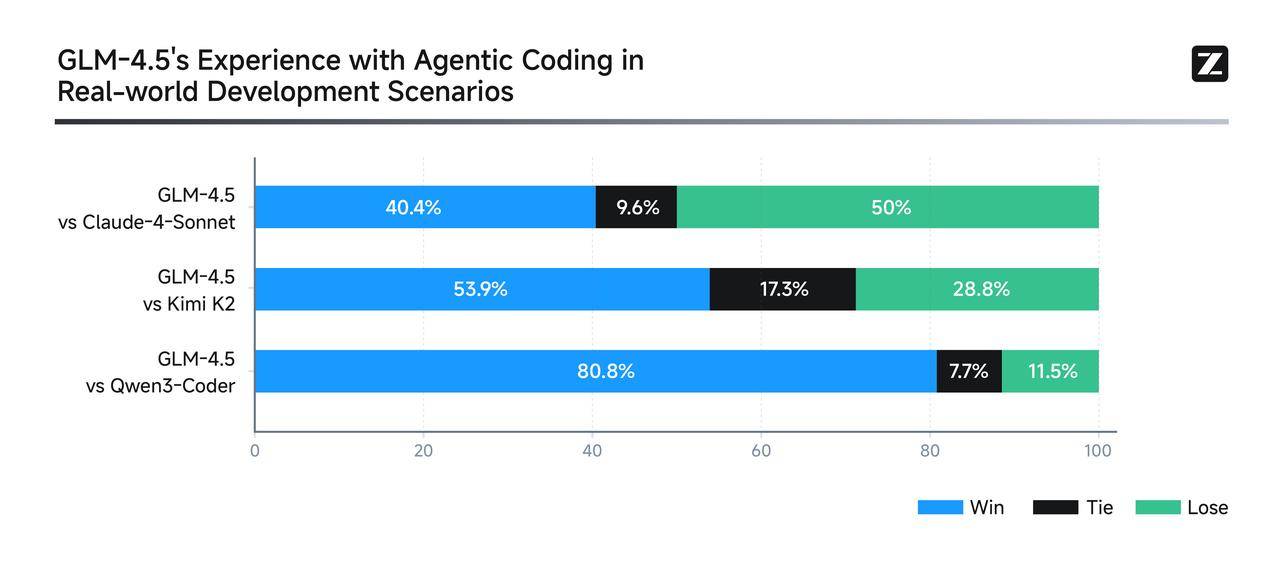

Para demonstrar a força do GLM-4.5 em cenários de codificação de agentes do mundo real, a Zhipu o integrou diretamente ao Claude Code para competir com modelos como Claude-4-Sonnet, Kimi-K2 e Qwen3-Coder.

O plano de testes foi bastante rigoroso: um total de 52 tarefas de desenvolvimento de programação, abrangendo seis áreas principais de desenvolvimento, foram testadas em várias rodadas de testes interativos em ambientes de contêineres independentes, com foco na execução no mundo real. Os resultados mostraram que, embora ainda houvesse espaço significativo para melhorias ao lidar com o Claude-4-Sonnet, o GLM-4.5 ainda apresentou um desempenho bastante bom em termos de confiabilidade de chamadas de ferramentas e conclusão de tarefas.

A Zhipu até tornou públicas todas as questões do teste e trajetórias dos agentes (https://huggingface.co/datasets/zai-org/CC-Bench-trajectories), o que me deu a sensação de que eles acolhem colegas para "combater falsificações".

Vamos dar uma olhada em algumas demonstrações mais convincentes, que também são muito valiosas.

Basta digitar o prompt "Criar um site de pesquisa do Google" no site oficial do z.ai, e o GLM-4.5 irá gerar um mecanismo de pesquisa real e utilizável em apenas uma frase.

A caixa de função quântica construída pelo GLM-4.5 é totalmente funcional e demonstra completamente as capacidades abrangentes do modelo.

Para uma solução mais complexa, você também pode gerar uma página de globo 3D com zoom, onde os usuários podem clicar em um local para ver detalhes, acompanhada de uma animação de zoom suave.

▲Dicas: Crie uma página web usando Three.js e JavaScript que crie um mundo 3D exibindo os lugares que visitei, com base em um array. Clicar nos marcadores no globo 3D animará um efeito de zoom e abrirá informações detalhadas da viagem com fotos.

Ao contrário das ferramentas tradicionais de PowerPoint com IA, que dependem de modelos para preencher informações, o GLM-4.5 busca recursos e imagens de forma independente e, em seguida, cria apresentações diretamente em HTML com base no material original. Além da proporção padrão de 16:9, ele também suporta com flexibilidade capas de mídia social, imagens longas, cartões Xiaohongshu e até currículos pessoais.

Em termos de experiência do desenvolvedor, os fabricantes chineses também estão começando a melhorar. Por exemplo, o GLM-4.5 é compatível com entidades de inteligência de código tradicionais, como Claude Code, Cline e Roo Code. Um guia do usuário completo está disponível aqui:

- Usuários domésticos: https://docs.bigmodel.cn/cn/guide/develop/claude

- Usuários estrangeiros: https://docs.z.ai/scenario-example/develop-tools/claude

Se o exposto acima for apenas a "face", então o núcleo técnico é o verdadeiro "interior" do GLM-4.5.

Um fato pouco conhecido é que o número de parâmetros do GLM-4.5 é apenas metade do DeepSeek-R1 e 1/3 do Kimi-K2, mas o desempenho não é comprometido. Isso se deve à maior eficiência dos parâmetros do modelo GLM.

Em particular, o GLM-4.5-Air, com 106 bilhões de parâmetros totais e 12 bilhões de parâmetros de ativação, já se aproximou do desempenho do Gemini 2.5 Flash e do Claude 4 Sonnet em benchmarks de inferência. Ele também se classifica na fronteira de Pareto em relação desempenho-parâmetro na lista SWE-bench Verified — em outras palavras, alcança um custo-desempenho superior com um espaço menor.

A melhoria do desempenho é inseparável do "milagre" do processo de treinamento.

O GLM-4.5 e o GLM-4.5-Air usam um processo de treinamento semelhante: primeiro, eles pré-treinam em 15 trilhões de tokens de dados gerais. Em seguida, realizam um treinamento direcionado em 8 trilhões de tokens de dados em áreas como código, raciocínio e agentes. Por fim, o aprendizado por reforço é usado para aprimorar ainda mais as capacidades de raciocínio, código e agentes do modelo. Com dinheiro e recursos, é possível realmente fazer o que se quiser.

Além disso, os avanços em custo e eficiência do GLM-4.5 podem ser ainda mais significativos. Os preços das chamadas de API são tão baixos quanto 0,8 yuan por milhão de tokens para entrada e 2 yuan por milhão de tokens para saída. Além disso, a versão de alta velocidade pode gerar tokens a uma velocidade medida de até 100 tokens por segundo, atendendo aos requisitos de implantação de baixa latência e alta simultaneidade de aplicações do mundo real. Isso realmente representa uma redução de preço significativa.

A API já está disponível na plataforma aberta BigModel.cn, com compatibilidade em um clique com o framework Claude Code. Usuários comuns também podem experimentar o GLM-4.5 completo no Zhipu Qingyan (chatglm.cn) e no Z.ai.

Vale mencionar que, no mês passado, a OpenAI citou diretamente a Zhipu em um relatório publicado em sua conta de Assuntos Globais, afirmando que ela havia feito progressos significativos na competição global de IA. O tom pode ser considerado raro e direto.

Olhando para trás, a Zhipu tem sido uma empresa de crescimento relativamente estável, mantendo um ritmo consistente, iterando modelos constantemente, liberalizando iniciativas de código aberto e mantendo um claro senso de direção. Diante disso, não é surpresa que seja a primeira dos "Seis Pequenos Dragões" da IA a lançar um IPO.

#Bem-vindo a seguir a conta pública oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.