Agora mesmo, OpenAI lançou o3! Rompendo novamente os limites da IA, ex-alunos da Universidade de Pequim participam de pesquisa e desenvolvimento

Agora mesmo, OpenAI deu início ao final do AI Spring Festival Gala de final de ano.

Os modelos da série o3 lançados desta vez são versões iterativas do o1. Considerando que pode haver conflitos de direitos autorais ou marcas registradas com a operadora de telecomunicações britânica O2, a OpenAI decidiu pular a nomenclatura "o2" e adotar diretamente "o3".

Por esse motivo, o CEO da OpenAI, Sam Altman, até riu da confusão da empresa na nomenclatura dos modelos.

A conferência foi organizada por Sam Altman, vice-presidente sênior de pesquisa, Mark Chen, e pelo cientista pesquisador Hongyu Ren.

É importante notar que Ren Hongyu se formou na Universidade de Pequim com bacharelado. Ele fez contribuições fundamentais para o1 e também é o desenvolvedor principal do GPT-4o. Ele tem ampla experiência em estágio de pesquisa na Apple, Microsoft e Nvidia.

A série o3 inclui dois modelos de grande sucesso:

- OpenAI o3: versão principal com desempenho poderoso

- OpenAI o3 mini: modelo leve, porém mais rápido e barato, com foco no custo-benefício

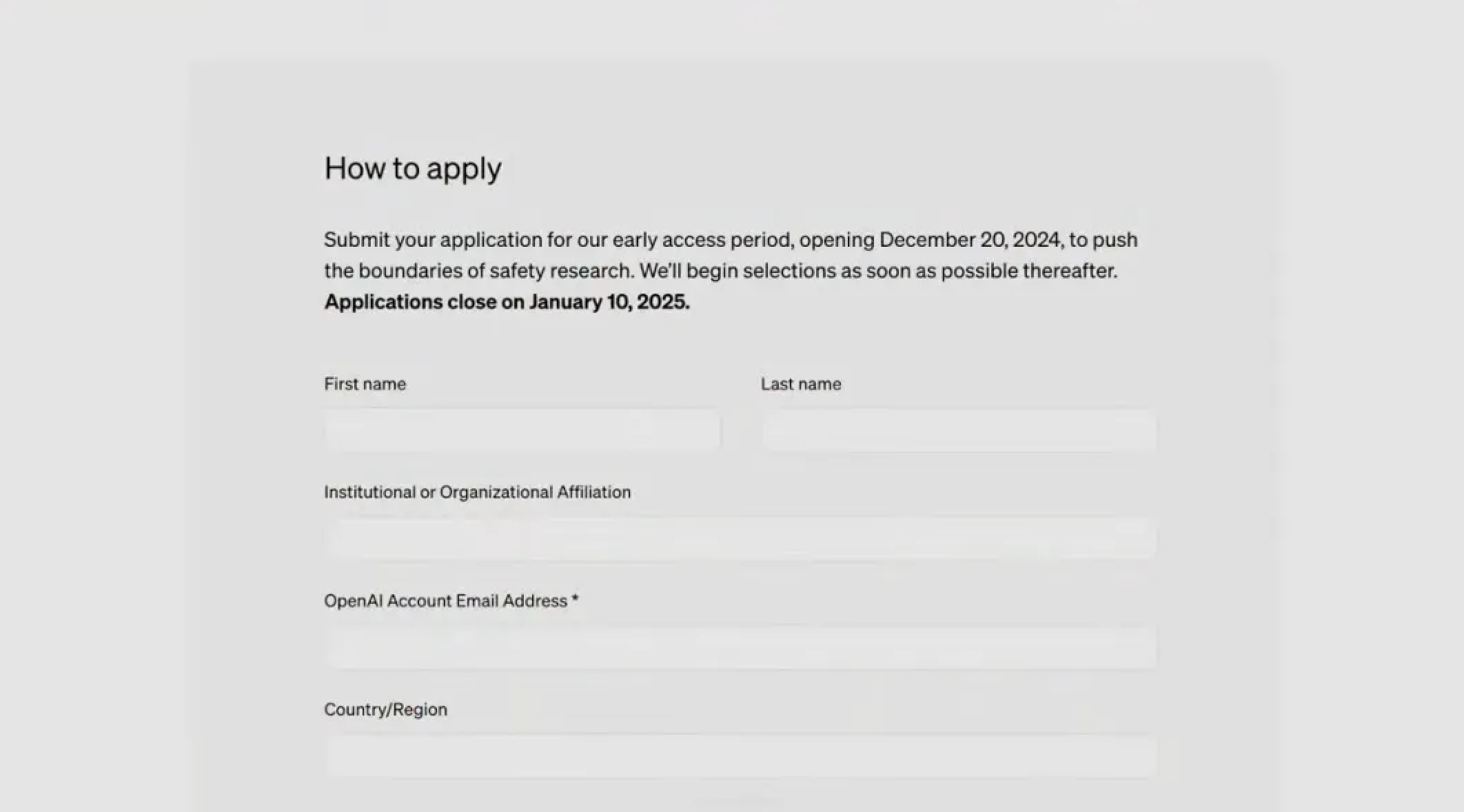

Não se precipite em ficar feliz, porque a série o3 não está atualmente aberta para usuários comuns. A OpenAI planeja abrir primeiro aplicativos para testes de segurança externos, e o lançamento oficial está previsto para janeiro do próximo ano.

Agora, os amigos interessados podem enviar uma inscrição:

https://openai.com/index/early-access-for-safety-testing/

o3 Grande salto no desempenho, memorização mecânica? não existe

Os “parâmetros do papel” do modelo o3 foram melhorados em todos os aspectos.

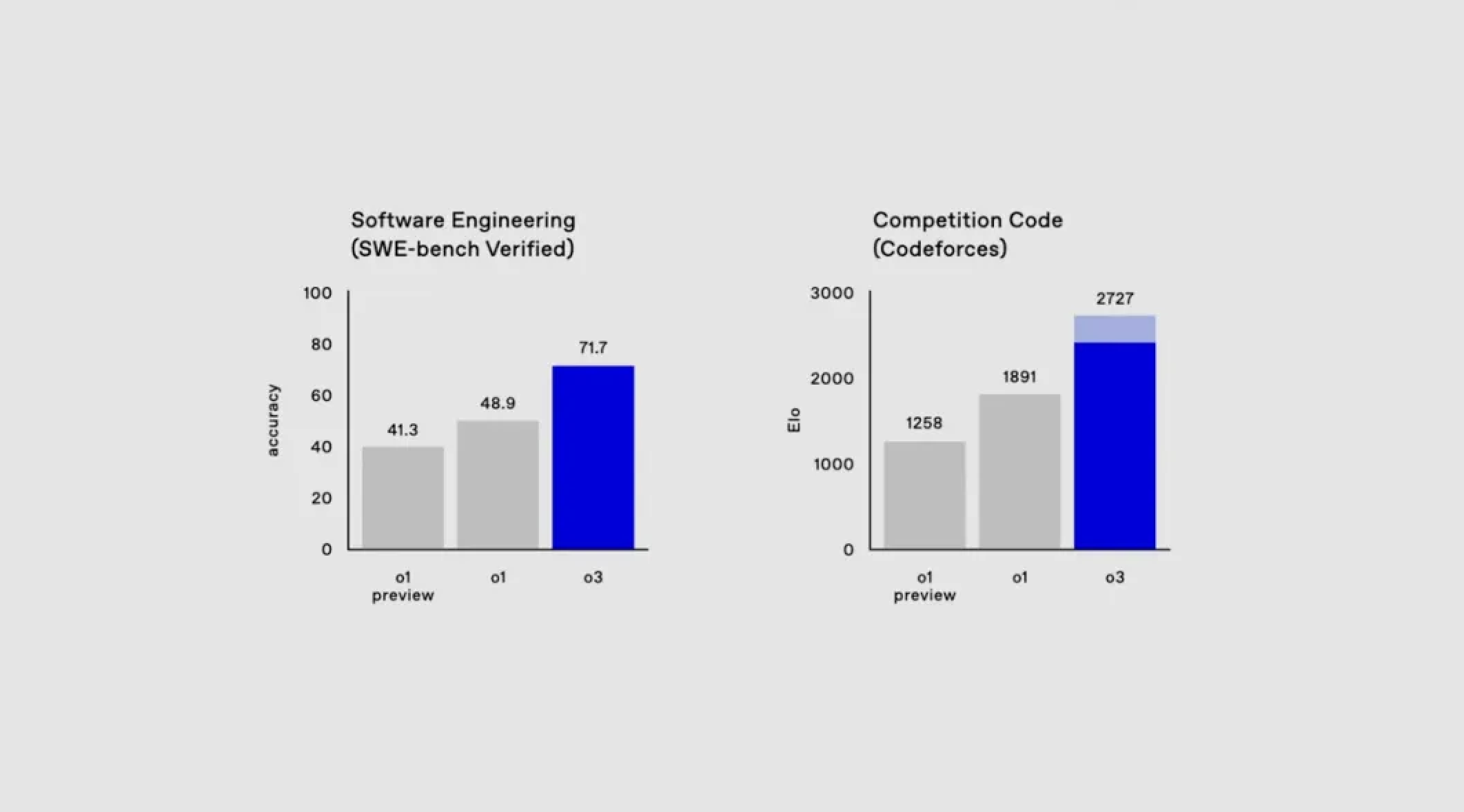

Primeiro, no teste de benchmark SweepBench Verified, o3 alcançou uma precisão de aproximadamente 71,7%, deixando diretamente o modelo o1 para trás em 20%.

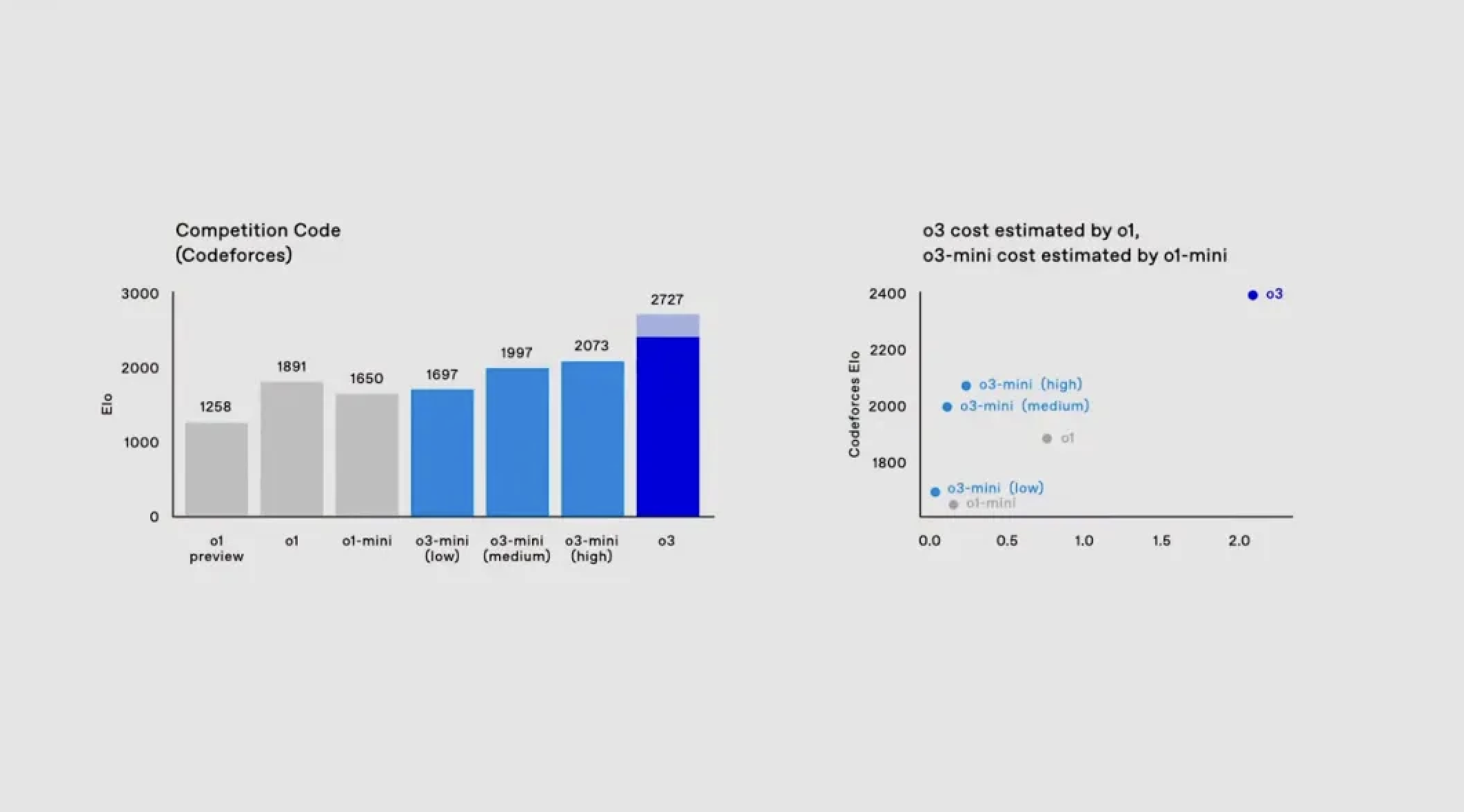

Passando para o domínio da codificação, o1 tem uma pontuação de 1891 na plataforma de competição de codificação Codeforces. E o3 pode pontuar até 2.727 ao correr a toda velocidade e estender o tempo de pensamento.

Para referência, a pontuação do demonstrador Mark Chen é de apenas 2.500, o que demonstra plenamente que o modelo o3 tem a capacidade de se aproximar ou até mesmo superar os programadores profissionais humanos.

No campo da matemática, o3 também tem um bom desempenho.

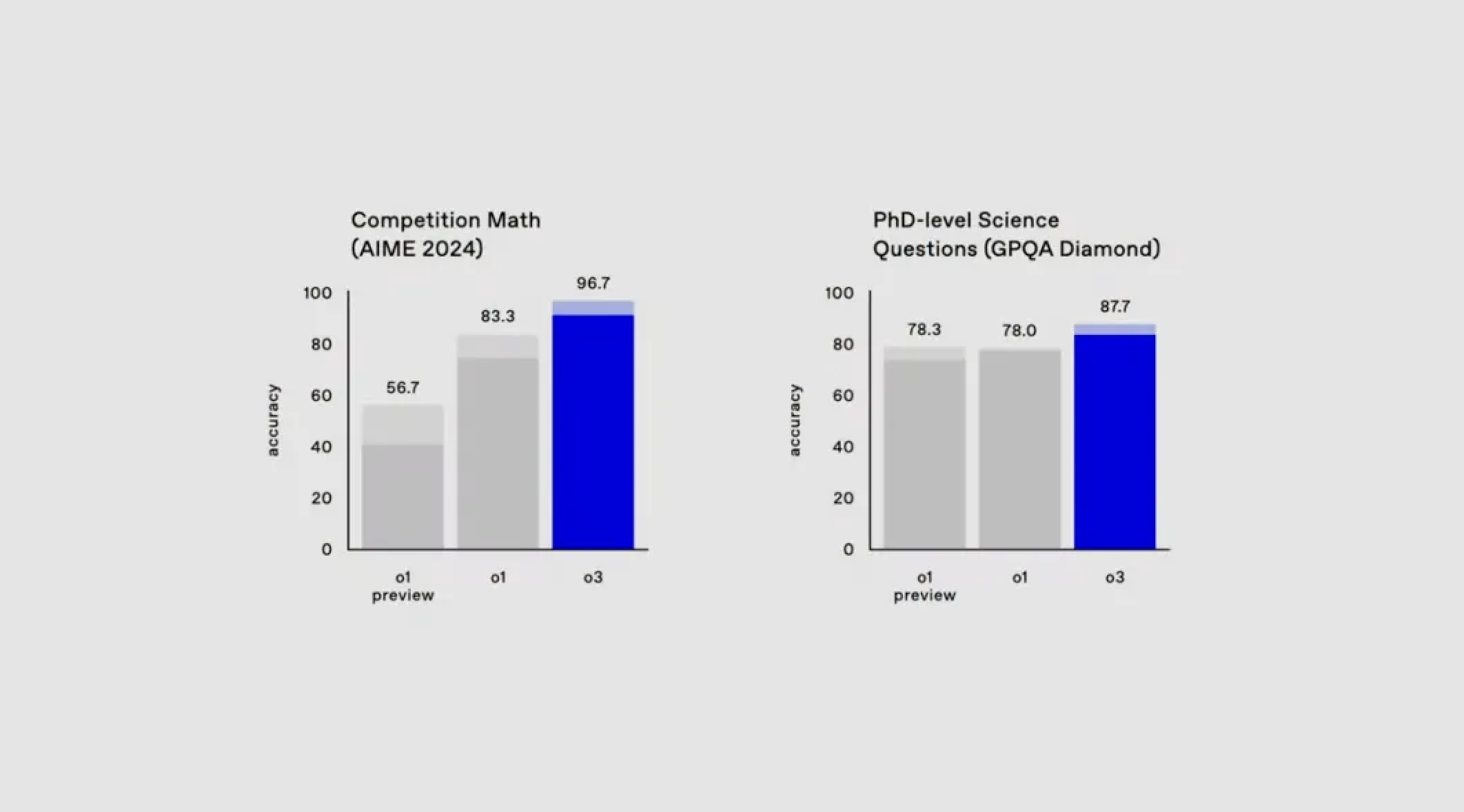

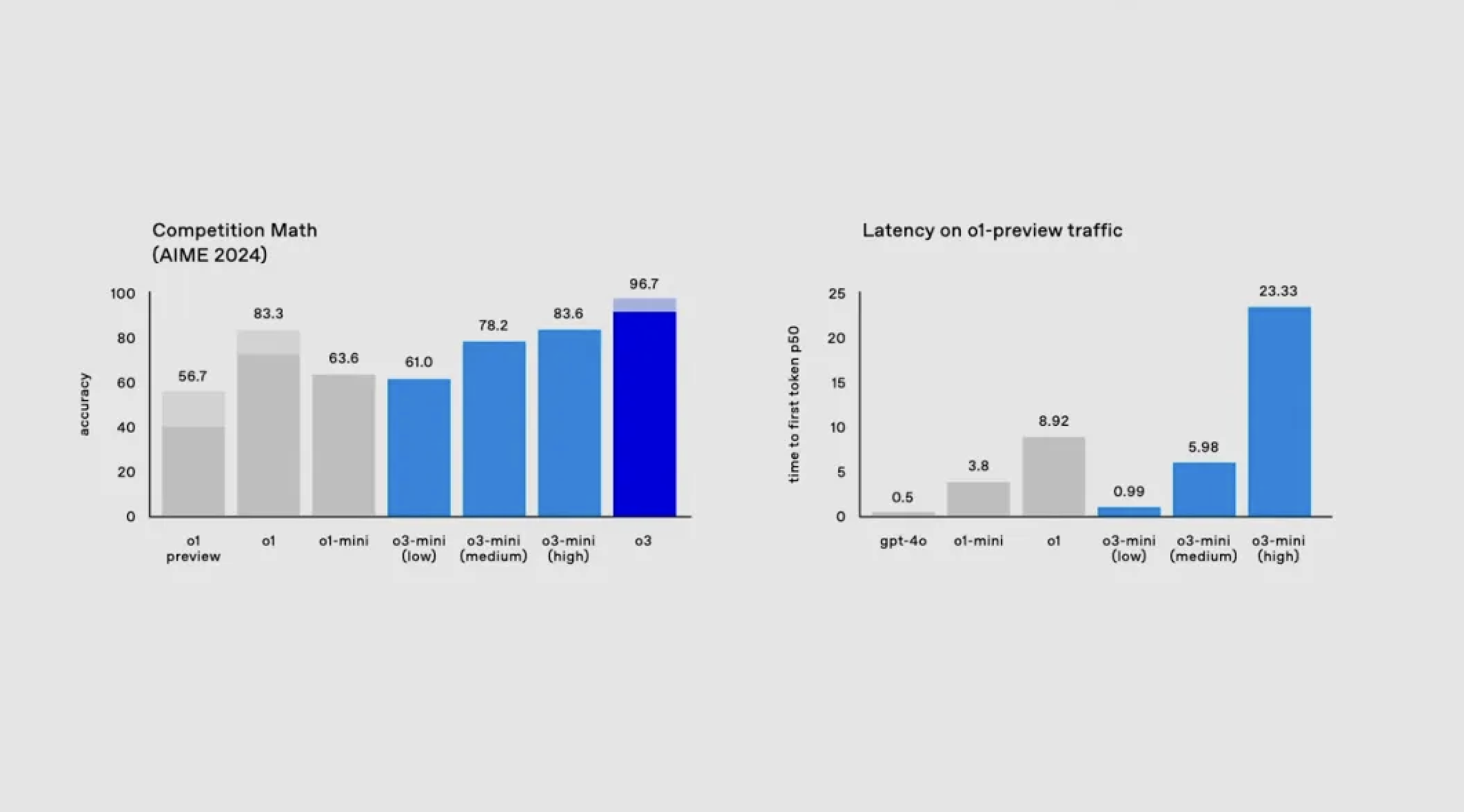

No teste AIME 2024 da Competição Americana de Matemática, o3 esmagou completamente os 83,3% do o1 com uma precisão de 90,67%.

No teste GPQA Diamond, que mede a capacidade de responder questões científicas em nível de doutorado, o3 obteve pontuação de 87,7%, enquanto o1 alcançou apenas 78%.

Que conceito? Você sabe, mesmo especialistas doutores na área muitas vezes só conseguem atingir cerca de 70% de precisão dentro de sua própria experiência.

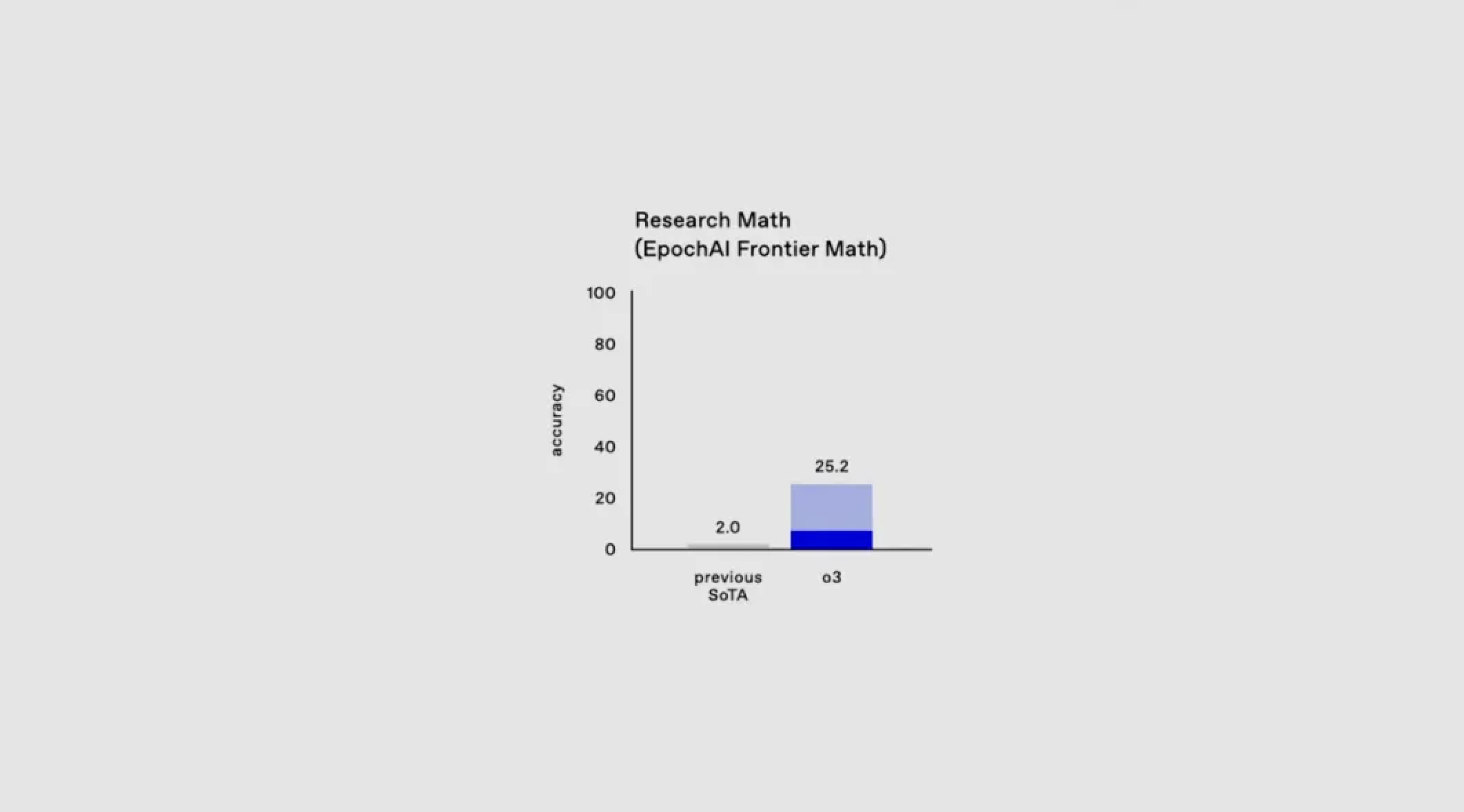

Diante da situação em que o teste de benchmark atual está próximo da pontuação máxima, a OpenAI introduziu um novo teste de matemática, EpochAI Frontier Math.

Esta é considerada uma das avaliações de matemática mais desafiadoras disponíveis atualmente, contendo questões extremamente complexas. Até mesmo matemáticos profissionais podem passar horas ou até dias resolvendo um único problema.

Atualmente, a precisão de todos os modelos existentes neste teste é inferior a 2%, mas em um teste de longo prazo com alto poder de computação, o3 pode atingir uma pontuação superior a 2.457.

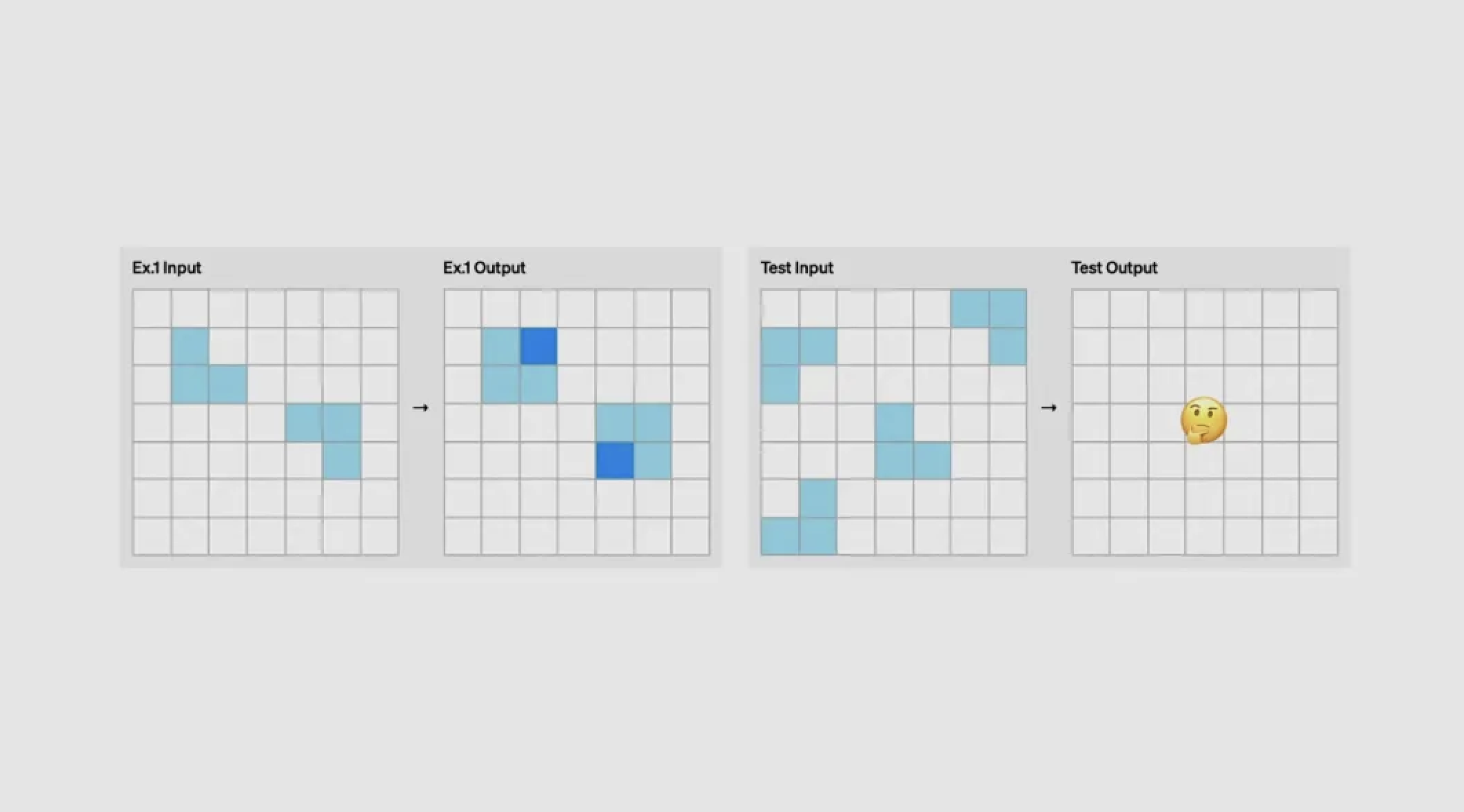

Falando em AGI, o Santo Graal no campo da IA, temos que mencionar o ARC-AGI, um teste de benchmark que mede especificamente o AGI.

O ARC-AGI foi desenvolvido por François Chollet, pai de Keras, e testa principalmente a capacidade de raciocínio do modelo através do raciocínio lógico gráfico.

Quando o apresentador fez uma pergunta improvisada a outro apresentador, Mark Chen, este último identificou os requisitos da tarefa: contar o número de pequenos quadrados coloridos em cada quadrado amarelo e gerar a borda correspondente de acordo.

Estas tarefas que são simples para os humanos são um problema difícil para a IA.

Além disso, cada tarefa do ARC-AGI requer competências diferentes e evita deliberadamente a duplicação, o que elimina completamente a possibilidade de o modelo depender de "aprendizagem mecânica" e testa verdadeiramente a capacidade do modelo de aprender e aplicar novas competências em tempo real.

Agora, o3 marca 75,7 pontos em configuração de baixo poder computacional. Quando foi solicitado à o3 que pensasse mais e aumentasse seu poder de computação, a o3 obteve 87,5% no mesmo conjunto reservado oculto, superando em muito a maioria das pessoas reais.

A implicação do OpenAI é que o3 nos aproximará um passo do AGI.

o3 mini é lançado, mais rápido e mais barato

Em setembro deste ano, a OpenAI lançou o1 mini, que possui fortes capacidades matemáticas e de programação a um custo extremamente baixo.

Continuando nesta direção de desenvolvimento, o o3 mini lançado hoje também mantém as características acima. A partir de agora, o modelo está aberto para testes de aplicações apenas para pesquisadores de segurança, com prazo até 10 de janeiro.

o3 mini suporta três modos de tempo de inferência: baixo, médio e alto.

Os usuários podem ajustar com flexibilidade o tempo de reflexão do modelo de acordo com a complexidade da tarefa. Por exemplo, problemas complexos podem exigir mais tempo de reflexão, enquanto problemas simples podem ser processados rapidamente.

A julgar pelo primeiro lote de resultados de avaliação, na pontuação Codeforces Elo, que mede a capacidade de programação, à medida que o tempo de inferência aumenta, sua pontuação Elo continua a subir, ultrapassando o o1 mini no tempo de inferência médio.

O apresentador pediu ao modelo para criar um gerador e executor de código usando Python, um script que inicia o servidor e cria uma interface de usuário local. Os usuários podem inserir uma solicitação de código na caixa de texto e o sistema enviará a solicitação à API em três modos avançados para gerar e executar o código correspondente.

Por exemplo, quando solicitado a gerar um código contendo OpenAI e números aleatórios, o modo de inferência média do o3 mini concluiu rapidamente o processo.

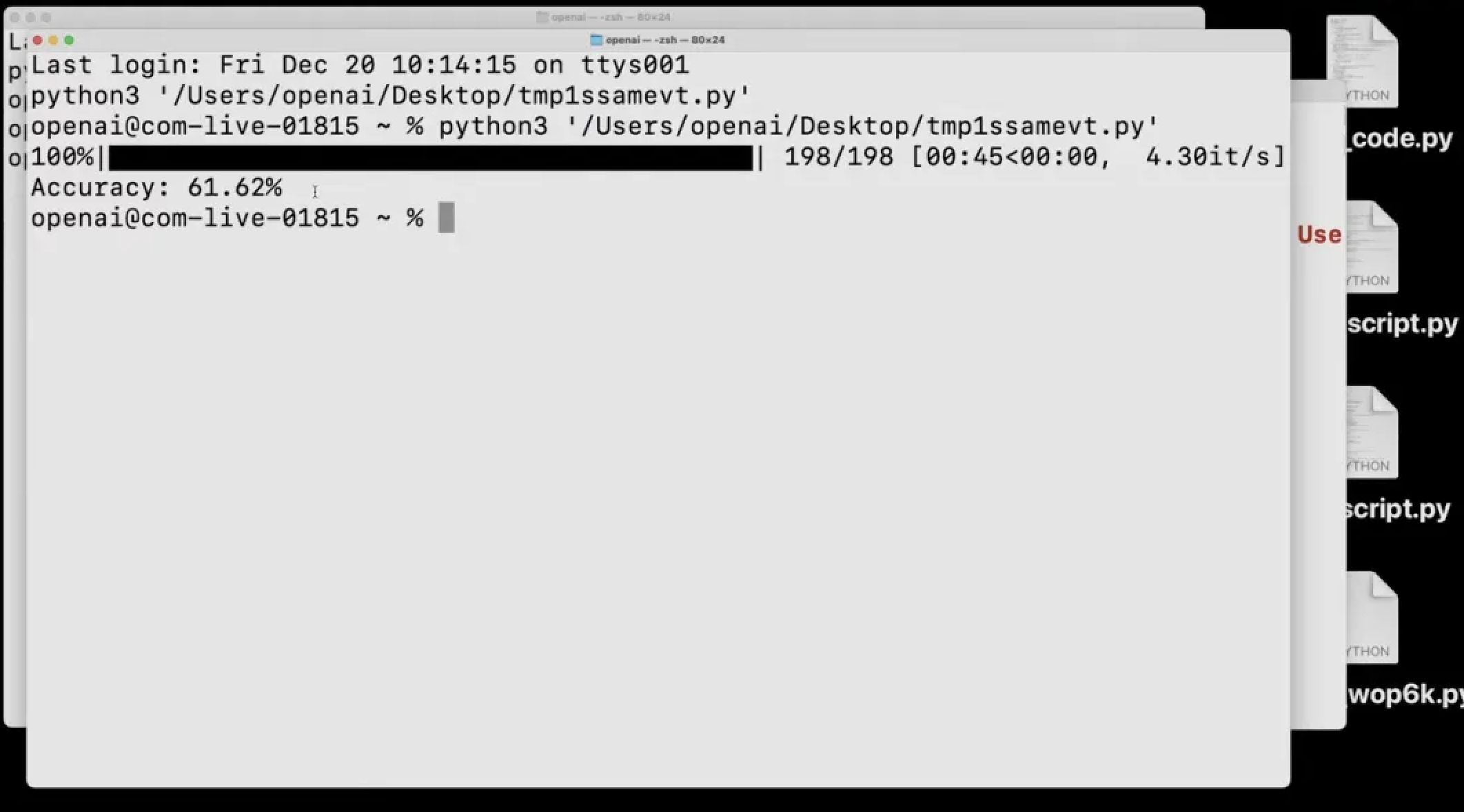

Além disso, ele pode testar a si mesmo. Por exemplo, no teste do conjunto de dados GPQA, o modelo concluiu a avaliação de conjuntos de dados complexos no modo de baixa inferência.

Ele baixa o arquivo original, identifica o CSS, respostas e opções, organiza as perguntas e respostas e por fim pontua, completando a autoavaliação em apenas um minuto com precisão de 61,62%.

No campo da matemática, o3 mini também tem um bom desempenho.

No teste de benchmark matemático AIME, seu modo de inferência baixa alcançou desempenho comparável ao o1 mini, e seu modo de inferência média ultrapassou o1 mini com menor latência.

Além disso, em resposta à voz dos desenvolvedores, o modelo o3 mini também oferecerá suporte total a funções de API, como chamadas de função, saída estruturada e instruções do desenvolvedor.

Agora, o canal de aplicativos para o3 mini e o3 está aberto. Espera-se que o o3 mini seja lançado para todos os usuários em janeiro, e a versão completa do o3 será lançada posteriormente.

No final do dia, nesta conferência de fim de ano de 12 dias, a OpenAI finalmente mostrou seu trunfo.

Pode-se dizer que o lançamento do modelo o3 trouxe uma conclusão inesperada, mas razoável, a esta conferência de imprensa que já esteve presa no dilema de “abrir em alta e descer”.

Em menos de 3 meses, a OpenAI concluiu a atualização iterativa do modelo o1.

Esta transformação da série GPT para a série o é obviamente uma escolha estratégica cuidadosamente considerada pela OpenAI, e os resultados subsequentes também provam que esta decisão é sábia.

No entanto, é importante notar que o CEO da Microsoft, Satya Nadella, afirmou recentemente em um podcast que a OpenAI está cerca de dois anos à frente de seus concorrentes na área de IA.

É este ambiente competitivo relativamente descontraído que permite à OpenAI focar no desenvolvimento do ChatGPT.

No entanto, a situação atual está a mudar tanto ofensivamente como defensivamente.

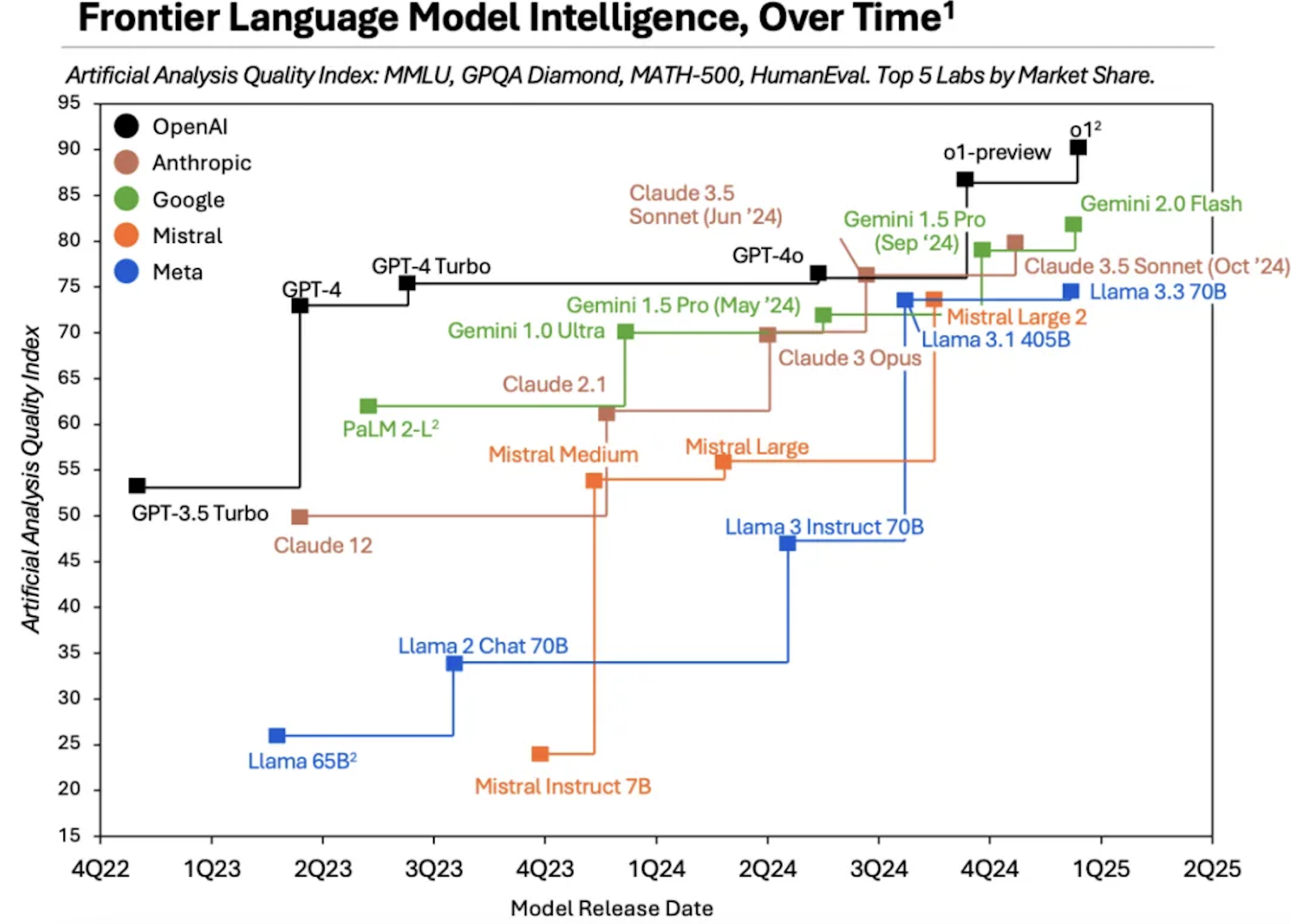

O relatório da Menlo Ventures mostra que a participação de mercado do ChatGPT está gradualmente sendo corroída por outros concorrentes, caindo de 50% em 2023 para 34% em 2024.

De “padrão” a “opcional”, o halo do ChatGPT está desaparecendo.

A razão por trás disso é óbvia. O “fosso” da OpenAI está sendo preenchido centímetro por centímetro por concorrentes que estão correndo descontroladamente.

Os dados de pesquisa da Análise Artificial mostram claramente que fabricantes como Anthropic e Google desenvolveram sucessivamente novos modelos com desempenho próximo ao GPT-4, OpenAI o1 e outros modelos.

Além disso, à medida que a Scaling Law atinge o seu limite e os principais executivos vão saindo um após o outro, os dividendos que a OpenAI ganhou ao confiar num único modelo básico no passado estão a desaparecer a um ritmo acelerado.

Em uma indústria onde tudo é calculado a cada passo, mesmo o modelo O3 lançado hoje terá dificuldade em criar novamente uma janela de 2 anos.

Especialmente quando novos modelos como Grok-3 e Claude estão ganhando impulso, pode não sobrar muito tempo para o OpenAI.

Acorde, o melhor fabricante de IA deste ano ainda é OpenAI, mas no próximo ano pode haver inúmeras respostas devido às diferentes direções de IA.

Felizmente, como usuários, seremos os maiores vencedores dessa mudança.

# Bem-vindo a seguir a conta pública oficial do WeChat do aifaner: aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.