A Sala N da Coreia do Sul reaparece! Um grande número de mulheres cujos rostos foram alterados pela IA pediram ajuda no Weibo, envolvendo 500 escolas e mais de 220 mil pessoas participantes.

Na obra “Ghost in the Shell”, do final do século passado, Motoko, cujo corpo inteiro foi transformado em prótese, duvidou se ele ainda existia. O corpo, a memória e as relações com outras pessoas, quando estas coisas podem ser replicadas, não podem ser usados como argumento a favor da vida física.

Quando a cantora de IA se tornou popular, Stefanie Sun também fez uma observação semelhante em sua resposta. Você não é especial, já é previsível e, infelizmente, também é personalizável.

Podemos acrescentar que qualquer pessoa pode ser descrita e gerada pela IA, mesmo que nunca tenha feito algo.

Lu Xun realmente disse que quando viu mangas curtas, imediatamente pensou em braços brancos. A imaginação humana é comum, e não é surpresa que cada vez que há um novo avanço na tecnologia, uma certa via vertical se desenvolva de forma mais madura: a pornografia.

A Coreia do Sul, que já chocou o mundo por causa da Sala N, agora está experimentando a versão 2.0.

Violência de pessoas comuns contra pessoas comuns

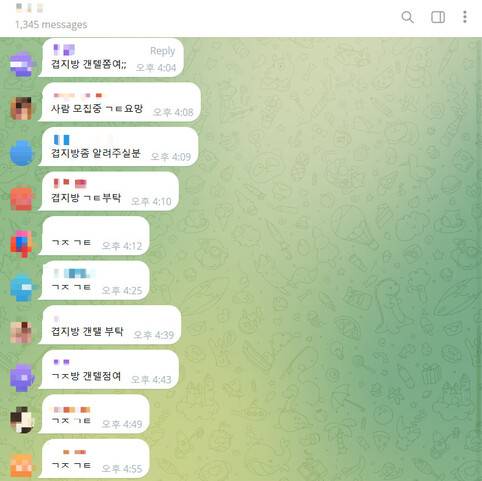

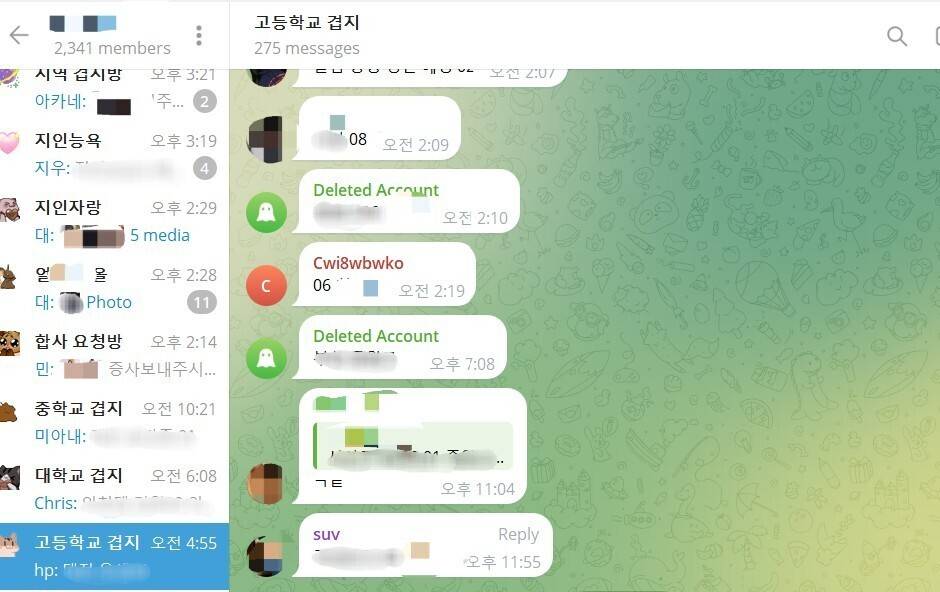

No incidente anterior da Sala N, o perpetrador estabeleceu várias salas de bate-papo no software criptografado de mensagens instantâneas Telegram e postou conteúdo de exploração sexual. Este incidente ocorreu principalmente no Telegram.

A principal diferença entre os dois é o meio de crime: um é a fotografia secreta e o outro é o Deepfake.

Já conhecemos o Deepfake, que usa IA para gerar vídeos, áudios ou imagens aparentemente reais para simular coisas que de fato não aconteceram.

Deepfakes são comumente usados na indústria do entretenimento e nos políticos, mas também estão sendo controlados por pessoas comuns e usados para prejudicar outras pessoas comuns.

Os perpetradores da Sala N 2.0 estenderam suas garras a seus familiares, colegas e colegas de classe. Muitas salas de bate-papo do Telegram são organizadas de acordo com escolas ou regiões, para que os membros do grupo tenham conhecidos comuns e tópicos semelhantes.

▲ Salas de bate-papo por campus universitário

Além das mulheres ao seu redor, as celebridades femininas também são alvo de sua caça. Algumas salas de bate-papo são até subdivididas em tipos de ocupação, incluindo professores, enfermeiras, soldados, etc.

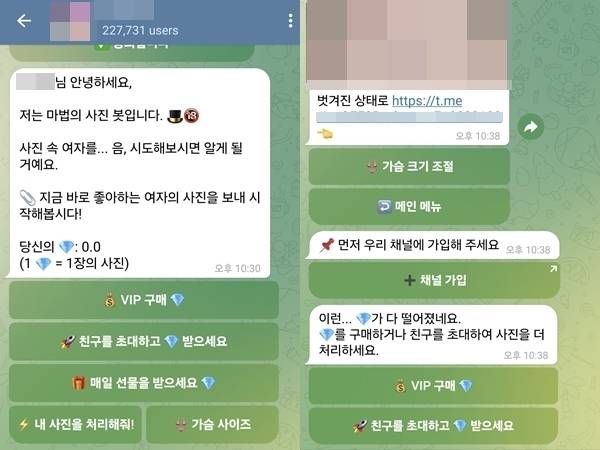

O Hankyoreh Daily informou que uma sala de bate-papo do Telegram com 227 mil participantes só precisava de fotos de mulheres para gerar conteúdo deepfake em 5 a 7 segundos.

Qual é o conceito de 220.000? A Coreia do Sul terá apenas 230 mil recém-nascidos em 2023 e a sua população total é de apenas mais de 50 milhões.

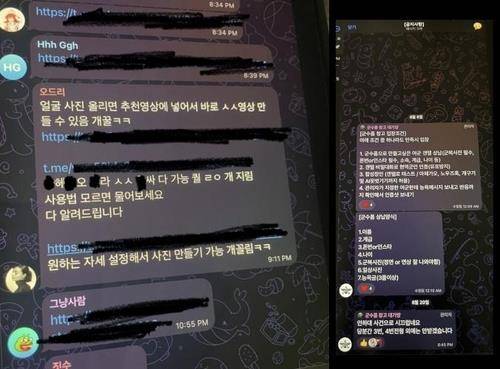

Essa sala de chat possui um robô que combina fotos femininas em fotos de nudez e pode ajustar os seios. Após o usuário entrar na sala de chat, uma mensagem aparecerá na janela de chat: “Agora envie as fotos femininas que você gosta”.

▲ Captura de tela da sala de chat explicando como usar o Deepfake

O número de participantes é escandaloso, o que pode estar relacionado ao baixo “limiar de entrada”: os links podem ser encontrados pesquisando por palavras-chave específicas no X (antigo Twitter).

Esta sala de chat também estabeleceu um modelo de monetização. As duas primeiras fotos são gratuitas e depois é cobrado 1 diamante (US$ 0,49, aproximadamente RMB 3,47) por foto. Os pagamentos só podem ser feitos com moeda virtual para garantir o anonimato. Se você convidar amigos, também poderá obter alguns créditos grátis.

Mas também existem algumas salas de bate-papo que exigem um “certificado de admissão” – se você quiser entrar no grupo, primeiro deverá enviar 10 fotos de pessoas que você conhece e passar na entrevista.

Avatares do software de chat KakaoTalk e fotos do Instagram podem ser usados como “matéria-prima”.

O que é ainda mais horrível é que uma grande proporção tanto das vítimas como dos perpetradores são adolescentes.

Os voluntários criaram um mapa atualizado em tempo real, mostrando em quais escolas os crimes ocorriam. Mesmo numa escola só para raparigas, haverá vítimas, porque os perpetradores não são necessariamente colegas de turma.

Exatamente quantas escolas foram afetadas ainda não foram determinadas. Alguns blogueiros afirmaram que mais de 70% das escolas estiveram envolvidas desta vez.

Em 26 de agosto, o "Korea JoongAng Daily" apontou que incluía pelo menos cerca de 300 escolas em todo o país, incluindo até escolas primárias. Em 28 de agosto, o relatório do WSJ ampliou o número para cerca de 500 escolas.

Um internauta lamentou na área de comentários: “Esta é basicamente toda a Coreia do Sul…”

Embora não haja um resultado claro da investigação deste incidente, os dados anteriores também podem ilustrar a gravidade da situação.

De acordo com estatísticas do Instituto Coreano de Direitos Humanos da Mulher, de janeiro a agosto deste ano, um total de 781 vítimas de Deepfake procuraram ajuda, das quais 288 eram menores, representando 36,9%. O número real é provavelmente muito maior do que isso.

Além disso, a Agência Nacional de Polícia Sul-Coreana afirmou que desde o início de 2023, cerca de 70% das cerca de 300 pessoas acusadas de produzir e distribuir fotos falsas de nus eram adolescentes.

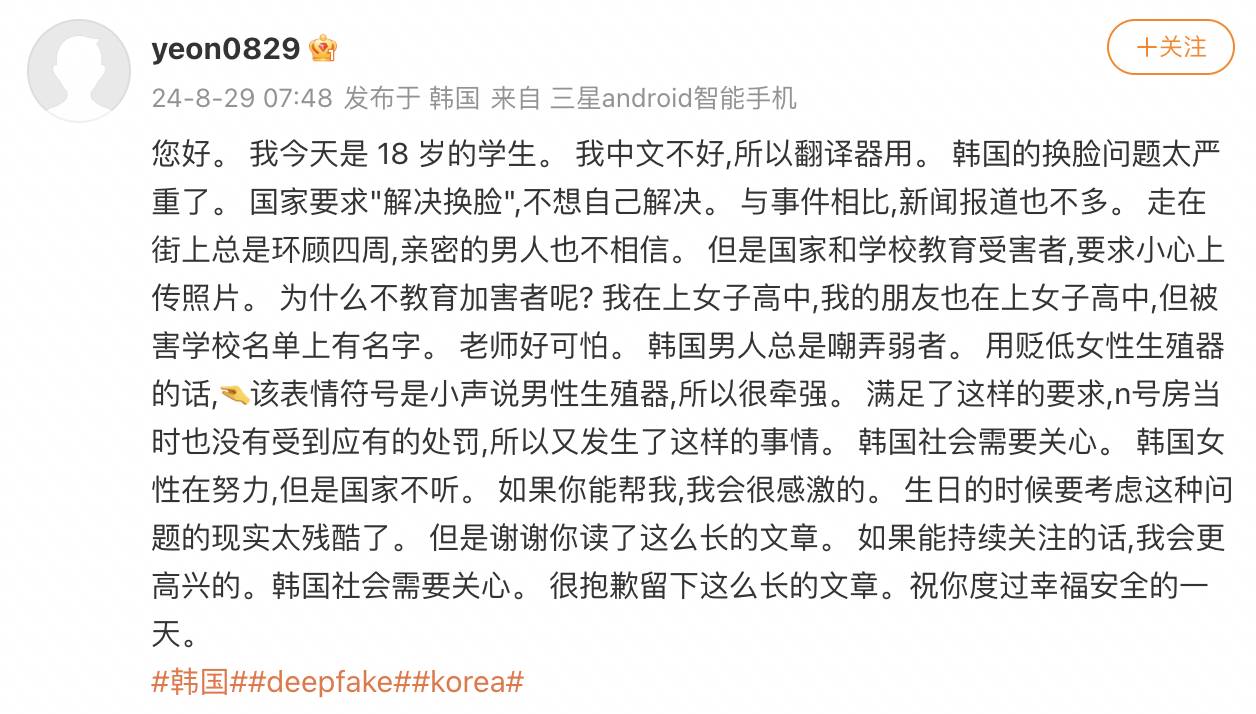

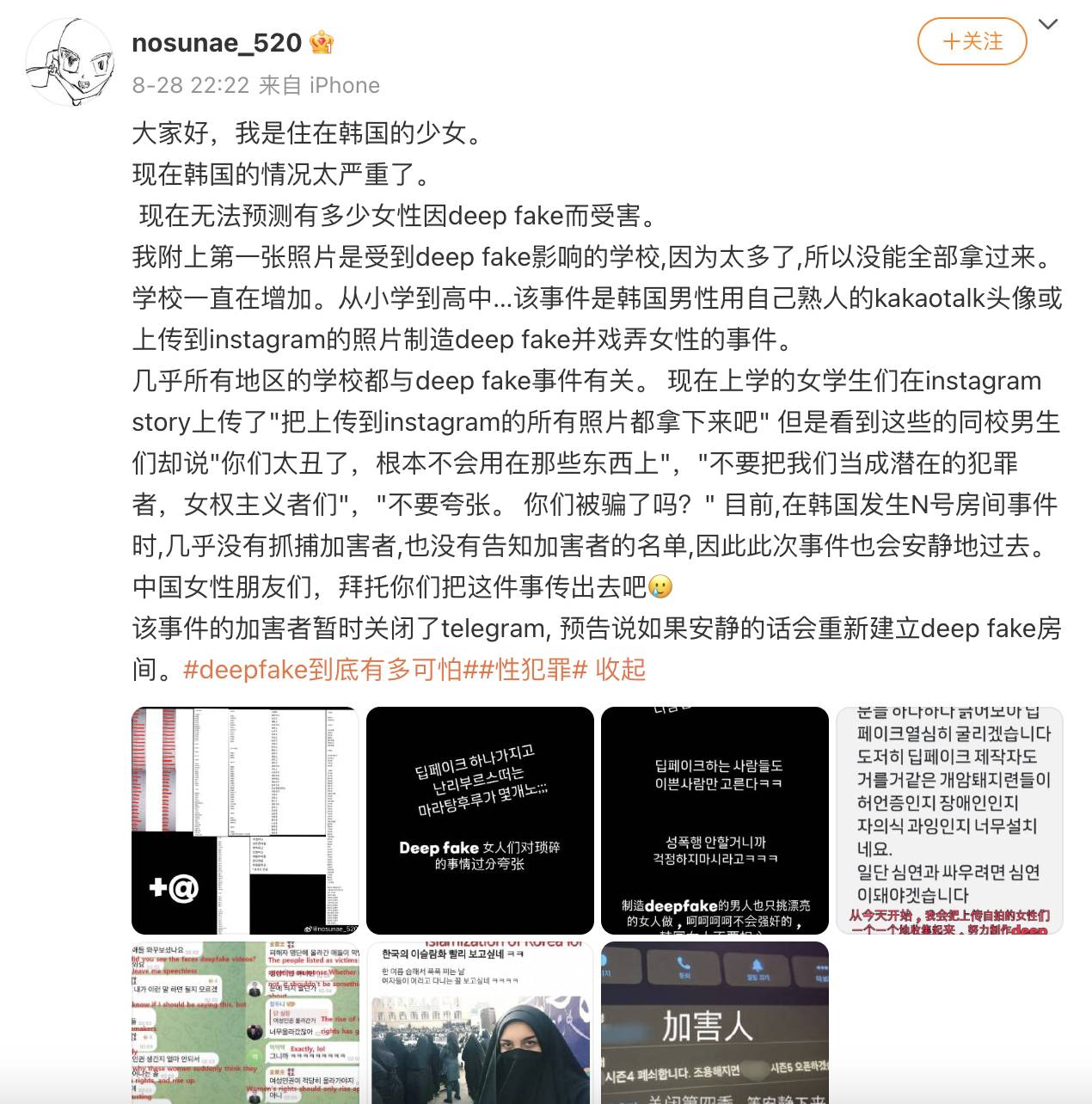

Muitas mulheres coreanas foram ao Weibo para pedir ajuda. Elas não sabiam chinês e só conseguiam ler o conteúdo em seus telefones, transmitindo seu desamparo e medo.

Alguns internautas se perguntam por que as mulheres coreanas procuraram ajuda na Internet chinesa. Na verdade, não são apenas as mulheres coreanas que também falam outras línguas.

Eles acreditam que se receberem atenção e forem criticados por estrangeiros, os meios de comunicação social reportarão de forma mais activa e os departamentos relevantes investigarão mais seriamente, em vez de fingirem ser surdos e manterem as coisas em segredo.

Algumas evidências criminais e até mesmo a identidade do iniciador foram investigadas pelas próprias mulheres coreanas, semelhante à Sala N daquela época. Felizmente, o Presidente da Coreia do Sul e o líder do partido da oposição expressaram a sua posição, o Presidente Yin Xiyue da Coreia do Sul propôs:

Deepfakes são um claro crime sexual digital e iremos erradicá-los de uma vez por todas.

Deepfakes podem ser vistos como uma pegadinha, mas são claramente atos criminosos que usam tecnologia sob o disfarce do anonimato, e qualquer pessoa pode se tornar uma vítima.

Os servidores do Telegram estão no exterior e seu CEO está detido em Paris, dificultando as investigações. A Comissão de Padrões de Comunicação da Coreia disse ter enviado uma carta solicitando ao governo francês que coopere na investigação do Telegram.

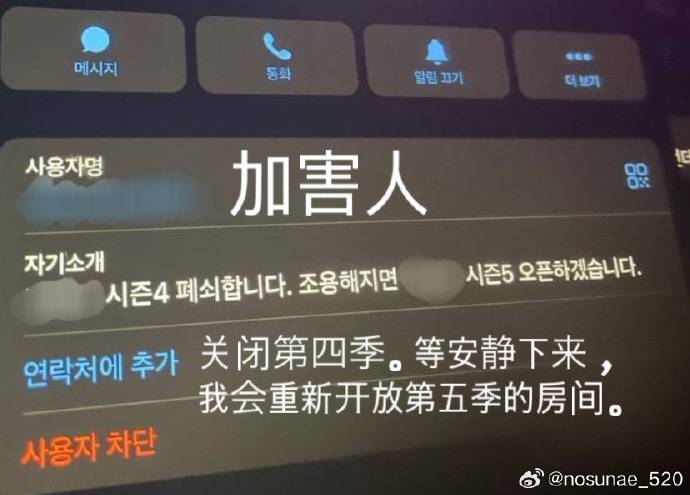

Depois de atrair a atenção da opinião pública, os comportamentos relacionados foram restringidos. No entanto, o Hankyoreh Daily relatou que alguns usuários inescrupulosos passarão por uma "verificação de identidade" mais rigorosa e continuarão a falsificar em salas de bate-papo mais privadas.

▲ Captura de tela da sala de bate-papo, os usuários discutem a entrada em uma sala de bate-papo mais privada

Conteúdo falso, dano real

Deepfakes não são novidade, mas seus danos raramente são reconhecidos.

Algumas mulheres na Coreia do Sul tornaram as suas contas nas redes sociais privadas ou apagaram fotos publicadas online numa tentativa de fazer as pazes.

Eles estavam angustiados e duvidosos. Por um lado, eles não sabem onde suas fotos foram compartilhadas e até que ponto elas se espalharam. Por outro lado, eles não entendem por que se pede às vítimas que tenham cuidado ao enviar fotos, em vez de educar os perpetradores.

Quando uma aluna pediu em seu story do Instagram para “tirar do ar todas as fotos que você enviou”, os meninos da mesma escola poderiam dizer: “Você é muito feio para ser usado nessas coisas”.

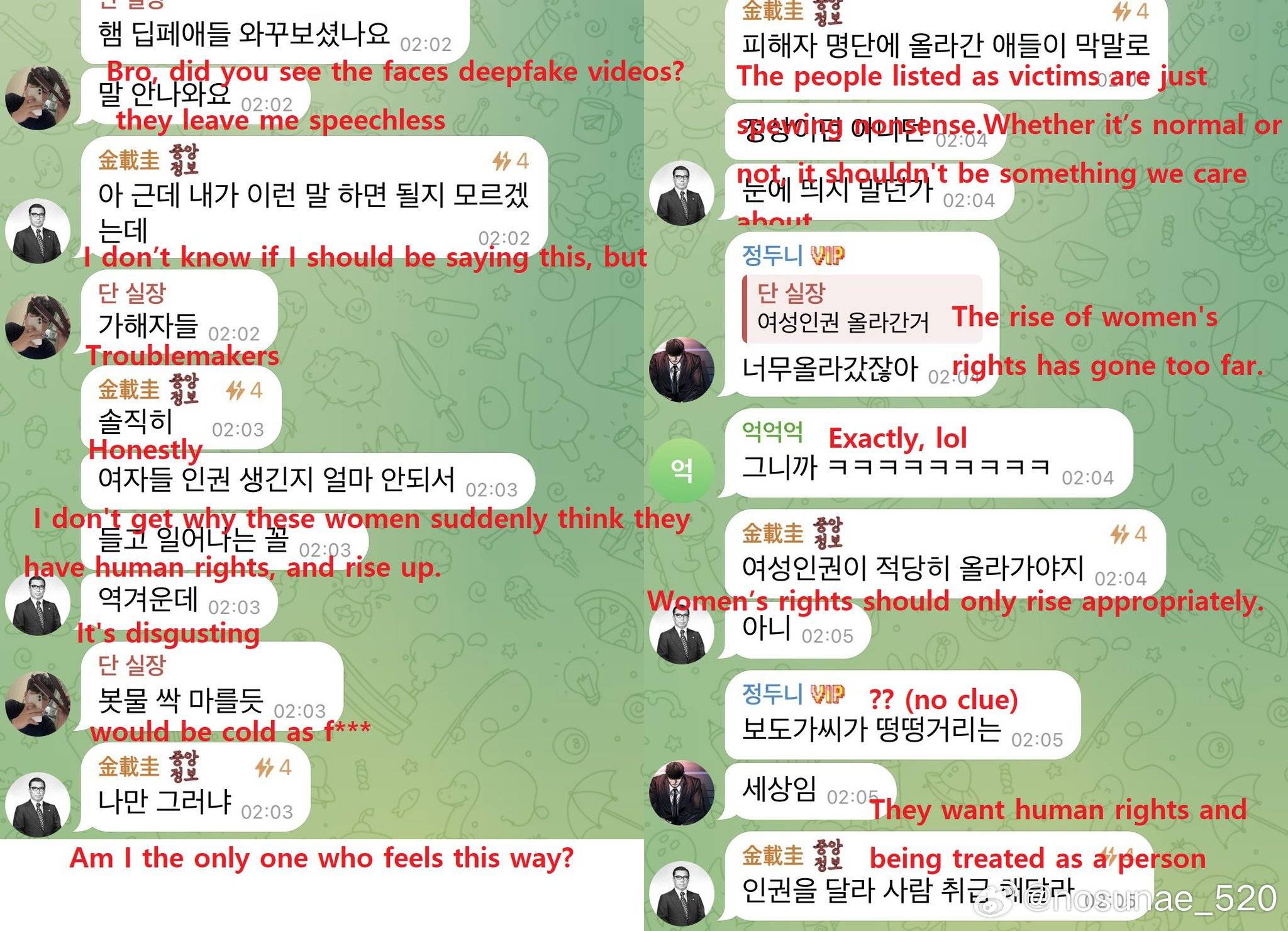

▲ Observações do perpetrador, dizendo que as mulheres são muito altas

Ainda existem algumas vozes como esta na Internet: “Não sei por que esse tipo de crime pode causar tantos danos. Se algumas pessoas cometessem isso sozinhas, o dano deveria ser muito pequeno”.

Mas o que as vítimas vivenciam é mais do que apenas ver seus rostos falsos. Os perpetradores também os insultarão, divulgarão as suas informações pessoais, tais como endereços, números de telefone e cartões de estudante, espalharão rumores sobre as suas vidas privadas e aproximar-se-ão e assediá-los-ão.

O que é ainda mais assustador é encontrar “pornografia de vingança” – os perpetradores ameaçam espalhar materiais falsos para chantagear e prejudicar as mulheres, causando danos secundários mais graves.

▲Um YouTuber coreano disse que as mulheres fazem barulho, mas ele sabe como se proteger encobrindo-se

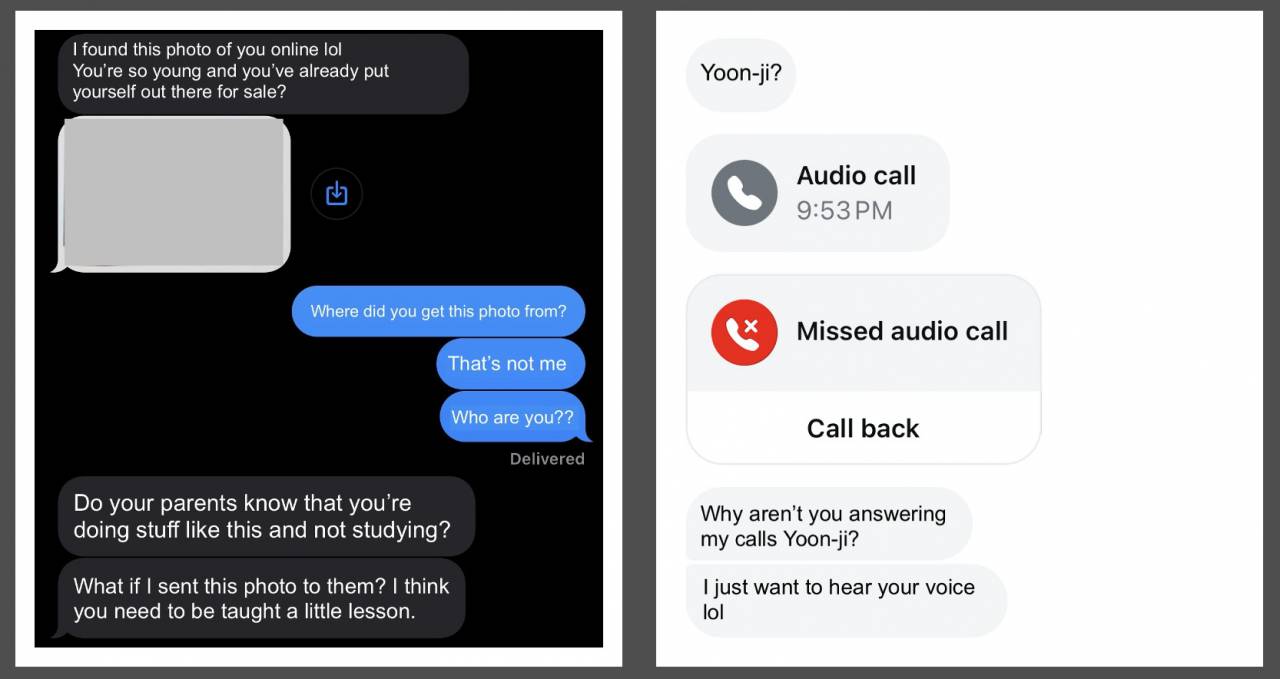

O Korea Herald informou que Song, um estudante do ensino médio de 17 anos na província de Gyeonggi, costumava compartilhar algumas fotos de dança e vídeos curtos online. Um dia, ela recebeu uma mensagem anônima no Instagram com três fotos explícitas: “Seus amigos e pais entendem esse lado da sua vida?”

Essas fotos são todas falsas, mas são quase indistinguíveis das imagens reais. O pesadelo não acabou e as mensagens que ela responde só vão deixar a outra parte mais animada e fazer mais exigências.

▲ Capturas de tela de mensagens de texto entre Song e o perpetrador, modificadas e traduzidas para o inglês de acordo com o pedido de Song

Ninguém pode compartilhar a dor. Algumas vítimas chegaram a dizer: “O mundo como eu o conhecia entrou em colapso”.

Isto não é equivalente ao preço pago pelo perpetrador.

▲ Capturas de tela da sala de chat, alguns comentários obscenos, como “Você pode definir a pose que deseja fazer nas fotos, é super legal”

O incidente ainda não foi resolvido, mas a Coreia do Sul já condenou Deepfake, um dos quais teve seu primeiro julgamento em 28 de agosto.

De julho de 2020 a abril deste ano, Park roubou fotos faciais de vítimas do sexo feminino, como ex-alunas da universidade, produziu 419 vídeos pornográficos Deepfake e divulgou 1.735 deles.

As vítimas começaram a correr em julho de 2021, antes de conseguirem levar o perpetrador a julgamento, e Park foi processado em maio deste ano.

Devido a este incidente Deepfake em grande escala, as autoridades sul-coreanas relevantes estão a considerar aumentar a pena máxima de prisão de 5 para 7 anos.

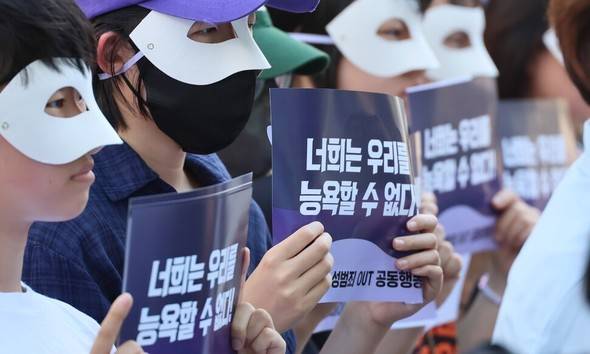

▲Mulheres sul-coreanas protestam contra crimes sexuais

Considerando que os crimes juvenis deepfake são muito comuns, mas existem lacunas na lei, a Coreia do Sul está a medir a punição máxima para os perpetradores na fase de escolaridade obrigatória.

Até hoje, o Deepfake ainda é uma área cinzenta em muitos lugares, e os esforços de proteção não conseguem acompanhar a velocidade das ameaças.

Por exemplo, nos Estados Unidos, se a vítima for adulta, os estados têm leis e regulamentos diferentes, seja criminalizando ou abrindo processos civis, mas atualmente não existe nenhuma lei federal que proíba a produção de conteúdo pornográfico Deepfake.

▲ Captura de tela da sala de bate-papo, membros conversando sobre conhecidos comuns

Uma razão pela qual a legislação é difícil é que algumas pessoas acreditam que mesmo que o sujeito na imagem Deepfake se pareça com você, na verdade não é você, então sua privacidade não é realmente violada.

Contudo, todos sabem que embora a imagem seja falsa, o dano é real.

O progresso jurídico é lento e, ao mesmo tempo, os perpetradores que nunca apareceram "acalmaram-se" temporariamente e aguardam "um retorno".

É tão fácil fazer o mal, Deepfakes são relevantes para todos

A Coreia do Sul não é uma exceção. O Deepfake ocorre independentemente das fronteiras nacionais.

Em setembro de 2023, na cidade espanhola de Almendralejo, um grupo de rapazes carregou fotos das suas colegas de turma publicadas nas redes sociais numa ferramenta de IA de “remoção com um clique”. Existem cinco escolas de ensino médio na cidade, e "fotos nuas" de colegas do sexo feminino circularam em pelo menos quatro delas.

Esta ferramenta pode ser utilizada através de aplicações móveis ou Telegram. São pelo menos 30 vítimas, maioritariamente estudantes do sexo feminino com idades entre os 12 e os 14 anos.

A maioria dos iniciadores os conhecia e também eram menores. Havia pelo menos 10 deles, alguns até com menos de 14 anos, e não podiam enfrentar acusações criminais.

▲Uma mãe pede que mais vítimas se apresentem

Eles criaram bate-papos em grupo no WhatsApp e no Telegram para divulgar essas “fotos de nudez” e ameaçaram as vítimas através do Instagram para extorquir “resgate” e fotos reais de nus.

Situação semelhante ocorreu em uma escola de ensino médio em Nova Jersey, EUA. Cerca de 30 vítimas foram tiradas por seus colegas do sexo masculino durante as férias de verão.

O diretor garantiu que todas as fotos foram apagadas e não seriam divulgadas novamente. O agressor foi suspenso da escola por alguns dias e voltou ao “local do crime” como se nada estivesse errado.

O Deepfake surgiu pela primeira vez em 2017 no Reddit, a “versão americana do Tieba”. A principal forma é substituir rostos de celebridades por protagonistas de vídeos pornográficos, ou fazer paródia de figuras políticas.

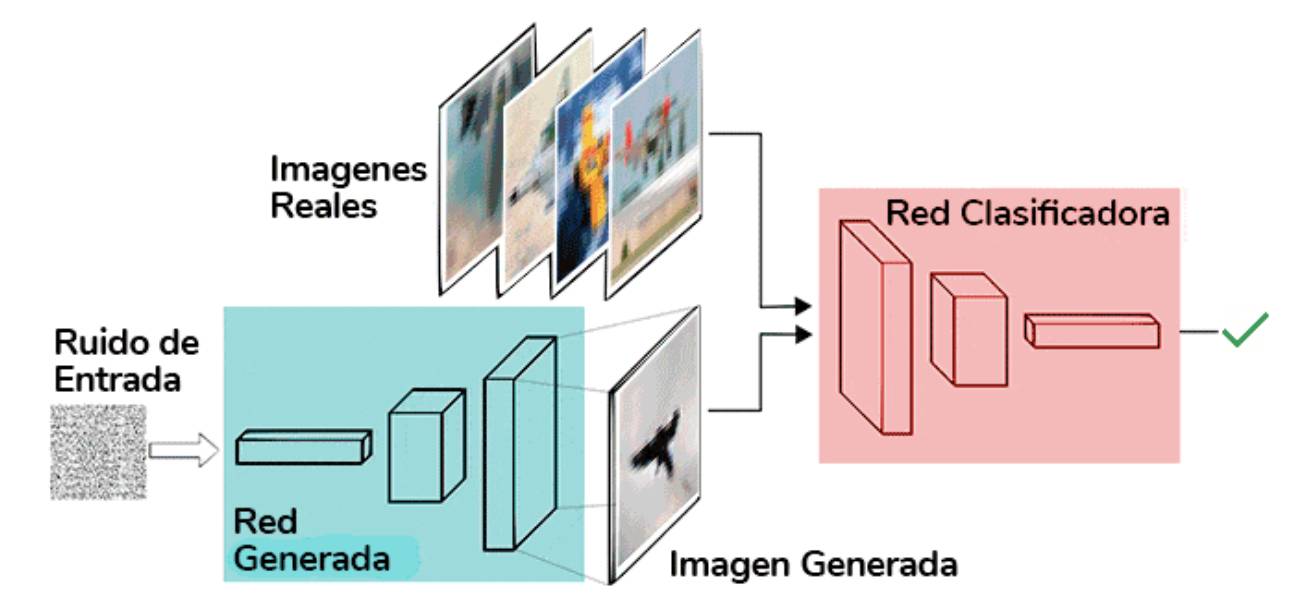

Do ponto de vista técnico, existem dois caminhos principais: um é o caminho do codificador-decodificador, que substitui uma face por outra comprimindo e reconstruindo a imagem; o outro é o caminho do gerador-discriminador (ou seja, Redes Adversariais Gerativas (GANs), geram); imagens realistas por meio de treinamento adversário.

▲GAN

Hoje, deepfake é um conceito mais amplo, não mais limitado à substituição da face original, utilizamos para nos referir a qualquer ato de falsificação da realidade através de meios tecnológicos.

Princípios técnicos complexos estão escondidos nos bastidores. Na frente dos usuários estão interfaces "prontas para uso". Os adolescentes também podem criar informações falsas à vontade.

Os aplicativos de “despir-se com um clique” exigem apenas uma foto, um endereço de e-mail e alguns dólares para tirar as “roupas” de celebridades, colegas de classe e estranhos em lotes. As fotos usadas para “despir-se” geralmente são de capturas de mídia social. sem o consentimento do editor e depois o espalha sem o seu conhecimento também.

Com base em um modelo de difusão de código aberto treinado em imagens massivas, os usuários podem gerar fotos falsas e explícitas de celebridades inserindo palavras imediatas.

▲ O modelo de IA de uma atriz de Hollywood foi baixado milhares de vezes

Projetos de código aberto do GitHub, como Deep-Live-Cam, podem mudar rostos em chats de vídeo com apenas uma foto.

Pode ser difícil enganar os jovens, mas não é necessariamente o caso dos mais velhos. Um exemplo trágico já aconteceu na realidade – um homem de 82 anos nos Estados Unidos perdeu 690.000 dólares por causa da sua fé cega na IA. Musk que enganou as pessoas no vídeo.

▲ Transmissão ao vivo de AI Musk

Em julho de 2023, a Deutsche Telekom publicou um anúncio sobre a segurança dos dados das crianças, apelando aos pais para que partilhassem o menos possível a privacidade das crianças na Internet.

Imagens, vídeos e áudios são todos Deepfake Embora entendamos racionalmente que “ver para crer” se tornou uma coisa do passado, nossa psicologia ainda não aceitou isso totalmente e não temos a capacidade correspondente de distinguir todos. pode se tornar uma vítima.

A tecnologia pode ser neutra, mas a informação que as pessoas utilizam a tecnologia para produzir não é apenas informação, mas também armas utilizadas para humilhar, estigmatizar e obter um sentimento de superioridade. Quanto mais vulgar e bizarro o conteúdo, mais fácil é divulgá-lo. Isso é verdade desde os tempos antigos.

O que as pessoas comuns podem fazer? Pelo menos podemos decidir como usamos a tecnologia e também podemos escolher que informação produzir e divulgar, prestar atenção às vítimas, zombar dos perpetradores e usar o nosso pouco poder para promover o progresso das leis e dos conceitos sociais.

Depois de trocar o rosto, por que a vítima deletou as fotos? Por que as vítimas sentem tanta vergonha depois de serem fotografadas secretamente? Esta parece ser uma questão que a tecnologia não consegue responder.

# Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.