A popularidade do ChatGPT pode dar um impulso inesperado à Nvidia

O zumbido constante em torno do ChatGPT da OpenAI se recusa a diminuir. Com a Microsoft agora usando a mesma tecnologia para alimentar seu novíssimo Bing Chat , é seguro dizer que o ChatGPT pode continuar com essa tendência ascendente por algum tempo. Isso é uma boa notícia para a OpenAI e a Microsoft, mas elas não são as únicas duas empresas a se beneficiar.

De acordo com um novo relatório, as vendas das placas gráficas de data center da Nvidia podem estar prestes a disparar. Com a comercialização do ChatGPT, a OpenAI pode precisar de até 10.000 novas GPUs para suportar o modelo crescente – e a Nvidia parece ser o fornecedor mais provável.

A empresa de pesquisa TrendForce compartilhou algumas estimativas interessantes hoje, e a parte mais interessante diz respeito ao futuro do ChatGPT. De acordo com a TrendForce, o modelo GPT que alimenta o ChatGPT em breve precisará de um aumento considerável no hardware para escalar o desenvolvimento.

“O número de parâmetros de treinamento usados no desenvolvimento desse modelo de linguagem autorregressiva aumentou de cerca de 120 milhões em 2018 para quase 180 bilhões em 2020”, disse a TrendForce em seu relatório. Embora não tenha compartilhado nenhuma estimativa para 2023, é seguro supor que esses números continuarão a aumentar tanto quanto a tecnologia e o orçamento permitirem.

A empresa afirma que o modelo GPT precisava de 20.000 placas gráficas para processar dados de treinamento em 2020. À medida que continua expandindo, espera-se que esse número suba para mais de 30.000. Isso pode ser uma ótima notícia para a Nvidia.

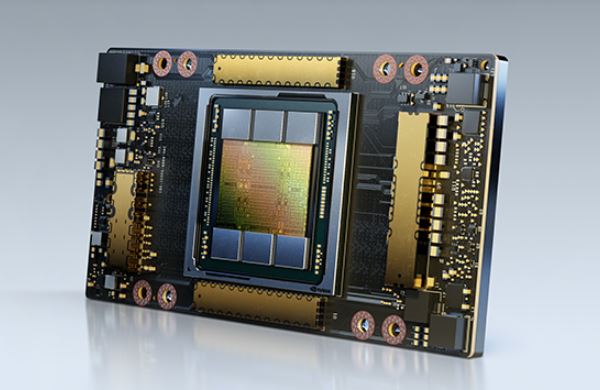

Esses cálculos são baseados na suposição de que a OpenAI usaria as GPUs A100 da Nvidia para alimentar o modelo de linguagem. Essas placas gráficas ultrapoderosas são realmente caras – na faixa de US $ 10.000 a US $ 15.000 cada. Eles também não são os principais cartões de centro de dados da Nvidia no momento, então é possível que o OpenAI opte pelos cartões H100 mais novos, que devem oferecer até três vezes o desempenho do A100. Essas GPUs vêm com um grande aumento de preço, com uma placa custando cerca de US$ 30.000 ou mais.

O mercado de GPU de data center não consiste apenas na Nvidia – a Intel e a AMD também vendem aceleradores de IA. No entanto, a Nvidia é frequentemente vista como a solução ideal para tarefas relacionadas à IA , portanto, é possível que ela consiga um acordo lucrativo se e quando a OpenAI decidir aumentar a escala.

Os jogadores devem ficar preocupados se a Nvidia, de fato, acabar fornecendo 10.000 GPUs para ativar o ChatGPT? Depende. As placas gráficas exigidas pelo OpenAI não têm nada a ver com as melhores GPUs da Nvidia para jogadores, então estamos seguros lá. No entanto, se a Nvidia acabar transferindo parte da produção para GPUs de data center, poderemos ver um suprimento limitado de placas gráficas de consumo no futuro. Realisticamente, o impacto pode não ser tão ruim – mesmo que a previsão de 10.000 GPUs confirme, a Nvidia não precisará entregá-los todos imediatamente.