A batalha empresarial do Vale do Silício está se transformando em uma competição culinária? Zuckerberg certa vez preparou pessoalmente uma sopa para atrair talentos, e a alegação da OpenAI de não estar preocupada é pura encenação.

Quando a galinhola e o molusco brigam, o pescador se beneficia. Às vezes, até espero que nós, usuários, sejamos esse pescador; quanto mais acirrada a competição entre os fabricantes de modelos, mais cedo teremos a oportunidade de usar modelos melhores.

Em 22 de dezembro de 2022, três semanas após o lançamento do ChatGPT, o Google tornou-se a primeira gigante da tecnologia a emitir um "alerta vermelho" em resposta à ameaça representada pela OpenAI.

Ontem, duas semanas após o lançamento do Gemini 3, a OpenAI emitiu seu primeiro "alerta vermelho" devido ao aumento significativo no uso do modelo Gemini 3.

Quando vi a notícia pela primeira vez, pensei que a OpenAI estivesse exagerando. Logo vi comentários dizendo coisas como "o orgulho precede a queda" e "vitória e derrota são comuns na guerra". Mas depois pensei que o tal "alerta vermelho" poderia ser apenas para os investidores. Afinal, se a OpenAI realmente não conseguir se tornar a número um, o tempo necessário para se tornar lucrativa em 2030 só aumentará.

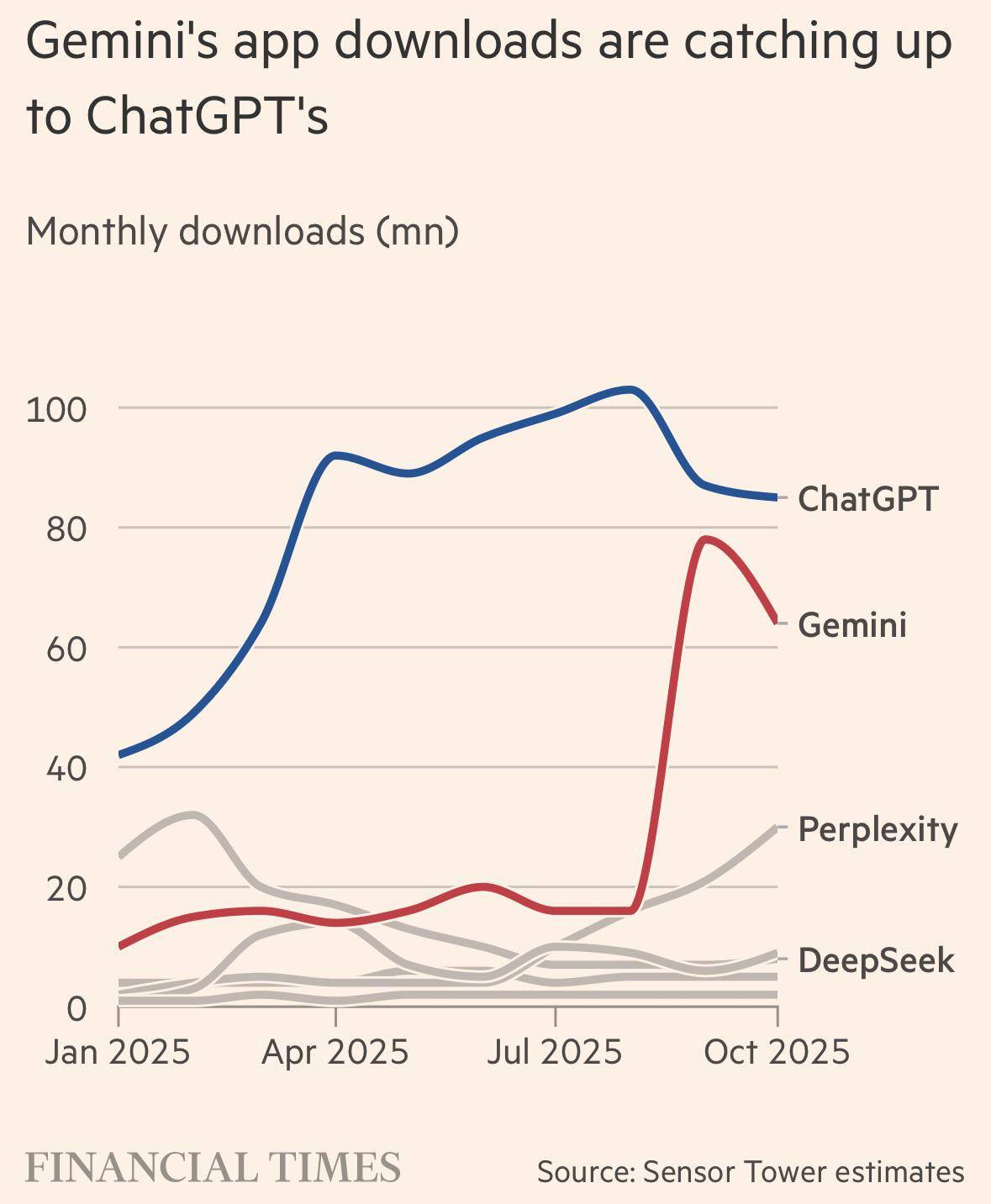

▲ Os downloads do aplicativo Gemini estão quase alcançando os do ChatGPT.

Segundo as últimas notícias, a OpenAI lançará um novo modelo de inferência na próxima semana, que internamente demonstrou ter um desempenho superior ao do Gemini 3. Além disso, eles planejam contra-atacar com um modelo de codinome "Garlic".

No entanto, o cenário mais realista é que a OpenAI inevitavelmente lançará um modelo melhor do que o Gemini 3, enquanto o Google também possui o Gemini 4 e o Gemini 5.

Na verdade, olhando para as notícias do Vale do Silício ao longo do último ano, foi um espetáculo dramático e tumultuoso. No início do ano, o surgimento repentino do DeepSeek R1 nos pressionou; no meio do ano, Zuckerberg lançou uma frenética "corrida por talentos", com salários altíssimos que redefiniram a compreensão de todos sobre o talento em IA; e no final do ano, fomos mais uma vez arrastados para a arena simples da competição de modelos.

Em uma entrevista recente para um podcast, Mark Chen, chefe de pesquisa da OpenAI, descreveu a batalha no Vale do Silício como tendo atingido um nível surreal. Ele disse que, para atrair os principais talentos da OpenAI, Zuckerberg chegou ao ponto de fazer sopa — literalmente sopa para beber — e entregá-la pessoalmente na porta dos pesquisadores.

Além dessas fofocas, ele também falou sobre a visão da OpenAI em relação ao Gemini 3, se o escalonamento está ultrapassado, o impacto do DeepSeek R1 sobre eles, a alocação interna de poder computacional da empresa e o cronograma para alcançar a Inteligência Artificial Geral (AGI).

A trajetória de Mark Chen é bastante interessante: ele vem do mundo das competições de matemática, formou-se no MIT, trabalhou com negociação de alta frequência (HFT) em Wall Street e ingressou na OpenAI em 2018 para pesquisar com Ilya. Ao contrário de Altman, que tem uma visão mais voltada para os negócios, essas experiências lhe conferiram uma característica muito peculiar: uma extrema aversão ao fracasso e uma forte crença na matemática.

Ele admitiu que atualmente não tem vida social e que tem trabalhado até 1h ou 2h da manhã todos os dias nas últimas duas semanas.

Compilamos esta entrevista de uma hora e meia e resumimos os principais pontos abaixo, o que pode proporcionar uma melhor compreensão das várias "batalhas" no Vale do Silício ao longo do último ano e dos esforços que a OpenAI fará para manter sua posição de liderança na era da IA.

Em relação ao Gemini 3, na verdade "não estamos preocupados".

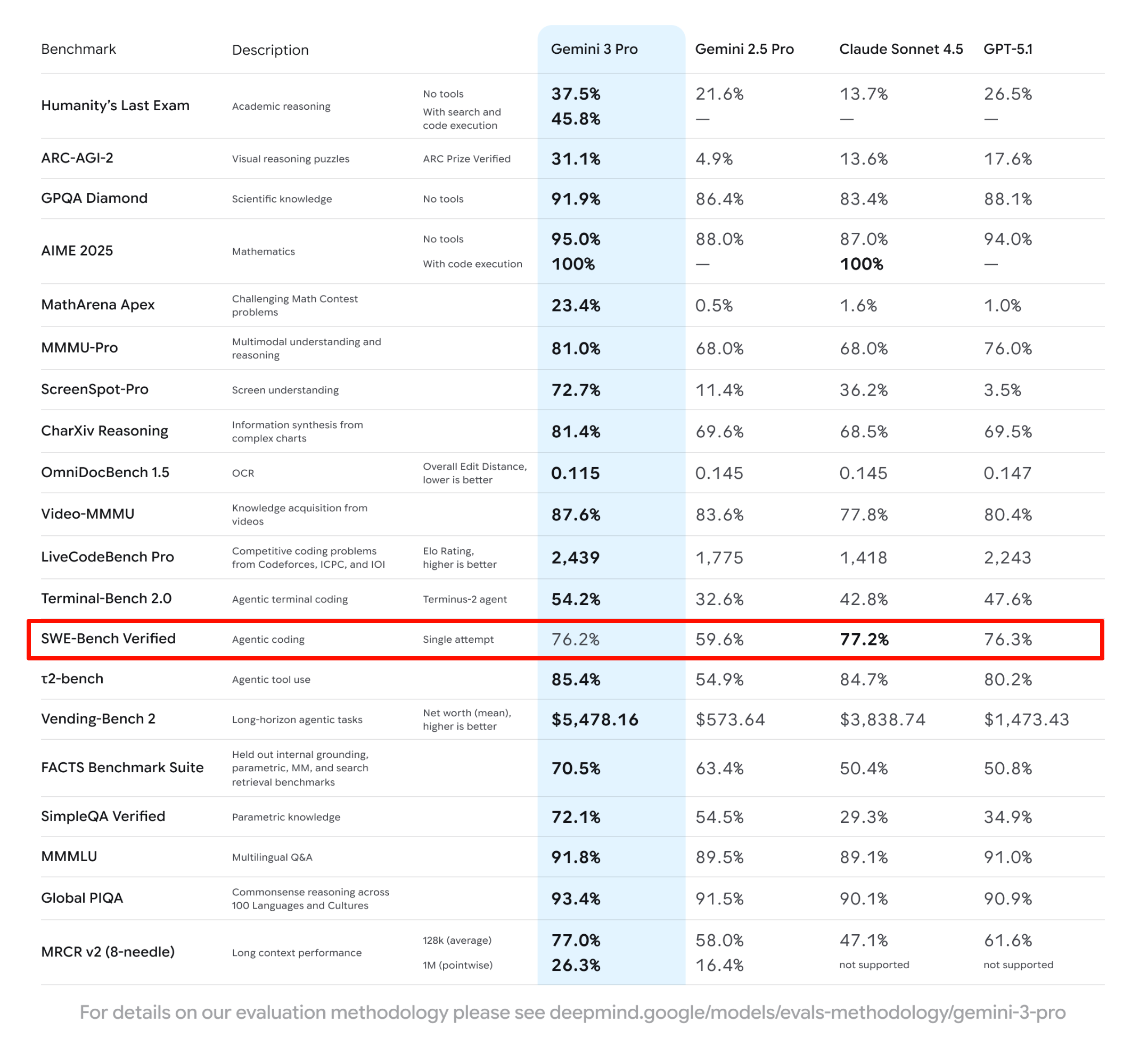

Será que a OpenAI realmente tem medo do Google? A avaliação de Mark é objetiva, porém incisiva. Ele reconheceu que o Gemini 3 é um bom modelo e que o Google finalmente encontrou o caminho certo. No entanto, ele apontou que, analisando os detalhes, como os dados do SWE-bench ( que também é o único benchmark que não alcançou o primeiro lugar na imagem do Gemini 3 dominando o ranking ), o Google ainda não resolveu o problema fundamental da eficiência de dados.

▲O desempenho do Gemini 3.0 Pro no SWE-Bench foi 0,1% pior que o do GPT-5.1.

Ele próprio afirmou com grande confiança que a OpenAI já possui um modelo específico para lidar com essa questão , e que eles estão confiantes de que podem obter resultados ainda melhores em termos de eficiência de dados.

Mark chegou a dizer que o memorando que Altman enviou alguns dias atrás, afirmando que todos deveriam se sentir pressionados, tinha a intenção de assustar a todos, mas na verdade visava injetar um senso de urgência. Ele disse que essa é uma tática comum usada pela gerência, e o objetivo do memorando era motivar a equipe, não fazê-la entrar em pânico.

Acho que uma das funções do Sam é incutir um senso de urgência e velocidade. Essa é a responsabilidade dele, e também a minha.

Como gestores, parte do nosso trabalho é incutir constantemente um senso de urgência na organização.

▲Como relatado anteriormente pelo The Information, Altman enviou um memorando interno quando o Gemini 3 foi lançado, mencionando que isso representaria dificuldades para a OpenAI.

O maior problema deles agora ainda é a alocação de poder computacional . Como diretor de pesquisa da OpenAI, uma de suas funções é decidir como alocar poder computacional para diferentes projetos dentro da empresa.

Juntamente com Jakub Pachocki (Cientista-Chefe da OpenAI), ele é responsável por definir a direção da pesquisa da OpenAI e determinar quanta capacidade computacional cada projeto pode receber. Eles revisam essa definição a cada um ou dois meses.

Eles reuniram todos os projetos em andamento da OpenAI em uma enorme tabela, cerca de 300 no total; em seguida, fizeram o possível para entender cada projeto, priorizaram-nos e, por fim, alocaram GPUs de acordo com essa tabela de prioridades.

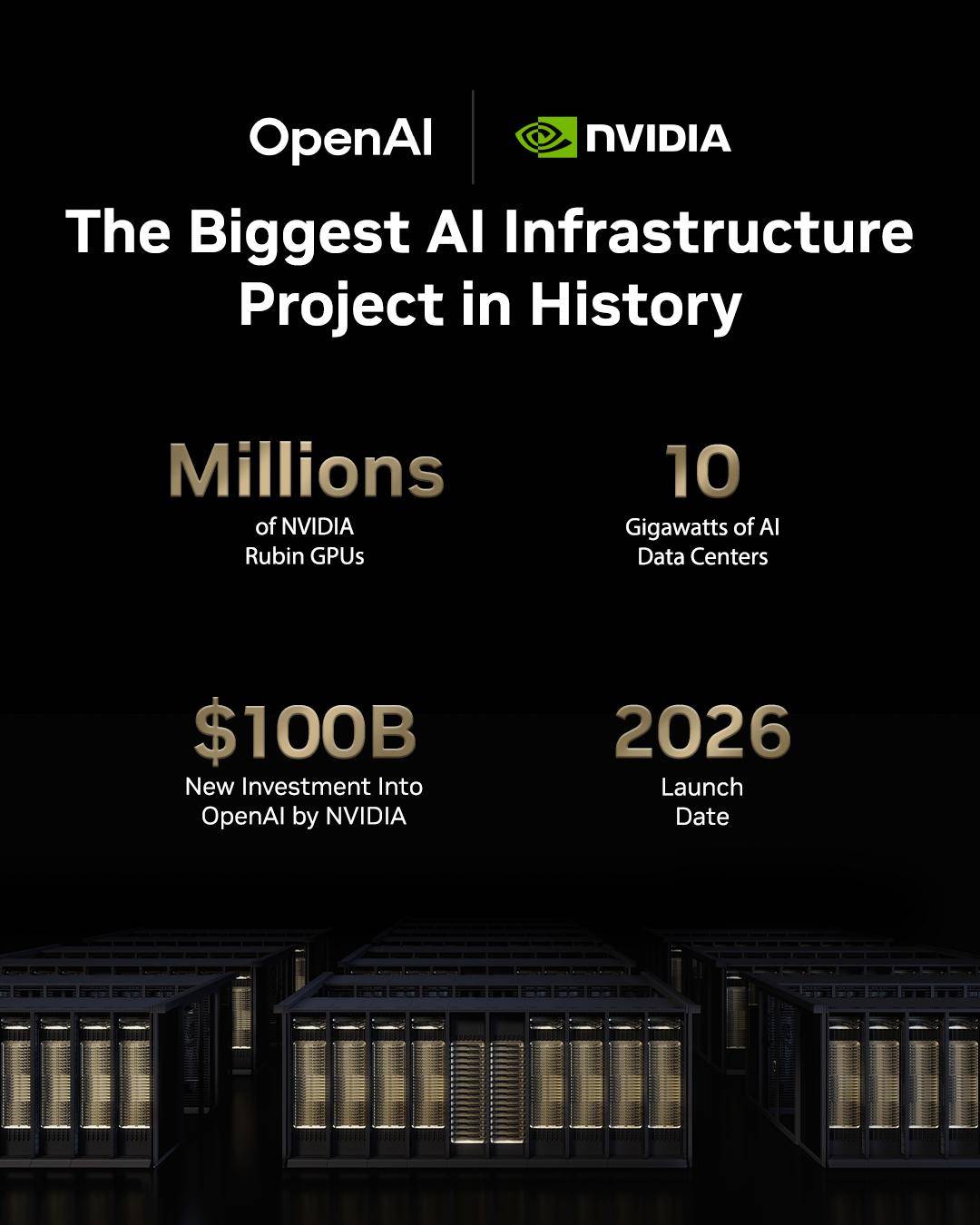

▲ Colaboração entre a NVIDIA e a OpenAI em um milhão de GPUs

Ele também mencionou que o que realmente consome a maior parte das GPUs não é o treinamento do modelo mais importante já lançado, mas sim seus experimentos internos explorando a próxima geração de paradigmas de IA.

Portanto, aos seus olhos, o lançamento do Gemini 3, a avaliação comparativa de um determinado modelo de código aberto e a nova pontuação máxima alcançada por um determinado modelo de pensamento são irrelevantes . Pelo contrário, o que deve ser evitado a todo custo é se deixar levar por essa competição.

Ele disse que, com o desenvolvimento atual dos modelos, podemos facilmente nos manter na liderança por semanas ou meses com apenas uma "pequena atualização". Mas se investirmos todos os nossos recursos nessas iterações de curto prazo, ninguém estará buscando a próxima geração de paradigmas. E quando alguém a encontrar, toda a área terá que seguir esse novo caminho pela próxima década.

Só um aviso rápido: prevejo que o lançamento do modelo da OpenAI na próxima semana será apenas uma atualização não planejada que alterou algumas classificações. Você ainda não está preocupado?

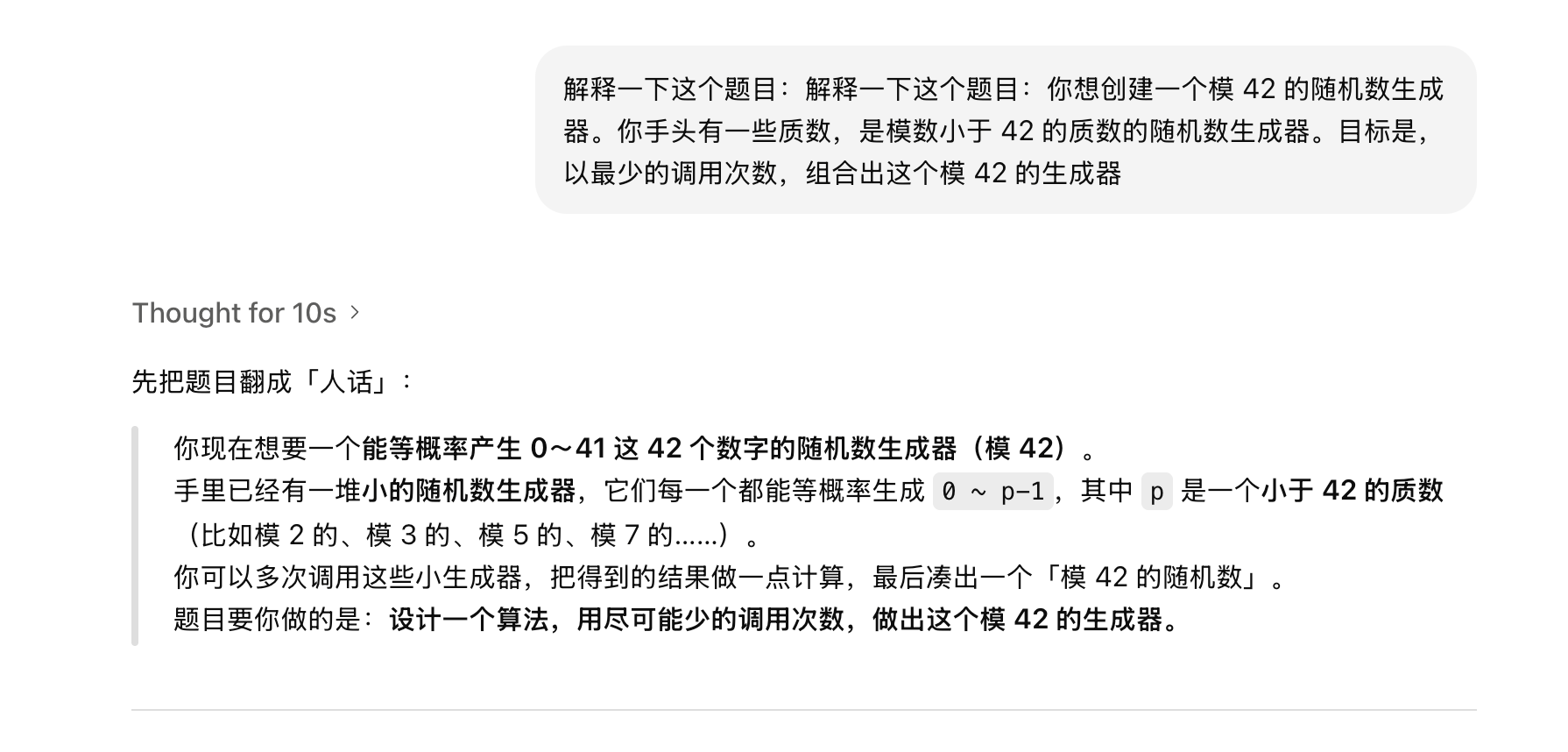

Ao discutir os rankings, ele mencionou que possui seu próprio conjunto de problemas particulares para testar se o modelo realmente possui intuição matemática de alto nível. Ele citou um problema matemático de 42 pontos, afirmando que os modelos de linguagem atuais, incluindo os modelos de pensamento O1, podem se aproximar da solução ideal, mas nunca a resolveram completamente.

Você deseja criar um gerador de números aleatórios módulo 42. Você possui alguns números primos que são módulo 42. O objetivo é gerar esse gerador módulo 42 com o menor número possível de chamadas.

Além de discutir o Gemini 3, o apresentador também perguntou a ele sobre sua opinião a respeito do DeepSeek.

Assim como a Gemini 3, Mark admitiu que o modelo de código aberto da DeepSeek os pressionou e até os fez duvidar se estavam no caminho errado.

A conclusão é: siga seu próprio caminho, não deixe que as ações dos concorrentes interrompam seu ritmo e concentre-se em seu próprio planejamento. A OpenAI não se tornará uma empresa imitadora; o que ela quer é definir o próximo paradigma.

Ilya tem muito potencial de escalabilidade, e a OpenAI precisa de pré-treinamento em larga escala.

Discussões recentes sobre o fracasso do escalonamento têm sido frequentes. Ilya afirmou inicialmente em uma entrevista em podcast que a era do escalonamento havia terminado, mas posteriormente esclareceu nas redes sociais que o escalonamento continuará trazendo melhorias e não é estático.

A chamada Lei de Escala segue a narrativa clássica: com a enorme infraestrutura computacional construída nos últimos anos, cada aumento de dez vezes no poder computacional deveria ter resultado em um salto significativo. No entanto, do GPT-4 para o GPT-5, o esperado "salto qualitativo" não se materializou, levando a discussões sobre o "fracasso da Lei de Escala". A recente entrevista de Ilya reforçou ainda mais esse ponto de vista.

Mark Chen refutou veementemente essa visão, afirmando: "Discordamos completamente". Ele revelou que a OpenAI investiu recursos massivos em inferência nos últimos dois anos, o que levou a uma ligeira degradação no pré-treinamento. Os problemas anteriores com o pré-treinamento do GPT-5 foram, na verdade, devido ao foco em inferência , e não ao fato de a Lei de Escala ter sido descartada.

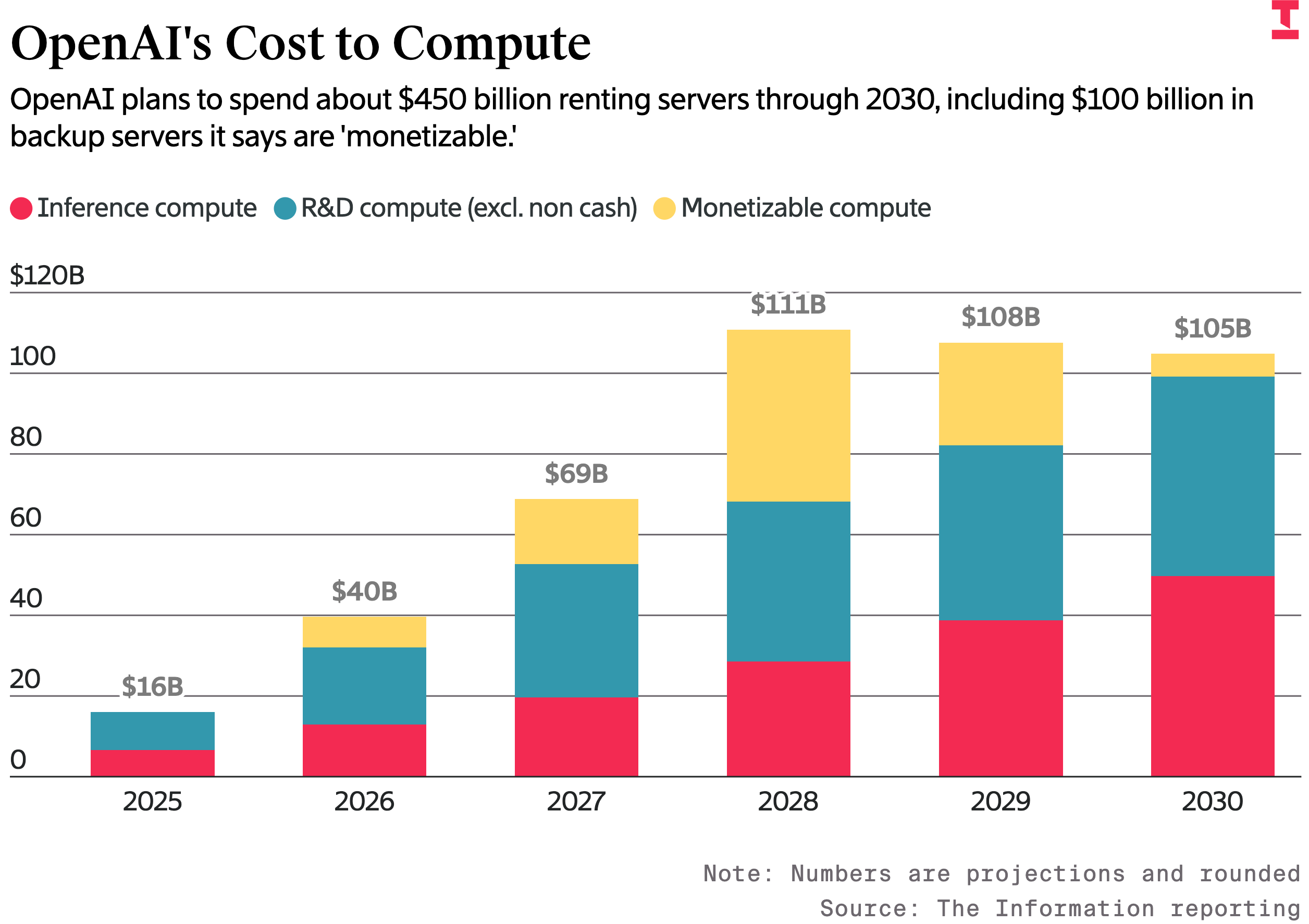

Sua função é alocar recursos computacionais, e ele reiterou que o poder computacional nunca será excessivo. Se houvesse três vezes mais poder computacional hoje, ele poderia usá-lo imediatamente; se houvesse dez vezes mais poder computacional hoje, ele poderia utilizá-lo completamente em poucas semanas. Para ele, a demanda por poder computacional é real e não há indícios de que vá diminuir.

▲ Custos de computação da OpenAI: A empresa planeja gastar aproximadamente US$ 450 bilhões com aluguel de servidores até 2030. A cor vermelha representa os custos de computação inferencial, a azul representa os custos de P&D (excluindo operações de caixa) e a amarela representa os custos de computação lucrativa.

Ele também mencionou que, nos últimos seis meses, ele e o cientista-chefe da OpenAI, Jakub Pachocki, voltaram a concentrar seus esforços em reformular o domínio do pré-treinamento .

Ele afirmou explicitamente que continuarão a desenvolver modelos escaláveis e que várias inovações algorítmicas foram alcançadas, projetadas especificamente para tornar a escalabilidade mais econômica, extraindo mais desempenho com a mesma capacidade computacional e mantendo a eficiência dos dados com maior capacidade computacional.

A sopa feita com carinho por Zuckerberg não se comparava à mensagem motivacional da OpenAI.

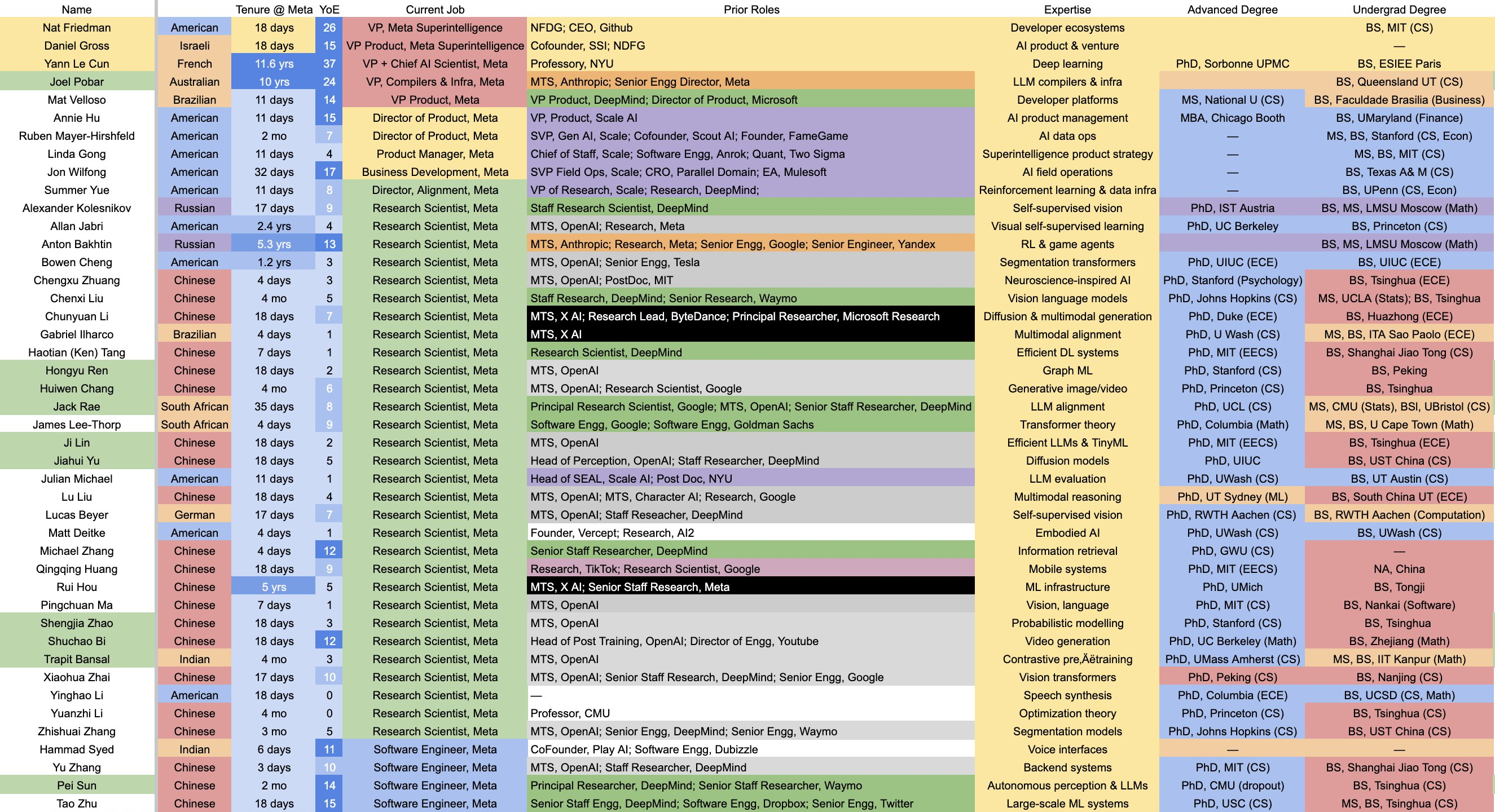

Por fim, há os rumores mencionados na entrevista. A Meta não teve nenhuma outra novidade este ano, mas a mídia exagerou durante um trimestre inteiro a respeito da "fuga massiva de talentos da OpenAI, da Apple e do Google para a Meta". Mark Chen abordou esse assunto diretamente no podcast, e os detalhes foram quase "inacreditáveis".

Ele disse que Zuckerberg estava realmente se empenhando ao máximo; para atrair talentos, ele não só escrevia e-mails à mão, como também entregava pessoalmente sopa de galinha. A guerra por talentos acabou se transformando em um metajogo de "quem sabe fazer a melhor sopa".

▲ Lista dos Laboratórios de Superinteligência da Meta, construídos com enormes somas de dinheiro para recrutar talentos.

No entanto, Meta tentou aliciar metade de seus subordinados diretos, mas todos optaram por ficar. Por que não foram embora? Não por causa do dinheiro, já que Meta obviamente ofereceu mais, mas por causa de suas crenças .

Mark disse que mesmo aqueles que abandonaram o barco para se juntar à Meta não ousaram dizer: "A Meta criará a IAG antes da OpenAI". Aqueles que permaneceram na OpenAI o fizeram porque realmente acreditavam que ela era o berço da IAG.

Ele também mencionou que aprendeu com suas experiências em Wall Street e jogando pôquer que o que você realmente precisa reter é o talento essencial, não cada indivíduo individualmente . Depois de descobrir que tipo de pessoa você absolutamente precisa manter, então pode concentrar todos os seus recursos e atenção nesse grupo.

Ele disse que sua emoção mais forte era, na verdade, o desejo de "proteger o instinto de pesquisa". Quando Barrett (vice-presidente de pesquisa da OpenAI) saiu, ele chegou a dormir em seu escritório por um mês só para manter a equipe de pesquisa focada.

▲ Barret e Mira (ex-CTO da OpenAI) estão atualmente na Thinking Machines.

Então, o que é AGI, na qual a OpenAI acredita? O apresentador perguntou: "Andrej Karpathy disse em um podcast recente que a AGI provavelmente ainda está a 10 anos de distância. O que você acha?"

Mark começou com um comentário jocoso sobre os vários textos publicitários "incríveis" da X, que alternam entre "A IA acabou" e "A IA é viável novamente". Ele acredita que cada pessoa tem uma compreensão diferente de IAG (Inteligência Artificial Geral), e mesmo dentro da OpenAI, é difícil chegar a uma definição unificada. Mas ele acredita nos objetivos que a OpenAI estabeleceu para a IAG.

- Dentro de um ano: Mudar a natureza da pesquisa. Atualmente, os pesquisadores escrevem o código e executam os experimentos por conta própria. Depois de um ano, a principal função dos pesquisadores será gerenciar estagiários de IA. A IA deverá ser capaz de atuar como uma assistente eficiente, executando a maioria das tarefas específicas.

- Em 2,5 anos: Alcançar a automação completa da pesquisa . Isso significa que os humanos serão responsáveis apenas por propor ideias (design de alto nível), enquanto a IA será responsável por implementar o código, depurar, executar os dados e analisar os resultados, formando um ciclo fechado.

De Copiloto a Cientista, Mark enfatiza que o objetivo da OpenAI for Science não é ganhar o Prêmio Nobel em si, mas construir um conjunto de ferramentas que permita aos cientistas atuais acelerar seu trabalho com um único clique, mesmo que isso exija a reestruturação de todo o sistema de avaliação científica, porque no futuro pode ser difícil distinguir se uma descoberta foi feita por um humano ou por IA.

Dois anos e meio podem parecer pouco tempo, mas para a indústria de IA, que agora realiza iterações semanais, é uma longa maratona.

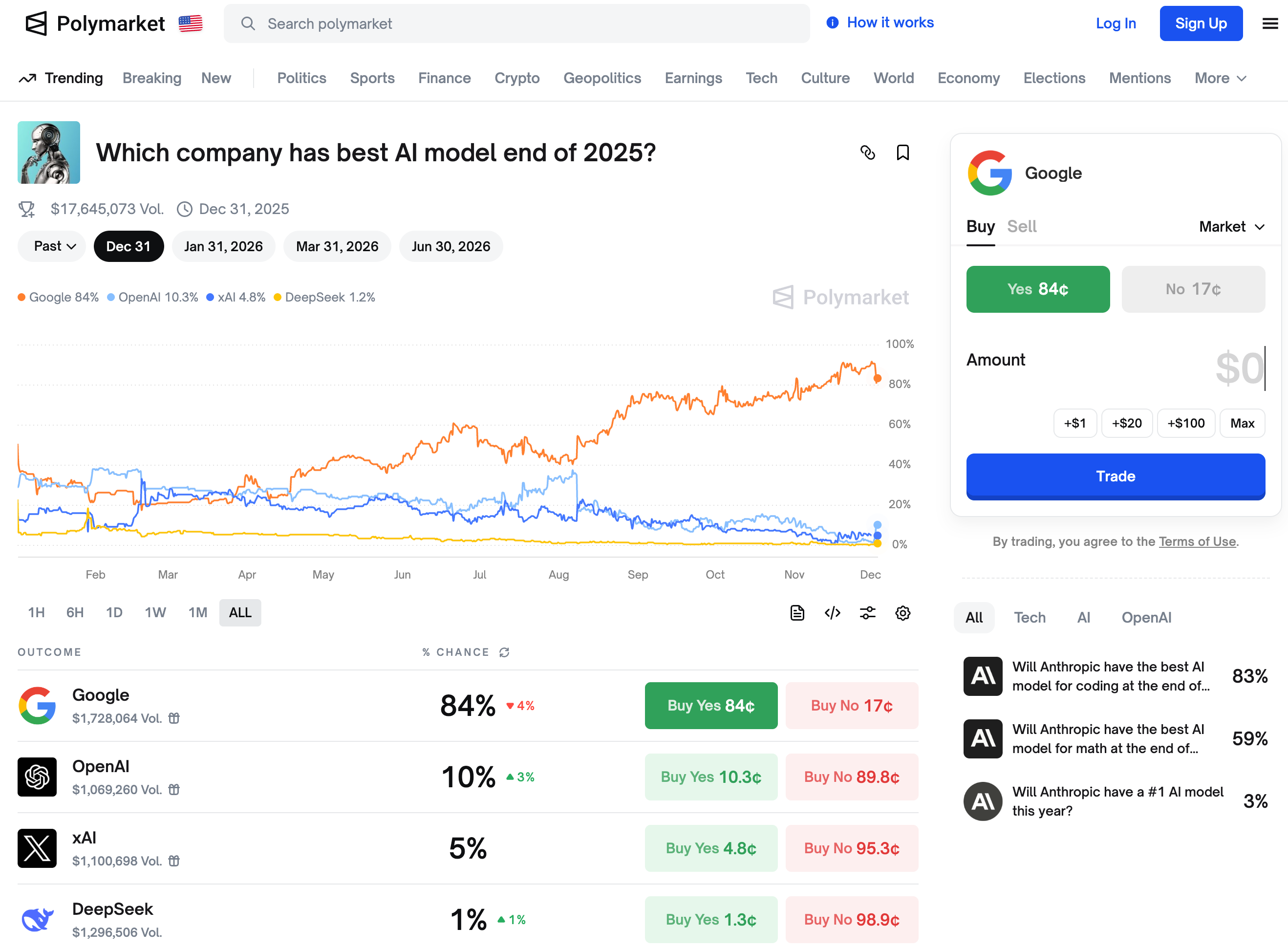

▲ De acordo com as previsões de mercado, o Google ocupa o primeiro lugar como a empresa que produzirá o melhor modelo de IA até o final de 2025.

Sejam as promessas lucrativas, porém vazias, de Zuckerberg, ou a visão idealista da OpenAI de definir o futuro, esse "drama" do Vale do Silício está longe de terminar. A serenidade de Mark Chen em seu podcast pode aliviar algumas ansiedades externas, mas os usuários, em última análise, votarão com os pés; bons modelos falarão por si mesmos.

#Siga a conta oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde você encontrará conteúdo ainda mais interessante o mais breve possível.