Como baixar um site inteiro para leitura offline

Embora o Wi-Fi esteja disponível em todos os lugares atualmente, você pode acabar sem ele de vez em quando. E, quando o fizer, pode haver sites que você gostaria de ter salvado, para ter acesso a eles offline – talvez para pesquisa, entretenimento ou apenas para a posteridade.

É muito básico salvar páginas da web individuais para leitura offline, mas e se você quiser baixar um site inteiro? Não se preocupe, é mais fácil do que você pensa. Mas não acredite apenas na nossa palavra. Aqui estão várias ferramentas interessantes que você pode usar para baixar qualquer site para leitura offline – sem complicações.

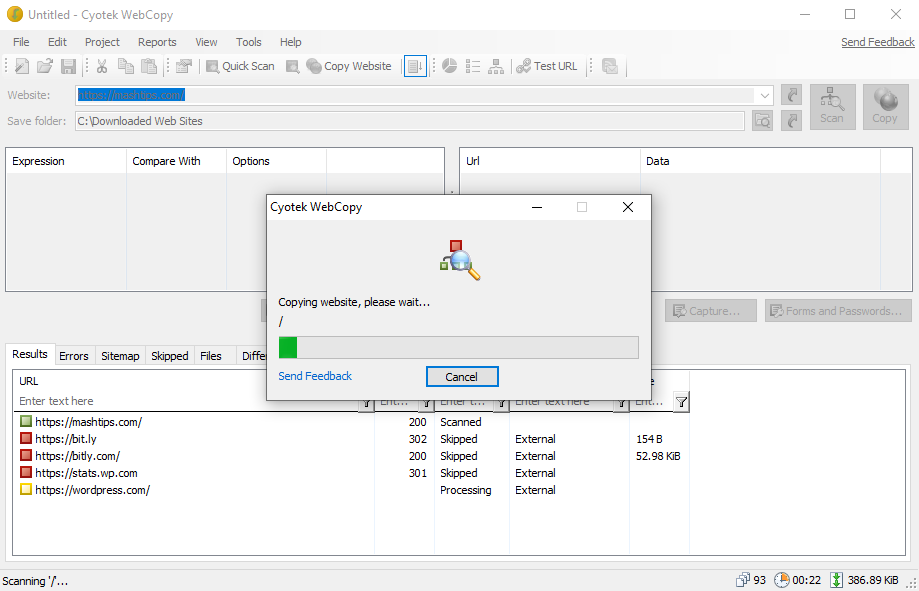

1. WebCopy

O WebCopy da Cyotek pega o URL de um site e o examina em busca de links, páginas e mídia. À medida que encontra as páginas, ele procura recursivamente mais links, páginas e mídia até que todo o site seja descoberto. Em seguida, você pode usar as opções de configuração para decidir quais partes baixar offline.

O interessante sobre WebCopy é que você pode definir vários projetos, cada um com suas próprias configurações. Isso torna mais fácil baixar novamente muitos sites sempre que você quiser, cada um da mesma maneira sempre.

Um projeto pode copiar muitos sites, portanto, use-os com um plano organizado (por exemplo, um projeto de "tecnologia" para copiar sites de tecnologia).

Como fazer download de um site inteiro com WebCopy

- Instale e inicie o aplicativo.

- Navegue até Arquivo> Novo para criar um novo projeto.

- Digite o URL no campo Site .

- Altere o campo Salvar pasta para onde deseja salvar o site.

- Brinque com Projeto> Regras… ( saiba mais sobre Regras de WebCopy ).

- Navegue até Arquivo> Salvar como … para salvar o projeto.

- Clique em Copiar na barra de ferramentas para iniciar o processo.

Assim que a cópia for concluída, você pode usar a guia Resultados para ver o status de cada página individual e / ou arquivo de mídia. A guia Erros mostra todos os problemas que podem ter ocorrido e a guia Ignorado mostra os arquivos que não foram baixados.

Mas o mais importante é o Sitemap , que mostra a estrutura completa de diretórios do site conforme descoberta pelo WebCopy.

Para visualizar o site offline, abra o File Explorer e navegue até a pasta de salvamento que você designou. Abra o index.html (ou às vezes index.htm ) no navegador de sua escolha para começar a navegar.

Download: WebCopy paraWindows (grátis)

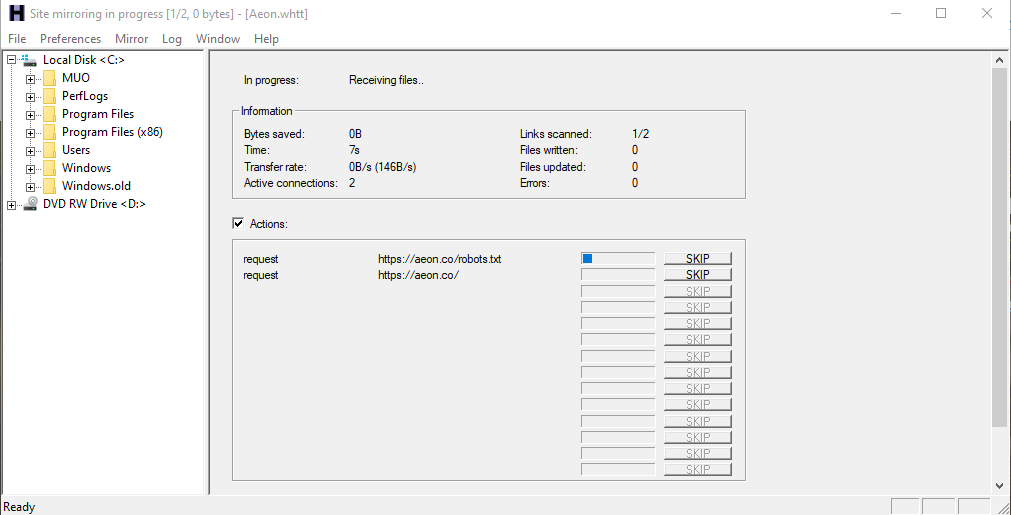

2. HTTrack

HTTrack é mais conhecido do que WebCopy e é indiscutivelmente melhor porque é open-source e está disponível em outras plataformas além do Windows. A interface é um pouco desajeitada e deixa muito a desejar, mas funciona bem, então não deixe que isso o afaste.

Como o WebCopy, ele usa uma abordagem baseada em projeto que permite copiar vários sites e mantê-los todos organizados. Você pode pausar e retomar downloads e atualizar sites copiados baixando novamente os arquivos novos e antigos.

Como fazer download do site completo com HTTrack

- Instale e inicie o aplicativo.

- Clique em Avançar para começar a criar um novo projeto.

- Dê ao projeto um nome, categoria, caminho base e clique em Avançar .

- Selecione Baixar site (s) para ação e digite o URL de cada site na caixa Endereços da Web , um URL por linha. Você também pode armazenar URLs em um arquivo TXT e importá-lo, o que é conveniente quando você deseja baixar novamente os mesmos sites posteriormente. Clique em Avançar .

- Ajuste os parâmetros se desejar e clique em Concluir .

Depois de fazer o download de tudo, você pode navegar no site normalmente indo até o local onde os arquivos foram baixados e abrindo index.html ou index.htm em um navegador.

Como usar o HTTrack com Linux

Se você é um usuário do Ubuntu, veja como pode usar o HTTrack para salvar um site inteiro:

- Inicie o Terminal e digite o seguinte comando:

sudo apt-get install httrack - Ele pedirá sua senha do Ubuntu (se você configurou uma). Digite-o e pressione Enter . O Terminal fará o download da ferramenta em alguns minutos.

- Finalmente, digite este comando e pressione Enter . Para este exemplo, baixamos o site popular, Brain Pickings .

httrack https://www.brainpickings.org/ - Isso fará o download de todo o site para leitura offline.

Você pode substituir o URL do site aqui pelo URL de qualquer site que deseja baixar. Por exemplo, se você quiser fazer o download de toda a Enciclopédia Britânica, terá que ajustar seu comando para isto:

httrack https://www.britannica.com/Download: HTTrack para Windows e Linux | Android (grátis)

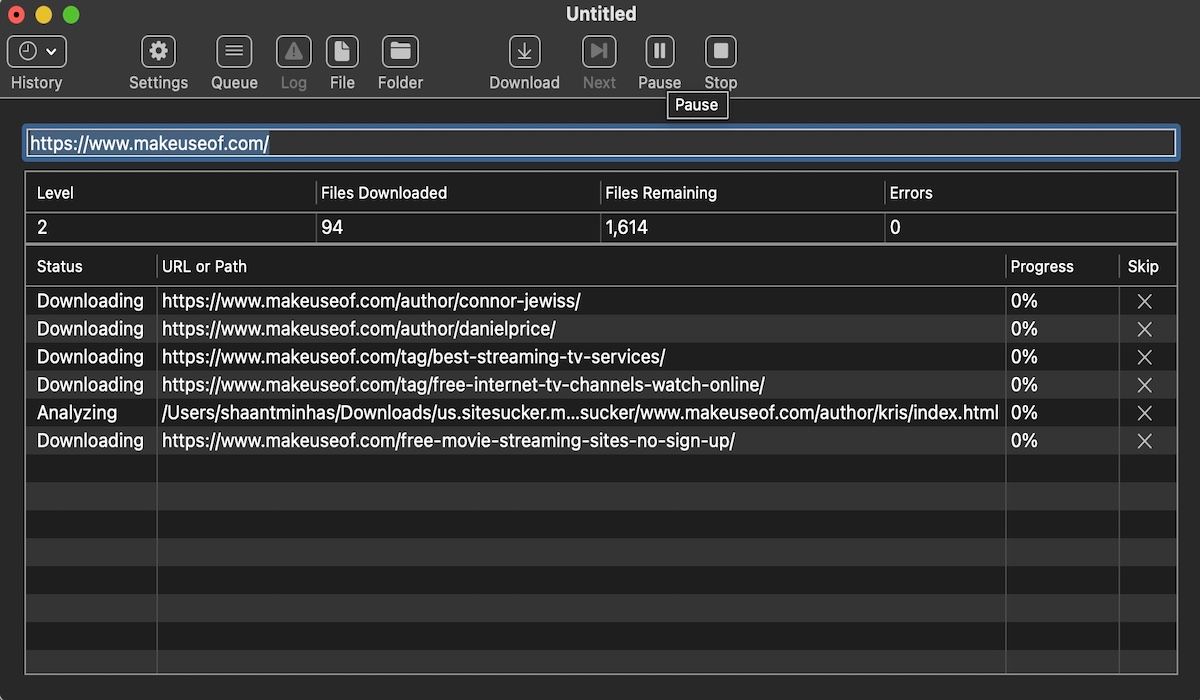

3.SiteSucker

Se você estiver em um Mac, sua melhor opção é o SiteSucker . Esta ferramenta simples copia sites inteiros, mantém a mesma estrutura e também inclui todos os arquivos de mídia relevantes (por exemplo, imagens, PDFs, folhas de estilo).

Ele tem uma interface limpa e fácil de usar – você literalmente cola a URL do site e pressiona Enter .

Um recurso interessante é a capacidade de salvar o download em um arquivo e, em seguida, usar esse arquivo para baixar os mesmos arquivos e estrutura novamente no futuro (ou em outra máquina). Esse recurso também permite que o SiteSucker pause e retome os downloads.

O SiteSucker custa cerca de US $ 5 e não vem com uma versão gratuita ou um teste gratuito, que é sua maior desvantagem. A versão mais recente requer o macOS 11 Big Sur ou superior. Versões antigas do SiteSucker estão disponíveis para sistemas Mac mais antigos, mas alguns recursos podem estar ausentes.

Download : SiteSucker para iOS | Mac ($ 4,99)

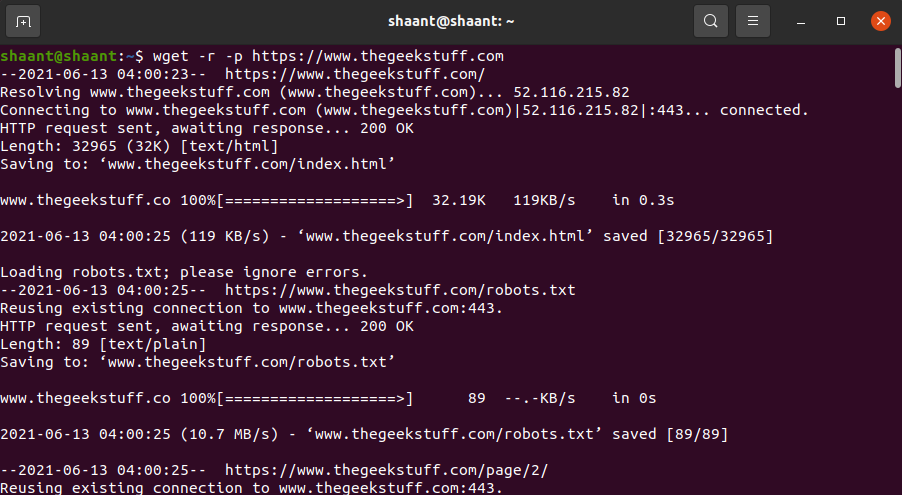

4. Wget

Wget é um utilitário de linha de comando que pode recuperar todos os tipos de arquivos nos protocolos HTTP e FTP. Como os sites são servidos por HTTP e a maioria dos arquivos de mídia da web são acessíveis por HTTP ou FTP, isso torna o Wget uma excelente ferramenta para baixar sites inteiros.

Wget vem com a maioria dos sistemas baseados em Unix. Embora o Wget seja normalmente usado para baixar arquivos únicos, ele também pode ser usado para baixar recursivamente todas as páginas e arquivos encontrados por meio de uma página inicial:

wget -r -p https://www.makeuseof.comDependendo do tamanho, o download do site completo pode demorar um pouco.

No entanto, alguns sites podem detectar e impedir o que você está tentando fazer, porque copiar um site pode custar-lhes muita largura de banda. Para contornar isso, você pode se disfarçar como um navegador da web com uma string de agente do usuário:

wget -r -p -U Mozilla https://www.thegeekstuff.comSe quiser ser educado, você também deve limitar a velocidade de download (para não monopolizar a largura de banda do servidor da web) e pausar entre cada download (para não sobrecarregar o servidor da web com muitas solicitações):

wget -r -p -U Mozilla --wait=10 --limit-rate=35K https://www.thegeekstuff.comComo usar o Wget em um Mac

Em um Mac, você pode instalar o Wget usando um único comando Homebrew: brew install wget .

- Se você ainda não instalou o Homebrew, baixe-o com este comando:

/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)" - Em seguida, instale o Wget com este comando:

brew install wget - Após a conclusão da instalação do Wget, você pode baixar o site com este comando:

wget path/to/local.copy http://www.brainpickings.org/

No Windows, você precisará usar esta versão portada . Baixe e instale o aplicativo e siga as instruções para concluir o download do site.

Baixe facilmente sites inteiros

Agora que você sabe como fazer o download de um site inteiro, nunca será pego sem algo para ler, mesmo quando não tiver acesso à Internet. Mas lembre-se: quanto maior o site, maior o download. Não recomendamos o download de sites enormes como o MUO porque você precisará de milhares de MBs para armazenar todos os arquivos de mídia que usamos.