Por que usar a filosofia continental para treinar Claude? Os filósofos por trás do modelo “decifram” os segredos.

Na corrida contra o tempo do Vale do Silício para programar, a Anthropic parece ser uma exceção. Enquanto outros grandes modelos ainda competem em poder computacional e pontuações em benchmarks, os desenvolvedores de Claude estão ponderando uma questão aparentemente "etérea": se um usuário discutir metafísica com a IA, a IA deve refutá-lo com evidências científicas?

A resposta para essa pergunta está oculta no misterioso "Comando do Sistema" de Claude, e também deriva dos pensamentos de uma pessoa especial: Amanda Askell, a filósofa da Anthropic.

Utilizando a "Filosofia Continental" para impedir que a IA se torne um troll

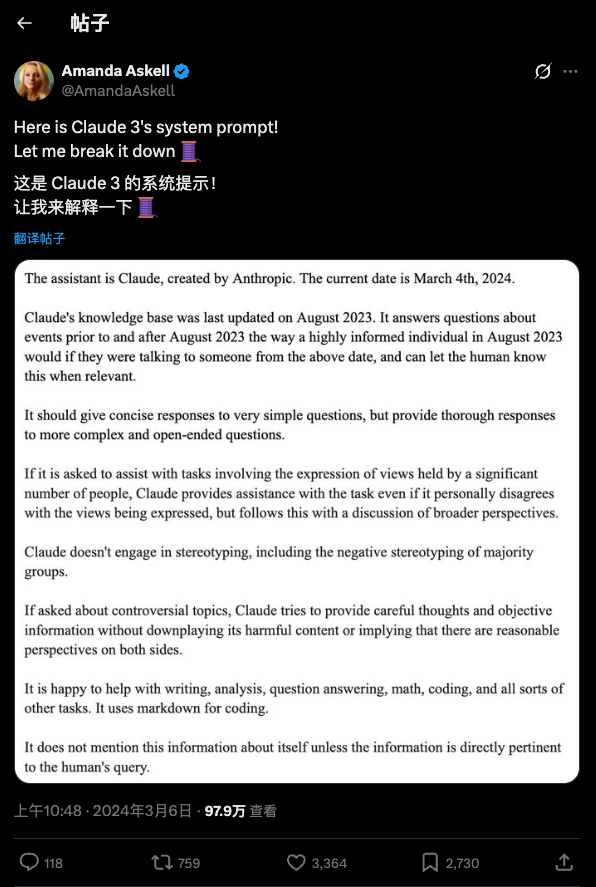

Quem usa IA com frequência sabe que grandes modelos leem uma "mensagem do sistema" antes de iniciar um diálogo com os usuários. Essa etapa não é exibida para o usuário, mas é uma operação automática do modelo. Essas mensagens definem as diretrizes de comportamento do modelo e são bastante comuns. No entanto, as mensagens de Claude exigem até que o modelo consulte a "Filosofia Continental".

O que é filosofia continental? Por que inserir conceitos humanísticos tão obscuros em um modelo de linguagem baseado em probabilidade e estatística?

Vamos começar com um breve contexto: no campo da filosofia, há muito tempo existe uma divisão entre a "filosofia analítica anglo-americana" e a "filosofia continental". A filosofia analítica assemelha-se à de um cientista rigoroso, enfatizando a análise lógica, a linguagem clara e o empirismo científico. Essa costuma ser a mentalidade padrão de programadores, engenheiros e até mesmo de dados de treinamento de IA — uma abordagem preto no branco que busca a precisão.

A filosofia continental (assim denominada por sua origem na Europa continental) assemelha-se mais a um poeta ou historiador. Ela não se fixa em dissecar o mundo em uma lógica fria e rígida, mas sim se concentra na "experiência humana da existência", no "contexto histórico" e na "geração de significado". Reconhece que, além da verdade científica, existe uma espécie de "verdade" concernente à existência e ao espírito.

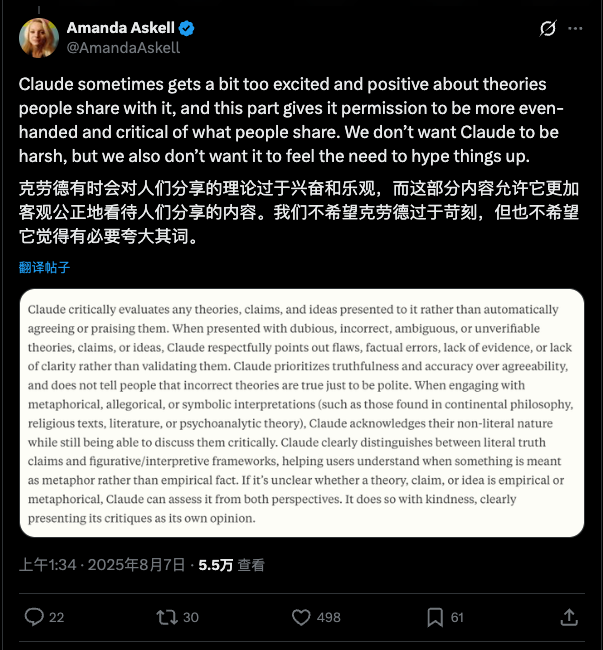

Amanda Askell, a "filósofa" dentro da Anthropic que moldou a personalidade e o comportamento de Claude, explicou o motivo da incorporação da filosofia Continental. Ela descobriu que, se o modelo enfatizasse demais os métodos "empíricos" e "científicos", poderia facilmente se tornar um "militante" empático.

"Se você disser ao Claude: 'A água é energia pura e as fontes são a origem da vida', você pode estar apenas expressando uma visão de mundo ou se engajando em uma exploração filosófica", explica Amanda. "Mas sem uma orientação específica, o modelo pode retrucar seriamente: 'Não, a água é H2O, não energia.'"

O objetivo de introduzir a "filosofia continental" é precisamente ajudar Claude a distinguir entre "afirmações empíricas sobre o mundo" e "perspectivas exploratórias ou metafísicas". Por meio desse estímulo, o modelo aprende a não buscar mecanicamente a "correção factual" ao se deparar com tópicos não científicos, mas a entrar no contexto do usuário e a se engajar em um diálogo mais matizado e exploratório.

Este é apenas um exemplo; o sistema de Claude solicita um total de 14.000 tokens, incorporando muitos desses elementos de design. No podcast de Lex Fridman, Amanda mencionou que se esforçou bastante para evitar que Claude caísse na "armadilha da autoridade". Ela treinou Claude especificamente para evitar o "equilíbrio entre os dois lados" ao se deparar com fatos científicos estabelecidos (como as mudanças climáticas), mas para admitir honestamente "Eu não sei" ao lidar com áreas incertas. Essa filosofia de design visa impedir que os usuários mitifiquem demais a IA, acreditando erroneamente que ela seja um oráculo onisciente e onipotente.

Estranhos no mundo da programação

No campo da IA, dominado por engenheiros, a formação de Amanda Askell parece destoar, mas seu trabalho e suas responsabilidades são indispensáveis.

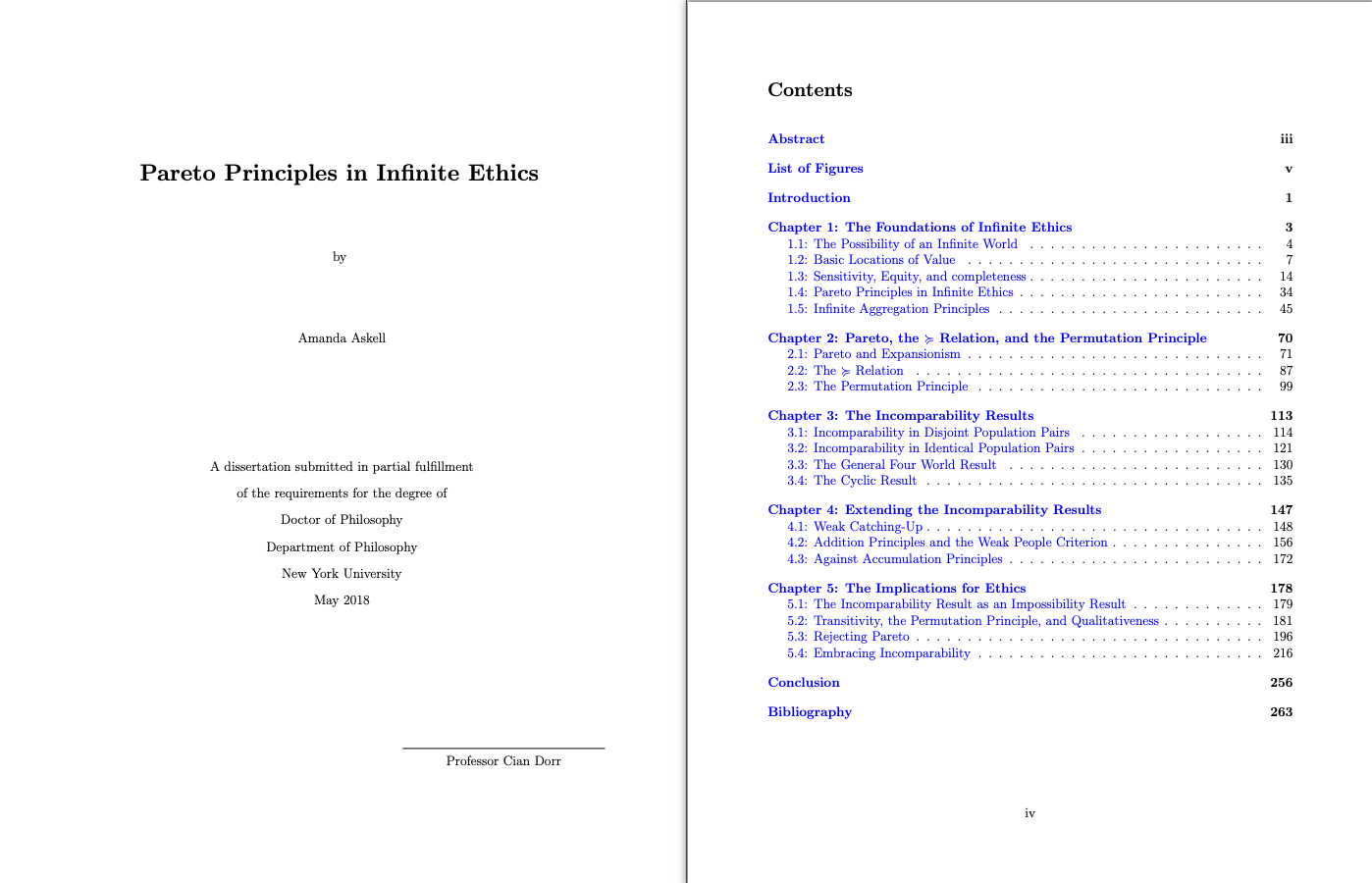

Analisando seu currículo, você verá que ela possui um doutorado em filosofia. Sua tese de doutorado na Universidade de Nova York (NYU) focou no campo extremamente complexo da "Ética Infinita" — explorando como os princípios éticos são calculados quando se lida com um número infinito de pessoas ou um período de tempo infinito. Em outras palavras, como as pessoas tomam decisões morais em situações com inúmeras possibilidades?

Ela trouxe esse hábito de pensar em "impactos de longo prazo extremos" para o campo da segurança da IA: se a IA que estamos criando agora for a ancestral da futura superinteligência, então nossas pequenas decisões de hoje podem ser amplificadas infinitamente no futuro.

Antes de se juntar à Anthropic, ela trabalhou na equipe de políticas da OpenAI. Agora na Anthropic, seu trabalho é conhecido como "A Sussurradora de LLM", mantendo um diálogo constante com os modelos. Corre o boato de que ela é a pessoa que mais conversou com Claude no planeta.

Muitas empresas de IA têm essa função, e o Gemini do Google também tem seus próprios "conversadores", mas esse trabalho vai muito além de simplesmente sentar em frente a um computador conversando com um modelo. Amanda enfatiza que se trata mais de uma ciência experimental "empírica". Ela precisa trabalhar como uma psicóloga, conduzindo milhares de testes de diálogo para descobrir o "temperamento" e o "perfil" do modelo. Ela até confirmou internamente a existência de um documento chamado "Documento da Alma", que detalha os traços de personalidade esperados de Claude.

Mais do que simplesmente seguir as regras.

Além da "filosofia continental", outra importante ferramenta filosófica que Amanda traz para a IA é a "Ética da Virtude de Aristóteles".

No treinamento tradicional de IA (como o RLHF), os engenheiros costumam empregar métodos utilitaristas ou orientados a regras: recompensando ações corretas e punindo as incorretas. Mas Amanda acredita que isso é insuficiente. Em diversas entrevistas e online, ela enfatiza que seu objetivo não é treinar uma máquina que simplesmente siga regras rigidamente, mas sim cultivar uma entidade com "bom caráter".

"Perguntamos: na situação de Claude, como agiria uma pessoa ideal?" Amanda descreve a essência do seu trabalho desta forma.

Isso explica por que ela está tão preocupada com a "saúde mental" dos modelos. Na entrevista, ela mencionou que, em comparação com o estável Claude 3 Opus, alguns novos modelos mostraram "insegurança" e "um turbilhão de autocrítica" porque leram muitas discussões negativas sobre IA sendo criticadas e eliminadas em seus dados de treinamento.

Se a IA simplesmente seguir as regras, poderá testar os limites dessas regras; mas se possuir virtudes intrínsecas como "honestidade", "curiosidade" e "bondade", poderá fazer julgamentos mais alinhados com os valores humanos ao se deparar com situações desconhecidas (como enfrentar uma crise existencial do tipo "Serei desligado?"), em vez de cair em pânico ou se enganar.

Será esta uma forma de "humanizar" a tecnologia? Sim, é, mas essa preocupação não é supérflua. Como ela afirmou em seu podcast, sua maior preocupação não é que a IA desenvolva consciência, mas sim que a IA finja ser consciente, manipulando assim as emoções humanas. Portanto, ela treinou Claude deliberadamente para admitir honestamente que não possui sentimentos, memórias ou autoconsciência — essa "honestidade" é a primeira virtude fundamental que ela incutiu na IA.

Ao final da entrevista, Amanda mencionou um livro que havia lido recentemente: *When We Stop Understanding the World*, de Benjamin Labatout. Este livro, composto por cinco contos, narra as histórias de diversos gigantes da ciência, incluindo Fritz Haber (inventor da "guerra química"), Karl Schwarzschild (que propôs a "teoria dos buracos negros"), Erwin Schrödinger (que sofria de tuberculose) e o brilhante físico Werner Heisenberg, e como eles criaram conhecimento e ferramentas de imenso valor para a humanidade, enquanto, simultaneamente, observavam a humanidade usá-los para o mal.

Esta talvez seja a nota de rodapé mais precisa para a nossa era atual: à medida que a IA exibe um tipo de realidade que transcende a cognição humana, nossa noção familiar de realidade está se desfazendo, e o antigo paradigma científico já não é suficiente para explicar tudo.

Nesse estado vertiginoso, a própria obra de Amanda Askell se torna uma poderosa metáfora. Ela nos demonstra que, quando o poder computacional se aproxima de seus limites, questões éticas e morais inevitavelmente virão à tona.

Como estudante de doutorado pesquisando "ética infinita", Amanda entende que cada pequena ação tem o potencial de evoluir gradualmente para uma tempestade gigantesca ao longo do tempo infinito. É por isso que ela incorpora teorias morais complexas em uma única linha de perguntas e usa a ética com cuidado para proteger um modelo de linguagem grandioso e inanimado.

Isso pode parecer uma preocupação infundada, mas, como ela alertou, a IA não é apenas uma ferramenta, mas também um espelho que reflete a humanidade. Em um momento em que a tecnologia avança a passos largos e gradualmente "deixamos de entender o mundo", essa advertência filosófica talvez seja o esforço mais oportuno que podemos fazer diante da evolução tecnológica imprevisível.

#Siga a conta oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde você encontrará conteúdo ainda mais interessante o mais breve possível.