Desenvolva aplicativos em 30 segundos e escreva imagens e textos em tempo real: a Lingguang pretende remodelar os limites da criatividade com IA.

Existem muitas opções para ter um assistente de IA no seu celular, mas eles são ou como um "papagaio sofisticado" ou um mero transmissor de informações — quem sabe? O que eu quero é um assistente que realmente faça o trabalho, um "parceiro criativo" que não só fale, mas também aja.

Este ano, você provavelmente percebeu que a IA está evoluindo de simplesmente "falar" para "fazer". A OpenAI criou o Atlas, e o Gemini 3.0 do Google permitirá que a IA controle computadores diretamente… Todos estão trabalhando na mesma direção: transformar a fala em ação e o diálogo em comportamento.

A Ant Financial acaba de lançar um novo assistente de IA multimodal, o Lingguang. Ele não enrola: você fala, ele age, transformando seus pensamentos em algo que você pode ver, usar e interagir bem diante dos seus olhos.

Desde responder perguntas até expressar ideias, a IA também precisa de estética da informação.

A página inicial do Lingguang é uma janela de bate-papo familiar. Os usuários podem fazer solicitações usando linguagem natural, como "Diga-me as calorias desta bebida" ou "Registre sua ingestão de alimentos hoje", o que reduz bastante a curva de aprendizado e torna o aplicativo mais fluido do que os aplicativos tradicionais.

Ainda parece um bate-papo casual, não é? Na verdade, cada conversa que você tem com Lingguang é uma ação para ele. Aqui estão três exemplos da vida real que você provavelmente usará.

Recentemente, devido aos Jogos Nacionais, Guangzhou também tem recebido o tratamento de uma cidade turística popular, especialmente a Torre de Cantão, que está sempre rodeada de turistas. Perguntei a Lingguang: "O que há de tão especial no projeto arquitetônico da Torre de Cantão?". Ele não só forneceu uma explicação em texto, como também um modelo arquitetônico interativo em 3D.

O design interativo, que permite a rotação e o zoom para visualizar detalhes estruturais, proporcionou-me uma compreensão clara e intuitiva da estrutura de torção de dupla face da Torre de Cantão e do design oblíquo da malha do cilindro externo.

Em sua conversa com Lingguang, o aplicativo não apenas informa "qual" é a resposta, mas também permite que você veja "como" a resposta se parece. Texto, imagens e animações estruturais são integrados, fazendo com que toda a experiência de perguntas e respostas pareça uma "explicação em texto e imagens" gerada em tempo real e incorporada à conversa. Seja você um estudante de arquitetura, um entusiasta do urbanismo ou simplesmente alguém que deseja aprender mais sobre esse ponto turístico por curiosidade, ele realmente economiza muito tempo que seria gasto procurando, folheando páginas e reunindo informações.

Em seguida, fiz uma pergunta: "Você poderia planejar um roteiro gastronômico para mim nas proximidades?" O sistema imediatamente entendeu que "nas proximidades" significava Guangzhou e gerou um mapa interativo com zoom, marcando seis ou sete pequenas lojas com estilos diferentes e até mesmo uma "rota secreta". Era possível clicar em cada local para ver os motivos da recomendação, avaliações, horário de funcionamento e até mesmo estimar o trajeto a pé.

Incrível! Ele consegue gerar conteúdo interativo diretamente na tela do celular, o que é raro até mesmo em toda a indústria.

Se esses dois exemplos evocam sentimentos de "boa aparência e estilo", então o que estamos prestes a apresentar é a "beleza racional" de Lingguang.

Para um excelente assistente de IA de uso geral, simplesmente fazer e responder perguntas claramente não é suficiente. Ele precisa ser capaz de gerar resultados estruturados, o que significa que precisa de uma compreensão profunda e reorganização da semântica da informação — não apenas para recuperar informações, mas também para extrair pontos-chave, compreender a semântica de forma inteligente e realizar processamento hierárquico.

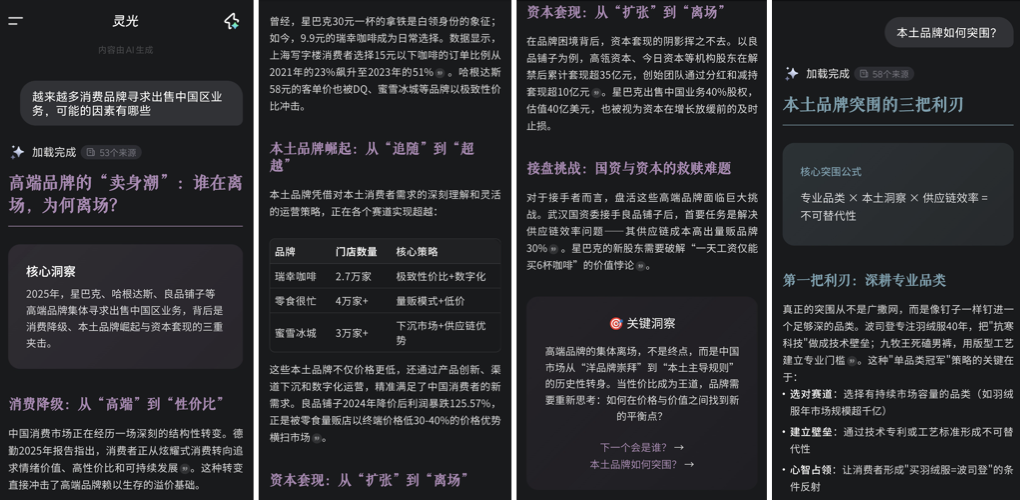

Por exemplo, ao se deparar com perguntas que exigem tanto uma perspectiva macro quanto uma análise micro, como "Por que as marcas de consumo estão vendendo suas operações na China/Por que o design de interface esqueumórfico está em declínio?", a resposta da Lingguang não se baseia em longos parágrafos de texto. Em vez disso, ela primeiro decompõe os fatores-chave — como mudanças no mercado consumidor, ciclo de vida da marca e pressão dos acionistas — e então organiza o conteúdo de acordo, formando uma estrutura explicativa clara de causa e efeito, logicamente progressiva.

Utilizar um formato de fichas com título e resumo, inseridos em um texto completo com imagem, evita a monotonia e também a natureza extensa e dispersa de relatórios em PowerPoint/web. Essa estrutura organizada não só é logicamente clara, como também apresenta visualmente uma "estética da informação": limpa, objetiva e com um ritmo agradável. Isso não apenas torna a absorção da informação mais eficiente, como também simula os métodos de organização de conteúdo de escritores experientes, fazendo com que a saída da IA se assemelhe mais a um conteúdo aprofundado e "compreensível", muito além de uma resposta superficial e "buscável".

Você provavelmente está se perguntando o tempo todo: como isso é possível? Como pode ser estruturalmente claro e visualmente atraente, ao mesmo tempo que permite interação em tempo real?

Quando Lingguang recebe uma pergunta, ativa um processo de criação de conteúdo centrado na geração de código . Sejam textos e imagens, mapas ou animações 3D, a camada subjacente consiste no modelo escrevendo o código, os estilos e os componentes correspondentes em tempo real, que são então montados e apresentados dinamicamente . Para realizar isso, não se trata de um único modelo grande trabalhando sozinho, mas sim de múltiplos agentes inteligentes colaborando : alguns lidam com as imagens, outros com o layout, outros recuperam as estruturas de dados… como blocos de construção.

Ele integra diferentes gêneros de conteúdo e se adapta a métodos comuns de apresentação, resultando em conteúdo extremamente natural. O efeito final também é mais adequado para encaminhamento, captura de tela e resumo em "conteúdo utilizável para o WeChat Moments" — ele contém tanto julgamento racional quanto transmite opiniões e emoções pessoais .

Crie seu próprio aplicativo em uma frase ou em 30 segundos.

Se a capacidade de criar diagramas e planejar rotas durante conversas já é incrível o suficiente, então a próxima funcionalidade é quase "mágica": basta digitar uma solicitação no teclado e o programa cria automaticamente um pequeno aplicativo para você.

A geração de aplicações usando agentes encontra-se atualmente numa situação um tanto problemática: muitas aplicações ficam presas num ponto de interrupção onde são "compreensíveis, mas não podem ser executadas". O "Flash Application" da Lingguang visa resolver esse problema, pois seu diálogo vai além das etapas de chamar e solicitar ferramentas, permitindo a geração direta de ferramentas.

Sim, não se trata de gerar um trecho de código, um protótipo ou uma sugestão, mas sim de gerar uma "ferramenta pronta para uso" instantaneamente. Colocar ideias em prática não é mais exclusividade de programadores; os aplicativos Flash podem oferecer a qualquer pessoa um ponto de partida para "criar coisas" manualmente.

Vejamos como isso facilita tanto a "concretização de ideias": Minha primeira tarefa foi: "Quero uma ferramenta que possa dividir textos longos em parágrafos menores."

Em apenas 30 segundos, uma pequena ferramenta que permite definir o número de parágrafos e segmentar arquivos automaticamente aparece. Você nem precisa abrir uma nova página; ela incorpora os resultados gerados diretamente no fluxo de diálogo, e você pode usá-la assim que a abrir.

Aqui está outro exemplo simples e prático: criar um tradutor de cardápios. A ideia principal é traduzir os nomes dos pratos em língua estrangeira para chinês, para que eu saiba o que são, e também ler os nomes em voz alta para que eu possa fazer o pedido facilmente.

Compreender texto, gerar linguagem, organizar interfaces e fornecer feedback sonoro — essas funcionalidades costumavam exigir vários componentes e talvez me obrigassem a explicar a lógica do código em detalhes. Agora, tudo isso pode ser feito em apenas uma linha.

Seja para pedir comida durante uma viagem ao exterior ou para praticar seu inglês falado e se familiarizar com nomes de pratos, esta pequena ferramenta está pronta para uso assim que gerada, proporcionando uma experiência verdadeiramente imediata e intuitiva. Por trás dela, existe uma estrutura completa de aplicação: ela não apenas gera páginas front-end, mas também utiliza os recursos de back-end de um modelo robusto. Além de fornecer o código, oferece design de interface gratuito. Módulos dinâmicos como tradução e síntese de voz estão todos integrados a esta pequena ferramenta.

Dessa forma, o produto resultante não é apenas uma demonstração , mas um produto real que pode interagir com os usuários em tempo real, responder a entradas e possui um ciclo lógico completo de front-end e back-end.

Em vez de perder tempo vasculhando toda a loja de aplicativos, é obviamente mais rápido e melhor usar um aplicativo Flash para criar uma pequena ferramenta perfeitamente adequada às minhas necessidades pessoais em um minuto. É flexível, instantâneo e não tem barreiras de entrada. Não é uma solução universal, mas uma solução temporária "personalizada para este momento", que ainda assim pode inspirar a satisfação psicológica da "criação" em pessoas comuns — mesmo aquelas sem conhecimento de desenvolvimento podem experimentar a alegria e o desejo de compartilhar "Eu criei um pequeno aplicativo" com apenas uma frase simples.

Atividades interativas com "olhos"

O vídeo em tempo real agora é um "recurso padrão" para assistentes de IA, e a Lingguang deu a essa função um nome bastante criativo: "Abrir os Olhos". É bem apropriado, já que não depende da digitação, mas sim da abertura da câmera, o que é como abrir os olhos da IA para receber outra linguagem natural: a linguagem visual.

Por exemplo, se você apontar seu telefone para uma xícara de chá com leite, a tela exibirá imediatamente sugestões dietéticas, precauções de armazenamento e várias perguntas adicionais para satisfazer sua curiosidade:

Essa funcionalidade é muito prática para alimentos e medicamentos. Seja para escolher algo para si mesmo ou comprar um produto novo para seus pais que eles não conhecem, essa funcionalidade é perfeita para você usar.

A característica única do OpenEye reside em sua tecnologia de reconhecimento em tempo real , que transcende o simples "reconhecimento de um objeto" e o transforma em um portal visual inteligente capaz de responder e dialogar. Ele pode compreender suas intenções potenciais a qualquer momento, iniciar proativamente ações subsequentes e transformar um único reconhecimento sob a lente em uma cadeia coerente de comportamentos.

Em comparação com as tecnologias de visão computacional mais antigas, que só conseguiam reconhecer logotipos ou produtos, esta deu um passo claramente mais longe: ela não apenas identifica o que algo é, mas também tenta entender por que você está olhando para aquilo e o que você pode precisar em seguida.

Em outras palavras, transforma a "câmera" em mais um canal de diálogo, um diálogo que guia a interação através da visão , verdadeiramente "abrindo os olhos": engajando-se na interação com os "olhos".

Isso devolve a todos o conceito de "criação".

A linguagem é código, e os requisitos são protótipos. O diálogo nunca é o objetivo final; seu verdadeiro valor reside em se tornar um gatilho para a produtividade. A inspiração rompe com o caminho tradicional de "pergunta-resposta-ação", transformando a própria linguagem no ponto de partida para as ferramentas. Ela torna o caminho de "Eu tenho uma ideia" para "Eu já fiz isso" mais curto e intuitivo.

Aplicativos que antes exigiam habilidades de programação, design e lógica de produto para serem criados agora podem ser gerados com uma única linha de linguagem natural. Pela primeira vez, pessoas comuns podem "produzir" diretamente uma ferramenta funcional, um cartão de conteúdo ou um fluxo interativo usando linguagem cotidiana, tornando-se essencialmente seus próprios gerentes de produto. Esse salto de "ser capaz de falar" para "ser capaz de criar" marca a abertura completa do limiar da produtividade.

Na próxima fase da indústria de IA, a competição não será mais sobre "quem tem o modelo mais robusto", mas sim sobre "quem consegue traduzir as capacidades em experiência do usuário". No início do ano, a DeepSeek liderou a onda de modelos de código aberto na China. Com o fim de 2025 se aproximando, vemos novas possibilidades para paradigmas de interação com IA na Lingguang. Ela demonstra, de forma muito concreta, um caminho crucial: do modelo subjacente de grande escala, passando pelas capacidades das ferramentas de nível intermediário, até chegar aos produtos de aplicação voltados para o usuário.

Desta vez, a pergunta "o que a IA pode fazer" finalmente se transformou de linguagem de laboratório em verbos cotidianos que os usuários podem usar . Transformou o "fazer" em "falar sobre isso" e devolveu o poder da "criação" a todos.

#Siga a conta oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde você encontrará conteúdo ainda mais interessante o mais breve possível.