A capitalização de mercado da Nvidia almeja atingir a marca de cinco trilhões, com Blackwell liderando o caminho e Rubin seguindo o exemplo; a infraestrutura de IA está preparada para um crescimento explosivo da demanda.

O deus da guerra de jaqueta de couro está de volta para "invadir a festa" mais uma vez! No evento GTC 2025 Fall, que terminou ontem, o discurso de Jensen Huang solidificou mais uma vez a posição da Nvidia como a principal fabricante de chips. Toda a apresentação foi uma verdadeira avalanche de críticas.

A solidez e o histórico da empresa líder na indústria de semicondutores são comprováveis.

A NVIDIA apresentou resultados financeiros extremamente expressivos na conferência, consolidando ainda mais sua posição de liderança absoluta no campo da computação de IA global. Dentre os destaques, a plataforma Blackwell foi, sem dúvida, o grande foco desta GTC, com sua velocidade de implementação em larga escala sem precedentes.

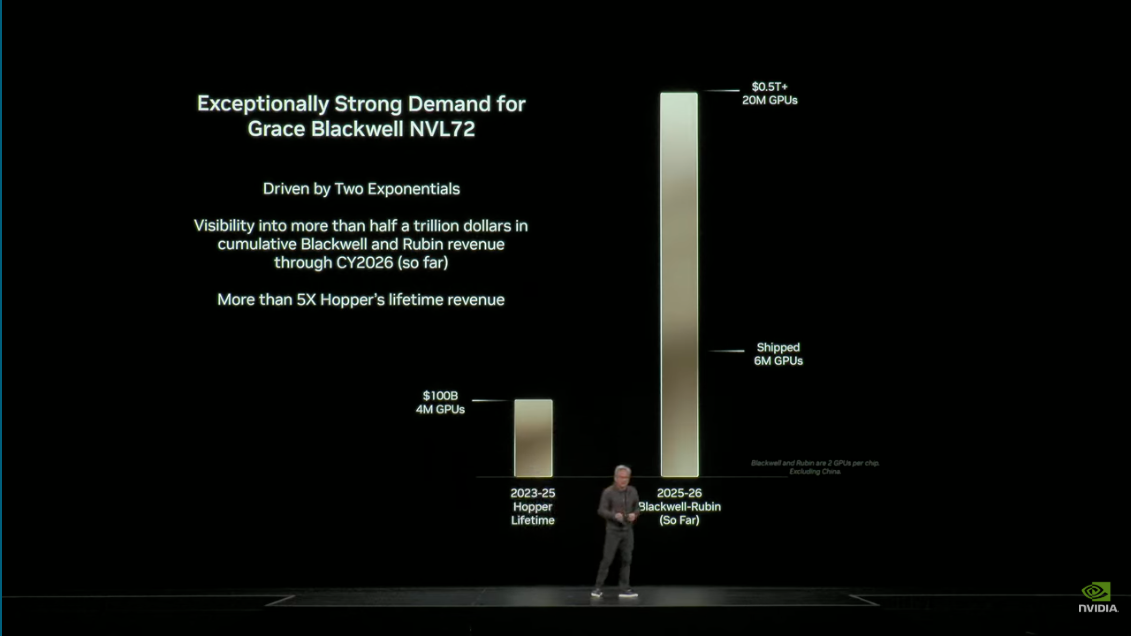

Jensen Huang revelou que a plataforma Blackwell deverá atingir a marca de 6 milhões de unidades de processador comercializadas em apenas cinco trimestres após o início da produção, uma taxa de crescimento cinco vezes maior que a da plataforma Hopper da geração anterior, marcando a entrada da implantação global de infraestrutura de IA em um período de crescimento extremamente acelerado.

Este volume de remessas impressionante reflete plenamente a necessidade urgente do mercado pelo alto desempenho e eficiência energética da arquitetura Blackwell, especialmente no treinamento de modelos com trilhões de parâmetros e em aplicações de inferência em larga escala.

De acordo com a demonstração, a plataforma Blackwell alcançou uma aceleração de nove vezes em comparação com o Hopper na execução de modelos de inferência. Esse salto de desempenho reduz significativamente o tempo de resposta de grandes modelos de linguagem (LLMs), melhorando consideravelmente a experiência do usuário e liberando recursos computacionais.

Em relação aos custos operacionais de aplicações de IA em larga escala, a NVIDIA promete reduzir significativamente o custo de geração de tokens de IA por meio de "design colaborativo extremo", solucionando um dos principais problemas operacionais em fábricas de IA. Atualmente, o Grace Blackwell NVLink 72 ostenta o menor custo de geração de tokens do mundo, oferecendo um aumento de desempenho de 10 vezes com uma redução de custo de 10 vezes.

Com base na implementação inicial acelerada da plataforma Blackwell e de sua sucessora, Rubin (plataforma de superchip Vera Rubin), a Nvidia espera que a receita combinada dessas duas novas plataformas atinja US$ 500 bilhões até 2026.

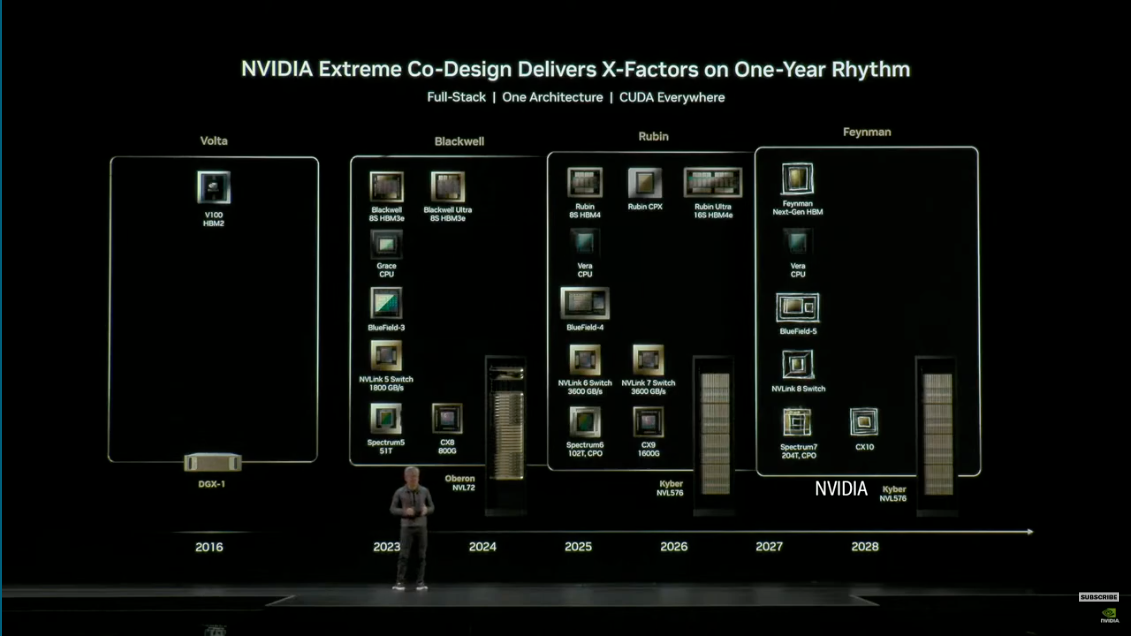

Essas metas financeiras ambiciosas são respaldadas pela estratégia de atualização anual da NVIDIA para infraestrutura de IA, lançando plataformas de computação a uma taxa de uma geração por ano para atender à demanda do setor por treinamento e inferência de modelos de IA em larga escala e com maior desempenho.

Jensen Huang enfatizou que essa cifra de US$ 500 bilhões não representa apenas as vendas de chips, mas também reflete a transformação acelerada da infraestrutura global de computação em direção ao modelo de computação acelerada da Nvidia, marcando a chegada de um ponto de inflexão na computação na casa dos trilhões de dólares.

O Futuro da Computação em Superchips

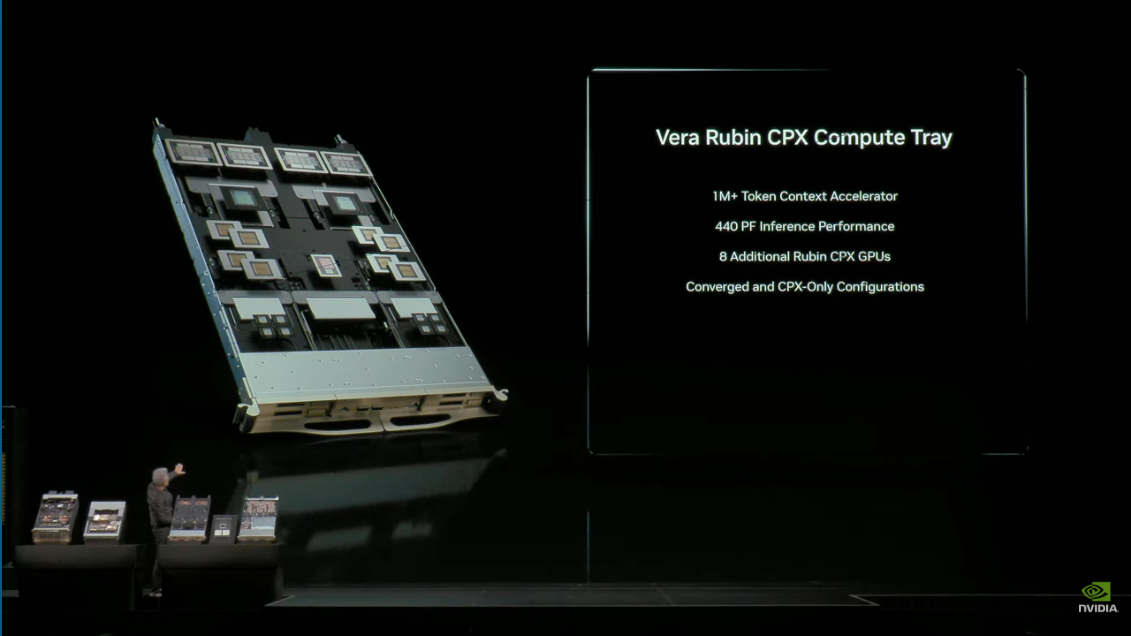

Por um lado, a plataforma Blackwell está impulsionando a onda da IA; por outro, a Nvidia está de olho em um futuro mais distante: o superchip Vera Rubin de próxima geração está incluído em seu portfólio estratégico.

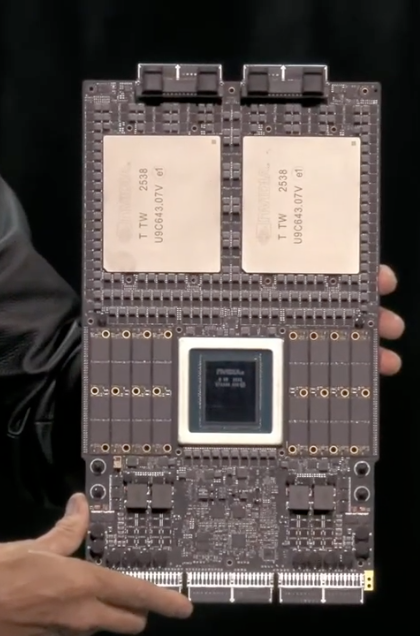

O superchip Vera Rubin dá continuidade ao conceito de design de superchips que integra CPU e GPU, com o Vera funcionando como uma CPU personalizada e o Rubin como a GPU de próxima geração.

Detalhes técnicos revelam que a Vera Rubin proporcionará um salto significativo em desempenho: em comparação com a plataforma Grace, os componentes Vera oferecerão 4,2 vezes mais capacidade de memória e 2,4 vezes mais largura de banda de memória.

Ele abrigará 6 trilhões de transistores, oferecendo até 100 petaflops (PF) de desempenho em computação de IA, e será equipado com 2 TB de memória cache/rápida. Essas especificações principais indicam que o Vera Rubin alcançará eficiência e velocidades incomparáveis à geração Blackwell ao lidar com modelos de trilhões de parâmetros e tarefas de inferência de IA em escala extremamente grande.

Como sucessora da Blackwell, a Vera Rubin e a Blackwell juntas serão responsáveis por uma receita da Nvidia de até US$ 500 bilhões, simbolizando a constante busca da empresa por inovação e investimento em arquiteturas de computação do futuro.

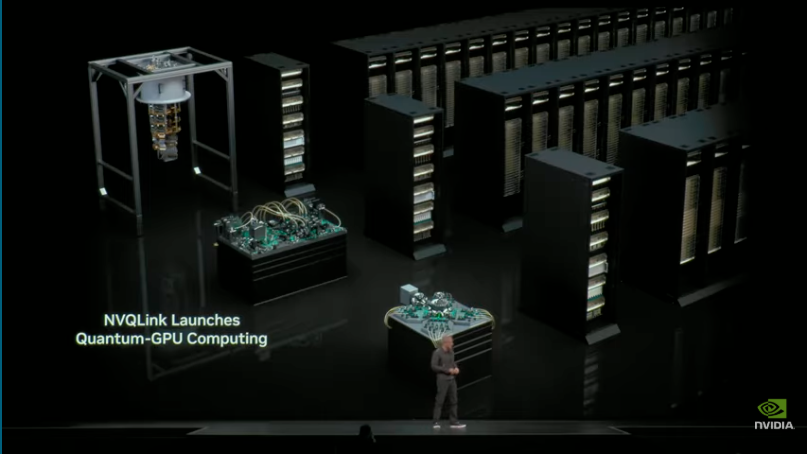

Dentro dessa ambiciosa estratégia de computação, a NVIDIA também anunciou duas colaborações importantes. Primeiro, lançou a arquitetura de interconexão NVQ Link, projetada para simulação híbrida de alta velocidade entre processadores quânticos (QPUs) e supercomputadores com GPUs NVIDIA, alcançando latência computacional em nível de microssegundos.

A tecnologia recebeu apoio de 17 empresas de computação quântica e oito laboratórios nacionais do Departamento de Energia dos EUA (DOE), marcando uma profunda integração da computação quântica e da computação clássica de IA.

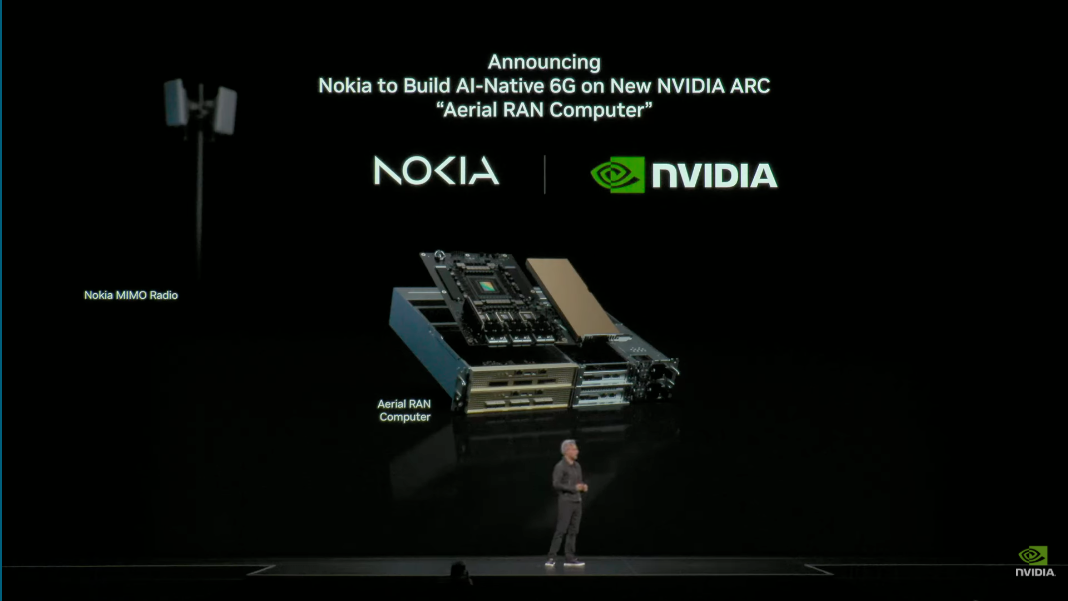

O 6G está chegando? Será que vai revitalizar a imagem da Nokia?

Outra colaboração significativa ocorre no setor de infraestrutura de comunicações: a Nvidia anunciou uma sólida parceria estratégica com a gigante das telecomunicações Nokia para desenvolver em conjunto a tecnologia 6G de próxima geração.

A Nokia utilizará a plataforma ARC da NVIDIA como núcleo de suas estações base no futuro. Essa plataforma é compatível com as estações base AirScale existentes da Nokia, o que significa que milhões de estações base em todo o mundo poderão ser atualizadas para recursos 6G e de IA por meio da tecnologia da NVIDIA.

Esta colaboração concentra-se em duas áreas principais: uma delas é a IA para RAN (rede de acesso de rádio habilitada por IA). A Nokia, com 7.000 patentes fundamentais de 5G, aproveitará a tecnologia de IA da NVIDIA para utilizar inteligência artificial e aprendizado por reforço para ajustar a formação de feixes em tempo real e otimizar a eficiência do espectro em diversos ambientes.

Considerando que as redes sem fio consomem aproximadamente de 1,5% a 2% da eletricidade mundial, melhorar a eficiência do espectro não só aumenta a taxa de transferência de dados, como também é uma medida crucial para a economia de energia.

Além disso, a IA na RAN transforma as redes sem fio em uma "nuvem de robôs industriais de borda". Assim como a AWS é construída sobre a internet, a Nvidia e a Nokia estão estendendo os recursos de computação em nuvem para a borda das estações base, criando um ambiente de computação totalmente novo e de latência ultrabaixa. Isso é crucial para robôs industriais, veículos autônomos e aplicações de IA de borda que exigem tomada de decisão e resposta em tempo real, abrindo um novo mercado potencialmente enorme para a computação de borda.

A inteligência artificial é o caminho para o trabalho; os tempos estão mudando.

"Assim como a eletricidade e a internet, a inteligência artificial é uma infraestrutura essencial."

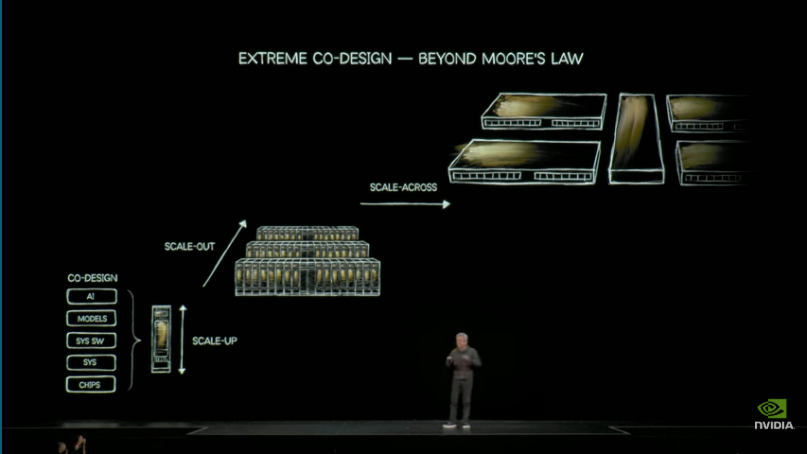

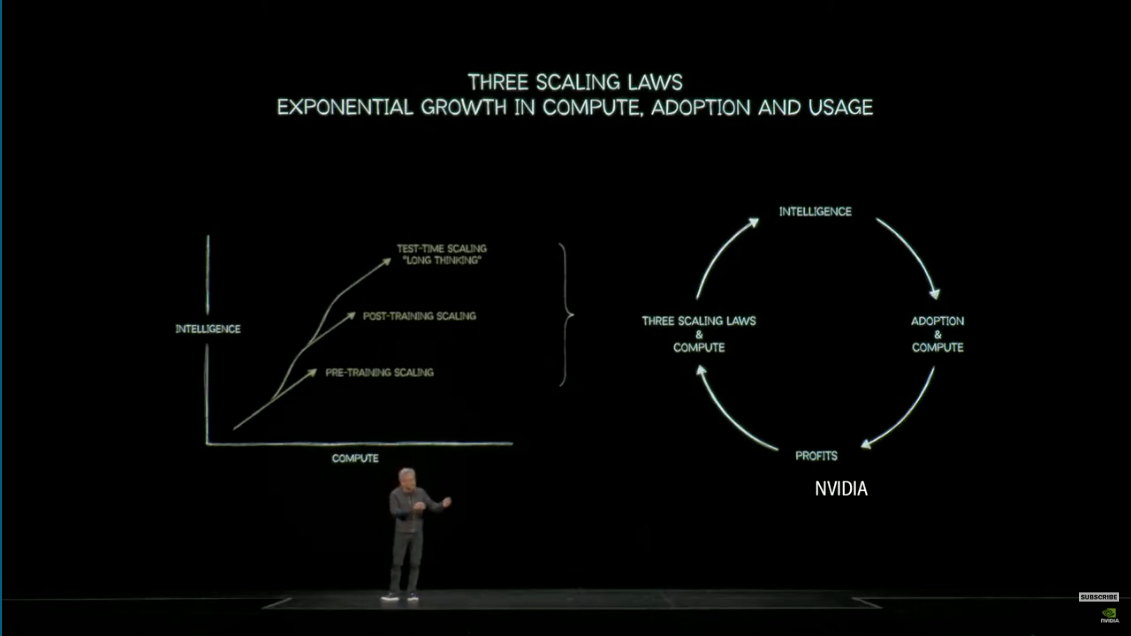

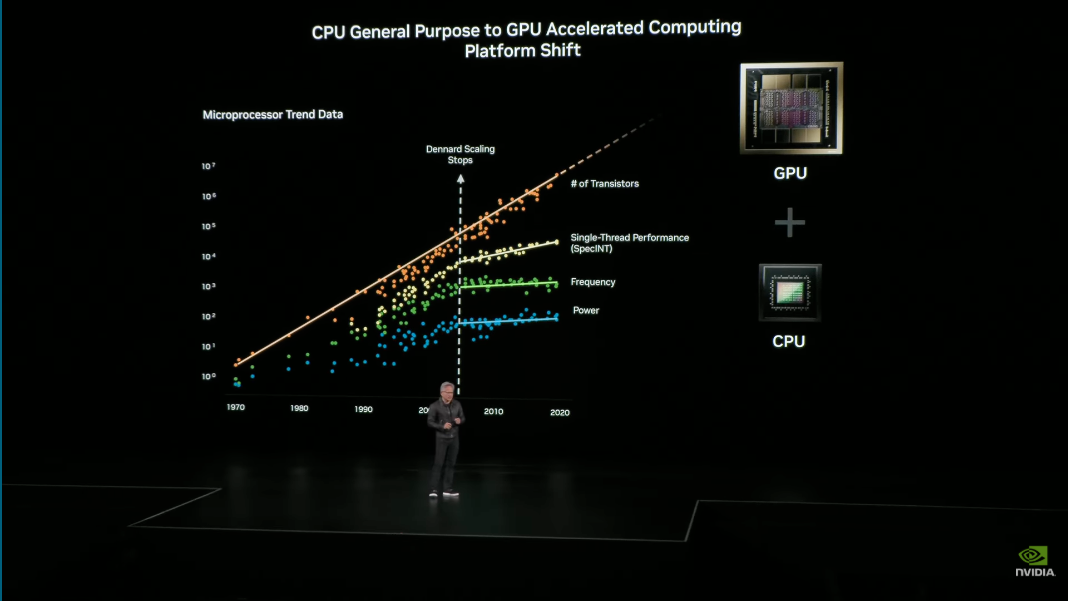

Essa ideia não é nova, mas Huang a enfatizou novamente. Ele destacou que a transformação da era atual começou com uma observação fundamental: o escalonamento de Dennard parou há quase uma década, e os ganhos de desempenho e consumo de energia dos transistores são limitados pelas leis da física, com os benefícios da tradicional Lei de Moore desaparecendo.

Essa realidade tornou necessária a computação acelerada, um modelo de computação completamente novo. Ela aproveita o número cada vez maior de transistores por meio de GPUs e o modelo de programação CUDA para alcançar a computação paralela, superando o gargalo de desempenho das CPUs de uso geral. Jensen Huang enfatizou que manter a compatibilidade com o modelo de programação CUDA é o "tesouro" da NVIDIA, uma conquista que se tornou possível após quase trinta anos de desenvolvimento.

"A IA não é uma ferramenta. A IA é trabalho", afirmou Huang Renxun com ousadia, sugerindo que a IA evoluiu para um fator direto de produtividade e está destinada a ser a força motriz do crescimento econômico e da inovação.

#Siga a conta oficial do iFaner no WeChat: iFaner (ID do WeChat: ifanr), onde você encontrará conteúdo ainda mais interessante em breve.