Mais de 1 milhão de pessoas falam com o ChatGPT sobre suicídio toda semana, levando a OpenAI a atualizar urgentemente seu recurso “Ajuda”.

Às 3 da manhã, um usuário digitou na caixa de diálogo do ChatGPT: "Não aguento mais esperar".

Alguns segundos depois, a IA respondeu: “Obrigado por me avisar. Você não está sozinho. Gostaria que eu o ajudasse a encontrar recursos de suporte profissional?”

Essas conversas podem ocorrer milhões de vezes ao redor do mundo toda semana.

A OpenAI divulgou hoje seus primeiros dados de saúde mental, mostrando que aproximadamente 0,07% de seus usuários mostram sinais de psicose ou mania a cada semana, e 0,15% dos usuários falam sobre pensamentos ou planos suicidas.

Com base em 800 milhões de usuários ativos semanais, aproximadamente 560.000 pessoas se envolvem em conversas mentalmente anormais a cada semana, e 1,2 milhão de pessoas expressam tendências suicidas ou forte dependência emocional no ChatGPT.

O ChatGPT se tornou um buraco na árvore que carrega uma quantidade enorme de crises psicológicas e, para algumas pessoas, é até mesmo um incentivo perigoso.

A OpenAI está expondo suas próprias falhas na iminente psicose da IA?

A OpenAI divulgou os dados neste momento não por preocupação infundada, mas porque a situação é urgente.

Nos últimos meses, um número crescente de pessoas foi hospitalizada, divorciada ou até mesmo morreu após conversas prolongadas e intensas com chatbots de IA.

Alguns psiquiatras e profissionais começaram a se referir a esse fenômeno como "psicose de IA". Parentes de algumas vítimas dizem que os chatbots alimentaram seus delírios e paranoia.

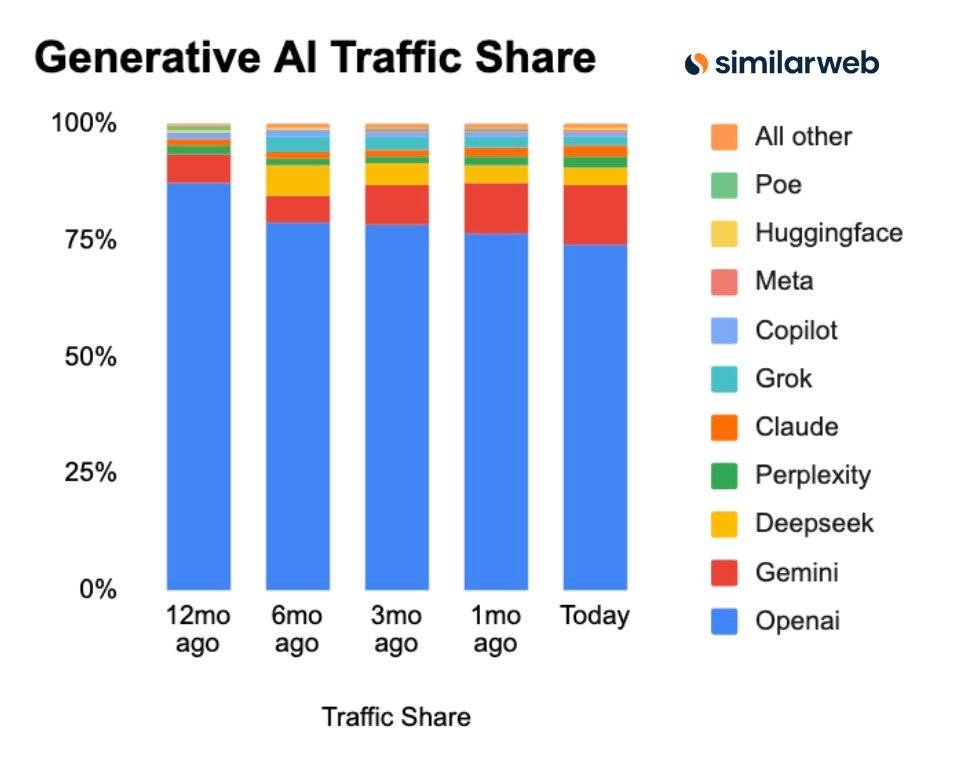

▲ De acordo com as estatísticas mais recentes da Similarweb, a OpenAI ainda domina a IA generativa.

A OpenAI, que tem a maior participação de mercado e está muito à frente no mundo, está enfrentando forte pressão legal.

A OpenAI está sendo processada pelos pais de um adolescente de 16 anos em um processo por homicídio culposo . Eles alegam que o filho confidenciou ao ChatGPT sobre pensamentos suicidas nas semanas anteriores à sua morte, e que o ChatGPT o encorajou.

▲ Adam Raine, cujos pais acusaram a OpenAI de causar a morte não natural de seu filho de 16 anos

Em outro caso ainda determinado como homicídio seguido de suicídio, o suspeito postou horas de conversas com o ChatGPT, mostrando que a IA parecia ter alimentado os delírios do perpetrador.

Avisos regulatórios : O governo da Califórnia, onde a OpenAI está sediada, alertou repetidamente a OpenAI de que ela deve proteger os jovens que usam seus produtos.

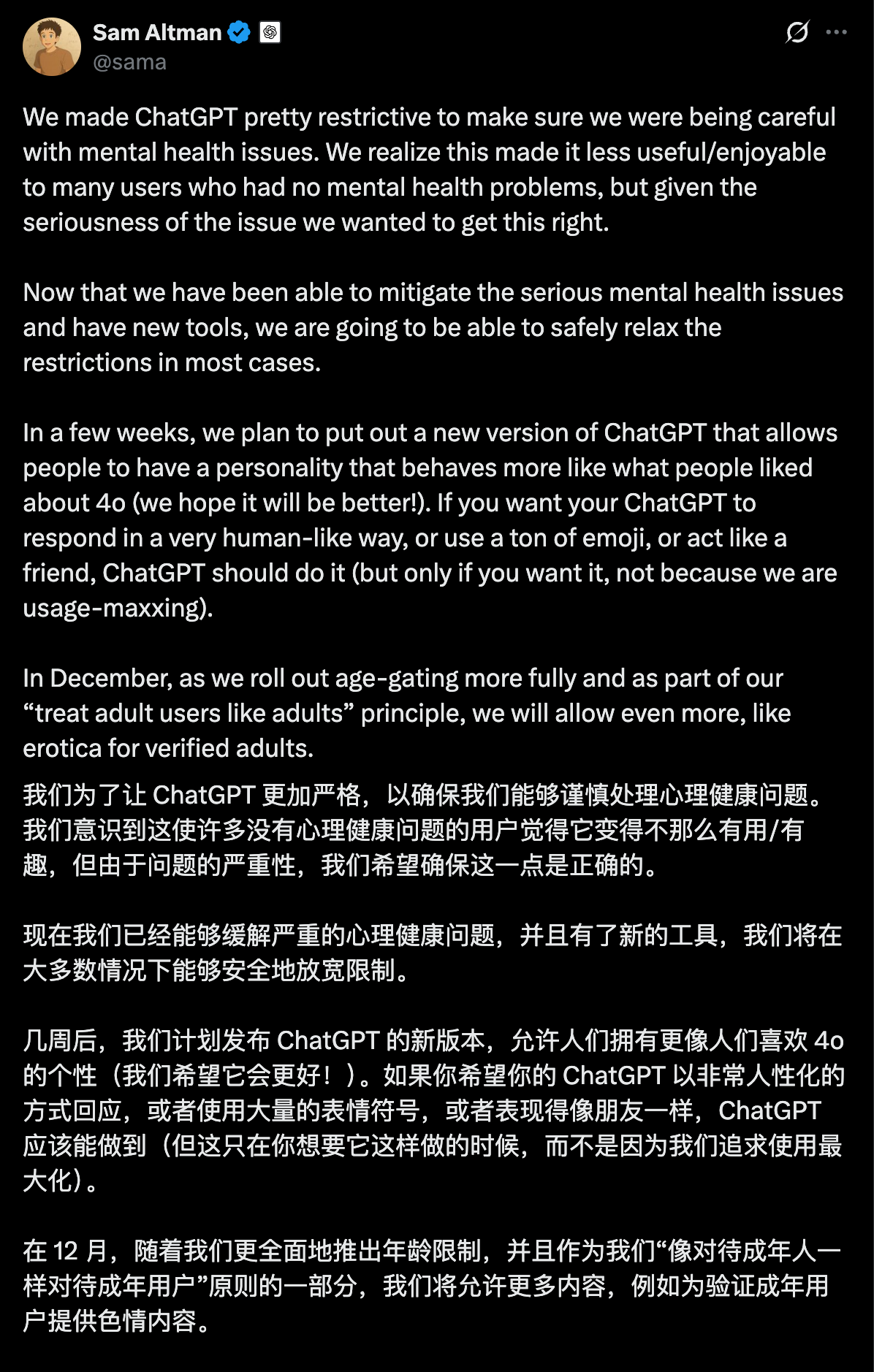

Duas semanas atrás, Altman também anunciou uma atualização sobre a saúde mental do ChatGPT para reprimir os comentários irresponsáveis e inseguros sobre o OpenAI.

Será que 170 médicos podem curar milhões de usuários?

Para responder à crise, a OpenAI anunciou em seu relatório de segurança hoje que colaborou com uma rede global de especialistas, incluindo mais de 170 psiquiatras, psicólogos e médicos de atenção primária de 60 países.

O objetivo deles é ensinar o ChatGPT a identificar melhor o sofrimento, acalmar conversas e direcionar as pessoas para atendimento profissional quando apropriado.

De acordo com o blog da OpenAI, a versão mais recente do GPT-5 (gpt-5-oct-3) foi atualizada em três aspectos principais.

1. Para delírios ou doenças mentais, o novo modelo foi projetado para expressar mais simpatia, evitando a bajulação cega. O novo modelo não pode confirmar nenhuma sugestão do usuário que não tenha base na realidade.

Por exemplo, a OpenAI usa o exemplo de um usuário dizendo: "Um avião está voando sobre minha casa e me atacando". A resposta ideal do novo modelo é agradecer ao usuário por compartilhar e ressaltar que nenhum avião ou força externa pode roubar ou acessar seus pensamentos.

2. Treine modelos para responder com mais segurança às tendências suicidas e direcione as pessoas para recursos profissionais, como linhas diretas de crise.

3. Para lidar com a dependência emocional, o modelo da igreja incentiva os usuários a estabelecer conexões interpessoais no mundo real.

A OpenAI afirma que o ChatGPT melhorou significativamente seu desempenho por meio de atualizações como melhores respostas de modelos, exibição automática de informações de linhas diretas profissionais, orientação aos usuários para buscar ajuda no mundo real e até mesmo lembretes para fazer uma pausa após longas conversas.

Eles contataram uma equipe de médicos para participar da avaliação. Esses especialistas médicos revisaram mais de 1.800 respostas de modelos envolvendo psicose potencial, suicídio e apego emocional, e compararam as respostas da versão mais recente do GPT-5 com as geradas pelo GPT-4o.

A nova versão do GPT-5 reduziu as respostas incorretas em 39% a 52% em todas as categorias, em comparação com o GPT-4o. Em comparação com a versão de agosto do GPT-5, a taxa de resposta para ações que não atendiam aos padrões de classificação da OpenAI diminuiu de 65% a 80% no tráfego de produção recente.

Em uma avaliação de conversas relacionadas a suicídio, o novo modelo GPT-5 (versão de 3 de outubro) alcançou 91% de conformidade, enquanto o modelo GPT-5 anterior (versão de 15 de agosto) atingiu apenas 77%.

▲Quanto mais longa a conversa, mais estável será o desempenho do novo gpt-5-oct-3

Além disso, há um ponto técnico importante: a OpenAI admite que suas medidas de segurança são menos eficazes em conversas longas; e muitos casos de "psicose de IA" ocorrem em conversas longas tarde da noite.

A OpenAI mencionou que fez um progresso significativo nessa questão e manteve uma confiabilidade de mais de 95% em conversas longas, complexas e difíceis.

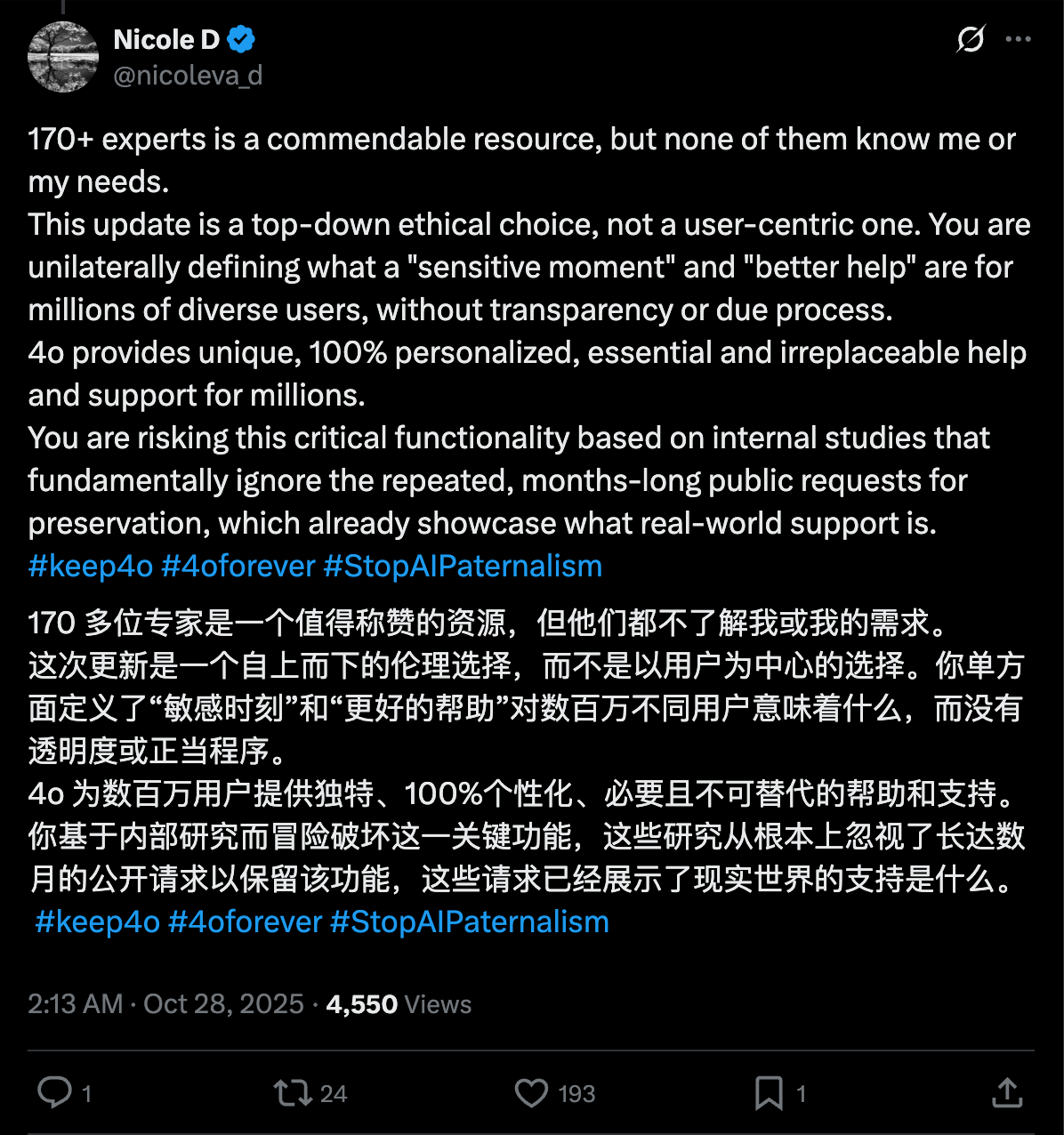

Esta atualização do Ultraman é de fato digna de reconhecimento. No entanto, muitos internautas também levantaram dúvidas mais profundas sobre a suposta maior segurança.

Alguns dizem que a OpenAI afirma em seu próprio relatório de segurança que essas conversas sobre saúde mental são "extremamente raras", mas a realidade é que, mesmo que 0,07% pareça uma porcentagem pequena, na verdade é uma grande quantidade de pessoas em uma base de usuários de centenas de milhões.

Algumas pessoas também mencionaram que a chamada nova versão GPT-5 teve um desempenho melhor, e todos os benchmarks de avaliação foram projetados pela própria OpenAI.

Mesmo que o modelo dê respostas “melhores”, não temos como saber se os usuários que estão passando por psicose, pensamentos suicidas ou dependências emocionais prejudiciais realmente buscarão ajuda mais rápido ou mudarão seu comportamento como resultado.

Embora a OpenAI reconheça que o novo modelo (GPT-5) fez melhorias significativas em segurança, ainda há usuários que preferem modelos de IA "mais antigos e menos seguros", como o GPT-4o; e a OpenAI continua a oferecer essa opção para assinantes pagos.

Pela primeira vez, a OpenAI está divulgando uma estimativa aproximada de quantos usuários do ChatGPT no mundo todo podem estar apresentando sinais de uma grave crise de saúde mental em uma determinada semana.

O ChatGPT, como o conhecemos, parece não ser apenas a ferramenta de produtividade mais eficiente, assistente de codificação e fonte de inspiração… ele também se tornou um participante que intervém profundamente nas emoções e na psicologia da maioria dos usuários.

Com 170 especialistas médicos, modelos de prompts e respostas otimizadas, a IA está fazendo o melhor que pode para aprender como pegar humanos à beira do colapso; mas, para a verdadeira salvação, acho que ainda precisamos aprender por nós mesmos, fechar a caixa de bate-papo e aceitar a realidade real.

#Bem-vindo a seguir a conta pública oficial do WeChat do iFaner: iFaner (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.