Depois de usar esta sequência espiritual do Google Camera, sinto que a fotografia com celular deveria ser assim

Seis anos atrás, comecei minha jornada como fotógrafo quando embarquei em um Airbus 320 da IndiGo para a Índia com minha câmera Sony na mão.

Hoje, seis anos depois, a fotografia feita por celulares está cobrindo o campo da imagem tradicional em uma velocidade extraordinária, e a linha de produtos do mercado de câmeras está gradualmente convergindo para ferramentas úteis em campos profissionais ou itens de moda.

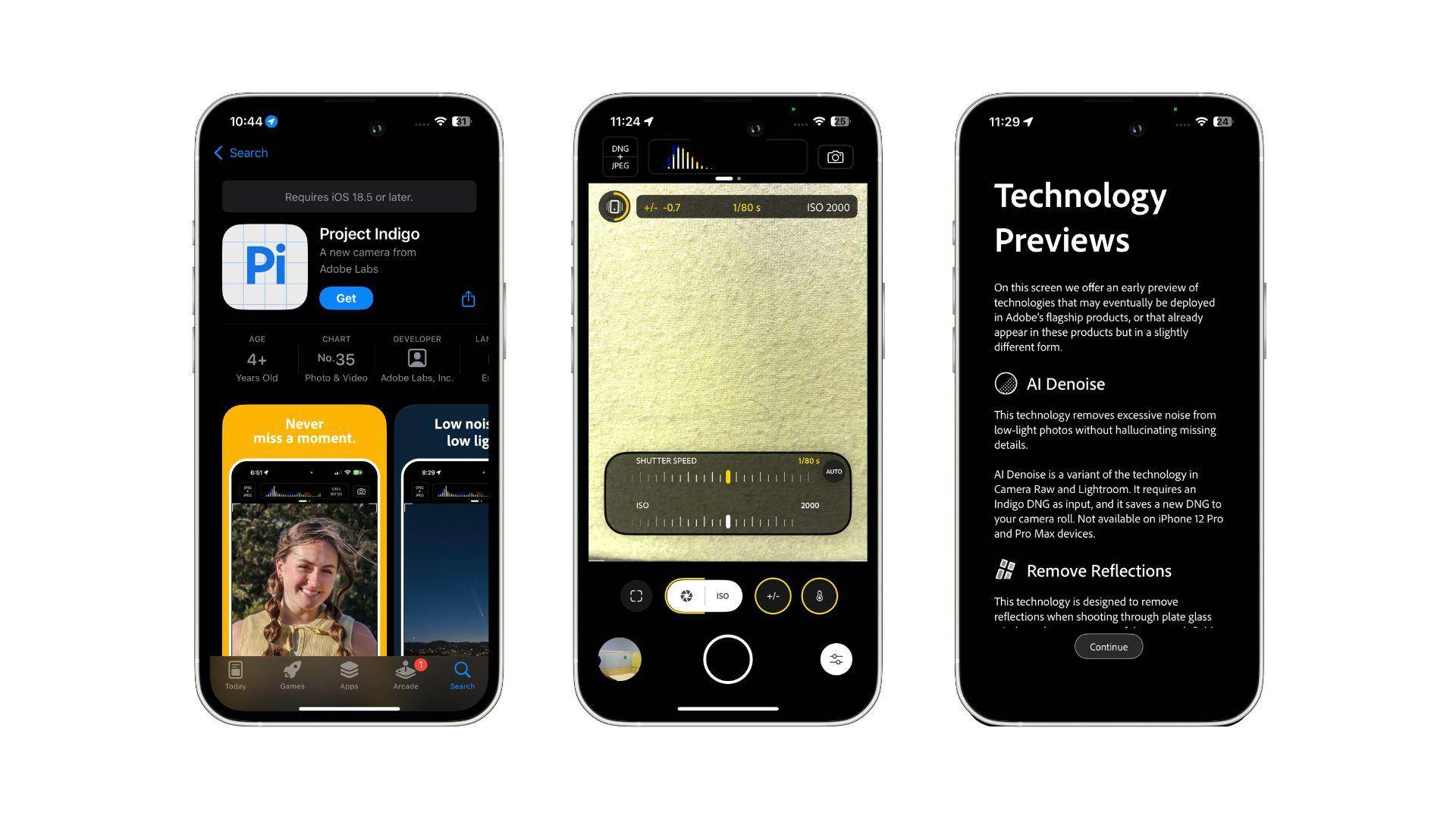

Nessa época, outro "Indigo" chamou minha atenção: o Projeto Indigo da Adobe, um aplicativo de imagem completamente diferente.

Ele traz a aclamada experiência de fotografia computacional do Google Camera para o iPhone em sua forma original, permitindo-me ter uma ideia de quão poderoso é o limite máximo da fotografia computacional.

Um aplicativo de câmera à prova do futuro, mas uma prévia

Se você der uma olhada rápida, pode ser difícil perceber que este é um aplicativo de imagens.

O ícone do aplicativo do Projeto Indigo não possui nenhum elemento gráfico. Em vez disso, ele segue o esquema de design usual da Adobe, colocando as primeiras letras das duas palavras do nome no ícone, e a imagem base é uma grade de 16 quadrados emoldurada por linhas azuis.

Ao entrar no Projeto Indigo (doravante denominado Indigo), a primeira coisa que você vê é a interface familiar de solicitação de permissão. Este aplicativo de imagens requer um total de três permissões:

- Permissões de controle de câmera

- Permissões de acesso ao álbum

- Permissões de informações de localização

A falta de direitos de acesso ao microfone indica que o Projeto Indigo é um aplicativo que atende exclusivamente a imagens estáticas, e a gravação de vídeos, que está mais de acordo com as tendências da Internet, não é seu foco.

Após a conclusão do pedido de permissão, o Indigo mostrará a interface principal e as funções deste aplicativo de imagens. Ignoramos essa etapa e vamos diretamente para a interface principal do aplicativo.

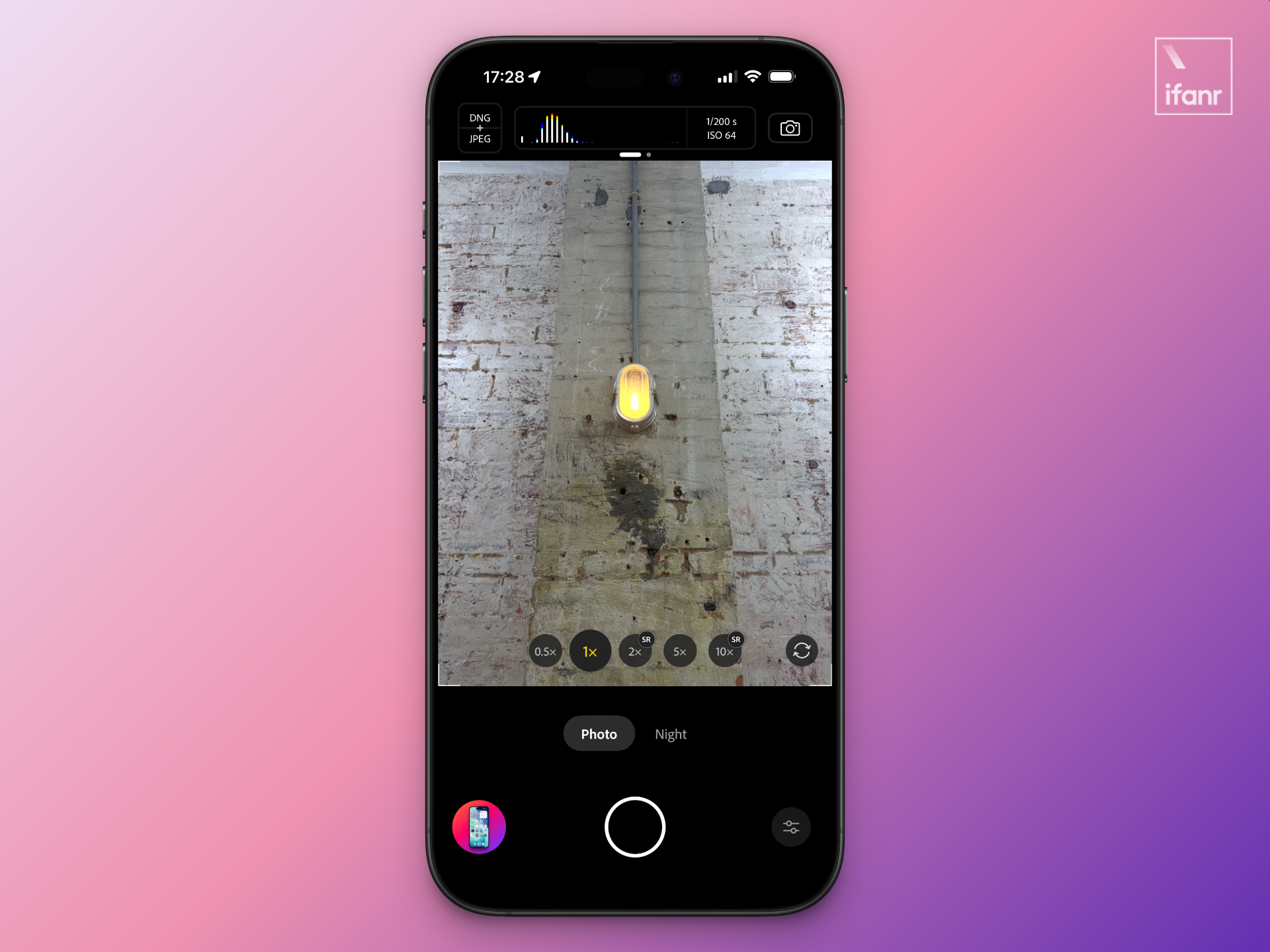

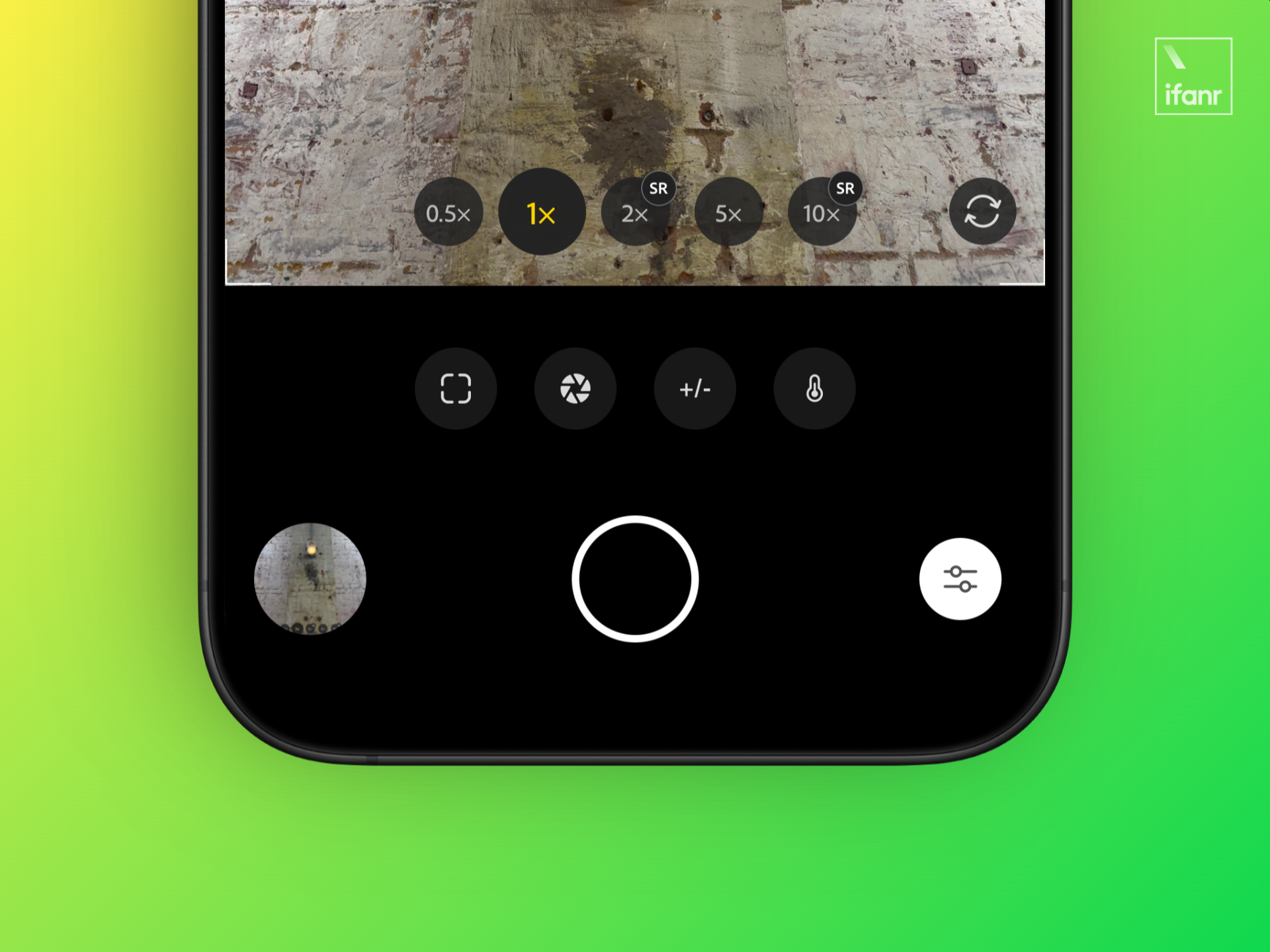

A interface principal de disparo do Project Indigo não segue o design do iOS 26, mas fornece o máximo de informações e controles possível, permitindo que os operadores tenham o máximo controle sobre seus efeitos fotográficos.

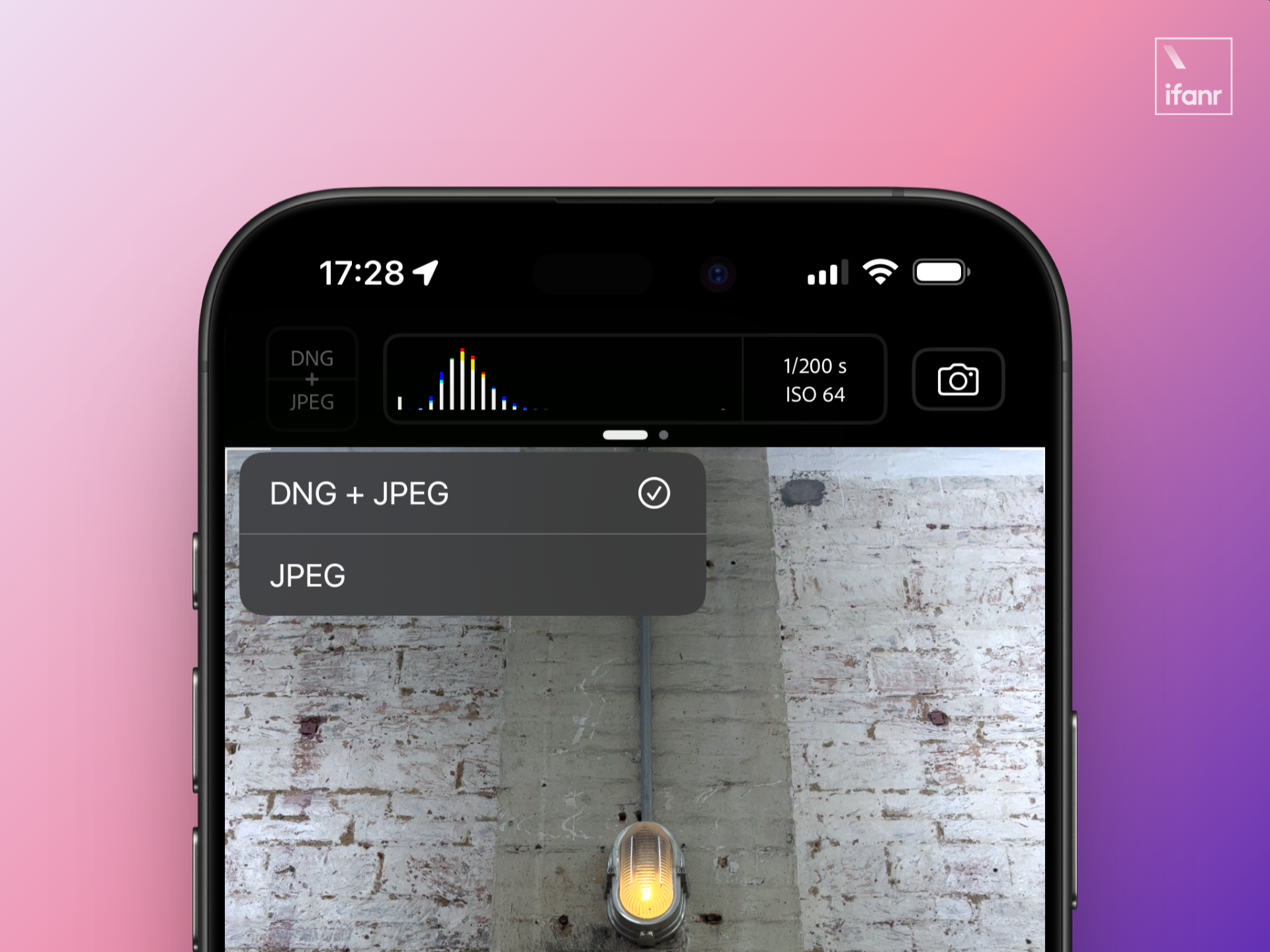

Começando pelo topo, ele é dividido em três partes: formato da imagem, histograma, parâmetros de exposição e modo de disparo. O formato da imagem permite que você escolha tirar fotos no formato JPEG ou DNG+JPEG.

O formato JPEG é um formato de divulgação comum, adequado para publicação direta na Internet ou nas redes sociais após a captura, enquanto o último é uma foto no formato RAW que registra informações detalhadas da imagem, o que pode fornecer um enorme espaço de pós-produção e não é adequado para divulgação direta.

O histograma e os parâmetros de exposição na parte superior central mostram claramente a exposição atual no visor e a combinação de velocidade do obturador e sensibilidade. Esta parte também pode ser deslizada para acessar o menu secundário. Neste menu, você pode controlar alguns controles auxiliares de enquadramento e disparo, como contagem regressiva, grade do visor, nível ou indicador de superexposição de realce. Você também pode acessar todas as configurações do aplicativo Indigo aqui.

À direita, o modo de disparo atual. As configurações de modo do Indigo não são complicadas e são divididas em apenas dois modos: foto e cena noturna.

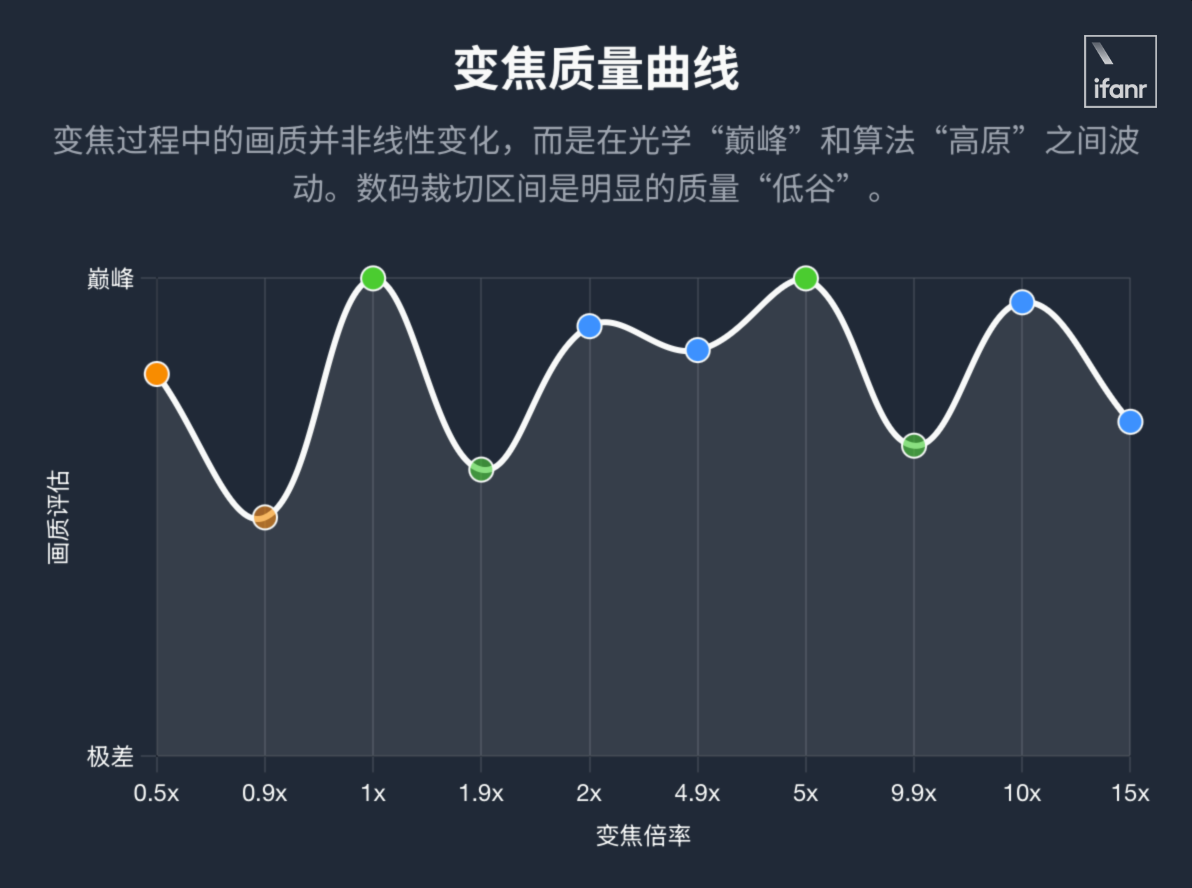

Voltando o olhar para a metade inferior da tela, na parte inferior do visor, está a conhecida barra de seleção de distância focal. Tomando meu iPhone 16 Pro como exemplo, o Indigo oferece cinco opções: 0,5×, 1×, 2×, 5× e 10×.

É bastante evidente que a palavra SR esteja marcada nas duas distâncias focais, 2× e 10×. No manual oficial, podemos descobrir que o nome completo de SR é Super-resolução Multi-frame. A 2×, baseada na câmera principal 1×, e a 10×, baseada na 5×, obterão clareza comparável à das distâncias focais ópticas com o suporte desta tecnologia.

Como o nome sugere, o princípio técnico por trás da tecnologia de super-resolução multiquadro é que, após pressionar o obturador, o telefone tira instantaneamente um número considerável de fotos e, em seguida, usa um certo algoritmo para mesclar dezenas de fotos e gerar fotos cheias de detalhes ricos e baixo ruído.

▲ Isso é muito constrangedor, a imagem é de Xiaohongshu @KERICH誠

Em testes reais, descobri que a tecnologia de super-resolução multiquadro funciona de 2× a 4,9×, e o mesmo vale para 10× e acima.

Ou seja, no Projeto Indigo, as tarefas de geração de imagens de cada distância focal são ainda mais divididas:

- 0,5×-1×: Corte digital baseado em lente ultra grande angular nativa;

- 1×-1,9×: corte digital baseado na câmera principal nativa;

- 2×-4,9×: Corte óptico baseado em tecnologia de super-resolução multiquadro;

- 5×-9,9×: corte digital baseado na lente telefoto nativa 5×;

- 10× e acima: Corte quase óptico baseado em tecnologia de super-resolução multiquadro.

Depois de observar o deslumbrante layout de distância focal, voltamos nossa atenção para a parte inferior. Os modos de foto e cena noturna estão posicionados horizontalmente entre o layout de distância focal e o botão do obturador. Aqui, você pode alternar rapidamente entre os dois modos para lidar com diferentes cenas de disparo. No entanto, há uma duplicação aqui com o seletor de modo no canto superior direito, o que parece ser um desperdício de espaço na interface do usuário.

Mais abaixo, está o botão do obturador mais importante. À esquerda do botão do obturador, está o álbum onde as fotos tiradas serão colocadas para posterior fusão. Você pode ver aqui que várias fotos estão sendo fundidas no fundo. Você também pode acessar o Lightroom a partir daqui para mais edições de fotos.

O lado direito é o modo manual mais profissional, onde você pode personalizar parâmetros que afetam diretamente a imagem final, como temperatura da cor, distância do foco, velocidade do obturador e sensibilidade.

Depois de ler o layout da página, fiquei muito curioso sobre o desempenho real de filmagem do Projeto Indigo e para ver que entendimento diferente essa antiga empresa focada no campo de imagens tem sobre imagens móveis.

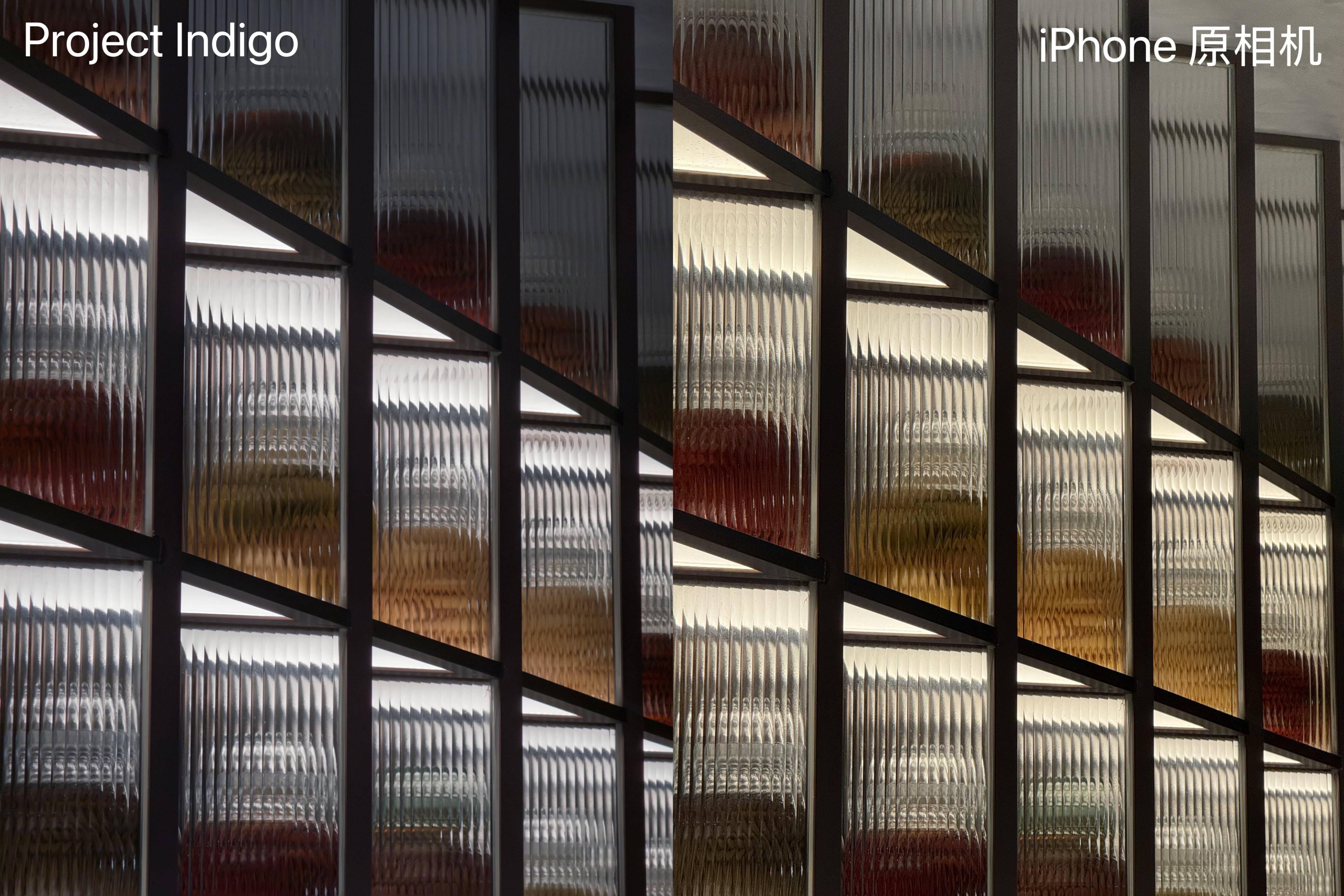

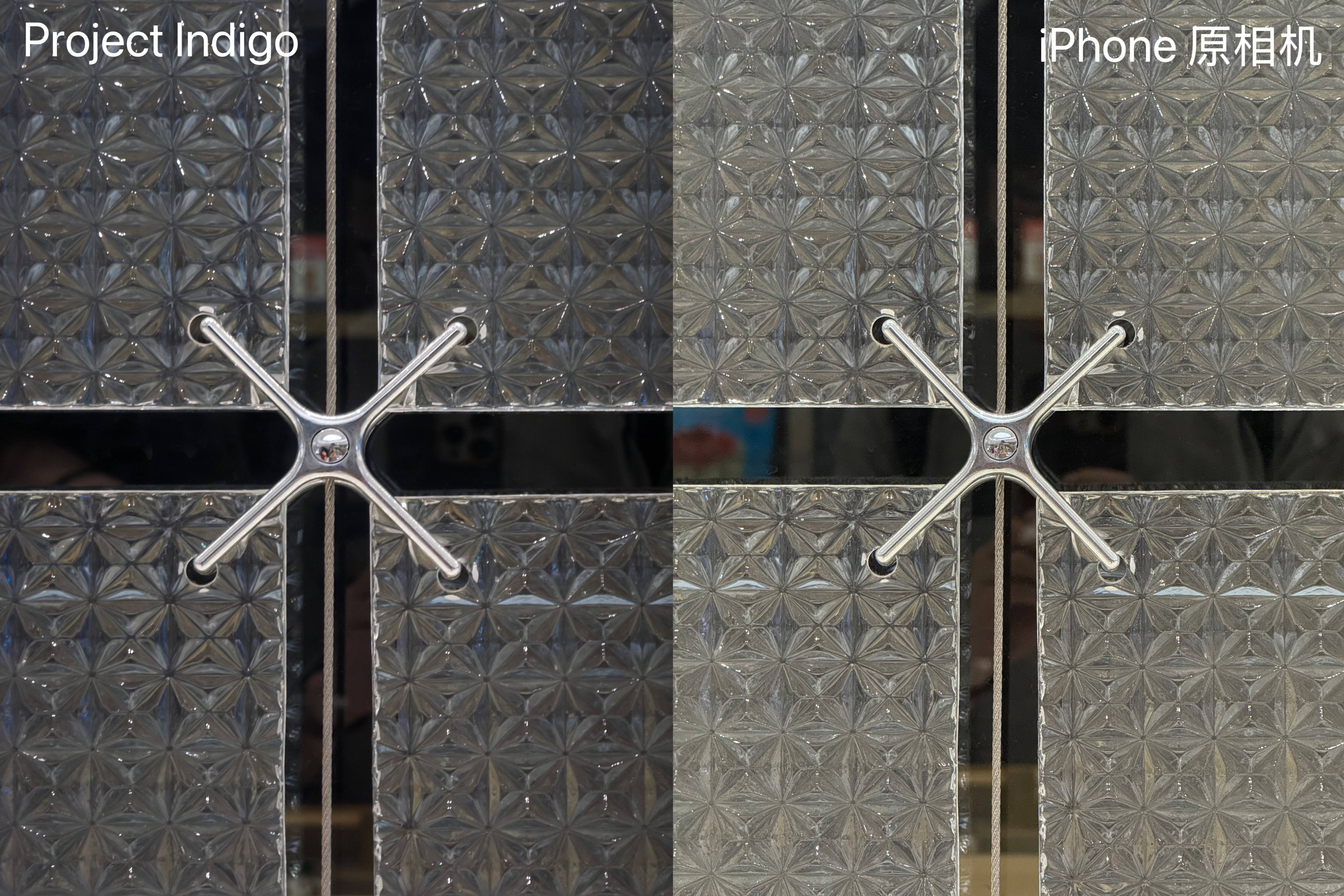

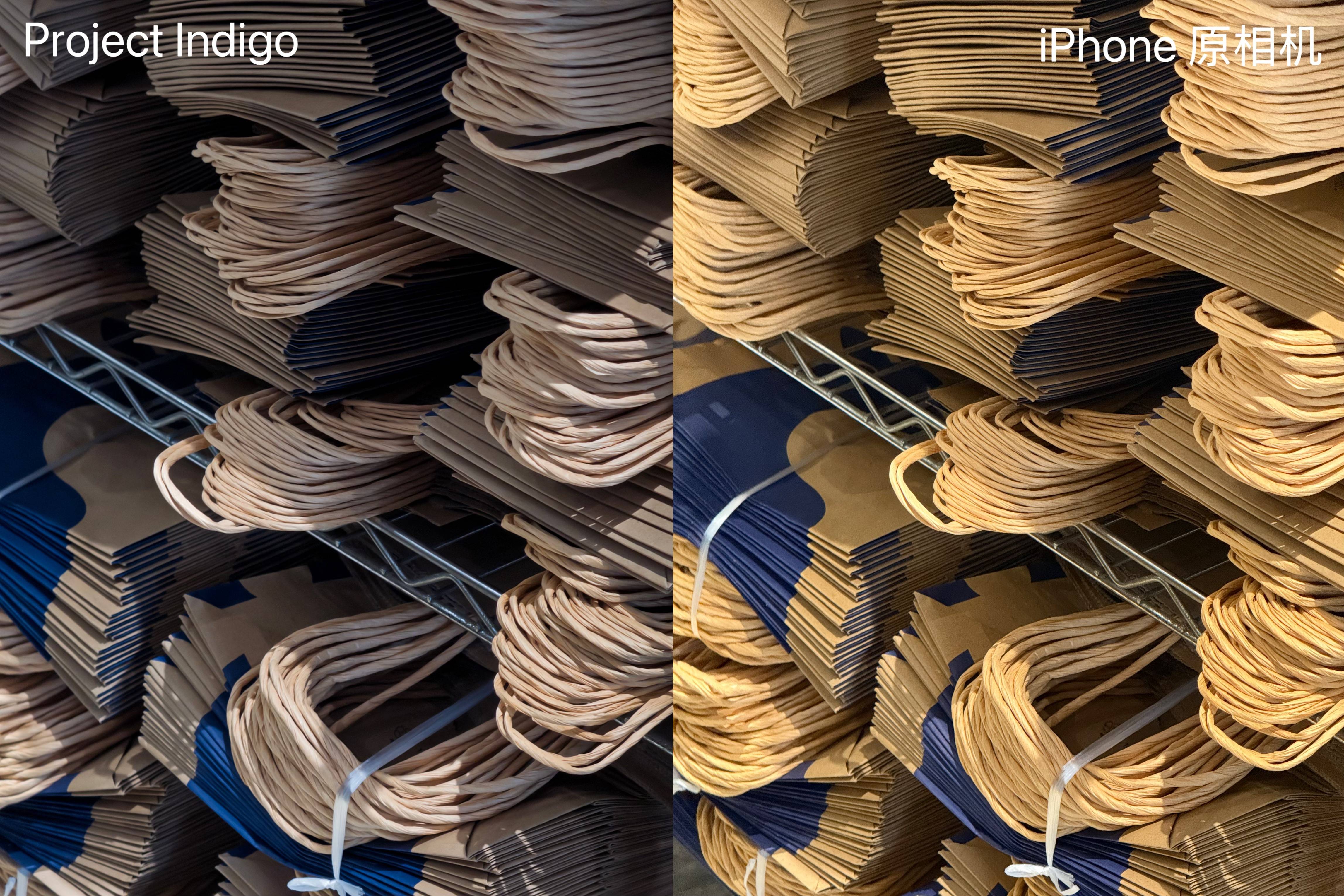

Deixe-me primeiro concluir. O Project Indigo é completamente diferente da câmera nativa do iPhone em dois aspectos principais. Baseado no mesmo hardware, o efeito de imagem do Project Indigo é mais atraente, e a transição entre claro e escuro está mais de acordo com o que se vê a olho nu, sem a sensação absurdamente brilhante do iPhone.

A julgar pelo histograma, os pixels do Projeto Indigo estão mais concentrados na metade esquerda, e a imagem tende a ser mais escura, o que está mais de acordo com a zona de conforto do olho humano, estimulando mais a ressonância emocional humana e mais de acordo com hábitos profundos de expressão artística.

Outra é que a imagem do Projeto Indigo apresenta menos nitidez e fragmentação, mas, graças à síntese de um número considerável de quadros múltiplos, a nitidez não é excessivamente atenuada. Após o zoom, as bordas dos objetos e do texto na imagem ainda mantêm um estado relativamente claro, preservando um certo grau de legibilidade.

Ao mesmo tempo em que torna a transição de luz e sombra mais natural e resolve o problema de bordas nítidas, o Project Indigo também tem uma otimização que não é fácil de notar: a imagem original da câmera do iPhone pode facilmente mostrar ruído sutil e denso após o zoom, mas o Project Indigo lida muito bem com esse ruído de fundo, e a imagem ainda pode permanecer pura quando ampliada.

No geral, o Project Indigo se destaca em detalhes de imagem, nitidez, supressão de ruído e desempenho de cores, mostrando uma tendência estética mais natural e harmoniosa, reproduzindo mais fielmente o que o olho nu vê.

Pode-se dizer que a estreia do Projeto Indigo resolveu todos os problemas pelos quais o iPhone é atualmente criticado, como nitidez excessiva, curva de brilho artificial e detalhes de imagem cheios de ruído de fundo. Ele até expandiu os limites disponíveis da distância focal do iPhone, mas não recomendo que você experimente imediatamente.

O motivo é que este aplicativo ainda apresenta muitos problemas: por exemplo, bordas pretas ocasionalmente aparecem na parte inferior das fotos, e as fotos tiradas ficam com uma coloração roxo-avermelhada após serem editadas no álbum. Ao mesmo tempo, o calor gerado e o consumo de energia durante todo o processo de captura são significativamente maiores do que os da câmera nativa do sistema.

De acordo com o feedback dos desenvolvedores do Projeto Indigo nas redes sociais, os problemas com bordas pretas e projeções de cores são causados principalmente pela adaptação incompleta do sistema, o que é um bug típico do estágio beta;

As razões para o calor e o consumo de energia são mais profundas. O Indigo usa um pipeline de processamento de imagem completamente diferente do iPhone, portanto, não consegue acessar o ISP nativo da Apple. Todos os cálculos multiquadro e tarefas de fusão de imagens são quase diretamente alocados ao próprio processador, o que naturalmente acarreta uma carga de hardware maior.

Na verdade, a Adobe já lembrou você de tudo isso antes de você abrir o software – lembra do ícone com fundo branco e wireframe azul?

Este design, que se assemelha a um projeto de engenharia, indica diretamente que o Projeto Indigo ainda está focado nos algoritmos e estruturas subjacentes da fotografia computacional e é um experimento orientado pela tecnologia, em vez de um produto final totalmente funcional e adequado para distribuição.

Ao mesmo tempo, a origem do Projeto Indigo também determina que sua experiência do usuário definitivamente não é boa o suficiente – este é um projeto lançado pela equipe da Nextcam sob a estrutura do Adobe Labs, que é o campo de testes e incubadora da Adobe para tecnologias futuras, com foco em levantar questões e verificar ideias em vez de entregar pontos finais.

▲ A maioria dos aplicativos aqui são incubados pelo Adobe Labs

A Origem e o Futuro da Fotografia Computacional

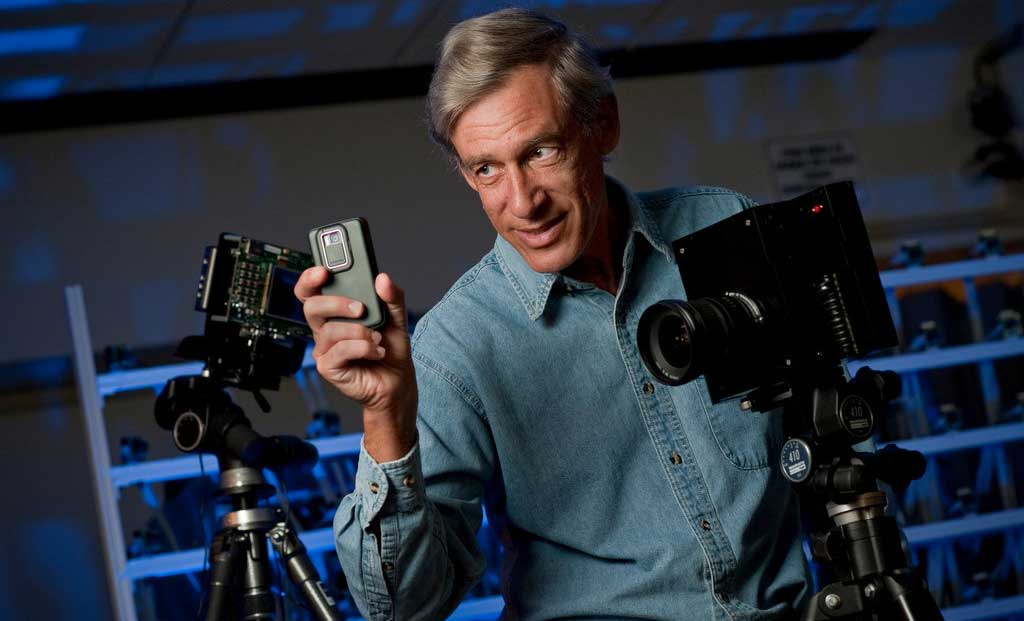

Embora o lançamento do Projeto Indigo seja atribuído à Adobe, uma empresa que trabalha na área de imagens há muito tempo, há um nome digno de nota na equipe da Nextcam que lançou o Indigo: Marc Levoy.

Se você conhece a época em que o sistema operacional Android doméstico ainda não havia sido lançado e o Google Camera era popular, talvez não esteja familiarizado com o nome Marc Levoy: o primeiro Pixel e o Google Camera, famoso por seus algoritmos, são obras-primas lideradas por ele.

▲Marc Levoy

A filosofia de Levoy está enraizada em sua formação acadêmica, um mundo muito diferente da fotografia óptica tradicional: computação gráfica.

Já durante seu doutorado, a tecnologia de renderização volumétrica que ele desenvolveu lançou as bases para a lógica central de seu trabalho posterior: por meio de cálculos, uma série de fatias de dados bidimensionais (como tomografias computadorizadas) foram reconstruídas em um todo tridimensional. Este foi o protótipo da lógica central da síntese multiquadro e reconstrução de imagens que ele posteriormente praticou em fotografia móvel.

Enquanto lecionava na Universidade de Stanford, Levoy construiu uma base teórica sólida para a fotografia computacional: o artigo "Light Field Rendering", que ele escreveu em coautoria com seus colegas, defendia que as câmeras deveriam registrar não apenas a intensidade da luz, mas também sua direção, permitindo operações revolucionárias, como o refocalização após o disparo.

Parece familiar? A câmera Lytro, que virou coisa do passado, é uma fiel praticante desse caminho.

Em 2004, Levoy redefiniu e popularizou o termo "fotografia computacional" em um curso de Stanford, interpretando a conotação mais ampla da palavra de outra perspectiva:

Fotografia computacional é uma técnica que visa aprimorar ou expandir as capacidades da fotografia digital, produzindo uma foto comum que é impossível de ser tirada com uma câmera tradicional.

Dez anos depois, Levoy ingressou oficialmente no Google e liderou a equipe para se concentrar em fotografia móvel. Suas ideias iniciais finalmente se concretizaram: um grupo de quadros de imagem com exposição extremamente curta é obtido por meio de disparos contínuos de alta velocidade, e algoritmos são usados para alinhar, mesclar e reduzir o ruído. Por fim, é calculada uma foto com qualidade pura e ampla faixa dinâmica que excede em muito a qualidade de qualquer quadro individual.

Uma teoria que exige uma computação enorme e é um tanto idealista demais, depois de resumida e refinada, foi implementada com poder computacional acessível a equipamentos comuns e finalmente caiu nas mãos de centenas de milhões de usuários. O clamor de dez anos atrás finalmente encontrou eco.

▲ Marc Levoy segurando o Pixel 3

Os protagonistas depois disso são o conhecido Pixel e seus famosos recursos. Em primeiro lugar, o HDR+, que muda completamente o desempenho de imagem dos celulares em condições complexas de iluminação. Por meio da tecnologia de síntese multiquadros, ele retém detalhes de alta resolução e, ao mesmo tempo, apresenta níveis de escuridão com clareza.

Em seguida, vem o modo retrato, que utiliza um algoritmo para obter um efeito de desfoque de fundo comparável ao de uma câmera SLR em uma única câmera. Esta é a personificação perfeita do seu conceito de redução de dimensionalidade; e o modo cena noturna leva essa ideia ao extremo. Ele pode combinar até 15 quadros, cada um com uma exposição de até 16 segundos, em uma foto de cena noturna brilhante e nítida. Seu efeito era incomparável no campo da imagem móvel da época.

Esses recursos, baseados na tecnologia de síntese de múltiplos quadros, não só permitiram que o Pixel de câmera única superasse os celulares de câmera dupla, como o iPhone e o Samsung, ganhando vários prêmios, como o de melhor celular com câmera do ano, mas também fizeram do termo fotografia computacional uma fórmula vencedora para imagens móveis.

Muitos anos depois, quando Levoy, que já havia ingressado na Adobe, foi questionado sobre a relação entre fotografia computacional e criação artística, sua filosofia foi clara e resoluta:

Não existe "fotografia direta". A faixa dinâmica da luz no mundo real excede em muito o limite do que qualquer sensor pode registrar. O próprio olho humano também é um mecanismo de fotossensibilidade adaptativa. As cenas que as pessoas veem foram processadas subjetivamente pelo cérebro, portanto, qualquer sistema de imagem digital precisa ajustar as cores e os tons registrados, e esses ajustes são inevitavelmente subjetivos.

Levoy não tem vergonha de falar sobre o produto e é até surpreendentemente honesto, afirmando que há vários anos as imagens do Pixel são construídas de acordo com sua filosofia e estética:

Adoro as pinturas de Caravaggio, então o estilo de imagem do Pixel 2 ao Pixel 4 tende a ser escuro e de alto contraste.

▲ A obra de Caravaggio "Jantar em Emaús"

Essa filosofia se estendeu por toda a carreira de Levoy, até ele deixar o Google e ingressar na Adobe. Ainda podemos ver esse estilo de tons escuros no Projeto Indigo, que é completamente diferente da estratégia de imagem da câmera original do iPhone, que foca em tons médios e realces.

Claro, isso é uma preferência estética por um lado, e também é inseparável dos requisitos do algoritmo por outro. A solução atual do Projeto Indigo é tirar várias fotos ligeiramente subexpostas para reter detalhes e cores de destaque e, em seguida, reduzir o ruído escuro por meio da síntese de múltiplos quadros. As fotos sintetizadas de acordo com essa lógica tendem a ser mais escuras.

Neste ponto, os interessados já podem descobrir um Easter egg de muito longo prazo: tanto estética quanto tecnicamente, o Projeto Indigo pode ser visto como a continuação espiritual do Pixel. O mais interessante é que este aplicativo incrível está disponível atualmente apenas na versão para iOS.

Isso não é uma espécie de ortodoxia do Google na Apple?

Não deixe que os algoritmos levem o crédito pelas fotos

A mudança é a única constante; a boa sorte nunca dura para sempre.

Fotografia computacional, um termo que representava tecnologia e avanço nos primeiros dias, tem apresentado tendência de queda no período seguinte.

Após o lançamento do Pixel, o Google Câmera tornou-se a câmera nativa do Pixel e gradualmente deixou de existir como um aplicativo independente. A dificuldade de adaptação aumentou drasticamente. Além disso, a melhoria contínua dos celulares domésticos gradualmente atraiu a atenção de todos e ganhou reconhecimento, o que também desviou a atenção das pessoas do Google Câmera.

![]()

▲ Começando com a clássica série Pixel 8 de "olhos de laser", a Pixel Camera começou a integração do sistema

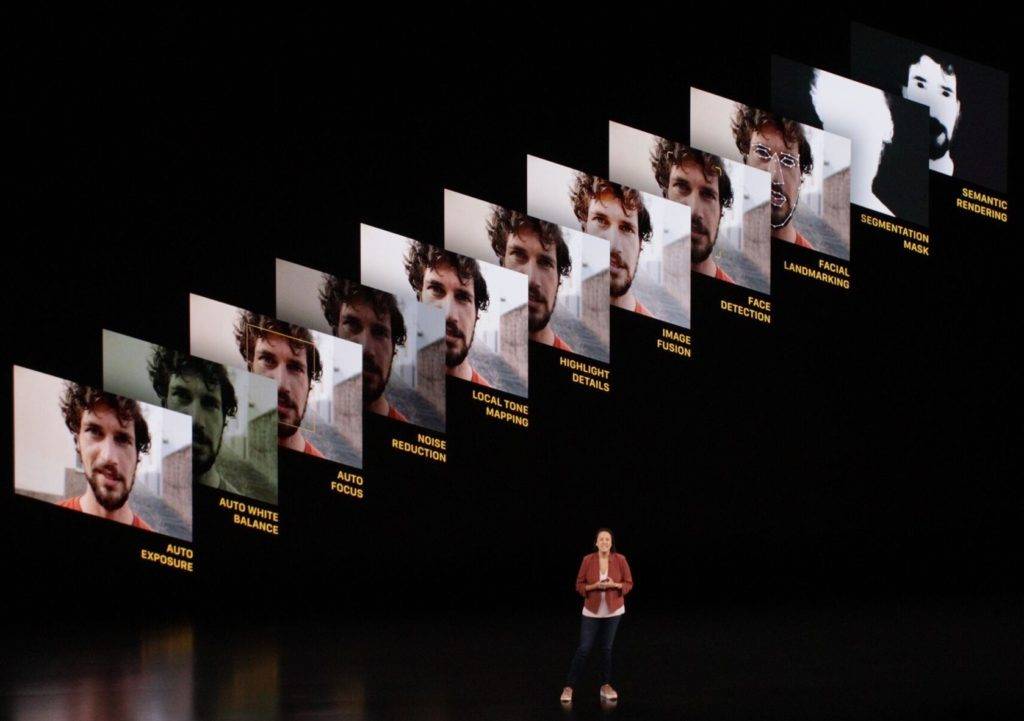

Por outro lado, a Apple, que ocupa metade do ecossistema de celulares, introduziu totalmente a tecnologia Deep Fusion na série iPhone 11. Ela também utiliza a tecnologia de empilhamento de múltiplos quadros, mas recebeu avaliações mistas.

Quanto ao iPhone sem Deep Fusion, embora o efeito seja natural, ele sofre em termos de qualidade de imagem e acabou sendo gradualmente eliminado em atualizações subsequentes do processador.

▲ O conhecido Deep Fusion está aqui

Desde então, o termo fotografia computacional passou a ter associações cada vez mais negativas: as fotos ficam extremamente borradas, com excesso de nitidez e com uma forte sensação de fragmentação. Esses adjetivos visuais desconfortáveis gradualmente se tornaram seus rótulos estereotipados.

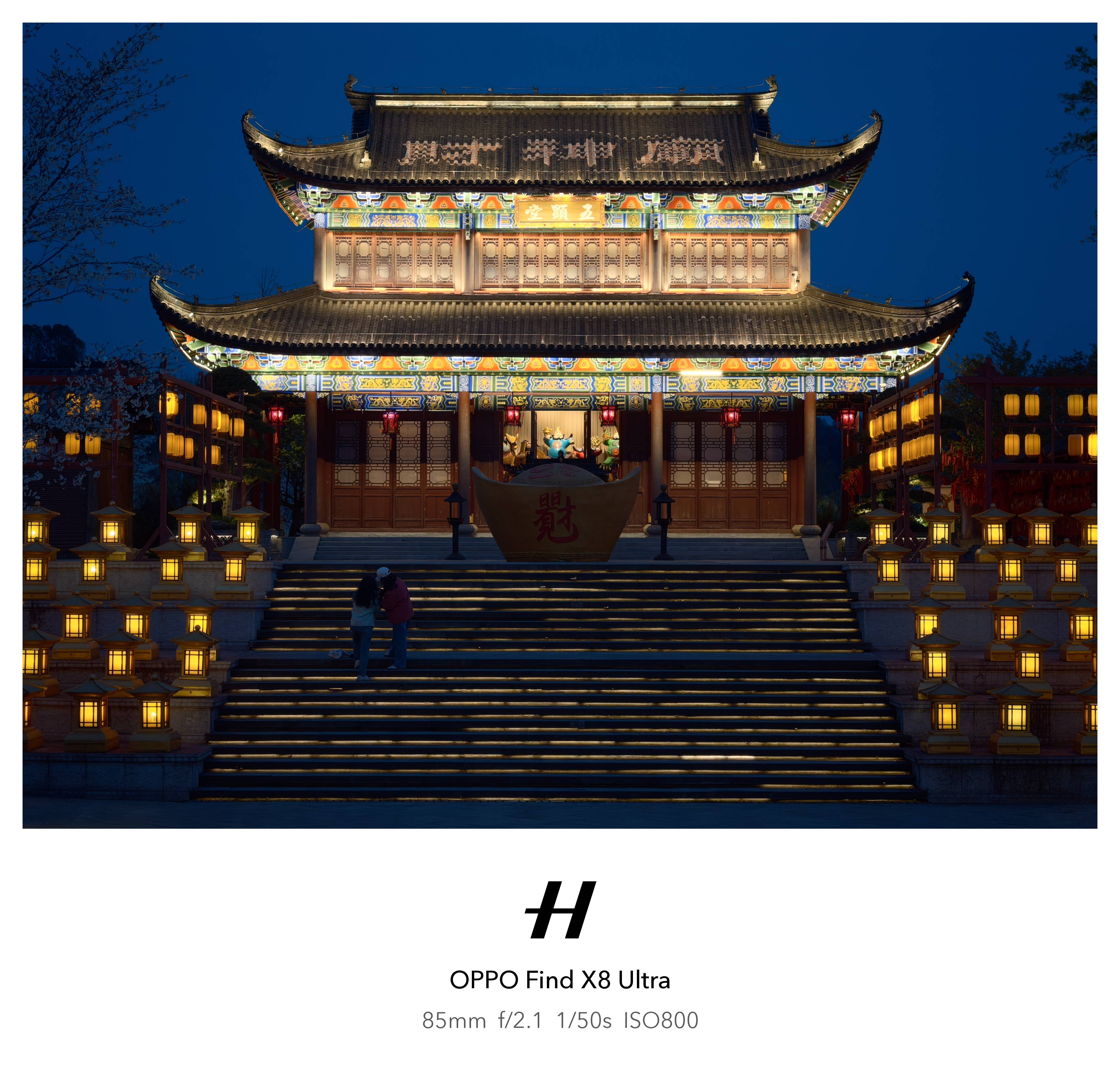

As coisas mudaram este ano. No OPPO Find X8 Ultra, há um "Modo Mestre" supostamente preparado para fotógrafos. Seu estilo de imagem é mais contido e suave do que a fotografia computacional convencional: ele suprime efetivamente a sensação de fragmentação causada pela nitidez digital, ao mesmo tempo em que apresenta uma curva de brilho mais natural.

Mas é um pouco lamentável que, ao mesmo tempo em que se busca a aparência, a sensação e a suavidade, a nitidez do Modo Mestre não seja mantida, a clareza das bordas dos objetos diminua e a qualidade da imagem não tenha solidez.

A abordagem do Projeto Indigo é mais radical. Ele busca o algoritmo de otimização de desempenho ao extremo e sintetiza dezenas de fotos de uma só vez, eliminando completamente o impacto negativo dos cálculos no filme finalizado, deixando apenas o cálculo no processo. O resultado final é uma foto com aparência e textura naturais, brilho linear e nitidez online.

Pode-se dizer que este é o melhor aplicativo de imagem que já vi até agora que separa algoritmos de produtos finalizados.

Em última análise, nossas dúvidas sobre a fotografia computacional vêm, na verdade, do nosso desgosto com os óbvios "rastros de processamento" nas fotos.

Sim, algoritmos são realmente importantes e trabalham muito duro, mas o que as pessoas querem é apenas uma boa foto comum, como disse Marc Levoy, que não requer nenhum equipamento profissional, mas pode produzir resultados inesperados somente por meio de cálculos.

Em vez de um pedaço de papel com um algoritmo escrito reivindicando o crédito.

#Bem-vindo a seguir a conta pública oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.