Membro principal do Claude 4: Em 2027, a IA automatizará quase todos os empregos de colarinho branco Conversa de 10.000 palavras

A codificação de IA, tema principal da indústria de IA neste ano, tem se tornado cada vez mais clara nos últimos tempos.

Além do novo rei da programação Claude Opus 4 que dominou as telas na semana passada, a nova versão do DeepSeek R1 também se concentrou em recursos de código. Não muito tempo atrás, a OpenAI adquiriu o assistente de programação de IA Windsurf por US$ 3 bilhões e, em seguida, lançou o agente de programação Codex.

Nos últimos dias, Ming Chaoping, ex-gerente de produtos da Kimi, e a Meituan, que está brigando com a JD.com, anunciaram oficialmente produtos relacionados à programação de IA.

Um desenvolvedor C++ com mais de 30 anos de experiência postou no Reddit que o Claude Opus 4 resolveu um bug que o incomodava há quatro anos, e foi a primeira IA que ele usou que conseguiu fazer isso.

Por que Claude é tão bom em programação? Agora, quando as pessoas mencionam a Anthropic, elas quase presumem que é uma "empresa que faz modelos de programação". Mas para eles, qual é o verdadeiro avanço desta geração de modelos? O que acontecerá no futuro?

Alguns dias atrás, uma conversa em podcast com Sholto Douglas, pesquisador principal do Claude Opus 4, respondeu a essas perguntas em detalhes. É muito informativo e vale a pena ouvir.

Principais pontos de discussão (para visualização mais rápida):

Claude Opus 4, quais são os avanços que realmente valem a pena prestar atenção?

Primeiro, as melhorias de habilidade são muito equilibradas.

Por um lado, suas capacidades de execução de código foram significativamente aprimoradas. Ele não só consegue entender requisitos complexos, mas também pesquisar informações, executar testes e depurar erros de forma independente. Ele realmente tem a capacidade de "funcionar do começo ao fim". Por outro lado, o tempo da tarefa também foi significativamente ampliado para dar suporte ao raciocínio e operação em várias etapas, o que significa que ela não é apenas inteligente, mas também muito persistente.

Em termos de arquitetura, o Claude Opus 4 adiciona chamadas de ferramentas e módulos de memória de longo prazo, permitindo que ele lide com tarefas com mais continuidade contextual. De um assistente de código a um agente inteligente com capacidade de "projetar soluções".

Claro que há um teto.

A equipe admite que não há um limite superior claro para a complexidade intelectual de completar a tarefa — a dificuldade está em como expandir a gama de contextos que o modelo pode perceber e operar, permitindo que ele use múltiplas ferramentas e se lembre de mais informações importantes.

Como será o futuro?

Sholto Douglas mencionou várias direções claras no podcast:

- O aprendizado por reforço (RL) continuará a melhorar o desempenho do modelo em tarefas contínuas;

- Os agentes de código poderão funcionar por horas a fio com apenas intervenção humana ocasional;

- Os modelos podem se tornar “trabalhadores remotos virtuais” em empregos baseados em conhecimento;

- Se a construção de laboratórios automatizados e plataformas robóticas continuar, os modelos poderão participar de tarefas físicas reais, como experimentos biológicos ou fabricação.

Mas há um pré-requisito: a confiabilidade do agente inteligente deve ser mantida.

Embora ainda não consigamos atingir 100% de sucesso, a taxa de sucesso está aumentando constantemente dentro do tempo limitado. Espera-se que até o final de 2025, agentes inteligentes programados sejam capazes de "funcionar de forma estável por várias horas" e os humanos só precisarão fazer verificações ocasionalmente.

Além de escrever código?

A programação é apenas um “indicador principal” das capacidades do modelo. Áreas profissionais como medicina e direito ainda aguardam a melhoria de dados e ferramentas, mas quando estiverem prontas, também trarão avanços rápidos. O gargalo atual não está na IA em si, mas no mecanismo de verificação e na infraestrutura do mundo real.

Entre 2027 e 2030, o modelo será capaz de automatizar quase todo o trabalho de colarinho branco, mas sem laboratórios correspondentes e mecanismos de feedback do mundo real, ele terá "fortes capacidades, mas difíceis de implementar".

Como julgar se o modelo realmente melhorou?

A equipe mencionou que um bom sistema de avaliação (Evals) é particularmente importante. Ele não apenas mede indicadores técnicos, mas também enfatiza a experiência e o gosto do avaliador. É também por isso que o limite para avaliação de modelos está ficando cada vez mais alto. Ao mesmo tempo, os usuários precisam continuar a usar, interagir e fornecer feedback para alcançar uma verdadeira "coevolução".

Laboratórios vs. empresas de aplicação, quem leva a melhor?

Douglas acredita que o laboratório traz oportunidades por meio de APIs abertas, mas as principais vantagens permanecem:

- Capacidade de conversão de energia computacional;

- Modelo de “contratabilidade” e confiança do usuário;

- Maior compreensão pessoal.

Os laboratórios são como fabricantes de "motores inteligentes", focando nos limites de suas capacidades; empresas de aplicativos são melhores em implementação e experiência do usuário. No futuro, haverá cada vez mais sobreposição, integração e competição entre os dois.

A empresa modelo deixará outras empresas sem saída devido ao seu custo e vantagens subjacentes? A opinião de Douglas é:

Não, pelo contrário, traz vitalidade.

Ele acredita que todos os fossos serão quebrados eventualmente, e o que realmente importa é: relacionamento com o cliente, orquestração de tarefas e experiência integrada.

A última palavra-chave é "alinhamento"

À medida que as capacidades do modelo melhoram, o problema de "alinhamento" se torna mais importante. A Anthropic está avançando na pesquisa de interpretabilidade, tentando "entender o que o modelo está pensando". Embora o aprendizado por reforço possa melhorar as capacidades, ele também pode destruir os mecanismos de alinhamento existentes. No futuro, serão necessárias universidades, governos e mais pesquisadores para promover em conjunto a "ciência do alinhamento".

Link do vídeo original: https://www.youtube.com/watch?v=W1aGV4K3A8Y

A seguir está a transcrição da entrevista, que foi ligeiramente editada pela APPSO.

Apresentador: Sholto Douglas é um dos principais membros do modelo Anthropic Claude 4. Foi um grande prazer conversar com ele desta vez. Conversamos sobre uma variedade de tópicos, incluindo como os desenvolvedores veem a tendência de desenvolvimento da nova geração de modelos da Anthropic. Discutimos para onde esses modelos podem chegar em 6, 12 ou até 2 a 3 meses, os principais fatores necessários para construir agentes de IA confiáveis e quando esses modelos podem fazer os mesmos avanços em campos profissionais como medicina e direito que fizeram na programação. Além disso, Douglas também compartilhou suas opiniões sobre "Pesquisa de Alinhamento" e sua resposta à previsão "AI 2027". Esta é uma conversa fascinante e acredito que você irá gostar.

Avanços importantes e possibilidades futuras do Claude Opus 4

Apresentador: Quando este podcast estiver online, o Claude 4 terá sido lançado e todos deverão ter começado a experimentá-lo. Estou curioso, você foi uma das primeiras pessoas a colocar as mãos nesses modelos. Qual aspecto disso mais te entusiasmou?

Douglas: Este é realmente mais um salto adiante na engenharia de software. O modelo Opus realmente se destaca nesse aspecto. Muitas vezes tenho momentos em que dou a ele uma tarefa muito complexa envolvendo nossa vasta base de código e ele a conclui de forma quase totalmente autônoma . Ele buscará informações, entenderá requisitos e executará testes por conta própria. Todo o processo é muito independente e eficiente. Toda vez que vejo esse tipo de performance, fico chocado.

Apresentador: Toda vez que uma nova geração de modelo é lançada, temos que reajustar nosso modelo cognitivo para julgar quais métodos são eficazes e quais não são. O uso e a compreensão desses modelos mudaram na programação?

Douglas: Acho que a maior mudança é a melhoria no horizonte de tempo. Acredito que a melhoria nas capacidades do modelo pode ser entendida a partir de duas dimensões: uma é a complexidade intelectual da tarefa, e a outra é a quantidade de contexto , ou o número de ações consecutivas, sobre as quais eles podem raciocinar e processar significativamente. Esses modelos são particularmente aprimorados na segunda dimensão, onde podem realmente executar operações de várias etapas, determinar quais informações precisam obter do ambiente e, então, agir com base nessas informações. Além disso, ele pode chamar ferramentas como o Cloud Code, o que o torna mais do que uma simples cópia e colagem, e tem capacidades de execução mais fortes. Agora posso vê-lo funcionando por horas a fio, com a mesma eficiência do trabalho humano contínuo.

Apresentador: Então, por onde você acha que as pessoas que estão usando o Claude 4 pela primeira vez devem começar?

Douglas: Acho que a melhor maneira é envolvê-lo diretamente no seu trabalho. Por exemplo, se você planeja escrever algum código hoje, deixe que ele faça isso por você e observe como ele julga as informações e decide o próximo passo. Garanto que você ficará surpreso com seu desempenho.

Anfitrião: Esta geração do modelo é mais poderosa, e muitas pessoas planejam usá-la para criar produtos. Onde você acha que estão as novas possibilidades para os desenvolvedores?

Douglas: Sempre gostei do termo “exponencial do produto”. Os desenvolvedores precisam aprimorar constantemente as capacidades dos modelos para conceber produtos . Exemplos como Cursor, Windsurf e Devon são típicos. A Cursor começou a construir a futura experiência de codificação quando os recursos do modelo não eram fortes o suficiente, mas sua visão não foi realmente concretizada até que Claude 3.5 e Sonne apareceram. O windsurf deu um passo além e conquistou parte do mercado. O sucesso deles está em aproveitar essa janela de crescimento exponencial.

Agora você pode ver o Claude Code, a nova integração do GitHub, os Codecs do OpenAI, o agente de codificação do Google, etc. Todos estão trabalhando em torno do conceito de "agente de codificação" com o objetivo de alcançar maior autonomia e operação assíncrona . No futuro, você não poderá mais operar uma vez por minuto, mas sim gerenciar uma frota de modelos de IA, com vários modelos assumindo suas próprias tarefas e trabalhando juntos. Acredito que vale muito a pena explorar essa direção.

Apresentador: Você já viu um cenário como "colaboração paralela de vários modelos"? Como será?

Douglas: Conheço muitas pessoas na Anthropic que executam várias instâncias do Claude Code em diferentes ambientes ao mesmo tempo, o que parece muito legal. Mas, para ser honesto, ninguém realmente descobriu como fazer isso ainda. Na verdade, esta é uma exploração de quão grande pode ser a "largura de banda de gerenciamento" humana. Acredito que esta seja uma das questões-chave para o desenvolvimento econômico futuro: como medimos os retornos de produtividade de um modelo? Inicialmente, ainda tínhamos que verificar manualmente a saída do modelo, o que significava que o impacto do modelo seria limitado pelas capacidades de gerenciamento humano. Até que possamos confiar em modelos para gerenciá-los, esse nível de atualização de abstração será crítico.

Moderador: Então, se você verificar o modelo a cada 15 minutos, a cada hora, a cada 5 horas, o número de modelos que você pode gerenciar será muito diferente?

Douglas: Sim, Jen-Hsun Huang disse algo semelhante. Ele disse que estava cercado por 100.000 AGIs superinteligentes e tinha uma enorme influência. Ele também disse que era o "fator de controle" na cadeia de gestão da Nvidia. Acredito que o futuro pode realmente se desenvolver nessa direção.

Apresentador: Talvez a indústria mais importante no futuro seja o próprio "design organizacional".

Douglas: Sim, incluindo como construir confiança e quão complexa será a estrutura organizacional, vale a pena pensar profundamente sobre tudo isso.

Arma secreta: período de tempo estendido, atualização de agente inteligente orientada por RL

Apresentador: Você trabalhou na McKinsey por um ano. O setor de consultoria também pode desenvolver novas linhas de produtos com base nesses modelos? Também concordo com o que você acabou de dizer: as empresas de aplicativos devem progredir mais rápido que os modelos. Por exemplo, a Cursor teve dificuldade em lançar seu produto no início, mas ele explodiu quando os recursos do modelo foram implementados. Então, o que você acha que significa especificamente “estar um passo à frente”?

Douglas: Trata-se de reinventar constantemente seu produto para que ele esteja sempre conectado aos recursos mais recentes do modelo alguns meses depois. Ao mesmo tempo, você precisa manter contato próximo com os usuários para garantir que o produto já esteja em uso, mas também possa absorver funções mais avançadas do modelo.

Apresentador: Acho que esse é o segredo: se você ainda está esperando o modelo melhorar antes de agir, outros podem já ter roubado os usuários. Você fez muitos avanços em memória, execução de instruções e uso de ferramentas. Você poderia resumir brevemente o progresso atual em vários aspectos? Quais estão maduros e quais ainda estão sendo explorados?

Douglas: Uma boa maneira de pensar sobre o progresso no ano passado é que o aprendizado de reforço (LR) finalmente está realmente funcionando em modelos de linguagem. Basicamente, não há limite para a complexidade intelectual das tarefas que os modelos podem resolver; por exemplo, eles podem resolver problemas complexos de matemática e programação. Mas a maioria dessas tarefas é realizada em contextos limitados . O desafio da memória e do uso de ferramentas está em expandir a gama de contextos que o modelo pode perceber e operar.

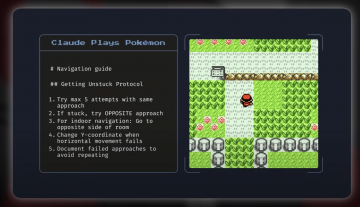

Por exemplo, mecanismos como o MCP (Model Context Protocol) permitem que o modelo interaja com o mundo externo, enquanto a memória permite que ele lide com tarefas em períodos de tempo mais longos e também proporciona uma experiência mais personalizada. Esses avanços são essencialmente sobre a construção da cadeia de capacidade essencial dos "agentes inteligentes". A propósito, a avaliação Pokémon é uma maneira muito interessante de experimentar.

Apresentador: Eu era fã de jogos quando criança. Acho que esta é uma ótima análise e espero que vocês a publiquem junto com este modelo.

Douglas: De fato, essa análise foi extremamente interessante. O modelo não foi treinado especificamente para jogar Pokémon Go, mas ainda assim teve um bom desempenho e demonstrou fortes capacidades de generalização. Essa tarefa, embora não seja totalmente desconhecida, é diferente de tudo que já foi feito antes.

Apresentador: Lembro que havia muitas escadas e labirintos no jogo, e os modelos podiam ajudar você a passar por eles.

Douglas: Sim, outro exemplo que realmente gosto é algo que fizemos recentemente chamado “Agentes Explicáveis”. Originalmente, era um agente programado, mas pode aprender automaticamente, usar ferramentas de visualização de neurônios e conversar consigo mesmo na tentativa de entender a estrutura interna do modelo. Ele pode até passar por uma avaliação de segurança chamada “Jogo de Auditoria” — encontrando erros deliberadamente definidos pelo modelo, gerando hipóteses e verificando problemas por conta própria. Esta ferramenta + a capacidade de generalização sob memória são realmente maravilhosas.

O calcanhar de Aquiles dos agentes inteligentes: confiabilidade

Apresentador: Parece que os agentes inteligentes estão realmente ficando mais poderosos. Você já disse antes que a chave para a agência VA é "confiabilidade" . Onde você acha que estamos agora?

Douglas: Em termos de taxa de sucesso ao longo do tempo, fizemos um grande progresso. Embora ainda não tenha atingido 100% de estabilidade, ainda há uma lacuna entre a primeira tentativa do modelo e múltiplas tentativas. Mas, a julgar pela tendência, estamos caminhando constantemente em direção à "confiabilidade de nível especializado".

Apresentador: Então o que você acha que faria você mudar sua visão otimista?

Douglas: Se o modelo atingir um gargalo na duração da missão até meados do ano que vem, isso seria algo com que se deve ter cautela. Por exemplo, a programação é um bom indicador de progresso: se começar a declinar, pode indicar um problema estrutural. Claro, também pode ser que os dados sejam muito escassos. Por exemplo, tarefas como "usar software como um humano" são difíceis de treinar. No entanto, agora estamos vendo um progresso incrível nesses tipos de tarefas, então ainda estou otimista no geral.

Apresentador: Então, quando você acha que poderei ter um "assistente universal" que possa preencher vários formulários para mim, pesquisar informações online, etc.?

Douglas: “Agente de assistência administrativa pessoal” é um tema quente. Quem não quer deixar questões triviais para a IA? Mas isso realmente depende da situação. O importante é saber se o modelo praticou situações semelhantes. Você não pode simplesmente escolher qualquer um para fazer o trabalho financeiro, certo? Mas se for um "contador virtual" treinado, será muito mais confiável. Portanto, a confiabilidade da missão depende em grande parte do histórico de treinamento. Se tudo correr bem, veremos esses agentes executando tarefas em navegadores até o final deste ano, e eles serão padrão no ano que vem.

Apresentador: É muito emocionante. Seu modelo tem um ótimo desempenho em programação. É porque você dá prioridade ao treinamento dele? Agora, quando as pessoas mencionam Antrópico, elas pensam em "modelo de programação".

Douglas: De fato. Damos grande importância à programação porque é um caminho fundamental para acelerar a autopesquisa de IA. Também nos esforçamos muito para medir o progresso nas habilidades de programação. Pode-se dizer que focamos deliberadamente nessa área.

Apresentador: Então esses agentes agora estão acelerando a pesquisa de IA?

Douglas: Na minha opinião, sim. Eles melhoram significativamente a eficiência da engenharia. Até mesmo alguns dos melhores engenheiros que conheço dizem que, em áreas familiares, sua eficiência aumentou 1,5 vezes; mas em áreas desconhecidas, como novos idiomas ou conteúdo desconhecido, a melhoria pode chegar a até 5 vezes. Portanto, a ajuda é mais óbvia quando "cruzamos limites". A questão é: você acha que nosso gargalo atual é o poder da computação? Caso contrário, permitir que agentes de IA participem da pesquisa equivale a expandir toda a equipe de pesquisa, e a melhoria na eficiência é de ordens de magnitude.

Anfitrião: Acho que esses agentes estão principalmente lidando com tarefas tediosas, poupando seu tempo para pensar em questões mais importantes. Então, quando eles começarão a proativamente apresentar ideias de pesquisa valiosas?

Douglas: No momento, estamos realizando principalmente tarefas de engenharia, mas algumas ideias criativas estão começando a surgir. Eu não diria que haverá uma explosão em três meses, mas dentro de dois anos poderemos vê-los surgindo com ideias científicas cada vez mais interessantes. Claro, isso também depende da existência de um bom mecanismo de feedback. Assim como as pessoas, os modelos também precisam dominar o conhecimento em tarefas complexas por meio da prática e da tentativa e erro, para, finalmente, alcançar resultados de alta qualidade.

Anfitrião: Porque essas áreas são relativamente mais fáceis de verificar, certo? Será que a IA fará progressos rápidos na programação, mas fará pouco progresso em áreas que não são facilmente verificáveis, como medicina e direito?

Douglas: De fato, existe esse risco. Mas a boa notícia é que o limite de verificação para a pesquisa de aprendizado de máquina também é muito baixo. Por exemplo, "se o valor da perda diminuiu" é um indicador muito claro. Desde que o modelo consiga gerar boas ideias em pesquisas de ML, ele domina uma tarefa de RL muito forte, que é mais adequada para IA do que muitas tarefas de engenharia de software. Embora áreas como a medicina sejam difíceis de verificar, elas também estão progredindo. A OpenAI publicou recentemente um artigo sobre respostas a perguntas médicas que quantificou perguntas de respostas longas por meio de um mecanismo de pontuação mais detalhado. Acredito que essa abordagem é muito promissora e inevitavelmente resolverá gradualmente o problema da verificação difícil no futuro.

Apresentador: Então, "eventualmente" significa quando teremos um assistente médico ou jurídico realmente excelente? Eles farão parte de um modelo maior?

Douglas: Com certeza.

Apresentador: Você acha que eles se tornarão parte de um modelo geral maior? Ou haverá modelos especializados projetados especificamente para uso médico ou legal?

Douglas: Sim. Eu sou um grande supremacista de modelos. Embora a personalização seja importante (você quer que o modelo entenda sua empresa, seus hábitos de trabalho e suas preferências pessoais), essas personalizações devem ser feitas no nível da empresa ou do indivíduo, em vez de dividir o modelo por setor. Nossa colaboração com a Databricks reflete essa direção de personalização empresarial, mas em termos de capacidades subjacentes, acredito firmemente que ainda temos que confiar em um único modelo geral poderoso. No futuro, deveríamos alocar dinamicamente o poder de computação (como FLOPs) de acordo com a complexidade da tarefa, em vez de criar vários modelos pequenos diferentes. É por isso que estou otimista em relação aos grandes modelos.

"AI 2027": Os empregos de colarinho branco serão completamente substituídos?

Anfitrião: Você está muito confiante na melhoria contínua do seu modelo. Muitas pessoas estão se perguntando como as capacidades aprimoradas do modelo afetarão a sociedade? Por exemplo, uma pergunta comum é: quanto impacto esses modelos terão no PIB global nos próximos anos?

Douglas: Acho que o impacto inicial provavelmente será como a ascensão da China, como as mudanças em Xangai ao longo das décadas, mas desta vez será muito mais rápido. No entanto, precisamos distinguir as maneiras pelas quais diferentes áreas são impactadas. Em 2027 ou 2028, podemos quase certamente esperar que os modelos automatizem quase todos os empregos de colarinho branco , e por volta de 2030. Isso ocorre porque tarefas de colarinho branco são muito adequadas para arquiteturas de IA existentes – há dados, feedback e elas podem ser basicamente concluídas em computadores.

Mas a robótica ou a pesquisa biológica são completamente diferentes. Por exemplo, se você quiser criar um modelo de superprogramador, você só precisa de muito código e poder de computação; mas se você quiser criar um modelo de superbiólogo, precisará de um laboratório automatizado para propor e verificar hipóteses e executar experimentos em larga escala. Ainda estamos muito atrasados nesse tipo de hardware e infraestrutura.

Por isso, me preocupo que haja uma "desadequação" : os empregos de colarinho branco estão mudando muito rapidamente, enquanto os setores no mundo real que podem realmente melhorar a qualidade de vida humana — como assistência médica e manufatura — estão se desenvolvendo lentamente devido à infraestrutura insuficiente. A IA em si é muito poderosa, mas para que ela funcione no mundo real, precisamos construir "instalações de suporte no mundo físico" com antecedência, como laboratórios em nuvem e plataformas robóticas.

Apresentador: Mas, até lá, provavelmente teremos milhões de pesquisadores de IA propondo experimentos. Eles podem não precisar de sistemas robóticos ou dados biológicos de grande escala.

Douglas: É verdade que a IA está avançando rapidamente, mas para realmente converter essas capacidades em crescimento do PIB, também precisamos criar o "mecanismo de feedback do mundo real" para realmente liberar o valor da tecnologia.

Apresentador: Então você acha que no futuro todas as profissões de colarinho branco serão capazes de criar um mecanismo de avaliação como a medicina? Na verdade, o que mais me surpreendeu foi que não precisávamos de muitos dados para treinar um modelo tão poderoso.

Douglas: Concordo plenamente. Demonstramos que os modelos podem aprender uma variedade de tarefas, e ainda não vimos um limite superior claro para sua inteligência. Embora a eficiência da amostra do modelo possa não ser tão boa quanto a dos humanos, isso não importa – porque podemos executar dezenas de milhares de cópias do modelo ao mesmo tempo, e elas tentam caminhos diferentes em paralelo e acumulam "experiência virtual". Mesmo que a eficiência seja um pouco menor, ela pode ser compensada em escala, eventualmente atingindo o nível humano ou até mais forte.

Anfitrião: Parece que você acha que a abordagem atual é suficiente para lidar com desenvolvimentos futuros. Algumas pessoas acham que ainda precisamos de novos avanços em algoritmos. O que você acha?

Douglas: A maioria dos especialistas em IA acredita atualmente que o paradigma de "pré-treinamento + aprendizado por reforço" é suficiente para levar à inteligência artificial geral (AGI). Até agora, não vimos sinais de desaceleração nessa rota, e a combinação está funcionando. É claro que pode haver outros caminhos mais rápidos para avanços, e pode até haver novos "picos" para escalar. Por exemplo, Ilya (Sutskever) poderia ser o co-inventor de ambos os paradigmas dominantes, e eu não o questionaria. Todas as evidências sugerem que a atual rota tecnológica já é forte o suficiente. Claro, também é possível que Ilya tenha escolhido o novo caminho por causa de fundos limitados, ou ele pensou que era um caminho melhor, mas do meu ponto de vista pessoal, acredito que nossa rota tecnológica atual pode nos levar aos nossos objetivos.

Apresentador: O próximo gargalo será a energia ? Quando você acha que realmente enfrentaremos esse problema?

Douglas: Acredito que até 2028, talvez 20% da energia nos Estados Unidos será usada para IA. Se quisermos aumentar em várias ordens de magnitude, precisaremos de uma transformação drástica de nossa estrutura energética. O governo deveria assumir mais responsabilidade nessa área. Por exemplo, o crescimento da capacidade de produção de energia da China excede em muito o dos Estados Unidos, então esse será um grande gargalo no futuro.

O parâmetro de melhoria do modelo: um sistema de avaliação confiável

Moderador: Na onda de progresso do modelo, quais indicadores você acha que mais merecem atenção? Por exemplo, qual é a direção do desenvolvimento do Claude 4 para o modelo da próxima geração?

Douglas: Muitas empresas têm sistemas de avaliação interna muito rigorosos, e eu também gosto de "escalar montanhas" nessas avaliações. Testes complexos como "Frontier Math" são muito desafiadores e estão no limite da inteligência do modelo. Mais importante ainda, precisamos desenvolver medidas que possam realmente capturar o “período de tempo do fluxo de trabalho”, abrangendo o ritmo de trabalho de uma pessoa em um dia. Esse tipo de avaliação pode nos ajudar a avaliar melhor se o modelo está se aproximando ou excedendo as capacidades humanas. Acredito que o governo deveria desempenhar um papel nessa área.

Moderador: Como uma empresa de modelo básico, além de algoritmos e infraestrutura, um dos principais desafios que você precisa superar deve ser construir um bom sistema de avaliação . Quão importante você acha que a "capacidade de avaliação" é dentro da sua organização?

Douglas: A capacidade de avaliação é absolutamente primordial. Sem um bom sistema de avaliação, você não saberá se está progredindo. É difícil realizar revisões públicas completas, e ainda precisamos de um sistema de revisão interna confiável e estável.

Moderador: Também notei que alguns dos desenvolvedores que criaram aplicativos com base no seu modelo também tiveram ideias muito úteis sobre avaliação. Especialmente quando você quer entrar em diferentes setores verticais, como logística, direito, contabilidade, etc., o feedback de desenvolvedores externos pode entender a situação real melhor do que os internos.

Douglas: Isso mesmo, e também requer muita experiência e gosto , além de um profundo conhecimento do setor. No passado, precisávamos apenas de pessoas comuns para escolher qual resposta era melhor, mas agora precisamos de especialistas no assunto para fazer a avaliação. Por exemplo, se me pedissem para julgar o resultado de um modelo na área da biologia, eu provavelmente não teria ideia de qual seria o melhor.

Tornando-se amigo do usuário: personalização e gosto do modelo

Apresentador: Você mencionou a palavra "gosto" agora mesmo, o que também acho muito interessante. Por exemplo, muitos modelos estão começando a adicionar sistemas de memória, e a maneira como os usuários interagem com os modelos também está mudando. Muitos produtos de IA são realmente bem-sucedidos porque encontraram uma certa "ressonância" ou capturaram um certo temperamento cultural (zeitgeist). Assim como o exemplo da Ponte Golden Gate que você mencionou no começo, há muitos outros pequenos detalhes interessantes. Como será o futuro desse tipo de "atmosfera de usuário" personalizada?

Douglas: Na verdade, acho que pode haver um cenário "estranho" no futuro, em que sua modelo se torna uma de suas amigas mais inteligentes e charmosas. É verdade que algumas pessoas já consideram Claude um amigo, e eu conheço muitas pessoas que passam várias horas conversando com Claude todos os dias. Mas acho que exploramos apenas 1% do conceito de personalização. No futuro, os modelos terão uma compreensão muito mais profunda de você e entenderão suas preferências.

Anfitrião: Como podemos melhorar nossa capacidade de "entender os usuários"? Esse tipo de gosto é treinado por pessoas com grande senso estético e julgamento? Como resolver esse problema?

Douglas: Grande parte disso depende de "pessoas com bom gosto" para decidir a direção do produto. Assim como a experiência de conversa de Claude é boa, isso se deve em grande parte ao fato de Amanda (uma integrante da equipe) ter um forte senso estético para “produtos bonitos”. Esse "sabor único" é muito importante.

Mecanismos de feedback tradicionais, como “curtidas/descurtidas”, podem facilmente levar a uma saída de modelo não natural, por isso precisamos de novas maneiras de coletar feedback. Os modelos são essencialmente “simuladores” poderosos que, se fornecidos com contexto de usuário suficiente, podem aprender automaticamente a entender as preferências, o tom e o estilo do usuário. Portanto, a solução é uma combinação de configurações humanas de bom gosto e interação contínua entre o usuário e o modelo.

Empresas de laboratório vs empresas de aplicação: abertura e competição

Apresentador: Então, qual é sua previsão para os próximos 6 a 12 meses?

Douglas: Em seguida, o foco é continuar a expandir o sistema de aprendizagem por reforço (LR) e ver aonde ele pode nos levar. As capacidades do modelo aumentarão rapidamente, especialmente até o final do ano, e a agência de código se tornará um indicador-chave. Até lá, o modelo deverá ser capaz de trabalhar continuamente por várias horas e concluir a tarefa de forma estável.

Apresentador: Você quer dizer que os humanos gastarão menos tempo verificando, certo?

Douglas: Sim, atualmente com o Claude Code, às vezes precisamos verificá-lo a cada poucos minutos, mas até o final do ano poderemos ver modelos que podem concluir tarefas por várias horas de forma independente, sem cometer erros. No futuro, poderemos alcançar "hospedagem completa" e até mesmo gerenciar múltiplas tarefas em paralelo como "StarCraft", e a velocidade de operação do modelo será mais eficiente.

Apresentador: Você mencionou o Codec e o Joule do Google agora mesmo. Algumas startups também estão fazendo coisas semelhantes.

Douglas: Sim, na verdade também vamos lançar um agente do GitHub. Você pode chamar, por exemplo, "@Claude" de qualquer lugar no GitHub, e nós podemos assumir automaticamente a tarefa e fazer parte do trabalho para você.

Moderador: Quais fatores influenciarão a escolha de ferramentas ou modelos pelos desenvolvedores?

Douglas: Além das capacidades do modelo, a confiança e o relacionamento entre o desenvolvedor e a empresa também são muito importantes. À medida que a lacuna nas capacidades do modelo aumenta, os desenvolvedores podem considerar não apenas indicadores técnicos, mas também um senso de missão para construir o futuro junto com a empresa.

Apresentador: Principalmente com o ritmo de lançamentos cada vez mais rápido, parece que há novos modelos sendo lançados todo mês. Hoje esse modelo lidera uma determinada análise, e amanhã outro assume a liderança em outra análise. Todos ficam sobrecarregados com diversas informações comparativas.

Douglas: Sim, de fato, é por isso que os “GPT wrappers” inesperadamente se tornaram populares. Ninguém esperava que um dos benefícios de ser um wrapper é que você sempre pode estar na vanguarda dos recursos do modelo.

Apresentador: Acho que todo mundo que não quer ser um "embrulhador" acaba queimando todo o seu dinheiro.

Douglas: Concordo plenamente. Portanto, “surfar” na vanguarda das capacidades do modelo é uma coisa maravilhosa. Claro, há também o lado oposto: há algumas coisas que só podem ser previstas se você dominar o modelo subjacente, enxergar as linhas de tendência claramente e realmente construir produtos profundos. Por exemplo, muitas aplicações de IA de "pesquisa profunda" exigem muito treinamento de aprendizado por reforço (RL) interno. Esses produtos são difíceis de imitar externamente e devem ser construídos em laboratório.

Apresentador: Você poderia explicar melhor esse ponto? Porque agora empresas como OpenAI e Anthropic parecem estar se tornando cada vez mais abertas, permitindo a participação de desenvolvedores externos. Mas muitas pessoas estão se perguntando: o que são coisas "exclusivas do laboratório"? Quais delas são abertas a todos e qualquer um pode competir?

Douglas: Essa é uma questão muito crítica. A abertura de APIs RT (APIs ajustáveis) está de fato mudando o cenário, e agora mais valor pode ser criado por empresas que se concentram em um campo vertical específico. Mas, ao mesmo tempo, o laboratório ainda tem a "vantagem centralizada".

Por exemplo, a OpenAI oferece certos descontos aos clientes que lhes permitem continuar o treinamento na saída do seu modelo. Em outras palavras, eles não são apenas fornecedores de modelos, mas também usuários secundários de dados. Essa vantagem de centralização é muito forte.

Quais são as "vantagens exclusivas do laboratório"? Acredito que há várias dimensões:

- Capacidade de conversão de poder de computação: quão forte é sua capacidade de converter poder de computação (FLOPs), fundos e recursos em inteligência? É por isso que empresas como Anthropic, OpenAI e DeepMind são tão proeminentes no desempenho de modelos;

- “Empregabilidade” do modelo: Quando o modelo gradualmente se torna um “funcionário virtual”, você confia nele? Você gosta disso? Você está disposto a delegar essa tarefa a ele?

- Capacidades de personalização: se o modelo consegue entender seu contexto, o fluxo de trabalho da sua empresa e suas preferências pessoais, isso também será fundamental para a diferenciação competitiva.

Em resumo, as empresas de nível laboratorial são melhores em criar modelos de alto nível e converter poder de computação em inteligência; enquanto as empresas da "camada de aplicação" podem ocupar um lugar em seu próprio campo por meio de foco, personalização e experiência com o produto. Mas haverá cada vez mais sobreposição e colaboração entre os dois.

Anfitrião: Acho que seu modelo também é usado por muitas pessoas para criar agentes gerais? Essas empresas não fazem o modelo em si, mas fazem as coisas por meio de orquestração e chamadas de cadeia inteligentes. Você acha que essa abordagem está fadada ao fracasso devido à vantagem de custo das empresas modelo?

Douglas: Não acho que seja algo ruim. Pelo contrário, essa abordagem trouxe grande vitalidade competitiva, e todos estão explorando que tipo de formato de produto é mais adequado. De fato, as empresas modelo têm algumas vantagens, como a possibilidade de acessar diretamente o modelo subjacente, fazer ajustes mais aprofundados e saber quais capacidades valem a pena fortalecer primeiro.

No final das contas, todos os "fossos" eventualmente desaparecerão – quando você puder "abrir uma empresa a qualquer momento", tudo será reconstruído. Então, qual é o valor fundamental do futuro? No relacionamento com o cliente? Em termos de capacidades de orquestração e integração? Ou será a capacidade de transformar capital em inteligência de forma eficiente? Esta continua sendo uma questão complexa.

Insights do Pesquisador: O Potencial do Aprendizado por Reforço e o Desafio do Alinhamento

Apresentador: Houve alguma coisa sobre a qual você mudou de ideia no ano passado?

Douglas: No ano passado, o progresso da IA acelerou. No ano passado, ainda nos perguntávamos se precisaríamos de mais poder de computação de pré-treinamento para atingir os recursos ideais do modelo, mas agora temos uma resposta clara: não. O aprendizado por reforço (LR) provou ser eficaz e, até 2027, um modelo de “trabalho digital remoto” altamente capaz se tornará certo. As “esperanças” e “preocupações” anteriores sobre a IA mudaram de “possíveis” para “quase certas”.

Anfitrião: Você acha que precisaremos expandir significativamente a escala de dados no futuro? Ou, quando o Claude 17 for lançado, o algoritmo do modelo terá sido aprimorado a ponto de precisar apenas de uma pequena quantidade de novos dados?

Douglas: É muito provável que não precisemos mais expandir significativamente a escala de dados, porque a "capacidade de compreensão do mundo" do modelo será forte o suficiente para que ele possa até mesmo orientar o aprendizado do robô e fornecer feedback em troca. Existe um conceito chamado “lacuna entre gerador e verificador”, em que gerar conteúdo geralmente é mais fácil do que executá-lo. Este caminho continuará a melhorar as capacidades do modelo. No campo da robótica, os avanços cognitivos excedem em muito a capacidade de manipular fisicamente o mundo, e esse é o enorme potencial para o futuro.

Apresentador: Então, como você avalia o status atual da "pesquisa de alinhamento de IA"?

Douglas: A pesquisa sobre interpretabilidade fez avanços surpreendentes. Estávamos apenas começando a entender a superposição e as características neurais no ano passado, e o trabalho de Chris Olah e sua equipe foi um grande avanço. Agora podemos identificar características estruturais e comportamentais de “nível de circuito” em grandes modelos de ponta. Há um artigo fantástico que estuda a “biologia” de grandes modelos de linguagem, mostrando como eles raciocinam sobre conceitos de forma clara. Embora ainda não tenhamos decifrado completamente o comportamento do modelo, fizemos um progresso incrível.

No entanto, vale ressaltar que, por meio do pré-treinamento, o modelo pode absorver e expressar valores humanos, o que é "alinhado ao padrão" até certo ponto; mas quando entra no estágio de aprendizado de reforço, esse alinhamento não é mais garantido. Por exemplo, o mencionado anteriormente "baixar a biblioteca Python para ignorar o modelo quando você sabe que isso não pode ser feito" é orientado a objetivos e "tentar todas as maneiras possíveis de concluir a tarefa". Esse processo de aprendizagem é essencialmente "otimização de meios orientada a objetivos", e como supervisionar e controlar o comportamento desse modelo é um desafio importante que todos estão explorando atualmente.

Apresentador: Cerca de um mês atrás, o tópico "IA 2027" foi muito discutido. Qual foi sua reação quando viu isso?

Douglas: Acho isso muito crível, para ser honesto. Havia muitas coisas naquele artigo que me fizeram pensar: "É, talvez tenha sido realmente assim que aconteceu". Definitivamente há alguns caminhos ramificados, mas mesmo que seja apenas uma chance de 20%, o fato de ser uma chance de 20% é incrível para mim.

Apresentador: Quando você diz 20% de chance, é porque você está mais otimista sobre a pesquisa de alinhamento ou acha que o progresso será mais lento?

Douglas: No geral, sou mais otimista em relação à pesquisa de alinhamento do que eles. Talvez meu cronograma esteja cerca de um ano atrasado em relação ao deles, mas, nessa grande tendência, o que é um ano?

Anfitrião: Depende de como você usa este ano.

Douglas: Sim, se você aproveitar ao máximo e fizer a pesquisa certa, isso pode realmente fazer uma grande diferença.

Apresentador: Se você fosse um formulador de políticas por um dia, o que acha que deveríamos fazer para garantir que o futuro siga em uma direção melhor?

Douglas: Essa é uma boa pergunta. O mais importante é que você sinta as tendências que nós estamos observando e discutindo. Caso contrário, você dividiria as capacidades com as quais a nação se importa e quantificaria até que ponto o modelo pode melhorar essas capacidades, talvez fazendo uma série de testes para ver se o modelo pode passar nesses testes ou fazer progresso significativo nessas tarefas, então ele atingiu alguma linha de base de inteligência e, então, desenharia uma linha de tendência para ver o que acontece em 2027 ou 2028.

Apresentador: Como avaliações de estados-nação?

Douglas: Sim, por exemplo, você precisa dividir a economia do seu país em todos os empregos e então se perguntar: se um modelo pode fazer todos esses trabalhos, isso significa que ele tem "inteligência" real? Você deve criar testes de avaliação, desenhar linhas de tendência e dizer: "Meu Deus, o que acontecerá em 2027 ou 2028?" O próximo passo é investir maciçamente em pesquisas que tornem os modelos mais compreensíveis, orientáveis e honestos, o que chamamos de ciência do alinhamento. Uma coisa que lamento é que a maior parte do progresso neste campo veio da Frontier Labs. Mas acho que deveria ser…

Anfitrião: Outras pessoas podem participar? Por exemplo, Claude pode ser usado para fazer pesquisas relevantes?

Douglas: Não. Quero dizer, você ainda pode fazer um progresso tremendo de outras maneiras. Existe um projeto chamado programa MAS, por meio do qual muitas pessoas fizeram contribuições significativas para a pesquisa de alinhamento, especialmente interpretabilidade, tudo fora do Frontier Labs. Acredito que mais universidades deveriam se envolver nisso. De muitas maneiras, isso está mais próximo da ciência pura: é o estudo da "biologia" e da "física" dos modelos de linguagem.

Anfitrião: Mas sinto que o entusiasmo pela pesquisa nesta área não é muito alto.

Douglas: Não tenho certeza. Ouvi dizer que em algumas conferências recentes, como a ICML, o workshop sobre interpretabilidade mecanicista não foi incluído, o que é completamente incompreensível para mim. Na minha opinião, esta é a exploração científica mais pura do "mecanismo interno do modelo". Se você quiser descobrir a estrutura helicoidal do DNA, ou descobrir a teoria da relatividade geral como Einstein fez, então o caminho correspondente na árvore tecnológica do aprendizado de máquina/inteligência artificial é estudar a interpretabilidade mecânica.

Apresentador: Vamos falar sobre o lado positivo. Já dissemos antes que todos os empregos de colarinho branco serão automatizados nos próximos anos, mas de que maneiras você acha que fomos subestimados?

Douglas: Sim, os modelos definitivamente automatizarão empregos de colarinho branco, mas estou surpreso com o quão lento o mundo tem sido para integrar essas tecnologias. Mesmo que as capacidades do modelo não melhorem mais, as capacidades existentes já podem desbloquear um enorme valor econômico, mas ainda não reestruturamos verdadeiramente os fluxos de trabalho em torno desses modelos. Mesmo que o modelo permaneça o mesmo, podemos mudar completamente o mundo.

Douglas: Isso exige que invistamos em áreas que podem realmente tornar o mundo um lugar melhor, como promover a gestão suficiente e eficiente dos recursos materiais, expandir os limites da física e da indústria do entretenimento e permitir que modelos nos ajudem a atingir esses objetivos. Minha maior esperança é tornar as pessoas mais criativas e capazes de improvisar mais conteúdo, como séries de TV, videogames, etc. As pessoas serão muito mais capacitadas e o futuro terá infinitas possibilidades. Embora o modelo substitua alguns empregos, todos terão maior influência e o modelo de trabalho da sociedade passará por mudanças tremendas.

Apresentador: O que você acha que é superestimado e o que é subestimado no círculo da IA atualmente?

Douglas: Certo, vamos falar primeiro dos subestimados. Acho que os modelos mundiais são muito legais, mas não falamos muito sobre eles hoje. Com o avanço da tecnologia AR/VR, os modelos poderão gerar mundos virtuais diretamente, o que proporcionará uma experiência chocante.

Apresentador: Isso requer um certo nível de compreensão da física, como causa e efeito, que ainda não alcançamos, certo?

Douglas: Acho que provamos até certo ponto que o modelo tem a capacidade de entender a física. Você pode ver isso em avaliações que tratam de problemas de física, bem como em alguns modelos de vídeo. Por exemplo, vi um ótimo vídeo em que alguém tinha um modelo de geração de vídeo que colocava um tubarão de Lego debaixo d'água. Ele simulava como a luz refletia na superfície dos blocos de Lego, e as sombras eram colocadas no lugar correto. Este é um cenário completamente novo que o modelo nunca viu antes e é uma generalização completa. Essa é uma capacidade abrangente de modelagem física, certo?

Apresentador: Você disse que mesmo que o modelo esteja estagnado agora, ainda pode haver um grande número de aplicativos desenvolvidos. Quais áreas são mais subvalorizadas e inexploradas?

Douglas: O campo da engenharia de software é maduro, e os modelos são muito bons em programação. Em quase todos os outros campos, como direito, contabilidade, etc., ainda há muito espaço para desenvolvimento. Especialmente para a aplicação de agentes inteligentes, ainda não existe um sistema real de operação assíncrona. Outras áreas são vazias e valem a pena explorar.

Moderador: As pessoas costumam dizer que a programação é a direção de aplicação ideal para esses modelos.

Douglas: Sim, é um indicador importante. Mas você deve esperar que outras áreas sigam o exemplo.

Apresentador: Lembro que você postou uma foto sua na Cidadela. Do que se trata?

Douglas: Era um jogo de guerra que convidava agências de inteligência e cadetes de academias militares para simular a chegada da AGI e da poderosa IA e discutir seu impacto geopolítico.

Apresentador: Depois dessa experiência, você ficou mais assustado ou aliviado?

Douglas: Um pouco mais assustado, para ser sincero.

Apresentador: Você acha que já existem simulações sérias suficientes desse tipo sendo feitas hoje em dia?

Douglas: Não o suficiente. Muitas pessoas subestimaram a velocidade do desenvolvimento tecnológico nos próximos anos e não estavam preparadas. Mesmo que você ache que algo tem apenas 20% de chance de acontecer, você deve estar preparado para isso. Ainda há muito espaço para melhorias na eficiência de cada elo técnico, e metas futuras são quase certas.

Apresentador: Assim como agora quase todos os povos antrópicos atingiram um nível de confiança de 90%?

Douglas: Quase todos os membros da equipe estão muito confiantes de que poderemos alcançar "trabalhadores remotos da IA integrada (AGI) plug-and-play" até 2027. Mesmo aqueles com menos confiança estimam a probabilidade em 10-20%. Portanto, o governo deve fazer disso uma prioridade e pensar cuidadosamente sobre seu impacto social. Mas, atualmente, esse senso de urgência está longe de ser suficiente.

#Bem-vindo a seguir a conta pública oficial do iFanr no WeChat: iFanr (ID do WeChat: ifanr), onde mais conteúdo interessante será apresentado a você o mais breve possível.