Transcrição da entrevista de 20.000 palavras de Jen-Hsun Huang: Espero que a Nvidia tenha 50.000 funcionários e 100 milhões de assistentes de IA

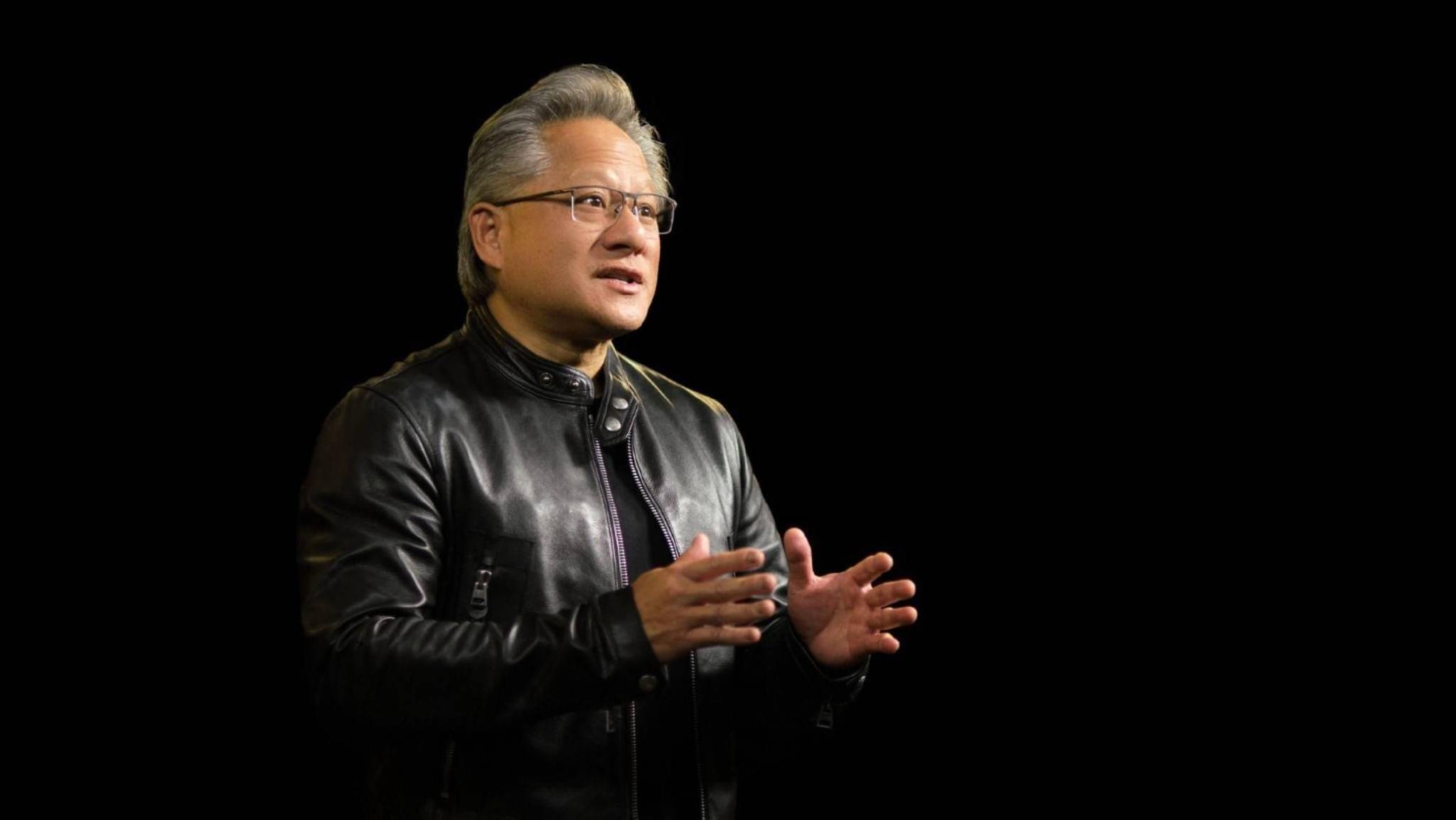

O CEO da NVIDIA, Jen-Hsun Huang, visitou recentemente o diálogo quinzenal "Open Source" e discutiu com Brad Gerstner e Clark Tang, parceiro da Altimeter, o tema de promover o desenvolvimento da inteligência em direção à inteligência artificial geral (AGI) .

Tendo estado profundamente envolvido no campo da IA e da aprendizagem automática durante muitos anos, a avaliação de Huang Renxun sobre o estado atual e as perspectivas do desenvolvimento da IA é certeira: Esta é uma revolução completa.

O raciocínio está experimentando um crescimento explosivo, a demanda por modelos de código aberto está crescendo e a infraestrutura de IA totalmente compatível está sendo constantemente implementada… Nesta era de popularidade da IA, Huang Renxun tem uma ideia ousada, esperando que a NVIDIA tenha 50.000 funcionários e 100 milhões de assistentes de IA no futuro.

Quando se trata das barreiras competitivas e do posicionamento da NVIDIA no mundo atual da IA, Huang Jen-Hsun está muito confiante em suas próprias vantagens e tem ambições consideráveis: a NVIDIA é a melhor em algoritmos e nossa missão é construir uma IA onipresente para o novo mundo. plataforma de computação.

É claro que, ao contrário da competição por quotas de mercado, esta ambição tem apenas a ver com “ exploração ”.

Numa entrevista que durou quase uma hora e meia, Huang fez uma análise precisa de como a aprendizagem automática está a remodelar o mundo da computação, como a IA está a provocar uma revolução tecnológica sem precedentes e, em última análise, a desencadear uma enorme onda de revolução. Além disso, tópicos como segurança de IA e controvérsias de código aberto também são abordados.

Por baixo da jaqueta de couro aparentemente fria está a apaixonada intenção original de Huang Renxun para o campo da IA: Levarei a sério meu trabalho, minhas responsabilidades, minha contribuição social e a era em que vivemos.

A densidade de informações desta entrevista é bastante alta e a discussão sobre a indústria de IA é aprofundada sem precedentes.

Link do vídeo da entrevista original:

Resumimos brevemente os principais pontos de Huang Jenxun nesta entrevista, da seguinte forma:

- Assistentes pessoais de IA aparecerão em breve e continuarão a evoluir com o tempo;

- Passamos da programação humana para o aprendizado de máquina, com inovação e crescimento acontecendo em toda a pilha de tecnologia;

- Promover a evolução acelerada da IA exige acelerar todas as partes do “volante”;

- O futuro da computação (desenvolvimento de aplicações) será altamente dependente da aprendizagem automática e da IA, e haverá agentes para ajudar os humanos a utilizar estas aplicações;

- A IA não substituirá os empregos, irá transformá-los e terá um impacto profundo na forma como as pessoas pensam sobre o trabalho;

- A segurança da IA é a base. Não exige necessariamente legislação separada para cada tecnologia importante, nem permite que a regulamentação seja excessivamente alargada a áreas desnecessárias;

- Deve haver um modelo de código aberto para promover a criação de IA. O código aberto é necessário para a ativação de muitas indústrias;

A seguir está o texto completo da entrevista compilada pela APPSO:

Passando da programação humana para o aprendizado de máquina

Brad Gerstner: É sexta-feira, 4 de outubro, e estamos na sede da Nvidia, na mesma rua do Altimeter. Realizaremos nossa reunião anual com investidores na segunda-feira para discutir todos os impactos da IA e nosso progresso na rapidez com que podemos dimensionar a inteligência.

Realmente não consigo pensar em pessoa melhor para iniciar esta conversa do que você, tanto como acionista quanto como nosso parceiro intelectual, e trocar ideias com você sempre nos torna mais inteligentes. Somos gratos por essa amizade, então obrigado pela visita.

Jen-Hsun Huang : Estou feliz por estar aqui.

Brad Gerstner: O tema deste ano é Estendendo a Inteligência à Inteligência Artificial Geral (AGI).

O que é chocante é que quando fizemos isso há dois anos, o tema era a era da IA, e isso foi dois meses antes do lançamento do ChatGPT. É realmente surpreendente pensar em todas essas mudanças. Então pensei que poderíamos começar com um experimento mental e talvez fazer uma previsão.

Se eu entender a inteligência artificial geral (AGI) simplesmente como um assistente pessoal no meu bolso, como eu a entendo, ela sabe tudo sobre mim, tem uma memória perfeita sobre mim, pode se comunicar comigo, pode reservar um hotel para mim, e até mesmo marcou uma consulta médica para mim. Na sua opinião, o mundo está mudando tão rápido hoje, quando você acha que poderemos ter esse tipo de assistente pessoal no bolso?

Jensen Huang: Chegará de alguma forma em breve. Esse assistente fica cada vez melhor com o tempo. Essa é a beleza da tecnologia como a conhecemos. Então acho que vai ser muito útil quando você está começando, mas não é perfeito. E então, com o tempo, fica cada vez melhor. Como toda tecnologia.

Brad Gerstner: Quando olhamos para a taxa de mudança, lembro-me de Elon dizer que a única coisa que importa é a taxa de mudança. Sentimos que o ritmo da mudança acelerou significativamente, é o ritmo de mudança mais rápido que já vimos nestas questões porque trabalhamos em IA há cerca de uma década e você está ainda há mais tempo. Este é o ritmo de mudança mais rápido que você já viu em sua carreira?

Jensen Huang: Sim, porque reinventámos a computação. Estas mudanças devem-se em grande parte ao facto de termos reduzido o custo marginal da computação num factor de 100.000 nos últimos 10 anos. Se calculado de acordo com a Lei de Moore, este processo representa uma melhoria de cerca de 100 vezes, mas conseguimos muito mais do que isso. Conseguimos isso de várias maneiras.

Primeiro, introduzimos a computação acelerada para transferir trabalho que não é eficiente da CPU para a GPU.

Em segundo lugar, inventamos uma nova precisão numérica, desenvolvemos novas arquiteturas, projetamos núcleos de integração, melhoramos a forma como os sistemas são construídos, o MVLink adicionou memória ultrarrápida (HBM) e implementamos a expansão full-stack por meio do MVLink e do InfiniBand. Basicamente, todos os detalhes que descrevi sobre a forma como a Nvidia faz as coisas contribuem para uma taxa de inovação que excede a Lei de Moore .

Agora, o que é realmente incrível é que, por causa disso, passamos da programação humana para o aprendizado de máquina.

E o mais surpreendente sobre o aprendizado de máquina é que ele aprende muito rapidamente. Assim, à medida que redefinimos como a computação é distribuída, temos muitas formas de processamento paralelo: paralelismo de tensores, paralelismo de pipeline e todos os tipos de métodos de computação paralela. Inventamos novos algoritmos e desenvolvemos novos métodos de treinamento com base nisso. Todas essas invenções tiveram um efeito combinado umas sobre as outras.

Antigamente, se você observar como a Lei de Moore funcionava naquela época, o software era estático. Ele foi projetado para existir estaticamente como um produto embalado, enquanto o hardware evolui no ritmo da Lei de Moore. Agora, toda a nossa pilha de tecnologia está crescendo e toda a pilha está inovando. Acho que esse é o status quo.

Agora, de repente, estamos vendo uma expansão incrível e, claro, uma mudança extraordinária. Mas o que estávamos falando antes eram modelos pré-treinados e escalonamento nesse nível, dobrando o tamanho do modelo, dobrando apropriadamente a quantidade de dados também.

Portanto, o poder computacional necessário aumenta quatro vezes a cada ano. Isso foi um grande negócio na época. Mas agora estamos vendo uma expansão na fase pós-treinamento, estamos vendo uma expansão também na fase de inferência, certo? As pessoas costumavam pensar que o pré-treinamento era difícil e a inferência relativamente fácil.

A ideia de que tudo está mais difícil agora é na verdade razoável, afinal seria um absurdo reduzir todo o pensamento humano a um processo único. Portanto, conceitos como pensamento rápido e pensamento lento, raciocínio, reflexão, iteração, simulação, etc. devem existir no pensamento, e agora esses conceitos estão sendo gradualmente integrados.

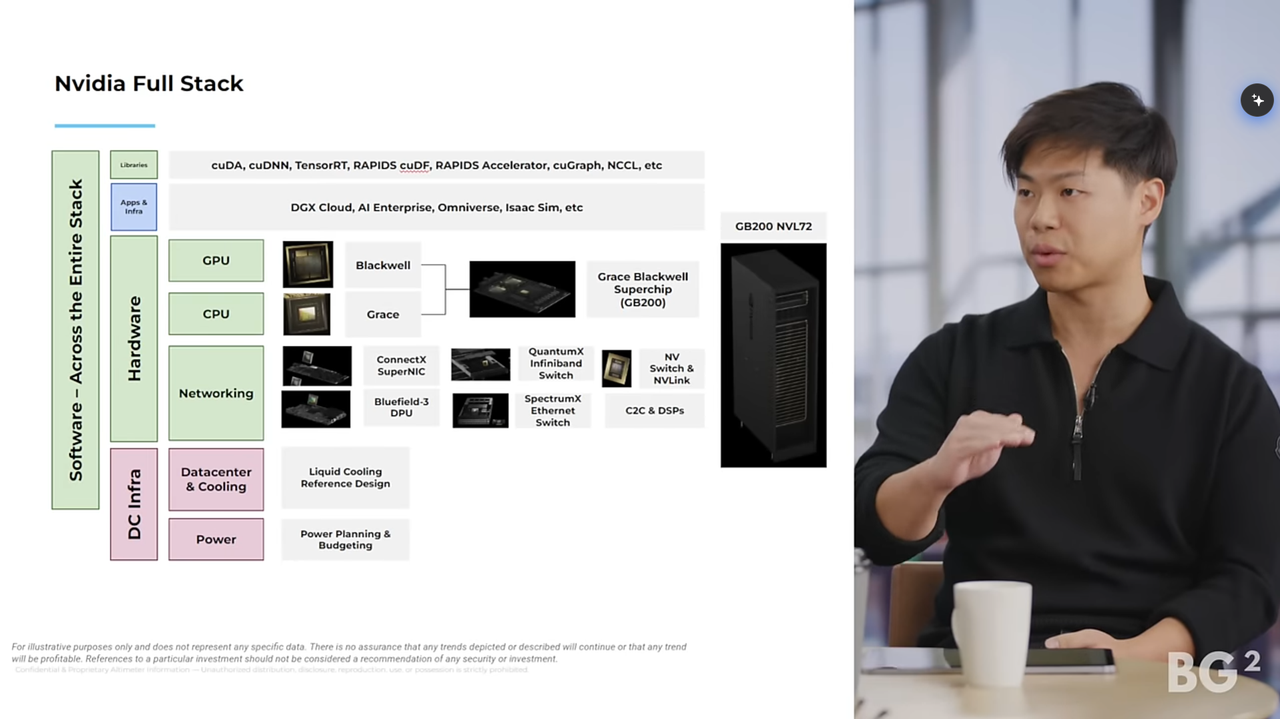

Clark Tang: Acho que uma das coisas mais incompreendidas sobre a Nvidia neste momento é o quanto de vantagem tecnológica real a Nvidia tem, certo? Acho que existe uma percepção de que quando alguém inventa um chip novo ou melhor, ele ganha.

Mas o fato é que você construiu toda a pilha de tecnologia na última década, de GPUs a CPUs e redes, especialmente software e bibliotecas que permitem que aplicativos sejam executados em plataformas NVIDIA. Você acha que a vantagem tecnológica da Nvidia é maior ou menor hoje do que era há três ou quatro anos?

Jensen Huang: Agradeço a sua consciência de que a computação mudou. Na verdade, a razão pela qual as pessoas pensavam (e muitas ainda pensam) que seria suficiente projetar um chip melhor era porque ele tinha mais floats, mais flips, bytes e bits, entende o que quero dizer? Se você olhar os slides principais, verá que eles estão cheios de operações de inversão e de ponto flutuante, bem como vários gráficos de barras, gráficos e similares.

Tudo isso é bom, quero dizer, é claro que o desempenho é importante, então basicamente importa. Infelizmente, porém, esta é uma maneira antiga de pensar. Como o software naquela época era apenas um aplicativo executado no Windows, o software era estático, o que significava que a melhor maneira de melhorar seu sistema era fabricar chips cada vez mais rápidos.

Mas percebemos que o aprendizado de máquina não é programação humana. O aprendizado de máquina não envolve apenas software, trata-se de todo o caminho dos dados. Na verdade, o volante no centro do aprendizado de máquina é a coisa mais importante. Então, como você pensa em permitir que cientistas e pesquisadores de dados trabalhem de forma eficaz dentro desse volante e, ao mesmo tempo, impulsioná-lo? E esse volante começa desde os primeiros estágios.

Muitas pessoas nem percebem que uma IA é realmente necessária para organizar dados para ensinar outra IA. E a própria IA já é bastante complexa.

▲ Assistentes pessoais de IA aparecerão de alguma forma em breve (Fonte: NITCO)

Acelere cada passo do volante

Brad Gerstner: Então está melhorando? Também está acelerando? Você sabe, quando pensamos novamente em vantagem competitiva, certo? É realmente o efeito combinado de todos esses fatores.

Jen-Hsun Huang: Absolutamente certo, precisamente por causa da IA mais inteligente para organizar os dados, agora temos até geração de dados sintéticos e várias formas diferentes de organizar e apresentar dados. Portanto, antes de você treinar, já há muito processamento de dados envolvido. E as pessoas sempre pensam no PyTorch como o começo e o fim do mundo inteiro.

É muito importante, mas não se esqueça que há muito trabalho antes de usar o PyTorch e muito trabalho depois de usar o PyTorch. E a ideia de um volante é na verdade a maneira como você deve pensar sobre isso. Você sabe, como devo pensar sobre todo esse volante? Como projetar um sistema de computação, uma arquitetura de computação, que ajude você a fazer esse volante funcionar da maneira mais eficiente possível? Essa não é uma etapa única de aplicação do treinamento, certo? Este é apenas um passo, ok?

Cada passo do volante é difícil, então a primeira coisa que você deveria pensar não é como fazer o Excel rodar mais rápido, ou como fazer o Doom rodar mais rápido, essa é a maneira antiga de fazer as coisas, certo?

Agora tudo que você precisa pensar é como tornar esse volante mais rápido. E há muitas etapas diferentes neste volante e, como você sabe, nada no aprendizado de máquina é simples, e nada é simples sobre o que o OpenAI faz, ou o que o X faz, ou o que a equipe Gemini e a DeepMind fazem.

Então decidimos: é nisso que você realmente deveria pensar. Este é todo o processo e você precisa acelerar cada parte. Você tem que respeitar a lei de Amdahl. A lei de Amdahl vai te dizer que se essa parte demorar 30% do tempo e eu acelerar 3 vezes, eu realmente não acelero muito todo o processo, entendeu?

Você realmente precisa criar um sistema que acelere cada etapa, e somente acelerando todo o processo você pode realmente melhorar significativamente o tempo de ciclo, e esse volante da taxa de aprendizado é, em última análise, o que leva ao crescimento exponencial.

O que estou dizendo é que a perspectiva de uma empresa se reflete em seus produtos. Observe que continuo falando sobre esse volante.

Clark Tang: Você quer dizer o ciclo inteiro.

Jensen Huang: Isso mesmo, e estamos acelerando tudo agora. O foco principal agora é o vídeo. Muitas pessoas estão se concentrando em IA física e processamento de vídeo. Basta pensar no front-end: terabytes de dados entram no sistema a cada segundo. Dê-me um exemplo de como funciona o pipeline de processamento desses dados, desde a ingestão de dados até a preparação para o treinamento, e tudo isso é acelerado por CUDA.

Clark Tang: Agora as pessoas estão pensando apenas em modelos de texto, mas no futuro também incluirão modelos de vídeo e também usarão alguns modelos de texto, como o1, para processar uma grande quantidade de dados antes de iniciarmos o processamento.

Jen-Hsun Huang: Os modelos de linguagem envolverão todas as áreas. A indústria gasta muita tecnologia e esforço treinando modelos de linguagem para treinar esses grandes modelos de linguagem. Agora usamos menor custo computacional em cada etapa. Isto é verdadeiramente notável.

Brad Gerstner: Não quero simplificar demais, mas é uma pergunta que ouvimos muito dos investidores, certo? Sim, mas e os chips personalizados? Sim, mas será que as suas barreiras competitivas serão derrubadas como resultado?

O que ouço você dizer é que neste sistema combinado as vantagens aumentam com o tempo. Então, ouço você dizer que estamos em maior vantagem hoje do que há três ou quatro anos, porque estamos melhorando todos os componentes. E esse efeito combinado significa, como um estudo de caso de negócios, que a Intel costumava ser dominante na pilha de tecnologia, e onde você está hoje em relação a eles?

Talvez apenas um rápido resumo e compare sua vantagem competitiva hoje com o que era no auge.

Jensen Huang: A Intel é extraordinária. A Intel é extraordinária porque foi provavelmente a primeira empresa extremamente boa em engenharia e produção de processos de fabricação, e o próximo passo além do processo de fabricação é projetar chips, certo? Eles projetaram os chips, construíram a arquitetura x86 e continuam a fabricar chips x86 mais rápidos. Esta é a inteligência deles. Eles combinam isso com processos de fabricação.

Nossa empresa é um pouco diferente porque reconhecemos que o processamento paralelo não exige, de fato, que todos os transistores sejam perfeitos. O processamento serial exige que cada transistor seja perfeito, enquanto o processamento paralelo requer um grande número de transistores para obter maior economia.

Prefiro ter 10 vezes mais transistores e ser 20% mais lento do que ter 10 vezes menos transistores e ser 20% mais rápido. Você entende? Eles preferem o oposto, portanto, o desempenho de thread único e o processamento de thread único são muito diferentes do processamento paralelo. Assim, percebemos que o nosso mundo não se trata realmente de fazer melhor. Queremos ser os melhores possíveis, mas o que realmente importa ao nosso mundo é melhorar.

Computação paralela, processamento paralelo é difícil porque cada algoritmo precisa ser refatorado e redesenhado de maneiras diferentes dependendo da arquitetura. O que as pessoas não percebem é que você pode ter três CPUs diferentes, cada uma com seu próprio compilador C, e pode compilar software para o ISA (arquitetura de conjunto de instruções) correspondente. Isso não é possível na computação acelerada, nem na computação paralela.

A empresa que desenvolveu a arquitetura teve que desenvolver seu próprio OpenGL. Então revolucionamos o aprendizado profundo porque tínhamos uma biblioteca específica de domínio chamada CUDNN. Sem CUDNN, não haveria aprendizagem profunda hoje.

Ninguém fala sobre CUDNN porque é uma camada abaixo do PyTorch e do TensorFlow. No início havia Caffe e Theano, agora existe Triton e existem muitas estruturas diferentes. Essa biblioteca específica de domínio, como CUDNN, e Optics, uma biblioteca específica de domínio chamada CuQuantum, Rapids e muitas outras.

Brad Gerstner: Os algoritmos específicos do setor estão abaixo da camada PyTorch na qual todos estão se concentrando. Por exemplo, muitas vezes ouço pessoas dizerem que se não existissem essas bibliotecas subjacentes…

Jensen Huang: Se não o tivéssemos inventado, nenhuma das aplicações de nível superior seria capaz de funcionar. Você entende o que estou dizendo? Matematicamente falando, a NVIDIA é realmente boa em algoritmos, que combinam ciência de nível superior e arquitetura de nível inferior.

▲Huang Renxun em entrevista

Entramos na era do raciocínio

Clark Tang: Agora toda a atenção está finalmente voltada para o raciocínio. Mas lembro que há dois anos Brad e eu jantamos com você e fizemos uma pergunta: você acha que a vantagem tecnológica da Nvidia será tão forte na inferência quanto no treinamento?

Jensen Huang: Eu definitivamente disse que seria mais forte.

Clark Tang: Você acabou de mencionar vários fatores, como combinações modulares e diferentes combinações de montagens, que às vezes não entendemos completamente. É importante que os clientes tenham flexibilidade para alternar entre eles. Mas você poderia falar um pouco mais sobre isso agora que entramos na era do raciocínio?

Jen-Hsun Huang: Raciocínio é um treinamento de raciocínio em larga escala, certo? Então, se você treinar bem, é provável que seu raciocínio também seja bom. Se você treinar nesta arquitetura sem nenhum ajuste, ele poderá rodar nesta arquitetura.

Claro, você ainda pode otimizar para outras arquiteturas, mas pelo menos, como já foi construído na arquitetura da NVIDIA, ele será executado na arquitetura da NVIDIA.

O outro aspecto, claro, é o aspecto do investimento de capital. Ao treinar um novo modelo, você desejará usar os melhores e mais recentes equipamentos para treinamento, o que deixará para trás os equipamentos que já foram usados. E esses dispositivos são ótimos para inferência. Portanto, haverá um caminho de dispositivo livre.

Por trás da nova infraestrutura está uma cadeia de dispositivos de infraestrutura gratuitos compatíveis com CUDA. Por isso somos muito rigorosos para garantir a compatibilidade ao longo de todo o processo para que os equipamentos que deixamos ainda possam manter um excelente desempenho.

Ao mesmo tempo, também investimos muita energia na reinvenção constante de novos algoritmos para garantir que, quando chegar a hora, o desempenho da arquitetura Hopper seja 2 a 4 vezes maior do que quando foi adquirida pela primeira vez, para que a infraestrutura pode continuar a permanecer eficiente.

Então, todo o trabalho que fazemos em termos de melhoria de novos algoritmos, novos frameworks, não só ajuda cada uma de nossa infraestrutura instalada, Hopper é melhor para isso, Ampere é melhor para isso, e até Volt é melhor para isso.

Lembro que Sam acabou de me dizer que recentemente eles retiraram sua infraestrutura Volt do OpenAI. Então, acho que deixamos vestígios dessas infraestruturas instaladas. Tal como acontece com toda infraestrutura de computação, é importante instalar a infraestrutura.

Os produtos da NVIDIA estão em todas as nuvens, no local e em todos os dispositivos de borda. Portanto, o modelo de linguagem visual Vela criado na nuvem pode funcionar perfeitamente no robô de ponta sem modificação. Subjacente a tudo isso está o CUDA. Então, acho que o conceito de compatibilidade arquitetônica é muito importante para projetos grandes. Isso não é diferente do conceito de compatibilidade para iPhones ou outros dispositivos.

Acho que a instalação de infraestrutura é muito importante para a inferência, mas o que realmente nos beneficia é que, como treinamos esses grandes modelos de linguagem em novas arquiteturas, somos capazes de pensar em como criar arquiteturas de inferência muito boas no futuro.

Então, estivemos pensando em modelos iterativos e modelos de inferência, como criar uma experiência de inferência muito interativa para seu agente pessoal, como interagir com você rapidamente quando ele precisar parar e pensar um pouco.

Então, como podemos conseguir isso? A resposta é NVLink. Você sabe, o NVLink nos permite utilizar esses sistemas que são adequados para treinamento, mas quando o treinamento é concluído, seu desempenho de inferência também é muito bom. O que você deseja otimizar é o tempo de resposta do primeiro token, e atingir o tempo de resposta do primeiro token é muito difícil porque requer muita largura de banda.

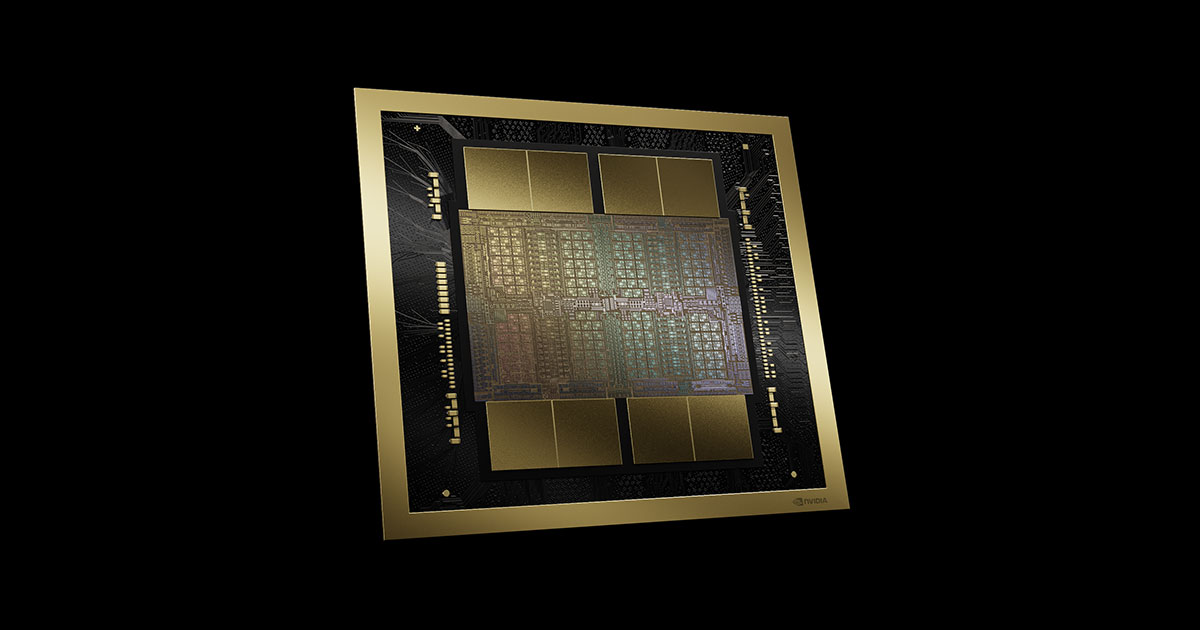

Se o seu contexto também for muito rico, você também precisará de muito poder computacional. Portanto, você precisa de largura de banda e poder de computação ilimitados ao mesmo tempo para atingir um tempo de resposta de alguns milissegundos. E este tipo de arquitetura é muito difícil de implementar. Por esta razão, inventamos Grace Blackwell NVLink.

▲ Arquitetura NVIDIA Blackwell (Fonte: NVIDIA)

A NVIDIA está construindo uma infraestrutura de IA completa e compatível

Brad Gerstner: Sabe, jantei com Andy Jassy no início desta semana e Andy disse: "Temos Tranium e Inferencia chegando." Acho que a maioria das pessoas ainda acha que isso é um desafio para a Nvidia.

Mas então ele disse: “A Nvidia é um parceiro muito importante para nós e continuará a ser um parceiro muito importante para nós no futuro, pelo menos no futuro que posso prever”.

O mundo funciona com NVIDIA, certo? Então, quando você pensa sobre esses ASICs personalizados sendo desenvolvidos para aplicações específicas, como os aceleradores de inferência da Meta, ou Tranium da Amazon, ou TPUs do Google, e a escassez de fornecimento que você está enfrentando atualmente, esses fatores mudam a dinâmica entre vocês, ou são apenas. complementar ao seu sistema?

Jensen Huang: Estamos apenas a fazer coisas diferentes, estamos a tentar alcançar objetivos diferentes. A NVIDIA está tentando construir uma plataforma de computação para este novo mundo, este mundo de aprendizado de máquina, este mundo de IA generativa, este mundo de IA de agente.

O que queremos criar é que, após 60 anos de computação, reinventámos toda a pilha de computação, desde a forma como a programação à aprendizagem automática, desde a forma como o software é processado das CPUs até às GPUs, desde a forma como o software é aplicado à inteligência artificial, certo? Ferramentas de software, inteligência artificial – todos os aspectos da pilha de computação, todos os aspectos da pilha de tecnologia mudaram.

O que queremos fazer é criar uma plataforma de computação onipresente, e é aí que reside a complexidade do nosso trabalho. Se você pensar no que estamos fazendo, estamos construindo uma infraestrutura completa de IA e pensamos nela como um computador.

Já disse antes que o data center é hoje a unidade fundamental da computação. Para mim, quando penso num computador, não estou pensando no chip, estou pensando no conceito: é o meu modelo mental dele, com todo o software, toda a programação, todas as peças mecânicas. Esta é a minha missão, este é o meu computador, e tentamos construir um computador totalmente novo todos os anos.

Sim, isso é uma loucura, ninguém fez isso antes. Todos os anos tentamos construir um computador completamente novo e todos os anos oferecemos melhorias de desempenho duas a três vezes maiores. Todos os anos reduzimos os custos duas a três vezes e todos os anos melhoramos a eficiência energética duas a três vezes.

Por isso a gente fala para nossos clientes, não compre todos os equipamentos de uma vez, compre um pouquinho todo ano, ok? A razão é que queremos que eles possam avançar para um futuro onde todas as arquiteturas sejam compatíveis, ok?

Agora, construir esta plataforma neste ritmo é muito difícil, e o que é duplamente difícil é que não estamos apenas vendendo infraestrutura ou serviços, estamos desmontando-os e integrando-os ao GCP, integrando-os ao AWS, integrados ao Azure. , integrado a outras plataformas, sabe?

A integração é diferente para cada plataforma. Temos que integrar todas as bibliotecas arquitetônicas, todos os algoritmos e todas as estruturas em seus sistemas. Integramos nossos sistemas de segurança nos sistemas deles, integramos nossas redes nos sistemas deles, certo? E então fazemos cerca de 10 dessas integrações por ano. E é aqui que reside a magia.

Brad Gerstner: Essa é a mágica, por quê? Quero dizer, é uma loucura. É uma loucura que você faça isso todos os anos. Pense bem, o que te leva a fazer isso todos os anos?

E voltando a isso, você sabe que Clark acabou de voltar de Taiwan, Coréia e Japão e se encontrou com todos os seus parceiros fornecedores – aqueles com quem você mantém relacionamento há mais de dez anos. Qual a importância destas parcerias para o efeito combinado de construção dessa barreira competitiva?

Jen-Hsun Huang: Sim, quando você o decompõe sistematicamente, e quanto mais você o decompõe, é surpreendente como todo o ecossistema da indústria eletrônica está comprometido em trabalhar conosco hoje para, em última análise, construir este cubo de computador e montá-lo em todos os diferentes ecossistemas? E a coordenação é tão perfeita. Obviamente, passamos a API, a metodologia, o processo de negócios e as regras de design para trás, e passamos a metodologia, a arquitetura e a API para frente.

Brad Gerstner: Estes foram fortificados há décadas.

Jen-Hsun Huang : Foi fortalecido há décadas e também está em constante evolução. Mas estas APIs têm de ser integradas quando necessário – todas estas coisas que são fabricadas em Taiwan e em todo o mundo acabam nos centros de dados do Azure. Eles vão se encaixar.

Clark Tang: Alguém simplesmente chama a API OpenAI e ela funciona.

Jen -Hsun Huang: Sim, é uma sensação totalmente maluca. Foi isto que inventámos, inventámos esta enorme infra-estrutura informática e o mundo inteiro está a construí-la connosco.

Está integrado em tudo, você pode vendê-lo através da Dell, pode vendê-lo através da HPE, está hospedado na nuvem e se estende a dispositivos de ponta. As pessoas estão usando-o em sistemas robóticos agora, estão usando-o em robôs humanóides, estão usando-o em carros autônomos, todos são arquitetonicamente compatíveis, o que é realmente uma loucura.

Clark, não quero que você pense que não respondi à sua pergunta. Na verdade, respondi. Estou me referindo a isso em relação ao seu ASIC.

Nós, como empresa, estamos apenas fazendo coisas diferentes. Como empresa, queremos ter uma compreensão clara do meio ambiente. Conheço muito bem tudo que envolve a nossa empresa e seu ecossistema, certo?

Conheço todas as pessoas que estão fazendo coisas diferentes e o que estão fazendo. Às vezes é um confronto para nós, às vezes não. Eu sei disso muito bem. Mas isso não muda os objetivos da nossa empresa. O único objetivo da empresa é construir uma plataforma arquitetônica que possa ser usada em qualquer lugar, e esse é o nosso objetivo.

Não estamos tentando tirar participação de mercado de ninguém. A NVIDIA é pioneira no mercado, não uma concorrente em ações. Se você olhar nossos relatórios corporativos, verá que nunca falamos sobre participação de mercado. Nunca falamos sobre participação de mercado dentro da empresa.

Todas as nossas discussões foram sobre como podemos criar a próxima coisa? Como resolvemos o próximo problema no volante? Como podemos fazer melhor pelas pessoas? Como podemos reduzir um ciclo volante que costumava levar um ano para apenas um mês? Você sabe, essa é a velocidade da luz para um volante, certo? Estamos pensando em todas essas questões diferentes, mas uma coisa é certa, estamos cientes de tudo ao nosso redor, mas temos muita clareza sobre a nossa missão.

A única questão é se esta missão é necessária e significativa. Todas as grandes empresas deveriam ter esta missão.

Fundamentalmente, a questão é o que você está fazendo? A única questão é: é necessário, é valioso, tem impacto e pode ajudar outras pessoas? Tenho certeza de que se você é um desenvolvedor, uma startup generativa de IA, decidindo como se tornar uma empresa, a única escolha que você não precisa considerar é qual ASIC suportar.

Se você oferece suporte apenas a CUDA, poderá usá-lo em qualquer lugar e sempre poderá mudar de ideia mais tarde, mas somos o ponto de entrada no mundo da IA, não somos? Depois de decidir aderir à nossa plataforma, outras decisões podem ser adiadas e você sempre poderá desenvolver seu próprio ASIC mais tarde, e não nos importamos.

Quando trabalho com o GCP, empresas como GCP, Azure, mostramos nosso roteiro com anos de antecedência. Eles não vão nos mostrar seu roteiro ASIC e isso não vai nos ofender, ok? Se seus objetivos forem claros e significativos e sua missão for importante para você e para os outros, você poderá ser transparente.

Observe que meu roteiro é público no GTC, enquanto meu roteiro será mais aprofundado com parceiros como Azure, AWS, etc. Não temos nenhuma dificuldade com eles, embora estejam desenvolvendo seus próprios ASICs.

▲ A missão da NVIDIA é construir uma infraestrutura de IA completa e compatível (Fonte: The Brand Hopper)

A IA está mudando o futuro da indústria

Brad Gerstner: Acho que quando as pessoas olham para a indústria, você disse recentemente que a demanda pela Blackwell é “louca”. Você também diz que a parte mais difícil do seu trabalho é suportar o fardo emocional de dizer “não” às pessoas em um mundo onde os recursos computacionais são escassos.

Mas os críticos dizem que este é apenas um momento no tempo e acreditam que será uma experiência de altos e baixos, tal como a construção excessiva de fibra óptica pela Cisco em 2000. Sabe, penso que quando estávamos jantando juntos no início de 2023, a previsão era que a receita da Nvidia em 2023 chegaria a US$ 26 bilhões, mas na verdade você faturou US$ 60 bilhões, certo?

Jensen Huang: Admita, esta é a maior falha de previsão que o mundo já viu.

Brad Gerstner: Estávamos particularmente entusiasmados naquela época, em novembro de 2022, porque pessoas como Mustafa, da Inflection, e Noam, da Character, vieram ao nosso escritório para discutir o investimento em suas empresas. Eles disseram, se você não pode investir diretamente em nossa empresa, então compre a Nvidia, porque o mundo está lutando para conseguir os chips da Nvidia para construir os aplicativos que vão mudar o mundo.

É claro que com o surgimento do ChatGPT esse “momento cambriano” chegou. Porém, mesmo assim, esses 25 analistas ainda estão obcecados com o “inverno criptográfico” e não conseguem imaginar o que está acontecendo no mundo, certo? Portanto, o resultado final superou em muito as expectativas.

Você deixou claro que a demanda pela Blackwell é insana e continuará sendo. É claro que o futuro é desconhecido e incognoscível, mas porque é que os críticos estão tão errados? Esta não será uma situação exagerada como a da Cisco em 2000.

Jensen Huang: A melhor forma de pensar no futuro é raciocinar a partir dos primeiros princípios, certo? Portanto, a questão é: qual é a razão para o que estamos fazendo agora? Primeiro, o que estamos fazendo? O que estamos fazendo? Estamos reinventando a computação, não estamos?

Acabamos de dizer que o futuro da computação será altamente dependente do aprendizado de máquina, certo? Quase todos os nossos aplicativos, sejam Word, Excel, PowerPoint, Photoshop, Premiere, AutoCAD, você me cita qualquer exemplo, todos eles são projetados à mão. Garanto a você que isso dependerá muito do aprendizado de máquina no futuro, certo?

E, além dessas ferramentas, você terá agentes para ajudá-lo a utilizá-las.

Então, agora é um fato, certo? Reinventamos a computação e não olhamos para trás. Toda a pilha de tecnologia computacional está sendo redefinida.

Ok, agora que chegamos a este ponto, estamos dizendo que o software será diferente, a forma como o software é escrito será diferente, a forma como o software será usado será diferente. Então, vamos admitir que esses são meus fatos básicos. Sim, então a questão é: o que acontece a seguir?

Então, vamos revisar como os cálculos eram feitos no passado. Temos um trilhão de dólares em equipamentos de informática. Se você olhar para o data center do passado, abrir a porta e olhar para ele, você diria que esses são os computadores que deseja usar para enfrentar o futuro? A resposta é não.

Você vê essas CPUs, sabemos o que elas podem e o que não podem fazer. Sabemos também que existem hoje centros de dados no valor de um bilião de dólares que necessitam de modernização. Então, neste momento, se vamos modernizar nos próximos quatro ou cinco anos, isso é completamente razoável e sensato.

Brad Gerstner: Temos conversado com pessoas que precisam se modernizar, e elas estão se modernizando com GPUs, sim.

Jensen Huang: Quer dizer, vamos fazer uma hipótese. Você tem US$ 50 bilhões em investimentos, você vai escolher a opção A: construir investimentos para o futuro, ou a opção B: construir investimentos de acordo com os padrões do passado? Você ultrapassou o capex e ele está parado e não vai melhorar de qualquer maneira.

A Lei de Moore essencialmente acabou, então por que reconstruí-la? Só precisamos investir esses US$ 50 bilhões em IA generativa, certo? Sua empresa ficará melhor assim. Então, quanto dos 50 bilhões você investirá? Eu colocaria 100% dos 50 mil milhões nisso porque tenho uma infra-estrutura com quatro anos.

Então agora, a partir dos primeiros princípios, você está apenas raciocinando a partir dessa perspectiva, e é exatamente isso que eles estão fazendo. Pessoas inteligentes fazem coisas inteligentes.

Agora, a segunda parte é esta: temos um trilião de dólares de capacidade para construir, certo? Um trilião de dólares em infra-estruturas, talvez 150 mil milhões de dólares investidos, certo? Portanto, vamos construir um trilião de dólares em infra-estruturas nos próximos 4 a 5 anos.

A segunda coisa que observamos é que a forma como o software é escrito é diferente, e a forma como o software será usado no futuro será diferente. Teremos agentes inteligentes, não é?

Teremos funcionários digitais em nossa empresa, e eles estarão na sua caixa de entrada, e no futuro, esses pontinhos, esses pequenos avatares se tornarão ícones da IA, certo? Vou enviar-lhes tarefas. Não programo mais em C++, uso palavras de alerta para “programar” IA, certo? Isso não é diferente de quando escrevi vários e-mails esta manhã.

Dei instruções à minha equipe, certo? Descrevi o contexto, declarei as limitações básicas do que sabia e descrevi sua missão. Dou-lhes orientação suficiente para entenderem o que preciso e quero ser o mais claro possível sobre os resultados esperados. Mas também deixo espaço para a criatividade para que eles possam me surpreender, certo?

Isso não é diferente de como eu aciono a IA hoje, é exatamente assim que aciono a IA. Portanto, além da nossa infra-estrutura modernizada, haverá uma infra-estrutura totalmente nova. Essa nova infraestrutura é a fábrica de IA que irá operar esses humanos digitais, e eles funcionarão 24 horas por dia.

Vamos tê-los em todas as empresas do mundo, vamos tê-los nas nossas fábricas, vamos tê-los nos nossos sistemas automatizados, certo? Portanto, o mundo precisa construir toda uma camada de estruturas computacionais, o que chamo de infraestrutura de fábrica de IA, que ainda não existe.

Então a questão é: quão grande é isso? Ainda não sabemos, mas pode chegar a trilhões de dólares, mas a beleza é que a arquitetura modernizada do data center é igual à arquitetura da fábrica de IA.

Brad Gerstner: Essa é a beleza. Você deixou bem claro que tem um trilhão de dólares em infraestrutura legada que precisa ser modernizada e que tem pelo menos um trilhão de dólares em novas cargas de trabalho de IA chegando, o que representa cerca de US$ 125 bilhões em receitas este ano.

Você sabe, lhe disseram que esta empresa nunca valeria mais do que US$ 1 bilhão. E agora você está sentado aqui, se você contabiliza apenas 125 bilhões em receitas do mercado total (TAM) de vários trilhões, que razão o faz pensar que sua receita futura não será 2 ou 3 vezes maior do que é agora? Existe alguma razão pela qual sua renda não continuará a crescer?

Jensen Huang: Não, está certo. Você sabe, não se trata do presente. A empresa é limitada apenas pelo tamanho do “lago”, você sabe, os peixinhos dourados só podem crescer para corresponder ao tamanho do lago.

Então a questão é: quão grande é o nosso lago? Isto requer muita imaginação, e é por isso que os pioneiros do mercado pensam no futuro, em vez de apenas competir no mercado existente.

É difícil ver claramente o futuro se você estiver apenas olhando para o passado e tentando conquistar participação de mercado. Os concorrentes em termos de participação de mercado só podem crescer até certo ponto, enquanto os pioneiros do mercado podem crescer muito. Então, acho que o que há de bom em nossa empresa é que tivemos que criar um espaço de mercado para nós mesmos desde o primeiro dia.

As pessoas não perceberam isso na época, mas criamos o mercado de PCs para jogos 3D quase do zero. Basicamente inventámos este mercado e todos os ecossistemas associados, incluindo o ecossistema das placas gráficas. Nós inventamos tudo. Portanto , criar um mercado totalmente novo para atender isso é algo que nos é muito familiar.

▲Brad Gerstner (esquerda) e Clark Tang (direita) na entrevista

OpenAI e X.AI incríveis

Brad Gerstner: Sim, isso é verdade para alguém que inventou um novo mercado. Vamos mudar um pouco de assunto e falar sobre modelos e OpenAI. Você sabe, a OpenAI arrecadou US$ 6,5 bilhões esta semana, avaliando-a em cerca de US$ 150 bilhões. Todos nós participamos desse financiamento.

Jen -Hsun Huang: Estou muito feliz por eles. Estou muito feliz que tudo deu certo. Sim, eles fizeram um ótimo trabalho e a equipe fez um ótimo trabalho.

Brad Gerstner: Há relatos de que sua receita ou taxa de receita é de cerca de US$ 5 bilhões este ano e pode chegar a US$ 10 bilhões no próximo ano. Se você observar o tamanho da empresa hoje, sua receita é aproximadamente o dobro da que o Google obteve em seu IPO.

Eles têm 250 milhões de usuários ativos semanais, o que estimamos ser o dobro do número de usuários no IPO do Google. E se você olhar para seu múltiplo de negócios, se você acredita que eles podem atingir US$ 10 bilhões em receita no próximo ano, então seu valor de mercado será cerca de 15 vezes a receita do próximo ano, que é aproximadamente o mesmo múltiplo que Google e Meta tiveram em seus IPOs, certo? ? Isso é bastante surpreendente quando você considera que esta empresa não tinha receita nem usuários ativos semanais há 22 meses.

Jensen Huang: Brad tem uma compreensão fantástica da história.

Brad Gerstner: Quando você pensar sobre isso, fale conosco sobre a OpenAI como sua parceira e como ela é importante para conscientizar o público e usar a IA.

Jensen Huang: Bem, esta é uma das empresas mais influentes do nosso tempo. Esta é uma empresa de IA pura que busca a visão da inteligência artificial geral (AGI).

Seja qual for a definição de AGI, dificilmente acredito que a sua definição seja totalmente importante, nem acredito na importância do timing. Uma coisa que sei é que a IA continuará a demonstrar uma série de capacidades ao longo do tempo. O roteiro para o desenvolvimento dessas capacidades será incrível. Antes de chegarmos à definição de AGI de alguém, iremos aplicá-la de forma ampla.

O que você precisa fazer agora é conversar com biólogos digitais, pesquisadores de tecnologia climática, pesquisadores de materiais, cientistas físicos, astrofísicos, químicos quânticos. Você pode procurar designers de videogame, engenheiros de produção, especialistas em robótica, escolher um setor de sua preferência, aprofundar-se nele, conversar com essas pessoas importantes e perguntar-lhes: a IA está revolucionando a maneira como trabalham? Então você traz esses dados de volta e se pergunta: quão cético você é?

Como não estão falando sobre os benefícios conceituais da IA algum dia no futuro, estão falando sobre o uso da IA agora. Quer se trate de tecnologia agrícola, tecnologia de materiais, tecnologia climática, escolha sua área de tecnologia ou ciência, eles estão avançando e a IA os está ajudando a avançar em seu trabalho.

Neste momento, todas as indústrias, todas as empresas, todas as universidades estão a usar IA. É incrível, não é? Com certeza vai mudar os negócios de alguma forma, sabemos disso, certo? Quero dizer, essa mudança é tão real e está acontecendo. Portanto, acho que o despertar da IA desencadeado pelo ChatGPT é completamente incrível. Adoro a velocidade deles e o objetivo único de avançar em campo, então é realmente impactante.

Brad Gerstner: Eles construíram um motor que pode financiar a próxima geração de modelos. Acho que há um consenso crescente no Vale do Silício de que toda a camada do modelo está se tornando comoditizada, e o Llama permite que muitas pessoas construam modelos a um custo muito baixo.

Então no começo tínhamos muitas empresas modelo, como Character, Inflection, Cohere, Mistral e assim por diante. Muitos questionam se estas empresas conseguirão atingir a “velocidade de escape” do motor económico e continuar a financiar a próxima geração de modelos. A minha impressão é que é por isso que estamos vendo uma consolidação no mercado, certo?

Claramente, a OpenAI atingiu aquela “velocidade de escape” onde pode financiar o seu futuro. Mas não está claro para mim se muitas outras empresas possam fazer isso. Esta é uma visão geral justa do estado atual da camada do modelo? Como vimos em muitos outros mercados, os líderes de mercado terão um motor económico e uma aplicação que lhes permitirá continuar a investir.

Jensen Huang: Em primeiro lugar, existe uma diferença fundamental entre modelos e inteligência artificial, certo? Os modelos são um componente necessário, mas insuficiente da inteligência artificial, certo? A inteligência artificial é uma capacidade, mas para quê? Qual é a aplicação?

A inteligência artificial dos carros autônomos está relacionada à inteligência artificial dos robôs humanóides, mas eles não são a mesma coisa. Eles estão relacionados à inteligência artificial do chatbot, mas não são a mesma coisa, certo? Então você precisa entender a classificação dessa pilha. Existem oportunidades em todos os níveis da pilha, mas nem todos os níveis têm oportunidades ilimitadas.

Acabei de dizer uma coisa e tudo que você precisa fazer é substituir a palavra “modelo” por “GPU”. Na verdade, esta foi a principal descoberta da nossa empresa há 32 anos – que existe uma diferença fundamental entre chips gráficos GPU e computação acelerada. A computação acelerada é diferente do que fazemos na infraestrutura de IA e, embora relacionada, não é exatamente a mesma. Eles são construídos um sobre o outro, mas não são idênticos. Cada nível de abstração requer habilidades completamente diferentes.

Alguém que é muito bom na construção de GPUs pode não ter ideia de como se tornar uma empresa de computação acelerada. Tem muita gente construindo GPUs, e nós inventamos a GPU, mas não somos os únicos a fabricar GPUs hoje, certo? Existem muitas GPUs no mundo, mas nem todas são empresas de computação acelerada. E há muitos aplicativos aceleradores, mas isso não é o mesmo que empresas de computação acelerada. Por exemplo, uma aplicação de IA muito especializada pode ter muito sucesso.

Brad Gerstner: Este é MTIA.

Jensen Huang: É verdade, mas pode não se tornar uma empresa com amplo alcance e capacidades. Então você tem que decidir onde quer estar. Pode haver oportunidades nessas diferentes áreas, mas assim como construir uma empresa, é preciso estar atento às mudanças no ecossistema e ao que é comoditizado ao longo do tempo, o que é uma característica, o que é um produto, o que é uma empresa, isso é certo. Bem, acabei de tocar em vários tópicos diferentes.

Brad Gerstner: Claro, há um novo participante que tem dinheiro, inteligência, ambição, e esse é o X.AI, certo? Há relatos de que você jantou com Larry e Elon. Eles convenceram você sobre 100.000 H100s, foram para Memphis e construíram um enorme cluster de supercomputação em questão de meses.

Jen-Hsun Huang: Em primeiro lugar, os três pontos não estão na mesma linha. Jantei com eles. A relação causal é exatamente assim.

Brad Gerstner: O que você acha da capacidade deles de construir clusters de supercomputação? Ainda há discussão de que eles querem adicionar mais 100.000 H200s para expandir o tamanho deste superaglomerado.

Primeiro, conte-nos sobre as ambições da Empresa X e o que elas alcançaram. Ao mesmo tempo, entramos na era dos 200.000 ou 300.000 clusters de GPU?

Jen-Hsun Huang: A resposta é sim. Comece reconhecendo que suas conquistas são merecidas. Desde a fase de conceito, até o data center sendo construído e pronto para a chegada dos equipamentos NVIDIA, até a alimentação, conexão dos equipamentos e realização do primeiro treinamento.

Em primeiro lugar, construir uma fábrica tão grande, utilizar tecnologia de refrigeração líquida, completar o fornecimento de energia, obter licenças e concluí-lo em tão pouco tempo. Quero dizer, é apenas uma conquista sobre-humana. Pelo que eu sei, só existe uma pessoa no mundo que pode fazer isso. A compreensão de Elon Musk sobre engenharia, arquitetura, sistemas de grande escala e mobilização de recursos é única e simplesmente incrível.

Claro, a equipe de engenharia dele também é muito boa, a equipe de software, a equipe de rede, a equipe de infraestrutura são ótimas. Elon entende isso profundamente. A partir do momento em que decidimos lançar o projeto, nossa equipe de engenharia, equipe de redes, equipe de infraestrutura de computação e equipe de software estavam totalmente preparadas.

Depois, toda infraestrutura, logística, e a quantidade de dados e equipamentos que chegaram naquele dia, e infraestrutura e tecnologia de computação da Nvidia, tudo foi treinado em 19 dias.

Você sabe o que isso significa? Alguém está dormindo? Trabalhando 24 horas por dia, ninguém dorme, sem dúvida. Em primeiro lugar, 19 dias é incrível, mas se você parar e pensar bem, é apenas uma questão de semanas. A quantidade de equipamento técnico que você pode ver é simplesmente incrível.

Todo o cabeamento e rede, a rede com equipamentos Nvidia é completamente diferente da rede em um data center de hiperescala. O número de fios em um nó, a parte traseira do computador contém todos os fios. Apenas juntar esse pico de tecnologia, mais todo o software, é incrível.

Portanto, acho incrível o que Elon e sua equipe fizeram e sou grato por ele ter reconhecido nosso trabalho com eles na área de engenharia e planejamento. Mas o que eles alcançaram foi único e sem precedentes.

Para você ter uma ideia melhor, com 100 mil GPUs, este é, sem dúvida, o supercomputador mais rápido do planeta. Este é apenas um aglomerado. Normalmente, quando você constrói um supercomputador, leva três anos para planejar, certo? Depois entregue o equipamento e passe um ano fazendo tudo funcionar. E estamos falando de 19 dias.

▲ O despertar da IA causado pelo ChatGPT é incrível (Fonte: artnet)

O raciocínio está prestes a explodir

Clark Tang: Quais são as vantagens da plataforma NVIDIA? Todo o seu processo foi endurecido, certo?

Jensen Huang: Sim, já está tudo a correr. Claro, existem vários algoritmos X, estruturas X e pilhas X, e ainda precisamos fazer muita integração. Mas o pré-planejamento foi tão bom que só o pré-planejamento foi impressionante.

Brad Gerstner: Elon é único, mas quando você acabou de responder, você mencionou que já existem 200.000 a 300.000 clusters de GPU, certo? Pode chegar a 500.000? Pode chegar a 1 milhão? A demanda pelo seu produto depende de esses clusters poderem escalar para milhões?

Jensen Huang: A resposta à última pergunta é não. Minha opinião é que o treinamento distribuído tem que funcionar e acho que a computação distribuída será inventada e alguma forma de aprendizagem federada e de computação distribuída e assíncrona será descoberta. Estou muito confiante e muito otimista quanto a isso.

Claro, é importante perceber que as leis de escalonamento no passado tratavam principalmente de pré-treinamento. Agora que entramos na multimodalidade, iniciamos a geração de dados sintéticos. A fase pós-treinamento aumenta muito rapidamente, com geração de dados sintéticos, sistemas de recompensa e treinamento baseado em aprendizagem por reforço, todos se desenvolvendo rapidamente. Agora a expansão do estágio de inferência também atingiu seu limite.

A ideia é que antes de o modelo responder à pergunta, ele tenha realizado o raciocínio interno 10 mil vezes, o que provavelmente não é um exagero. Pode ter feito uma busca em árvore, pode ter feito aprendizado por reforço baseado no problema, pode ter feito algum tipo de simulação, deve ter feito muita reflexão, pode ter olhado alguns dados e informações, certo? Portanto, seu contexto pode ser muito grande.

Acho que inteligência é o que estamos fazendo, não é? Isto é o que estamos fazendo. Então, se você fizer as contas nesse dimensionamento, dimensionando o tamanho do modelo e a escala computacional por um fator de 4 por ano, juntamente com a crescente demanda por uso…

Achamos que precisamos de milhões de GPUs? Sem dúvida, sim. Esta é atualmente uma questão determinística. Portanto, a questão é: como arquitetamos isso da perspectiva do data center? Depende muito se o data center vai gerar gigawatts de uma só vez ou 250 megawatts por vez? Minha opinião é que ambos os cenários ocorrem.

Clark Tang: Acho que os analistas estão sempre focados nas escolhas arquitetônicas atuais, mas acho que uma das maiores conclusões dessa conversa é que você está pensando em todo o ecossistema e no que acontecerá muitos anos no futuro.

Portanto, a Nvidia escala, seja vertical ou horizontalmente, para se preparar para o futuro, em vez de depender apenas de um mundo de 500.000 ou 1 milhão de clusters de GPU. Quando o treinamento distribuído chegar, você já terá escrito o software para suportá-lo.

Jen -Hsun Huang: Sim, lembre-se do Megatron que nós e nossos parceiros desenvolvemos há cerca de sete anos. Sem ele, a escala destas tarefas de formação em grande escala não seria possível. Inventamos o Megatron, inventamos o Nickel, o GPU Direct e todo o trabalho que fizemos com RDMA, o que tornou o processamento paralelo de pipeline muito mais fácil.

Todo o processamento paralelo de modelos, toda a decomposição de treinamento distribuído, processamento em lote e todas essas tecnologias são porque fizemos o trabalho inicial e agora também estamos nos preparando para a próxima geração de tecnologias no futuro.

Brad Gerstner: Então vamos falar sobre Strawberry e o1.

Em primeiro lugar, acho legal que tenham batizado o visto o1, certo? O visto o1 visa atrair os melhores e mais brilhantes talentos de todo o mundo para os Estados Unidos, e sei que todos somos profundamente apaixonados por isso.

Gosto muito da ideia de construir um modelo que pense e nos leve a novos patamares de escala inteligente, homenageando os gênios que vieram para a América através da imigração e nos tornaram quem somos hoje.

Jen -Hsun Huang: Deve ser uma inteligência alienígena.

Brad Gerstner: Claro, este projeto é liderado pelo nosso amigo Noah Brown, que trabalhou no Pluribus e no Cicero, ambos projetos Meta. Quão importante é que a inferência no tempo de inferência seja uma dimensão de inteligência completamente nova, em vez de apenas construir modelos maiores?

Jen-Hsun Huang: Isto é muito importante, extremamente importante. Muita inteligência não pode ser feita antecipadamente, sabia? Mesmo muitos cálculos não podem ser reordenados antecipadamente. A execução fora de ordem pode ser feita antecipadamente, mas muitas coisas só podem ser feitas em tempo de execução.

Portanto , seja do ponto de vista da ciência da computação ou do ponto de vista da inteligência, muitas coisas exigem contexto e contexto, e o tipo de resposta que você procura, às vezes, uma resposta simples e rápida é suficiente, e as consequências dessa resposta dependem de o que você usa a natureza desta resposta.

Portanto, algumas respostas podem levar uma noite para serem pensadas, e algumas respostas podem levar uma semana, certo? Posso me imaginar enviando uma mensagem para minha IA e contando, pense nisso durante a noite e não me conte imediatamente, certo? Quero que você pense nisso a noite toda e depois me diga sua melhor resposta amanhã de manhã e raciocine para mim.

Então , acho que as camadas inteligentes, do ponto de vista do produto, terão versões únicas e algumas que levarão cinco minutos para serem feitas.

Brad Gerstner: Essa camada de inteligência é capaz de combinar esses problemas com os modelos e cenários de uso apropriados. Ontem à noite estávamos usando o modo de fala avançado e a visualização o1, e eu estava ensinando meu filho para o exame de história avançada, e parecia que o melhor professor de história avançada do mundo estava sentado ao seu lado e pensando juntos sobre essas questões. Foi uma experiência extraordinária.

Jen-Hsun Huang: Meu mentor agora é IA.

Brad Gerstner: Claro, eles existem hoje. Isso também remete ao tópico de que mais de 40% de sua receita hoje vem de inferência. Mas o raciocínio vai explodir por causa das “cadeias de raciocínio”, certo?

Jen-Hsun Huang: O crescimento do raciocínio será um bilhão de vezes.

Brad Gerstner: Dobre, dobre um bilhão de vezes.

Jen-Hsun Huang: Sim. Esta é a parte que a maioria das pessoas ainda não entende completamente. Esta é exatamente a mudança industrial de que falávamos anteriormente, esta é a Revolução Industrial.

Brad Gerstner: Esta é uma produção inteligente, certo?

Jensen Huang: Vai crescer mil milhões de vezes.

Brad Gerstner: Todos prestam muita atenção à NVIDIA, pensando que ela é usada principalmente para treinar modelos maiores. Não é verdade? Se 50% da sua receita hoje vem do treinamento, então a escala de inferência excederá em muito o treinamento no futuro. O treinamento é importante, mas esperamos que o crescimento na inferência supere em muito o crescimento no treinamento, e é quase impossível fazer de outra forma.

Jensen Huang: Esperamos que sim, sim, ir à escola é uma coisa boa, mas o objetivo final é que você possa contribuir na sociedade. Portanto, treinar esses modelos é bom, mas o objetivo final é torná-los impactantes.

Brad Gerstner: Você já está usando Inference Chain e ferramentas como o1 para melhorar seu próprio negócio?

Jen-Hsun Huang: Nossos sistemas de segurança de rede hoje são inseparáveis de nossa própria inteligência. Temos agentes que ajudam a projetar os chips, e sem esses agentes o chip Hopper não seria possível, nem a Blackwell, muito menos o Rubin.

Temos designers de chips de IA, engenheiros de software de IA e engenheiros de verificação de IA, e todos nós os desenvolvemos dentro da empresa. Como temos essa capacidade, preferimos aproveitar esta oportunidade para explorarmos essa tecnologia nós mesmos.

▲ O crescimento da inferência será de um bilhão de vezes (Fonte: NVIDIA)

Precisamos de uma IA mais eficiente e segura

Brad Gerstner: Sabe, quando entrei no prédio hoje, alguém veio até mim e disse, sabe, pergunte ao Jensen sobre cultura, é tudo sobre cultura. Olho para o seu negócio e falamos muito sobre adaptabilidade e eficiência, estruturas organizacionais planas que permitem execução rápida, equipes pequenas operando.

Você sabe, a NVIDIA é única neste espaço, gerando cerca de US$ 4 milhões em receita por funcionário e cerca de US$ 2 milhões em lucro ou fluxo de caixa livre por funcionário. Você estabeleceu uma cultura de eficiência que realmente libera criatividade, inovação, responsabilidade e propriedade, e quebrou o modelo tradicional de gestão funcional. Todo mundo gosta de falar sobre quantos subordinados diretos você tem.

O uso da IA é a chave para permitir que você permaneça altamente criativo e ao mesmo tempo eficiente?

Jen-Hsun Huang: Sem dúvida. Espero que um dia a Nvidia tenha hoje 32 mil funcionários e tenhamos 4 mil famílias em Israel, espero que estejam bem. Espero que um dia a Nvidia seja uma empresa com 50.000 funcionários e 100 milhões de assistentes de IA.

Em cada equipe, teremos um diretório de IA com um grupo de IAs que são boas em fazer diversas coisas. Também teremos uma caixa de entrada repleta de um catálogo de IAs com as quais trabalhamos e sabemos que são boas em nossas áreas de habilidade. Portanto, a IA recruta outras IA para resolver problemas. As IAs também se comunicarão entre si nos canais do Slack.

Brad Gerstner: E trabalhando com humanos.

Jen-Hsun Huang: Trabalhando com humanos. Portanto, seremos um grande grupo de funcionários, parte dos quais são funcionários digitais e de IA, parte dos quais são funcionários humanos biológicos, e espero que haja alguns funcionários da mecatrônica no futuro.

Brad Gerstner: Do ponto de vista empresarial, acho que isso costuma ser mal compreendido. Você acabou de descrever uma empresa que tem a produção de uma empresa com 150.000 funcionários, mas na verdade usou apenas 50.000 funcionários. Você não está dizendo que vai demitir todos os seus funcionários, você ainda está aumentando o quadro de funcionários, mas o rendimento dessa empresa vai aumentar significativamente, certo?

Jen-Hsun Huang: Isso é algo que muitas vezes é mal compreendido. A IA não substituirá os empregos, mas transformará todos os empregos. A IA terá um impacto profundo na forma como as pessoas pensam sobre o trabalho, temos que admitir isso, certo?

A IA tem o potencial de fazer tanto bem como mal, e devemos construir uma IA segura, sim, essa deve ser a base. Mas a parte esquecida é que quando as empresas utilizam a IA para aumentar a produtividade, isso provavelmente levará a melhores lucros ou a um melhor crescimento, ou ambos. E quando isso acontecer, é improvável que o próximo e-mail do CEO seja um aviso de demissão.

Brad Gerstner: Com certeza, porque a empresa está crescendo.

Jensen Huang: Sim, a razão é que temos mais ideias do que podemos explorar e precisamos de pessoas que nos ajudem a pensar sobre isso e depois automatizar essas ideias. Quanto à parte de automação, a IA pode nos ajudar a alcançá-la.

Obviamente que também nos ajudará a pensar, mas ainda precisamos de descobrir que problema queremos resolver. Existem inúmeros problemas que podemos resolver, mas as empresas devem escolher aqueles que mais precisam ser resolvidos e então encontrar uma forma de automatizá-los e escalá-los.

Assim, à medida que nos tornarmos mais eficientes, contrataremos mais pessoas. Muitas vezes as pessoas esquecem disso. Se olharmos para a história, fica claro que temos mais ideias hoje do que há 200 anos. É por isso que o PIB e os empregos estão a crescer, apesar de estarmos a automatizar como loucos.

Brad Gerstner: Este é um ponto importante à medida que entramos neste período em que quase toda a produtividade e prosperidade humanas são um subproduto da tecnologia e da automação ao longo dos últimos 200 anos. Podemos olhar para o gráfico de crescimento do PIB per capita ao longo dos últimos 200 anos, desde Adam Smith até à destruição criativa de Schumpeter, e ele continua a acelerar. Isso me leva a uma pergunta.

Se olharmos para a década de 1990, o crescimento da produtividade nos Estados Unidos foi de cerca de 2,5% a 3% ao ano. Depois, na década de 2000, desacelerou para cerca de 1,8%. A última década registou o crescimento da produtividade mais lento alguma vez registado. Isto refere-se ao crescimento da nossa produção para um factor fixo de trabalho e capital, e é o mais lento já registado.

Muitas pessoas discutiram isso. Mas se o mundo é o que você descreve, e vamos aproveitar e fabricar inteligência, estaremos à beira de uma expansão massiva da produtividade humana?

Jen-Hsun Huang: Esta é a nossa esperança. Essa é a nossa esperança e, claro, vivemos neste mundo, por isso temos provas diretas, certo? Temos provas diretas, como investigadores individuais que utilizam IA, de que podem agora explorar a ciência numa escala sem precedentes, o que é um reflexo da produtividade.

Ou projetamos um chip tão complexo e fazemos isso tão rápido e o quadro de funcionários da empresa não cresce na mesma proporção, o que também é reflexo da produtividade, certo? O software que desenvolvemos também está cada vez melhor porque aproveitamos a IA e os supercomputadores para nos ajudar, e o número de funcionários está crescendo quase linearmente.

Esta é mais uma prova de produtividade. Portanto, não importa em que setor eu mergulhe, posso verificar por mim mesmo, posso verificar pessoalmente se essas manifestações prevalecem. Não há dúvida de que a inteligência é o recurso mais valioso do mundo e agora vamos produzi-la em grande escala.

Todos temos de aprender a viver num ambiente onde estamos rodeados por uma IA que pode fazer as coisas muito bem ou até melhor do que nós. Quando reflito sobre isso, vejo que esta é a minha vida.

Tenho 60 subordinados diretos, certo? Eles são todos pessoas de classe mundial em suas áreas e se saem muito melhor do que eu. Não tenho nenhum problema em trabalhar com eles e não tenho nenhum problema em treiná-los e me comunicar com eles. Então, acho que o que as pessoas vão aprender é que todos serão CEOs de agentes de IA.

Eles precisam ter criatividade, determinação e algum conhecimento de como resolver problemas para poder programar essas IAs para ajudá-los a atingir seus objetivos, assim como eu administro minha empresa.

Brad Gerstner: Você mencionou uma questão que é a discussão sobre alinhamento e IA segura. Também mencionou a tragédia que está a acontecer no Médio Oriente. Você sabe, existem muitas aplicações de autonomia e IA em diferentes partes do mundo neste momento.

Então, vamos falar sobre maus atores, IA de segurança e coordenação com Washington. Como você está se sentindo agora? Estamos no caminho certo? Estamos coordenando o suficiente? Lembro-me de que Mark Zuckerberg disse uma vez que a maneira de derrotar a IA ruim é tornar a IA boa melhor. Como você descreveria como garantimos que a IA tenha um benefício líquido positivo para a humanidade, em vez de nos prender em um mundo distópico sem propósito?

Jen-Hsun Huang: A discussão sobre segurança é muito importante e significativa. A visão abstrata, isto é, tratar a IA como uma grande rede neural, não é uma boa visão. E a razão é que sabemos que a inteligência artificial e os grandes modelos de linguagem, embora relacionados, não são a mesma coisa.

Há muito trabalho acontecendo agora que considero brilhante. Primeiro, um modelo de código aberto permite que todos os setores, todas as empresas e toda a comunidade de investigação tenham acesso à IA e aprendam como aproveitar esta capacidade nos seus campos. muito bom.

Em segundo lugar, as forças tecnológicas de desenvolvimento da IA estão concentradas em inventar formas de tornar a IA mais segura. A IA é usada para filtrar dados, filtrar informações, treinar outras IAs, criar IAs alinhadas, gerar dados sintéticos, expandir o conhecimento de IA, reduzir alucinações e toda IA criada para imagens vetoriais, gráficos, etc., para informar e monitorar outros sistemas de IA que ainda não receberam reconhecimento suficiente pela criação de IA segura.

Brad Gerstner: Esses sistemas já estão sendo construídos.

Jensen Huang: Sim, estamos construindo esses sistemas e todos na indústria estão fazendo isso. Incluindo testes de equipe vermelha, controle de processos, cartões de modelo, sistemas de avaliação, sistemas de benchmark, etc., todos esses mecanismos de segurança estão sendo construídos em um ritmo alarmante. Esses esforços não receberam o crédito que merecem, você sabe.

Brad Gerstner: Sim, atualmente não há regulamentações governamentais que exijam que você faça isso. Este é agora um momento em que os intervenientes da indústria estão a levar a sério estas questões críticas e a coordenar-se em torno das melhores práticas.

Jensen Huang: Exatamente, estes esforços não são suficientemente reconhecidos e não são totalmente compreendidos. As pessoas precisam começar a falar sobre IA como um sistema composto de múltiplas IAs e sua natureza como um sistema bem projetado.

No que diz respeito à regulamentação, precisamos de lembrar que a IA é uma capacidade e pode ser aplicada em muitos campos. Não há necessariamente necessidade de legislação separada para cada tecnologia importante, mas a regulamentação não deve poder estender-se a áreas desnecessárias.

A maior parte da regulamentação deveria ser realizada para aplicações específicas. Por exemplo, agências como a FAA (Federal Aviation Administration), NIH (National Institutes of Health), FDA (U.S. Food and Drug Administration) já estão regulamentando aplicações de tecnologia, e agora. eles É necessário começar a gerenciar aplicações tecnológicas que incluam IA.

Portanto, não entendam mal isto e não ignorem a vasta quantidade de sistemas regulatórios existentes que precisaremos ativar. Não dependa apenas de uma comissão global de IA, pois cada órgão regulador é criado por uma razão. A razão pela qual estas diferentes agências reguladoras existem é para enfrentar diferentes desafios. Voltemos aos princípios básicos novamente.

▲Clark Tang em entrevista

O código aberto de IA impulsiona a ativação da indústria

Brad Gerstner: Meu parceiro Bill Gurley (Nota do editor: Bill estava ausente desta entrevista) provavelmente me culparia se eu não voltasse à questão do código aberto. Você lançou recentemente um modelo de código aberto muito importante e muito poderoso. Claramente, a Meta também está fazendo contribuições significativas para o código aberto.

Quando eu estava lendo o Twitter, notei que havia muita discussão sobre o Open versus fechado. O que você acha do código aberto e, especificamente, a capacidade do seu próprio modelo de código aberto de acompanhar o ritmo da tecnologia de ponta? Esta é a primeira pergunta.

A segunda pergunta é: essa é sua visão para o futuro, com um modelo de código aberto e um modelo fechado que alimenta operações comerciais? Esses dois podem criar uma tensão saudável para a segurança da IA?

Jen-Hsun Huang: A discussão sobre código aberto e fonte fechada está relacionada à segurança, mas não se trata apenas de segurança. Por exemplo, ter um modelo de código fechado como mecanismo de um modelo econômico para sustentar a inovação é totalmente bom e eu apoio de todo o coração.

Eu acho que definir o problema simplesmente como fonte fechada versus código aberto é uma maneira errada de pensar. Deve ser de código fechado e código aberto, certo? Porque o código aberto é necessário para a ativação de muitas indústrias.

Se não houver código aberto agora, como todos esses diferentes campos científicos podem ser ativados na IA? Porque eles precisam desenvolver sua própria IA específica de domínio e precisam aproveitar os modelos de código aberto para criar IA específica de domínio. Os dois estão relacionados, mas não iguais.

Só porque você tem um modelo de código aberto, não significa que você tenha IA. Portanto, você deve ter modelos de código aberto para impulsionar a criação da IA. Portanto, serviços financeiros, assistência médica, transporte e muitas outras áreas da ciência e da indústria estão sendo ativadas por código aberto.

Brad Gerstner: É inacreditável que seu modelo de código aberto esteja em alta demanda, não é?

Jensen Huang: Nosso modelo de código aberto? Claro, downloads de lhama, certo? Obviamente, o trabalho que Mark (Zuckerberg) e sua equipe estão fazendo é incrível, em grande demanda e energizando completamente todos os setores e todos os campos da ciência.

A razão pela qual criamos Nemotron foi para a geração de dados sintéticos. Intuitivamente, parece não confiável pensar que uma IA gerará continuamente dados em um loop para aprender. É questionável quantas vezes você pode dar a volta nesse loop infinito. No entanto, tenho uma imagem em minha mente, que é como travar uma pessoa super inteligente em uma sala suave.

No entanto, se duas ou três pessoas discutirem juntas, temos diferentes modelos de IA, terem diferentes distribuições de conhecimento e puderam questionar e responder e nos comunicar de um lado para o outro, então os três se tornaremos mais inteligentes. Portanto, a idéia de trocar, interagir, discussões, debates, aprendizado de reforço e geração de dados sintéticos entre os modelos de IA faz sentido intuitivo.

Portanto, nosso Nemotron 350B, 340B são os melhores modelos de sistema de recompensa do mundo. É o melhor modelo crítico e é realmente excelente. Portanto, essa é uma ferramenta fantástica para aprimorar todos os outros modelos, por mais bons os outros modelos, recomendo o uso do Nemotron 340B para aprimorá -los e torná -los ainda melhores. E vimos Llama melhorar, e todos os outros modelos se beneficiaram disso.

▲ A meta está fazendo contribuições significativas para o código aberto (fonte: LinkedIn)

Ai é uma revolução completa

Brad Gerstner: Como alguém que entregou o primeiro DGX-1 em 2016, tem sido uma jornada incrível. Sua jornada é incomum e incrível. O fato de você ter conseguido superar esses tempos difíceis iniciais é extraordinário em si.

Você entregou o primeiro DGX-1 em 2016 e inauguramos esse "momento cambriano" em 2022. Então, quero fazer uma pergunta que me perguntei frequentemente: quanto tempo você acha que seu status de trabalho atual pode durar?

Com 60 relatórios diretos, você está em toda parte dirigindo esta revolução. Você gosta do processo? Há mais alguma coisa que você preferia fazer?

Jen-Hsun Huang: Você está perguntando sobre seus sentimentos na última hora e meia? A resposta é: ótimo. Eu me diverti muito e não conseguia imaginar fazer nada mais que valha a pena.

Deixe -me pensar sobre isso, acho que nosso trabalho sempre deve parecer divertido. Meu trabalho nem sempre é divertido, nem espero que seja. O trabalho sempre deve ser divertido? Eu acho que o importante é que o trabalho é sempre importante. Não me levo muito a sério, mas levo meu trabalho muito a sério. Eu assumo nossas responsabilidades, nossa contribuição para a sociedade e os tempos em que vivemos muito a sério.

Isso é sempre divertido? Não, mas eu sempre amo isso? Sim, como tudo, seja família, amigos, filhos, é sempre divertido? Não, mas sempre os amamos profundamente? Absolutamente.

Quanto tempo posso fazer isso? A verdadeira questão é: quanto tempo posso permanecer relevante? A resposta a esta pergunta é respondida apenas por outra pergunta: como continuarei aprendendo? Estou mais otimista hoje e não estou dizendo isso por causa do que estamos falando hoje. Por causa do advento da IA, estou mais otimista sobre minha capacidade de permanecer relevante e continuar aprendendo. Eu uso todos os dias. Não sei se vocês também usam, mas eu o uso todos os dias.

Não há nenhum estudo que não envolva IA e, mesmo que eu saiba a resposta, usarei a IA para verificar. Surpreendentemente, as próximas duas ou três perguntas que faço frequentemente revelam algo que eu não sabia.

Você pode escolher o tópico que lhe interessa, penso na IA como mentor, ai como assistente, ai como parceiro para debater, para verificar meu trabalho. Gente, isso é realmente uma revolução completa. E eu sou um trabalhador da informação e minha saída é informação.

Então, acho que a contribuição da IA para a sociedade é extraordinária. Se eu posso permanecer relevante assim e continuar contribuindo, sei que esse trabalho é importante o suficiente para continuar buscando. E minha qualidade de vida é incrível.

Brad Gerstner: Não consigo imaginar perder esse momento. Você e eu estamos nesse setor há décadas, e este é o nosso maior momento em trinta anos. Somos profundamente gratos por essa colaboração.

Jensen Huang: não perca os próximos dez anos.

Brad Gerstner: Muito obrigado pela troca de idéias, você nos deixa mais sábios. Obrigado, acho que você desempenha um papel muito importante como líder na navegação no futuro com otimismo e segurança.

Jensen Huang: Obrigado por estar conosco. Eu realmente gostei, eu realmente agradeço, obrigado Brad, obrigado Clark.

# Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.