Esses produtos de IA estão quebrando barreiras para 430 milhões de pessoas

Anteriormente, escrevemos um artigo – "Não me pergunte de novo por que os surdos vão aos festivais de música" , que popularizou a posição especial dos festivais de música no exterior: intérpretes de linguagem de sinais.

Embora os deficientes auditivos não possam ouvir ou ouvir a música com clareza, eles podem sentir o ritmo da música e o calor da atmosfera por meio dos movimentos altamente contagiosos das mãos, das expressões faciais e da linguagem corporal dos intérpretes de linguagem de sinais.

Este pode ser um cenário inesperado de linguagem de sinais para pessoas ouvintes. Na verdade, ainda existem muitos locais onde são necessários intérpretes de língua de sinais, tanto online quanto offline, mas não há número suficiente deles.

Sally Chalk, uma inglesa, abriu uma empresa britânica de interpretação de linguagem de sinais em 2002. Após 20 anos de operação, a empresa cresceu consideravelmente e o tempo para contratar um intérprete de linguagem de sinais foi reduzido para 30 minutos, mas ela está ainda não satisfeito.

As pessoas com deficiência auditiva podem ter acesso imediato à interpretação da linguagem de sinais, da mesma forma que ativam as legendas em um site de vídeo?

A resposta dela é envolver a IA.

Do online ao offline, as pessoas com deficiência auditiva deveriam poder usar a sua “língua nativa” com mais frequência

Em 2022, Sally Chalk abriu uma nova empresa start-up, Signapse, com foco no desenvolvimento de software generativo de tradução de linguagem de sinais de IA para traduzir texto escrito para a linguagem de sinais americana e a linguagem de sinais britânica em tempo real.

Em maio deste ano, a Signapse recebeu £ 2 milhões em financiamento inicial, dos quais £ 500.000 vieram do governo britânico.

Um dos cenários off-line que eles visam são os centros de transporte, como estações de trem e aeroportos.

O Aeroporto Internacional de Cincinnati/Northern Kentucky, nos Estados Unidos, fez parceria com a Signapse para exibir a linguagem de sinais americana na tela para fornecer informações de boas-vindas, segurança, partida, chegada e outras.

Como funciona a IA? Signapse é baseado em um grande conjunto de dados de linguagem de sinais e usa redes adversárias generativas (GAN) e técnicas de aprendizagem profunda para criar intérpretes de linguagem de sinais virtuais realistas que traduzem com a maior precisão possível.

Esses avatares são baseados em intérpretes reais de linguagem de sinais e, cada vez que são usados comercialmente, as pessoas reais recebem uma parte.

Considerando que os destinos dos aeroportos, horários de partida e números de plataforma mudam frequentemente, a tradução em linguagem de sinais do Signapse pode ser atualizada em tempo real, integrando-se aos dados de tráfego.

Ao mesmo tempo, a Signapse não ignorou as necessidades online e também fornece tradução em linguagem de sinais para sites e streaming de vídeo.

Embora sites como o YouTube tenham legendas fechadas, as pessoas com deficiência auditiva geralmente preferem a linguagem de sinais às legendas porque a linguagem de sinais tem estruturas e expressões gramaticais independentes de outros idiomas, melhorando sua experiência online.

Você deve ter notado que, quando nos referimos à linguagem de sinais, usamos a linguagem de sinais americana e a linguagem de sinais britânica. Assim como as línguas faladas e escritas em todo o mundo são incompreensíveis, a linguagem de sinais é abrangente.

De acordo com as Nações Unidas, aproximadamente 70 milhões de pessoas em todo o mundo usam a linguagem de sinais como principal forma de comunicação, e existem mais de 300 tipos diferentes de linguagem de sinais usados em todo o mundo. Só nos Estados Unidos, 500.000 pessoas usam a linguagem de sinais americana.

Portanto, o que a Signapse está fazendo atualmente é na verdade muito limitado, cobrindo apenas um pequeno número de pessoas que usam a linguagem de sinais americana e britânica e cenários verticais limitados. Nos últimos dois anos, a Signapse criou cerca de 5.000 anúncios de trânsito em linguagem de sinais britânica todos os dias.

A Signapse espera que no futuro seus serviços sejam mais universais, expandidos para a educação e outros cenários, e também mais personalizados, permitindo aos usuários personalizar a aparência dos intérpretes virtuais de linguagem de sinais.

O ambiente e as condições apoiam a IA, e os principais fabricantes nacionais também possuem produtos de linguagem de sinais semelhantes.

Âncoras de linguagem de sinais de IA apareceram na sala de transmissão ao vivo Honor of Kings da Tencent e na conferência de desenvolvedores da Huawei.

Nos Jogos Olímpicos de Inverno de 2022, a âncora de linguagem de sinais AI criada em conjunto pela CCTV News e Baidu Intelligent Cloud Xilin foi lançada, e a Escola de Inteligência Artificial para Surdos da Universidade de Tecnologia de Tianjin participou da anotação de material de linguagem de sinais.

Por trás da âncora da linguagem de sinais AI, a plataforma de linguagem de sinais AI do Baidu Intelligent Cloud Xiling também pode atender às necessidades de tradução rápida de linguagem de sinais em diferentes cenários, como hospitais, estações, bancos, etc., que é o mesmo que o herói Signapse.

Viagens mais tranquilas, experiência de visualização mais envolvente, serviços mais livres de barreiras…

Se a margem para melhorias na interpretação da linguagem gestual é mais profunda do que o mar, pelo menos a forma como as pessoas com deficiência auditiva obtêm informação pública está a ser alterada pela IA, com ondas visíveis que continuam a aumentar.

Pessoas do Duolingo no mundo da linguagem de sinais

As pessoas com deficiência auditiva também precisam “ouvir” música? É suficiente que pessoas com deficiência auditiva leiam textos? Este é um problema típico considerado do ponto de vista de ouvir a lógica das pessoas.

Na verdade, deveríamos perguntar o contrário: como podem as pessoas com deficiência auditiva também ter um sentimento de participação em festivais de música? Como a Internet pode tornar a navegação mais agradável para os deficientes auditivos?

Portanto, não é que haja uma tela extra em uma estação ocupada, mas que a tela deveria estar lá.

Mais empresas e mais indivíduos estão aproveitando o poder da tecnologia para tornar a linguagem de sinais cada vez mais relevante.

Permitir que pessoas ouvintes aprendam a linguagem de sinais é uma das ideias mais fáceis de imaginar.

PopSign é um aplicativo para aprender linguagem de sinais enquanto joga. Ele usa um modelo de linguagem de sinais de IA e foi desenvolvido em conjunto pelo Google, Rochester Institute of Technology e Georgia Institute of Technology. crianças com deficiência auditiva de pais ouvintes.

Aprendendo com a lição que memorizar palavras começa com “abandono” (desistir) e termina com desistência, o PopSign não reproduz vídeos chatos de linguagem de sinais, mas usa minijogos para aumentar seu interesse e confiança no aprendizado da linguagem de sinais. Duolingo, que pede freneticamente que você faça check-in.

Existe também uma empresa americana chamada SLAIT que quer ser o “Duolingo” no mundo da linguagem de sinais. Eles também oferecem cursos e testes interativos e envolventes. Se você acertar, o tutor de IA lhe dará feedback em tempo real e fornecerá a quantidade certa de valor emocional.

No entanto, ensinar linguagem de sinais é apenas a segunda melhor opção para o SLAIT. O que eles queriam fazer no início era, na verdade, uma ferramenta de linguagem de sinais de IA para bate-papo por vídeo e tradução em tempo real.

Mas é difícil fazer uma refeição sem arroz. SLAIT é uma equipe pequena sem dados ou fundos suficientes. Em comparação com a tradução direta de frases em linguagem de sinais, ensinar vocabulário individual em linguagem de sinais é mais simples, mas igualmente valioso.

O árduo trabalho de interpretação da linguagem de sinais é deixado para os gigantes ricos.

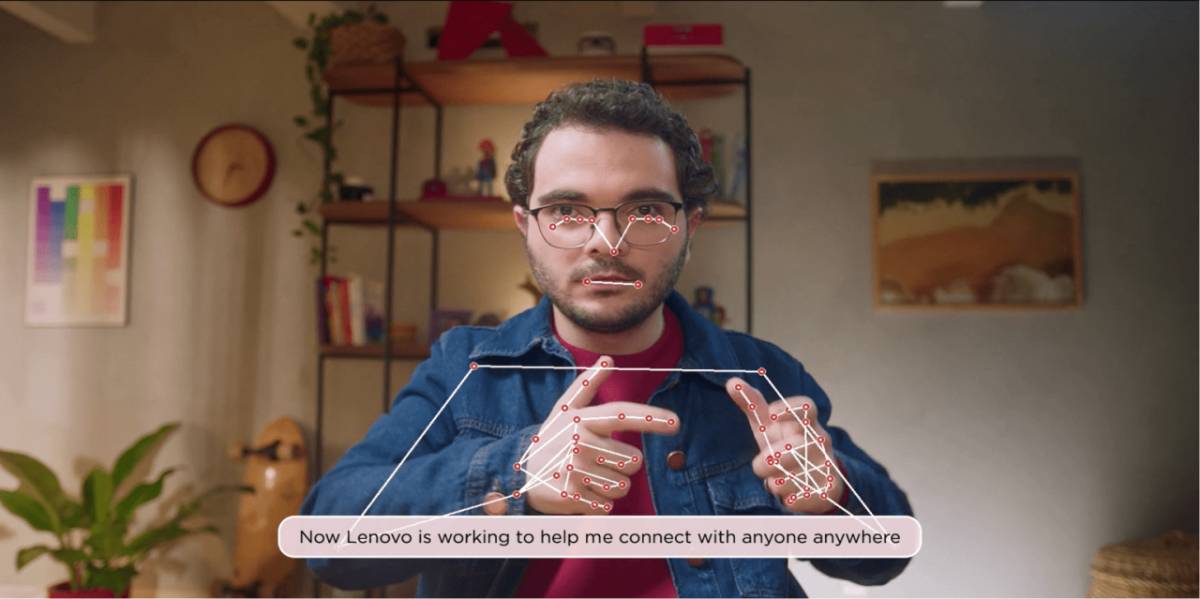

Em agosto de 2023, a Lenovo Brasil desenvolveu um aplicativo de tradução de bate-papo em tempo real baseado em IA para traduzir a língua de sinais portuguesa e planeja cobrir mais línguas de sinais em todo o mundo no futuro.

Quando uma pessoa com deficiência auditiva assina em frente à câmera do aparelho, o algoritmo irá traduzi-lo instantaneamente para o texto em português e enviá-lo ao destinatário do outro lado.

Deveria haver tantas ferramentas desse tipo quanto possível, que complementem os serviços de ensino de língua de sinais e permitam que os deficientes auditivos assumam uma posição mais ativa e se tornem mais iniciadores de conversas.

O Google está mais voltado para o produto e lançou o 2023 Kaggle AI Sign Language Recognition Competition.

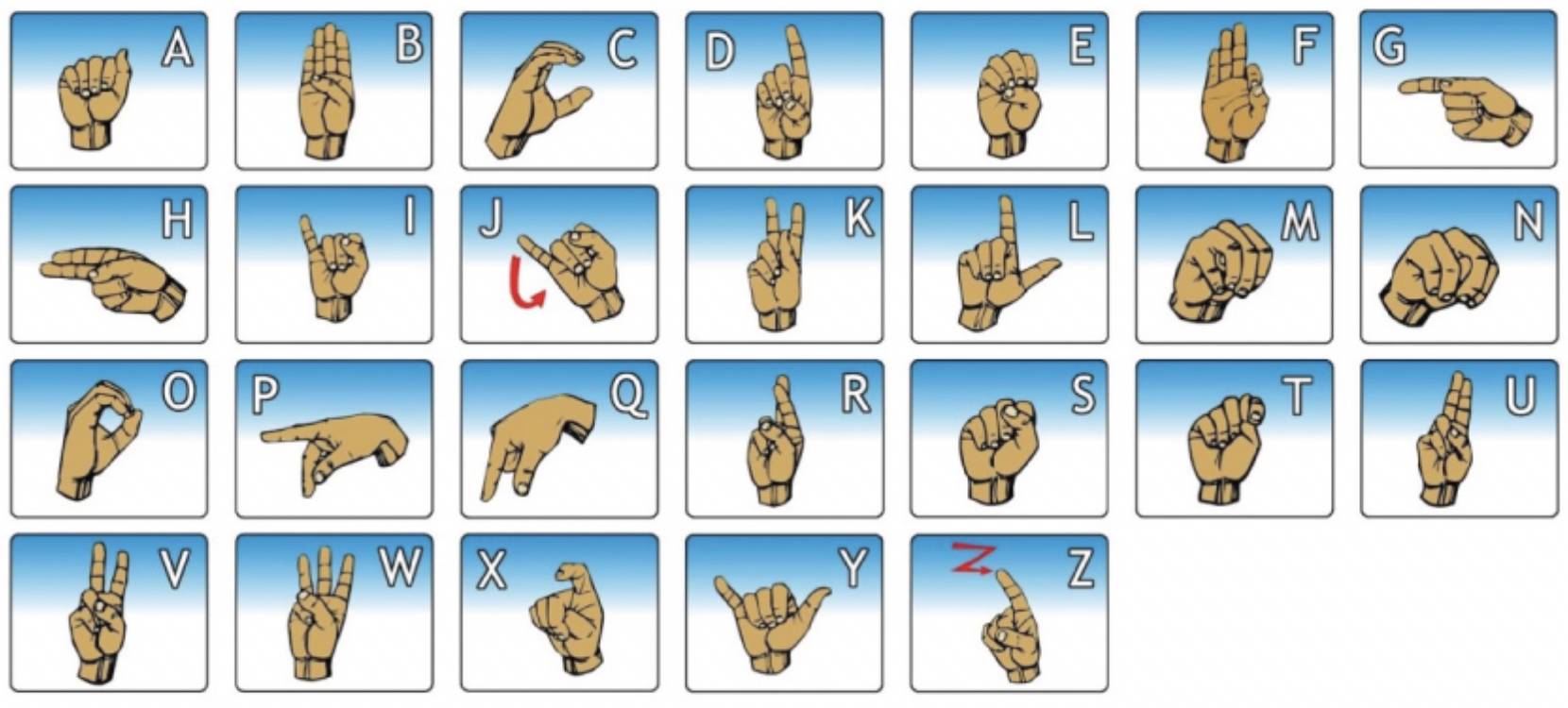

O tema desta competição é muito interessante – os competidores constroem um modelo de ortografia digital que usa câmeras inteligentes para rastrear rapidamente dedos, palmas das mãos e rostos com base em mais de 3 milhões de caracteres ortográficos obtidos de selfies de pessoas com deficiência auditiva.

A ortografia dos dedos é um tipo de linguagem de sinais que usa diferentes formas e posições dos dedos para representar letras. Para muitas pessoas com deficiência, soletrar com os dedos é muito mais rápido do que digitar no teclado virtual de um smartphone.

Portanto, melhorar o reconhecimento da linguagem de sinais e construir modelos de ortografia digital é permitir que pessoas com deficiência auditiva usem diretamente a linguagem de sinais em que são melhores, em vez de digitar e falar, e usem funções como pesquisa, mapas e mensagens de texto em seus celulares. telefones.

Além disso, isto também ajudará a desenvolver aplicações de conversão de linguagem gestual em fala, quebrando o impasse que impede as pessoas com deficiência auditiva de utilizarem a voz para convocar assistentes digitais.

Em outras palavras, muitos produtos que priorizam a voz não consideraram os usuários que não são bons em falar desde o início. É hora de preencher as lacunas.

Sam Sepah, gerente-chefe de produtos de pesquisa de acessibilidade do Google, mencionou em uma entrevista à Forbes que seu objetivo é tornar a linguagem de sinais uma opção de linguagem universal ao usar os produtos do Google.

Na verdade, este também deveria ser o objetivo de toda a Internet – tornar a linguagem de sinais uma linguagem universal no mundo digital.

Como software de aprendizagem de idiomas, o Duolingo oferece a todos oportunidades educacionais iguais. O que os produtos de linguagem de sinais de IA fazem as pessoas sentirem é que as restrições que não deveriam existir estão sendo suspensas e as pessoas podem se comunicar umas com as outras em qualquer lugar.

Quanto mais poderosa a IA se torna, mais devemos valorizar a humanidade

Em maio, quando o GPT-4o foi lançado, um vídeo de demonstração foi muito comovente.

A pessoa com deficiência visual sabe pela boca da IA que bandeiras estão voando sobre o Palácio de Buckingham, patos brincam tranquilamente no rio e um táxi está prestes a chegar. Os cantos de sua boca sobem em resposta ao tom alegre da IA.

Como diz o ditado, a tecnologia abre a porta para um novo mundo. Pode-se entender, inversamente, que as pessoas com deficiência viviam originalmente num mundo que não foi concebido para elas?

Dados da OMS mostram que 430 milhões de pessoas em todo o mundo necessitam de tratamento de reabilitação para resolver a perda auditiva incapacitante. O número de intérpretes de língua de sinais está longe de ser adequado. Nos Estados Unidos, a proporção de usuários com deficiência auditiva em relação aos intérpretes de língua de sinais americana é de aproximadamente 50 para 1.

Portanto, por enquanto, a linguagem de sinais da IA desempenha apenas um papel complementar e de cereja no bolo, e ainda não está a ponto de “roubar empregos”.

Os produtos de linguagem de sinais de IA mencionados acima são basicamente de pequena escala, verticais e enraizados em regiões específicas, compensando a inacessibilidade dos intérpretes humanos.

No mês passado, também vi um produto interessante de linguagem de sinais de IA.

Pesquisadores de várias universidades, incluindo a Rutgers University e a Carnegie Mellon University, processaram vídeos públicos de linguagem de sinais em um conjunto de dados contendo 8 línguas de sinais e treinaram o SignLLM, o primeiro modelo multilíngue de geração de linguagem de sinais.

Abrange uma variedade de línguas de sinais e pode gerar línguas de sinais por meio de palavras de texto. Não é muito conveniente? No entanto, os pesquisadores disseram que o mundo exterior não deve exagerar os resultados de sua pesquisa. O vídeo de demonstração não é um resultado direto do modelo e ainda é muito difícil de produzir.

Ao mesmo tempo, alguns especialistas com deficiência auditiva se manifestaram e disseram que a qualidade da tradução da linguagem de sinais nesses vídeos varia. Alguns são meio compreensíveis, alguns são completamente incompreensíveis e não possuem expressões faciais. O projeto tem potencial, mas tem. precisa ser melhorado.

O mais importante é permitir que os usuários com deficiência auditiva participem, expressem suas opiniões e melhorem o produto em conjunto, pois “sem a nossa participação não haverá decisões sobre nós”.

Uma sensação sutil é que parece difícil tornar “sexy” produtos sem barreiras.

Muitas vezes, eles não são tão empolgantes quanto o lançamento de modelos grandes e hardware de IA. Eles sempre dizem quais funções eles têm e a quem servem. Eles esperam fazer melhor no futuro e não “morderão mais do que podem mastigar”.

E aos olhos do capital de risco, também são nichos, têm potencial desconhecido e podem não ter retorno do investimento.

Mas a "madrinha da IA" Li Feifei disse uma vez que a IA serve para ajudar as pessoas. Quanto mais poderosa a IA, mais devemos valorizar a humanidade.

Todos não deveriam ter medo de perder um voo, todos deveriam poder interagir com os produtos e todos deveriam desfrutar de festivais de música.

Aquelas coisas que antes eram invisíveis e inaudíveis também deveriam ser iluminadas pela luz da tecnologia. Vamos estalar os dedos em ressonância, para que as necessidades de mais pessoas possam ser satisfeitas, para que as capacidades de mais pessoas possam ser melhoradas, para que possamos ganhar mais e perder menos.

# Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.