xAI recebe US$ 6 bilhões em financiamento, Musk também planeja construir uma “fábrica de supercomputação”

Agora há pouco, a xAI anunciou oficialmente que recebeu US$ 6 bilhões em financiamento da Série B, e sua avaliação também saltou para aproximadamente US$ 18 bilhões.

Os principais investidores nesta rodada de financiamento incluem Valor Equity Partners liderado por Antonio Gracias, o primeiro investidor em Tesla e SpaceX, a empresa de investimento de Dubai Vy Capital, o capital de risco privado dos EUA Andreessen Horowitz, Sequoia Capital, empresa de investimento de capital de risco Fidelity Management & Research Company, e Kingdom Holding, uma holding da Arábia Saudita, etc.

O produto mais famoso da xAI atualmente é o chatbot Grok. Desde que Grok foi lançado oficialmente em novembro de 2023, ele vem se atualizando e tentando superar o ritmo do OpenAI.

No ano passado, Grok cresceu aos trancos e barrancos. Em março deste ano, Musk anunciou o código aberto do modelo especialista híbrido de 314 bilhões de parâmetros Grok-1 no final de março, xAI lançou o texto longo de 128k Grok-1.5 em abril, xAI lançou o primeiro modelo grande multimodal; Grok-1,5V.

Atualmente o xAI usa 20.000 GPUs para treinar o Grok 2.0. A versão mais recente do Grok pode processar texto, gráficos e reconhecer objetos do mundo real, e os modelos futuros do Grok também podem reconhecer áudio e vídeo.

Musk também declarou publicamente que o xAI usará até 100.000 GPUs para treinar e executar sua próxima versão do Grok.

De acordo com o último relatório do The Information, Musk revelou em uma apresentação aos investidores em maio que a xAI planeja construir uma “Gigafábrica de Computação” para fornecer suporte de poder computacional para a próxima versão do Grok.

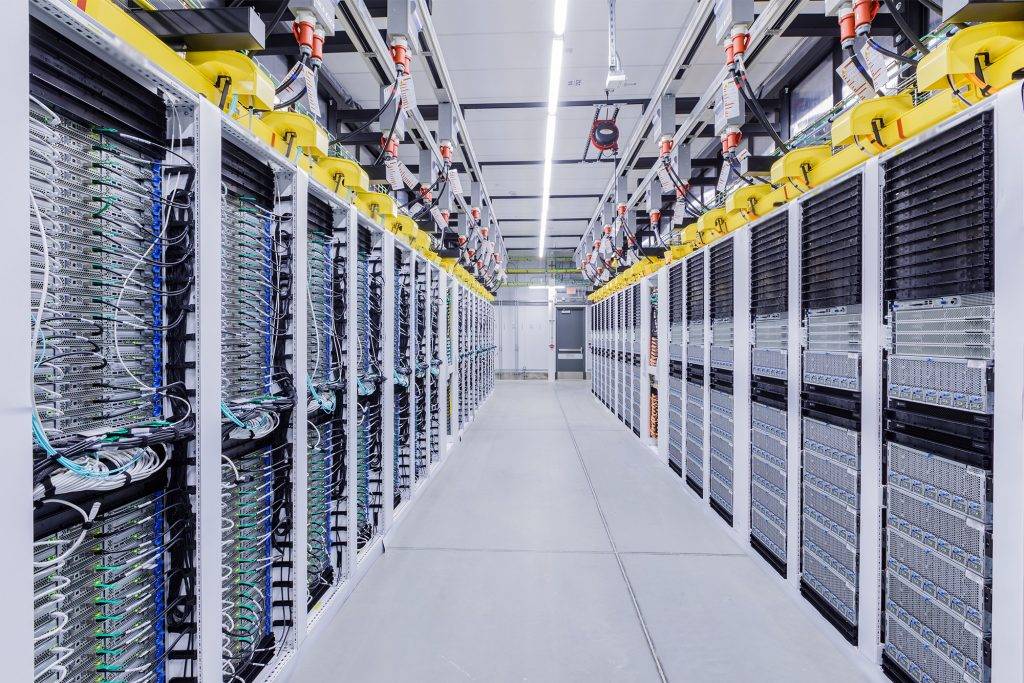

A nova “Super Computing Factory” da xAI é essencialmente um supercomputador, semelhante ao cluster de GPU Meta construído para treinar modelos de IA. Um cluster refere-se a vários chips de servidor conectados por cabos dentro de um único data center para que possam executar cálculos complexos simultaneamente e de maneira eficiente. De modo geral, ter um cluster com mais chips e maior poder de computação significa que ele pode trazer uma IA mais poderosa.

xAI planeja conectar 100.000 GPUs H100 à "Super Computing Factory" e pode cooperar com a Oracle. Em meados deste mês, foi relatado que a xAI estava discutindo questões relacionadas a servidores em nuvem com executivos da Oracle, e a xAI planejava gastar US$ 10 bilhões para alugar servidores Oracle nos próximos anos.

Atualmente, a xAI alugou aproximadamente 16.000 servidores com chip H100 da Oracle e se tornou o maior cliente de GPU da Oracle.

Além do poder computacional, outro fator importante na determinação da localização de um data center de IA é o fornecimento de energia. Foi calculado que um data center com 100.000 GPUs pode exigir 100 megawatts de energia dedicada.

O escritório da xAI está localizado na área da Baía de São Francisco, mas a eletricidade também será um fator importante a considerar ao selecionar a localização da nova “fábrica de supercomputação”.

Musk disse aos investidores que a xAI ainda está atrás dos concorrentes nesta fase. Fontes dizem que até o final deste ano ou início do próximo, OpenAI e Microsoft poderão ter clusters do tamanho imaginado por Musk.

A OpenAI e a Microsoft também estão discutindo o desenvolvimento de um supercomputador de US$ 100 bilhões contendo milhões de GPUs NVIDIA que seriam várias vezes maiores que o xAI.

Em março deste ano, no comunicado de imprensa da Nvidia, Musk declarou publicamente que o hardware de inteligência artificial da Nvidia era “o melhor”.

Musk também disse em uma teleconferência com investidores em abril que a Tesla tem 35 mil Nvidia H100 para treinar sua direção autônoma e planeja mais que dobrar esse número até o final do ano.

A CFO da NVIDIA, Colette Kress, incluiu xAI na lista de clientes. No futuro, xAI trabalhará com OpenAI, Amazon, Google e outras empresas para dar prioridade ao uso da arquitetura de IA generativa carro-chefe da próxima geração da NVIDIA, Blackwell.

Embora a "superfábrica de poder de computação" esteja fazendo fila para comprar chips NVIDIA, a xAI ainda está desenvolvendo seu próprio supercomputador Dojo.

No Tesla AI Day em 2022, ela demonstrou sua plataforma de computação Dojo desenvolvida por ela mesma. Dojo é composto internamente por "blocos de treinamento". Cada "bloco" contém 25 chips D1. Esses 25 chips são agregados em poder de computação de 54P e uma largura de banda de bisseção de 13,4 TB/S.

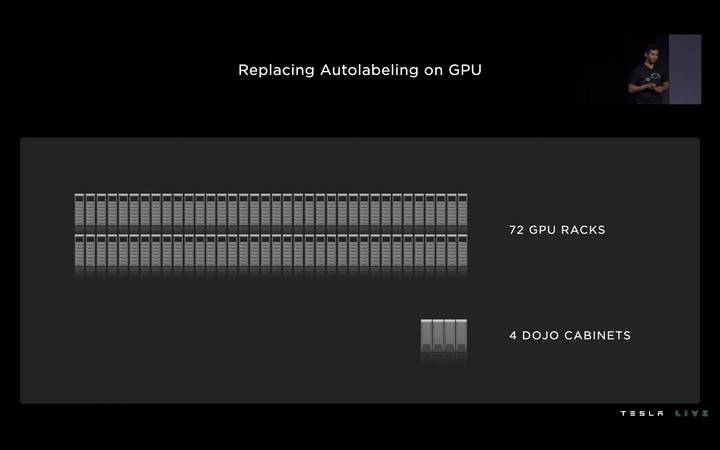

O Dojo também pode ser apresentado em forma de gabinete. Sob a poderosa pilha de hardware, um gabinete Dojo pode fornecer potência de computação 1.1E, 13 TB de memória de alta largura de banda e 1,3 TB de memória de alta velocidade. Quatro Dojos podem fornecer poder de computação equivalente a 72 racks de GPU.

No entanto, nesta fase, como a estabilidade e a produção do Dojo não foram garantidas, o xAI ainda só pode escolher GPUs NVIDIA para treinar IA.

O financiamento da Série B recentemente obtido pela xAI ajudou-a a resolver os seus encargos financeiros até certo ponto. Mas o próprio Musk admitiu que, se quiser ser competitivo no setor de IA, terá de gastar pelo menos vários bilhões de dólares todos os anos.

Quer se trate do Neuralink, que implanta microchips no cérebro humano, do Optimus, um robô humanóide, ou do assistente inteligente Grok AI, estes projetos ativamente promovidos por Musk apontam vagamente para o objetivo final: inteligência artificial geral (AGI).

xAI ainda tem um longo caminho a percorrer e está trabalhando duro para mudar o jogo. No entanto, agora parece que a Nvidia pode ser a maior vencedora no momento.

# Bem-vindo a seguir a conta pública oficial do WeChat do aifaner: aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.