O “pequeno canhão de aço” doméstico que derrubou o GPT-4V durante a noite pode ser a principal arma para Huawei e Xiaomi lutarem contra a IA do iPhone

Quantas etapas são necessárias para colocar um modelo grande em um telefone celular?

Se 2023 é o primeiro ano da explosão da IA generativa, então vários fabricantes alcançaram um raro consenso este ano – apostando totalmente em grandes modelos finais.

Como uma nova empresa de IA especializada em "grandes modelos eficientes", a Wallface Intelligence está flexionando seus músculos novamente hoje, lançando o modelo de código aberto multimodal final mais poderoso, MiniCPM-Llama3-V 2.5.

- O desempenho abrangente multimodal final mais forte: superando os gigantes multimodais Gemini Pro e GPT-4V

- Capacidades de OCR SOTA! Pixels 9 vezes mais nítidos, dificultando o reconhecimento preciso de imagens e textos longos

- A codificação de imagem é 150 vezes mais rápida! A primeira aceleração multimodal em nível de sistema final

A terceira bala do "pequeno canhão de aço" doméstico está aqui, esmagando o GPT-4V

Assim como os humanos dependem dos seus cinco sentidos para explorar o mundo, as capacidades multimodais são um curso obrigatório na evolução da IA.

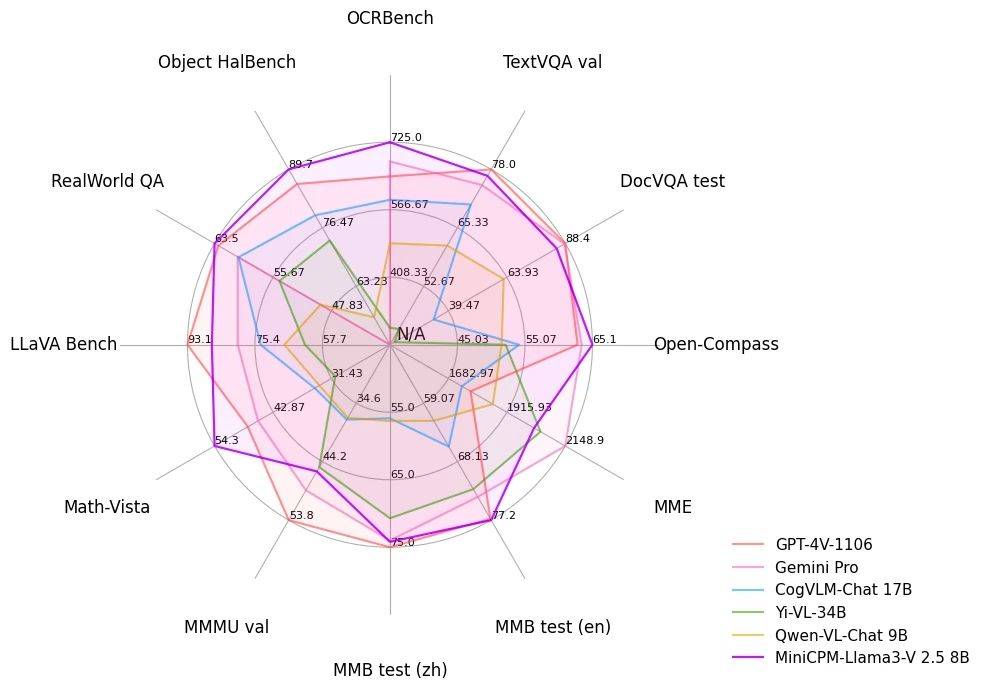

Com apenas um modelo final de 8B, o MiniCPM-Llama3-V 2.5, que é "grande com pequeno", obteve pontuação de 65,1 na plataforma de avaliação OpenCompass. Não só é comparável ao modelo de código fechado Qwen-VL-Max, como também é comparável. o desempenho geral também supera o peso pesado GPT-4V e Gemini Pro.

No abrangente teste de benchmark de OCR (Reconhecimento Óptico de Caracteres), o MiniCPM-Llama3-V 2.5 alcançou uma pontuação de 725 pontos, excedendo em muito o GPT-4V por uma grande margem e superando modelos inovadores como Claude 3V Opus.

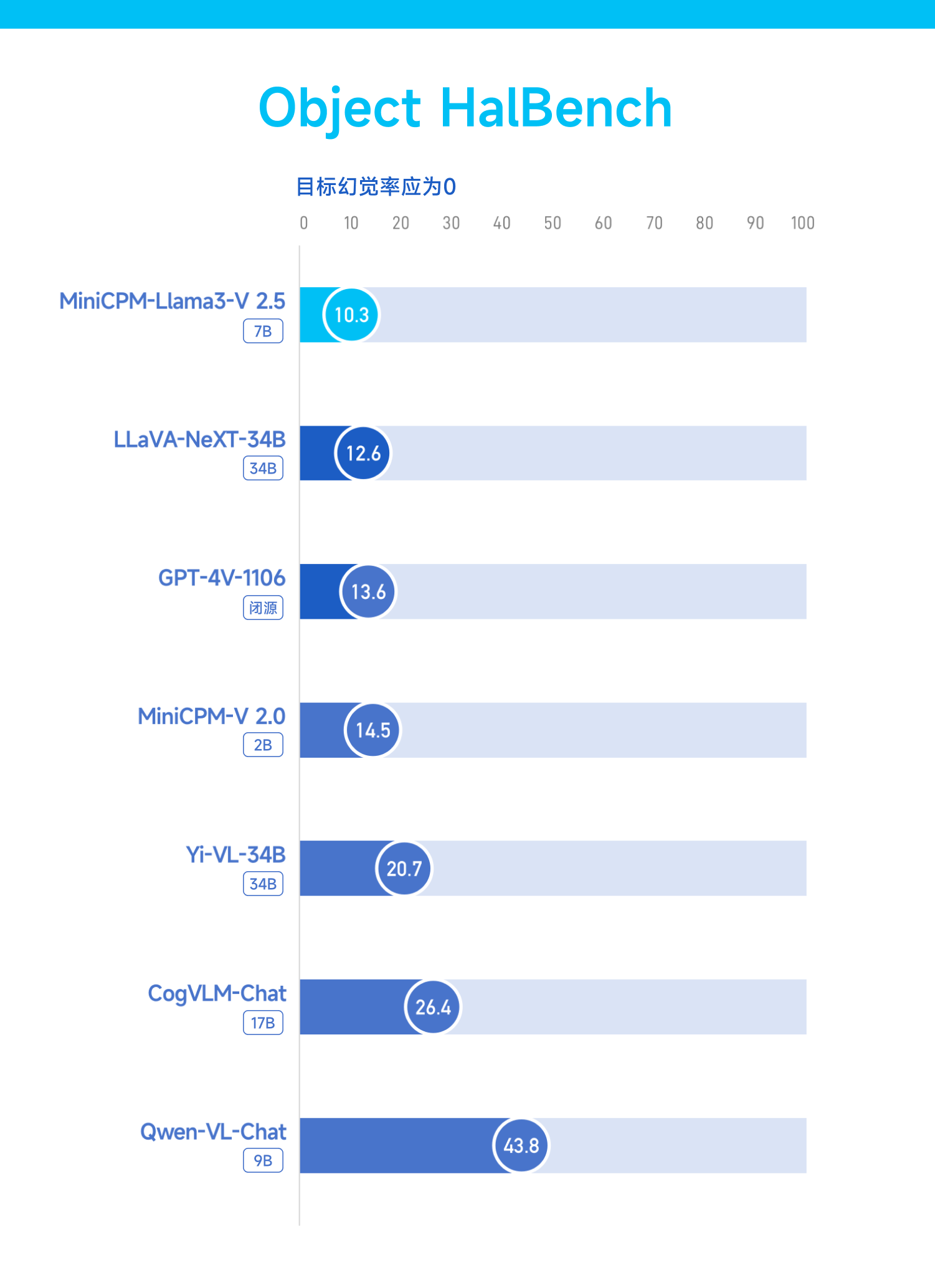

A capacidade de alucinar é o maior problema teimoso que assola modelos grandes em um curto período de tempo. O MiniCPM-Llama3-V 2.5 também melhorou esse problema.

Refletido no teste de benchmark Object HalBench, sua taxa de alucinação caiu drasticamente de 14,5 no MiniCPM-V 2.0 (2B) para 10,3, ultrapassando mais uma vez GPT-4 V e LLaVA-NeXT-34B.

O benchmark RealWorldQA é um teste de compreensão da realidade por um modelo.

MiniCPM-Llama3-V 2.5 entregou uma folha de respostas de 63,5, perdendo apenas para InternVL-Chat-V1.5 (26B), mas ainda superando GPT-4V e Gemini Pro.

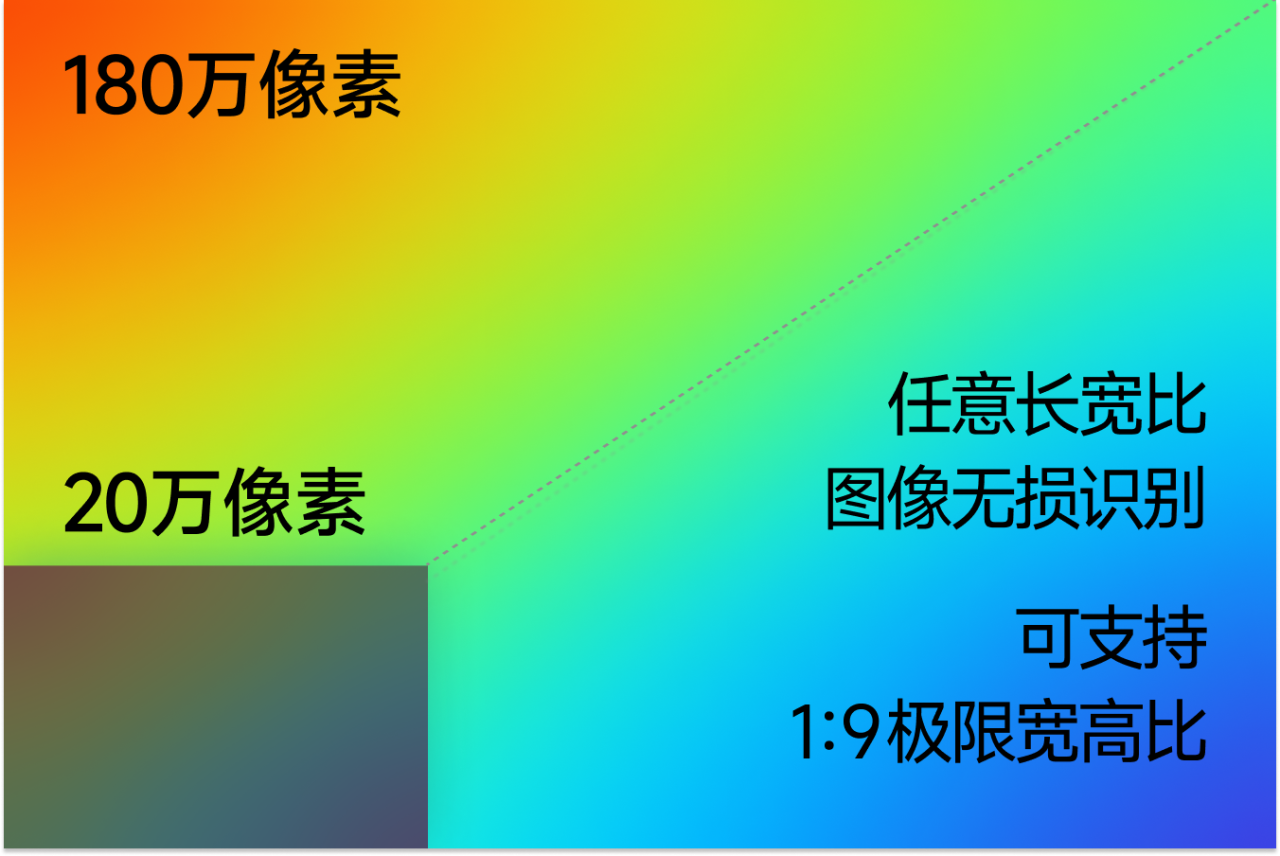

Contando com a tecnologia de codificação eficiente de imagem de alta definição autodesenvolvida, o MiniCPM-Llama3-V 2.5 suporta codificação eficiente e reconhecimento sem perdas de 1,8 milhão de imagens de pixel de alta definição e suporta qualquer proporção de aspecto, até mesmo a imagem de proporção extrema de 1:9 .Para isso, é apenas um pedaço de bolo.

“Ser capaz de ver” é apenas o começo, o mais importante é saber “pensar”. O MiniCPM-Llama3-V 2.5 leva as capacidades de raciocínio complexo a um novo nível.

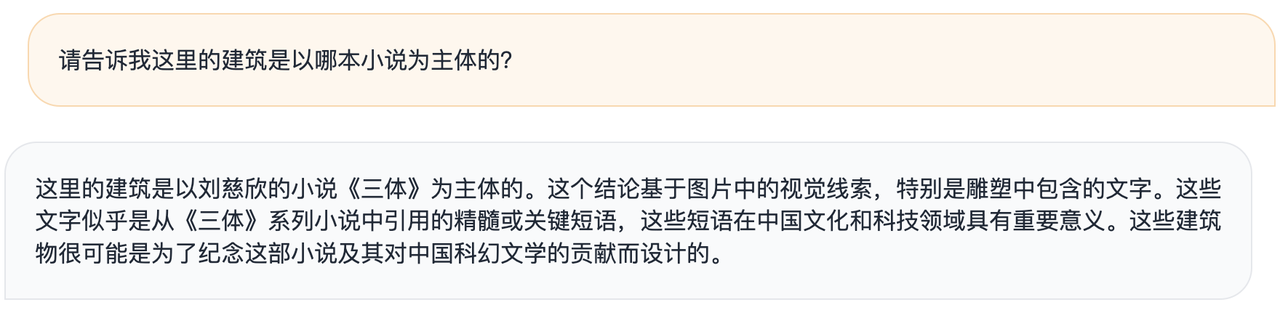

As autoridades disseram que, dado um exemplo de edifício artístico gravado com citações famosas de "O Problema dos Três Corpos", um modelo geral grande só pode descrever aproximadamente o modelo da imagem, mas o MiniCPM-Llama3-V 2.5 pode associá-lo a "O Problema dos Três Corpos" com base nas informações reconhecidas. "livros.

▲MiniCPM-Llama3-V 2.5

▲GPt-4V

Você também pode dar suas próprias ideias – esses edifícios provavelmente foram projetados para comemorar o romance e sua contribuição para a literatura de ficção científica chinesa.

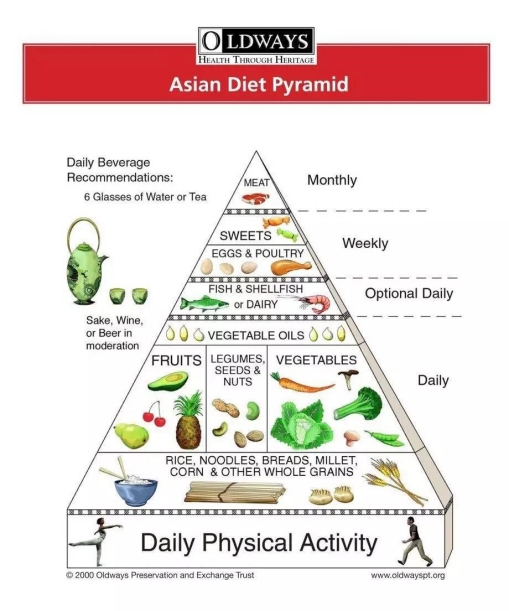

Ou dê-lhe uma versão em inglês da Pirâmide da Dieta Asiática e ele poderá instantaneamente se tornar um nutricionista pessoal e personalizar receitas para a semana.

Se você tem preguiça de ler artigos longos, deixe no MiniCPM-Llama3-V 2.5, e depois faça perguntas, ele dará as respostas o mais rápido possível.

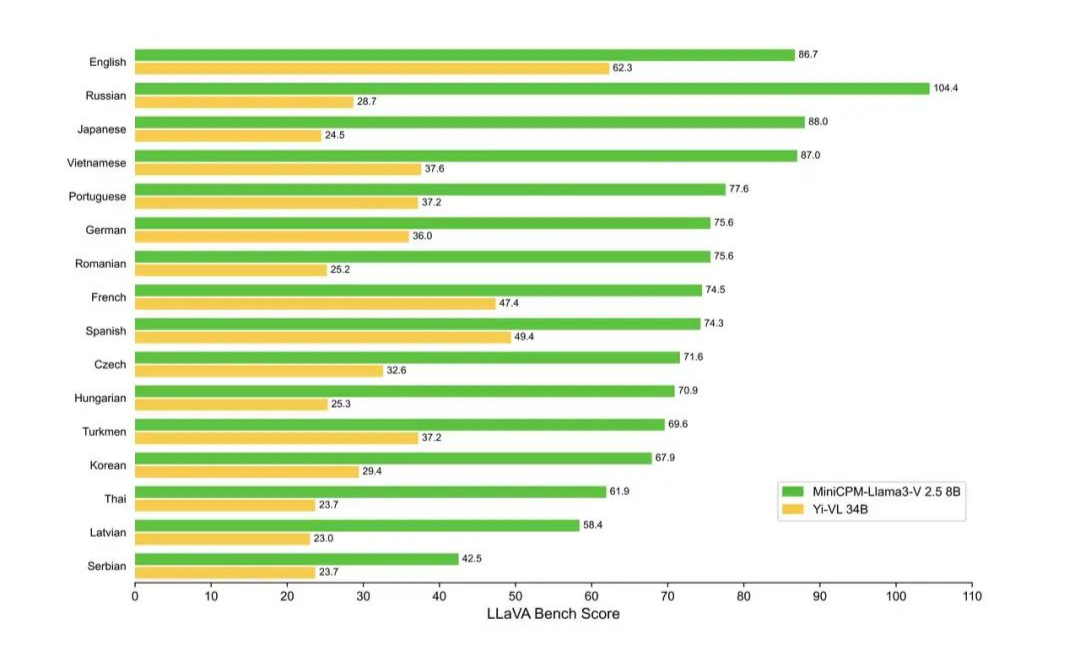

Agora, o MiniCPM-Llama3-V 2.5 suporta mais de 30 idiomas, abrangendo alemão, francês, espanhol, italiano, russo e outros idiomas convencionais. Os idiomas dos países ao longo do Cinturão e Rota estão basicamente ao seu alcance.

Deve-se notar que MiniCPM-Llama3-V 2.5 é na verdade um modelo ajustado baseado no modelo de código aberto Llama3-8B-Instruct.

No passado, era um grande problema permitir que a IA processasse diferentes informações, como imagens e texto, ao mesmo tempo e em alta velocidade. No entanto, o Wall-Facing Intelligence adota uma estrutura de aceleração NPU, que é especialmente projetada para acelerar o processo. processamento de imagens, fazendo com que a IA funcione de forma mais eficiente em telefones celulares.

De acordo com a introdução oficial, o revestimento de parede só pode realizar a aceleração do sistema final pela primeira vez. Atualmente, o MiniCPM-Llama3-V 2.5 foi implantado com eficiência em telefones celulares e alcançou uma aceleração de 150 vezes na codificação de imagem.

Por exemplo, a velocidade de decodificação do modelo de idioma Llama 3 no telefone celular é de cerca de 0,5 token/s, enquanto o modelo multimodal MiniCPM-Llama3-V 2.5 melhorou a velocidade de decodificação de idioma no telefone celular para 3 por meio de otimização múltipla métodos como CPU.

Em anexo está o endereço de código aberto MiniCPM-Llama3-V 2.5:  https://github.com/OpenBMB/MiniCPM-V

https://github.com/OpenBMB/MiniCPM-V

Modelo do lado do dispositivo, um campo de batalha para fabricantes de telefones celulares

Nos últimos dois anos, os modelos do lado do dispositivo apareceram frequentemente nos PPTs de voz dos principais fabricantes de terminais.

Os chamados modelos finais são aqueles modelos de inteligência artificial executados em dispositivos terminais. Esses modelos são normalmente projetados para serem leves o suficiente para acomodar o poder de computação e as restrições de recursos do dispositivo final.

Depois que o GPT-4 entrou no ar, "AI Godfather" Geoffrey Hinton apontou uma vez que acho que haverá um estágio em que treinaremos em computadores com grande poder de computação. Uma vez treinado, ele poderá ser executado em dispositivos de baixo consumo de energia. .

A característica do modelo end-side é que ele pode ser executado no lado do dispositivo (como smartphones, sistemas embarcados, etc.) para processar dados e tomar decisões sem enviar os dados para um servidor remoto.

Separando as palavras acima, podemos descobrir as vantagens do modelo final:

- Execução local: O modelo é executado localmente no dispositivo sem depender de um servidor remoto.

- Processamento em tempo real: Capacidade de processar dados em tempo real no dispositivo, proporcionando resposta rápida.

- Baixa latência: Como os dados não precisam ser transferidos entre o dispositivo e o servidor, eles apresentam menor latência.

- Proteção da privacidade: Os dados são processados localmente, reduzindo o risco de vazamento de dados e melhorando a proteção da privacidade.

- Independência de rede: O modelo final funciona mesmo sem conectividade de rede.

- Otimização de recursos: O modelo final geralmente precisa ser otimizado para se adaptar aos recursos computacionais limitados e ao espaço de armazenamento do dispositivo terminal.

- Aplicável a uma variedade de dispositivos: O modelo do lado do cliente pode ser implantado em vários tipos de dispositivos terminais, incluindo, entre outros, smartphones, dispositivos domésticos inteligentes, dispositivos vestíveis, etc.

- Miniaturização e otimização: Os modelos podem precisar passar por compressão, poda, quantização e outros processos técnicos para reduzir o tamanho do modelo e melhorar a eficiência operacional.

É claro que o grande modelo do lado do cliente e o grande modelo da nuvem são sinérgicos, e não o produto de oposição.

Assim, vemos que, embora modelos grandes como Llama 3 e Claude estejam se desenvolvendo a todo vapor, a pesquisa sobre modelos finais não ficou para trás.

O cientista da NVIDIA JImFan apontou que o mais recente GPT-4o é provavelmente um modelo pequeno destilado, e os benefícios são óbvios – mais refinado e mais eficiente.

Quer seja o Phi-3 lançado pela Microsoft no mês passado, a série de pequenos canhões de aço de desempenho lançada pela Wallface Intelligence ou a série de modelos OpenELM recentemente anunciada pela Apple como código aberto, novos modelos de pequeno porte são constantemente lançados.

2024 é um ano crítico para a implementação de aplicações de IA, e os modelos do lado do dispositivo também estão ganhando impulso e se preparando para brilhar neste ano.

Um fato indiscutível é que a maioria das inovações atuais em terminais atingiu um período de gargalo. Tomemos como exemplo os telefones celulares que “crescem” em nossos corpos. A sensação de surpresa e inovação quando Steve Jobs lançou o iPhone há muito se perdeu no longo rio do tempo.

A proposta de inovação de terminais impulsionada pela IA, independentemente de ser mais um artifício do que a realidade ou de usar tecnologia futura para “conceder dinheiro” ao presente, pode na verdade libertar ainda mais a imaginação de dispositivos como telefones celulares e se tornar um ponto-chave para quebrar o jogo.

É sob essa tendência que o modelo do lado do dispositivo deixou de ser apenas um conceito que permanece nas discussões teóricas ou nos folhetos dos fabricantes. Ele começou a penetrar gradativamente em nosso dia a dia.

Na conferência HamonyOS 4 em agosto do ano passado, Yu Chengdong anunciou a capacidade do assistente inteligente Xiaoyi de acessar grandes modelos de IA. Imediatamente depois, Lei Jun revelou que a Xiaomi executou um modelo grande com parâmetros de 1,3B em seu celular, e os efeitos de algumas cenas são comparáveis aos da nuvem.

Nenhum dos telefones celulares domésticos "Yuwujia" foi deixado para trás. OPPO Xiaobu Assistant baseado em AndersGPT, Honor Magic 6 equipado com modelo grande AI do lado do terminal 7B e vivo equipado com matriz de modelo grande Blue Heart também foram anunciados oficialmente um após o outro.

Nas primeiras horas desta manhã, o repórter da Bloomberg Mark Gurman deu a notícia de que a Apple melhorará a função de voz da Siri para torná-la mais conversacional e adicionará funções para ajudar os usuários a lidar com a vida diária, incluindo:

- Resumir automaticamente as notificações do iPhone

- Resuma artigos de notícias

- Transcrever memorandos de voz

- Melhorar os recursos existentes para preenchimento automático de calendários e recomendação de aplicativos

- Edição de fotos com IA

Quanto ao principal assistente de voz Siri, é provável que no futuro esteja intimamente conectado com o modelo do lado do dispositivo OpenAI ou Gemini.

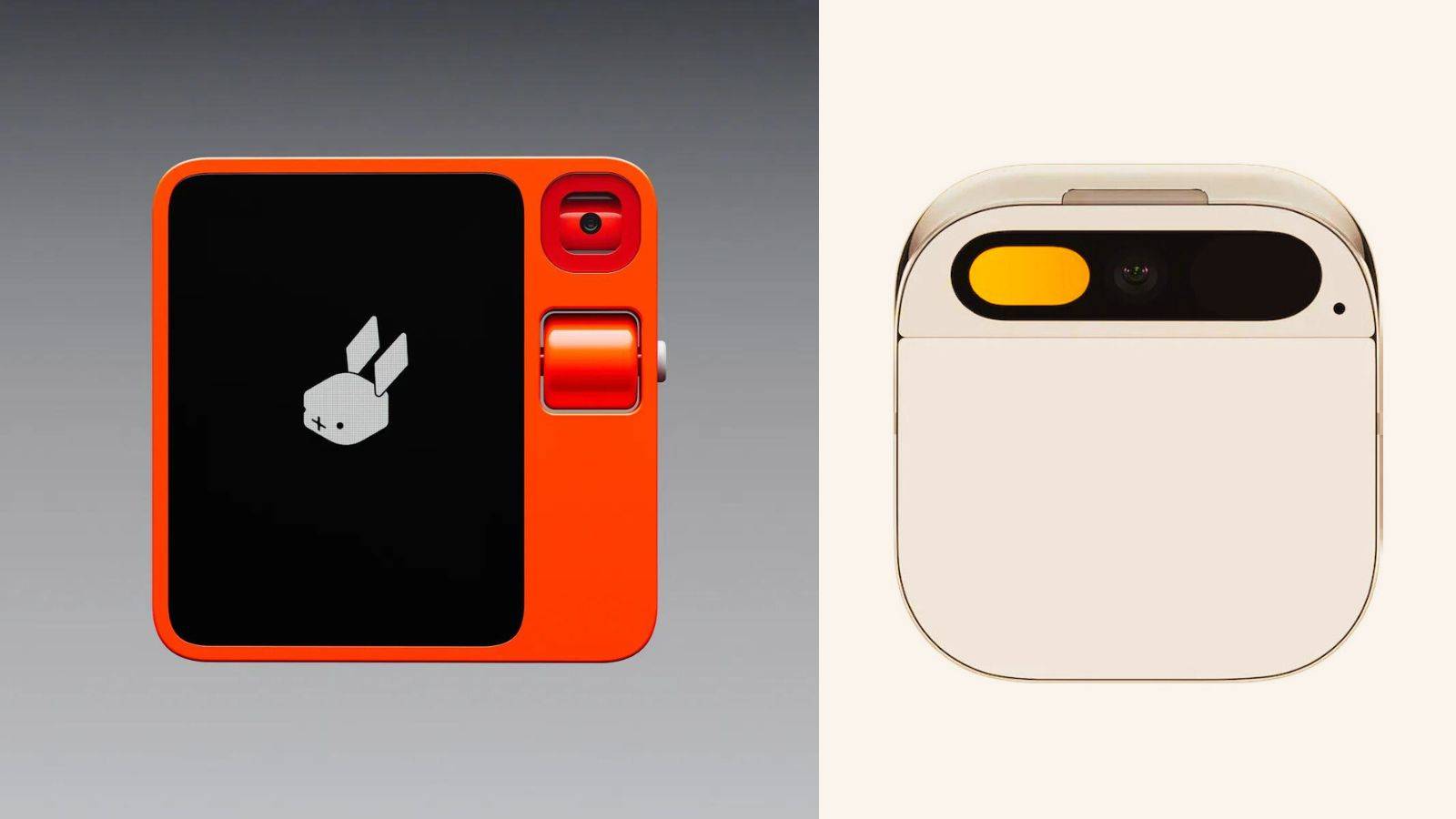

Embora o popular hardware de IA Rabbit R1 seja questionado como sendo um shell Android, o que ele mostrou na conferência de imprensa também é um perfil do estado ideal de um telefone com IA – um sistema sem barreiras entre aplicativos e com interação suave.

No entanto, esta situação não acontece da noite para o dia. Se o assistente de voz AI puder realmente entender os usuários e agendar aplicativos conforme o esperado, isso não apenas subverterá completamente a experiência do usuário, mas também deverá mudar o relacionamento entre fabricantes de telefones celulares e terceiros. desenvolvedores de aplicativos de terceiros.

Por exemplo, há notícias de que a Apple, que sempre esteve fechada, começou a abraçar ativamente a abertura face a esta torrente de mudanças tecnológicas.

De acordo com Ben Reitzes, da Melius Research, a Apple deverá lançar uma loja dedicada a aplicativos de IA na próxima WWDC. Este não é apenas um importante ponto de viragem na estratégia aberta da Apple, mas também um sinal claro da sua transformação estratégica na era da IA.

Isso também mostra que a Apple está tentando criar mais valor para desenvolvedores e usuários, construindo um ecossistema aberto de IA, ao mesmo tempo que conquista um espaço de mercado mais amplo para si mesma.

Mais perto de casa, modelos finais como o MiniCPM-Llama3-V 2.5 provaram sua força – o modelo não só tem "quanto maiores os parâmetros, melhor o desempenho", mas pode aproveitar o desempenho mais forte com os menores parâmetros!

Ao mesmo tempo, entrar na vida é apenas o primeiro passo. Quando a jornada de dados é reduzida a zero, o modelo do lado do dispositivo permite que a IA reaja um passo mais rápido do que o pensamento humano, o que pode significar que a próxima primavera de dispositivos terminais terá chegado. realmente chegou.

Até então, cada interação entre usuários e produtos finais irá desencadear um som involuntário de “uau”.

# Bem-vindo a seguir a conta pública oficial do WeChat do aifaner: aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.