Bombardeio noturno! Nvidia lança o chip de IA mais poderoso do mundo, com desempenho aumentando 30 vezes. Huang é o Steve Jobs desta época

Agora mesmo, a NVIDIA lançou o chip AI mais poderoso do mundo.

A IA generativa atingiu um ponto crítico.

A conferência GTC 2024 de duas horas foi mais como um concerto em grande escala. Jim Fan, um cientista sênior da NVIDIA, brincou que “Jensen Huang é a nova Taylor Swift”.

Esta é provavelmente a posição atual de Jen-Hsun Huang da Nvidia na indústria de IA.

No ano passado, Huang Renxun afirmou que o "momento iPhone" da IA chegou, permitindo-nos ver como a vida quotidiana está a ser reescrita pela IA, e hoje mostra que a velocidade desta mudança está a acelerar loucamente.

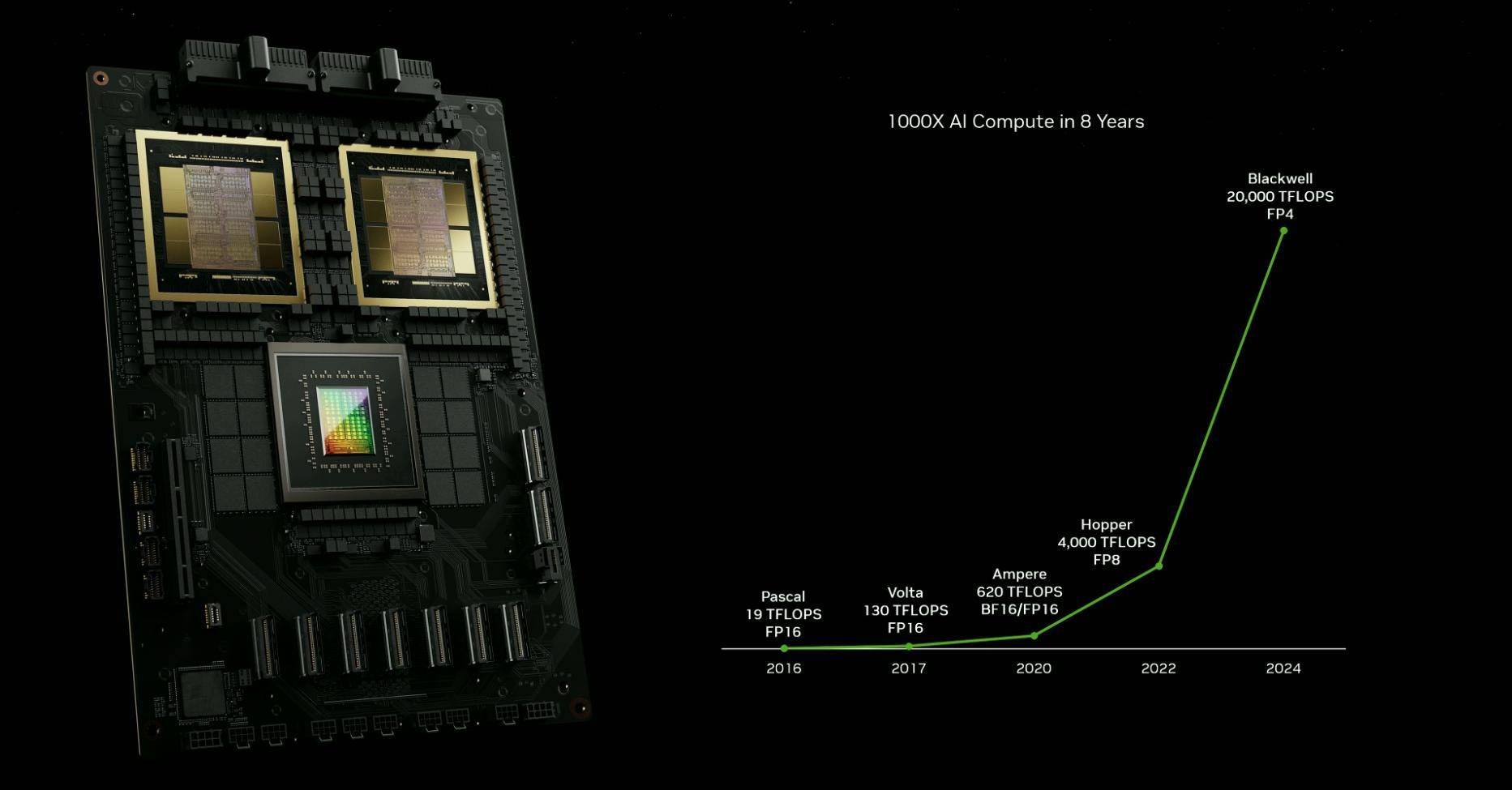

Nos últimos 10 anos, a NVIDIA avançou a IA aproximadamente um milhão de vezes, ultrapassando em muito a Lei de Moore. Em outras palavras, a NVIDIA está escrevendo sua própria lei de iteração. Do poder de computação do chip à implementação de IA, da fabricação de automóveis à logística médica, a NVIDIA promoveu o desenvolvimento de vários setores ao mesmo tempo em que progrediu.

A Lei de Moore morreu, mas a NVIDIA deu origem a uma nova Lei de Moore.

Exceto pelas placas gráficas de computador, a NVIDIA raramente é percebida por nós em tempos normais, mas o progresso tecnológico de muitos produtos ao nosso redor é sempre inseparável deles. Depois de ler este primeiro resumo do GTC 2024, talvez você possa ter uma percepção mais óbvia do onda de AIGC.

Um tweet enviado pelo CEO da OpenAI, Sam Altman, no X ontem à noite pode ser uma nota de rodapé dos tempos:

Este é o ano mais interessante da história da humanidade, exceto para todos os anos futuros

Este foi o ano mais interessante da história da humanidade, mas será o ano mais chato no futuro.

Nasce o chip de IA mais poderoso do mundo e seu desempenho dispara

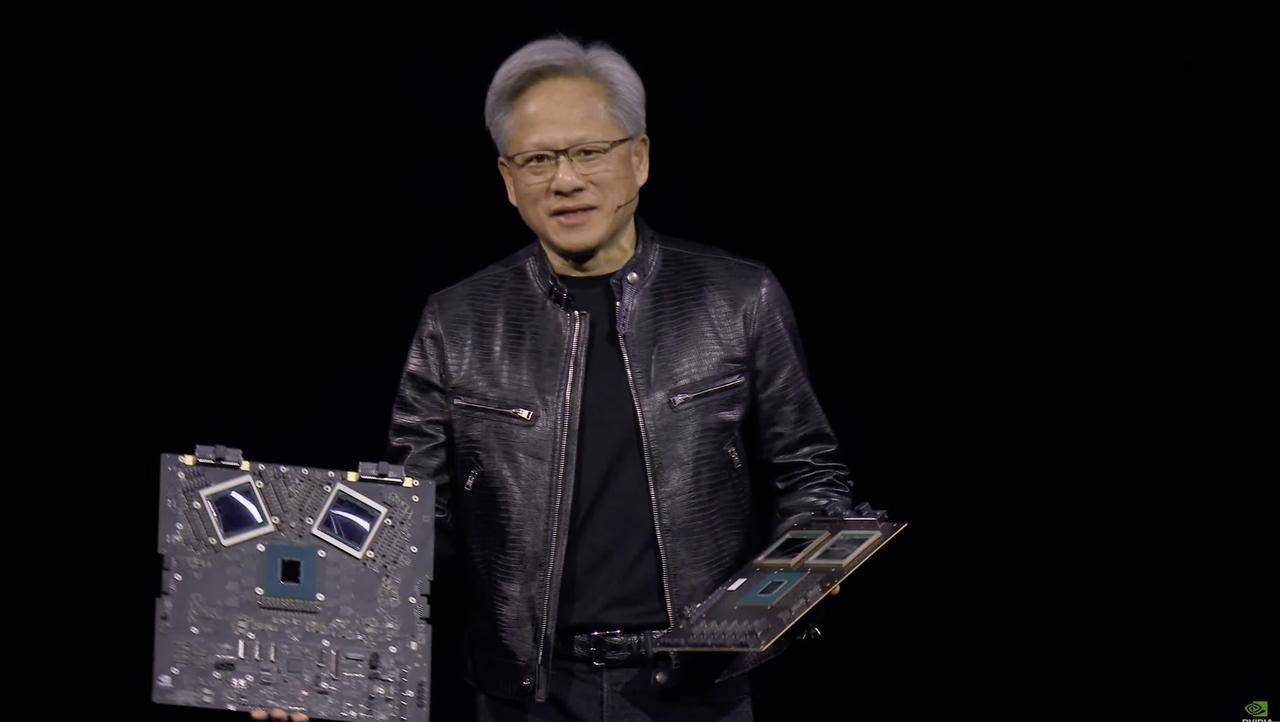

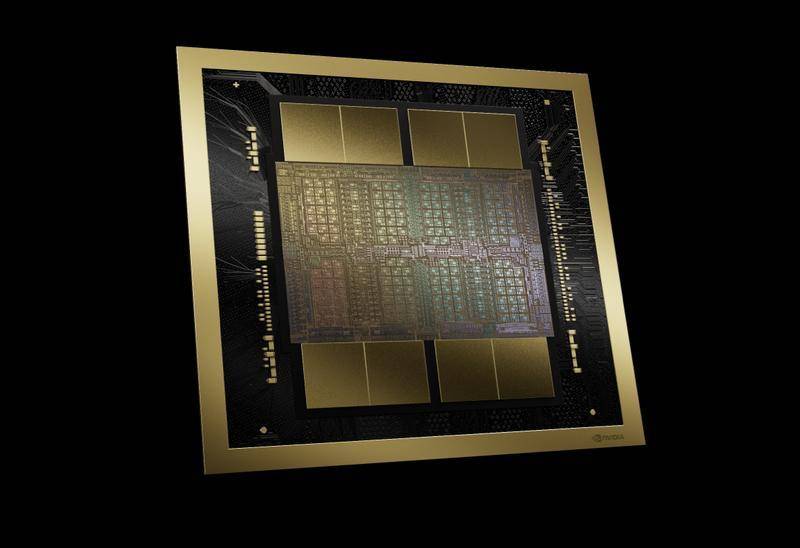

Esta é a GPU mais avançada em produção no mundo atualmente.

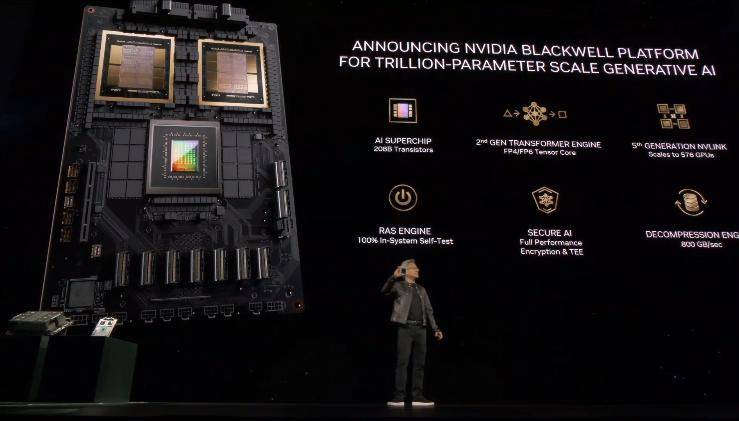

O protagonista da conferência de imprensa é o chip AI "Blackwell B200", Huang Renxun disse que o nome deste chip vem do matemático, teórico dos jogos e teórico das probabilidades David Blackwell.

Baseado no processo 4NP da TSMC, o chip de computação sob a arquitetura Blackwell possui 104 bilhões de transistores, o que é outro avanço em comparação com os 80 bilhões de transistores da GPU GH100 da geração anterior.

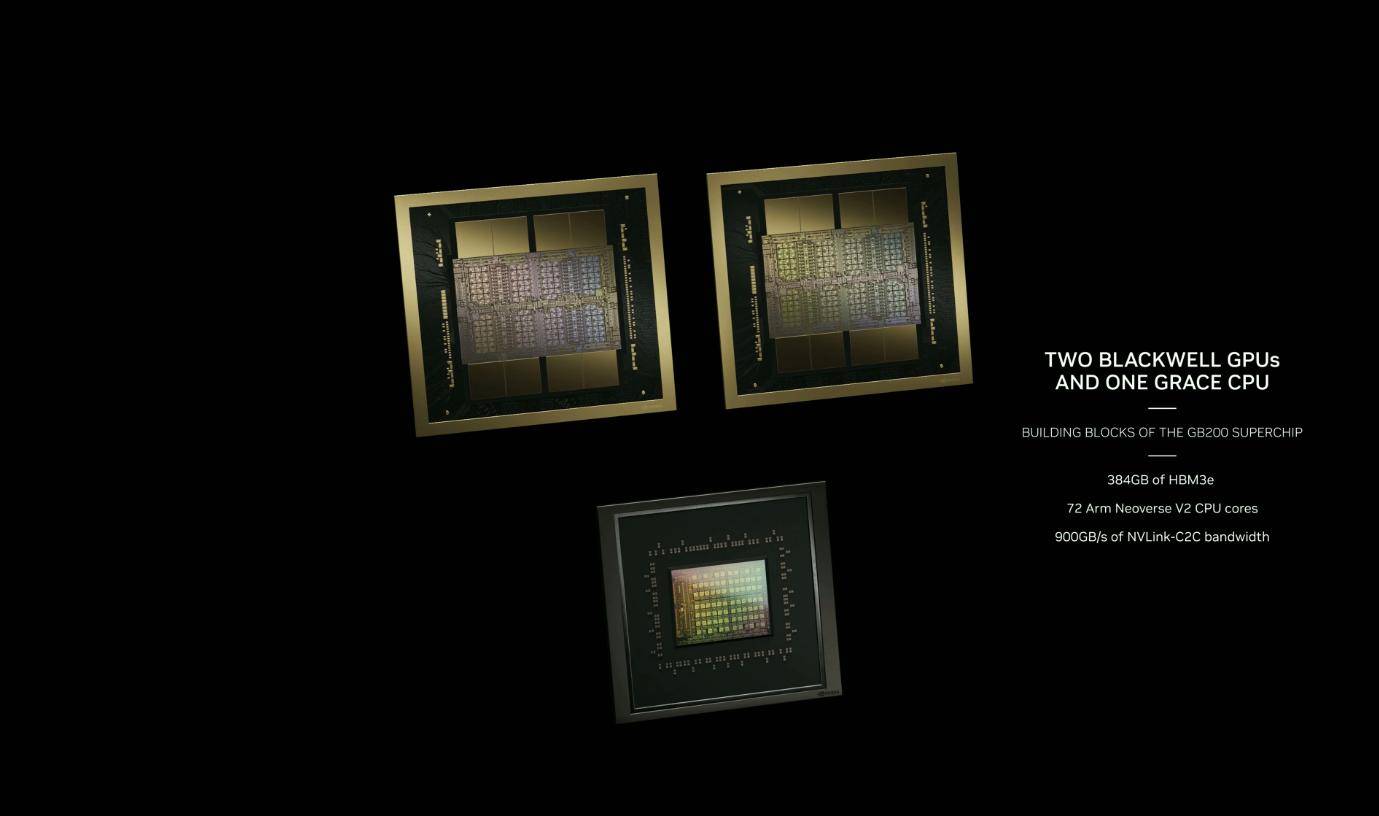

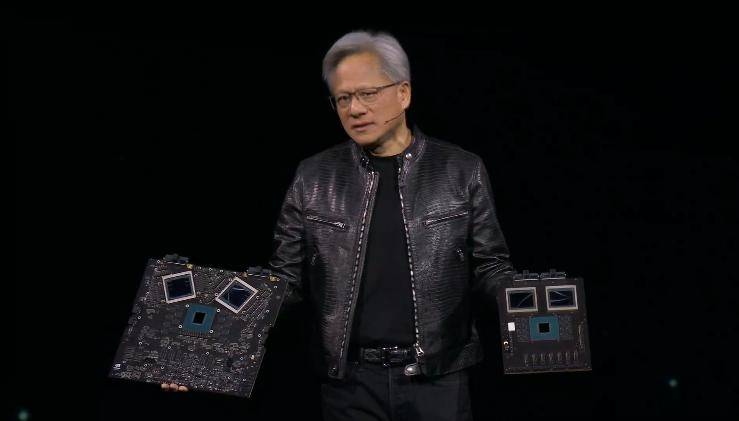

Blackwell B200 não é uma única GPU no sentido tradicional, é composta por duas GPUs Blackwell + um chip Grace CPU e é conectada por meio de NV-HBI (Nvidia High Bandwidth Interface) de 10 TB/s para garantir que cada chip possa funcionar sozinho. .

Portanto, o B200 na verdade tem 208 bilhões de transistores e pode fornecer até 20 petaflops de poder de computação FP4.As duas GPUs combinadas com uma única CPU Grace podem aumentar a eficiência do trabalho de inferência LLM (Large Language Model).

O desempenho do GB200 também será bastante melhorado.No benchmark GPT-3 LLM com 175 bilhões de parâmetros, o desempenho do GB200 é 7 vezes maior que o do H100 e sua velocidade de treinamento é 4 vezes maior que a do H100.

Além disso, reduz os custos e o consumo de energia em 25 vezes em comparação com o H100.

Anteriormente, embora o processador AI H100 da NVIDIA fosse muito popular, o consumo máximo de energia de cada H100 chegava a 700 watts, excedendo o consumo médio de energia das residências americanas comuns. Os especialistas prevêem que, à medida que um grande número de H100s são implantados, sua potência total o consumo será tão elevado quanto Uma grande cidade americana é comparável, ou mesmo maior, a alguns pequenos países europeus.

Huang Renxun disse que treinar um modelo de 1,8 trilhão de parâmetros anteriormente exigia 8.000 GPUs Hopper e 15 megawatts de potência. Agora, 2.000 GPUs Blackwell podem fazer isso com apenas 4 megawatts de consumo de energia.

O poderoso desempenho da GPU Blackwell B200 também pode ser perfeitamente refletido em termos de consumo de energia. O B200, que utiliza a mais recente tecnologia de interconexão NVLink, suporta a mesma arquitetura de 8GPU e switches de rede de 400 GbE. Embora seu desempenho seja bastante melhorado, ele pode atingir o mesmo pico de consumo de energia (700 W) que a geração anterior H100/H200.

Outro ponto digno de nota é o poder computacional do FP4. Huang Renxun disse que nos últimos oito anos, o poder de computação da IA aumentou mil vezes.A melhoria mais crítica é o motor Transformer de segunda geração, que melhorou significativamente a computação, a largura de banda e o tamanho do modelo através do poder de computação do FP4.

Comparado com o poder de computação FP8 comumente usado em IA, os dois chips de computação do B200 tornam seu desempenho 2,5 vezes maior que o do H100. O poder de computação de cada chip na arquitetura Blackwell é 25% maior do que o chip Hopper da geração anterior.

O cientista sênior da NVIDIA, Jim Fan, chama a nova GPU Blackwell B200 de "uma nova fera de desempenho".

O poder de computação do B200 excede 1 Exaflop em uma única arquitetura. O desempenho do primeiro DGX entregue à OpenAI por Jen-Hsun Huang é de 0,17 petaflops. Os parâmetros GPT-4-1.8T podem ser treinados em 2.000 unidades Blackwell em 90 dias.

Não é exagero dizer que nasceu uma nova Lei de Moore.

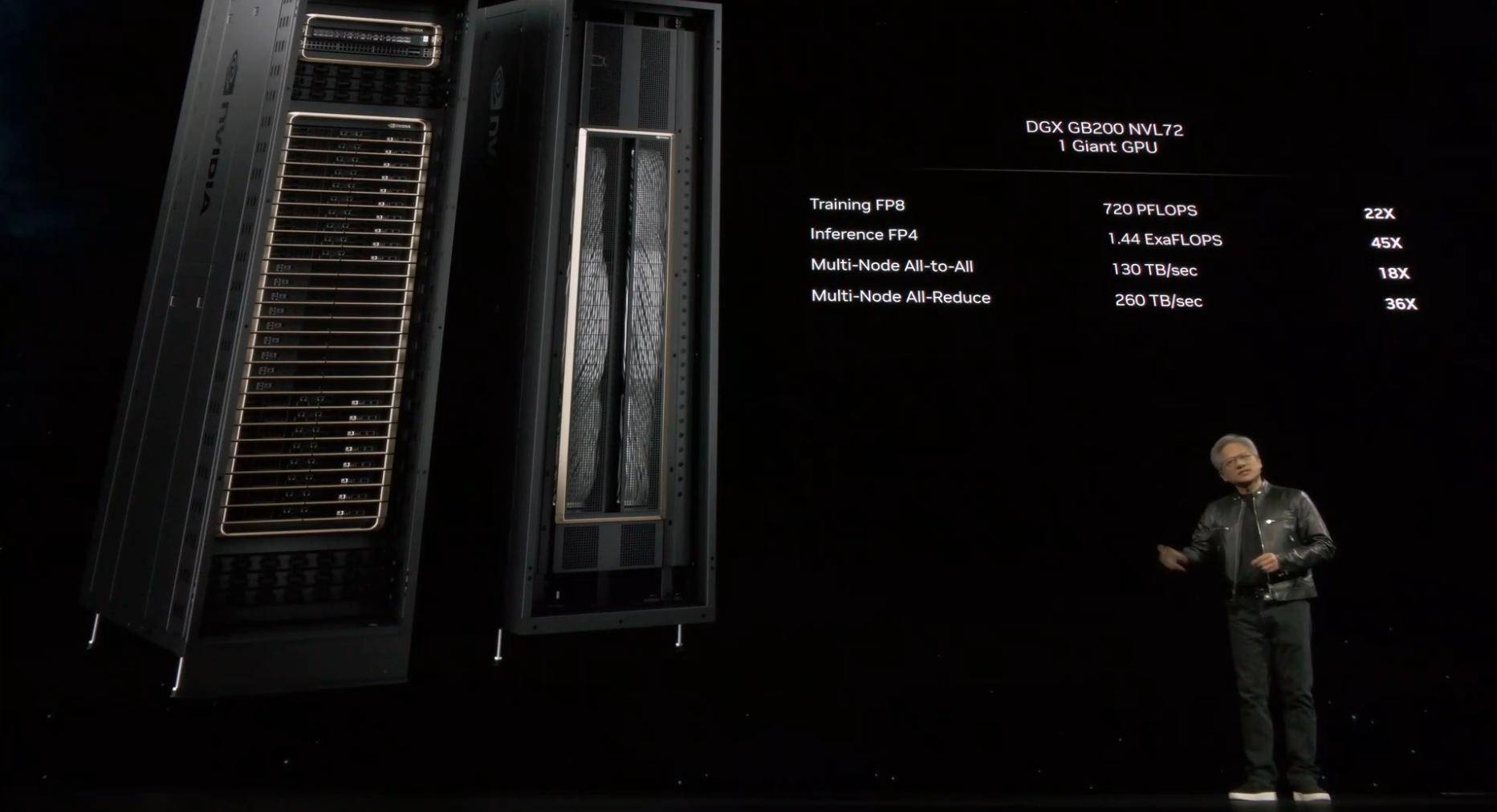

Como o Blackwell está disponível em diversas variantes, a Nvidia também fornece especificações para o nó de servidor completo, com três opções principais.

O primeiro é o maior e mais poderoso sistema GB200 NVL72, configurado com 18 servidores 1U, cada servidor equipado com dois super chips GB200. O sistema fornece 72 GPUs B200 com 1440 Peta FLOPS de desempenho de inferência de IA FP4 e 720 Peta FLOPS de desempenho de treinamento de IA FP8. Ele adotará uma solução de refrigeração líquida. Um NVL72 pode lidar com 27 trilhões de modelos de parâmetros (GPT-4 O parâmetro máximo não exceder 1,7 trilhão de parâmetros).

Outra especificação é o HGX B200, que se baseia no uso de oito GPUs B200 e uma CPU x86 em um único nó de servidor. Cada GPU B200 pode ser configurada até 1000W, e a GPU fornece até 18 petaflops de taxa de transferência FP4, o que é mais lento. do que a GPU no GB200 10%.

Por fim, a NVIDIA também lançará o HGX B100, que possui as mesmas especificações gerais do HGX B200, equipado com CPU x86 e 8 GPUs B100, mas será diretamente compatível com a infraestrutura HGX H100 existente e permitirá a implantação mais rápida de GPUs Blackwell. , cada O TDP da GPU é limitado a 700W.

Antes disso, a Nvidia se tornou uma empresa multitrilionária por meio de chips de IA como H100 e H200, superando empresas líderes como a Amazon. A nova GPU Blackwell B200 e o "super chip" GB200 lançados hoje são muito promissores. Pode se estender sua liderança e até mesmo ultrapassar a Apple.

A era do software que define tudo está chegando

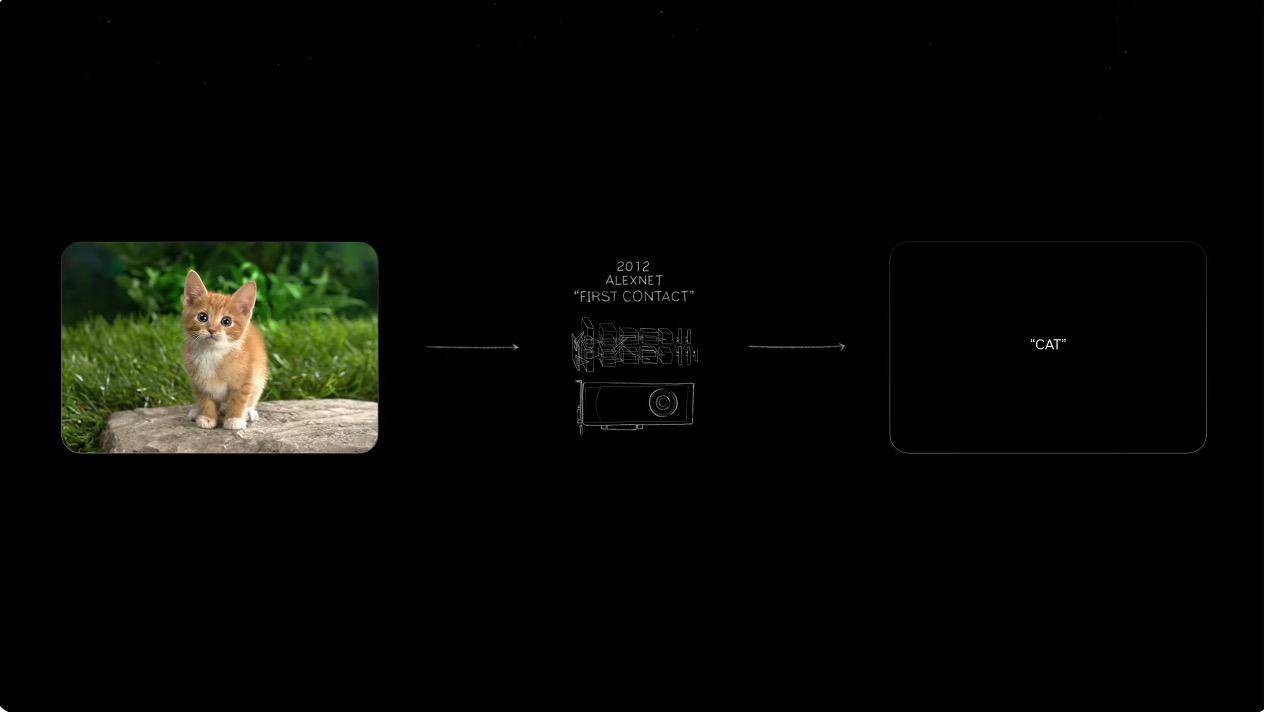

Em 2012, um pequeno grupo de pesquisadores lançou um sistema inovador de reconhecimento de imagens chamado AlexNet, que na época superava em muito os métodos anteriores na tarefa de classificar cães e gatos, tornando-o líder em aprendizagem profunda e redes neurais convolucionais. o potencial da (CNN) no reconhecimento de imagens.

Foi justamente depois de ver as oportunidades na IA que Huang Renxun decidiu apostar tudo na IA. O interessante é que antigamente era usado para reconhecer imagens geradas e gerar texto, mas agora é para gerar imagens por meio de texto.

Então, quando a onda de IA generativa chegar, o que podemos fazer com ela? Jen-Hsun Huang deu algumas respostas padrão.

Os modelos meteorológicos tradicionais combinados com o modelo meteorológico Cordiff da NVIDIA podem alcançar previsões que exploram áreas de centenas ou até milhares de quilômetros, fornecendo a gama de impactos como tufões, minimizando assim as perdas de propriedades. Cordiff também estará aberto a mais países e regiões no futuro.

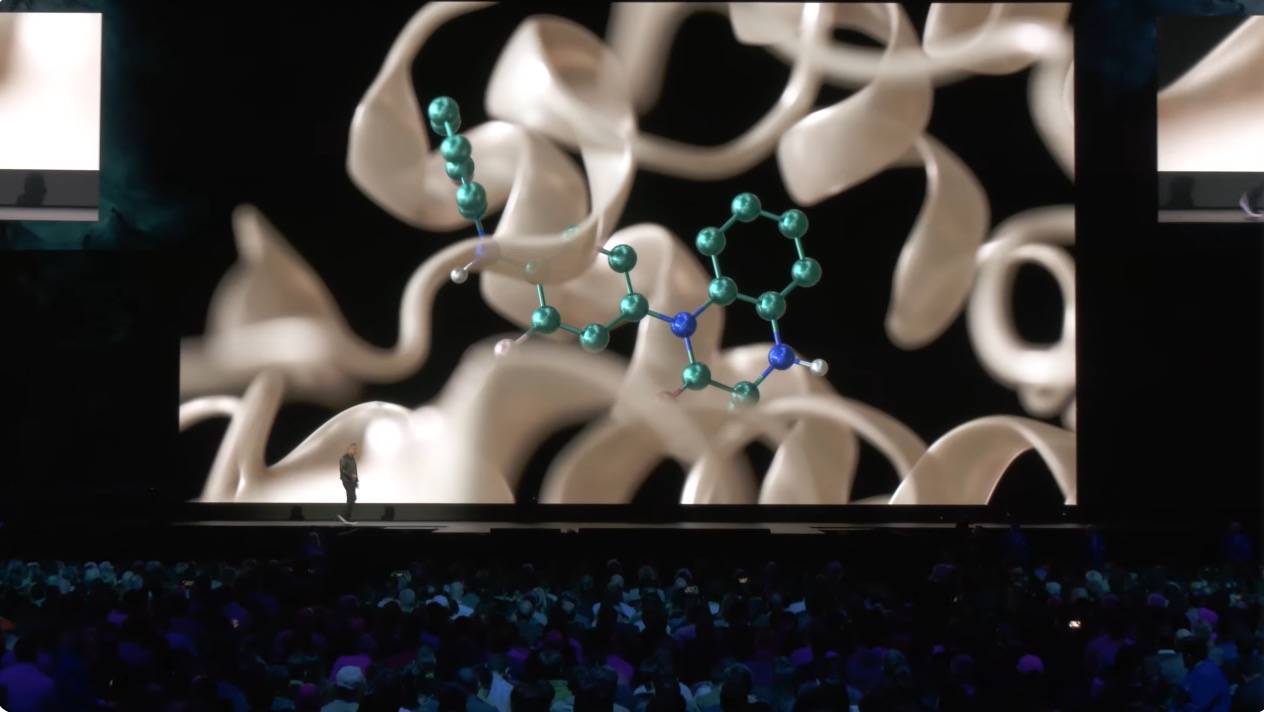

A IA generativa pode não só compreender imagens e áudio através de capacidades digitais, mas também pode utilizar o seu enorme poder computacional para digitalizar milhares de milhões de compostos para detectar novos medicamentos.

Como traficante de armas de IA, Huang Renxun também introduziu o sistema NiMS, especializado em auxiliar no desenvolvimento de chips de IA. No futuro, você pode até ter a oportunidade de formar uma superequipe de IA. Depois de dividir a tarefa em uma série de subtarefas, você pode permitir que diferentes IAs concluam tarefas como recuperação e otimização de software.

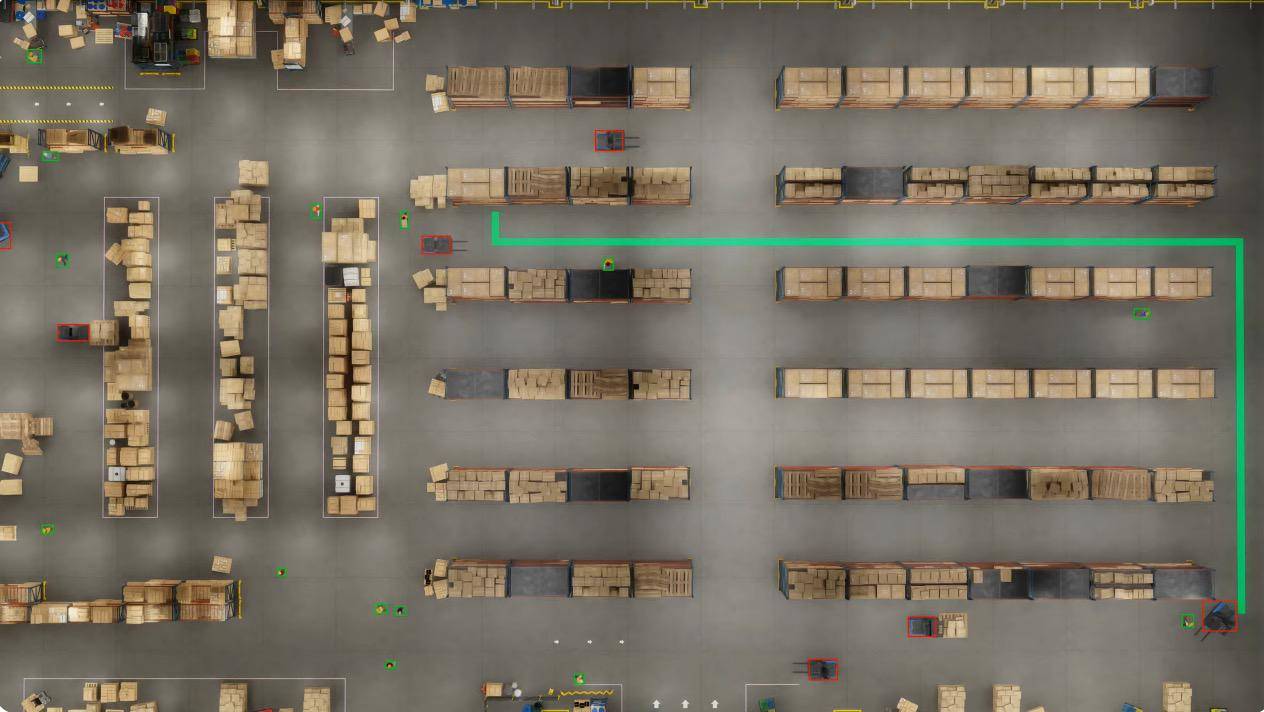

As instalações, armazéns e edifícios fabris do futuro serão definidos por software.

Quer se trate de robôs humanóides, carros autônomos ou braços manipuladores, esses robôs autônomos requerem sistemas operacionais em nível de software. Por exemplo, através da combinação de IA e Omniverse, a NVIDIA construiu um armazém robótico cobrindo uma área de 100.000 metros quadrados.

Neste ambiente simulado fisicamente preciso, 100 câmeras montadas no teto mapeiam todas as atividades no armazém em tempo real usando o software NVIDIA Metropolis e os recursos de planejamento de rotas de robôs móveis autônomos (AMRs).

Essas simulações também incluem testes de loop de software do agente de IA para avaliar e otimizar a capacidade do sistema de se adaptar à imprevisibilidade do mundo real.

Num cenário simulado, a AMR encontrou um incidente no seu caminho para recolher uma palete, bloqueando a rota pretendida. A Nvidia Metropolis então atualizou e enviou um mapa de ocupação em tempo real para o sistema de controle, que calculou o novo caminho ideal.

Os operadores de armazém também podem fazer perguntas ao modelo visual por meio de linguagem natural, e o modelo pode compreender detalhes e atividades e fornecer feedback instantâneo para melhorar a eficiência operacional.

Vale ressaltar que o Apple Vision Pro também apareceu nesta conferência. As empresas podem transmitir facilmente descrições interativas de cenas universais (OpenUSD) de aplicativos 3D para o Vision Pro em tempo real por meio do Omniverse Cloud, ajudando os usuários a explorar mundos virtuais como nunca antes.

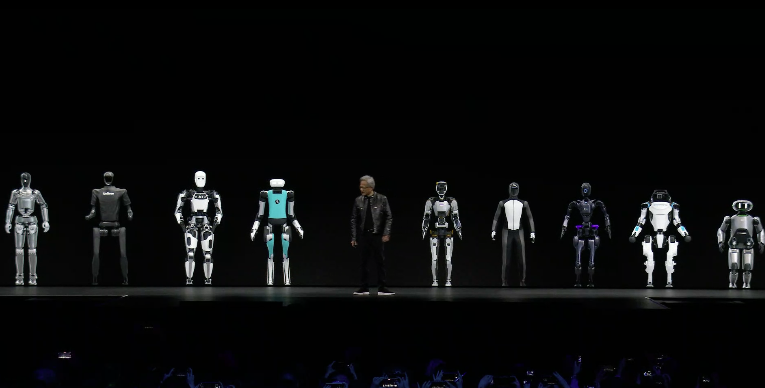

O final da coletiva de imprensa foi o familiar segmento de robôs. Como disse Huang Renxun, no momento em que abriu as mãos e ficou com outros robôs humanóides, neste momento, “a interseção de computação gráfica, física e inteligência artificial, esta.. … Tudo começa neste momento.”

▲ Pequeno ovo de páscoa

Dez anos atrás, no GTC, Jen-Hsun Huang enfatizou pela primeira vez a importância do aprendizado de máquina. Embora muitas pessoas ainda considerassem a Nvidia um fabricante de "placas gráficas para jogos", elas já estavam na vanguarda da revolução da IA.

Em 2024, conhecido como o primeiro ano de aplicações de IA, a NVIDIA já usou software e hardware de IA para capacitar vários setores em muitos campos: grandes modelos de linguagem, IA conversacional, computação de ponta, big data, direção autônoma, robôs biônicos…

A descoberta de medicamentos não é nossa especialidade, a computação é; construir carros não é nossa especialidade, os computadores de IA necessários para construir carros são. Francamente, é difícil para uma empresa ser boa em todas essas coisas, mas somos muito bons na parte de computação de IA.

Comparada com o líder de um único setor, a NVIDIA é mais como um “grande homem nos bastidores”.Enquanto a IA for mencionada, a NVIDIA deve ser um tópico inevitável.

Como disse Huang, a NVIDIA já é uma empresa de plataforma.

Foi a implantação avançada e a tendência geral de desenvolvimento histórico que permitiram à Nvidia ocupar mais de 70% das vendas do mercado de chips de IA no início da era da IA. A avaliação da empresa também ultrapassou US$ 2 trilhões, não muito tempo atras.

Talvez esta seja também a razão pela qual a Apple desistiu de construir carros depois de lutar por muitos anos e investiu pesadamente em IA generativa. Quer se trate de benefícios económicos ou de tendências tecnológicas, é demasiado digno de aposta.

Numa altura em que ainda questionamos a utilidade da “IA”, a NVIDIA provou com ações que a IA se tornou uma parte indispensável da nova era.

Autor: Li Chaofan, Xiao Fanbo, Mo Chongyu

# Bem-vindo a seguir a conta pública oficial do WeChat de aifaner: aifaner (WeChat ID: ifanr).Mais conteúdo interessante será fornecido a você o mais rápido possível.