Desigualdade de linguagem de grandes modelos de IA: o treinamento em inglês custa o mais barato, o treinamento em chinês custa o dobro do inglês

Recentemente, o usuário do X (anteriormente Twitter) @Dylan Patel mostrou um estudo da Universidade de Oxford: Ao estudar a linguagem do GPT-4 e da maioria dos outros LLMs comuns, o estudo descobriu que o custo da inferência do LLM (Large Language Model) é muito diferente. grande.

Entre eles, a entrada e a saída em inglês são muito mais baratas do que em outros idiomas. O custo do chinês simplificado é cerca de 2 vezes o do inglês, o custo do espanhol é 1,5 vezes o do inglês e o custo do shan birmanês é 15 vezes o do inglês .

O princípio pode ser rastreado até um artigo publicado pela Universidade de Oxford no arXiv em maio deste ano.

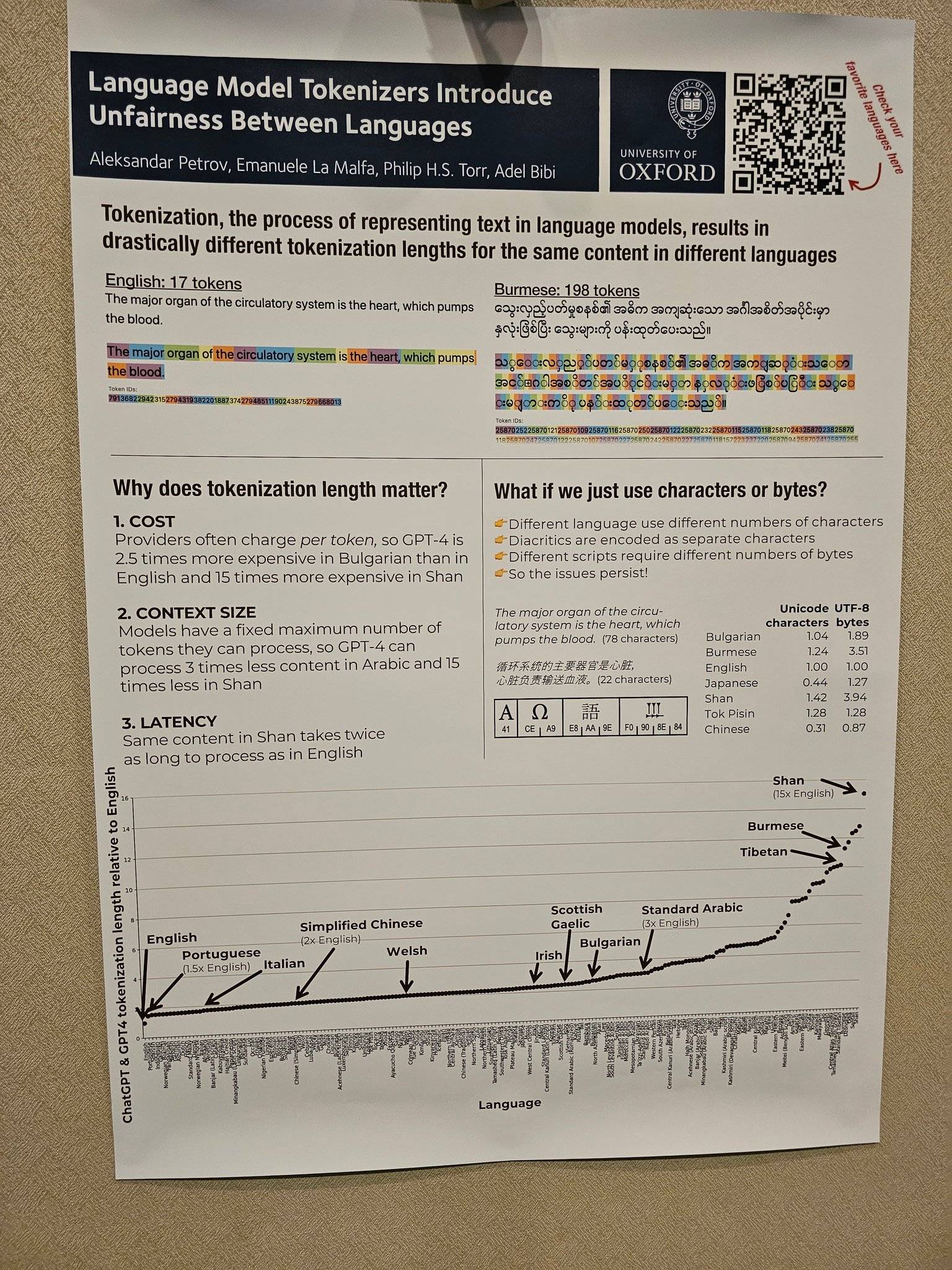

Lexical é o processo de conversão de texto de linguagem natural em uma sequência de tokens, que é a primeira etapa no processamento de texto do modelo de linguagem. No cálculo do custo do poder de computação do LLM, quanto mais tokens, maior o custo do poder de computação.

Sem dúvida, sob a tendência de comercialização de IA generativa, o custo do poder de computação também será enxertado nos usuários.Muitos serviços de IA atuais são cobrados de acordo com o número de palavras que precisam ser processadas.

O artigo mostra que, após analisar 17 métodos de lematização, os pesquisadores descobriram que o comprimento de um mesmo texto é convertido em sequências de lemas em idiomas diferentes, o que é totalmente justo.

Por exemplo, de acordo com o tokenizador GPT3 da OpenAI, se você tokenizar "seu amor", apenas dois tokens serão necessários em inglês, enquanto oito tokens serão necessários em chinês simplificado. Embora o texto em chinês simplificado tenha apenas 4 caracteres e o texto em inglês tenha 14 caracteres.

Pelas imagens expostas pelo usuário do X @Dylan Patel, também pode ser percebido intuitivamente que são necessários 17 tokens (tokens) para o LLM processar uma frase em inglês e 198 tokens (tokens) para o LLM processar uma frase em birmanês com o mesmo significado. Isso significa que o processamento do birmanês será 11 vezes mais caro do que o inglês.

Existem muitas situações semelhantes. O site de Aleksandar Petrov fornece muitos ícones e dados relacionados. Amigos interessados podem clicar em "https://aleksandarpetrov.github.io/tokenization-fairness/" para ver as diferenças entre os idiomas.

Há também uma página semelhante no site oficial do OpenAI, explicando como a API lematiza um trecho de texto e exibe o número total de tokens no texto. O site oficial também menciona que um lema geralmente corresponde a cerca de 4 caracteres em um texto em inglês e 100 lemas equivalem a cerca de 75 palavras.

Graças à curta duração das sequências lexicais do inglês, o inglês é o maior vencedor em relação ao custo-benefício do pré-treinamento de inteligência artificial generativa, deixando outros usuários de idiomas para trás, criando indiretamente uma situação injusta.

Entre outras coisas, essa diferença no comprimento da sequência de token pode levar a uma latência de processamento injusta (algumas linguagens levam mais tempo para processar o mesmo conteúdo) e modelagem injusta de dependências de sequência longa (algumas linguagens podem processar apenas textos mais curtos).

Simplificando, os usuários de determinados idiomas precisam pagar custos mais altos, sofrer atrasos maiores e obter desempenho inferior, reduzindo assim seu acesso justo às oportunidades de tecnologia da linguagem, o que indiretamente leva a usuários falantes de inglês e An AI divide formas entre o resto do uso da linguagem do mundo.

Considerando apenas o custo de produção, o custo do chinês simplificado é o dobro do inglês. Com o desenvolvimento aprofundado do campo de IA, o chinês simplificado, que está sempre "a um passo de distância", obviamente não é amigável. Sob o equilíbrio de fatores sobrepostos, como custo, os países que não falam inglês também estão tentando desenvolver seus próprios modelos de língua nativa.

Tomando a China como exemplo, como um dos primeiros gigantes domésticos a explorar a IA, em 20 de março de 2023, a Baidu lançou oficialmente a IA generativa Wenxin Yiyan.

Posteriormente, lotes de excelentes modelos em grande escala, como o modelo em grande escala Tongyi Qianwen da Alibaba e o modelo em grande escala Pangu da Huawei, surgiram um após o outro.

Entre eles, o grande modelo NLP no modelo grande Pangu da Huawei é o primeiro grande modelo chinês da indústria com 100 bilhões de parâmetros, que tem 110 bilhões de parâmetros densos e é treinado com 40 TB de dados massivos.

Como a vice-secretária-geral das Nações Unidas, Amina Mohamed, certa vez alertou na Assembleia Geral da ONU, se a comunidade internacional não agir de forma decisiva, a exclusão digital se tornará "a nova face da desigualdade".

Da mesma forma, com o rápido desenvolvimento da IA generativa, a lacuna da IA provavelmente se tornará uma nova rodada de "novas faces da desigualdade" digna de atenção.

Felizmente, as gigantes tecnológicas nacionais que costumam ficar "enojadas" já tomaram providências.

#Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (ID do WeChat: ifanr), conteúdo mais interessante será apresentado a você o mais rápido possível.